인공지능은 빠르게 발전하고 있으며, 개발자들은 이제 고급 추론 기능을 제공하는 도구를 요구하고 있습니다. NVIDIA는 NVIDIA Llama Nemotron 모델군으로 이러한 요구를 충족합니다. 이 모델들은 복잡한 추론을 요구하는 작업에서 뛰어난 성과를 보이며, 컴퓨팅 효율성을 제공하고 기업 사용을 위한 오픈 라이센스가 제공됩니다. 개발자는 NVIDIA의 NIM 마이크로서비스를 통해 제공되는 NVIDIA Llama Nemotron API를 통해 이러한 모델에 접근할 수 있어 애플리케이션에 통합이 용이합니다.

NVIDIA Llama Nemotron 모델 이해하기

API에 들어가기 전에 NVIDIA Llama Nemotron 모델을 살펴보겠습니다. 이 모델군은 Nano, Super, Ultra의 세 가지 변형을 포함합니다. 각각은 특정 배치 요구를 목표로 하며, 성능과 자원 요구를 균형 잡습니다.

- Nano (8B 파라미터): 엔지니어들이 이 모델을 엣지 디바이스 및 PC에 최적화했습니다. 최소한의 컴퓨팅 파워로 높은 정확도를 제공하여 경량 애플리케이션에 적합합니다.

- Super (49B 파라미터): 개발자들이 이 모델을 단일 GPU 설정용으로 설계했습니다. 처리량과 정확성 간의 균형을 이루며, 중간 정도 복잡한 작업에 적합합니다.

- Ultra (253B 파라미터): 전문가들이 이 모델을 다중 GPU 데이터 센터 서버용으로 제작했습니다. 가장 까다로운 AI 에이전트 애플리케이션에 대한 최고 수준의 정확도를 제공합니다.

NVIDIA는 이러한 모델을 메타의 Llama 프레임워크 위에 구축하며, 증류 및 강화 학습과 같은 후처리 기법으로 성능을 향상시킵니다. 이로 인해 과학 분석, 고급 수학, 코딩 및 지침 따르기와 같은 추론 작업에서 뛰어난 성능을 보입니다. 각 모델은 128,000개의 토큰의 컨텍스트 길이를 지원하여 긴 문서를 처리하거나 긴 상호작용에서 컨텍스트를 유지할 수 있습니다.

눈에 띄는 특징은 시스템 프롬프트를 통해 추론을 켜거나 끌 수 있는 기능입니다. 개발자는 복잡한 질문에 대한 추론을 활성화하고, 정적 정보를 검색하는 것과 같은 간단한 작업에서는 이를 비활성화할 수 있습니다. 이 유연성은 리소스 사용을 최적화하여 실제 애플리케이션에서 중요한 이점을 제공합니다.

NVIDIA Llama Nemotron API 설정하기

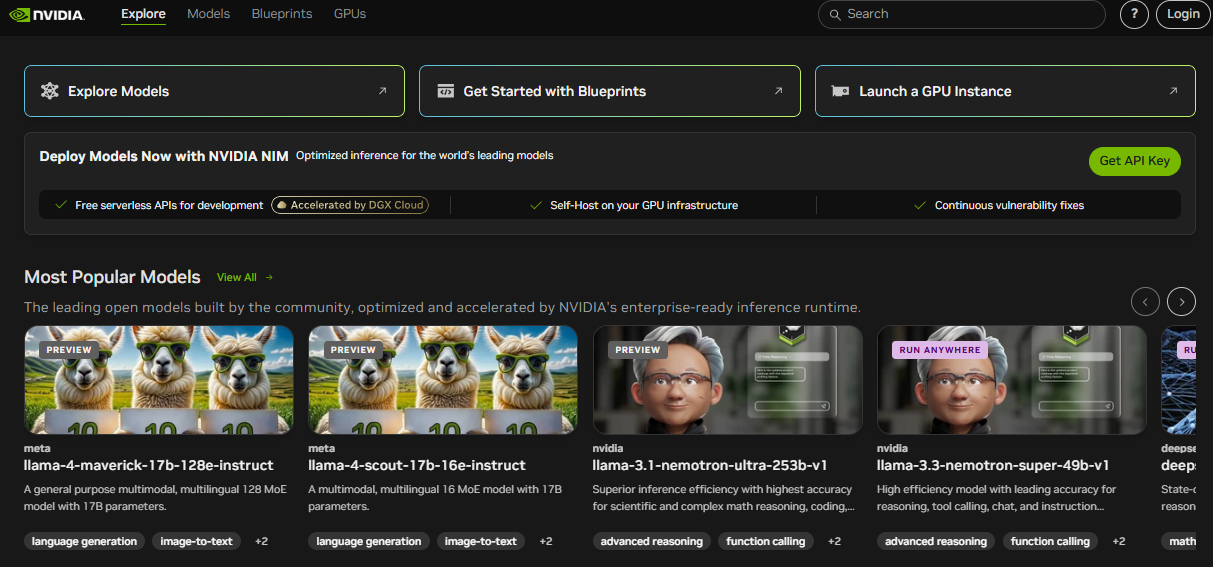

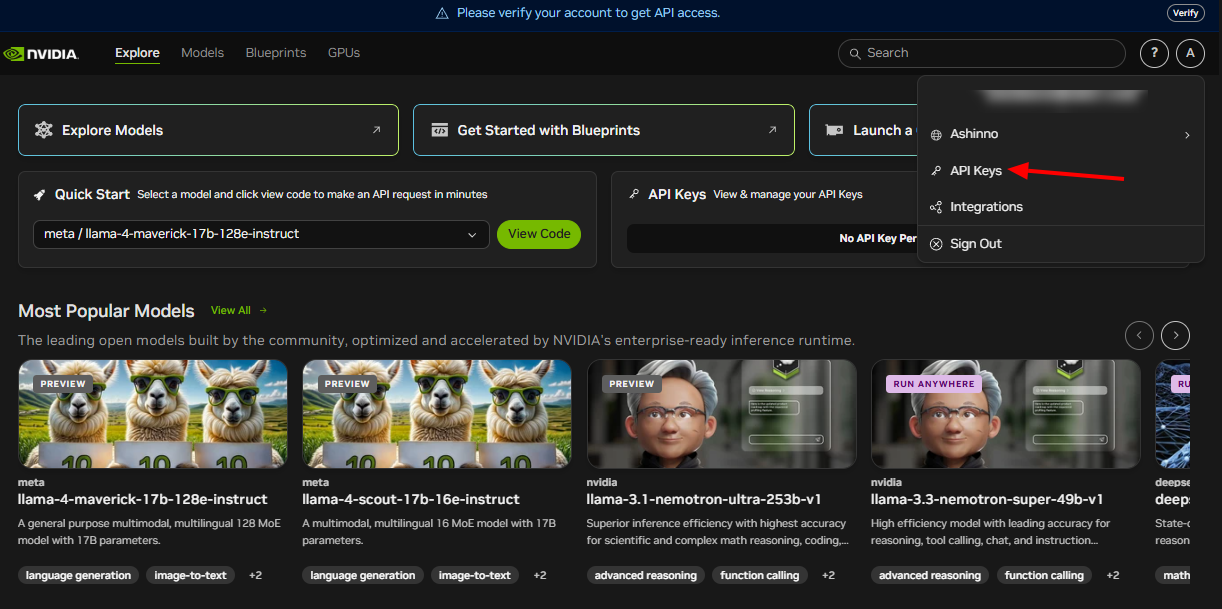

NVIDIA Llama Nemotron API를 활용하려면 먼저 설정해야 합니다. NVIDIA는 이 API를 클라우드, 온프레미스 또는 엣지 환경에서 배포를 지원하는 NIM 마이크로서비스를 통해 제공합니다. 시작하려면 다음 단계를 따르십시오:

NVIDIA 개발자 프로그램에 가입하기: 자원, 문서 및 도구에 접근하기 위해 등록합니다. 이 단계는 필요한 생태계를 열어줍니다.

API 자격 증명 받기: NVIDIA는 API 키를 제공합니다. 이를 사용하여 요청을 안전하게 인증하세요.

필요한 라이브러리 설치하기: Python 개발자의 경우, HTTP 호출을 처리하기 위해 requests 라이브러리를 설치하십시오. 터미널에서 이 명령을 실행하세요:

pip install requests

이 단계를 완료하면 NVIDIA Llama Nemotron API와 상호작용할 수 있는 환경이 준비됩니다. 다음으로 요청을 만드는 방법을 살펴보겠습니다.

API 요청 만들기

NVIDIA Llama Nemotron API는 RESTful 표준을 준수하여 프로젝트에 통합하기 쉽게 만듭니다. API 엔드포인트에 POST 요청을 보내고 요청 본문에 매개변수를 포함합니다. 실용적인 예로 이를 분해해 보겠습니다.

Python을 사용하여 API를 쿼리하는 방법은 다음과 같습니다:

import requests

import json

# API 엔드포인트 및 인증 정의

endpoint = "https://your-nim-endpoint.com/api/v1/generate"

headers = {

"Authorization": "Bearer YOUR_API_KEY",

"Content-Type": "application/json"

}

# 요청 페이로드 생성

payload = {

"model": "llama-nemotron-super",

"prompt": "단어 'strawberry'에 R가 몇 개 있나요?",

"max_tokens": 100,

"temperature": 0.7,

"reasoning": "on"

}

# 요청 전송

response = requests.post(endpoint, headers=headers, data=json.dumps(payload))

# 응답 처리

if response.status_code == 200:

result = response.json()

print(result["text"])

else:

print(f"오류: {response.status_code} - {response.text}")

주요 매개변수 설명

model: 모델 변형(Nano, Super 또는 Ultra)을 지정합니다. 배포에 따라 선택하세요.prompt: 모델이 처리할 입력 텍스트를 제공합니다.max_tokens: 응답 길이를 토큰으로 제한합니다. 이를 조정하여 출력 크기를 제어합니다.temperature: 0에서 1 사이의 범위입니다. 낮은 값(예: 0.5)은 예측 가능한 출력을 생성하고, 높은 값(예: 0.9)은 창의성을 높입니다.reasoning: 추론 기능을 전환합니다. 복잡한 작업을 위해 "on"으로 설정하고, 간단한 작업을 위해 "off"로 설정합니다.

예를 들어, 추론을 활성화하면 수학 문제 해결과 같은 작업에 적합하고, 비활성화하면 기본 조회에 적합합니다. top_p와 같은 매개변수를 추가하여 다양성 제어를 하거나 특정 토큰(예: "\n\n")에서 생성을 중단하는 stop_sequences를 설정할 수도 있습니다.

확장된 예는 다음과 같습니다:

payload = {

"model": "llama-nemotron-super",

"prompt": "프로그래밍에서 재귀를 설명하세요.",

"max_tokens": 200,

"temperature": 0.6,

"top_p": 0.9,

"reasoning": "on",

"stop_sequences": ["\n\n"]

}

이 요청은 재귀에 대한 자세한 설명을 생성하고 이중 줄바꿈에서 중단됩니다. Apidog와 같은 도구는 이러한 요청을 효율적으로 테스트하고 다듬는 데 도움을 줄 수 있습니다.

API 응답 처리하기

요청을 전송한 후 NVIDIA Llama Nemotron API는 JSON 응답을 반환합니다. 여기에는 생성된 텍스트 및 메타데이터가 포함됩니다. 샘플 응답은 다음과 같습니다:

{

"text": "단어 'strawberry'에는 R가 세 개 있습니다.",

"tokens_generated": 10,

"time_taken": 0.5

}

text: 모델의 출력을 포함합니다.tokens_generated: 생성된 토큰 수를 나타냅니다.time_taken: 생성 시간을 초 단위로 측정합니다.

상태 코드를 항상 확인하십시오. 200 코드는 성공을 나타내며, JSON을 구문 분석할 수 있습니다. 오류는 400 또는 500과 같은 코드를 반환하며, 응답 본문에서 디버깅을 위한 세부 정보가 제공됩니다. 재시도 또는 대체와 같은 오류 처리 로직을 구현하여 운영 환경에서 안정성을 확보하세요.

예를 들어, 이전 코드를 확장하면:

if response.status_code == 200:

result = response.json()

print(f"응답: {result['text']}")

print(f"사용된 토큰: {result['tokens_generated']}")

else:

print(f"실패: {response.text}")

# 필요 시 재시도 로직을 여기에 추가하세요

이 접근 방식은 다양한 조건에서 애플리케이션을 신뢰할 수 있도록 유지합니다.

모범 사례 및 사용 사례

NVIDIA Llama Nemotron API의 잠재력을 극대화하려면 다음 모범 사례를 채택하세요:

- 리소스 사용 최적화: 복잡한 작업에 대해서만 추론을 활성화합니다. 이로 인해 컴퓨팅 비용이 크게 줄어듭니다.

- 성능 모니터링:

time_taken을 추적하여 실시간 애플리케이션의 경우 적시에 응답하는지 확인합니다. - 매개변수 조정:

temperature와max_tokens를 실험하여 창의성과 정확성의 균형을 맞춥니다. - 자격 증명 보안: API 키를 환경 변수 또는 안전한 금고에 보관하고 코드에는 절대 보관하지 마십시오.

- 배치 요청: 한 번의 호출로 여러 프롬프트를 처리하여 효율성을 높입니다.

실용적인 사용 사례

API의 다재다능함은 다양한 애플리케이션을 지원합니다:

- 고객 지원: 복잡한 쿼리를 해결하는 챗봇을 개발하세요. 예를 들어 하드웨어 문제를 고치는 것과 같은 일들입니다.

- 교육: 단계별 논리로 개념을 설명하는 튜터를 만드세요. 예를 들어, 미적분을 가르치는 것입니다.

- 연구: 과학자들이 데이터를 분석하거나 가설을 작성하는 데 도움을 줍니다.

- 소프트웨어 개발: 자연어 입력을 기반으로 코드를 생성하거나 스크립트를 디버깅합니다.

코드 예시:

payload = {

"model": "llama-nemotron-super",

"prompt": "팩토리얼을 계산하는 파이썬 함수를 작성하세요.",

"max_tokens": 200,

"temperature": 0.5,

"reasoning": "on"

}

모델은 다음과 같은 결과를 반환할 수 있습니다:

def factorial(n):

if n == 0 or n == 1:

return 1

return n * factorial(n - 1)

이는 재귀 논리를 통해 추론할 수 있는 능력을 보여줍니다. Apidog는 이러한 API 호출을 테스트하는 데 도움을 줄 수 있어 정확성을 확보할 수 있습니다.

결론

NVIDIA Llama Nemotron API는 개발자들이 강력한 추론 기능을 가진 고급 AI 에이전트를 구축할 수 있도록 합니다. 전환 가능한 추론 기능은 성능을 최적화하며, Nano, Super 및 Ultra 모델의 확장성은 다양한 요구를 충족합니다. 챗봇, 교육 도구 또는 코딩 도우미를 구축하든, 이 API는 유연성과 강력을 제공합니다.

또한 Apidog과 같은 도구와 통합하면 워크플로우가 향상됩니다. 엔드포인트를 테스트하고, 응답을 검증하며, 신속하게 반복하여 혁신에 집중하세요. AI가 발전함에 따라 NVIDIA Llama Nemotron API를 마스터하는 것은 이 혁신적인 분야의 최전선에 서는 것을 가능하게 합니다.