AI 코딩 에이전트의 강력한 기능을 예상치 못한 요금 없이 사용하고 싶으신가요? 좋은 소식입니다. 2025년에는 번들 크레딧 사용, 파트너 모델 활용, 심지어 유능한 대안을 로컬에서 실행하는 등 Codex를 무료(또는 거의 무료)로 사용할 수 있는 여러 합법적인 방법이 있습니다. 이 가이드는 개발자들이 실제로 매일 사용하는 검증된 경로를 명확한 단계와 함께 제시합니다.

Codex란 무엇인가요?

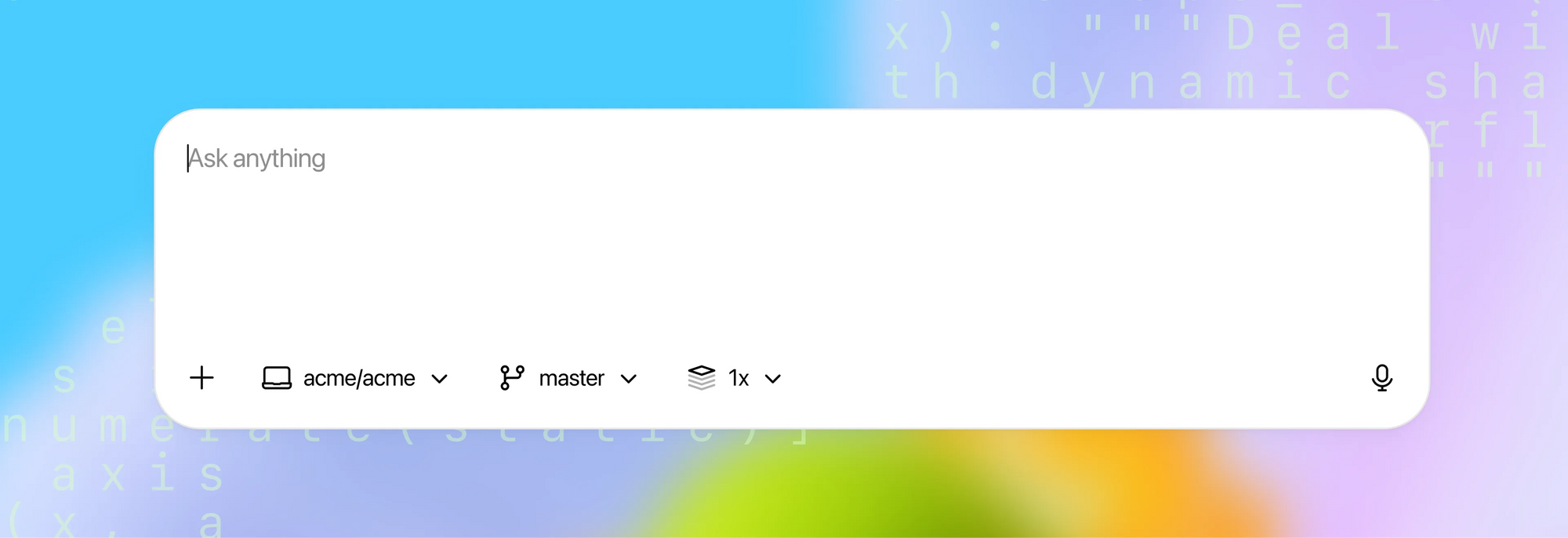

Codex는 코드를 읽고, 쓰고, 실행하여 더 빠르게 개발하고, 버그를 해결하며, 익숙하지 않은 저장소를 이해하도록 돕는 OpenAI의 에이전트형 코딩 시스템입니다. 로컬 및 클라우드 환경에서 작동하며, 리팩토링, 테스트 추가, 문서 생성, 풀 리퀘스트 준비와 같은 복잡한 작업을 위임할 수 있습니다.

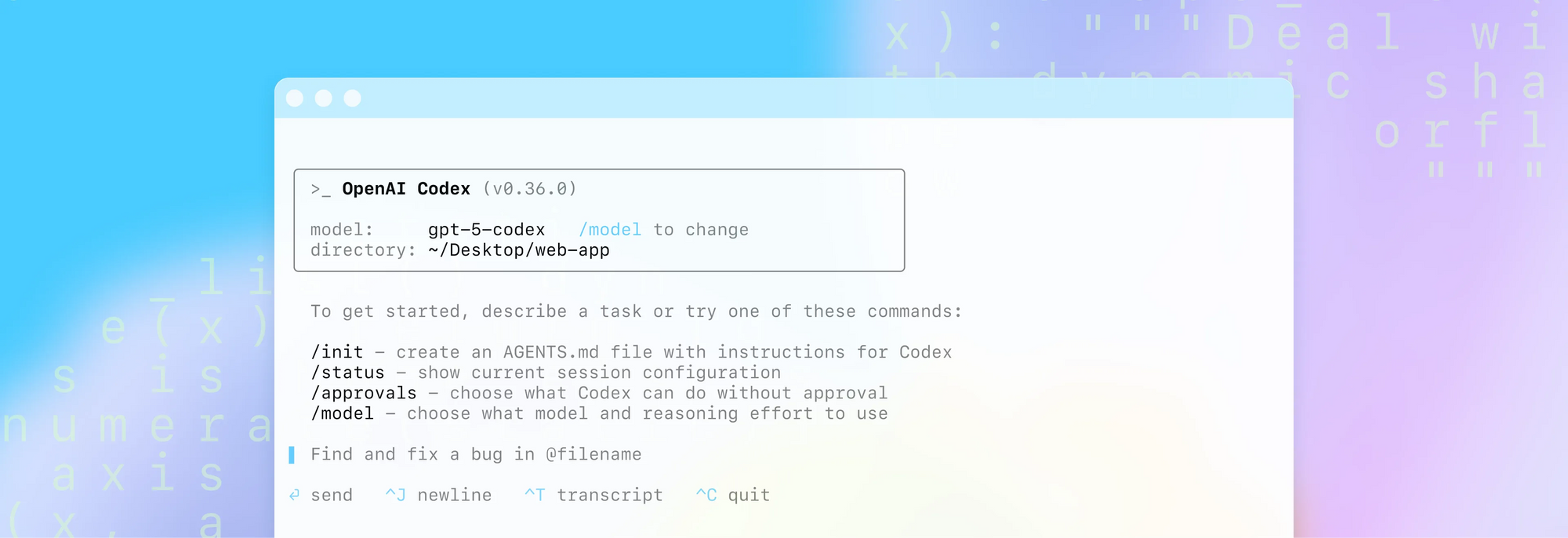

Codex 작동 방식 요약:

- 리포지토리와 지침을 분석한 다음, 도구 지원 루프(예: 터미널/CLI)를 실행하여 변경 사항을 구현합니다.

- 차이점(diff)을 제안하고, 테스트를 실행하며, 검사가 통과할 때까지 반복하여 변경된 내용에 대한 명확한 요약을 생성합니다.

- 여러 클라이언트(웹, IDE 확장, iOS)를 통해 사용할 수 있으며, PR 워크플로우를 위해 GitHub와 통합됩니다.

배포 옵션:

- 클라우드 "위임(delegation)"은 코드와 종속성이 포함된 샌드박스 컨테이너를 실행하여 백그라운드 작업 및 병렬 작업을 가능하게 합니다.

- 로컬 사용은 Codex CLI를 통해 지원되며, 오프라인 워크플로우를 위해 로컬 모델 제공자와 페어링할 수도 있습니다.

보안 참고 사항:

- MFA/SSO 및 조직 정책이 지원됩니다. 클라우드 실행 시 비밀 및 환경 변수는 추가 암호화로 처리됩니다.

- 관리자는 예측 가능한 동작 및 규정 준수를 위해 환경(종속성, 인터넷 접근 수준)을 구성할 수 있습니다.

방법 1 — Codex CLI 내에서 ChatGPT 구독 사용

이미 ChatGPT를 구독하고 있다면, 거래당 API 요금을 지불하지 않고도 Codex CLI 내에서 해당 구독을 사용할 수 있습니다. 즉, 사용량이 구독 혜택에 포함되어 있으므로 각 호출에 대해 API 키를 제공할 필요 없이 CLI를 통해 Codex 기능을 이용할 수 있습니다.

실용적인 팁:

- ChatGPT 계정을 사용하여 Codex CLI에 로그인합니다.

- 로그인 및 토큰 문제를 피하려면 최신 CLI 빌드를 사용하고 있는지 확인합니다.

- 조직의 보안 정책이 CLI 사용을 허용하는지 확인합니다.

많은 개발자들은 헬퍼 함수 생성, 차이점 검토 또는 테스트 초안 작성과 같은 반복적인 작업을 위해 토큰당 요금 걱정 없이 "Codex를 무료로 사용"하기를 원합니다. 기존 구독을 활용하면 비용을 안정화하는 데 도움이 됩니다.

방법 2 — Codex CLI를 통해 무료 크레딧 사용

ChatGPT Plus 또는 Pro 사용자라면 Codex CLI 내에서 무료 API 크레딧을 사용할 수 있습니다. 공식 지침에 따르면, ChatGPT 계정으로 Codex CLI에 로그인한 Plus 및 Pro 사용자는 30일 동안 각각 $5 및 $50의 무료 API 크레딧을 사용할 수 있습니다. 문제가 발생하면 최신 CLI 버전을 사용하고 있는지 확인하세요.

빠른 시작 (CLI 명령어):

npm i -g @openai/codex@latest

codex --free크레딧 사용에 문제가 발생하면 Codex CLI를 업그레이드하고 다시 시도하세요.

방법 3 — 모델 제공자 전환

Codex CLI는 제공자를 전환할 수 있어, 사용 가능한 무료 모델(예: Mistral을 통해)을 대상으로 할 수 있습니다. 탐색적 작업을 위해 Codex를 무료로 사용해야 하는 경우 실용적인 방법입니다.

예시 (개념적):

[model_providers.mistral]

name = "Mistral"

base_url = "https://api.mistral.ai/v1"

env_key = "MISTRAL_API_KEY"팁:

- "무료" 모델을 필터링하고 "도구(tools)"가 지원되는지 확인하세요. 그렇지 않으면 에이전트 흐름이 실패할 수 있습니다.

- 무료 모델 카탈로그는 자주 변경되므로, 안정적인 옵션을 찾기 위해 몇 가지를 테스트해보세요.

방법 4 — Ollama로 모델 로컬 실행

모델을 로컬에서 실행하는 것은 Codex를 무료로 사용하는 가장 독립적인 방법입니다. Ollama를 사용하면 모델(예: Mistral 변형)을 가져와 로컬 서버를 실행하고 Codex CLI가 로컬 제공자를 가리키도록 할 수 있습니다. 이는 외부 토큰당 비용을 없애고 오프라인에서도 작동할 수 있지만, 디스크 공간 및 컴퓨팅 요구 사항이 증가합니다.

주요 단계 (개념적):

- Ollama를 설치하고

ollama명령이 로컬에서 실행되는지 확인합니다. - 도구를 지원하는 모델(예: Mistral 변형)을 가져오고, 크기 및 리소스 요구 사항을 기록합니다.

ollama serve를 시작하고 Codex CLI가 로컬 제공자를 사용하도록 구성합니다.

[model_providers.ollama]

name = "Ollama"

base_url = "http://localhost:11434/v1"여기에서 모델 제공자를 구성하는 방법을 확인하세요.

고려 사항:

- 대용량 다운로드(수 GB) 및 더 높은 로컬 리소스 사용량

- 보통 수준의 하드웨어에서 잠재적으로 느린 생성 속도

- 데이터 지역성 및 네트워크 노출에 대한 완전한 제어

결론 — 적합한 무료 경로를 선택한 다음, Apidog로 더 빠르게 출시하세요

Codex를 무료로 사용하는 단 하나의 "최고의" 방법은 없습니다. 대신, 무료 크레딧 사용, Codex CLI 내에서 ChatGPT 구독 활용, Mistral과 같은 제공자로 전환하여 무료 티어 사용, 또는 Ollama로 로컬에서 모델 실행 등 여러 합법적인 접근 방식이 있습니다. 각 경로는 편의성, 성능, 제어 및 비용의 균형이 다릅니다. 가장 현명한 방법은 현재 단계와 제약 조건에 맞는 것을 선택한 다음, Apidog에서 API 라이프사이클을 표준화하는 것입니다.

Apidog는 AI 코딩의 이점을 활용하도록 돕습니다. 명확하게 설계하고, 자신 있게 디버그하며, 세분화된 제어로 응답을 검증하고, AI로 테스트 케이스를 생성하며, 소비자가 실제로 사용할 수 있는 문서를 게시합니다.

더 원활하고 엔드투엔드 API 워크플로우를 경험할 준비가 되셨나요? 무료 Apidog 워크스페이스를 생성하고, 기존 OpenAPI/Swagger를 가져와 AI로 가속화된 아이디어가 얼마나 빠르게 강력하고 잘 문서화된 서비스로 전환되는지 경험해보세요.