로컬에서 Gemma 3을 Ollama와 함께 실행하면 클라우드 서비스에 의존하지 않고 AI 환경을 완벽하게 제어할 수 있습니다. 이 가이드는 Ollama 설정 방법, Gemma 3 다운로드 방법, 그리고 기계에서 실행하는 방법에 대해 안내합니다.

시작해 봅시다.

왜 Ollama와 함께 로컬에서 Gemma 3을 실행하나요?

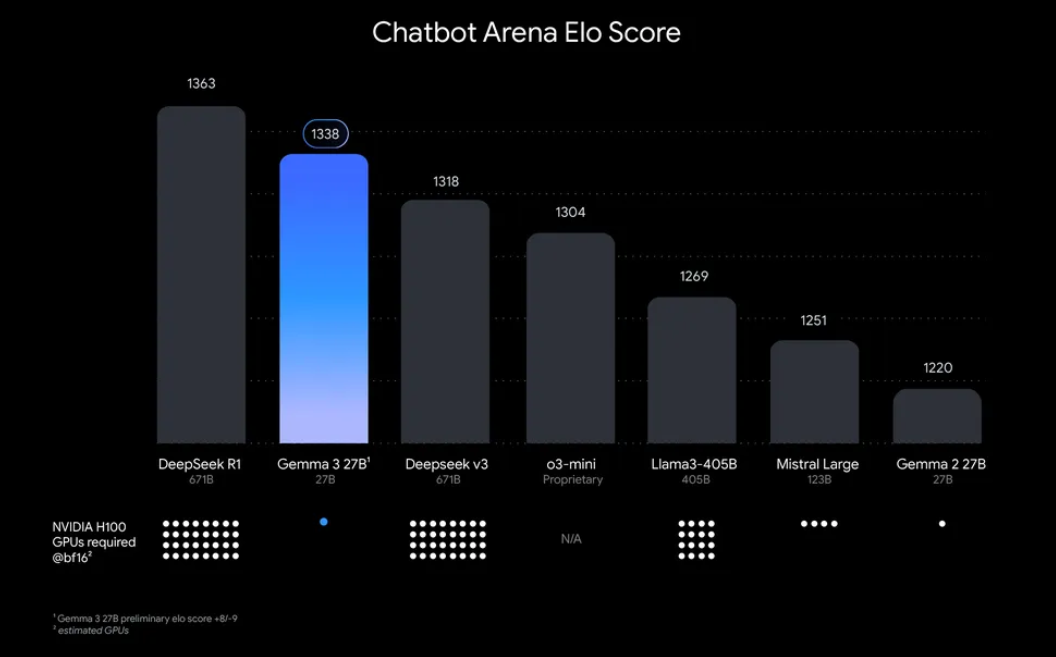

“로컬에서 Gemma 3을 실행하는 데 왜 신경 써야 하나요?” 음, 매력적인 이유가 몇 가지 있습니다. 첫째, 로컬 배포는 민감한 정보를 클라우드로 전송할 필요가 없으므로 데이터 및 개인 정보에 대한 완전한 제어를 제공합니다. 또한 지속적인 API 사용 비용을 피할 수 있어 비용 효율적입니다. 게다가, Gemma 3의 효율성 덕분에 27B 모델조차 단일 GPU에서 실행할 수 있어, 겸손한 하드웨어를 가진 개발자들도 접근할 수 있습니다.

Ollama는 로컬에서 대형 언어 모델(LLM)을 실행하기 위한 경량 플랫폼으로, 이 프로세스를 간소화합니다. 모델 가중치, 구성 및 종속성을 모두 사용하기 쉬운 형식으로 패키징합니다. Gemma 3와 Ollama의 조합은 기계에서 AI 워크플로우를 실험하고, 애플리케이션을 구축하며, 테스트하는 데 이상적입니다. 그럼, 소매를 걷어붙이고 시작해 보겠습니다!

Ollama로 Gemma 3을 실행하기 위해 필요한 것들

설정에 들어가기 전에 다음 요구 사항을 확인하세요:

- 호환 가능한 기계: GPU(최적 성능을 위해서는 NVIDIA)가 장착된 컴퓨터가 필요합니다. 27B 모델은 상당한 자원을 요구하지만, 1B 또는 4B와 같은 더 작은 모델은 덜 강력한 하드웨어에서 실행할 수 있습니다.

- Ollama 설치: Ollama를 다운로드하고 설치하세요. MacOS, Windows 및 Linux에서 사용할 수 있습니다. ollama.com에서 다운로드할 수 있습니다.

- 기본 명령 줄 기술: 터미널 또는 명령 프롬프트를 통해 Ollama와 상호작용할 것입니다.

- 인터넷 연결: 처음에는 Gemma 3 모델을 다운로드할 필요가 있지만, 다운로드 한 후에는 오프라인에서도 실행할 수 있습니다.

- 선택 사항: API 테스트를 위한 Apidog: Gemma 3를 API와 통합하거나 프로그래밍적으로 응답을 테스트할 계획이라면 Apidog의 직관적인 인터페이스가 시간과 노력을 절약할 수 있습니다.

이제 장비가 모두 갖춰졌으니, 설치 및 설정 과정을 시작해 봅시다.

단계별 가이드: Ollama 설치 및 Gemma 3 다운로드

1. 기계에 Ollama 설치하기

Ollama는 로컬 LLM 배포를 간편하게 하며, 설치가 간단합니다. 방법은 다음과 같습니다:

- MacOS/Windows의 경우: ollama.com에 방문하여 운영 체제에 맞는 설치 프로그램을 다운로드하세요. 화면의 지시에 따라 설치를 완료합니다.

- Linux(예: Ubuntu)의 경우: 터미널을 열고 다음 명령어를 실행합니다:

curl -fsSL https://ollama.com/install.sh | sh

이 스크립트는 하드웨어(포함된 GPU 등)를 자동으로 감지하여 Ollama를 설치합니다.

설치가 완료되면 다음 명령어를 실행하여 설치를 확인합니다:

ollama --version

현재 버전 번호가 표시되어 Ollama가 준비되었음을 확인할 수 있습니다.

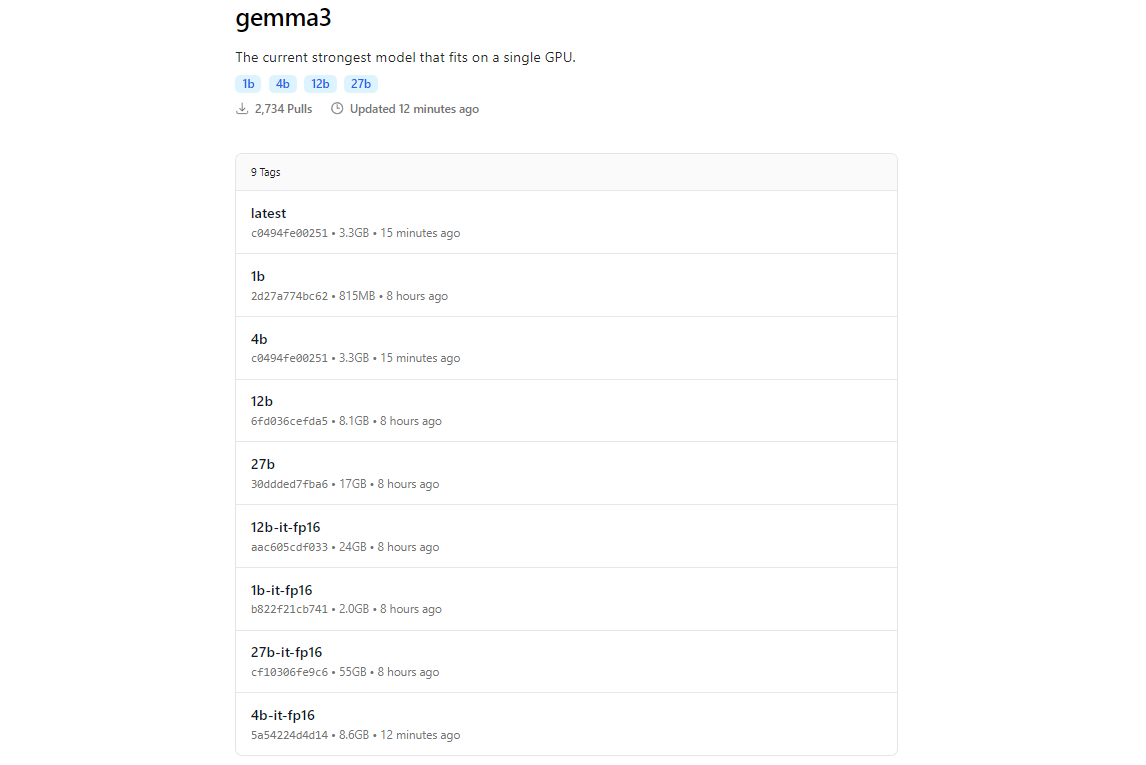

2. Ollama를 사용하여 Gemma 3 모델 가져오기

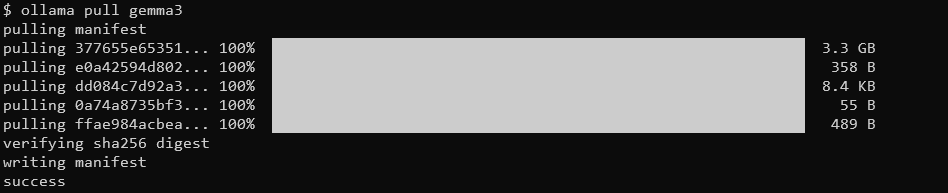

Ollama의 모델 라이브러리는 Hugging Face 및 Google의 AI 제공과 같은 플랫폼과의 통합 덕분에 Gemma 3을 포함하고 있습니다. Gemma 3을 다운로드하려면 ollama pull 명령어를 사용합니다.

ollama pull gemma3

더 작은 모델의 경우 다음을 사용할 수 있습니다:

ollama pull gemma3:12bollama pull gemma3:4bollama pull gemma3:1b

모델에 따라 다운로드 크기가 다릅니다. 27B 모델은 몇 기가바이트가 될 것으로 예상되므로 충분한 저장 공간을 확보하세요. Gemma 3 모델은 효율성을 위해 최적화되어 있지만, 더 큰 변형을 위해서는 괜찮은 하드웨어가 필요합니다.

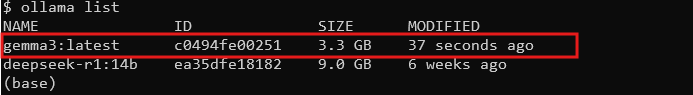

3. 설치 확인

다운로드가 완료되면 모든 모델을 나열하여 모델이 사용 가능한지 확인합니다:

ollama list

목록에 gemma3 (또는 선택한 크기)가 있어야 합니다. 그게 있다면, Gemma 3을 로컬에서 실행할 준비가 완료된 것입니다!

Ollama로 Gemma 3 실행: 상호 작용 모드 및 API 통합

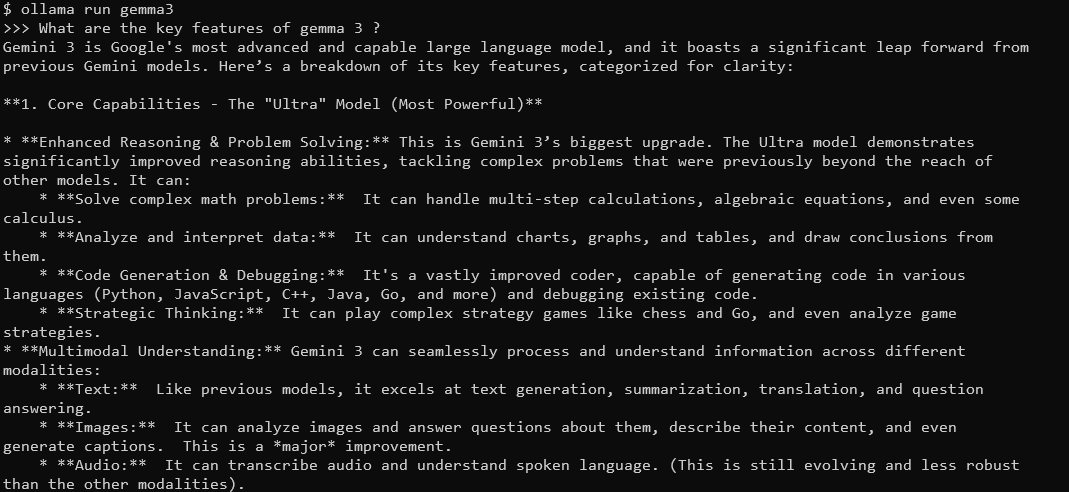

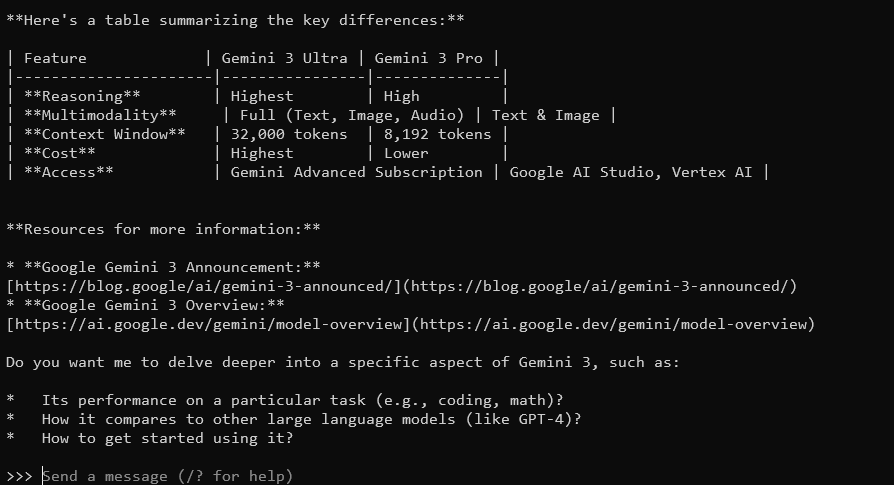

상호 작용 모드: Gemma 3와 채팅하기

Ollama의 상호 작용 모드는 터미널에서 Gemma 3와 직접 채팅할 수 있게 해줍니다. 시작하려면 다음 명령어를 실행하세요:

ollama run gemma3

쿼리를 입력할 수 있는 프롬프트가 표시됩니다. 예를 들어, 시도해 보세요:

Gemma 3의 주요 기능은 무엇인가요?

Gemma 3은 128K 컨텍스트 창과 다중 모드 기능을 통해 자세하고 맥락에 맞는 답변을 제공합니다. 140개 이상의 언어를 지원하며, 텍스트, 이미지, 심지어 특정 크기에서 비디오 입력도 처리할 수 있습니다.

종료하려면 Ctrl+D 또는 /bye를 입력하세요.

Ollama API와 Gemma 3 통합하기

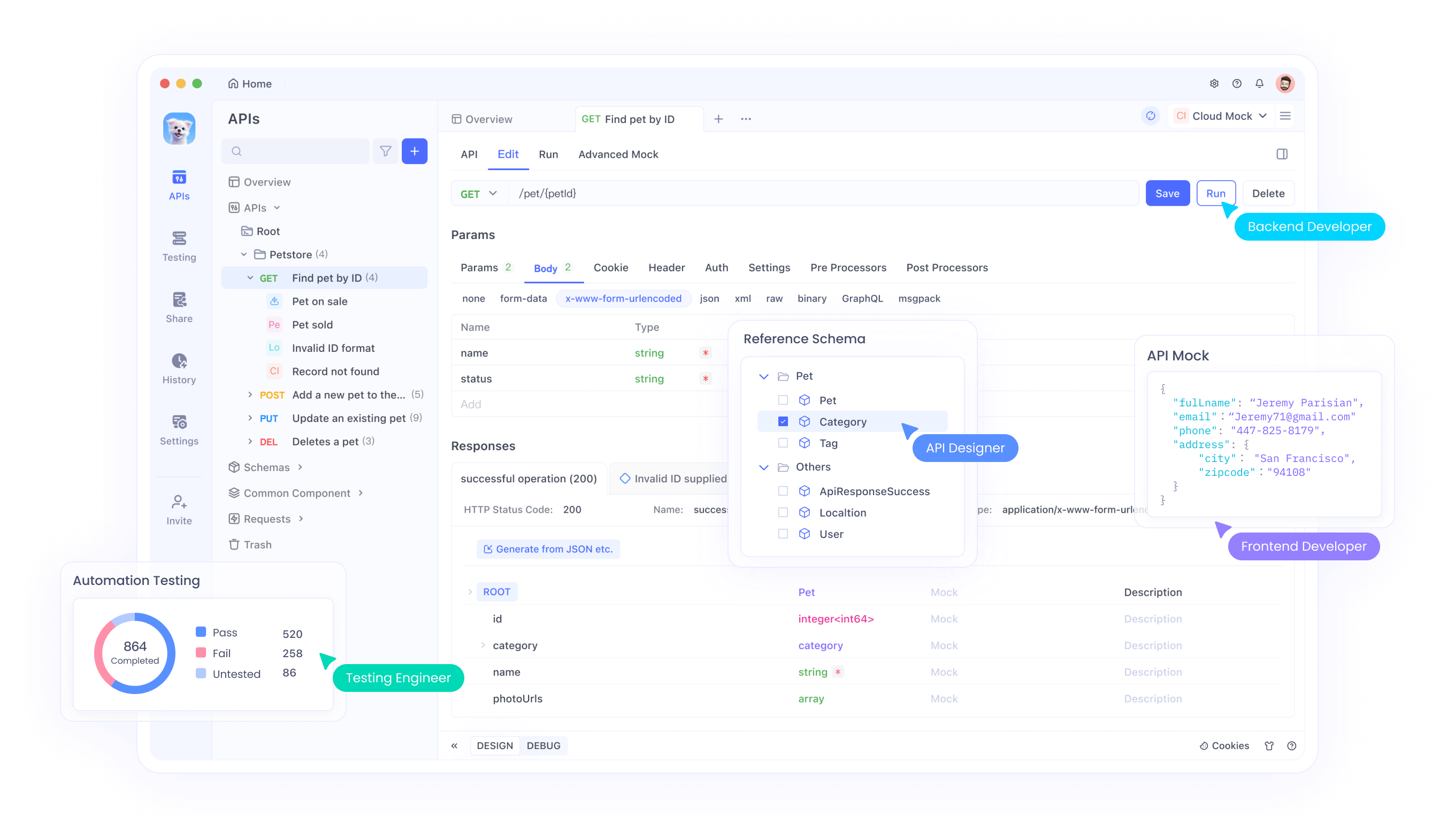

응용프로그램을 구축하거나 상호작용을 자동화하려는 경우, Ollama는 사용 가능한 API를 제공합니다. 이때 Apidog의 사용자 친화적인 인터페이스가 API 요청을 효율적으로 테스트하고 관리하는 데 도움이 됩니다. 시작하는 방법은 다음과 같습니다:

Ollama 서버 시작하기: 다음 명령어를 실행하여 Ollama의 API 서버를 시작합니다:

ollama serve

기본적으로 localhost:11434에서 서버가 시작됩니다.

API 요청하기: HTTP 요청을 통해 Gemma 3과 상호작용할 수 있습니다. 예를 들어, curl을 사용하여 프롬프트를 보낼 수 있습니다:

curl http://localhost:11434/api/generate -d '{"model": "gemma3", "prompt": "프랑스의 수도는 무엇인가요?"}'

응답에는 Gemma 3의 출력이 JSON 형식으로 포함됩니다.

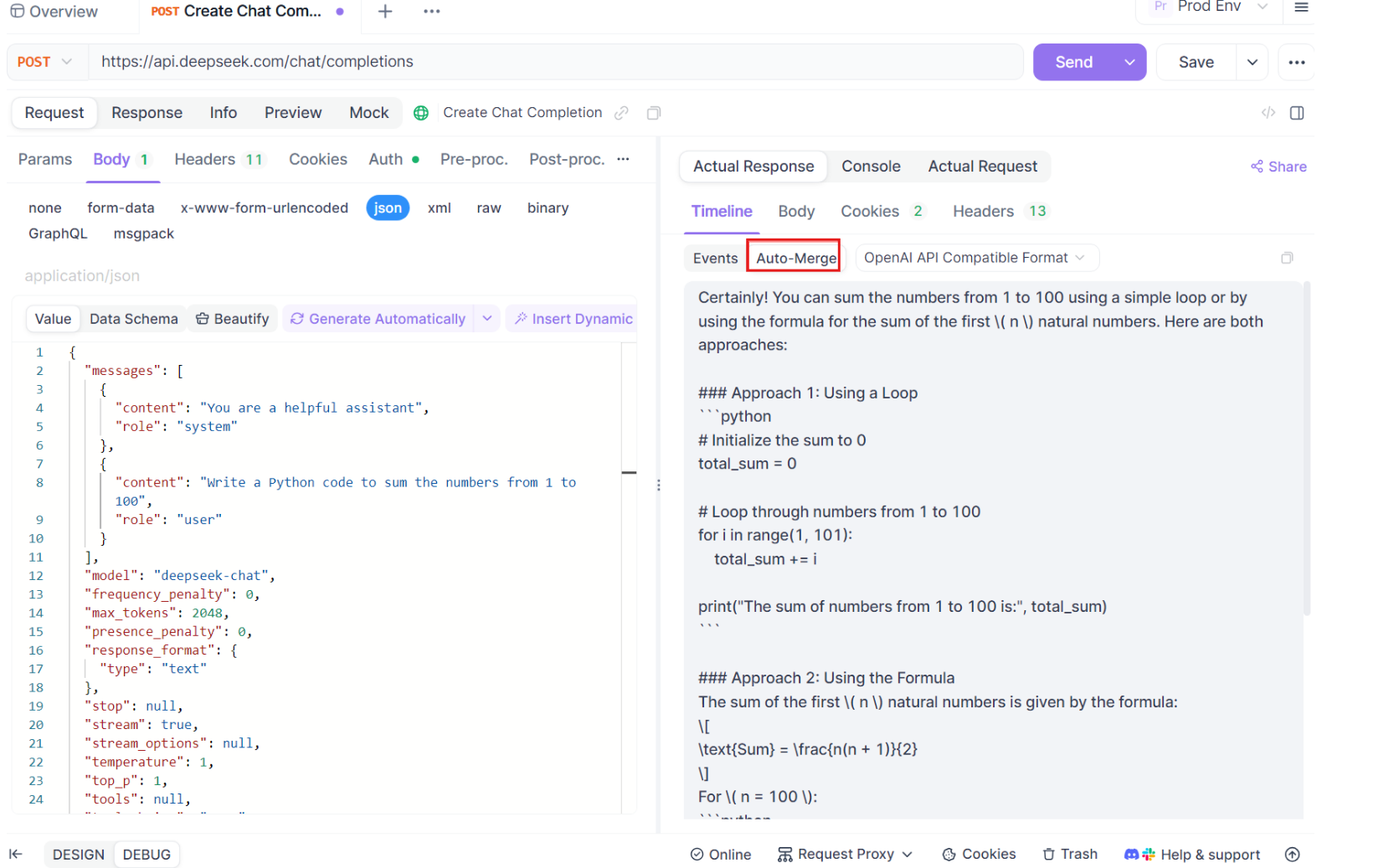

테스트를 위한 Apidog 사용하기: Apidog를 무료로 다운로드하고 Gemma 3의 응답을 테스트하기 위한 API 요청을 생성하세요. Apidog의 시각적 인터페이스를 사용하면 엔드포인트(http://localhost:11434/api/generate)를 입력하고, JSON 페이로드를 설정하며, 복잡한 코드를 작성하지 않고도 응답을 분석할 수 있습니다. 이는 특히 통합을 디버깅하고 최적화하는 데 유용합니다.

Apidog에서 SSE 테스트를 사용하는 단계별 가이드

새로워진 자동 병합 기능을 포함하여 Apidog에서 최적화된 SSE 테스팅 기능을 사용하는 프로세스를 안내하겠습니다. 이 단계를 따라 실시간 디버깅 경험을 극대화하세요.

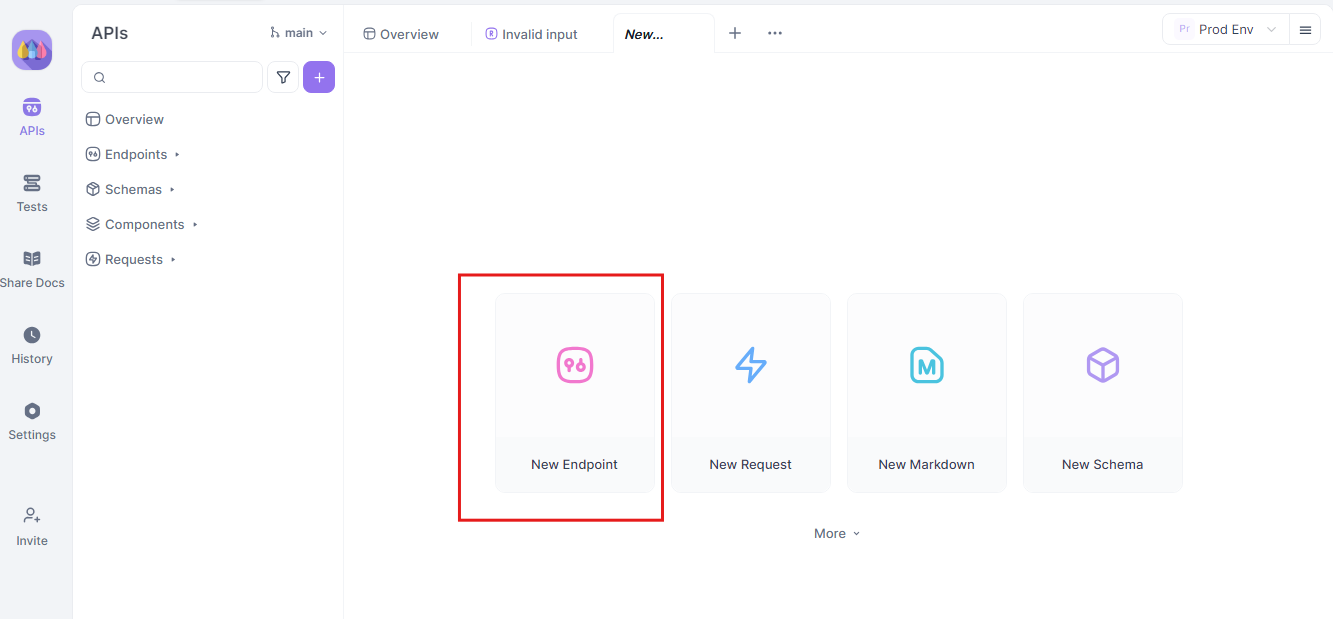

1단계: 새 API 요청 생성하기

Apidog에서 새 HTTP 프로젝트를 시작하세요. 새 엔드포인트를 추가하고 API 또는 AI 모델의 엔드포인트 URL을 입력하세요. 이는 실시간 데이터 스트리밍을 테스트하고 디버깅하는 시작점입니다.

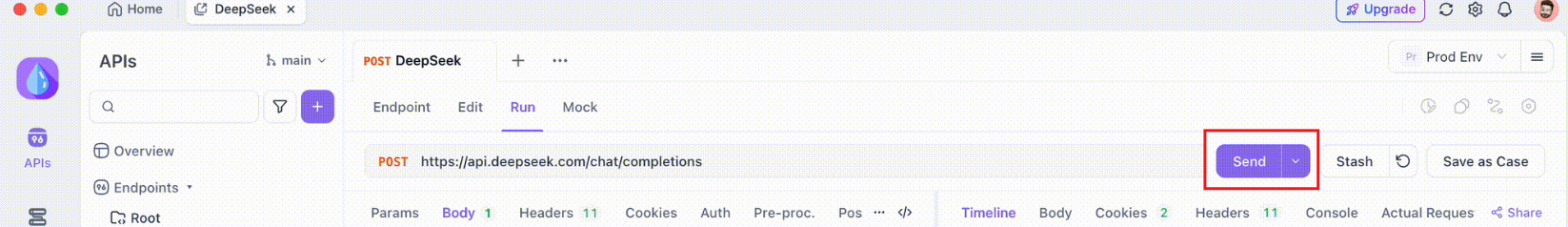

2단계: 요청 보내기

엔드포인트가 설정되면 API 요청을 보냅니다. 응답 헤더를 주의 깊게 관찰하세요. 헤더에 Content-Type: text/event-stream이 포함되어 있다면, Apidog는 자동으로 응답을 SSE 스트림으로 인식하고 해석합니다. 이 감지는 이후 자동 병합 프로세스에 중요합니다.

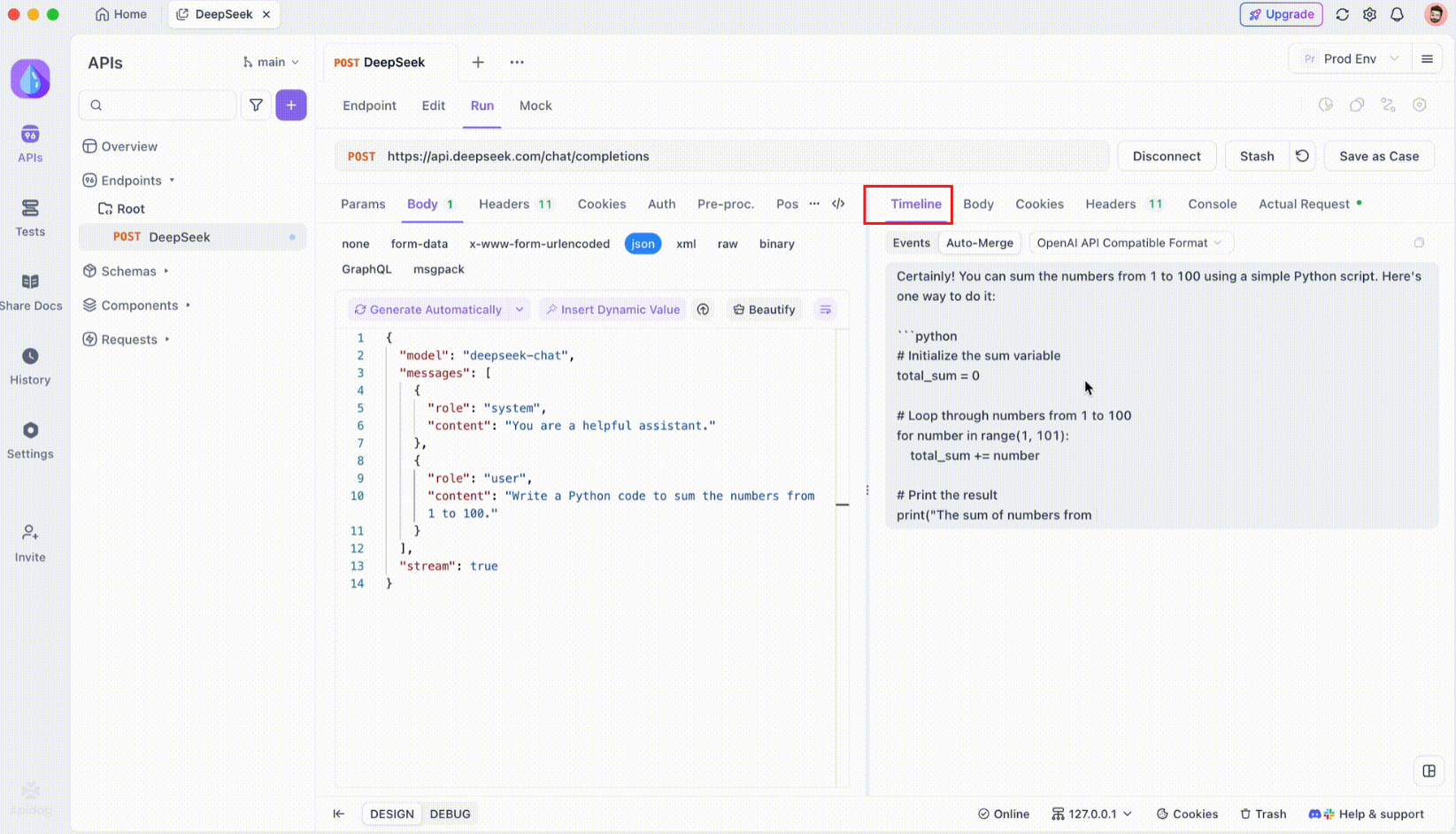

3단계: 실시간 타임라인 모니터링하기

SSE 연결이 설정된 후, Apidog는 모든 수신 SSE 이벤트를 실시간으로 표시하는 전용 타임라인 뷰를 엽니다. 이 타임라인은 새로운 데이터가 도착할 때마다 지속적으로 업데이트되어 데이터 흐름을 정확하게 모니터링할 수 있습니다. 타임라인은 단순한 데이터의 원시 덤프가 아니라 데이터가 전송되는 시점과 방식에 대한 구조화된 시각화를 제공합니다.

4단계: 자동 병합 메시지

마법이 일어나는 곳입니다. 자동 병합 개선 기능을 통해 Apidog는 인기 있는 AI 모델 형식을 자동으로 인식하고 파편화된 SSE 응답을 완전한 응답으로 병합합니다. 이 단계에는 다음이 포함됩니다:

- 자동 인식: Apidog는 응답 형식이 지원되는 형식(OpenAI, Gemini 또는 Claude)인지 확인합니다.

- 메시지 병합: 형식이 인식되면 플랫폼은 모든 SSE 조각을 자동으로 결합하여 매끄럽고 완전한 응답을 제공합니다.

- 향상된 시각화: DeepSeek R1과 같은 특정 AI 모델의 경우, 타임라인은 모델의 사고 과정을 표시하여 생성된 응답 뒤의 논리에 대한 추가 통찰력을 제공합니다.

이 기능은 AI 기반 응용프로그램을 다룰 때 특히 유용하여 응답의 모든 부분이 수동 개입 없이 포착되고 전체적으로 제공되도록 보장합니다.

5단계: JSONPath 추출 규칙 구성하기

모든 SSE 응답이 기본 제공 형식으로 자동으로 일치하지는 않습니다. 사용자 정의 추출이 필요한 JSON 응답을 다룰 때 Apidog는 JSONPath 규칙을 구성할 수 있게 해줍니다. 예를 들어, 원시 SSE 응답에 JSON 객체가 포함되어 있고 content 필드를 추출해야 하는 경우, 다음과 같이 JSONPath 구성을 설정할 수 있습니다:

- JSONPath:

$.choices[0].message.content - 설명:

$는 JSON 객체의 루트를 나타냅니다.choices[0]는choices배열의 첫 번째 요소를 선택합니다.message.content는 메시지 객체 내의 content 필드를 지정합니다.

이 구성은 Apidog에 SSE 응답에서 원하는 데이터를 추출하는 방법을 지시하여 비표준 응답도 효과적으로 처리할 수 있도록 합니다.

결론

Ollama와 함께 Gemma 3을 로컬에서 실행하는 것은 기계에서 구글의 고급 AI 기술을 활용할 수 있는 흥미로운 방법입니다. Ollama 설치 및 모델 다운로드에서 터미널 또는 API를 통한 상호작용에 이르기까지, 이 가이드는 모든 단계를 안내드립니다. 다중 모드 기능, 다국어 지원, 그리고 인상적인 성능을 지닌 Gemma 3은 개발자와 AI 애호가 모두를 위한 게임 체인저입니다. Apidog와 같은 도구를 활용하여 무결점 API 테스트 및 통합을 잊지 마세요. 오늘 무료로 다운로드하여 Gemma 3 프로젝트를 개선하세요!

1B 모델로 노트북에서 작업하든 27B 모델의 한계를 GPU 리그에서 밀어내든, 이제 가능성을 탐색할 준비가 되었습니다. 행복한 코딩 되세요, 그리고 Gemma 3로 놀라운 것들을 만드세요!