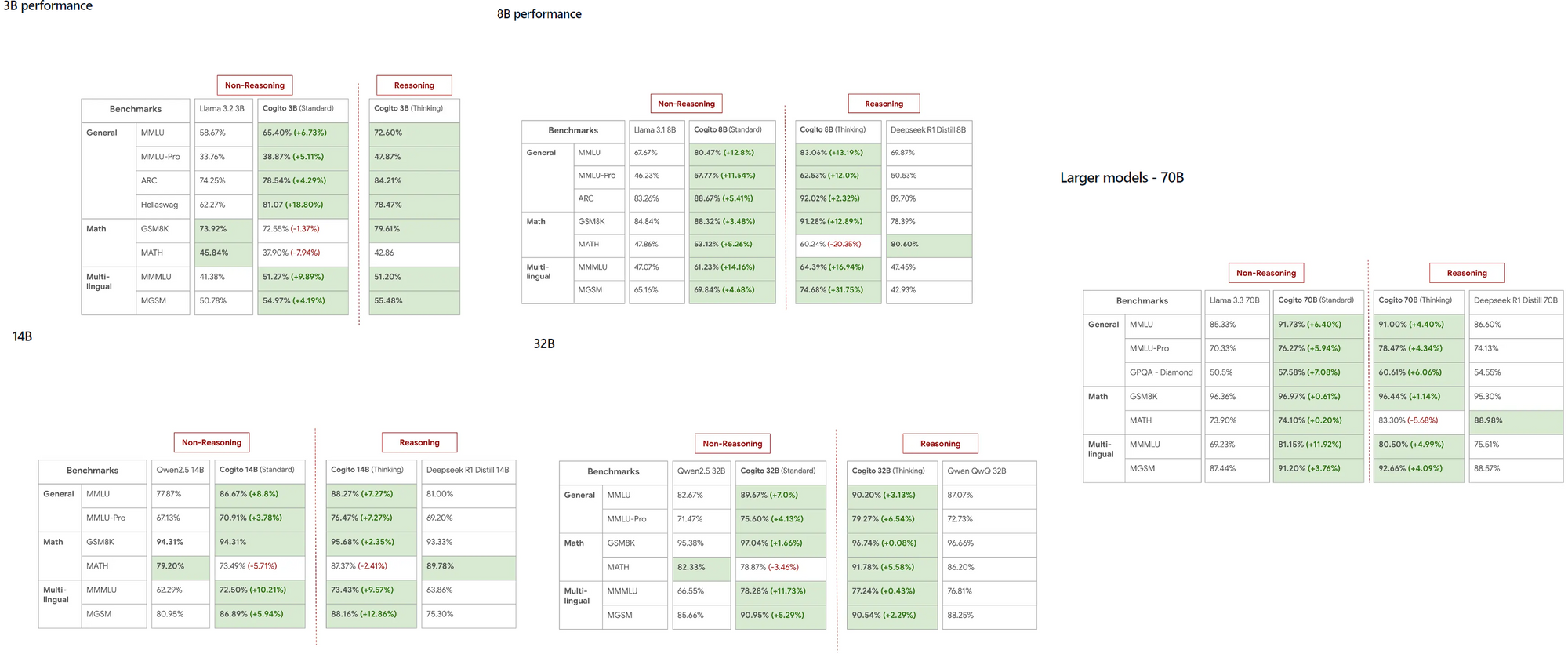

DeepCogito에서 출시한 Cogito 모델은 LLaMA 및 DeepSeek와 같은 기존 모델을 다양한 규모에서 능가하는 놀라운 능력으로 AI 커뮤니티에서 빠르게 주목받고 있습니다. 3B에서 70B 매개변수에 이르는 이러한 오픈 소스 모델은 개발자에게 로컬 머신에서 일반적인 슈퍼 인공지능을 직접 탐험할 수 있는 강력한 도구를 제공합니다.

Cogito와 Ollama에 대해 알아야 할 사항

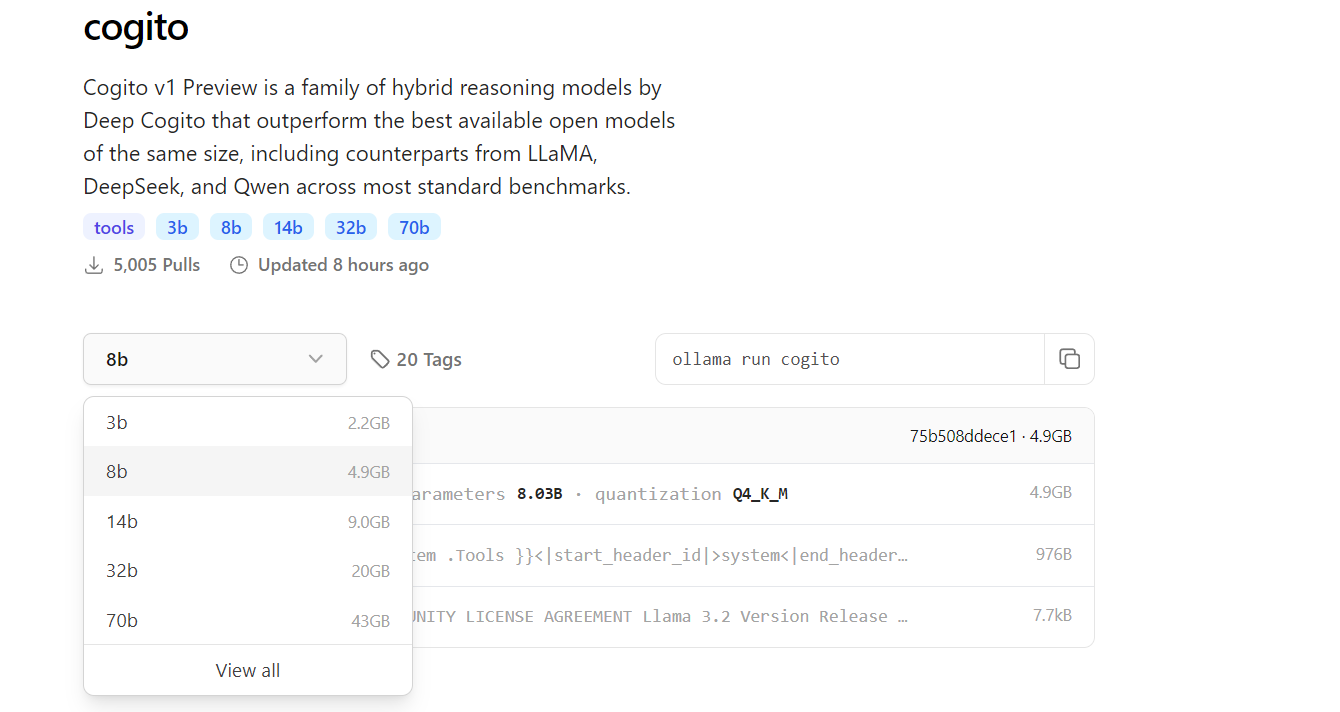

Cogito 는 DeepCogito 팀이 개발한 일련의 오픈 소스 AI 모델을 나타내며, 일반적인 슈퍼 인공지능 달성에 명확한 초점을 맞추고 있습니다. 이러한 모델은 반복 증류 및 증폭(IDA)이라는 기술을 활용하여 더 나은 솔루션을 도출하기 위해 더 많은 계산을 사용하여 모델의 추론 능력을 반복적으로 향상시키고, 그 과정을 모델의 매개변수에 증류합니다. 3B, 8B, 14B, 32B 및 70B 크기로 제공되는 Cogito 모델은 109B 및 400B 매개변수 모델의 출시와 함께 추가 확장될 예정입니다.

반면에, Ollama는 개발자가 클라우드 기반 API 없이 로컬 머신에서 LLM을 실행할 수 있는 다재다능한 프레임워크입니다. MacOS, Windows, Linux와 같은 여러 플랫폼을 지원하는 Ollama는 다양한 사용자가 접근할 수 있도록 보장합니다. Cogito를 Ollama와 함께 로컬에서 실행함으로써 고급 AI 모델을 디바이스에서 실험할 수 있으며, 이는 비용을 절감할 뿐만 아니라 민감한 애플리케이션의 데이터 개인정보 보호를 향상시킵니다.

Cogito를 로컬에서 실행해야 하는 이유

Cogito를 로컬에서 실행하는 것은 개발자에게 여러 가지 이점을 제공합니다. 첫째로, 외부 API에 대한 의존성을 없애준다는 점에서 지연 시간을 줄이고 데이터가 개인정보로 유지됩니다. 이는 데이터 보안이 중요한 애플리케이션에서는 특히 중요합니다. 또한, Cogito 모델은 LLaMA 4 Scout와 같은 경쟁 모델에 비해 성능이 우수하다는 것을 입증하였으며, 작은 규모에서도 뛰어난 성능을 발휘하여 고성능 작업에 적합한 선택이 됩니다.

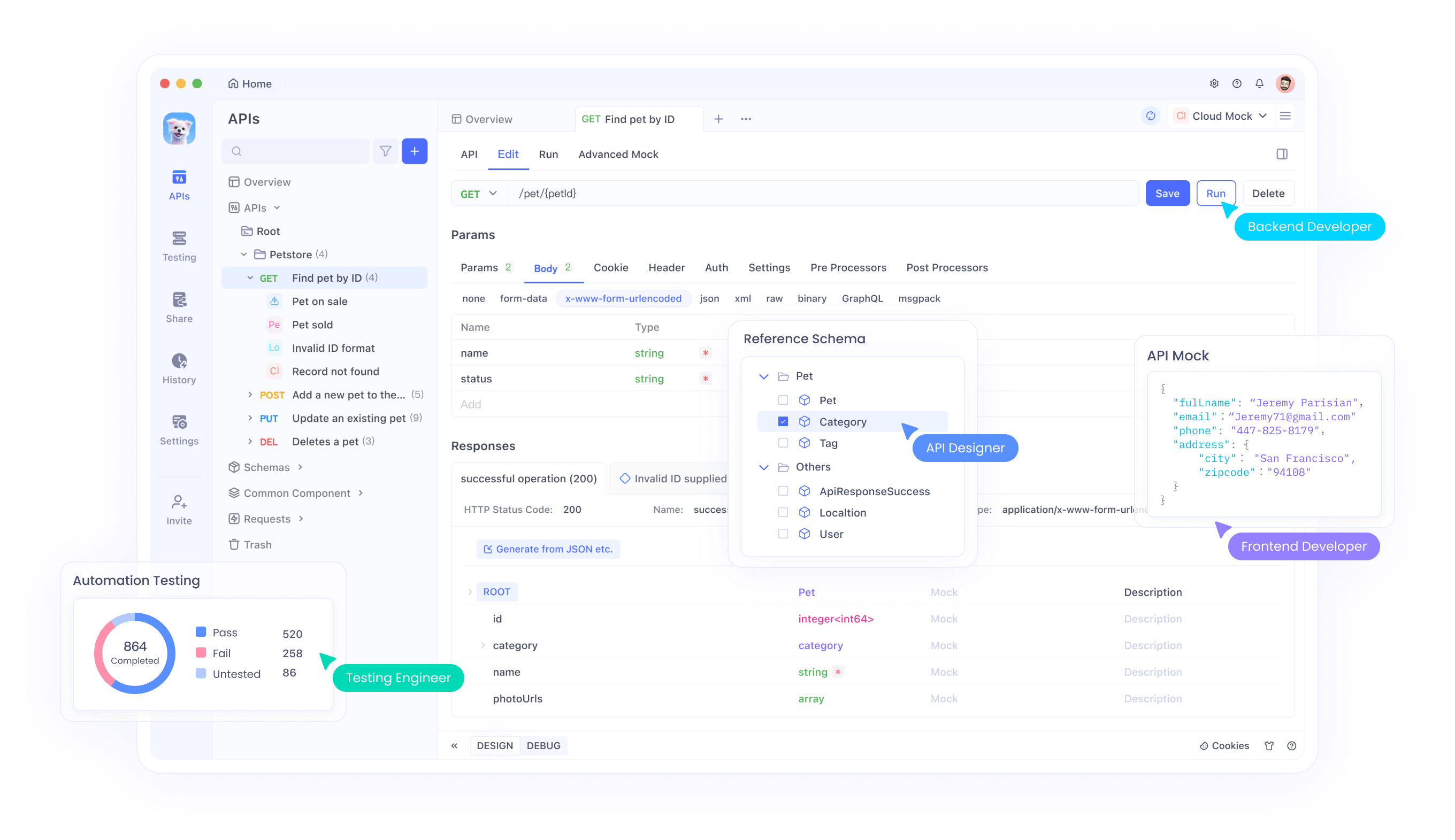

로컬 실행은 리소스가 제한된 환경이나 제한된 인터넷 액세스가 있는 지역에서 작업하는 개발자에게도 이상적입니다. 또한, Ollama의 직관적인 명령줄 인터페이스는 Cogito를 포함한 여러 모델을 관리하고 실행하는 프로세스를 단순화합니다. 마지막으로, 로컬 설정은 API 통합을 테스트할 때 개발 중에 더 빠른 반복이 가능하게 하며, Apidog와 같은 도구를 사용하여 내 엔드포인트를 설계하고 디버그하는 데 효율적으로 관리할 수 있습니다.

Ollama로 Cogito 실행을 위한 필수 조건

설정 프로세스를 시작하기 전에 시스템이 필요한 요구 사항을 충족하는지 확인하세요. 3B 또는 8B 매개변수 버전과 같은 작은 모델의 경우, 최소 16GB의 RAM이 필요하며, 70B와 같은 큰 모델은 원활한 실행을 위해 64GB 이상의 RAM이 필요할 수 있습니다. CUDA 지원이 있는 NVIDIA 카드와 같은 호환 가능한 GPU는 모델 추론을 크게 가속화하므로 강력히 권장됩니다.

Python 3.8 이상도 설치해야 합니다. 이는 Ollama의 Python 라이브러리 및 기타 관련 도구의 종속성이기 때문입니다.

그 후, Ollama를 공식 웹사이트 또는 GitHub 리포지토리에서 다운로드하여 설치하고 운영 체제에 맞는 지침을 따르세요. 저장 공간도 중요한 요소입니다. Cogito 모델은 3B 모델의 경우 수 기가바이트에서 70B 모델의 경우 100GB 이상일 수 있으므로 시스템에 충분한 공간이 있는지 확인하세요. 마지막으로 Cogito를 API와 통합할 계획이라면 Apidog가 설치되어 있어야 API 엔드포인트를 효율적으로 설계하고 테스트하여 원활한 개발 경험을 보장합니다.

1단계: 머신에 Ollama 설치하기

Cogito를 로컬에서 실행하는 첫 번째 단계는 머신에 Ollama를 설치하는 것입니다. Ollama 웹사이트 또는 GitHub 페이지를 방문하여 운영 체제에 맞는 설치 프로그램을 다운로드하세요. MacOS 및 Windows 사용자라면 설치 프로그램을 실행하고 화면의 안내에 따라 설정을 완료하면 됩니다. Linux를 사용하는 경우 다음 명령어를 실행하여 Ollama를 직접 설치할 수 있습니다:

curl -fsSL https://ollama.com/install.sh | sh를 터미널에 입력하세요.

설치가 완료되면 터미널을 열고 ollama --version을 입력하여 Ollama가 올바르게 설치되었는지 확인하세요.

Ollama가 실행되고 있는지 확인하려면 ollama serve를 실행하세요. 이 명령은 모델 관리를 위한 로컬 서버를 시작하며, Ollama의 명령줄 인터페이스를 설정합니다. 이후 단계에서 Cogito와 같은 모델을 가져오고 실행하는 데 사용할 것입니다.

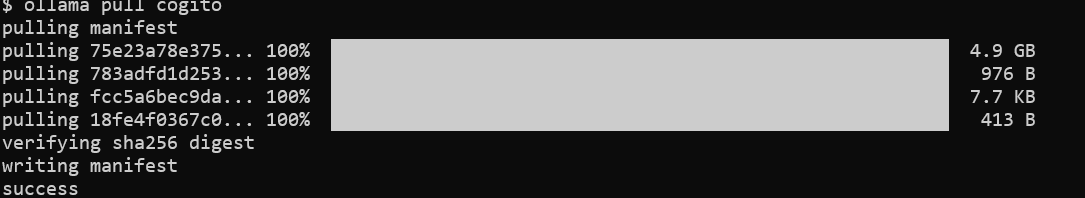

2단계: Ollama의 라이브러리에서 Cogito 모델 끌어오기

Ollama가 설치되었으므로, 다음 단계는 Cogito 모델을 다운로드하는 것입니다. 터미널을 열고 ollama pull cogito 명령어를 실행하여 Ollama의 라이브러리에서 Cogito 모델을 가져옵니다.

기본적으로 이 명령은 Cogito 모델의 최신 버전을 가져오지만, ollama pull cogito:3b와 같이 태그를 사용하여 특정 크기를 지정할 수 있습니다. 사용 가능한 모델 크기는 https://ollama.com/library/cogito에서 확인하세요.

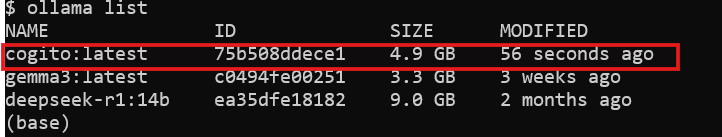

인터넷 속도 및 모델 크기에 따라 다운로드 과정은 시간이 걸릴 수 있습니다. 3B 모델은 약 2.2GB, 70B 모델은 최대 43GB이므로 이를 감안해야 합니다. 다운로드가 완료된 후 ollama list를 실행하여 모델이 시스템에 있는지 확인하세요. 이 시점에서 Cogito는 로컬에서 실행할 준비가 되었으며, 다음 단계로 진행할 수 있습니다.

3단계: Ollama로 Cogito 로컬 실행하기

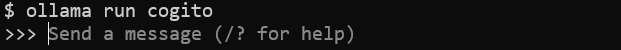

모델이 다운로드된 후, 머신에서 Cogito를 실행할 수 있습니다. 터미널에서 ollama run cogito 명령어를 실행하여 Cogito 모델을 실행합니다.

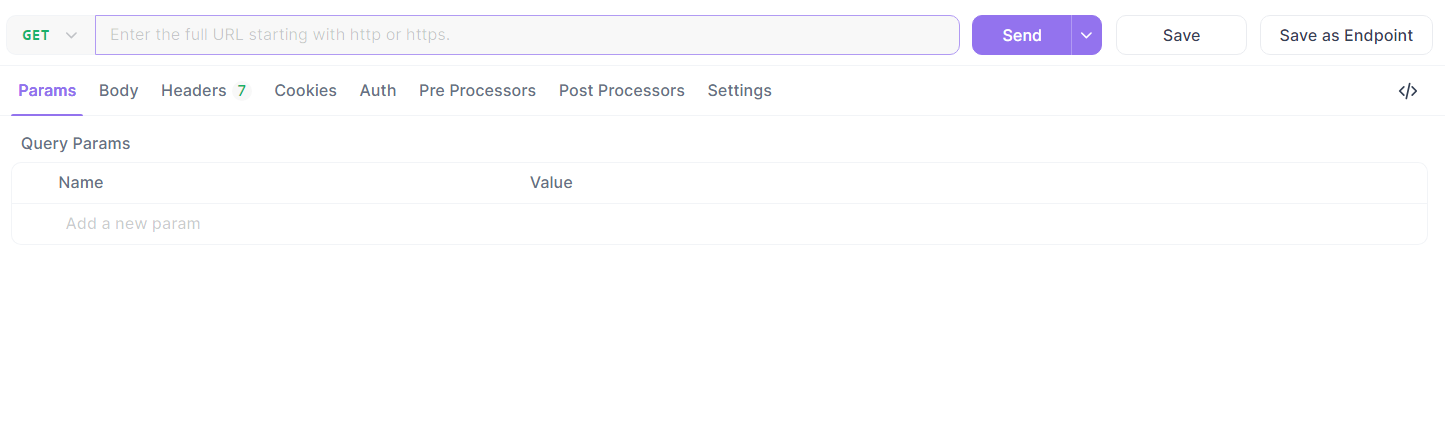

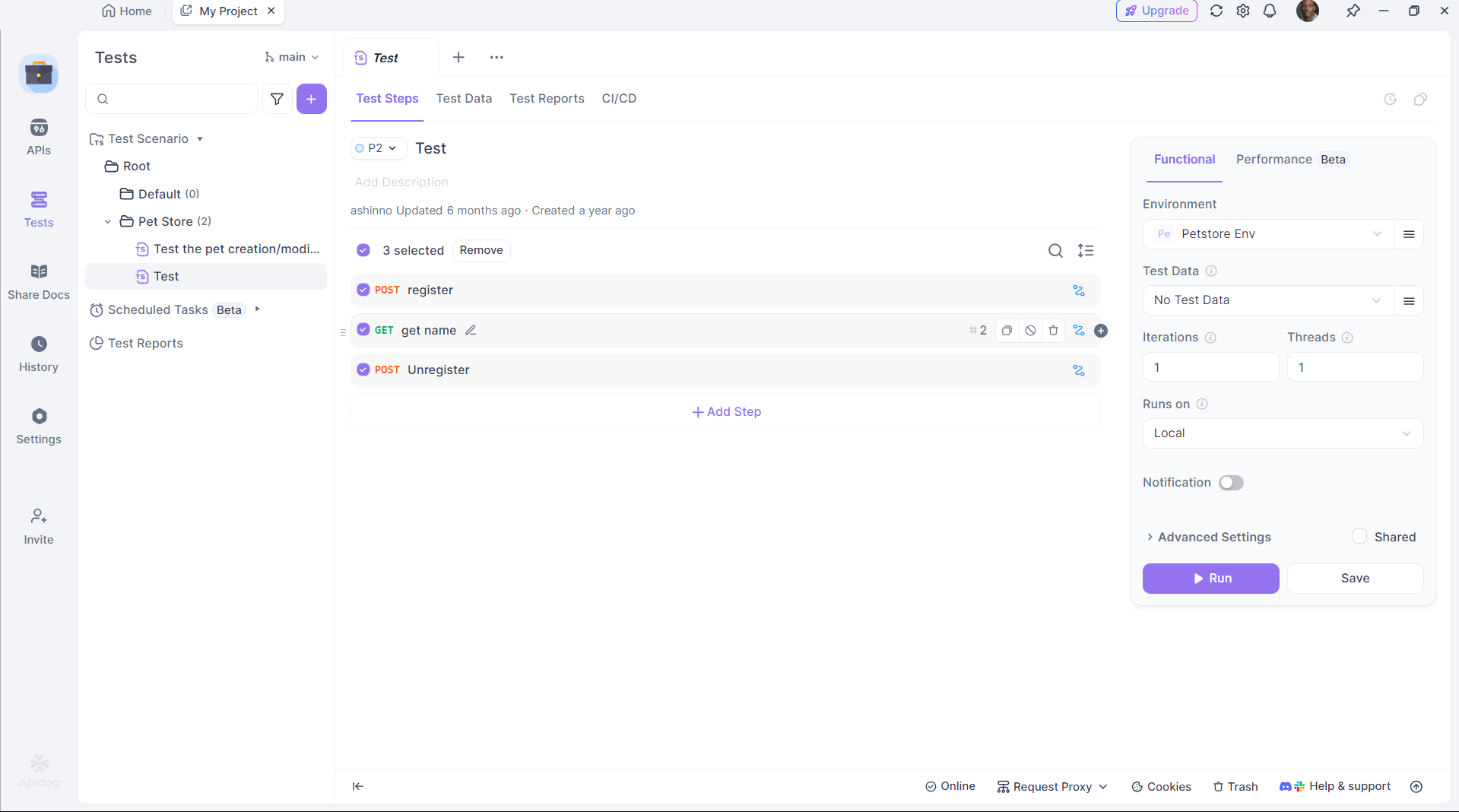

4단계: Apidog로 API 테스트 강화하기

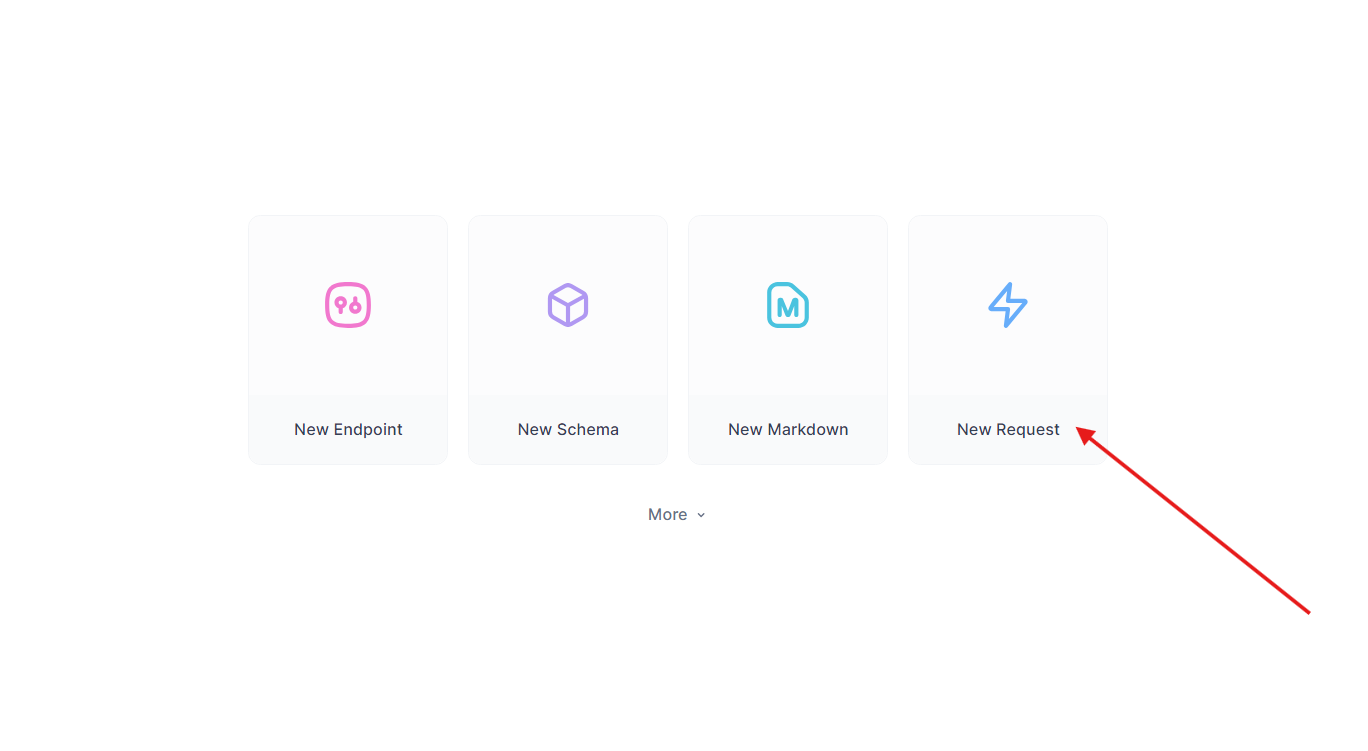

Cogito는 API 코드를 생성하는 데 뛰어나지만, 이러한 API를 테스트하는 것이 중요합니다. Apidog는 이 프로세스를 간소화합니다:

Apidog 설치하기:

공식 사이트에서 Apidog를 다운로드하고 설치합니다.

생성된 API 테스트하기:

앞서 만든 Flask 엔드포인트를 사용합니다. Apidog에서:

- 새 요청을 생성합니다.

- URL을

http://localhost:5000/api/data로 설정하고 GET 요청을 보냅니다.

- 응답 확인:

{"message": "Hello, World!"}.

테스트 자동화하기:

Apidog의 스크립팅을 사용하여 검증을 자동화하여 DeepCoder의 출력이 기대에 부합하는지 확인합니다.

Apidog은 코드 생성과 배포 사이의 간극을 메우고 생산성을 향상시킵니다.

일반적인 문제 해결

Cogito를 로컬에서 실행하는 데 때때로 어려움이 있을 수 있지만, 대부분의 문제는 몇 가지 점검으로 해결할 수 있습니다. Ollama가 시작되지 않는 경우, 다른 프로세스가 포트 11434를 사용하고 있는지 확인하세요. 충돌하는 프로세스를 종료하거나 Ollama 구성에서 포트를 변경해야 합니다. "메모리 부족" 오류의 경우, 모델 크기를 줄이거나 시스템의 스왑 공간을 늘려서 더 큰 모델을 수용할 수 있도록 고려하세요. 모델이 반응하지 않는 경우, ollama pull cogito를 사용하여 올바르게 가져왔는지 확인하고 ollama list 출력에 나타나는지 확인하세요. 느린 추론 시간은 종종 CPU만으로 실행되고 있음을 나타내므로, nvidia-smi를 실행하여 GPU 지원이 활성화되어 있는지 확인하세요.

API 통합을 위해 Apidog를 사용할 때, 잘못된 JSON 페이로드로 인해 오류가 발생할 수 있으므로 Apidog의 편집기에서 스키마를 다시 확인하세요. 더 자세한 진단을 위해 ~/.ollama/logs에서 Ollama의 로그를 검토하여 문제를 신속하게 식별하고 해결하세요.

결론

Ollama로 Cogito를 로컬에서 실행하면 일반적인 슈퍼 인공지능을 탐구하고자 하는 개발자에게 많은 가능성을 열어줍니다. 이 가이드에 설명된 단계를 따르면 머신에 Cogito를 설정하고 성능을 최적화하며, Apidog를 통해 관리되는 API를 사용하여 더 큰 애플리케이션에 통합할 수 있습니다. RAG 시스템, 코딩 어시스턴트 또는 웹 애플리케이션을 구축하고 있든 Cogito의 고급 기능은 혁신을 위한 강력한 도구가 됩니다. DeepCogito 팀이 더 큰 모델을 출시하고 기술을 지속적으로 개선함에 따라 로컬 AI 개발의 잠재력은 계속해서 증가할 것입니다. 이를 통해 개발자는 획기적인 솔루션을 창출할 수 있습니다.