알리바바 클라우드의 Qwen 팀이 대규모 언어 모델(LLM) 라인업에 두 가지 강력한 모델인 Qwen3-4B-Instruct-2507과 Qwen3-4B-Thinking-2507을 출시했습니다. 이 모델들은 추론, 지시 따르기, 긴 컨텍스트 이해 능력에서 상당한 발전을 가져왔으며, 256K 토큰 컨텍스트 길이를 기본으로 지원합니다. 개발자, 연구원 및 AI 애호가를 위해 설계된 이 모델들은 코딩부터 복잡한 문제 해결에 이르는 다양한 작업에 강력한 기능을 제공합니다. 또한, 무료 API 관리 플랫폼인 Apidog와 같은 도구는 이러한 모델을 애플리케이션에 통합하고 테스트하는 과정을 간소화할 수 있습니다.

Qwen3-4B 모델 이해하기

Qwen3 시리즈는 알리바바 클라우드의 대규모 언어 모델 제품군의 최신 진화를 나타내며, Qwen2.5 시리즈의 후속작입니다. 특히, Qwen3-4B-Instruct-2507과 Qwen3-4B-Thinking-2507은 각각 다른 사용 사례에 맞춰져 있습니다. 전자는 일반적인 대화 및 지시 따르기에 뛰어나고, 후자는 복잡한 추론 작업에 최적화되어 있습니다. 두 모델 모두 262,144 토큰의 기본 컨텍스트 길이를 지원하여 방대한 데이터셋, 긴 문서 또는 다중 턴 대화를 쉽게 처리할 수 있습니다. 또한, Hugging Face Transformers와 같은 프레임워크 및 Apidog와 같은 배포 도구와의 호환성 덕분에 로컬 및 클라우드 기반 애플리케이션 모두에서 접근할 수 있습니다.

Qwen3-4B-Instruct-2507: 효율성을 위한 최적화

Qwen3-4B-Instruct-2507 모델은 비사고 모드로 작동하며, 일반적인 작업에 대한 효율적이고 고품질의 응답에 중점을 둡니다. 이 모델은 지시 따르기, 논리적 추론, 텍스트 이해 및 다국어 기능을 향상시키기 위해 미세 조정되었습니다. 특히, <think></think> 블록을 생성하지 않아 단계별 추론보다 빠르고 직접적인 답변이 선호되는 시나리오에 이상적입니다.

주요 개선 사항은 다음과 같습니다:

- 향상된 일반 기능: 이 모델은 수학, 과학, 코딩 및 도구 사용에서 우수한 성능을 보여 기술 애플리케이션에 다용도로 활용될 수 있습니다.

- 다국어 지원: 100개 이상의 언어와 방언을 지원하여 글로벌 애플리케이션에서 강력한 성능을 보장합니다.

- 긴 컨텍스트 이해: 256K 토큰 컨텍스트 길이를 통해 법률 문서나 긴 코드베이스와 같은 확장된 입력을 잘림 없이 처리합니다.

- 사용자 선호도와의 정렬: 이 모델은 더 자연스럽고 매력적인 응답을 제공하며, 창의적인 글쓰기 및 다중 턴 대화에서 탁월합니다.

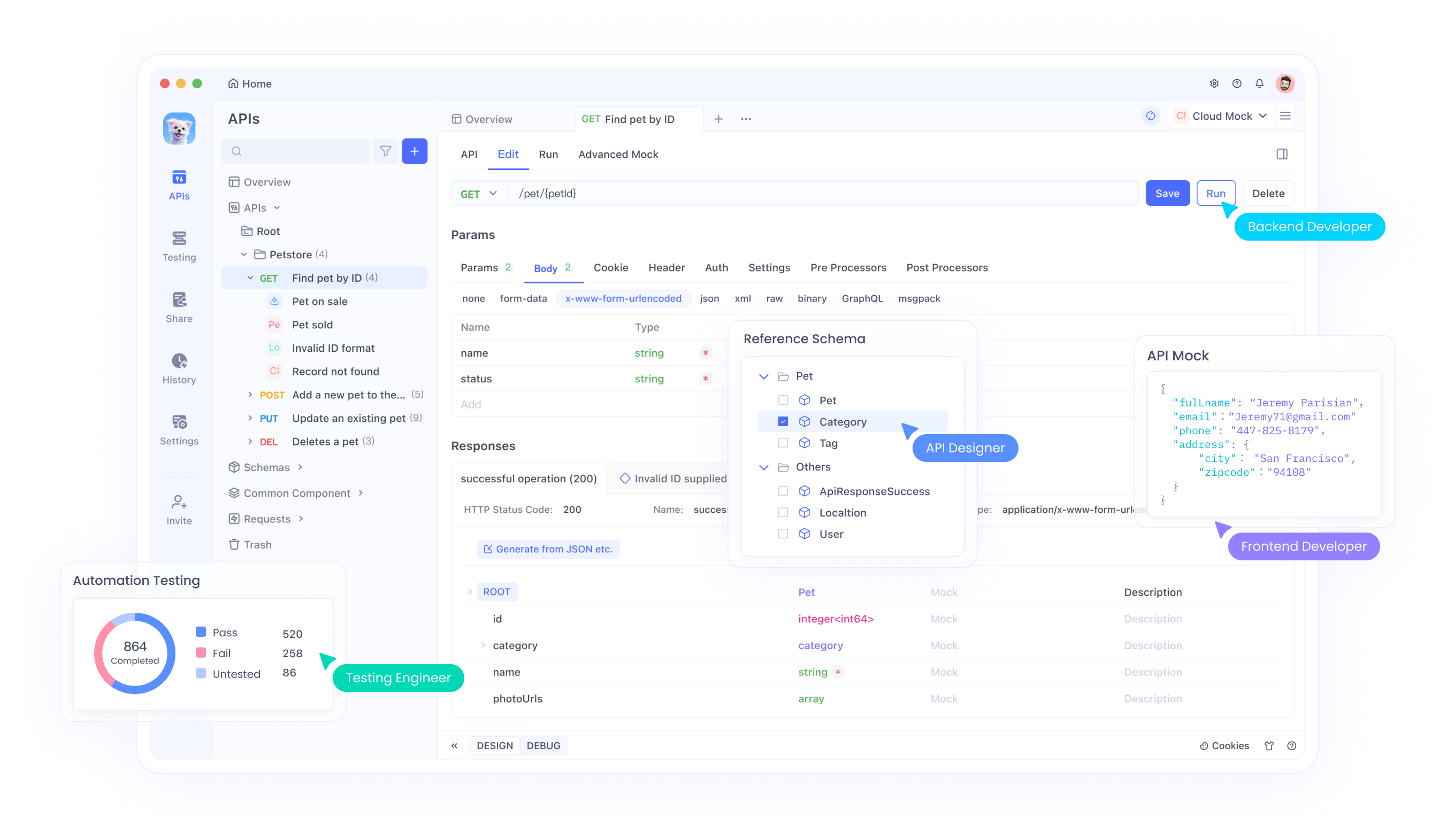

이 모델을 API에 통합하는 개발자를 위해 Apidog는 API 엔드포인트를 테스트하고 관리하는 사용자 친화적인 인터페이스를 제공하여 원활한 배포를 보장합니다. 이러한 효율성 덕분에 Qwen3-4B-Instruct-2507은 빠르고 정확한 응답이 필요한 애플리케이션에 탁월한 선택이 됩니다.

Qwen3-4B-Thinking-2507: 심층 추론을 위해 구축됨

대조적으로, Qwen3-4B-Thinking-2507은 논리적 문제 해결, 수학 및 학술 벤치마크와 같이 집중적인 추론이 필요한 작업을 위해 설계되었습니다. 이 모델은 오직 사고 모드에서 작동하며, 복잡한 문제를 분해하기 위해 사고 연쇄(CoT) 프로세스를 자동으로 통합합니다. 기본 채팅 템플릿에 사고 동작이 내장되어 있으므로, 출력에는 여는 <think> 태그 없이 닫는 </think> 태그만 포함될 수 있습니다.

주요 개선 사항은 다음과 같습니다:

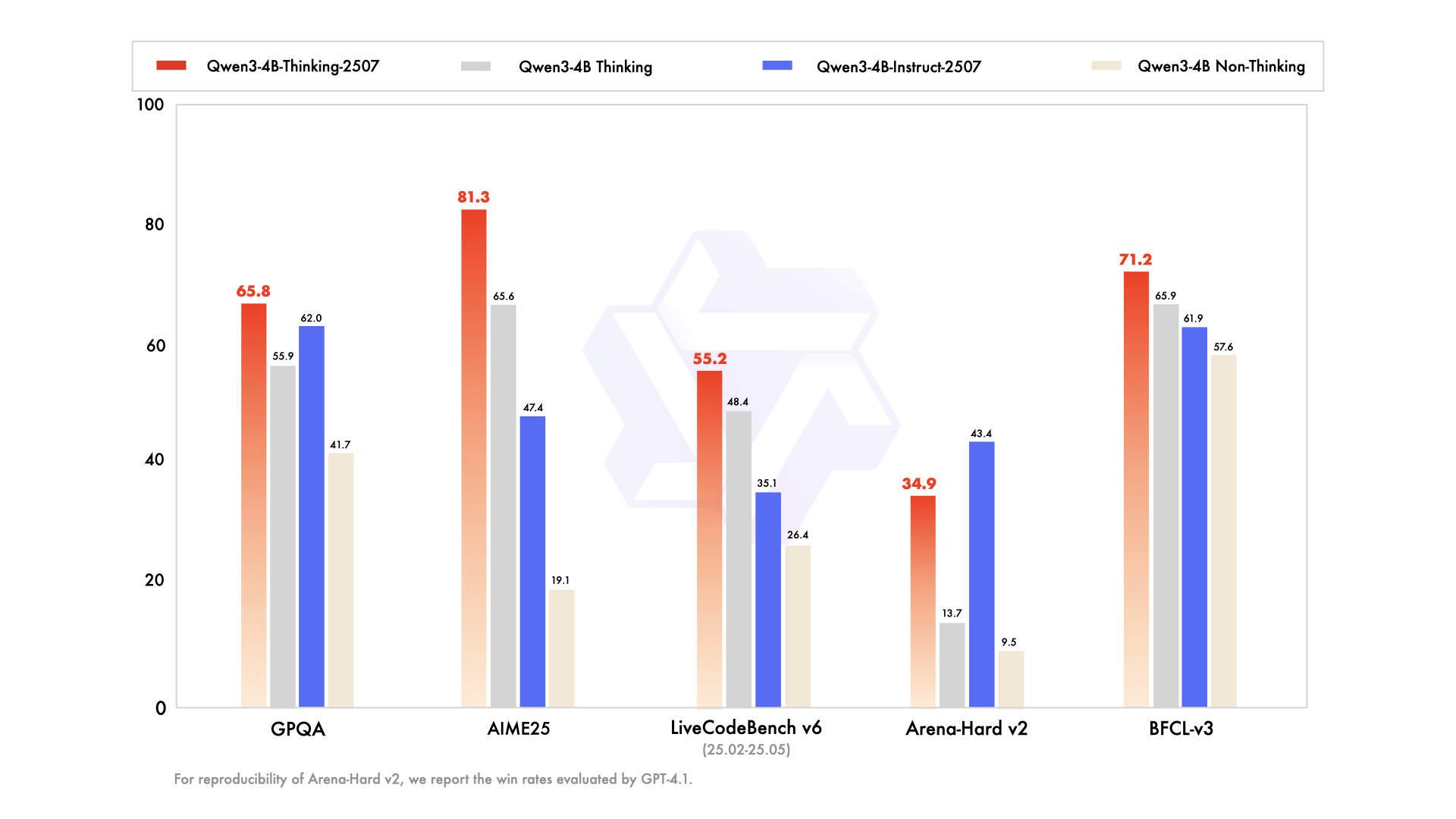

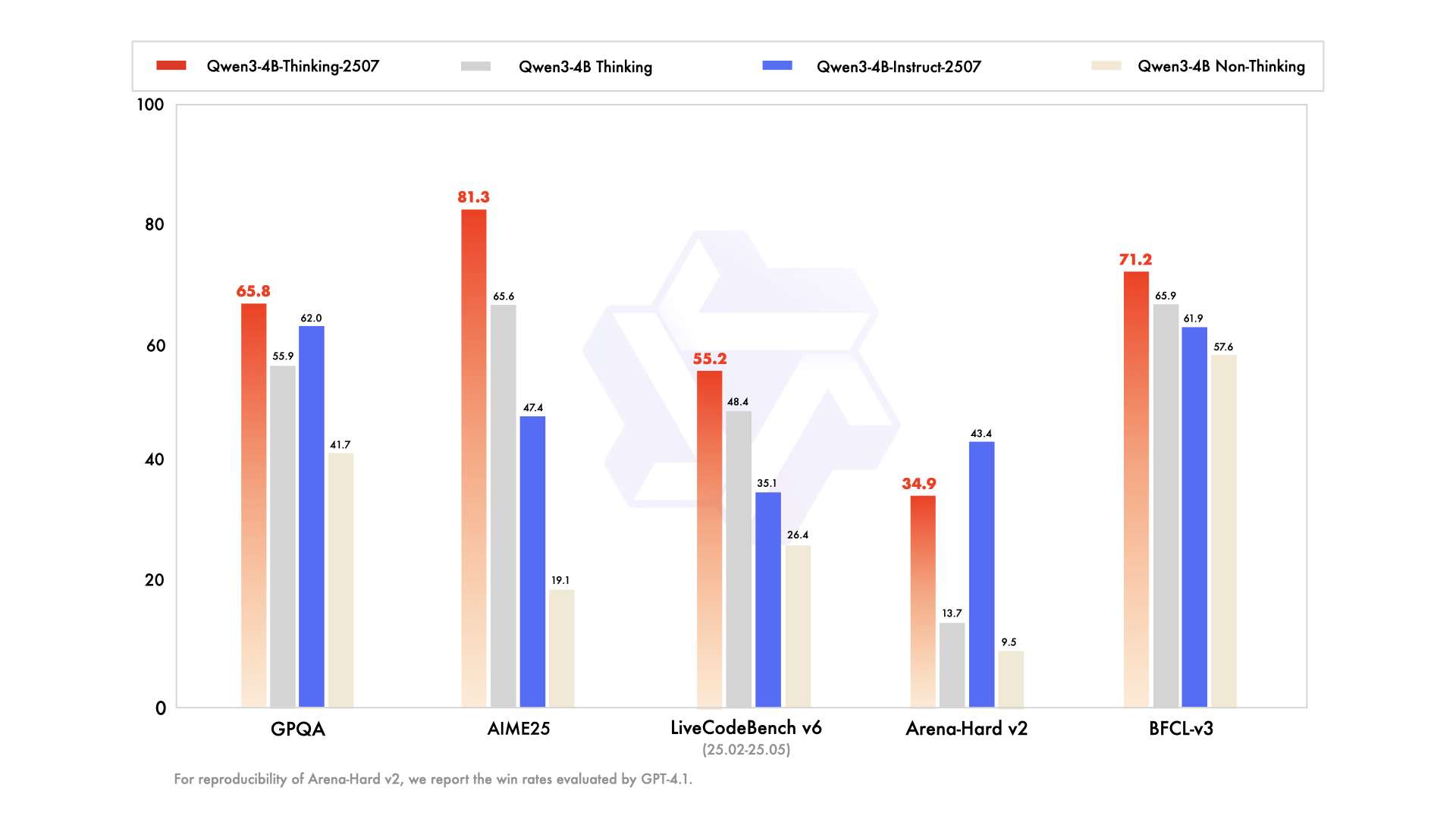

- 고급 추론 기능: 이 모델은 특히 STEM 분야 및 코딩에서 오픈 소스 사고 모델 중 최첨단 결과를 달성합니다.

- 증가된 사고 깊이: 인간 전문가 수준의 추론이 필요한 작업에서 탁월하며, 철저한 분석을 위한 확장된 사고 길이를 제공합니다.

- 256K 컨텍스트 길이: Instruct 모델과 마찬가지로, 대규모 데이터셋 또는 복잡한 쿼리 처리에 이상적인 방대한 컨텍스트 창을 지원합니다.

- 도구 통합: 이 모델은 Qwen-Agent와 같은 도구를 활용하여 간소화된 에이전트 워크플로우를 가능하게 하며, 자동화된 시스템에서의 유용성을 향상시킵니다.

추론 집약적인 애플리케이션을 다루는 개발자를 위해 Apidog는 API 테스트를 용이하게 하여 모델의 출력이 예상 결과와 일치하는지 확인합니다. 이 모델은 연구 환경 및 복잡한 문제 해결 시나리오에 특히 적합합니다.

기술 사양 및 아키텍처

두 Qwen3-4B 모델은 밀집(dense) 및 전문가 혼합(MoE) 아키텍처를 포함하는 Qwen3 제품군의 일부입니다. 4B라는 명칭은 40억 개의 매개변수를 의미하며, 계산 효율성과 성능 사이의 균형을 이룹니다. 결과적으로, 이 모델들은 상당한 자원을 요구하는 Qwen3-235B-A22B와 같은 더 큰 모델과 달리 소비자 등급 하드웨어에서 접근할 수 있습니다.

아키텍처 주요 특징

- 밀집 모델 설계: MoE 모델과 달리 Qwen3-4B 모델은 밀집 아키텍처를 사용하여 선택적 매개변수 활성화 없이도 작업 전반에 걸쳐 일관된 성능을 보장합니다.

- 컨텍스트 확장을 위한 YaRN: 이 모델들은 YaRN을 활용하여 컨텍스트 길이를 32,768 토큰에서 262,144 토큰으로 확장하여 상당한 성능 저하 없이 긴 컨텍스트 처리를 가능하게 합니다.

- 훈련 파이프라인: Qwen 팀은 긴 사고 연쇄 콜드 스타트, 추론 기반 강화 학습, 사고 모드 융합 및 일반 강화 학습을 포함하는 4단계 훈련 프로세스를 사용했습니다. 이 접근 방식은 추론 및 대화 기능을 모두 향상시킵니다.

- 양자화 지원: 두 모델 모두 FP8 양자화를 지원하여 정확도를 유지하면서 메모리 요구 사항을 줄입니다. 예를 들어, Qwen3-4B-Thinking-2507-FP8은 자원 제약이 있는 환경에서 사용할 수 있습니다.

하드웨어 요구 사항

이 모델들을 효율적으로 실행하려면 다음을 고려하세요:

- GPU 메모리: FP8 양자화 모델의 경우 최소 8GB VRAM이 권장되며, bfloat16 모델은 16GB 이상이 필요할 수 있습니다.

- RAM: 최적의 성능을 위해 16GB의 통합 메모리(VRAM + RAM)는 대부분의 작업에 충분합니다.

- 추론 프레임워크: 두 모델 모두 Hugging Face Transformers(버전 ≥4.51.0), vLLM(≥0.8.5) 및 SGLang(≥0.4.6.post1)과 호환됩니다. Ollama 및 LMStudio와 같은 로컬 도구도 Qwen3을 지원합니다.

이 모델들을 배포하는 개발자를 위해 Apidog는 API 성능을 모니터링하고 테스트하는 도구를 제공하여 추론 프레임워크와의 효율적인 통합을 보장함으로써 프로세스를 간소화합니다.

Hugging Face 및 ModelScope와의 통합

Qwen3-4B 모델은 Hugging Face와 ModelScope 모두에서 사용할 수 있어 개발자에게 유연성을 제공합니다. 아래에서는 Hugging Face Transformers와 함께 Qwen3-4B-Instruct-2507을 사용하는 방법을 보여주는 코드 스니펫을 제공합니다.

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen3-4B-Instruct-2507"tokenizer = AutoTokenizer.from_pretrained(model_name)model = AutoModelForCausalLM.from_pretrained(model_name, torch_dtype="auto", device_map="auto")

prompt = "Write a Python function to calculate Fibonacci numbers."messages = [{"role": "user", "content": prompt}]text = tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

generated_ids = model.generate(**model_inputs, max_new_tokens=16384)output_ids = generated_ids[0][len(model_inputs.input_ids[0]):].tolist()content = tokenizer.decode(output_ids, skip_special_tokens=True)print("Generated Code:\n", content)Qwen3-4B-Thinking-2507의 경우, 사고 내용을 처리하기 위해 추가적인 파싱이 필요합니다:

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen3-4B-Thinking-2507"tokenizer = AutoTokenizer.from_pretrained(model_name)model = AutoModelForCausalLM.from_pretrained(model_name, torch_dtype="auto", device_map="auto")

prompt = "Solve the equation 2x^2 + 3x - 5 = 0."messages = [{"role": "user", "content": prompt}]text = tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

generated_ids = model.generate(**model_inputs, max_new_tokens=32768)output_ids = generated_ids[0][len(model_inputs.input_ids[0]):].tolist()

try:index = len(output_ids) - output_ids[::-1].index(151668) # tokenexcept ValueError:index = 0thinking_content = tokenizer.decode(output_ids[:index], skip_special_tokens=True).strip("\n")content = tokenizer.decode(output_ids[index:], skip_special_tokens=True).strip("\n")print("Thinking Process:\n", thinking_content)print("Solution:\n", content)이 스니펫들은 Qwen 모델을 Python 워크플로우에 쉽게 통합할 수 있음을 보여줍니다. API 기반 배포의 경우, Apidog는 이러한 엔드포인트를 테스트하여 신뢰할 수 있는 성능을 보장하는 데 도움을 줄 수 있습니다.

성능 최적화 및 모범 사례

Qwen3-4B 모델의 성능을 극대화하려면 다음 권장 사항을 고려하세요:

- 샘플링 매개변수: Qwen3-4B-Instruct-2507의 경우

temperature=0.7,top_p=0.8,top_k=20,min_p=0을 사용하세요. Qwen3-4B-Thinking-2507의 경우temperature=0.6,top_p=0.95,top_k=20,min_p=0을 사용하세요. 성능 저하를 방지하기 위해 탐욕적 디코딩은 피하세요. - 컨텍스트 길이 관리: 메모리 부족 문제가 발생하면 컨텍스트 길이를 32,768 토큰으로 줄이세요. 하지만 추론 작업의 경우 131,072 토큰 이상의 컨텍스트 길이를 유지하세요.

- 존재 페널티: 반복을 줄이기 위해

presence_penalty를 0에서 2 사이로 설정하되, 언어 혼합을 방지하기 위해 높은 값은 피하세요. - 추론 프레임워크: 고처리량 추론을 위해 vLLM 또는 SGLang을 사용하고, Apidog를 활용하여 API 성능을 모니터링하세요.

Qwen3-4B-Instruct-2507과 Qwen3-4B-Thinking-2507 비교

두 모델 모두 40억 개의 매개변수 아키텍처를 공유하지만, 설계 철학은 다릅니다:

- Qwen3-4B-Instruct-2507: 속도와 효율성을 우선시하여 챗봇, 고객 지원 및 범용 애플리케이션에 적합합니다.

- Qwen3-4B-Thinking-2507: 심층 추론에 중점을 두어 학술 연구, 복잡한 문제 해결 및 사고 연쇄 프로세스가 필요한 작업에 이상적입니다.

개발자는 /think 및 /no_think 프롬프트를 사용하여 모드를 전환할 수 있어 작업 요구 사항에 따라 유연성을 제공합니다. Apidog는 API 기반 애플리케이션에서 이러한 모드 전환을 테스트하는 데 도움을 줄 수 있습니다.

커뮤니티 및 생태계 지원

Qwen3-4B 모델은 Hugging Face, ModelScope, 그리고 Ollama, LMStudio, llama.cpp와 같은 도구들의 지원을 받아 강력한 생태계의 혜택을 누립니다. Apache 2.0 라이선스 하에 오픈 소스로 공개된 이 모델들은 커뮤니티 기여 및 미세 조정을 장려합니다. 예를 들어, Unsloth는 70% 더 적은 VRAM으로 2배 빠른 미세 조정을 위한 도구를 제공하여 이 모델들을 더 넓은 사용자층이 접근할 수 있도록 합니다.

결론

Qwen3-4B-Instruct-2507 및 Qwen3-4B-Thinking-2507 모델은 알리바바 클라우드의 Qwen 시리즈에서 지시 따르기, 추론 및 긴 컨텍스트 처리에서 타의 추종을 불허하는 기능을 제공하며 상당한 도약을 이루었습니다. 256K 토큰 컨텍스트 길이, 다국어 지원, 그리고 Apidog와 같은 도구와의 호환성을 통해 이 모델들은 개발자들이 지능적이고 확장 가능한 애플리케이션을 구축할 수 있도록 지원합니다. 코드를 생성하거나, 방정식을 풀거나, 다국어 챗봇을 만들 때 이 모델들은 탁월한 성능을 제공합니다. 오늘 바로 잠재력을 탐색하기 시작하고, Apidog를 사용하여 원활한 개발 경험을 위해 API 통합을 간소화하세요.