터미널에 갇히지 않고 Llama 3.1 또는 Mistral과 같은 강력한 언어 모델과 채팅하고 싶으신가요? Open WebUI는 Ollama의 LLM과의 상호 작용을 재미있고 직관적으로 만들어주는 세련된 ChatGPT와 유사한 인터페이스로 가는 여러분의 길입니다. 이 인터페이스를 사용하면 채팅 기록을 저장하고, 프롬프트를 보관하며, 심지어 더 스마트한 응답을 위해 문서를 업로드할 수도 있습니다. 이 모든 것이 브라우저에서 가능합니다. 이 초보자 친화적인 가이드에서는 Ollama 설치, 터미널에서 모델 테스트, 그리고 더 사용자 친화적인 경험을 위해 Open WebUI로 한 단계 발전하는 방법을 안내해 드립니다. 빠른 설정을 위해 Docker를 사용하고 재미있는 프롬프트로 테스트해 보겠습니다. AI 채팅을 수월하게 만들 준비가 되셨나요? 시작해 봅시다!💡API를 문서화해야 하시나요? AI 프로젝트에 완벽한 세련되고 대화형 방식으로 API 문서를 설계하고 공유하려면 APIdog를 사용해 보세요!button

Open WebUI란 무엇인가요? 여러분의 LLM 커맨드 센터

Open WebUI는 Ollama에 연결되는 오픈 소스 자체 호스팅 웹 인터페이스로, Llama 3.1 또는 Mistral과 같은 대규모 언어 모델(LLM)과 브라우저 기반 대시보드에서 상호 작용할 수 있게 해줍니다. Ollama의 명령줄 인터페이스와 달리 Open WebUI는 ChatGPT처럼 느껴지며 다음을 제공합니다:

- 채팅 기록: 대화를 저장하고 다시 확인하세요.

- 프롬프트 저장: 자주 사용하는 프롬프트를 저장하고 재사용하세요.

- 문서 업로드: 컨텍스트를 인지하는 응답(검색 증강 생성, RAG)을 위해 파일을 추가하세요.

- 모델 전환: 클릭 한 번으로 모델 간에 쉽게 전환하세요.

5만 개 이상의 GitHub 스타를 받은 Open WebUI는 로컬에서 LLM과 협업적이고 그래픽적인 방식으로 작업하려는 개발자와 AI 애호가들에게 인기가 많습니다. 먼저 Ollama를 실행하여 Open WebUI를 추가할 가치가 있는지 알아보겠습니다!

Ollama 설치 및 테스트

Open WebUI를 시작하기 전에 Ollama를 설정하고 터미널에서 Llama 3.1 또는 Mistral과 같은 모델을 테스트해 보겠습니다. 이를 통해 Open WebUI의 직관적인 인터페이스를 이해하기 위한 기준점을 얻을 수 있습니다.

1. 시스템 요구 사항 확인:

- OS: Windows, macOS 또는 Linux (Ubuntu 24.04 또는 유사).

- 하드웨어: 모델을 위해 최소 16GB RAM 및 10GB 여유 저장 공간 (Llama 3.1 8B는 약 5GB 필요). GPU (예: NVIDIA 1060 4GB)는 더 빠른 성능을 위해 선택 사항입니다.

- 소프트웨어: ollama.com에서 다운로드 가능한 Ollama.

2. Ollama 설치: OS에 맞는 Ollama를 ollama.com에서 다운로드하여 설치하세요. 설치 프로그램 안내에 따르세요—빠른 설정입니다. 다음 명령으로 설치를 확인하세요:

ollama --version

0.1.44 (2025년 4월)와 같은 버전이 표시될 것입니다. 실패하면 Ollama가 PATH에 있는지 확인하세요.

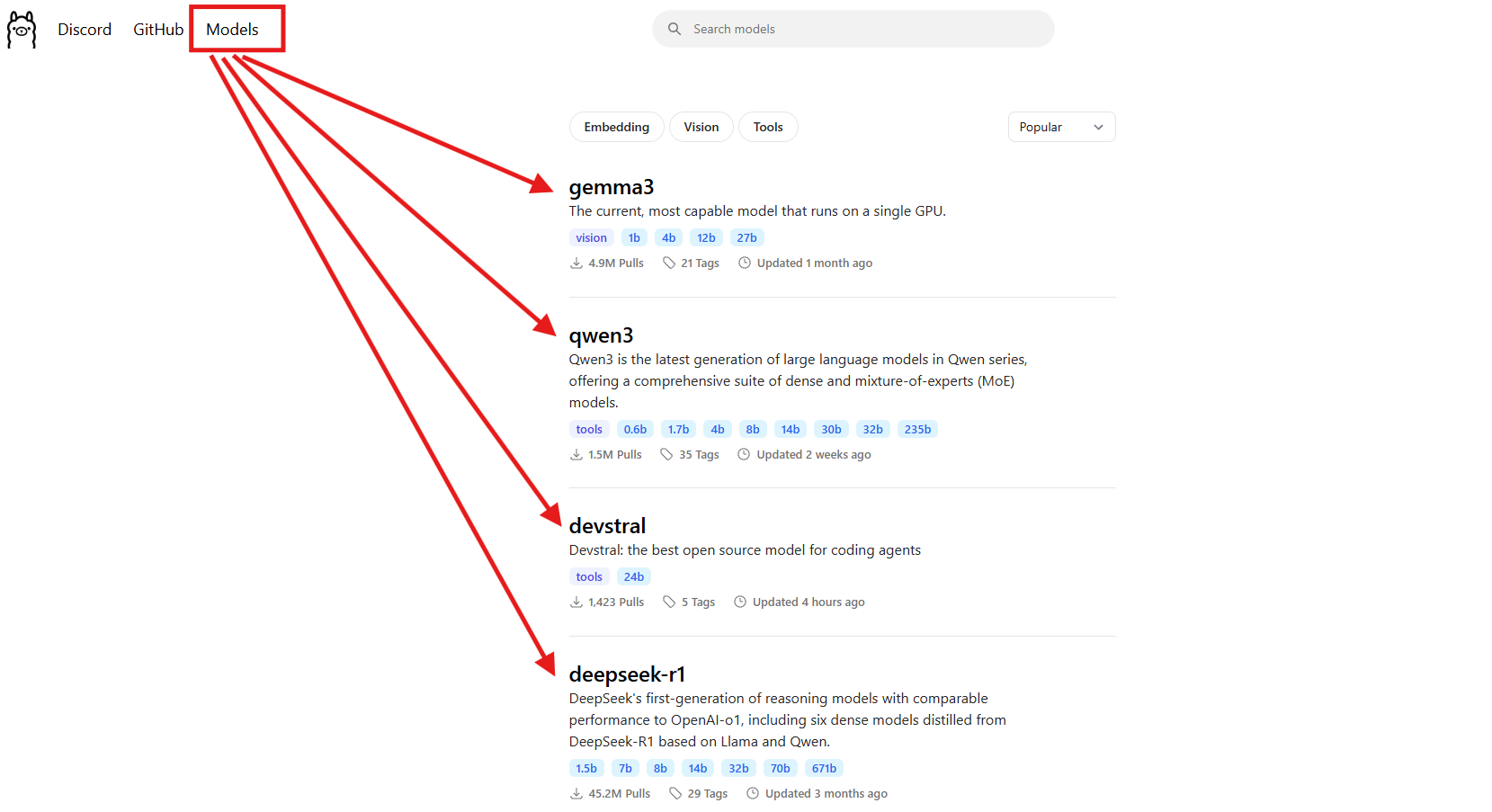

3. 모델 다운로드: Llama 3.1 (8B) 또는 Mistral (7B)과 같은 모델을 선택하세요. 이 가이드에서는 Llama 3.1을 사용합니다:

ollama pull llama3.1

약 5GB를 다운로드하므로 인터넷이 느리다면 커피 한 잔 하세요. 설치되었는지 확인하세요:

ollama list

llama3.1:latest를 찾으세요. Mistral (ollama pull mistral)은 더 가벼운 모델(약 4GB)을 원한다면 또 다른 훌륭한 옵션입니다.

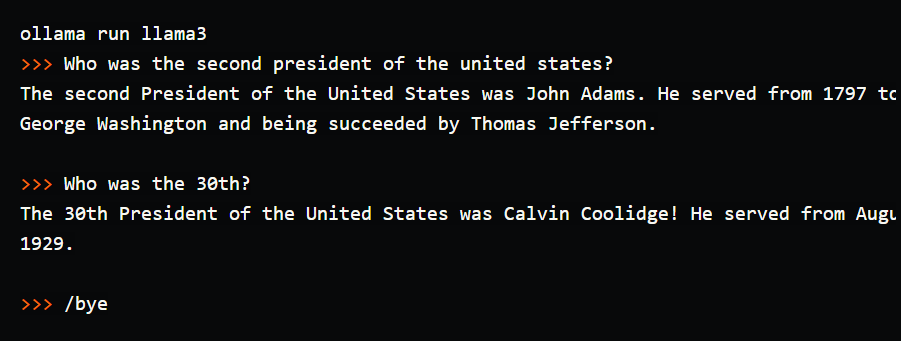

4. 터미널에서 모델 테스트: Ollama의 작동을 확인하기 위해 간단한 프롬프트를 시도해 보세요:

ollama run llama3.1

프롬프트(>>>)에서 "Tell me a dad joke about computers."라고 입력하고 Enter 키를 누르세요. "Why did the computer go to the doctor? It had a virus!"와 같은 응답을 받을 수 있습니다. /bye로 종료하세요. 저는 이걸 실행해서 웃음이 나올 만한 농담을 얻었지만, 터미널에서 입력하는 것은 불편하게 느껴졌습니다—채팅 기록도 없고 저장된 프롬프트도 없었습니다. 이것이 Open WebUI가 빛을 발하는 부분입니다. 대화를 저장하고, 프롬프트를 재사용하며, 더 풍부한 응답을 위해 문서를 업로드할 수 있는 시각적 인터페이스를 제공합니다. 이제 설정해 봅시다!

Open WebUI를 위한 환경 설정

이제 Ollama의 터미널 인터페이스를 보셨으니, LLM 경험을 더 직관적으로 만들기 위해 Open WebUI를 준비해 보겠습니다. Open WebUI 설정에 필요하므로 Docker가 설치되어 있다고 가정합니다.

1. Docker 확인: Docker가 설치 및 실행 중인지 확인하세요:

docker --version

Docker 27.4.0과 같은 결과가 예상됩니다. Docker가 없다면 공식 웹사이트에서 Docker Desktop을 다운로드하여 설치하세요—Windows, macOS 또는 Linux에서 빠르게 설정할 수 있습니다.

2. 프로젝트 폴더 생성: 정리된 상태를 유지하세요:

mkdir ollama-webui

cd ollama-webui

이 폴더는 Open WebUI를 실행하기 위한 기반이 됩니다.

3. Ollama 실행 확인: 별도의 터미널에서 Ollama를 시작하세요:

ollama serve

이 명령은 Ollama의 API를 http://localhost:11434에서 실행합니다. Open WebUI가 모델에 연결하기 위해 필요하므로 이 터미널을 열어두세요.

Docker로 Open WebUI 설치

Ollama와 Llama 3.1이 준비되었으니, 빠르고 안정적인 설정을 위해 단일 Docker 명령을 사용하여 Open WebUI를 설치해 보겠습니다.

1. Open WebUI 실행: ollama-webui 폴더에서 다음을 실행하세요:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

이 명령은 다음을 수행합니다:

- Open WebUI 이미지를 가져옵니다 (

ghcr.io/open-webui/open-webui:main, 약 3.77GB). - 브라우저 접속을 위해 로컬 포트 3000을 컨테이너 포트 8080에 매핑합니다.

host.docker.internal을 추가하여localhost:11434의 Ollama API에 연결합니다.- 볼륨(

open-webui)을 사용하여 채팅 기록 및 설정을 유지합니다. - 컨테이너 이름을

open-webui로 지정하고 자동으로 다시 시작하도록 설정합니다.

다운로드에는 시간이 걸립니다. docker ps로 실행 중인지 확인하세요—open-webui 컨테이너를 찾으세요.

2. Open WebUI 접속: 브라우저를 열고 http://localhost:3000으로 이동하세요. Open WebUI의 환영 페이지가 표시될 것입니다. "Sign Up"을 클릭하여 계정을 만드세요 (첫 번째 사용자는 관리자 권한을 얻습니다). 강력한 비밀번호를 사용하고 안전하게 저장하세요. 이제 채팅할 준비가 되었습니다! 페이지가 로드되지 않으면 컨테이너가 실행 중인지(docker logs open-webui) 확인하고 포트 3000이 사용 가능한지 확인하세요.

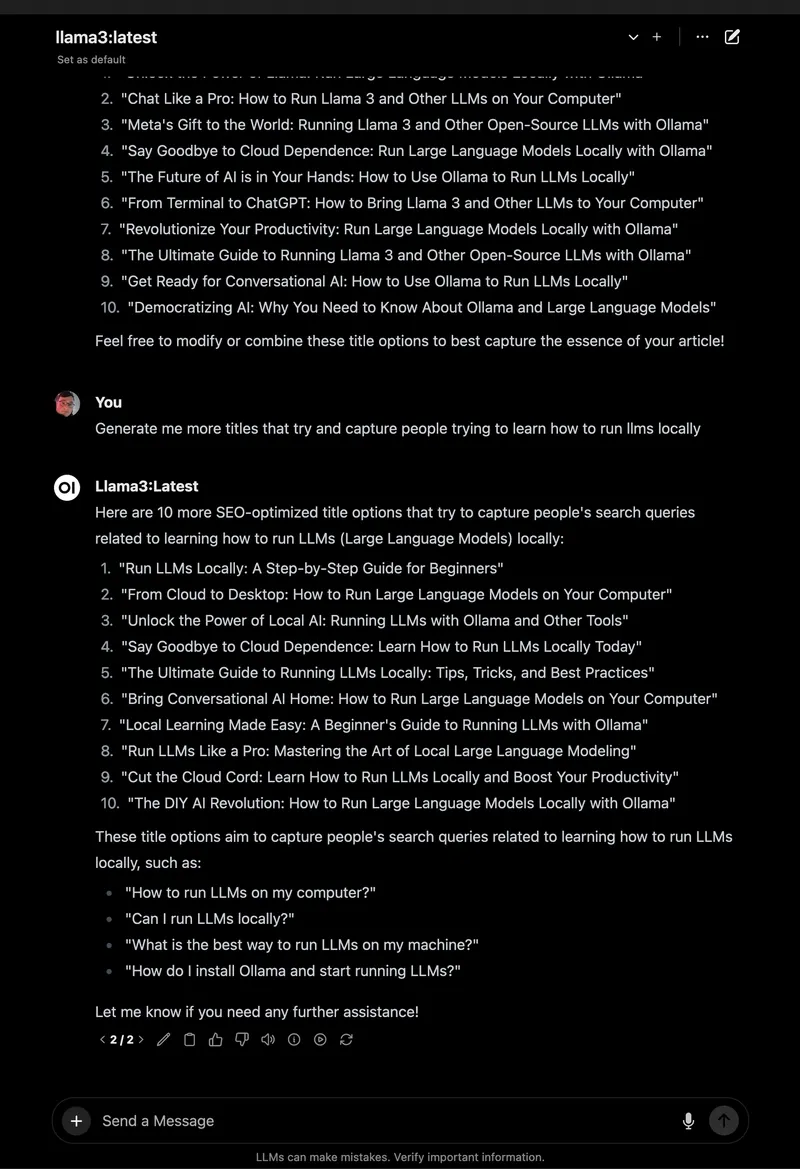

Open WebUI 사용: 채팅 및 기능 탐색

Open WebUI가 실행 중이니, Llama 3.1과 채팅하고 터미널보다 훨씬 향상된 훌륭한 기능을 탐색해 봅시다.

1. 채팅 시작:

- Open WebUI에서 좌측 상단 모델 선택기에서

llama3.1:8b를 선택하세요 (가져왔으므로 나타나야 합니다). - 사이드바에서 "New Chat"을 클릭하세요.

- 동일한 프롬프트 "Tell me a dad joke about computers."를 입력하세요.

- Enter 키를 누르세요. "Why did the computer go to art school? Because it wanted to learn to draw a better byte!"와 같은 응답을 받을 것입니다.

인터페이스는 깔끔하며, 프롬프트와 응답이 채팅 기록에 자동으로 저장됩니다.

2. 채팅 저장 및 정리: 왼쪽 사이드바에서 핀 아이콘을 클릭하여 채팅을 저장하세요. 쉽게 접근할 수 있도록 이름을 변경하세요 (예: "아재 개그"). 사이드바를 통해 채팅을 보관하거나 삭제하여 실험 내용을 정리된 상태로 유지할 수 있습니다—터미널 스크롤보다 훨씬 좋습니다!

3. 프롬프트 저장: 아재 개그 프롬프트를 재사용하기 위해 저장하세요:

- 설정 > 프롬프트로 이동하세요.

- "New Prompt"를 클릭하고 이름을 "아재 개그"로 지정한 후 "Tell me a dad joke about computers."를 붙여넣으세요.

- 저장하세요. 이제 한 번의 클릭으로 어떤 채팅에든 적용할 수 있습니다.

4. RAG를 위한 문서 업로드: 채팅에 컨텍스트를 추가하세요:

- 채팅 입력란에서 "#" 아이콘을 클릭하여 문서 라이브러리를 엽니다.

- 텍스트 파일 (예: Spring Boot 3.2 가이드)을 업로드하세요.

- "How do I use the REST Client in Spring Boot 3.2?"라고 질문하세요. Llama 3.1은 문서를 참조하여

RestClient.create().get().uri("/users").retrieve()와 같은 코드 스니펫을 제공할 것입니다.

저는 Python 튜토리얼 PDF로 이것을 테스트했는데, Open WebUI는 터미널의 기본적인 응답과 달리 컨텍스트를 인지하는 답변을 잘 해냈습니다.

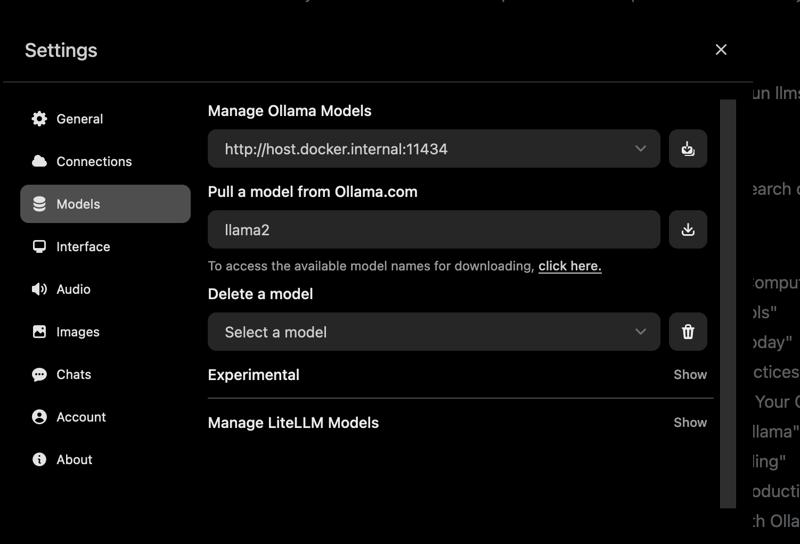

5. 더 많은 기능 탐색:

- 모델 전환: 모델 선택기를 사용하여 Mistral 또는 가져온 다른 모델을 시도해 보세요 (

ollama pull mistral). - 응답 사용자 정의: "Chat Control"을 클릭하여 어조 (예: "재미있게") 또는 길이를 조정하세요.

- 관리 도구: 설정 > 관리자에서 사용자를 관리하거나 모델 접근을 제한할 수 있습니다 (팀에 적합합니다).

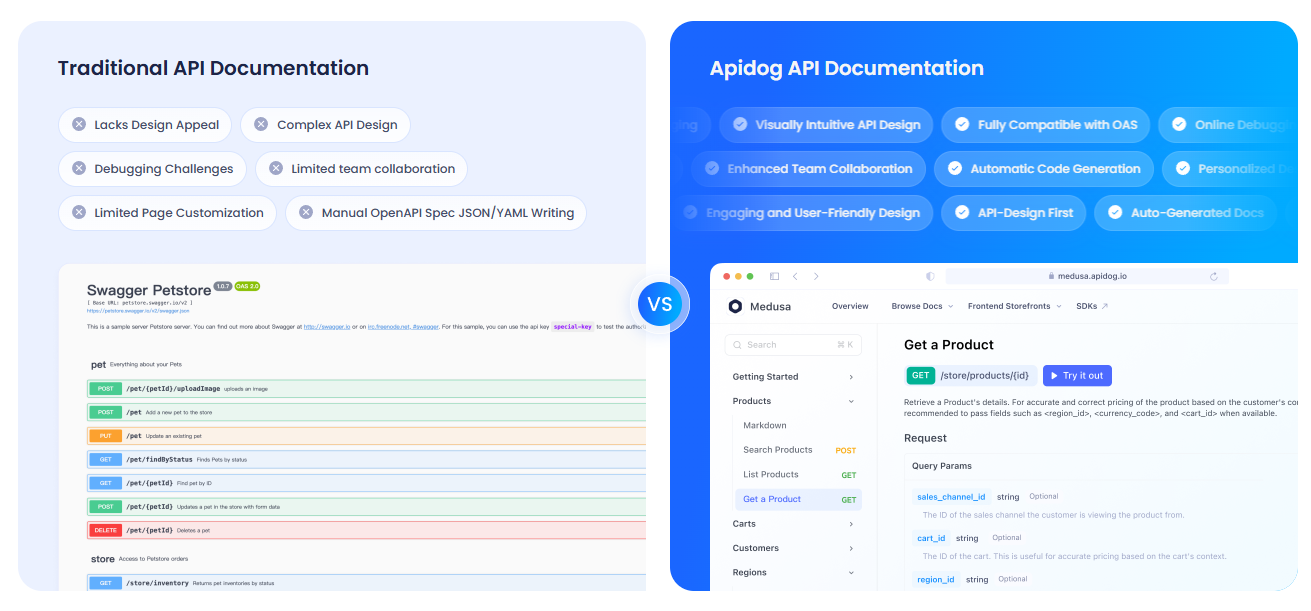

APIdog로 API 문서화

Ollama의 API와 상호 작용하기 위해 Open WebUI를 사용하고 설정을 문서화하고 싶으신가요? APIdog는 대화형 API 문서를 생성하는 훌륭한 도구입니다. 세련된 인터페이스와 자체 호스팅 옵션은 AI 프로젝트 공유에 이상적입니다—확인해 보세요!

문제 해결 및 팁

- 연결 문제: Open WebUI가 Ollama를 찾을 수 없다면,

ollama serve가 실행 중이고 포트 11434가 열려 있는지 확인하세요. Docker 로그를 확인하세요:docker logs open-webui. - 포트 충돌: 포트 3000이 사용 중이라면 컨테이너를 중지하고(

docker stop open-webui), 제거한 후(docker rm open-webui), 새 포트로docker run명령을 다시 실행하세요(예:-p 3001:8080). - 느린 응답: 속도를 위해 Ollama의

:cuda태그가 있는 GPU 또는 Mistral과 같은 더 작은 모델을 사용하세요. - 커뮤니티: 지원 및 아이디어를 얻으려면 Open WebUI의 GitHub 토론 또는 Discord에 참여하세요.

왜 Open WebUI를 선택해야 할까요?

Open WebUI는 Ollama를 투박한 터미널 도구에서 강력하고 사용자 친화적인 플랫폼으로 변환합니다:

- 직관적인 인터페이스: 브라우저 기반 대시보드는 초보자와 전문가 모두에게 완벽합니다.

- 정리: 저장된 채팅 및 프롬프트는 터미널 로그와 달리 작업을 깔끔하게 유지합니다.

- 컨텍스트 인지: 문서 업로드는 RAG를 가능하게 하여 더 스마트한 답변을 제공합니다.

- 개인 정보 보호: 로컬에서 실행되어 데이터를 안전하게 유지합니다.

터미널과 Open WebUI 모두 테스트한 후, 저는 GUI의 편리함과 기능에 매료되었습니다. 폴더폰에서 스마트폰으로 업그레이드하는 것과 같습니다!

마무리: Open WebUI 모험이 기다립니다

터미널 채팅에서 벗어나 Ollama와 함께 완전한 Open WebUI 설정을 완료하여 LLM 상호 작용을 부드럽고 재미있게 만들었습니다! Llama 3.1, 저장된 채팅, 문서 업로드를 통해 이전과는 다른 방식으로 AI를 탐색할 준비가 되었습니다. 새로운 모델을 시도하고, 더 많은 프롬프트를 저장하거나, APIdog로 API를 문서화해 보세요. Open WebUI 성공 사례를 Open WebUI GitHub에 공유하세요—여러분이 무엇을 만들지 기대됩니다! 즐거운 AI 작업 되세요!

button