대규모 언어 모델(LLM)을 로컬에서 실행하는 것은 한때 하드코어 CLI 사용자나 시스템 전문가의 영역이었습니다. 하지만 빠르게 변화하고 있습니다. 로컬 머신에서 오픈 소스 LLM을 실행하기 위한 간단한 명령줄 인터페이스로 잘 알려진 Ollama가 최근 macOS 및 Windows용 네이티브 데스크톱 앱을 출시했습니다.

이 앱들은 단순히 기본적인 래퍼가 아닙니다. 이 앱들은 모델과 채팅하고, 문서를 분석하고, 문서를 작성하고, 심지어 이미지를 다루는 것을 개발자에게 훨씬 더 쉽게 만들어주는 강력한 기능을 제공합니다.

이 글에서는 새로운 데스크톱 경험이 개발자 워크플로우를 어떻게 개선하는지, 어떤 기능이 돋보이는지, 그리고 이러한 도구들이 실제 코딩 생활에서 어디에서 빛을 발하는지 살펴보겠습니다.

로컬 LLM이 여전히 중요한 이유

ChatGPT, Claude, Gemini와 같은 클라우드 기반 도구들이 헤드라인을 장식하고 있지만, 로컬 우선 AI 개발을 향한 움직임이 커지고 있습니다. 개발자들은 다음과 같은 도구를 원합니다:

- 비공개 - 코드와 문서가 사용자의 머신에 유지됩니다.

- 맞춤 설정 가능 - 모델, 메모리 제한 및 하드웨어를 선택할 수 있습니다.

- 오프라인 친화적 - 외부 API 또는 가동 시간에 의존하지 않습니다.

- 빠름 - 네트워크 지연 또는 서버 병목 현상이 없습니다.

Ollama는 이러한 트렌드를 직접적으로 활용하여 LLaMA, Mistral, Gemma, Codellama, Mixtral 등과 같은 모델을 머신에서 기본적으로 실행할 수 있게 해주며, 이제 훨씬 더 원활한 경험을 제공합니다.

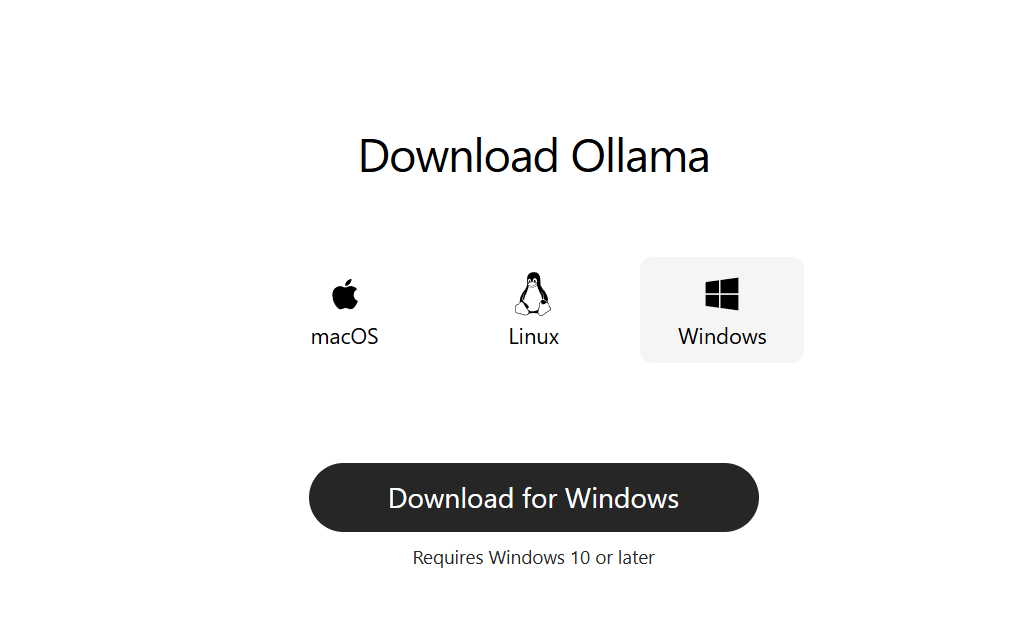

1단계: 데스크톱용 Ollama 다운로드

ollama.com으로 이동하여 시스템에 맞는 최신 버전을 다운로드하세요:

- macOS (Apple Silicon 또는 Intel)

- Windows 10/11 (x64)

일반 데스크톱 앱처럼 설치하세요. 시작하는 데 명령줄 설정이 필요하지 않습니다.

2단계: 실행 및 모델 선택

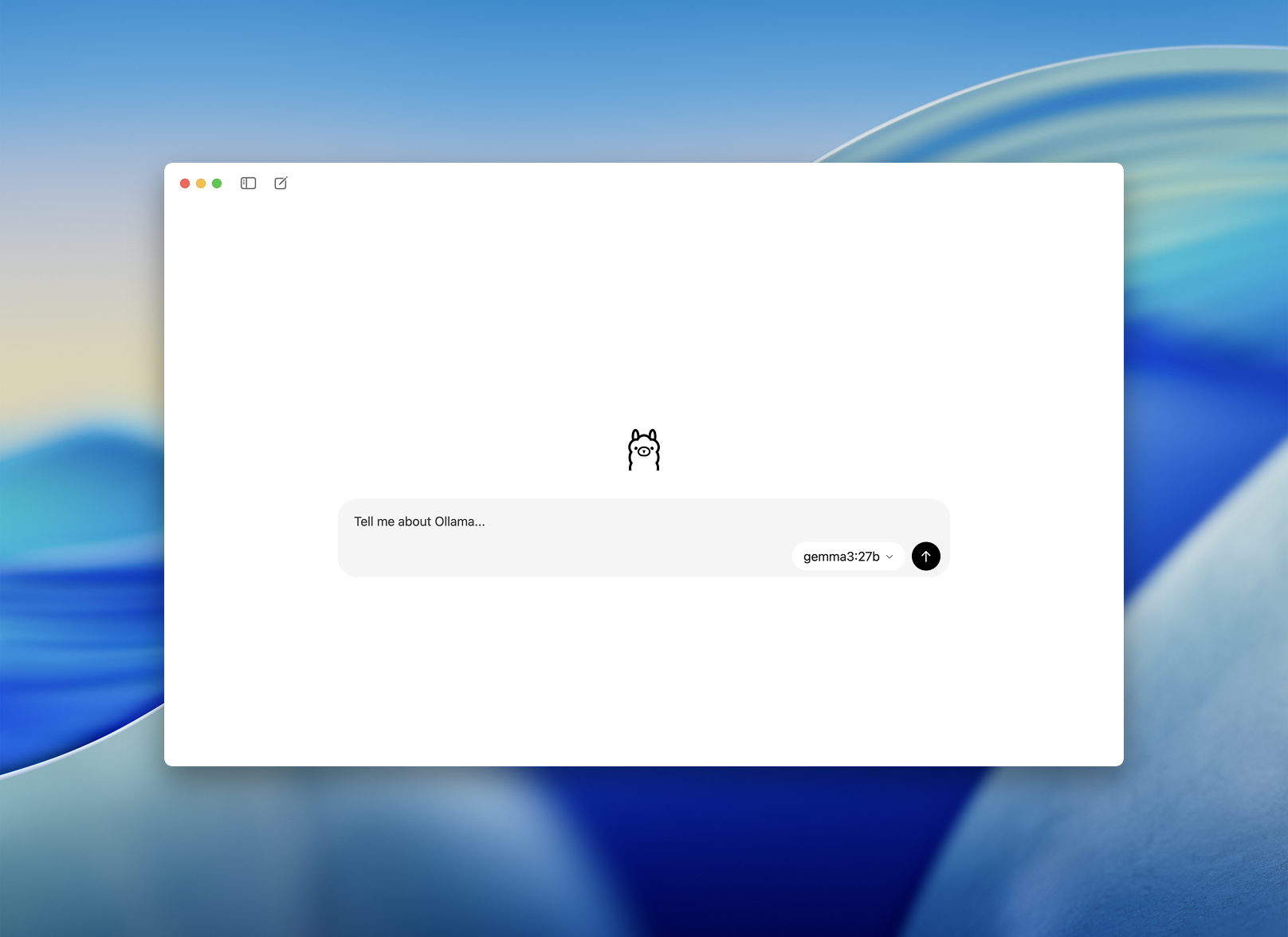

설치 후 Ollama 데스크톱 앱을 엽니다. 인터페이스는 깔끔하며 간단한 채팅 창처럼 보입니다.

다운로드하여 실행할 모델을 선택하라는 메시지가 표시됩니다. 몇 가지 옵션은 다음과 같습니다:

llama3– 범용 어시스턴트codellama– 코드 생성 및 리팩토링에 적합mistral– 빠르고 작고 정확함gemma– Google이 지원하는 오픈 웨이트 모델

하나를 선택하면 앱이 자동으로 다운로드하여 로드합니다.

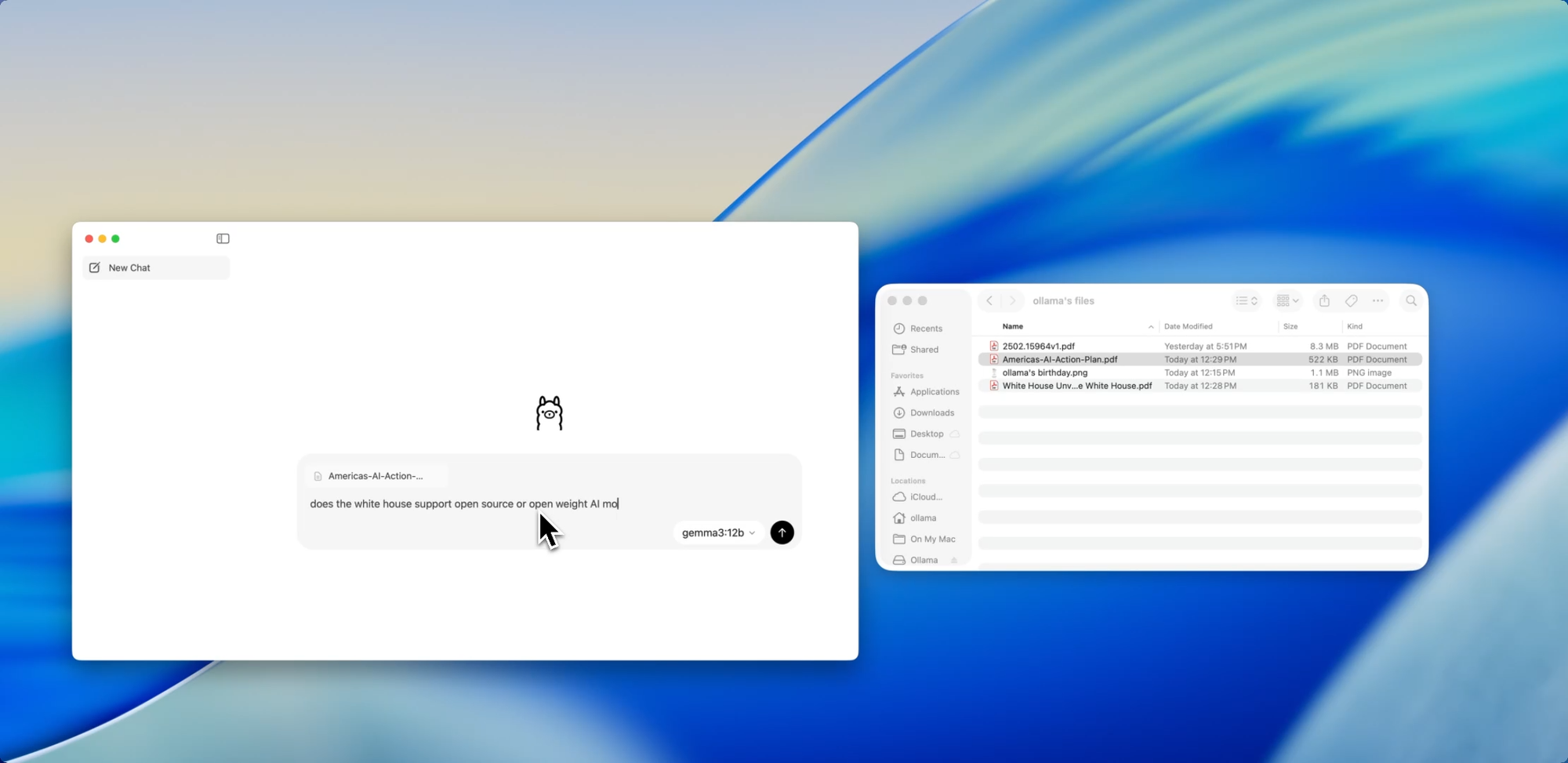

개발자를 위한 더 원활한 온보딩 - 모델과 더 쉽게 채팅하는 방법

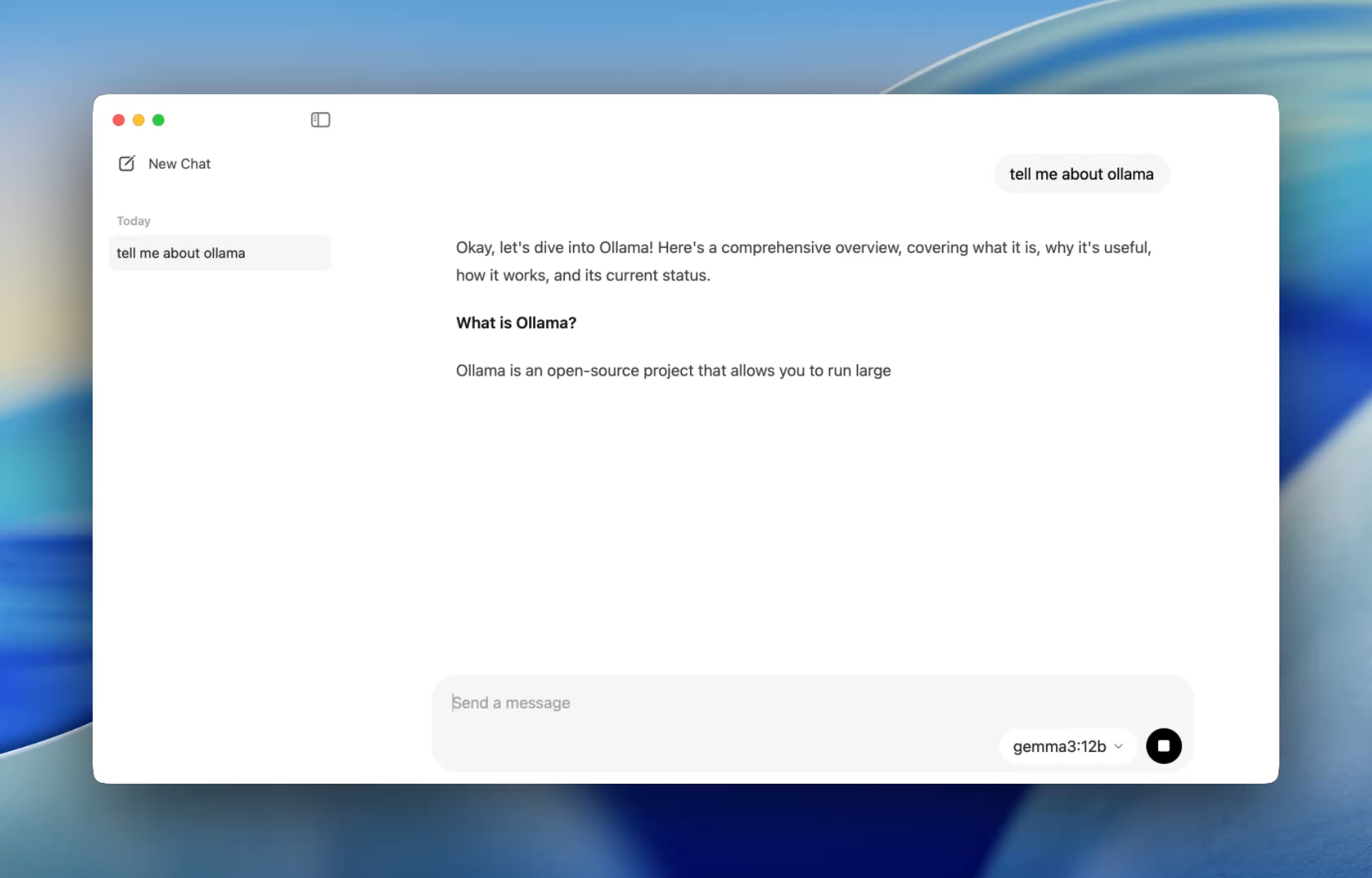

이전에는 Ollama를 사용하려면 터미널을 열고 ollama run 명령을 실행하여 모델 세션을 시작해야 했습니다. 이제 데스크톱 앱은 다른 네이티브 애플리케이션처럼 열리며 간단하고 깔끔한 채팅 인터페이스를 제공합니다.

이제 ChatGPT에서 하던 것과 동일한 방식으로 모델과 대화할 수 있습니다. 하지만 완전히 오프라인으로요. 이는 다음 상황에 완벽합니다:

- 코드 검토 지원

- 테스트 생성

- 리팩토링 팁

- 새로운 API 또는 언어 학습

이 앱은 간단한 설치 외에 추가 설정 없이 codellama 또는 mistral과 같은 로컬 모델에 즉시 액세스할 수 있도록 해줍니다.

그리고 사용자 지정을 좋아하는 개발자를 위해, CLI는 여전히 백그라운드에서 작동하여 필요한 경우 터미널을 통해 컨텍스트 길이, 시스템 프롬프트 및 모델 버전을 전환할 수 있습니다.

드래그. 드롭. 질문.

파일과 채팅

새 앱에서 가장 개발자 친화적인 기능 중 하나는 파일 수집입니다. `.pdf`, `.md`, `.txt` 등 어떤 파일이든 채팅 창으로 드래그하면 모델이 그 내용을 읽습니다.

60페이지짜리 디자인 문서를 이해해야 하나요? 지저분한 README에서 TODO를 추출하고 싶으신가요? 아니면 클라이언트의 제품 브리핑을 요약하고 싶으신가요? 파일을 넣고 다음과 같은 자연어 질문을 해보세요:

- “이 문서에서 논의된 주요 기능은 무엇인가요?”

- “이것을 한 단락으로 요약해주세요.”

- “누락된 섹션이나 불일치하는 부분이 있나요?”

이 기능은 문서를 스캔하고, 사양을 검토하고, 새 프로젝트에 온보딩하는 데 소요되는 시간을 획기적으로 줄일 수 있습니다.

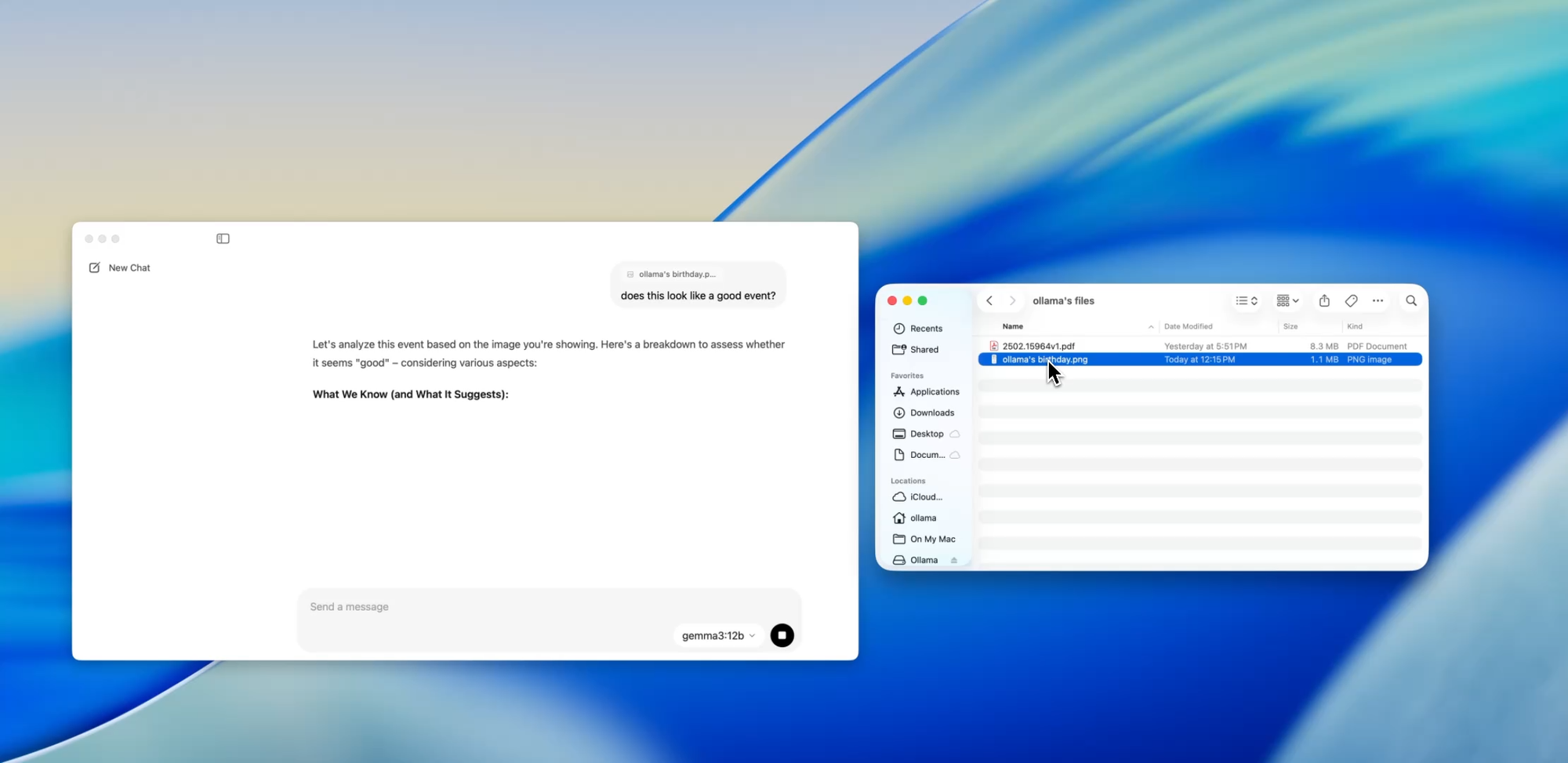

텍스트를 넘어

멀티모달 지원

Ollama 내의 일부 모델(예: Llava 기반 모델)은 이제 이미지 입력을 지원합니다. 즉, 이미지를 업로드하면 모델이 이를 해석하고 응답합니다.

몇 가지 사용 사례는 다음과 같습니다:

- 스크린샷에서 다이어그램 또는 차트 읽기

- UI 목업 설명

- 스캔된 손글씨 메모 검토

- 간단한 인포그래픽 분석

GPT-4 Vision과 같은 도구에 비해 아직 초기 단계이지만, 로컬 우선 앱에 멀티모달 지원이 내장되어 있다는 것은 다중 입력 시스템을 구축하거나 AI 인터페이스를 테스트하는 개발자에게 큰 진전입니다.

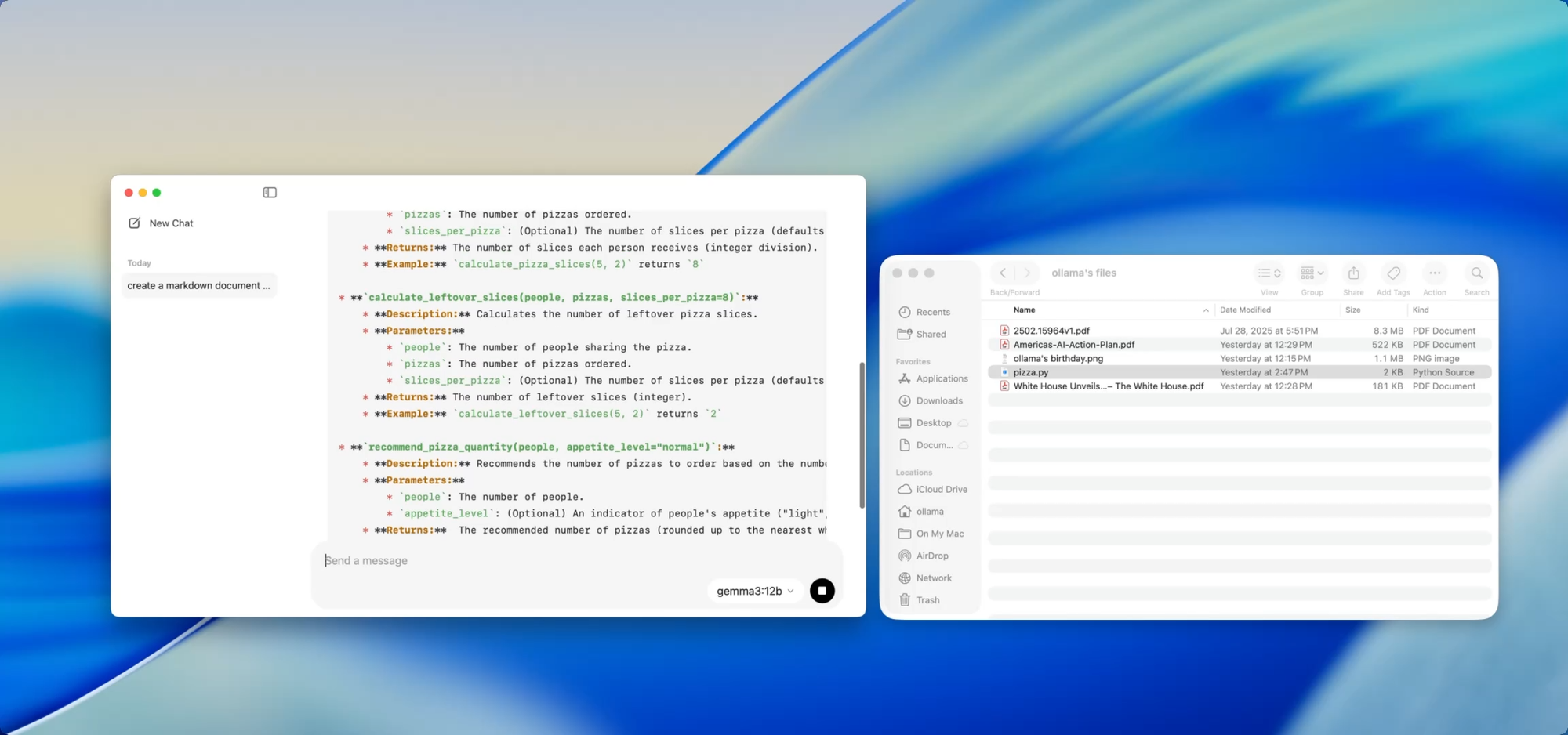

개인적이고 로컬 문서 — 당신의 명령에 따라

문서 작성

성장하는 코드베이스를 유지 관리한다면, 문서 드리프트의 어려움을 잘 아실 겁니다. Ollama를 사용하면 민감한 코드를 클라우드에 푸시하지 않고도 로컬 모델을 사용하여 문서를 생성하거나 업데이트할 수 있습니다.

utils.py와 같은 파일을 앱으로 드래그한 다음 질문하세요:

- “이 함수들에 대한 독스트링을 작성해주세요.”

- “이 파일이 하는 일에 대한 마크다운 개요를 만들어주세요.”

- “이 모듈은 어떤 의존성을 사용하나요?”

이는 AI를 사용하여 문서화 워크플로우를 자동화하는 [Deepdocs]와 같은 도구와 함께 사용될 때 더욱 강력해집니다. 프로젝트의 README 또는 스키마 파일을 미리 로드한 다음, 후속 질문을 하거나 변경 로그, 마이그레이션 노트 또는 업데이트 가이드를 생성할 수 있습니다 — 모두 로컬에서요.

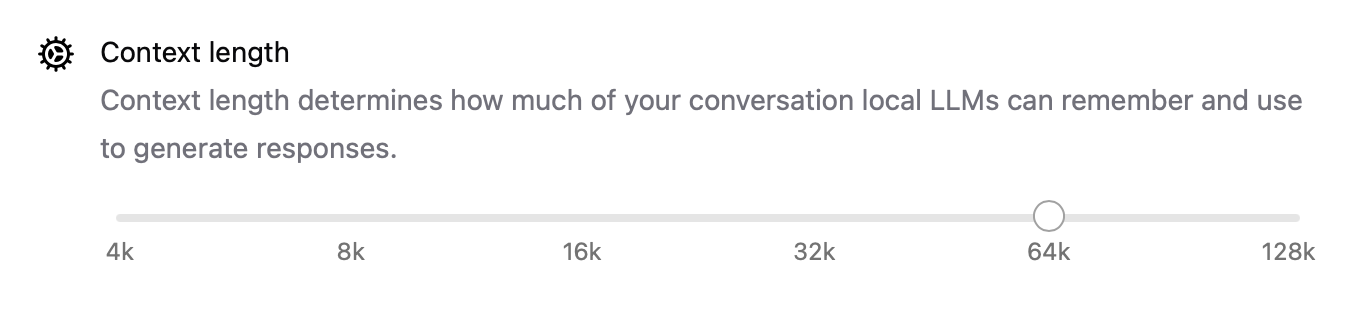

내부 성능 튜닝

이번 새 릴리스를 통해 Ollama는 전반적인 성능도 향상시켰습니다:

- GPU 가속은 Apple Silicon 및 최신 Nvidia/AMD 카드에 더 잘 최적화되었습니다.

- 컨텍스트 길이는 이제

num_ctx=8192와 같은 설정으로 구성할 수 있으므로 더 긴 입력을 처리할 수 있습니다. - 네트워크 모드를 사용하면 Ollama를 LAN의 다른 앱이나 장치에서 호출할 수 있는 로컬 API 서버로 실행할 수 있습니다.

- 이제 다운로드한 모델의 저장 위치를 변경할 수 있습니다 — 외장 드라이브에서 작업하거나 프로젝트별로 모델을 격리하려는 경우에 완벽합니다.

이러한 업그레이드는 로컬 에이전트부터 개발 도구, 개인 연구 보조 도구에 이르기까지 모든 것에 앱을 유연하게 만듭니다.

CLI와 GUI: 두 세계의 장점

가장 좋은 점은? 새로운 데스크톱 앱이 터미널을 대체하는 것이 아니라 보완한다는 것입니다.

여전히 다음을 수행할 수 있습니다:

ollama pull codellama

ollama run codellama

또는 모델 서버를 노출할 수 있습니다:

ollama serve --host 0.0.0.0

따라서 로컬 LLM에 의존하는 사용자 지정 AI 인터페이스, 에이전트 또는 플러그인을 구축하는 경우, 이제 Ollama의 API를 기반으로 구축하고 GUI를 사용하여 직접 상호 작용하거나 테스트할 수 있습니다.

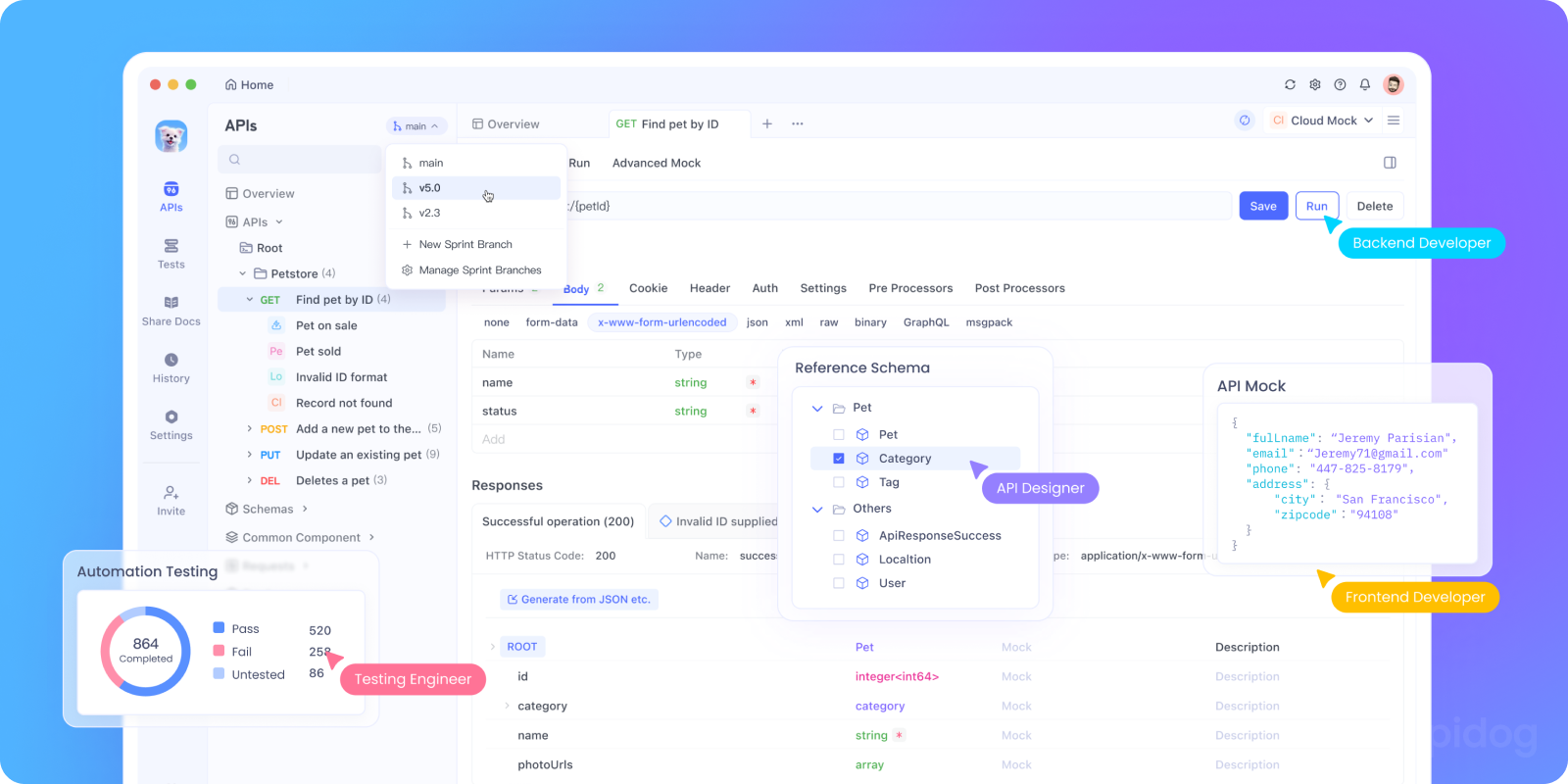

Apidog로 Ollama의 API 로컬에서 테스트하기

Ollama를 AI 앱에 통합하거나 로컬 API 엔드포인트를 테스트하고 싶으신가요? 다음을 사용하여 Ollama의 REST API를 실행할 수 있습니다:

bash tollama serve

그런 다음, Apidog를 사용하여 로컬 LLM 엔드포인트를 테스트, 디버그 및 문서화하세요.

Ollama와 함께 Apidog를 사용하는 이유:

- 로컬

http://localhost:11434서버로 POST 요청을 보내기 위한 시각적 인터페이스 - AI 지원 요청 생성 및 응답 유효성 검사 지원

- 자체 호스팅 AI 앱, 에이전트 프레임워크 또는 내부 도구에 완벽

- 로컬 LLM 워크플로우 및 사용자 지정 모델 서버와 원활하게 작동

실제로 작동하는 개발자 사용 사례

새로운 Ollama 앱이 실제 개발자 워크플로우에서 빛을 발하는 지점은 다음과 같습니다:

| 사용 사례 | Ollama가 돕는 방법 |

|---|---|

| 코드 검토 보조 | 리팩토링 피드백을 위해 codellama를 로컬에서 실행 |

| 문서 업데이트 | 모델에 문서 파일 재작성, 요약 또는 수정 요청 |

| 로컬 개발 챗봇 | 컨텍스트 인식 보조 도구로 앱에 임베드 |

| 오프라인 연구 도구 | PDF 또는 백서 로드 및 주요 질문 |

| 개인 LLM 플레이그라운드 | 프롬프트 엔지니어링 및 미세 조정 실험 |

데이터 프라이버시 또는 모델 환각에 대해 우려하는 팀에게 로컬 우선 LLM 워크플로우는 점점 더 매력적인 대안을 제공합니다.

마무리 생각

Ollama의 데스크톱 버전은 로컬 LLM을 해킹성 과학 실험보다는 세련된 개발자 도구처럼 느끼게 합니다.

파일 상호 작용, 멀티모달 입력, 문서 작성 및 네이티브 성능 지원을 통해 속도, 유연성 및 제어를 중요하게 생각하는 개발자에게 진지한 선택지가 됩니다.

클라우드 API 키 없음. 백그라운드 추적 없음. 토큰당 과금 없음. 필요에 맞는 오픈 모델을 선택하여 빠르고 로컬에서 추론할 수 있습니다.

머신에서 LLM을 실행하는 것에 대해 궁금했거나 이미 Ollama를 사용하고 있고 더 원활한 경험을 원한다면 지금 다시 시도해 볼 때입니다.