개발자들은 비용 부담 없이 텍스트와 이미지를 모두 처리할 수 있는 효율적인 도구를 찾습니다. NVIDIA Nemotron Nano 12B v2 VL은 작지만 강력한 비전-언어 모델로, OpenRouter와 같은 플랫폼을 통해 NVIDIA API 무료 티어로 접근하면 쉽게 실험할 수 있습니다.

이 게시물은 NVIDIA Nemotron Nano 12B v2 VL API를 무료로 활용하는 과정을 안내합니다. 모델의 아키텍처, 설정 요구 사항, 실제 구현 단계 및 고급 사용 패턴에 대해 배우게 될 것입니다. 이 글을 마치면 이미지 캡셔닝부터 시각적 질의응답에 이르기까지 이 모델을 애플리케이션에 배포할 수 있는 지식을 갖추게 될 것입니다.

NVIDIA Nemotron Nano 12B v2 VL 이해하기: 핵심 아키텍처 및 기능

NVIDIA 엔지니어들은 효율적인 비전-언어 처리 수요 증가에 대응하기 위해 Nemotron Nano 12B v2 VL 모델을 설계했습니다. 이 120억 매개변수 모델은 트랜스포머 기반의 언어 이해와 시각 인코더를 결합하여 텍스트와 이미지의 교차 시퀀스를 처리할 수 있도록 합니다. 상당한 GPU 자원을 요구하는 대규모 모델과 달리, Nemotron Nano 12B v2 VL은 엣지 배포 및 낮은 지연 시간 추론에 최적화되어 실시간 애플리케이션에 이상적입니다.

핵심적으로, 이 모델은 비전 트랜스포머(ViT)를 사용하여 입력 이미지에서 특징을 추출한 다음, 다중 모달 프로젝터를 통해 이 특징들을 텍스트 임베딩 공간과 정렬합니다. 언어 구성 요소는 확장된 컨텍스트 처리를 위한 회전 위치 임베딩을 통합한 NVIDIA의 Nemotron 아키텍처를 기반으로 합니다. 이 설정은 최대 4,096개의 토큰 컨텍스트 길이를 지원하며, 시각 자료와 결합된 짧은 설명이나 쿼리를 포함하는 대부분의 실제 작업에 충분합니다.

주요 기능은 다음과 같습니다:

- 이미지-텍스트 정렬: 모델은 이미지에 대한 설명 캡션을 생성하거나 시각적 콘텐츠를 기반으로 질문에 답변합니다.

- 다중 모달 추론: "전경에 있는 자동차는 무슨 색인가요?"와 같이 사용자가 이미지에서 특정 세부 정보를 쿼리하는 시각적 질의응답(VQA)과 같은 작업을 수행합니다.

- 문서 이해: OCR과 유사한 텍스트 추출과 의미론적 해석을 결합하여 스캔된 문서나 차트를 처리합니다.

벤치마크는 강력한 성능을 보여줍니다. VQAv2 데이터셋에서 Nemotron Nano 12B v2 VL은 약 75%의 정확도를 달성하며, 훨씬 적은 컴퓨팅 자원을 소비하면서도 대규모 모델에 필적합니다. 개발자에게 이는 특히 NVIDIA API 무료 액세스를 사용할 때 더 빠른 프로토타이핑 주기로 이어집니다.

또한, 모델의 양자화 옵션(예: 4비트 또는 8비트 가중치)은 상당한 정확도 손실 없이 메모리 점유 공간을 줄입니다. NVIDIA는 NGC 카탈로그를 통해 이를 제공하지만, API 기반 사용의 경우 OpenRouter와 같은 플랫폼이 표준화된 HTTP 엔드포인트를 통해 모델을 노출하여 어려운 작업을 처리합니다.

NVIDIA API 무료 티어 접근하기: OpenRouter 통합

AI 모델을 위한 통합 게이트웨이인 OpenRouter를 통해 요청을 라우팅하면 NVIDIA Nemotron Nano 12B v2 VL API를 무료로 사용할 수 있습니다. OpenRouter는 이 특정 모델 변형에 대해 관대한 무료 티어를 제공하여 분당 최대 10개의 요청과 분당 1,000개의 토큰을 무료로 허용합니다. 이 제한은 테스트 및 소규모 개발에 적합하며, 더 높은 처리량이 필요하면 유료 플랜으로 업그레이드할 수 있습니다.

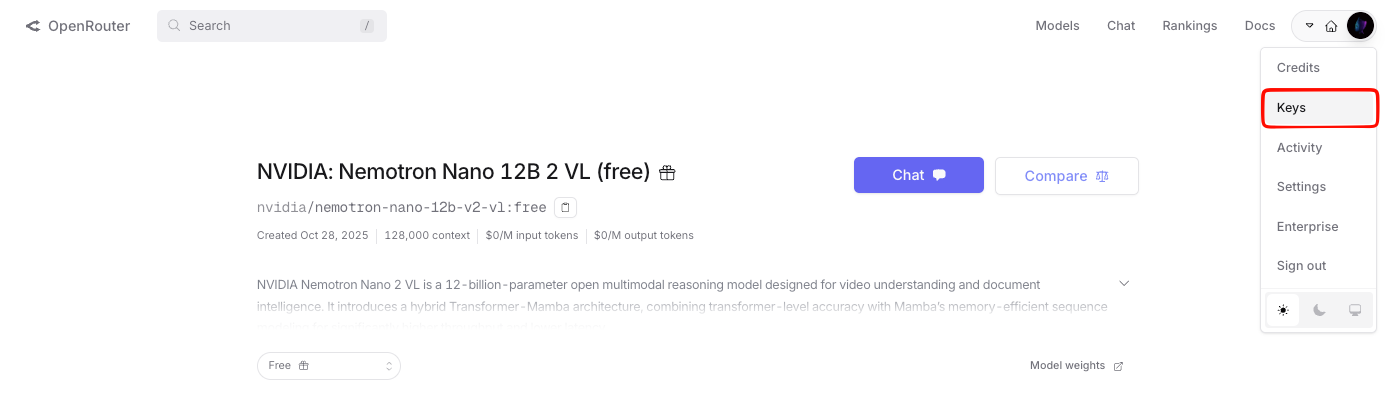

먼저 OpenRouter에서 계정을 생성하세요. 대시보드로 이동하여 이메일 또는 GitHub 자격 증명을 사용하여 가입합니다. 로그인 후 "Keys" 섹션에서 API 키를 생성합니다. 이 키는 간단한 베어러 토큰 체계를 따라 모든 후속 호출을 인증합니다.

OpenRouter는 OpenAI의 형식을 모방하여 API 인터페이스를 표준화하므로 GPT 엔드포인트에 익숙한 개발자의 마이그레이션을 간소화합니다. 요청의 기본 URL은 https://openrouter.ai/api/v1이며, 모델을 nvidia/nemotron-nano-12b-v2-vl:free로 지정합니다. 이 태그는 무료 티어 엔드포인트를 사용하도록 하여 예기치 않은 요금이 부과되는 것을 방지합니다.

시각 입력의 경우, JSON 페이로드 내에서 이미지를 base64 문자열로 인코딩합니다. API는 JPEG 및 PNG 형식을 지원하며, 이미지당 최대 해상도는 1024x1024 픽셀입니다. 더 높은 해상도는 오버플로를 방지하기 위해 자동으로 크기가 조정됩니다. 텍스트 입력은 표준 UTF-8 문자열로 유지되며, 모델은 생성된 텍스트를 포함하는 JSON 형식의 응답을 출력합니다.

설정에서 구현으로 넘어가면서 이제 개발 환경을 준비합니다. Python 3.8 이상과 HTTP 처리를 위한 requests 라이브러리를 설치합니다. 더 고급 테스트를 위해 Apidog는 원활하게 통합되어 요청/응답 주기를 시각화하고 팀 협업을 위한 컬렉션을 내보낼 수 있습니다.

단계별 설정: 전제 조건 및 환경 구성

먼저 시스템 준비 상태를 확인합니다. Python이 컴퓨터에 설치되어 있는지 확인하고, 터미널에서 python --version을 통해 확인할 수 있습니다. 설치되어 있지 않다면 공식 Python 웹사이트에서 다운로드하세요.

다음으로, 의존성을 격리하기 위해 가상 환경을 생성합니다:

python -m venv nemotron_env

source nemotron_env/bin/activate # On Windows: nemotron_env\Scripts\activate

필요한 패키지를 설치합니다:

pip install requests

OpenRouter API 키를 안전하게 저장하세요. 이를 위해 환경 변수를 사용하세요. 프로젝트 디렉토리에 OPENROUTER_API_KEY=your_key_here를 포함하는 .env 파일을 생성합니다. python-dotenv 라이브러리를 사용하여 로드합니다:

pip install python-dotenv

코드에서 다음과 같이 가져와서 사용합니다:

import os

from dotenv import load_dotenv

load_dotenv()

api_key = os.getenv('OPENROUTER_API_KEY')

이 구성은 민감한 데이터를 하드코딩하는 것을 방지하며, 이는 프로덕션 환경의 모범 사례입니다. 이러한 기반이 마련되었으므로 이제 첫 API 호출을 작성할 수 있습니다.

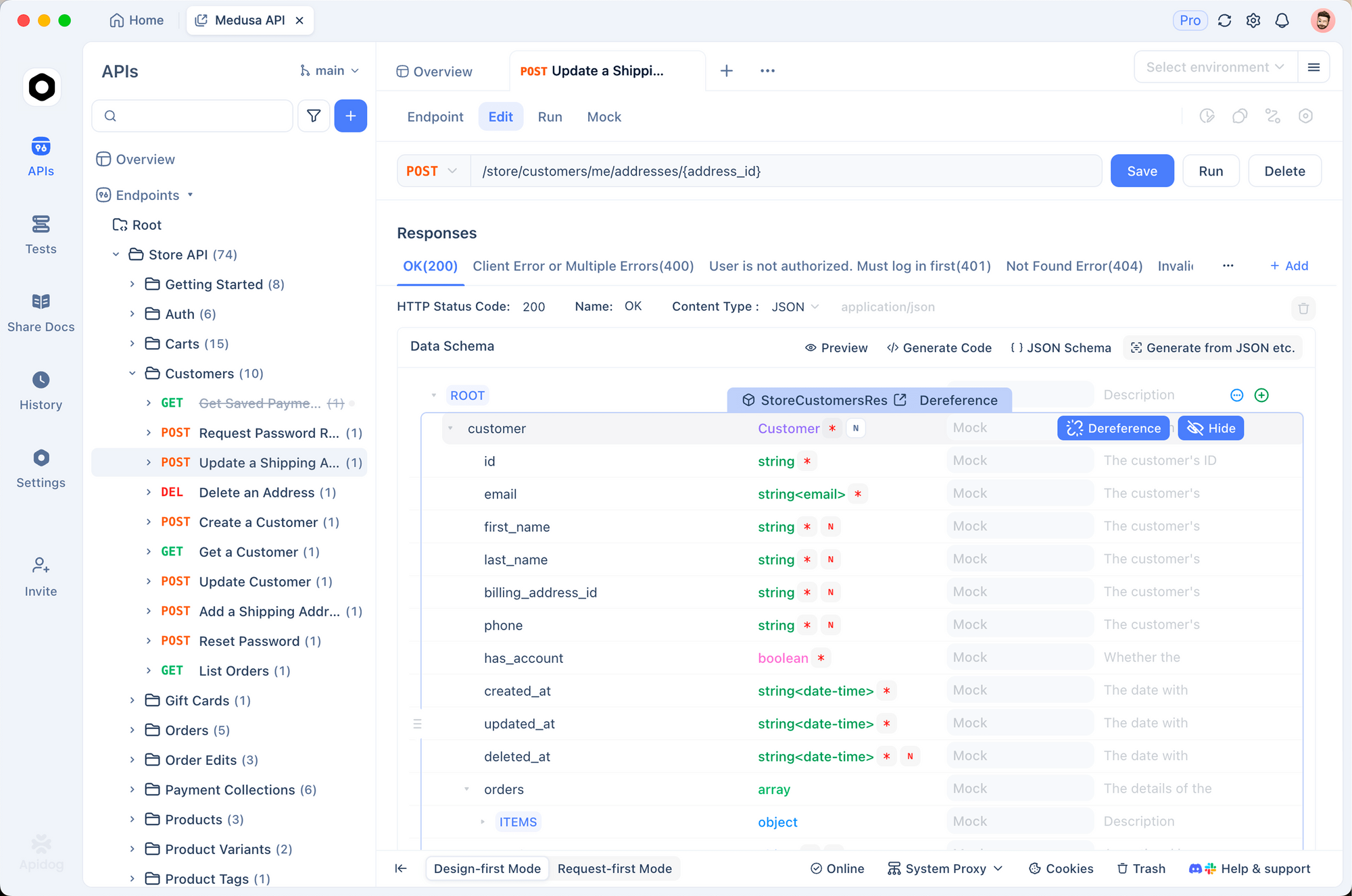

또한 GUI 기반 테스트를 선호한다면 Apidog가 빛을 발합니다. OpenRouter 스키마를 Apidog로 직접 가져오고, NVIDIA API 무료 키를 구성한 다음, 코드 작성 없이 시뮬레이션을 실행할 수 있습니다. 이 접근 방식은 JSON 구조가 중요한 다중 모달 페이로드의 경우 특히 디버깅 속도를 높여줍니다.

기본 API 호출 구현: 텍스트 전용 및 이미지 전용 예제

자신감을 얻기 위해 간단한 요청부터 시작합니다. 핵심 엔드포인트는 /chat/completions이며, model, messages와 temperature(창의성 제어를 위해 0-2), max_tokens(최대 2048)와 같은 선택적 매개변수를 포함하는 JSON 본문을 허용하는 POST 메서드입니다.

모델 숙지를 위해 텍스트 전용 쿼리를 고려해 보세요:

import requests

import json

import base64

url = "https://openrouter.ai/api/v1/chat/completions"

headers = {

"Authorization": f"Bearer {api_key}",

"Content-Type": "application/json"

}

payload = {

"model": "nvidia/nemotron-nano-12b-v2-vl:free",

"messages": [

{"role": "user", "content": "Explain the basics of vision-language models in 100 words."}

],

"max_tokens": 150,

"temperature": 0.7

}

response = requests.post(url, headers=headers, json=payload)

result = response.json()

print(result['choices'][0]['message']['content'])

이 스크립트는 프롬프트를 보내고 간결한 설명을 검색합니다. OpenRouter의 최적화된 라우팅 덕분에 응답은 평균 2초 이내에 스트리밍됩니다.

이제 이미지 전용 처리로 확장합니다. 이미지 파일을 base64로 인코딩합니다:

with open("sample_image.jpg", "rb") as image_file:

base64_image = base64.b64encode(image_file.read()).decode('utf-8')

content = [

{

"type": "text",

"text": "Describe this image in detail."

},

{

"type": "image_url",

"image_url": {

"url": f"data:image/jpeg;base64,{base64_image}"

}

}

]

payload["messages"] = [{"role": "user", "content": content}]

# Repeat the POST request as above

이 모델은 이미지를 분석하여 "황혼녘 도시 거리에 주차된 빨간색 스포츠카, 배경에는 흐릿한 보행자들이 있다"와 같은 설명을 출력합니다. 이러한 출력은 VL 융합이 효과적임을 보여줍니다.

그러나 복잡한 시나리오의 경우, 다음에서 살펴보겠지만 여러 모달리티를 결합합니다.

고급 사용법: NVIDIA Nemotron Nano 12B v2 VL을 사용한 다중 모달 쿼리

텍스트와 이미지를 결합하면 모델의 잠재력을 최대한 발휘할 수 있습니다. 각 요소가 유형("text" 또는 "image_url")과 값을 지정하는 인터리브된 콘텐츠 배열로 메시지를 구성합니다.

시각적 질의응답 예시:

content = [

{"type": "image_url", "image_url": {"url": f"data:image/png;base64,{base64_chart_image}"}},

{"type": "text", "text": "What is the trend in sales from Q1 to Q4 in this chart?"}

]

payload["messages"] = [{"role": "user", "content": content}]

response = requests.post(url, headers=headers, json=payload)

API는 "1분기 10만 달러에서 4분기 40만 달러로 매출이 꾸준히 증가하여 300% 성장을 나타냅니다"와 같은 논리적인 응답을 반환합니다. 이 기능은 데이터 시각화 도구 또는 자동화된 보고 시스템에 매우 유용합니다.

신뢰성을 높이려면 역할극을 위한 시스템 프롬프트를 통합합니다:

payload["messages"] = [

{"role": "system", "content": "You are a precise image analyst."},

{"role": "user", "content": content}

]

시스템 메시지는 모델의 동작을 안내하여 출력에서 환각 현상을 줄입니다. 또한, 다양성과 일관성의 균형을 맞추는 핵 샘플링을 위해 top_p를 0.9로 설정합니다.

배치 처리를 위해 OpenRouter는 웹소켓을 통한 비동기 호출을 지원하지만, 무료 티어의 단순성을 위해 동기 POST를 고수하세요. 대시보드를 통해 사용량을 모니터링하여 제한 내에 유지하세요. 이를 초과하면 429 오류가 발생하며, 이는 지수 백오프(exponential backoff)로 처리해야 합니다.

import time

try:

response = requests.post(url, headers=headers, json=payload)

if response.status_code == 429:

time.sleep(60) # Wait 1 minute

response = requests.post(url, headers=headers, json=payload)

except Exception as e:

print(f"Error: {e}")

이러한 복원력은 중단 없는 워크플로를 보장합니다. 확장함에 따라 Apidog의 모킹 기능은 응답을 시뮬레이션하여 오프라인 개발을 돕습니다.

NVIDIA API 무료 테스트 및 문서화를 위한 Apidog 활용

Apidog는 원시 스크립트를 넘어선 API 상호 작용을 가능하게 합니다. 이 오픈 소스 도구는 OpenAPI 사양 가져오기를 지원하며, OpenRouter는 Nemotron 엔드포인트에 대한 사양을 제공합니다.

앞서 언급했듯이 Apidog를 무료로 다운로드하고 다음 단계를 따르세요:

- Apidog를 실행하고 새 프로젝트를 생성합니다.

- OpenRouter 컬렉션을 GitHub 저장소에서 가져오거나 스키마 JSON을 붙여넣습니다.

- 환경 변수에 NVIDIA API 무료 키를 추가합니다.

- 요청을 설계합니다: 드래그 앤 드롭 이미지 업로드는 자동으로 base64로 변환됩니다.

- 테스트를 실행하고 트레이스를 확인합니다. Apidog는 지연 시간 급증 또는 페이로드 오류를 강조 표시합니다.

예제를 포함한 Markdown 보고서를 생성하여 엔드포인트를 손쉽게 문서화할 수 있습니다. 예를 들어, VQA 쿼리에 대한 curl 명령을 내보냅니다:

curl -X POST https://openrouter.ai/api/v1/chat/completions \

-H "Authorization: Bearer $OPENROUTER_API_KEY" \

-H "Content-Type: application/json" \

-d '{"model":"nvidia/nemotron-nano-12b-v2-vl:free","messages":[{"role":"user","content":[{"type":"image_url","image_url":{"url":"data:image/jpeg;base64,..."},"type":"text","text":"Analyze this."}]}]}'

이러한 내보내기는 팀과의 공유를 용이하게 합니다. 또한, Apidog의 협업 모드는 변경 사항을 추적하여 NVIDIA Nemotron Nano 12B v2 VL 실험을 버전 제어합니다.

실제로는 Apidog가 상용구 코드를 추상화하기 때문에 개발자들은 40% 더 빠른 반복 주기를 보고합니다. Postman으로 내보내거나 SDK를 통해 직접 통합하여 프로덕션으로 전환할 수 있습니다.

오류 처리, 모범 사례 및 최적화 전략

API 사용 시 오류가 발생하므로 이를 사전에 예측해야 합니다. 일반적인 문제에는 401(잘못된 키)이 포함되며, 베어러 토큰을 다시 확인하세요. 400(잘못된 형식의 JSON)의 경우 JSONLint와 같은 도구로 페이로드를 검증합니다. 너무 큰 base64 문자열과 같은 이미지 관련 오류는 Pillow를 사용하여 미리 파일을 압축하여 해결할 수 있습니다.

from PIL import Image

img = Image.open("large_image.jpg")

img = img.resize((512, 512))

img.save("resized.jpg", quality=85)

모범 사례에는 10 RPM(분당 요청 수) 제한을 준수하기 위해 호출 사이에 time.sleep(6)을 사용하여 자체적으로 속도 제한을 두는 것이 포함됩니다. Redis를 사용하여 자주 사용되는 응답을 캐시하여 API 호출 횟수를 최소화합니다.

최적화는 프롬프트 엔지니어링에 중점을 둡니다. "이 사진에서 객체와 그 관계를 식별하세요"와 같은 간결한 쿼리가 모호한 쿼리보다 더 나은 결과를 제공합니다. 사실적인 작업에는 더 낮은 값을, 창의적인 생성에는 더 높은 값을 사용하여 온도(temperature) 값을 실험해 보세요.

제한 내에서 비용 없이 확장하려면 논리적 쿼리를 단일 메시지로 일괄 처리하여 토큰 효율성을 극대화합니다. 응답 메타데이터를 통해 토큰 사용량을 모니터링합니다: result['usage']['total_tokens'].

또한 logging 모듈과 함께 로깅을 통합하여 성능을 추적합니다:

import logging

logging.basicConfig(level=logging.INFO)

logging.info(f"Response tokens: {result['usage']['total_tokens']}")

이러한 습관은 견고한 애플리케이션을 구축합니다. 개선함에 따라 초저지연을 위해 Nemotron과 로컬 전처리를 결합한 하이브리드 설정을 고려해 보세요.

결론

이제 NVIDIA Nemotron Nano 12B v2 VL API를 무료로 활용할 수 있는 도구를 갖게 되었습니다. 초기 설정부터 고급 배포에 이르기까지 이 가이드는 성공을 위한 준비를 제공합니다. 과감하게 실험하세요. 간단한 호출부터 시작하여 정교한 애플리케이션으로 발전시켜 나가세요. 정제된 프롬프트나 Apidog 지원 테스트와 같은 꾸준한 작은 조정이 상당한 이득을 가져온다는 것을 기억하세요.

추가 자료를 보려면 NVIDIA 개발자 포럼이나 OpenRouter의 변경 로그를 살펴보세요. 아직 Apidog를 다운로드하지 않았다면 지금 다운로드하여 API 워크플로를 혁신해 보세요. 어떤 프로젝트를 먼저 시도하시겠습니까?