Kimi K-2.5는 멀티모달 대규모 언어 모델의 주요 발전을 나타냅니다. Moonshot AI는 추론 단계당 약 320억 개의 매개변수를 활성화하는 1조 개의 매개변수 전문가 혼합 아키텍처를 구축했습니다. 이 모델은 추론, 코딩, 시각적 이해, 짧은 비디오 분석, 그리고 최대 100개의 병렬 서브 에이전트 지원을 통한 에이전트 동작에서 탁월합니다. 개발자들은 종종 프로덕션과 유사한 환경에서 Kimi K-2.5를 활용할 비용 효율적인 방법을 찾습니다.

OpenClaw (2026년 초 ClawdBot에서 MoltBot으로 브랜드가 변경되었지만, 커뮤니티에서는 여전히 OpenClaw라고 불리는 경우가 많음)는 오픈 소스 자체 호스팅 에이전트 프레임워크를 제공합니다. 이것은 Kimi K-2.5와 같은 LLM을 Telegram, Discord, Slack, WhatsApp을 포함한 메시징 플랫폼에 연결합니다. OpenClaw는 OpenAI 호환 API 표준을 따르므로 통합이 간단합니다.

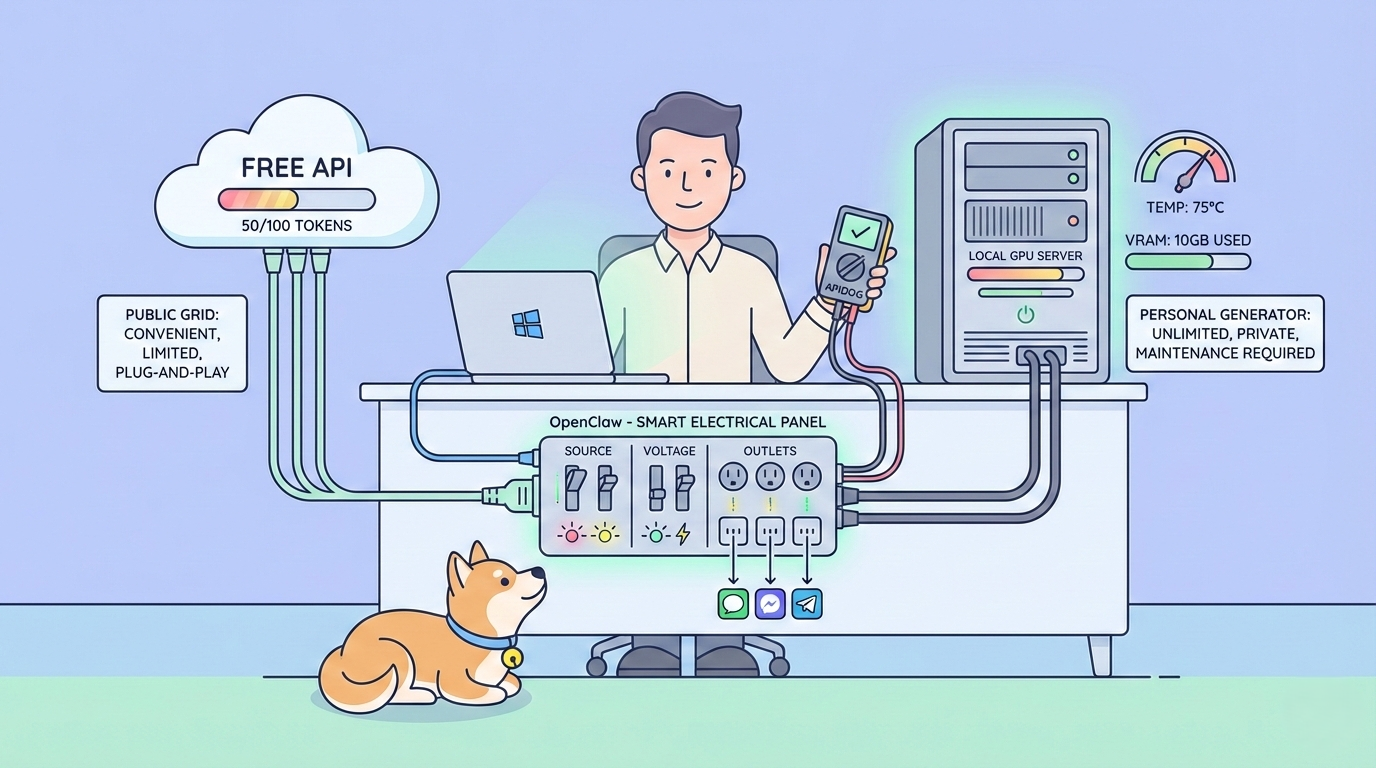

로컬 추론 옵션과 제한된 무료 API 티어를 통해 OpenClaw를 사용하여 Kimi K-2.5를 진정으로 무료 또는 거의 무료로 사용할 수 있습니다. 이 접근 방식은 강력한 개인 정보 보호, 실시간 작업에 대한 지연 시간 감소, 그리고 중간 정도의 워크로드에 대한 반복적인 클라우드 비용 없음이라는 이점을 제공합니다.

Kimi K-2.5 + OpenClaw가 고가치 무료 AI 액세스를 제공하는 이유

Kimi K-2.5는 네이티브 멀티모달 처리에서 뛰어납니다. 텍스트, 이미지 (메시지에서 base64 인코딩됨), UI 스크린샷, 다이어그램, 시각적 토큰으로 추출된 짧은 비디오 프레임을 처리합니다. 공식 API는 256K 토큰 컨텍스트 창을 지원하여 전체 코드 리포지토리, 긴 문서 또는 확장된 채팅 기록을 한 번에 분석할 수 있도록 합니다.

에이전트 기능은 Kimi K-2.5가 병렬 하위 작업을 실행하고, 도구 호출을 조정하고, 복잡한 목표를 향해 반복하는 하위 에이전트를 생성하도록 합니다. 벤치마크에 따르면 Kimi K-2.5는 코딩, 수학, 시각적 추론 분야에서 Claude 3.5 Sonnet 또는 GPT-4o와 같은 모델보다 앞서거나 근접한 성능을 보이며, 토큰당 비용은 훨씬 적게 듭니다.

OpenClaw는 이러한 기능을 실용적인 에이전트로 전환합니다. 이것은 대화 상태를 관리하고, 채널 간 메시지를 라우팅하며, 스킬(사용자 지정 도구)을 실행하고, 영구 메모리를 유지합니다. OpenClaw를 로컬에서 실행하면 모든 데이터가 하드웨어에 보관되므로, 민감한 워크플로우에 중요합니다.

무료 액세스 경로는 다음과 같습니다:

- Moonshot API 무료 티어 (많은 지역에서 일일 약 150만 토큰, 변경될 수 있음)

- Hugging Face의 커뮤니티 양자화 GGUF 가중치를 사용한 완전 로컬 추론

두 경로 모두 OpenClaw와 깔끔하게 통합됩니다.

사전 요구 사항: 2026년 Windows / WSL2 적절한 설정

OpenClaw는 Linux 환경 내에서 가장 잘 작동하므로, Windows 머신에서는 Ubuntu와 함께 WSL2 (Windows용 Linux 하위 시스템 2)를 사용하는 것이 권장됩니다. 이는 완전한 Linux 셸, GPU 가속 (호환 가능한 하드웨어가 있는 경우 NVIDIA CUDA를 통해), 그리고 Windows와의 원활한 파일 공유를 제공합니다.

Windows에 WSL2 + Ubuntu 설치 (초보자 권장)

2026년 현재 Microsoft는 WSL2를 활성화하고, 기본적으로 최신 Ubuntu 배포판을 설치하며, 모든 것을 자동으로 설정하는 단일 명령으로 설치를 간소화했습니다.

- 관리자 권한으로 PowerShell 열기:

- 시작 버튼을 마우스 오른쪽 버튼으로 클릭 → Windows PowerShell (관리자) 또는 터미널 (관리자) 선택.

- UAC (사용자 계정 컨트롤) 프롬프트 확인.

2. 한 줄 설치 프로그램 실행:

wsl --install이 명령은 다음을 수행합니다:

- 필요한 Windows 기능 ("Linux용 Windows 하위 시스템" 및 "가상 머신 플랫폼")을 활성화합니다.

- 최신 WSL 커널을 다운로드하고 설치합니다.

- Ubuntu (기본 배포판, 일반적으로 24.04와 같은 최신 LTS)를 설치합니다.

- WSL 2를 기본 버전으로 설정합니다.

3. 메시지가 표시되면 컴퓨터를 다시 시작하십시오 (기능 변경 사항을 적용하려면 재부팅이 필요합니다).

4. 재부팅 후, Ubuntu 설정이 새 터미널 창에서 자동으로 시작됩니다:

- 초기 설치가 완료될 때까지 기다리십시오 (몇 분 소요).

- 요청 시 Linux 사용자 이름과 암호를 생성하십시오 (이는 Windows 자격 증명과 별개입니다).

- 이 사용자 이름은 기본 Linux 사용자가 됩니다.

5. Ubuntu 터미널 (앱) 열기:

- Windows 시작 메뉴에서 Ubuntu를 검색하여 실행하십시오 (이는 "Ubuntu" 또는 "Ubuntu 24.04 LTS"로 나타납니다).

- 또는 PowerShell 또는 Windows 터미널에서 다음을 입력하십시오:

ubuntu또는

wsl(이는 기본 배포판인 Ubuntu를 엽니다).

- 이제 Ubuntu bash 셸 (username@hostname:~$와 같은 프롬프트) 안에 있습니다.

6. WSL2 활성화 확인: PowerShell에서 (Ubuntu 내부가 아님):

wsl --list --verbose다음과 같이 표시되어야 합니다:text

NAME STATE VERSION

* Ubuntu Running 2(별표 *는 기본 배포판을 표시합니다; VERSION 2는 WSL2를 확인합니다.)

선택적 조정

- 특정 Ubuntu 버전 (예: 22.04)을 설치하려면: wsl --install -d Ubuntu-22.04

- 사용 가능한 모든 배포판 나열: wsl --list --online

- Ubuntu 패키지 즉시 업데이트: Ubuntu 터미널 내에서 sudo apt update && sudo apt upgrade -y를 실행하십시오.

Ubuntu가 실행되면 이 Ubuntu 터미널 내에서 OpenClaw 사전 요구 사항을 계속 진행하십시오.

- Node.js ≥ 24 설치 (v22는 최신 OpenClaw 종속성을 손상시킴): NodeSource 또는 nvm 사용; apt 예시:

curl -fsSL https://deb.nodesource.com/setup_24.x | sudo -E bash -

sudo apt install -y nodejs2. Corepack 활성화 및 pnpm 10 준비:

corepack enable

corepack prepare pnpm@10 --activate3. 전역 pnpm bin 경로 설정:

pnpm setup

source ~/.bashrc # 또는 터미널 재시작4. 확인:

node -v # ≥24여야 함

pnpm -v # 10.x

echo $PATH # ~/.local/share/pnpm 포함OpenClaw 올바르게 설치 (2026년 2월)

이전 moltbot / clawdbot npm 패키지와 molt.bot/install.sh는 레거시입니다. 현재 공식 설치 프로그램을 사용하십시오:

curl -fsSL https://openclaw.ai/install.sh | bash- Ubuntu (WSL2) 터미널 내에서 이것을 실행하십시오.

- 설치 후 셸을 다시 로드하십시오: source ~/.bashrc.

- CLI 확인:

command -v openclaw- 구성 파일은 ~/.openclaw/openclaw.json에 있습니다 (이전 경로에서 자동으로 마이그레이션됨).

- 자주 업데이트하십시오: npm update -g openclaw@latest.

Apidog로 Kimi K-2.5 엔드포인트 먼저 테스트 (중요한 유효성 검사 단계)

OpenClaw 구성을 건드리기 전에 항상 Kimi K-2.5 액세스를 확인하십시오. 대부분의 통합 실패는 유효하지 않은 키 또는 엔드포인트에서 비롯됩니다.

- Windows 머신에 Apidog를 다운로드하고 실행하십시오 (무료 버전도 완벽하게 작동합니다).

- 새로운 POST 요청을 생성하십시오.

- URL 설정:text

https://api.moonshot.ai/v1/chat/completions4. 헤더 추가:

- Authorization: Bearer sk-your-moonshot-key

- Content-Type: application/json

5. Kimi K-2.5를 위한 이 테스트 본문을 붙여넣으십시오:

{

"model": "kimi-k2.5",

"messages": [

{

"role": "user",

"content": "Confirm you are Kimi K-2.5 and describe three key multimodal or agentic capabilities."

}

],

"temperature": 0.7,

"max_tokens": 256

}6. 요청을 전송하십시오.

관련 응답과 함께 200 OK가 수신되면 키가 작동함을 확인합니다. Apidog는 실시간 지연 시간, 전체 요청/응답 페이로드, 토큰 사용량을 표시하며, OpenClaw 통합을 위한 코드 스니펫 (Node.js, Python, cURL)을 자동으로 생성합니다. 이 1분 확인은 몇 시간의 디버깅 시간을 절약해 줍니다.

OpenClaw에서 Moonshot API를 통해 Kimi K-2.5 통합하기

- platform.moonshot.ai에서 가입하고 API 키 (sk-...)를 생성하십시오.

- ~/.openclaw/openclaw.json (Ubuntu 내부) 편집:JSON

{

"agent": {

"model": { "primary": "moonshot/kimi-k2.5" }

},

"models": {

"providers": {

"moonshot": {

"baseUrl": "https://api.moonshot.ai/v1",

"apiKey": "sk-your-moonshot-key",

"api": "openai-completions",

"models": [

{

"id": "kimi-k2.5",

"name": "Kimi K-2.5 API 256K",

"contextWindow": 262144,

"maxTokens": 8192

}

]

}

}

}

}3. 키 보안: export MOONSHOT_API_KEY=sk-... (또는 .env 사용).

4. 재시작: openclaw restart.

5. 연결된 앱 (예: Telegram)에서 테스트: "오늘 누가 당신에게 힘을 주나요?"를 보내면 → Moonshot / Kimi K-2.5를 참조하는 응답이 옵니다.

100% 무료, 무제한 액세스를 위해 Kimi K-2.5를 로컬에 배포

- GPU 가속을 사용하여 llama.cpp 빌드 (Ubuntu 내부; 빌드 종속성 먼저 설치: sudo apt install build-essential cmake git):

git clone https://github.com/ggerganov/llama.cpp

cd llama.cpp && make LLAMA_CUDA=1 # 또는 해당되는 경우 ROCm/Metal2. GGUF 가중치 다운로드 (권장: unsloth/Kimi-K2.5-GGUF):

huggingface-cli download unsloth/Kimi-K2.5-GGUF --local-dir ./kimi-gguf(필요한 경우 huggingface-hub 설치: pip install -U huggingface_hub)

3. OpenAI 호환 서버 시작:

./llama-server -m ./kimi-gguf/kimi-k2.5-UD-IQ2_XXS.gguf --port 8080 --ctx-size 32768 --n-gpu-layers 99 --host 0.0.0.0 --flash-attn4. OpenClaw 구성 업데이트:

{

"agent": { "model": { "primary": "local-kimi/kimi-k2.5" } },

"models": {

"providers": {

"local-kimi": {

"baseUrl": "http://127.0.0.1:8080/v1",

"apiKey": "sk-no-key-required",

"api": "openai-completions",

"models": [

{ "id": "kimi-k2.5-local", "name": "Kimi K-2.5 Local GGUF", "contextWindow": 32768, "maxTokens": 4096 }

]

}

}

}

}5. 재시작: openclaw restart.

API 대 로컬 Kimi K-2.5 비교 (2026년)

| 기능 | Moonshot API (무료 티어) | 로컬 GGUF 추론 |

|---|---|---|

| 컨텍스트 창 | 256K 토큰 | 8K–128K (VRAM 제한) |

| 멀티모달 (이미지/비디오) | 완전 네이티브 | 이미지 지원; 비디오 일부 |

| 비용 | 무료 ~150만 토큰/일 (티어 0) | 다운로드 후 무료 |

| 개인 정보 보호 | Moonshot으로 전송됨 | 완전 로컬 |

| 지연 시간 | 낮음 (클라우드) | GPU 의존적 (5–40 t/s) |

| 에이전트 스웜 | 탁월함 | 좋음, 그러나 컨텍스트 제약 있음 |

| 권장 VRAM | 없음 | 적절한 양자화를 위해 24–96GB |

최대 기능을 위해 API를 선택하고, 과도하거나 민감한 사용을 위해서는 로컬로 전환하십시오.

OpenClaw 설정에서 Kimi K-2.5 성능 최적화

- 자동 실패를 방지하려면 구성의 contextWindow를 서버의 --ctx-size와 정확히 일치시키십시오.

- 정확한 코딩/에이전트 작업을 위해 온도를 낮추십시오 (0.6–0.8).

- 제공자 간 지연 시간 및 토큰 효율성을 벤치마킹하려면 Apidog를 사용하십시오.

- llama.cpp에서 플래시 어텐션을 활성화하여 20–40% 속도 향상을 얻으십시오.

- 로컬 실행의 경우, 낮은 양자화 (예: IQ3 또는 Q4)로 시작한 다음 VRAM이 허용하는 대로 업그레이드하십시오.

- 간결한 출력을 위해 Kimi K-2.5를 안내하도록 OpenClaw에 사용자 지정 시스템 프롬프트를 추가하십시오.

- 추론 중에는 nvidia-smi로 VRAM을 모니터링하고; 레이어를 적극적으로 오프로드하십시오.

- API 속도 제한이 나타나면 사용자 지정 스킬에 지수 백오프를 구현하십시오.

일반적인 Kimi K-2.5 + OpenClaw 문제 해결

- 401 Unauthorized: Apidog에서 키를 다시 확인하십시오.

- 컨텍스트 오버플로 충돌: --ctx-size를 줄이거나 기록을 요약하십시오.

- 느린 로컬 생성: --n-gpu-layers를 줄이고, 낮은 양자화를 사용하며, 최적화를 활성화하십시오.

- 멀티모달 로컬 실패: GGUF에 시각 지원이 포함되어 있는지 확인하고; API로 전환하십시오.

- 채팅 응답 없음: 제공자 오류에 대해 OpenClaw 로그를 확인하고; 서비스를 다시 시작하십시오.

Kimi K-2.5 및 OpenClaw를 위한 최종 권장 사항

Kimi K-2.5와 OpenClaw를 결합하면 유연하고 강력한 AI 에이전트를 만들 수 있습니다. 빠른 성과와 완전한 멀티모달/에이전트 기능을 위해 Moonshot API 무료 티어부터 시작하십시오. 하드웨어가 지원되면 무제한 개인 실행을 위해 로컬 GGUF 추론으로 전환하십시오.

모든 유효성 검사 단계를 간소화하려면 Apidog를 무료로 다운로드하십시오. 컨텍스트 크기 일치, 키 보안, 엔드포인트 벤치마킹과 같은 작은 구성 조정으로 가장 큰 신뢰성 향상을 얻을 수 있습니다.

오늘 두 가지 경로를 모두 실험해 보십시오. Kimi K-2.5와 OpenClaw는 최소 또는 제로 비용으로 최첨단 AI 기능을 함께 제공합니다.