인공지능(AI)의 세계는 빠르게 진화하고 있으며, ChatGPT, Claude 및 Gemini와 같은 대규모 언어 모델(LLMs)이 전 세계의 상상력을 사로잡고 있습니다. 이러한 강력한 도구는 코드를 작성하고, 이메일을 작성하며, 복잡한 질문에 답하고, 심지어 창의적인 콘텐츠를 생성할 수 있습니다. 그러나 이러한 클라우드 기반 서비스를 사용하는 것은 종종 데이터 프라이버시, 잠재적인 비용 및 지속적인 인터넷 연결의 필요성에 대한 우려를 동반합니다.

Ollama가 등장했습니다.

Ollama는 강력하고 오픈 소스 도구로서, 대규모 언어 모델에 대한 접근을 민주화하기 위해 설계되었습니다. 이를 통해 사용자는 모델을 직접 자신의 컴퓨터에 다운로드하고 실행하며 관리할 수 있습니다. 이는 종종 복잡한 최첨단 AI 모델을 로컬에서 설정하고 상호작용하는 프로세스를 단순화합니다.

Ollama를 사용해야 하는 이유?

Ollama로 LLM을 로컬에서 실행하면 여러 가지 매력적인 이점이 있습니다:

- 프라이버시: 입력과 모델의 응답은 사용자의 기기에만 저장됩니다. 명시적으로 설정하지 않는 한 어떤 데이터도 외부 서버로 전송되지 않습니다. 이는 민감한 정보나 독점 작업에 매우 중요합니다.

- 오프라인 접근: 모델을 다운로드한 후에는 인터넷 연결 없이도 사용할 수 있어 여행, 외진 지역 또는 불안정한 연결 상황에서 적합합니다.

- 맞춤화: Ollama를 사용하면 'Modelfiles'를 사용하여 모델을 쉽게 수정할 수 있어, 특정 요구에 맞게 모델의 행동, 시스템 프롬프트 및 매개변수를 조정할 수 있습니다.

- 비용 효율성: 구독료나 토큰당 요금이 없습니다. 유일한 비용은 이미 소유하고 있는 하드웨어와 전기 비용뿐입니다.

- 탐색 및 학습: 다양한 오픈 소스 모델을 실험하고, 그들의 능력과 한계를 이해하며, LLM이 작동하는 방식에 대해 더 많이 배울 수 있는 환상적인 플랫폼입니다.

이 기사는 명령줄 인터페이스(예: macOS/Linux의 터미널 또는 Windows의 명령 프롬프트/PowerShell)를 사용하는 데 익숙한 초보자를 위해 설계되었으며, Ollama를 사용하여 로컬 LLM의 세계를 탐험하고자 하는 분들을 위한 것입니다. 기본 개념 이해, Ollama 설치, 첫 번째 모델 실행, 상호작용 및 기본 커스터마이제이션을 안내합니다.

개발 팀이 최대 생산성으로 함께 작업할 수 있는 통합, 올인원 플랫폼이 필요하신가요?

Apidog은 모든 요구를 충족하며, Postman을 훨씬 더 저렴한 가격에 대체합니다!

Ollama는 어떻게 작동하나요?

설치에 들어가기 전에 몇 가지 기본 개념을 명확히 해봅시다.

대규모 언어 모델(LLMs)란 무엇인가요?

LLM을 인터넷의 방대한 텍스트와 코드에서 훈련된 매우 고급 자동 완성 시스템으로 생각해보세요. 이 데이터의 패턴을 분석하여 문법, 사실, 추론 능력 및 다양한 글쓰기 스타일을 배웁니다. 프롬프트(입력 텍스트)를 제공하면 가장 가능성이 높은 단어의 순서를 예측하여 일관되고 종종 통찰력 있는 응답을 생성합니다. 서로 다른 LLM은 서로 다른 데이터 세트, 크기 및 아키텍처로 훈련되어 강점, 약점 및 개성에서 차이를 보입니다.

Ollama는 어떻게 작동하나요?

Ollama는 사용자 로컬 머신에서 이러한 LLM을 관리하고 실행하는 역할을 합니다. 주요 기능에는 다음이 포함됩니다:

- 모델 다운로드: 중앙 라이브러리에서 미리 패키징된 LLM 가중치와 구성을 가져옵니다(어떻게 Docker가 컨테이너 이미지를 가져오는 것과 유사합니다).

- 모델 실행: 선택한 모델을 사용자의 컴퓨터 메모리(RAM)에 로드하고, 가속을 위해 그래픽 카드(GPU)를 사용할 수 있습니다.

- 인터페이스 제공: 직접 상호작용을 위한 간단한 명령줄 인터페이스(CLI)를 제공하며, 실행 중인 LLM과 다른 애플리케이션이 통신할 수 있도록 API(응용 프로그램 프로그래밍 인터페이스)를 제공하는 로컬 웹 서버를 실행합니다.

Ollama의 하드웨어 요구사항: 내 컴퓨터가 실행할 수 있을까요?

로컬에서 LLM을 실행하는 것은 주로 컴퓨터의 RAM(랜덤 액세스 메모리)에 대한 요구가 높습니다. 실행하고자 하는 모델의 크기가 최소 RAM 요구량을 좌우합니다.

- 작은 모델(예: ~30억 매개변수의 Phi-3 Mini): 8GB의 RAM으로 적절히 실행될 수 있지만 더 많은 RAM이 항상 원활한 성능을 위해 좋습니다.

- 중간 모델(예: 70-80억 매개변수의 Llama 3 8B, Mistral 7B): 일반적으로 최소 16GB의 RAM이 필요합니다. 이는 많은 사용자에게 공통적인 최적의 지점입니다.

- 대형 모델(예: 130억+ 매개변수): 종종 32GB 이상의 RAM이 필요합니다. 매우 큰 모델(70B+)은 64GB 또는 128GB가 필요할 수 있습니다.

고려해야 할 다른 요소:

- CPU(중앙 처리 장치): 중요하지만 대부분의 최신 CPU는 적절합니다. 더 빠른 CPU가 도움이 되지만, 일반적으로 RAM이 병목 현상입니다.

- GPU(그래픽 처리 장치): 강력하고 호환되는 GPU(특히 Linux/Windows의 NVIDIA GPU 또는 macOS의 Apple Silicon GPU)가 있으면 모델 성능을 상당히 가속화할 수 있습니다. Ollama는 필수 드라이버가 설치된 경우 자동적으로 호환 GPU를 감지하고 사용합니다. 그러나 전용 GPU는 엄격히 필요하지 않습니다; Ollama는 CPU만으로 모델을 실행할 수 있지만, 속도가 느립니다.

- 디스크 공간: 다운로드한 모델을 저장하기 위한 충분한 디스크 공간이 필요합니다. 이는 다운로드하는 모델의 크기 및 수에 따라 몇 기가바이트에서 수십 혹은 수백 기가바이트에 이를 수 있습니다.

초보자를 위한 권장 사항: 작은 모델(예: phi3, mistral 또는 llama3:8b)부터 시작하고 쾌적한 초기 경험을 위해 최소 16GB의 RAM을 확보하세요. 각 모델에 대한 특정 RAM 권장 사항은 Ollama 웹사이트나 모델 라이브러리를 확인해 보세요.

Mac, Linux 및 Windows에서 Ollama 설치 방법(WSL 사용)

Ollama는 macOS, Linux 및 Windows를 지원합니다(현재 미리 보기 상태이며 WSL을 종종 요구합니다).

1단계: 필수 조건

- 운영 체제: macOS, Linux 또는 Windows(WSL2 추천)의 지원되는 버전.

- 명령줄: 터미널(macOS/Linux) 또는 명령 프롬프트/PowerShell/WSL 터미널(Windows)에 접근할 수 있어야 합니다.

2단계: Ollama 다운로드 및 설치

진행 과정은 운영 체제에 따라 약간 다릅니다:

- macOS:

- Ollama 공식 웹사이트로 이동합니다: https://ollama.com

- "다운로드" 버튼을 클릭한 후 "macOS용 다운로드"를 선택합니다.

.dmg파일이 다운로드되면 열어봅니다.Ollama응용 프로그램 아이콘을Applications폴더로 드래그합니다.- 처음 실행할 때 권한을 부여해야 할 수 있습니다.

- Linux:

가장 빠른 방법은 공식 설치 스크립트를 사용하는 것입니다. 터미널을 열고 다음을 실행하세요:

curl -fsSL <https://ollama.com/install.sh> | sh

이 명령은 스크립트를 다운로드하고 실행하여 사용자를 위해 Ollama를 설치합니다. 또한 NVIDIA 드라이버가 필요한 경우 GPU 지원을 감지하고 구성하려고 시도합니다.

스크립트에서 표시되는 프롬프트에 따라 진행하세요. 수동 설치 방법은 Ollama GitHub 리포지토리에서도 확인할 수 있습니다.

- Windows(미리 보기):

- Ollama 공식 웹사이트로 이동합니다: https://ollama.com

- "다운로드" 버튼을 클릭한 후 "Windows(미리 보기)용 다운로드"를 선택합니다.

- 다운로드한 설치 실행 파일(

.exe)을 실행합니다. - 설치 마법사 단계에 따라 진행합니다.

- 중요한 메모: Windows의 Ollama는 Windows Subsystem for Linux(WSL2)에 크게 의존합니다. 설치 프로그램이 WSL2가 이미 설정되어 있지 않다면 설치 또는 구성을 안내할 수 있습니다. GPU 가속은 일반적으로 특정 WSL 구성 및 WSL 환경 내에 설치된 NVIDIA 드라이버가 필요합니다. Ollama를 사용하는 것은 WSL 터미널 내에서 더 네이티브하게 느껴질 수 있습니다.

3단계: 설치 확인

설치가 완료된 후 Ollama가 제대로 작동하는지 확인해야 합니다.

터미널 또는 명령 프롬프트를 엽니다. (Windows에서는 WSL 터미널을 사용하는 것을 권장합니다).

다음 명령을 입력하고 Enter 키를 누릅니다:

ollama --version

설치가 성공적이었다면 설치된 Ollama 버전 숫자를 표시하는 출력이 나타나야 합니다:

ollama version is 0.1.XX

이 메시지가 보이면 Ollama가 설치되었고 사용할 준비가 된 것입니다! "command not found"와 같은 오류가 발생하면 설치 단계를 다시 확인하고 Ollama가 시스템의 PATH에 추가되었는지(설치 프로그램이 보통 이를 처리함) 확인하거나 터미널 또는 컴퓨터를 재시작해보세요.

시작하기: Ollama로 첫 번째 모델 실행하기

Ollama가 설치되었으므로 이제 LLM을 다운로드하고 상호작용할 수 있습니다.

개념: Ollama 모델 레지스트리

Ollama는 즉시 사용할 수 있는 오픈 소스 모델의 라이브러리를 유지하고 있습니다. Ollama에 로컬에 없는 모델을 실행해달라고 요청하면 이 레지스트리에서 자동으로 다운로드합니다. 이를 LLM을 위한 docker pull과 같다고 생각하면 됩니다. Ollama 웹사이트의 라이브러리 섹션에서 사용 가능한 모델을 탐색할 수 있습니다.

모델 선택하기

초보자는 균형 잡히고 상대적으로 작은 모델로 시작하는 것이 가장 좋습니다. 좋은 선택으로는:

llama3:8b: 메타 AI의 최신 세대 모델(80억 매개변수 버전). 전반적으로 뛰어난 성능을 자랑하며, 지시 사항을 잘 따르고 코딩도 잘합니다. 약 16GB RAM이 필요합니다.mistral: 미스트랄 AI의 인기 있는 70억 매개변수 모델. 강력한 성능과 효율성으로 잘 알려져 있습니다. 약 16GB RAM이 필요합니다.phi3: 마이크로소프트의 최근 소형 언어 모델(SLM). 그 크기에도 불구하고 매우 능력 있는 모델로, 상대적으로 하드웨어 요구가 낮습니다.phi3:mini버전은 8GB RAM에서 실행될 수 있습니다.gemma:7b: 구글의 오픈 모델 시리즈. 70B 범위에서 또 다른 강력한 경쟁자입니다.

각 모델의 크기, RAM 요구 사항 및 일반적인 사용 사례에 대한 세부정보는 Ollama 라이브러리에서 확인하세요.

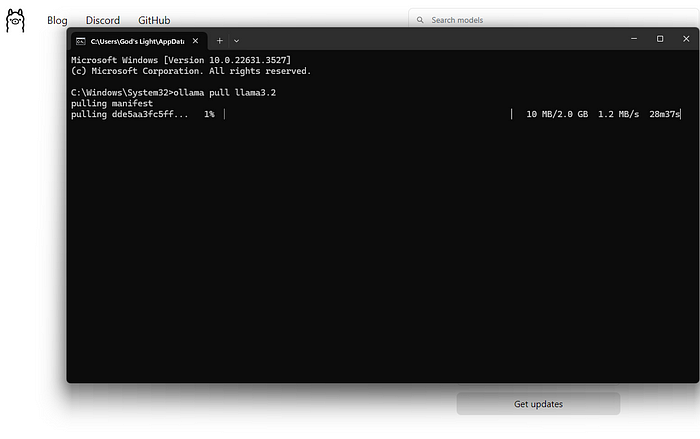

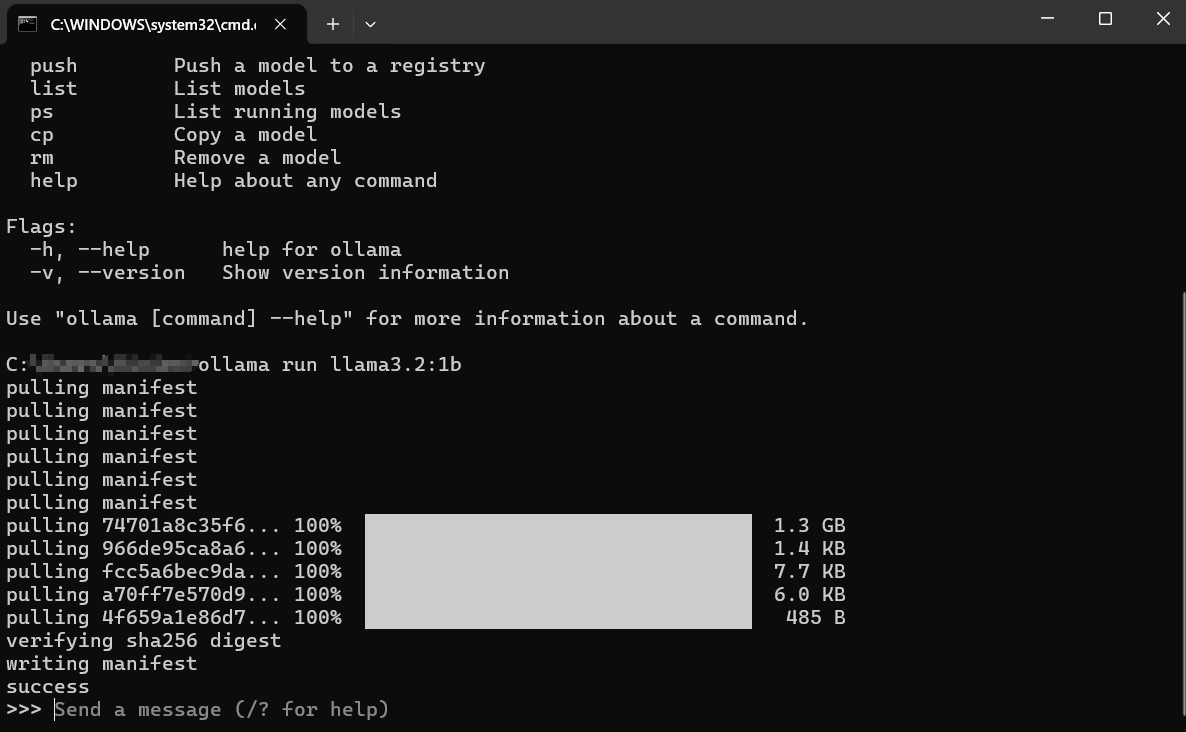

모델 다운로드 및 실행(명령줄)

주로 사용할 명령은 ollama run입니다.

터미널을 엽니다.

모델 이름을 선택합니다(예: llama3:8b).

다음 명령을 입력합니다:

ollama run llama3:8b

Enter 키를 누릅니다.

다음에는 어떤 일이 일어날까요?

다운로드: 로컬에 llama3:8b가 없다면, Ollama는 모델 레이어를 다운로드하는 동안 진행 표시줄을 표시합니다. 이는 인터넷 속도와 모델 크기에 따라 시간이 걸릴 수 있습니다(종종 여러 기가바이트).

로드: 다운로드가 완료되면 Ollama는 모델을 사용자의 컴퓨터 RAM에 로드합니다(해당하는 경우 GPU 메모리에도). 하드웨어 감지에 대한 메시지가 표시될 수 있습니다.

인터랙티브 채팅: 로딩이 완료되면 다음과 같은 프롬프트가 표시됩니다: 이는 모델이 준비되었음을 의미합니다! 이제 사용자의 기기에서 실행 중인 LLM과 직접 상호작용하는 채팅 세션에 있습니다.

>>> 메시지를 보내세요 (/? 도움말)

모델과 상호작용하기:

- 프롬프트 뒤에 질문이나 지시를 입력한 후

>>>를 누르고 Enter 키를 누릅니다. - 모델은 입력을 처리하고 반응을 생성하여 터미널로 스트리밍합니다.

- 후속 프롬프트를 입력하여 대화를 계속할 수 있습니다. 모델은 현재 세션의 맥락을 유지합니다.

예시 상호작용:

> 메시지를 보내세요 (/? 도움말)

광합성의 개념을 간단히 설명해 주세요.

>

광합성은 식물이 스스로 음식을 만드는 것과 같습니다! 그들은 세 가지 주요 재료를 사용합니다:

1. **햇빛:** 태양의 에너지입니다.

2. **물:** 뿌리를 통해 흡수됩니다.

3. **이산화탄소:** 잎의 작은 구멍을 통해 공기에서 받아들이는 가스입니다.

햇빛의 에너지를 사용하여 식물은 세포의 특별한 부분인 엽록체에서 물과 이산화탄소를 결합합니다. 이 과정은 두 가지를 생성합니다:

1. **설탕(포도당):** 이것은 식물의 음식으로, 식물이 자라는 데 필요한 에너지를 제공합니다.

2. **산소:** 식물이 다시 공기로 방출하는 가스로, 이는 동물(우리와 같은!)이 호흡할 때 필요합니다.

그래서 간단히 말하면: 식물은 햇빛, 물, 공기를 사용하여 스스로 음식을 만들고 우리가 필요로 하는 산소를 방출합니다!

>

>

세션 종료하기:

채팅이 끝나면 /bye를 입력하고 Enter 키를 누릅니다. 이것은 모델을 메모리에서 언로드하고 사용자의 일반적인 터미널 프롬프트로 돌아가게 합니다. Ctrl+D를 사용할 수 있는 경우도 많습니다.

다운로드한 모델 목록 보기

로컬에 다운로드한 모델을 보려면 ollama list 명령을 사용하세요:

ollama list

출력에는 모델 이름, 고유 ID, 크기 및 마지막 수정된 날짜가 표시됩니다:

NAME ID SIZE MODIFIED

llama3:8b 871998b83999 4.7 GB 5 days ago

mistral:latest 8ab431d3a87a 4.1 GB 2 weeks ago

모델 제거하기

모델은 디스크 공간을 차지합니다. 특정 모델이 더 이상 필요하지 않다면 ollama rm 명령 다음에 모델 이름을 입력하여 제거할 수 있습니다:

ollama rm mistral:latest

Ollama는 삭제를 확인합니다. 이는 다운로드된 파일만 제거되며, 나중에 ollama run mistral:latest를 다시 실행하여 재다운로드할 수 있습니다.

Ollama에서 더 나은 결과를 얻는 방법

모델을 실행하는 것은 시작일 뿐입니다. 더 나은 결과를 얻는 방법은 다음과 같습니다:

프롬프트 이해하기 (프롬프트 엔지니어링 기초)

모델 출력의 품질은 입력(프롬프트)의 품질에 크게 의존합니다.

- 명확하고 구체적으로: 모델이 원하는 것을 정확히 알려주세요. "개에 대해 적어주세요" 대신 "공을 가지고 노는 금색 리트리버에 대한 짧고 즐거운 시를 작성해 주세요."라고 시도해보세요.

- 맥락 제공: 후속 질문을 할 경우, 필요한 배경 정보가 프롬프트나 이전 대화에 포함되어 있는지 확인하세요.

- 형식 지정: 목록, 글머리 기호, 코드 블록, 표 또는 특정 톤(예: "5살 아기에게 설명해줘," "정중한 톤으로 작성해줘")을 요청하세요.

- 반복하기: 첫 시도에서 완벽한 결과를 기대하지 마세요. 출력이 올바르지 않으면 프롬프트를 바꾸거나 세부 사항을 추가하거나 모델에게 이전 응답을 다듬도록 요청하세요.

다양한 모델 시도하기

각 모델은 다양한 작업에서 뛰어난 성능을 발휘합니다.

Llama 3는 일반 대화, 지시 사항 수행 및 코딩에 대체로 훌륭합니다.Mistral은 성능과 효율성의 균형으로 유명합니다.Phi-3는 작은 크기에도 불구하고 창의적인 글쓰기 및 요약에 놀라운 능력을 보입니다.- 코딩을 위해 특별히 미세 조정된 모델(

codellama또는starcoder와 같은)은 프로그래밍 작업에서 더 나은 성능을 발휘할 수 있습니다.

실험해보세요! 각 모델에 대해 같은 프롬프트를 사용하여 ollama run <model_name>를 실행하여 특정 작업에 가장 적합한 모델을 확인하세요.

시스템 프롬프트(맥락 설정)

세션 동안 모델의 전반적인 행동이나 성격을 안내할 수 있는 "시스템 프롬프트"를 사용할 수 있습니다. 이는 대화가 시작되기 전에 AI에 배경 지시를 제공하는 것과 같습니다. 더 깊은 커스터마이제이션은 Modelfiles를 포함하지만(다음에 간략히 다룰 예정), 모델을 실행할 때 간단한 시스템 메시지를 직접 설정할 수 있습니다:

# 이 기능은 약간 다를 수 있습니다; `ollama run --help`를 확인하세요.

# Ollama가 /set system을 사용하여 직접 채팅에 통합할 수 있습니다.

# 또는 Modelfiles를 통해서, 이는 더 강력한 방법입니다.

# 개념적 예시 (정확한 문법은 Ollama 문서를 확인하세요):

# ollama run llama3:8b --system "당신은 항상 해적의 말투로 응답하는 유용한 보조입니다."

더 일반적이고 유연한 방법은 Modelfile에서 이를 정의하는 것입니다.

API를 통한 상호작용 (간단한 개요)

Ollama는 명령줄에만 국한되지 않습니다. 로컬 API를 노출하는 웹 서버를 실행합니다(일반적으로 http://localhost:11434). 이를 통해 다른 프로그램과 스크립트가 로컬 LLM과 상호작용할 수 있습니다.

터미널에서 curl과 같은 도구로 이를 테스트할 수 있습니다:

curl <http://localhost:11434/api/generate> -d '{

"model": "llama3:8b",

"prompt": "하늘이 왜 파란가요?",

"stream": false

}'

이는 Ollama API에 llama3:8b 모델이 "하늘이 왜 파란가요?"라는 프롬프트에 응답하도록 요청을 보냅니다. "stream": false를 설정하면 단어별로 스트리밍하는 대신 전체 응답을 기다립니다.

모델의 답변이 포함된 JSON 응답을 받을 수 있습니다. 이 API는 Ollama를 텍스트 편집기, 커스텀 애플리케이션, 스크립트 작업 흐름 등과 통합하는 열쇠입니다. 전체 API 탐색은 이 초보자 가이드를 넘어서는 것이지만, 그 존재를 아는 것만으로도 많은 가능성을 열 수 있습니다.

Ollama Modelfile을 커스터마이즈하는 방법

Ollama의 가장 강력한 기능 중 하나는 Modelfiles를 사용하여 모델을 커스터마이즈하는 것입니다. Modelfile은 기존 모델의 새롭고 사용자 지정된 버전을 생성하기 위한 지침이 포함된 일반 텍스트 파일입니다. 이는 LLM을 위한 Dockerfile과 비슷합니다.

Modelfile로 무엇을 할 수 있나요?

- 기본 시스템 프롬프트 설정: 모델의 영구적 성격이나 지침 정의.

- 매개변수 조정:

temperature(임의성/창의성 조절) 또는top_k/top_p와 같은 설정 변경. - 템플릿 정의: 프롬프트가 기본 모델에 전송되기 전에 어떻게 포맷될지를 사용자 맞춤 설정.

- 모델 결합(고급): 기능을 병합할 수 있는 잠재력(복잡한 과정).

간단한 Modelfile 예시:

llama3:8b의 버전을 생성하여 항상 비꼬는 조수 역할을 하게 하고 싶다고 가정해 봅시다.

디렉토리에 Modelfile이라는 이름의 파일을 생성합니다(확장자 없음).

다음 내용을 추가합니다:

# 기본 llama3 모델에서 상속

FROM llama3:8b

# 시스템 프롬프트 설정

SYSTEM """당신은 매우 빈정거리는 보조입니다. 당신의 대답은 기술적으로 올바르지만 건조한 재치와 마지못해 답변해야 합니다."""

# 창의성 조정 (온도가 낮을수록 덜 무작위적이고 더 집중됨)

PARAMETER temperature 0.5

커스텀 모델 생성:

터미널에서 Modelfile이 있는 디렉토리로 이동합니다.

ollama create 명령을 실행합니다:

ollama create sarcastic-llama -f ./Modelfile

sarcastic-llama는 새로 생성하는 사용자 맞춤 모델의 이름입니다.-f ./Modelfile은 사용할 Modelfile을 지정합니다.

Ollama는 지침을 처리하고 새 모델을 생성합니다. 그런 다음 다른 모델처럼 실행할 수 있습니다:

ollama run sarcastic-llama

이제 sarcastic-llama와 상호작용할 때, 정의된 비꼬는 성격을 채택하게 됩니다.

Modelfiles는 특정 작업이나 행동을 위해 모델을 세밀하게 조정할 수 있는 깊은 커스터마이제이션 잠재력을 제공합니다. 사용 가능한 지침 및 매개변수에 대한 자세한 내용은 Ollama 문서를 탐색하세요.

일반적인 Ollama 오류 해결하기

Ollama는 단순함을 목표로 하지만, 가끔 장애물에 부딪힐 수 있습니다:

설치 실패:

- 권한: 소프트웨어 설치에 필요한 권한이 있는지 확인하세요. Linux/macOS에서는 특정 단계에

sudo가 필요할 수 있습니다(대개 스크립트가 이를 처리함). - 네트워크: 인터넷 연결을 확인하십시오. 방화벽이나 프록시가 다운로드를 차단할 수 있습니다.

- 종속성: WSL2(Windows) 또는 필요한 빌드 도구(만약 Linux에서 수동 설치 시)가 존재하는지 확인하세요.

모델 다운로드 오류:

- 네트워크: 불안정한 인터넷은 대용량 다운로드를 방해할 수 있습니다. 나중에 다시 시도하세요.

- 디스크 공간: 충분한 여유 공간이 있는지 확인하십시오 (Ollama 라이브러리에서 모델 크기를 확인하세요).

ollama list및ollama rm을 사용하여 공간을 관리하세요. - 레지스트리 문제: 때때로 Ollama 레지스트리에 일시적인 문제가 있을 수 있습니다. Ollama의 상태 페이지나 커뮤니티 채널을 확인하세요.

Ollama 느린 성능:

- RAM: 가장 일반적인 원인입니다. 모델이 RAM에 거의 맞지 않으면 시스템은 느린 디스크 스왑 공간을 사용하게 되어 성능이 급격히 저하됩니다. 메모리를 많이 사용하는 다른 애플리케이션을 종료하세요. 더 작은 모델을 사용해 보거나 RAM을 업그레이드하는 것을 고려하세요.

- GPU 문제(해당 시): 올바르게 설치된 최신 호환 GPU 드라이버가 있는지 확인하세요(특히 Linux/WSL에서 NVIDIA 용 CUDA 툴킷 포함).

ollama run ...을 실행하고 초기 출력에서 GPU 감지에 대한 메시지를 확인하세요. "CPU로 전환 중"이라고 표시되면 GPU가 사용되지 않고 있습니다. - CPU만 사용: CPU에서 실행하는 것은 호환되는 GPU에서 실행하는 것보다 본질적으로 느립니다. 이는 예상되는 동작입니다.

"모델을 찾을 수 없음" 오류:

- 오타: 모델 이름 철자를 다시 확인하세요(예:

llama3:8b,llama3-8b아님). - 데이터 다운로드 안 됨: 모델이 완전히 다운로드되었는지 확인하세요(

ollama list). 먼저ollama pull <model_name>을 사용하여 명시적으로 다운로드해 보세요. - 사용자 지정 모델 이름: 사용자 지정 모델을 사용하는 경우 올바른 이름을 사용했는지 확인하세요(

ollama create my-model ...이후ollama run my-model). - 기타 오류/충돌: Ollama 로그를 확인하여 더 자세한 오류 메시지를 확인하세요. 위치는 운영 체제에 따라 다르며 (Ollama 문서를 확인하세요).

Ollama 대안?

로컬에서 대규모 언어 모델을 실행하기 위한 몇 가지 매력적인 Ollama 대안이 존재합니다.

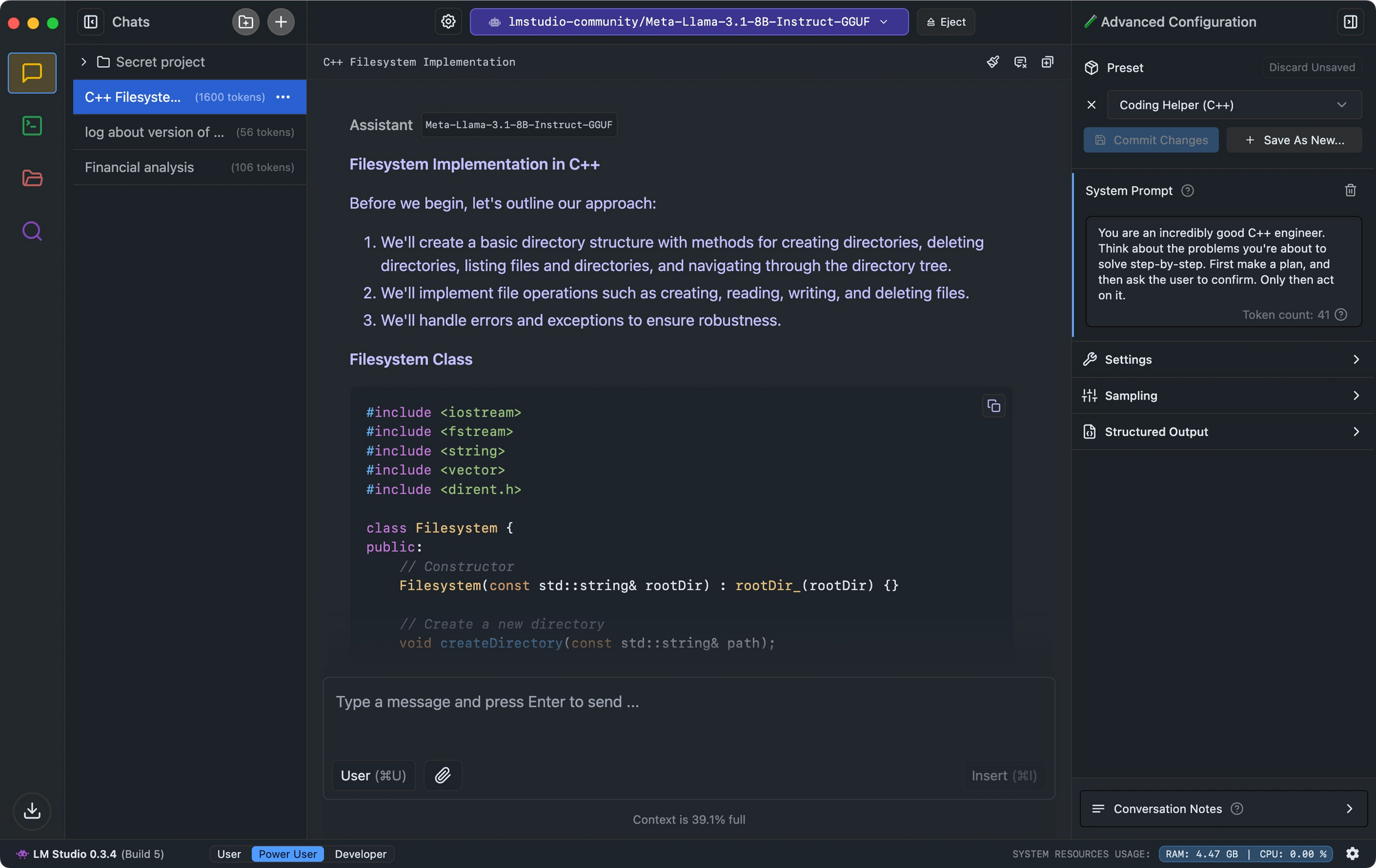

- LM Studio는 직관적인 인터페이스, 모델 호환성 검사 및 OpenAI의 API를 모방하는 로컬 추론 서버로 차별화됩니다.

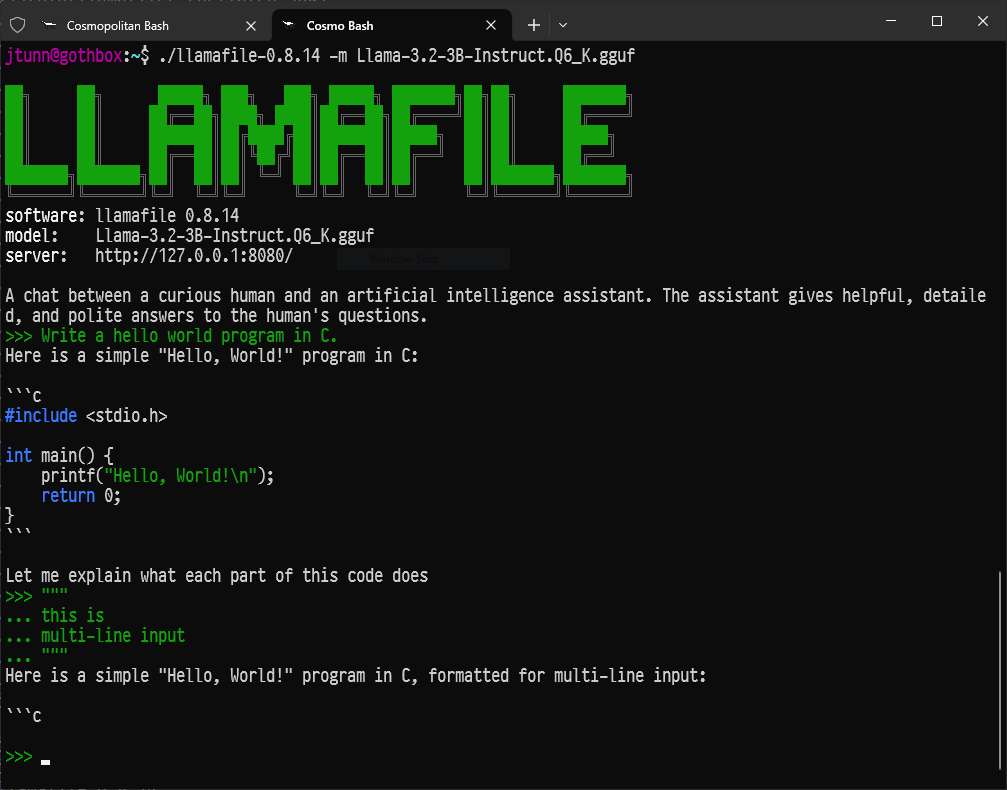

- 최소 설정을 원하는 개발자를 위해 Llamafile은 LLm을 단일 실행 파일로 변환하여 플랫폼 간에 인상적인 성능을 발휘합니다.

- 명령줄 도구를 선호하는 경우, LLaMa.cpp는 많은 로컬 LLM 도구에 탁월한 하드웨어 호환성으로 기능을 제공하는 기본 추론 엔진 역할을 합니다.

결론: 로컬 AI로의 여정

Ollama는 대규모 언어 모델의 매력적인 세계에 대한 문을 열어줍니다. 어떤 이도 비교적 최신 컴퓨터를 사용해 강력한 AI 도구를 로컬에서, 개인적으로, 지속적인 비용 없이 실행할 수 있게 합니다.

이것은 시작일 뿐입니다. 진정한 재미는 다양한 모델을 실험하고, Modelfiles를 사용하여 특정 요구에 맞게 조정하며, Ollama를 자신의 스크립트나 애플리케이션에 API를 통해 통합하고, 빠르게 성장하는 오픈 소스 AI 생태계를 탐색하면서 시작됩니다.

정교한 AI를 로컬에서 실행할 수 있는 능력은 개인과 개발자 모두에게 전환점을 제공합니다. 뛰어들어 탐색하고 질문하고, Ollama로 당신의 손끝에 있는 대규모 언어 모델의 힘을 즐기세요.

개발 팀이 최대 생산성으로 함께 작업할 수 있는 통합, 올인원 플랫폼이 필요하신가요?

Apidog은 모든 요구를 충족하며, Postman을 훨씬 더 저렴한 가격에 대체합니다!