Claude Code 내에서 Open AI의 오픈 웨이트 모델인 GPT-OSS로 코딩 워크플로우를 강화하고 싶으신가요? 정말 좋은 소식입니다! 2025년 8월에 출시된 GPT-OSS(20B 또는 120B 변형)는 코딩 및 추론을 위한 강력한 도구이며, Claude Code의 세련된 CLI 인터페이스와 무료 또는 저렴한 비용으로 페어링할 수 있습니다. 이 대화형 가이드에서는 Hugging Face, OpenRouter 또는 LiteLLM을 사용하여 GPT-OSS를 Claude Code와 통합하는 세 가지 방법을 안내해 드립니다. 지금 바로 시작하여 AI 코딩 도우미를 가동해 보세요!

최대 생산성으로 개발팀이 함께 작업할 수 있는 통합된 올인원 플랫폼을 원하십니까?

Apidog는 귀하의 모든 요구 사항을 충족하며, Postman을 훨씬 저렴한 가격으로 대체합니다!

GPT-OSS란 무엇이며 Claude Code와 함께 사용해야 하는 이유는 무엇인가요?

GPT-OSS는 Open AI의 오픈 웨이트 모델 제품군으로, 20B 및 120B 변형은 코딩, 추론 및 에이전트 작업에 탁월한 성능을 제공합니다. 128K 토큰 컨텍스트 창과 Apache 2.0 라이선스를 통해 유연성과 제어를 원하는 개발자에게 완벽합니다. Anthropic의 CLI 도구(버전 0.5.3+)인 Claude Code는 대화형 코딩 기능으로 개발자들에게 인기가 많습니다. OpenAI 호환 API를 통해 Claude Code를 GPT-OSS로 라우팅하면 Anthropic 구독 비용 없이 Claude의 익숙한 인터페이스를 즐기면서 GPT-OSS의 오픈 소스 기능을 활용할 수 있습니다. 준비되셨나요? 설정 옵션을 살펴보겠습니다!

Claude Code와 GPT-OSS 사용을 위한 전제 조건

시작하기 전에 다음을 확인하세요:

- Claude Code ≥ 0.5.3:

claude --version으로 확인하세요.pip install claude-code로 설치하거나pip install --upgrade claude-code로 업데이트하세요. - Hugging Face 계정: huggingface.co에서 가입하고 읽기/쓰기 토큰을 생성하세요 (설정 > 액세스 토큰).

- OpenRouter API 키: 선택 사항, 경로 B용. openrouter.ai에서 얻으세요.

- Python 3.10+ 및 Docker: 로컬 설정 또는 LiteLLM(경로 C)용.

- 기본 CLI 지식: 환경 변수 및 터미널 명령에 대한 지식이 도움이 됩니다.

경로 A: Hugging Face에서 GPT-OSS 자체 호스팅

완전한 제어를 원하시나요? Hugging Face의 추론 엔드포인트에 GPT-OSS를 호스팅하여 비공개적이고 확장 가능한 설정을 구축하세요. 방법은 다음과 같습니다:

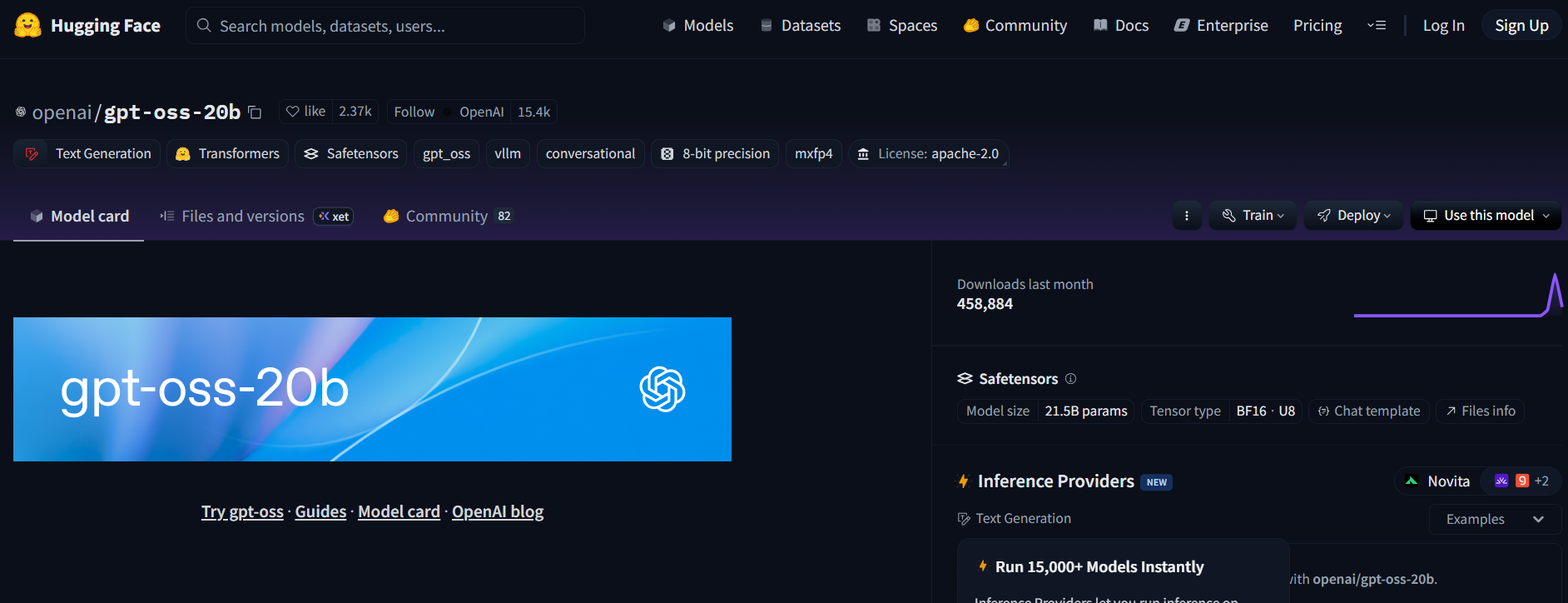

1단계: 모델 가져오기

- Hugging Face의 GPT-OSS 저장소(openai/gpt-oss-20b 또는 openai/gpt-oss-120b)를 방문하세요.

- 모델에 액세스하려면 Apache 2.0 라이선스에 동의하세요.

- 또는 코딩 중심 모델로 Qwen3-Coder-480B-A35B-Instruct(Qwen/Qwen3-Coder-480B-A35B-Instruct)를 사용해 보세요 (가벼운 하드웨어에는 GGUF 버전을 사용하세요).

2단계: 텍스트 생성 추론 엔드포인트 배포

- 모델 페이지에서 Deploy > Inference Endpoint를 클릭하세요.

- Text Generation Inference (TGI) 템플릿(≥ v1.4.0)을 선택하세요.

- Enable OpenAI compatibility를 선택하거나 고급 설정에서

--enable-openai를 추가하여 OpenAI 호환성을 활성화하세요. - 하드웨어 선택: 20B의 경우 A10G 또는 CPU, 120B의 경우 A100. 엔드포인트를 생성하세요.

3단계: 자격 증명 수집

- 엔드포인트 상태가 실행 중이 되면 다음을 복사하세요:

- ENDPOINT_URL:

https://<your-endpoint>.us-east-1.aws.endpoints.huggingface.cloud와 유사합니다. - HF_API_TOKEN: 설정 > 액세스 토큰에서 가져온 Hugging Face 토큰.

2. 모델 ID를 기록해 두세요 (예: gpt-oss-20b 또는 gpt-oss-120b).

4단계: Claude Code 구성

- 터미널에서 환경 변수를 설정하세요:

export ANTHROPIC_BASE_URL="https://<your-endpoint>.us-east-1.aws.endpoints.huggingface.cloud"

export ANTHROPIC_AUTH_TOKEN="hf_xxxxxxxxxxxxxxxxx"

export ANTHROPIC_MODEL="gpt-oss-20b" # 또는 gpt-oss-120b

<your-endpoint> 및 hf_xxxxxxxxxxxxxxxxx를 실제 값으로 바꾸세요.

2. 설정을 테스트하세요:

claude --model gpt-oss-20b

Claude Code는 TGI의 /v1/chat/completions API를 통해 응답을 스트리밍하여 OpenAI의 스키마를 모방하며, GPT-OSS 엔드포인트로 라우팅됩니다.

5단계: 비용 및 확장 참고 사항

- Hugging Face 비용: 추론 엔드포인트는 자동 확장되므로, 크레딧 소진을 피하기 위해 사용량을 모니터링하세요. A10G는 시간당 약 $0.60, A100은 시간당 약 $3입니다.

- 로컬 옵션: 클라우드 비용 없이 TGI를 Docker로 로컬에서 실행하세요:

docker run --name tgi -p 8080:80 -e HF_TOKEN=hf_xxxxxxxxxxxxxxxxx ghcr.io/huggingface/text-generation-inference:latest --model-id openai/gpt-oss-20b --enable-openai

그런 다음 ANTHROPIC_BASE_URL="http://localhost:8080"로 설정하세요.

경로 B: OpenRouter를 통한 GPT-OSS 프록시

DevOps가 없으신가요? 문제없습니다! OpenRouter를 사용하여 최소한의 설정으로 GPT-OSS에 액세스하세요. 빠르고 청구를 처리해 줍니다.

1단계: 등록 및 모델 선택

- openrouter.ai에서 가입하고 Keys 섹션에서 API 키를 복사하세요.

- 모델 슬러그를 선택하세요:

openai/gpt-oss-20bopenai/gpt-oss-120bqwen/qwen3-coder-480b(Qwen의 코더 모델용)

2단계: Claude Code 구성

- 환경 변수를 설정하세요:

export ANTHROPIC_BASE_URL="https://openrouter.ai/api/v1"

export ANTHROPIC_AUTH_TOKEN="or_xxxxxxxxx"

export ANTHROPIC_MODEL="openai/gpt-oss-20b"

or_xxxxxxxxx를 OpenRouter API 키로 바꾸세요.

2. 테스트하세요:

claude --model openai/gpt-oss-20b

Claude Code는 OpenRouter의 통합 API를 통해 GPT-OSS에 연결되며, 스트리밍 및 폴백을 지원합니다.

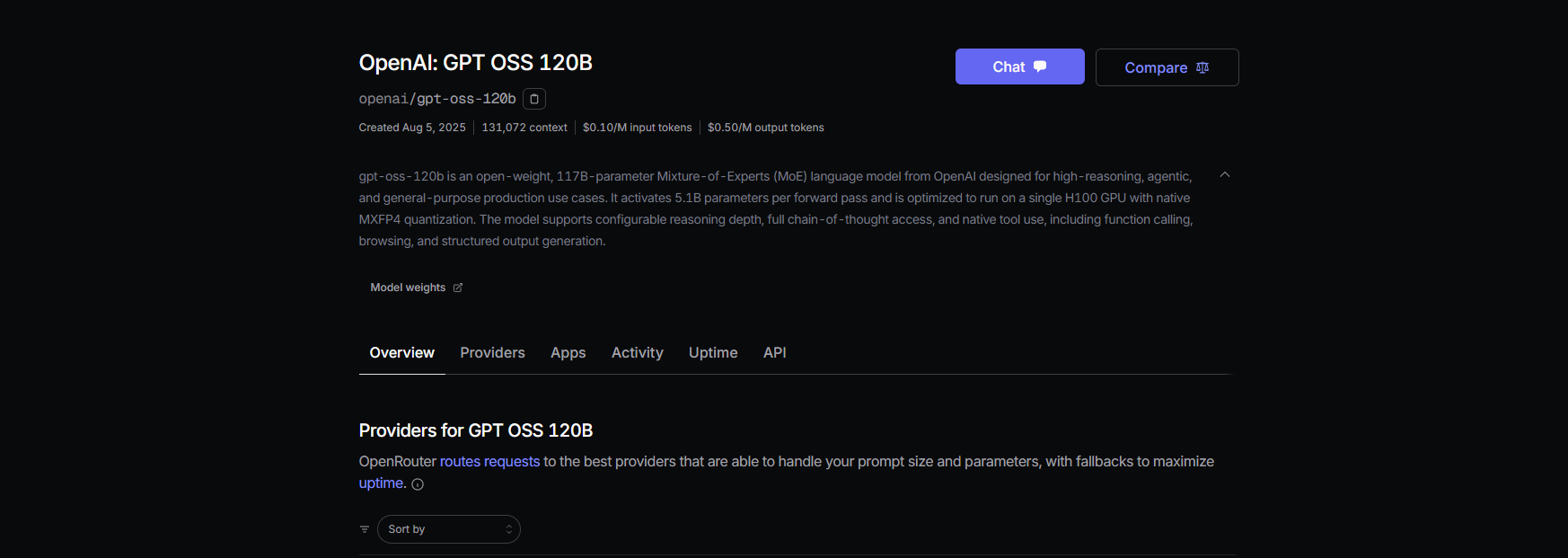

3단계: 비용 참고 사항

- OpenRouter 가격: GPT-OSS-120B의 경우 입력 토큰당 약 $0.50/M, 출력 토큰당 약 $2.00/M으로, GPT-4와 같은 독점 모델(약 $20.00/M)보다 훨씬 저렴합니다.

- 청구: OpenRouter가 사용량을 관리하므로 사용한 만큼만 지불합니다.

경로 C: 혼합 모델 플릿에 LiteLLM 사용

단일 워크플로우에서 GPT-OSS, Qwen 및 Anthropic 모델을 저글링하고 싶으신가요? LiteLLM은 모델을 원활하게 핫스왑하는 프록시 역할을 합니다.

1단계: LiteLLM 설치 및 구성

- LiteLLM 설치:

pip install litellm

2. 구성 파일(litellm.yaml) 생성:

model_list:

- model_name: gpt-oss-20b

litellm_params:

model: openai/gpt-oss-20b

api_key: or_xxxxxxxxx # OpenRouter 키

api_base: https://openrouter.ai/api/v1

- model_name: qwen3-coder

litellm_params:

model: openrouter/qwen/qwen3-coder

api_key: or_xxxxxxxxx

api_base: https://openrouter.ai/api/v1

or_xxxxxxxxx를 OpenRouter 키로 바꾸세요.

3. 프록시 시작:

litellm --config litellm.yaml

2단계: Claude Code를 LiteLLM으로 지정

- 환경 변수를 설정하세요:

export ANTHROPIC_BASE_URL="http://localhost:4000"

export ANTHROPIC_AUTH_TOKEN="litellm_master"

export ANTHROPIC_MODEL="gpt-oss-20b"

2. 테스트하세요:

claude --model gpt-oss-20b

LiteLLM은 OpenRouter를 통해 GPT-OSS로 요청을 라우팅하며, 비용 로깅 및 안정성을 위한 간단한 셔플 라우팅을 제공합니다.

3단계: 참고 사항

- 지연 시간 라우팅 피하기: Anthropic 모델과의 문제를 방지하려면 LiteLLM에서 간단한 셔플 모드를 사용하세요.

- 비용 추적: LiteLLM은 투명성을 위해 사용량을 기록합니다.

Claude Code로 GPT-OSS 테스트하기

GPT-OSS가 작동하는지 확인해 봅시다! Claude Code를 열고 다음 명령을 시도해 보세요:

코드 생성:

claude --model gpt-oss-20b "Write a Python REST API with Flask"

다음과 같은 응답을 예상할 수 있습니다:

from flask import Flask, jsonify

app = Flask(__name__)

@app.route('/api', methods=['GET'])

def get_data():

return jsonify({"message": "Hello from GPT-OSS!"})

if __name__ == '__main__':

app.run(debug=True)

코드베이스 분석:

claude --model gpt-oss-20b "Summarize src/server.js"

GPT-OSS는 128K 컨텍스트 창을 활용하여 JavaScript 파일을 분석하고 요약을 반환합니다.

디버깅:

claude --model gpt-oss-20b "Debug this buggy Python code: [paste code]"

87.3%의 HumanEval 통과율로 GPT-OSS는 문제를 정확하게 찾아내고 수정할 수 있습니다.

문제 해결 팁

- /v1/chat/completions에서 404 오류? TGI(경로 A)에서

--enable-openai가 활성화되어 있는지 확인하거나 OpenRouter의 모델 가용성(경로 B)을 확인하세요. - 빈 응답?

ANTHROPIC_MODEL이 슬러그(예:gpt-oss-20b)와 일치하는지 확인하세요. - 모델 스왑 후 400 오류? LiteLLM(경로 C)에서 간단한 셔플 라우팅을 사용하세요.

- 첫 토큰이 느리게 생성되나요? 0으로 스케일링한 후 작은 프롬프트로 Hugging Face 엔드포인트를 워밍업하세요.

- Claude Code가 충돌하나요? 0.5.3 이상으로 업데이트하고 환경 변수가 올바르게 설정되었는지 확인하세요.

Claude Code와 함께 GPT-OSS를 사용해야 하는 이유

GPT-OSS와 Claude Code를 페어링하는 것은 개발자의 꿈입니다. 다음을 얻을 수 있습니다:

- 비용 절감: OpenRouter의 입력 토큰당 $0.50/M은 독점 모델보다 저렴하며, 로컬 TGI 설정은 하드웨어 비용 외에 무료입니다.

- 오픈 소스 파워: GPT-OSS의 Apache 2.0 라이선스를 통해 비공개로 사용자 정의하거나 배포할 수 있습니다.

- 원활한 워크플로우: Claude Code의 CLI는 코딩 친구와 대화하는 것처럼 느껴지며, GPT-OSS는 94.2% MMLU 및 96.6% AIME 점수로 어려운 작업을 처리합니다.

- 유연성: LiteLLM 또는 OpenRouter를 사용하여 GPT-OSS, Qwen 또는 Anthropic 모델 간에 전환할 수 있습니다.

사용자들은 GPT-OSS의 코딩 능력에 대해 극찬하며, "다중 파일 프로젝트를 위한 예산 친화적인 괴물"이라고 부릅니다. 자체 호스팅하든 OpenRouter를 통해 프록시하든, 이 설정은 비용을 낮게 유지하고 생산성을 높입니다.

결론

이제 Claude Code와 함께 GPT-OSS를 사용할 준비가 되었습니다! Hugging Face에 자체 호스팅하든, OpenRouter를 통해 프록시하든, 모델 저글링을 위해 LiteLLM을 사용하든, 강력하고 비용 효율적인 코딩 설정을 갖추게 됩니다. REST API 생성부터 코드 디버깅까지 GPT-OSS는 모든 것을 제공하며, Claude Code는 이를 손쉽게 만듭니다. 사용해보고, 댓글에 좋아하는 프롬프트를 공유하고, AI 코딩에 대해 함께 이야기해 봅시다!

최대 생산성으로 개발팀이 함께 작업할 수 있는 통합된 올인원 플랫폼을 원하십니까?

Apidog는 귀하의 모든 요구 사항을 충족하며, Postman을 훨씬 저렴한 가격으로 대체합니다!