개발자들은 다양한 애플리케이션에서 견고한 성능을 제공하는 강력한 언어 모델을 끊임없이 찾고 있습니다. Zhipu AI는 인공지능 능력의 한계를 뛰어넘는 GLM 시리즈의 고급 반복 모델인 GLM-4.6을 소개합니다. 이 모델은 컨텍스트 처리, 추론 및 실제 유용성에서 상당한 개선 사항을 통합하여 이전 버전을 기반으로 구축되었습니다. 엔지니어들은 GLM-4.6을 워크플로우에 통합하여 코드 생성부터 콘텐츠 제작에 이르는 복잡한 작업을 더 높은 효율성과 정확성으로 처리합니다.

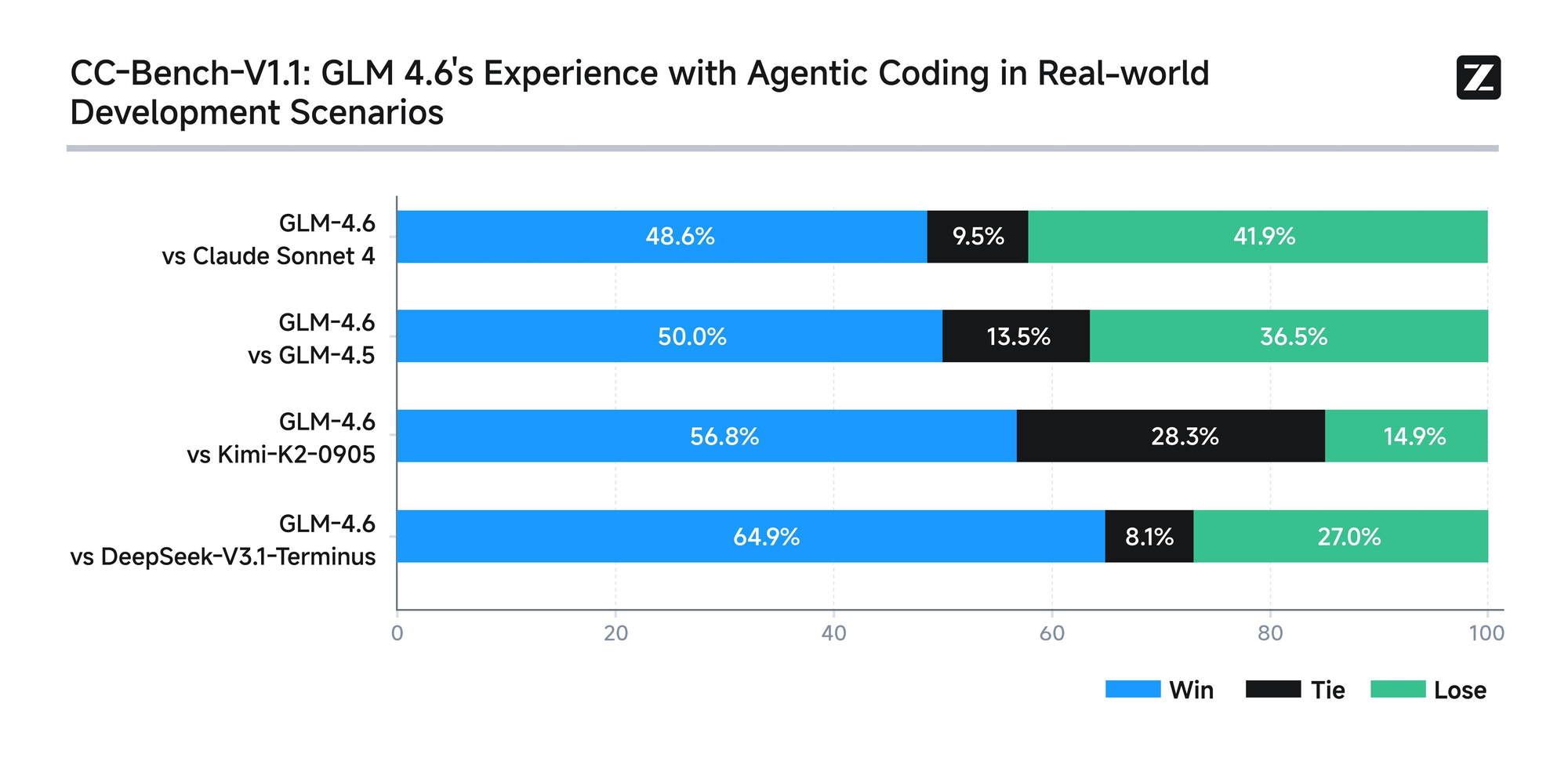

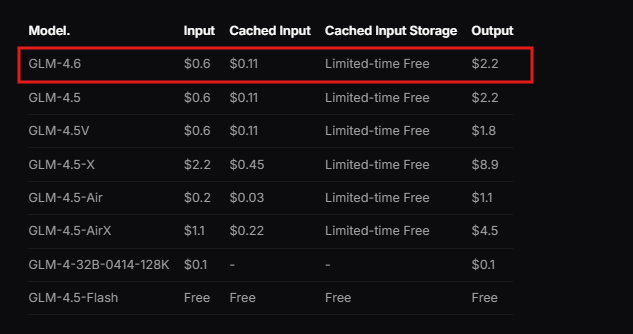

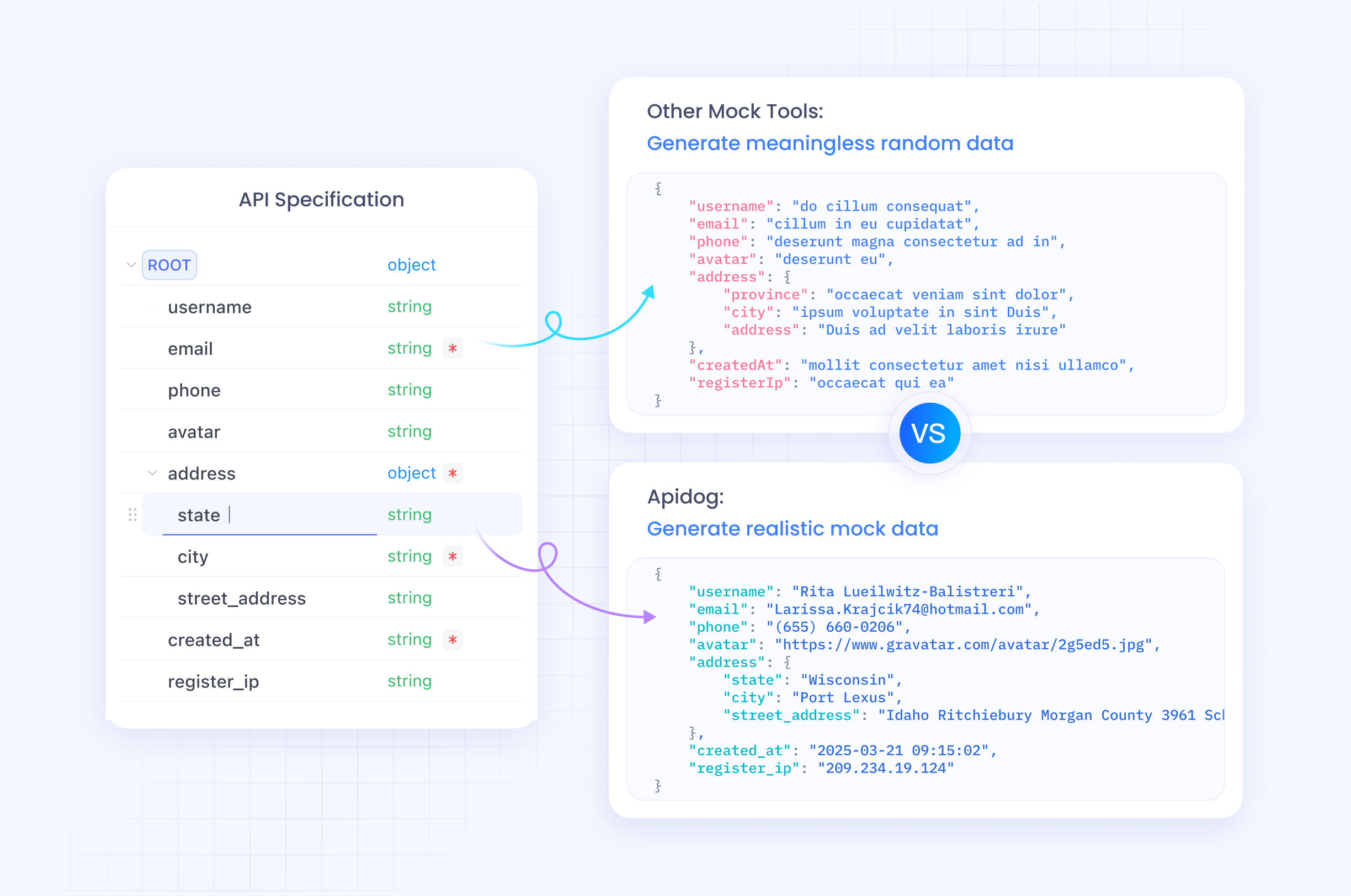

Zhipu AI는 저렴한 가격으로 시작하는 구독 기반 서비스인 GLM 코딩 플랜의 일환으로 GLM-4.6을 설계했습니다. 사용자들은 Claude Code, Cline, OpenCode 등과 같은 통합 도구를 통해 이 모델에 접근하여 원활한 AI 지원 개발을 가능하게 합니다. 이 모델은 광범위한 컨텍스트를 처리하고 고품질 출력을 생성하는 실제 시나리오에서 탁월한 성능을 발휘합니다. 또한 GLM-4.6은 벤치마크에서 Claude Sonnet 4와 같은 국제적인 선두 주자들과 경쟁하며 우수한 성능을 보여줍니다. 이는 신뢰할 수 있는 AI 지원을 필요로 하는 중국 및 해외 개발자들에게 최고의 선택이 됩니다.

모델의 기반을 이해하는 것에서 나아가, 이제 핵심 기능과 이들이 기술 구현에 어떻게 도움이 되는지 살펴보겠습니다.

GLM-4.6이란 무엇인가요?

Zhipu AI는 GLM-4.6을 광범위한 기술 및 창의적 작업을 위해 최적화된 대규모 언어 모델로 개발합니다. 이 모델은 고성능을 유지하면서 효율적인 계산을 가능하게 하는 3,550억 개 매개변수의 MoE(Mixture of Experts) 아키텍처를 특징으로 합니다. 사용자들은 이전 버전의 128K 제한에서 크게 향상된 200K 토큰의 확장된 컨텍스트 창을 높이 평가합니다. 이러한 확장은 모델이 복잡하고 긴 형식의 상호 작용을 일관성을 잃지 않고 관리할 수 있도록 합니다.

또한 GLM-4.6은 텍스트 입력 및 출력 양식을 지원하여 정밀한 언어 처리를 요구하는 애플리케이션에 다용도로 활용될 수 있습니다. 최대 출력 토큰 제한은 128K에 달하여 상세한 응답을 위한 충분한 공간을 제공합니다. 개발자들은 이러한 사양을 활용하여 문서 분석 또는 다단계 추론 체인과 같은 광범위한 데이터를 처리하는 시스템을 구축합니다.

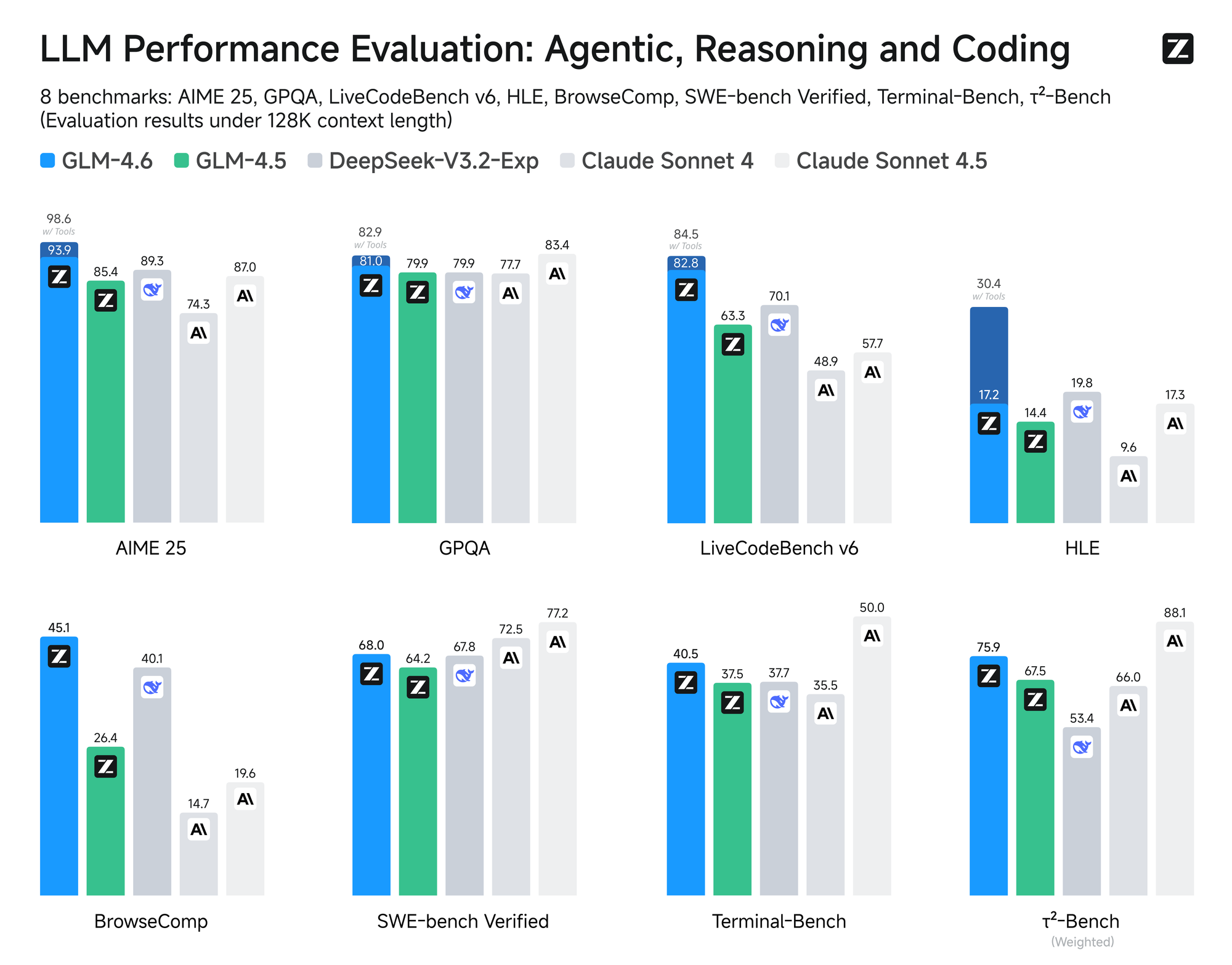

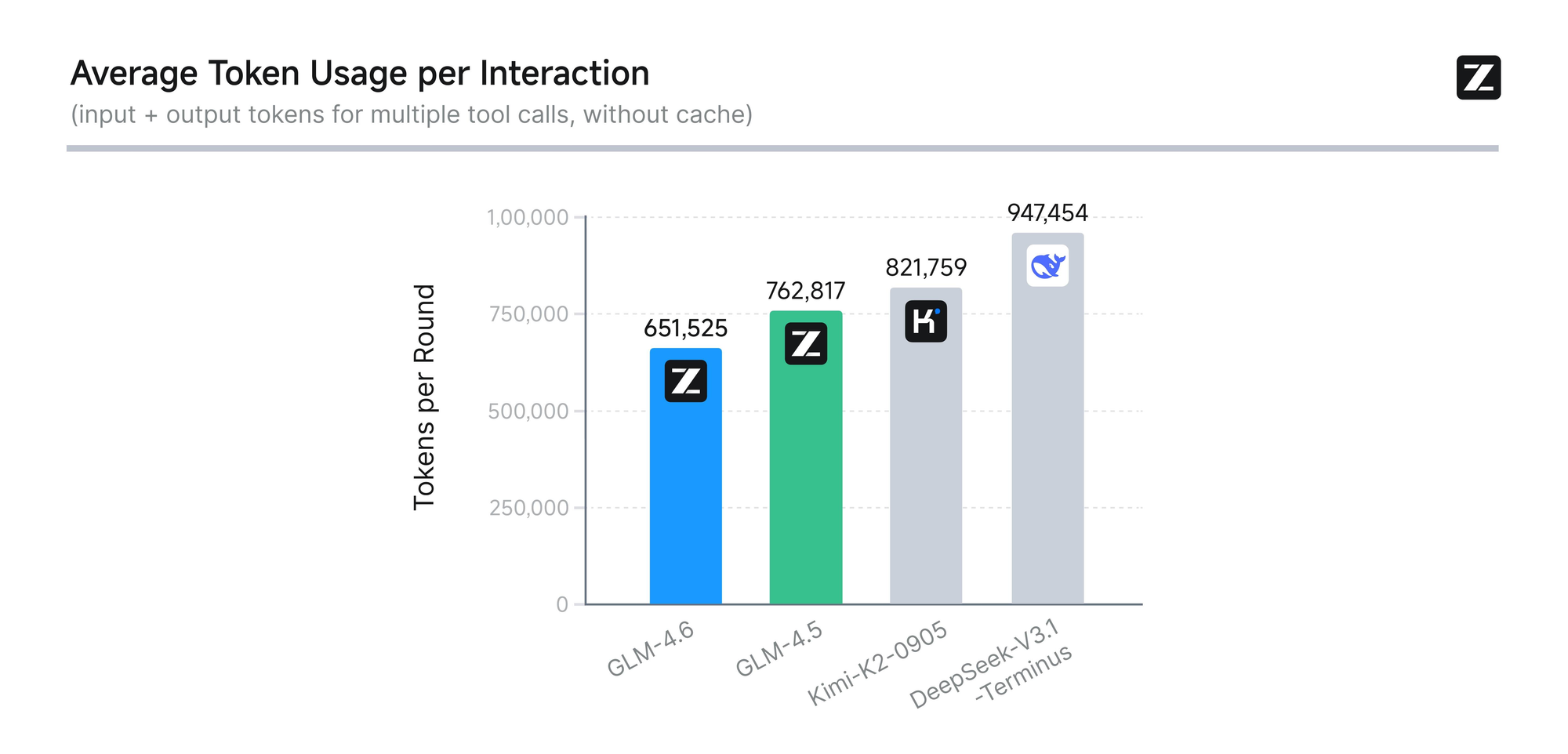

이 모델은 AIME 25, GPQA, LCB v6, HLE, SWE-Bench Verified를 포함한 8가지 권위 있는 벤치마크에서 엄격한 평가를 거칩니다. 결과는 GLM-4.6이 Claude Sonnet 4 및 4.6과 같은 선도적인 모델들과 동등한 성능을 보인다는 것을 보여줍니다. 예를 들어, Claude Code 환경에서 수행된 실제 코딩 테스트에서 GLM-4.6은 74가지 실제 시나리오에서 경쟁사보다 뛰어난 성능을 발휘합니다. 이는 토큰 소비 효율성을 30% 이상 향상시켜 대량 사용자들의 운영 비용을 절감합니다.

더욱이 Zhipu AI는 모든 테스트 질문과 에이전트 궤적을 공개적으로 발표하여 투명성을 약속합니다. 이러한 관행은 개발자들이 주장을 검증하고 결과를 재현할 수 있게 하여 기술에 대한 신뢰를 높입니다. GLM-4.6은 또한 추론 중 도구 사용을 지원하는 고급 추론 기능을 통합합니다. 이 기능은 모델이 자율적으로 작업을 계획하고 실행하는 에이전트 프레임워크에서 유용성을 향상시킵니다.

코딩 외에도 GLM-4.6은 다른 분야에서도 빛을 발합니다. 이는 인간의 선호도에 가깝게 글쓰기를 다듬어 스타일, 가독성 및 역할극의 진정성을 향상시킵니다. 번역 작업에서 이 모델은 프랑스어, 러시아어, 일본어, 한국어와 같은 소수 언어에 최적화되어 비공식적인 맥락에서도 의미론적 일관성을 보장합니다. 콘텐츠 제작자들은 소설, 대본, 카피라이팅에 이를 사용하여 컨텍스트 확장과 감정적 뉘앙스의 이점을 얻습니다.

가상 캐릭터 개발은 GLM-4.6이 다중 턴 대화에서 일관된 톤을 유지한다는 점에서 또 다른 강점입니다. 이는 소셜 AI 및 브랜드 의인화에 이상적입니다. 지능형 검색 및 심층 연구에서 이 모델은 의도 이해 및 결과 합성을 향상시켜 통찰력 있는 출력을 제공합니다.

전반적으로 GLM-4.6은 개발자들이 더 스마트한 애플리케이션을 만들 수 있도록 지원합니다. 긴 컨텍스트 처리, 효율적인 토큰 사용 및 광범위한 적용 가능성의 조합은 AI 분야에서 이 모델을 독보적으로 만듭니다. 이제 모델의 본질을 파악했으니, 실제 구현을 위해 API에 접근하는 방법으로 넘어가겠습니다.

GLM-4.6 API에 접근하는 방법

Zhipu AI는 오픈 플랫폼을 통해 GLM-4.6 API에 대한 직접적인 접근을 제공합니다. 개발자들은 Zhipu AI 웹사이트, 특히 open.bigmodel.cn 또는 z.ai에서 계정을 등록하는 것으로 시작합니다. 이 과정은 안전한 등록을 위해 이메일 또는 전화번호 인증을 요구합니다.

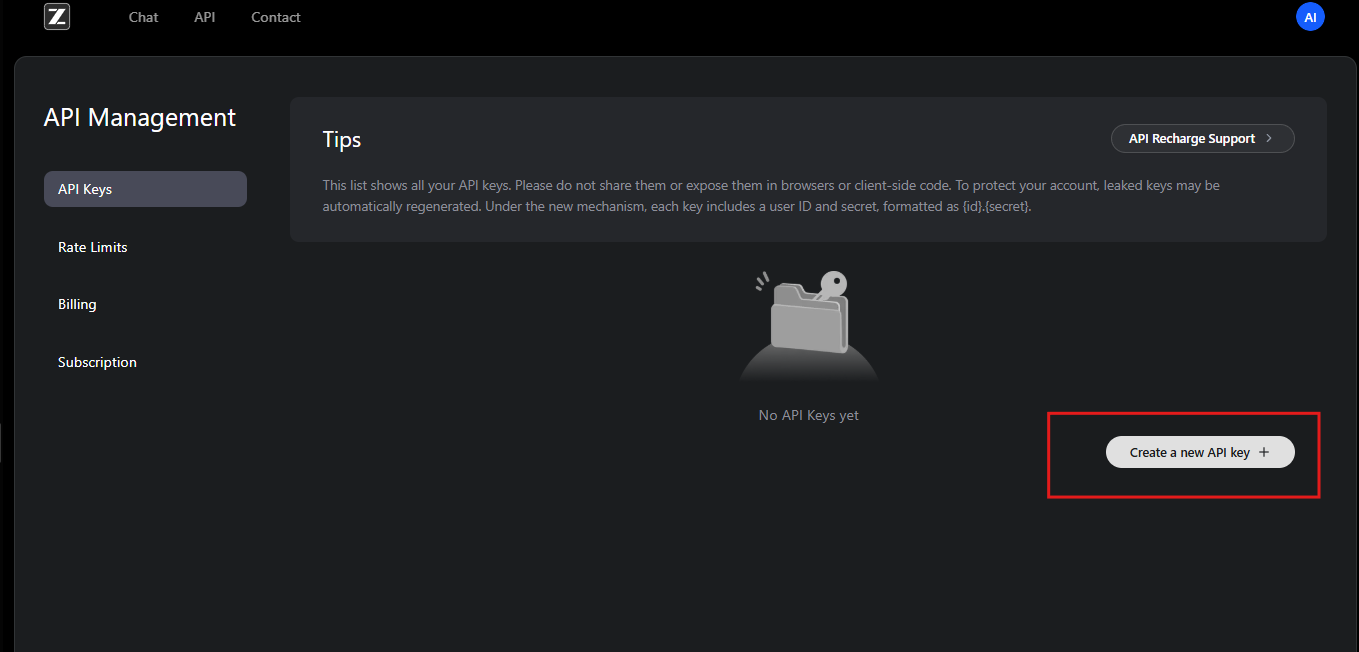

등록 후, 사용자들은 GLM 코딩 플랜을 구독합니다. 이 플랜은 GLM-4.6 및 관련 모델들을 잠금 해제합니다. 구독자들은 API 대시보드에 접근하여 API 키를 생성합니다. 이 키들은 요청을 인증하기 위한 자격 증명으로 사용됩니다.

또한 Zhipu AI는 통합 단계를 자세히 설명하는 문서를 제공합니다. 개발자들은 호환 가능한 프로그래밍 환경과 같은 전제 조건을 이해하기 위해 이 자료를 검토합니다. API는 표준 HTTP 클라이언트와 호환되는 RESTful 디자인을 따릅니다.

시작하려면, 사용자들은 계정의 API 관리 섹션으로 이동합니다. 여기서 새로운 API 키를 생성하고 그 값을 안전하게 기록합니다. Zhipu AI는 보안을 위해 주기적으로 키를 교체할 것을 권장합니다. 또한 플랫폼은 구독 등급에 따라 사용 할당량을 제공하여 과도한 사용을 방지합니다.

개발자들이 문제가 발생하면 Zhipu AI의 지원팀이 이메일이나 포럼을 통해 지원합니다. 또한 일반적인 접근 문제를 해결하기 위한 커뮤니티 자료도 제공합니다. 접근이 확보되면, 다음 단계는 GLM-4.6 API와 효과적으로 상호 작용하기 위한 인증 설정입니다.

GLM-4.6 API 인증 및 설정

인증은 안전한 API 상호 작용의 핵심입니다. Zhipu AI는 GLM-4.6 API에 대해 Bearer 토큰 인증을 사용합니다. 개발자들은 각 요청의 Authorization 헤더에 API 키를 포함합니다.

설정을 위해 개발 환경에 필요한 라이브러리를 설치하세요. 예를 들어, Python 사용자들은 requests 라이브러리를 활용합니다. 이를 임포트하고 다음과 같이 헤더를 구성합니다:

import requests

api_key = "your-api-key"

headers = {

"Authorization": f"Bearer {api_key}",

"Content-Type": "application/json"

}

이 코드는 요청을 보내기 위한 환경을 준비합니다. 마찬가지로 Node.js를 사용하는 JavaScript 개발자들은 fetch API 또는 axios 라이브러리를 사용합니다. 그들은 options 객체에 헤더를 설정합니다.

또한 시스템이 네트워크 요구 사항을 충족하는지 확인하세요. GLM-4.6 API 엔드포인트는 https://api.z.ai/api/paas/v4/chat/completions에 있습니다. 도메인에 핑을 보내거나 간단한 요청을 전송하여 연결을 테스트하세요.

설정 중 개발자들은 API 키를 안전하게 저장하기 위해 환경 변수를 구성합니다. 이 관행은 스크립트에 민감한 정보를 하드코딩하는 것을 방지합니다. Python의 dotenv 또는 Node.js의 process.env와 같은 도구들이 이를 용이하게 합니다.

프록시나 VPN을 사용하는 경우, Zhipu AI 서버로의 트래픽을 허용하는지 확인하세요. 인증 실패는 종종 잘못된 키 형식이나 만료된 구독에서 비롯됩니다. Zhipu AI는 응답에 오류를 기록하여 문제 진단을 돕습니다.

인증이 완료되면 개발자들은 엔드포인트를 탐색합니다. 이 설정은 GLM-4.6 기능에 대한 신뢰할 수 있고 안전한 접근을 보장합니다.

GLM-4.6 API 엔드포인트 탐색

GLM-4.6 API는 채팅 완료를 위한 기본 엔드포인트를 중심으로 합니다. 개발자들은 응답을 생성하기 위해 https://api.z.ai/api/paas/v4/chat/completions로 POST 요청을 보냅니다.

이 엔드포인트는 기본 모드와 스트리밍 모드를 모두 처리합니다. 기본 모드에서는 서버가 전체 요청을 처리하고 완전한 응답을 반환합니다. 그러나 스트리밍 모드는 출력을 점진적으로 전달하며, 실시간 애플리케이션에 이상적입니다.

엔드포인트를 호출하려면 필수 매개변수를 포함하는 JSON 페이로드를 구성합니다. 모델 필드는 "glm-4.6"을 지정합니다. 메시지 배열은 대화를 시뮬레이션하는 역할-콘텐츠 쌍을 포함합니다.

예를 들어, 기본적인 curl 요청은 다음과 같습니다:

curl -X POST "https://api.z.ai/api/paas/v4/chat/completions" \

-H "Content-Type: application/json" \

-H "Authorization: Bearer your-api-key" \

-d '{

"model": "glm-4.6",

"messages": [

{"role": "user", "content": "Generate a Python function for sorting a list."}

]

}'

서버는 생성된 콘텐츠를 포함하는 JSON으로 응답합니다. 개발자들은 이를 파싱하여 어시스턴트 메시지를 추출합니다.

또한 이 엔드포인트는 사고 단계와 같은 고급 기능을 지원합니다. 출력에서 상세한 추론을 활성화하려면 thinking 객체를 설정하세요.

이 엔드포인트를 이해하면 개발자들이 대화형 AI 시스템을 구축할 수 있습니다. 다음으로, 요청 매개변수를 자세히 분석해 보겠습니다.

GLM-4.6 API 요청 매개변수에 대한 상세 설명

요청 매개변수는 GLM-4.6 API의 동작을 제어합니다. 모델 매개변수는 이 특정 버전을 선택하기 위해 "glm-4.6"을 필수로 합니다.

메시지 배열은 대화를 이끌어갑니다. 각 객체는 역할("user"는 입력, "assistant"는 이전 응답)과 텍스트 문자열 형태의 콘텐츠를 포함합니다. 개발자들은 역할을 번갈아 가며 다중 턴 대화를 구성합니다.

또한 max_tokens는 응답 길이를 제한하여 과도한 출력을 방지합니다. 균형 잡힌 결과를 위해 4096으로 설정하세요. Temperature는 무작위성을 조절합니다. 0.6과 같은 낮은 값은 결정론적인 출력을 생성하는 반면, 높은 값은 창의성을 장려합니다.

스트리밍의 경우, "stream": true를 포함하세요. 이는 응답 형식을 청크 데이터로 변경합니다.

thinking 매개변수는 단계별 추론을 가능하게 합니다. 응답에 중간 생각을 포함하려면 "thinking": {"type": "enabled"}로 설정하세요.

다른 선택적 매개변수로는 핵 샘플링을 위한 top_p와 반복을 억제하기 위한 presence_penalty가 있습니다. 개발자들은 사용 사례에 따라 이들을 조정합니다.

유효하지 않은 매개변수는 잘못된 요청에 대한 400과 같은 코드로 오류 응답을 트리거합니다. 전송하기 전에 항상 페이로드를 검증하세요.

이 매개변수들을 숙달함으로써 개발자들은 최적의 성능을 위해 GLM-4.6 API 호출을 사용자 정의할 수 있습니다.

GLM-4.6 API 응답 처리

GLM-4.6 API의 응답은 JSON 형식으로 도착합니다. 개발자들은 생성된 콘텐츠에 접근하기 위해 choices 배열을 파싱합니다.

기본 모드에서 응답은 다음을 포함합니다:

{

"id": "chatcmpl-...",

"object": "chat.completion",

"created": 1694123456,

"model": "glm-4.6",

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "Your generated text here."

},

"finish_reason": "stop"

}

]

}

애플리케이션에서 사용하기 위해 content 필드를 추출합니다.

스트리밍 모드에서는 응답이 서버 전송 이벤트(SSE)로 스트리밍됩니다. 각 청크는 다음과 같습니다:

data: {"id":"chatcmpl-...","choices":[{"delta":{"content":" partial text"}}]}

개발자들은 전체 출력을 구축하기 위해 델타를 누적합니다.

오류 처리는 상태 코드 확인을 포함합니다. 401은 인증 실패를 나타내고, 429는 속도 제한을 알립니다.

디버깅을 위해 응답을 기록하세요. 이 접근 방식은 GLM-4.6 API와의 견고한 통합을 보장합니다.

GLM-4.6 API 통합을 위한 코드 예제

개발자들은 다양한 언어로 GLM-4.6 API를 구현합니다. Python에서는 기본적인 호출을 위해 requests를 사용합니다:

import requests

import json

url = "https://api.z.ai/api/paas/v4/chat/completions"

payload = {

"model": "glm-4.6",

"messages": [{"role": "user", "content": "Explain quantum computing."}],

"max_tokens": 500,

"temperature": 0.7

}

headers = {

"Authorization": "Bearer your-api-key",

"Content-Type": "application/json"

}

response = requests.post(url, data=json.dumps(payload), headers=headers)

print(response.json()["choices"][0]["message"]["content"])

이 코드는 쿼리를 전송하고 응답을 출력합니다.

Node.js를 사용하는 JavaScript에서는:

const fetch = require('node-fetch');

const url = 'https://api.z.ai/api/paas/v4/chat/completions';

const payload = {

model: 'glm-4.6',

messages: [{ role: 'user', content: 'Write a haiku about AI.' }],

max_tokens: 100

};

const headers = {

'Authorization': 'Bearer your-api-key',

'Content-Type': 'application/json'

};

fetch(url, {

method: 'POST',

body: JSON.stringify(payload),

headers

})

.then(res => res.json())

.then(data => console.log(data.choices[0].message.content));

Python에서 스트리밍을 위해서는 sseclient와 같은 SSE 파싱 라이브러리를 사용하세요.

이 예제들은 실제적인 통합을 보여주며, 개발자들이 신속하게 프로토타입을 만들 수 있게 합니다.

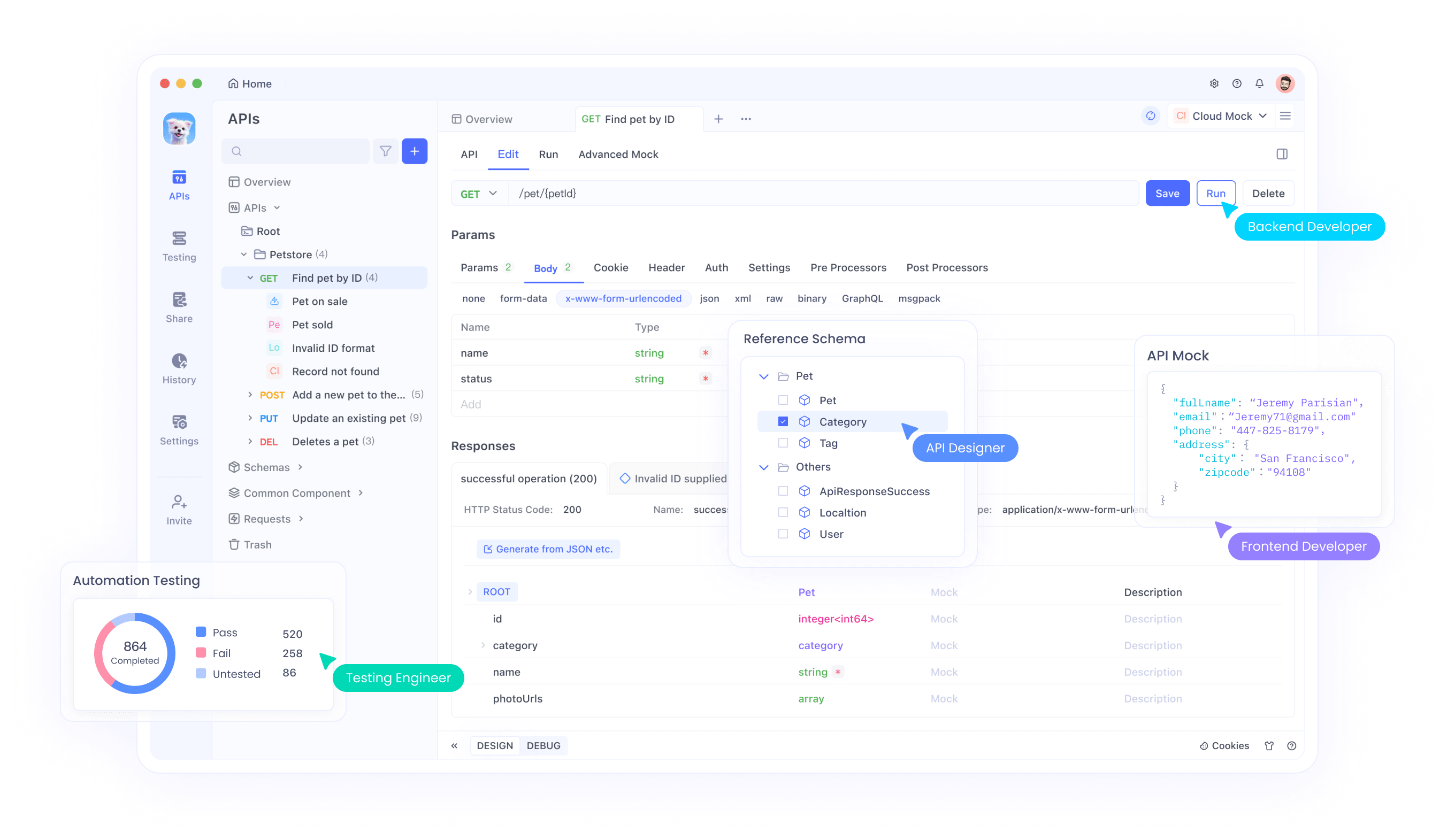

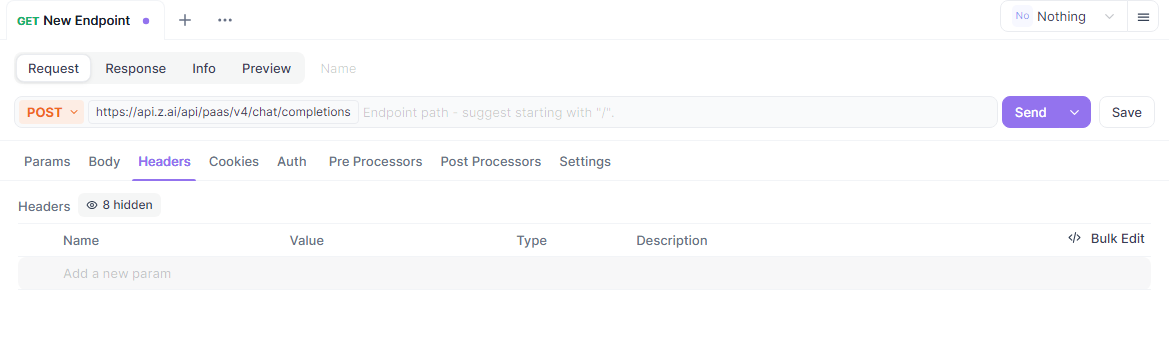

GLM-4.6 API 테스트를 위한 Apidog 사용

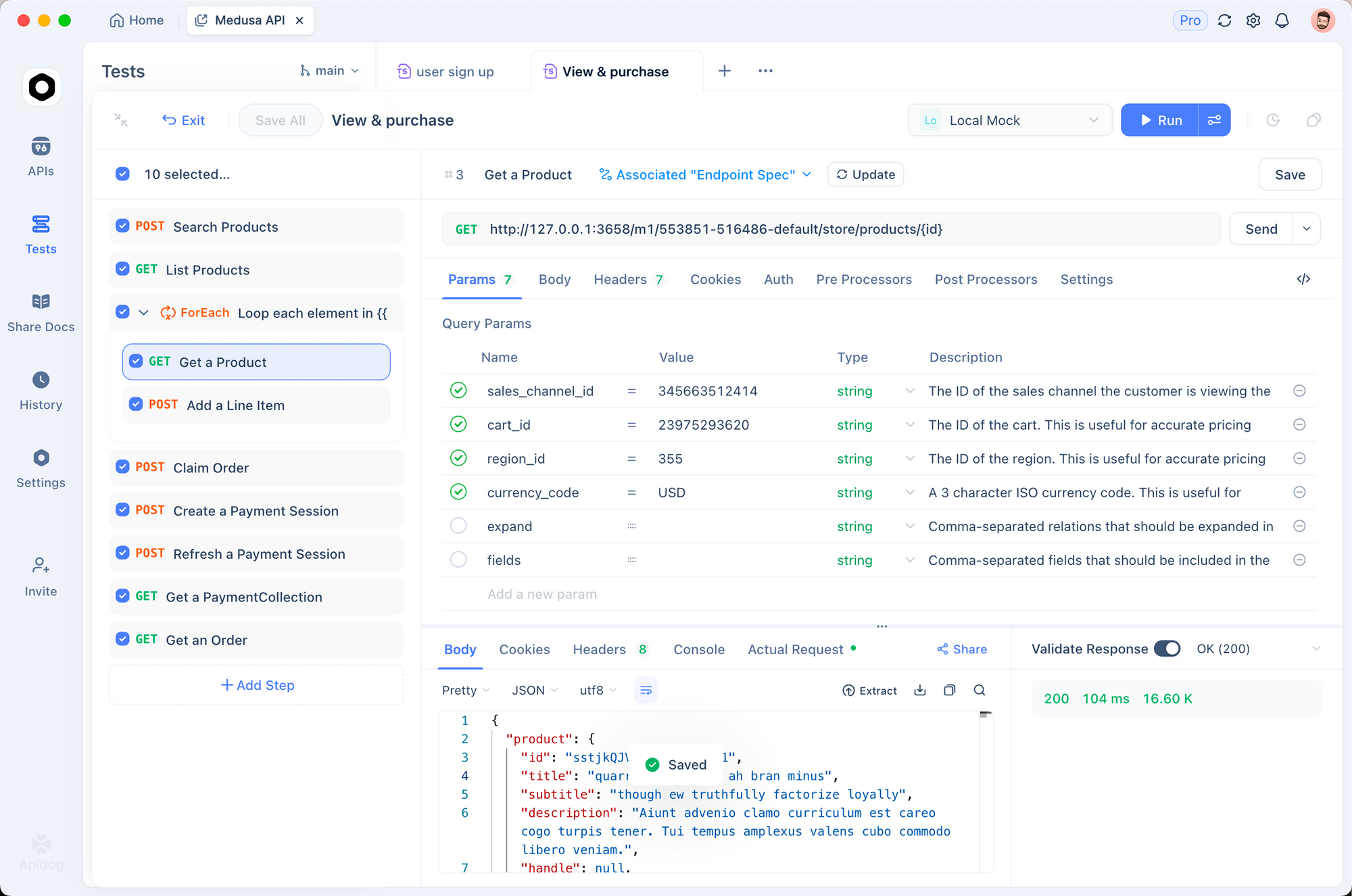

Apidog는 GLM-4.6 API 테스트를 위한 훌륭한 도구입니다. 이 올인원 플랫폼은 개발자들이 API 상호 작용을 설계, 디버그, 모의 및 자동화할 수 있도록 합니다.

apidog.com에서 Apidog를 다운로드하고 프로젝트를 생성하는 것으로 시작하세요. https://api.z.ai/api/paas/v4/chat/completions URL로 새 API를 추가하여 GLM-4.6 API 엔드포인트를 가져옵니다.

Apidog의 헤더 섹션에서 "Authorization: Bearer your-api-key"를 추가하여 인증을 설정하세요. model 및 messages와 같은 JSON 매개변수로 요청 본문을 구성하세요.

Apidog는 사용자 친화적인 인터페이스에서 요청을 보내고 응답을 볼 수 있게 합니다. 개발자들은 요청을 복제하고 매개변수를 조정하여 다양한 테스트를 수행합니다.

또한 Apidog에서 시나리오를 생성하여 테스트를 자동화하세요. GLM-4.6 API가 예상대로 작동하는지 확인하기 위해 응답 내용을 검증하는 어설션을 정의하세요.

Apidog의 모의 서버는 오프라인 개발을 위한 응답을 시뮬레이션합니다. 이 기능은 실제 API 호출 없이 프로토타이핑을 가속화합니다.

Apidog를 통합함으로써 개발자들은 GLM-4.6 API 워크플로우를 간소화하고, 오류를 줄이며, 배포 속도를 높일 수 있습니다.

GLM-4.6 API를 위한 모범 사례 및 속도 제한

모범 사례를 준수하면 GLM-4.6 API의 잠재력을 극대화할 수 있습니다. 개발자들은 구독에 따라 일반적으로 분당 토큰 또는 일일 요청으로 정의되는 속도 제한 내에서 사용량을 모니터링합니다.

429와 같은 오류 발생 시 재시도를 위해 지수 백오프를 구현하세요. 이는 서버 과부하를 방지합니다.

응답 품질을 향상시키기 위해 프롬프트를 명확하게 최적화하세요. 시스템 메시지를 사용하여 컨텍스트를 설정하고 모델을 효과적으로 안내하세요.

프로덕션 환경에서 API 키를 안전하게 보호하세요. 클라이언트 측 코드에 노출하는 것을 피하세요.

감사 및 성능 분석을 위해 상호 작용을 기록하세요. 이 데이터는 개선 사항을 알려줍니다.

빈 응답 또는 시간 초과와 같은 엣지 케이스를 대체 메커니즘으로 처리하세요.

Zhipu AI는 문서에서 속도 제한을 업데이트합니다. 정기적으로 확인하세요.

이러한 관행을 따르면 GLM-4.6 API를 효율적이고 안정적으로 사용할 수 있습니다.

GLM-4.6 API의 고급 사용법

고급 사용자들은 대화형 애플리케이션을 위해 스트리밍을 탐색합니다. "stream": true로 설정하고 청크를 실시간으로 처리하세요.

메시지에 함수 호출을 포함하여 도구를 통합하세요. GLM-4.6은 도구 호출을 지원하여 에이전트가 외부 작업을 실행할 수 있도록 합니다.

예를 들어, 페이로드에 도구를 정의합니다:

"tools": [

{

"type": "function",

"function": {

"name": "get_weather",

"description": "Get current weather",

"parameters": {...}

}

}

]

필요한 경우 모델은 도구 호출로 응답합니다.

특정 작업에 따라 temperature를 미세 조정하세요. 사실적 쿼리에는 낮게, 창의적 쿼리에는 높게 설정합니다.

문서 요약을 위해 긴 컨텍스트와 결합하세요. 메시지에 대규모 텍스트를 입력하세요.

복잡한 워크플로우를 위해 LangChain과 같은 에이전트 프레임워크에 통합하세요.

이러한 기술들은 정교한 시스템에서 GLM-4.6의 모든 잠재력을 발휘하게 합니다.

결론

GLM-4.6 API는 개발자들에게 AI 혁신을 위한 강력한 도구를 제공합니다. 이 가이드를 따르면 프로젝트에 원활하게 통합할 수 있습니다. 기능을 실험하고, Apidog를 사용하여 테스트하며, 성공을 위한 모범 사례를 적용하세요. Zhipu AI는 GLM-4.6을 계속 발전시키며, 앞으로 더 큰 기능을 약속합니다.