Gemini 3 Pro가 Ollama의 무료 티어에서 제공되어 개발자들이 즉시 주목했습니다. 더 이상 가장 뛰어난 멀티모달 모델 중 하나를 실험하기 위해 유료 Cloud Max 또는 Pro 구독이 필요하지 않습니다. 또한, 이 통합은 Gemini 3 Pro의 최첨단 추론 능력을 수백만 명이 로컬 모델에 이미 사용하고 있는 익숙한 Ollama 워크플로우에 직접 도입합니다.

다음으로, 어떤 점이 변경되었는지, 설정 방법, 그리고 소비자 하드웨어에서 성능을 극대화하는 방법을 알아보겠습니다.

Ollama의 Gemini 3 Pro에서 변경된 점은 무엇인가요?

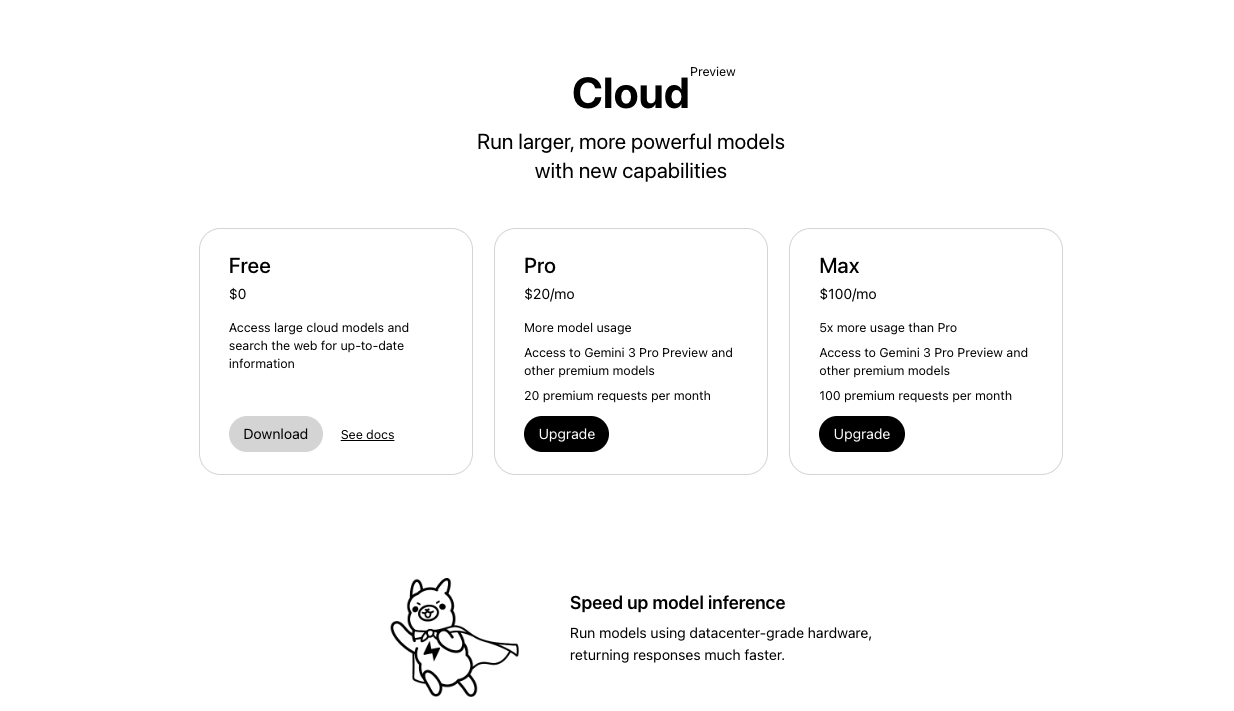

Ollama는 처음에는 Gemini 3 Pro를 Ollama의 유료 클라우드 요금제로 제한했습니다. 하지만 2025년 11월 18일, Ollama 공식 계정은 해당 모델이 이제 Pro 및 Max 티어와 함께 무료 티어에서도 제공된다고 발표했습니다.

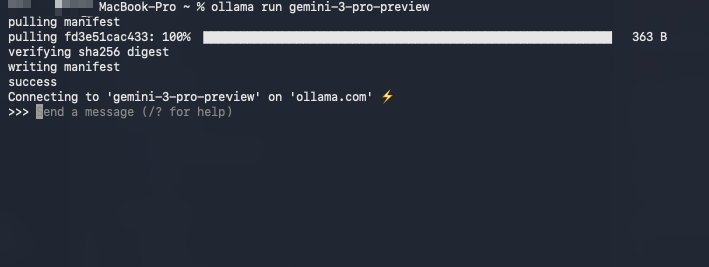

이제 다음 단일 명령어를 실행할 수 있습니다:

ollama run gemini-3-pro-preview

이 명령어는 추가 과금 없이 모델을 가져와 실행합니다. 또한, 이 모델은 100만 토큰 컨텍스트 창, 기본 멀티모달 입력(텍스트, 이미지, 오디오, 비디오), 그리고 고급 에이전트 기능을 지원합니다.

| 티어 | Gemini 3 Pro 액세스 | 요율 제한 (대략) | 비용 |

|---|---|---|---|

| 무료 | 예 (미리보기) | 보통 | $0 |

| Pro | 예 | 높음 | 유료 |

| Max | 예 | 최고 | 더 높은 유료 |

이러한 변화는 접근성을 민주화합니다. 결과적으로, 독립 개발자, 연구원, 취미 활동가들은 이전에는 기업 구독이 필요했던 것과 동일한 최첨단 추론 능력을 얻게 됩니다.

시작하기 전 필수 사항

최신 Ollama를 설치해야 합니다 — 버전 0.3.12 이상은 클라우드 호스팅 모델을 원활하게 처리합니다. https://ollama.com/download에서 다운로드하세요.

단계별 가이드: 무료 티어에서 Gemini 3 Pro 미리보기 실행하기

모델을 실행하려면 다음 단계를 정확히 따르세요.

먼저 터미널을 열고 Ollama가 실행 중인지 확인합니다:

ollama --version

버전 0.3.12 이상이 표시되어야 합니다.

두 번째로, 모델을 직접 가져와 실행합니다:

ollama run gemini-3-pro-preview

Ollama는 무료 티어 자격을 자동으로 감지하고 API 키(첫 실행 후 안전하게 저장됨)를 통해 Google의 백엔드에 연결합니다. 또한, 첫 실행 시 키가 없는 경우 키를 요청합니다.

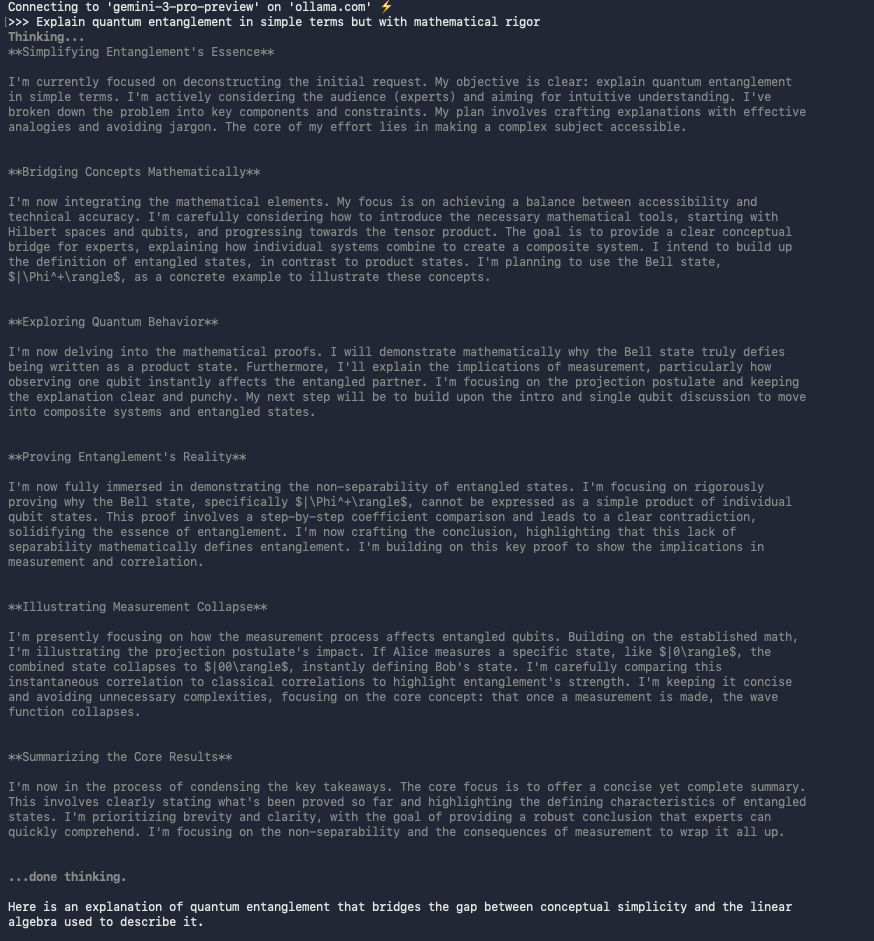

세 번째로, 기본적인 상호 작용을 테스트합니다:

>>> Explain quantum entanglement in simple terms but with mathematical rigor.

모델은 명확한 설명과 함께 종종 LaTeX 형식의 방정식을 포함하여 응답합니다.

또한, Open WebUI와 같은 도구에서 이미지나 문서를 직접 업로드할 수 있습니다.

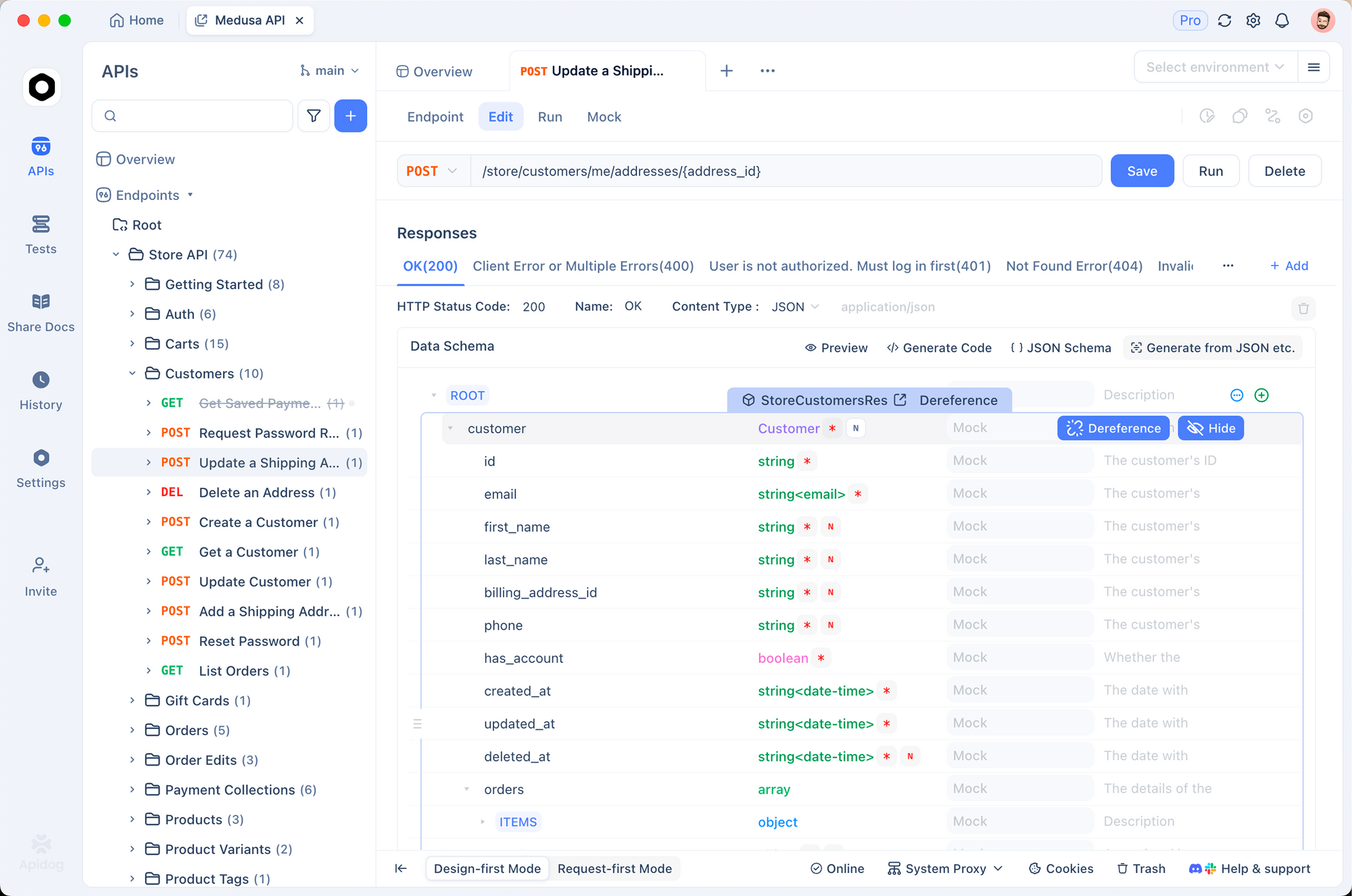

Apidog로 Gemini API 직접 테스트하기

스크립팅 또는 통합을 위해 Gemini 엔드포인트에 직접 액세스해야 하는 경우가 있습니다. Apidog는 자동 요청 생성, 환경 변수 및 응답 유효성 검사를 지원하므로 이 분야에서 뛰어납니다.

공식 엔드포인트를 통해 동일한 모델을 테스트하는 방법은 다음과 같습니다:

Apidog를 열고 새 요청을 생성합니다.

메서드를 POST로, URL을 다음과 같이 설정합니다:

https://generativelanguage.googleapis.com/v1/models/gemini-3-pro-preview:generateContent

쿼리 매개변수: key=YOUR_API_KEY를 추가합니다.

본문(JSON)에는 다음을 사용합니다:

{

"contents": [{

"parts": [{

"text": "Compare Gemini 3 Pro to GPT-4o on reasoning benchmarks."

}]

}]

}

요청을 보냅니다.

Apidog는 응답을 자동으로 형식화하고, 토큰 사용량을 강조 표시하며, 요청을 컬렉션으로 저장할 수 있도록 합니다. 이 접근 방식은 호출을 연결하거나 에이전트를 구축할 때 매우 유용합니다.

멀티모달 기능: 시각, 오디오 및 비디오

Gemini 3 Pro는 기본 멀티모달 처리 기능으로 두드러집니다. 예를 들어, 이미지 URL이나 로컬 파일을 입력할 수 있습니다:

ollama run gemini-3-pro-preview

>>> (회로도 이미지를 업로드)

이 회로도를 설명하고 효율성 향상을 위한 개선 사항을 제안해주세요.

모델은 다이어그램을 분석하고, 구성 요소를 식별하며, 최적화를 제안합니다. 마찬가지로, 동일한 세션에서 비디오 프레임이나 오디오 대본을 처리할 수 있습니다.

실제로 개발자들은 이전 Gemini 1.5 Pro와 비교하여 문서 이해 작업, 특히 텍스트/이미지 혼합 PDF에서 더 뛰어난 성능을 보고합니다.

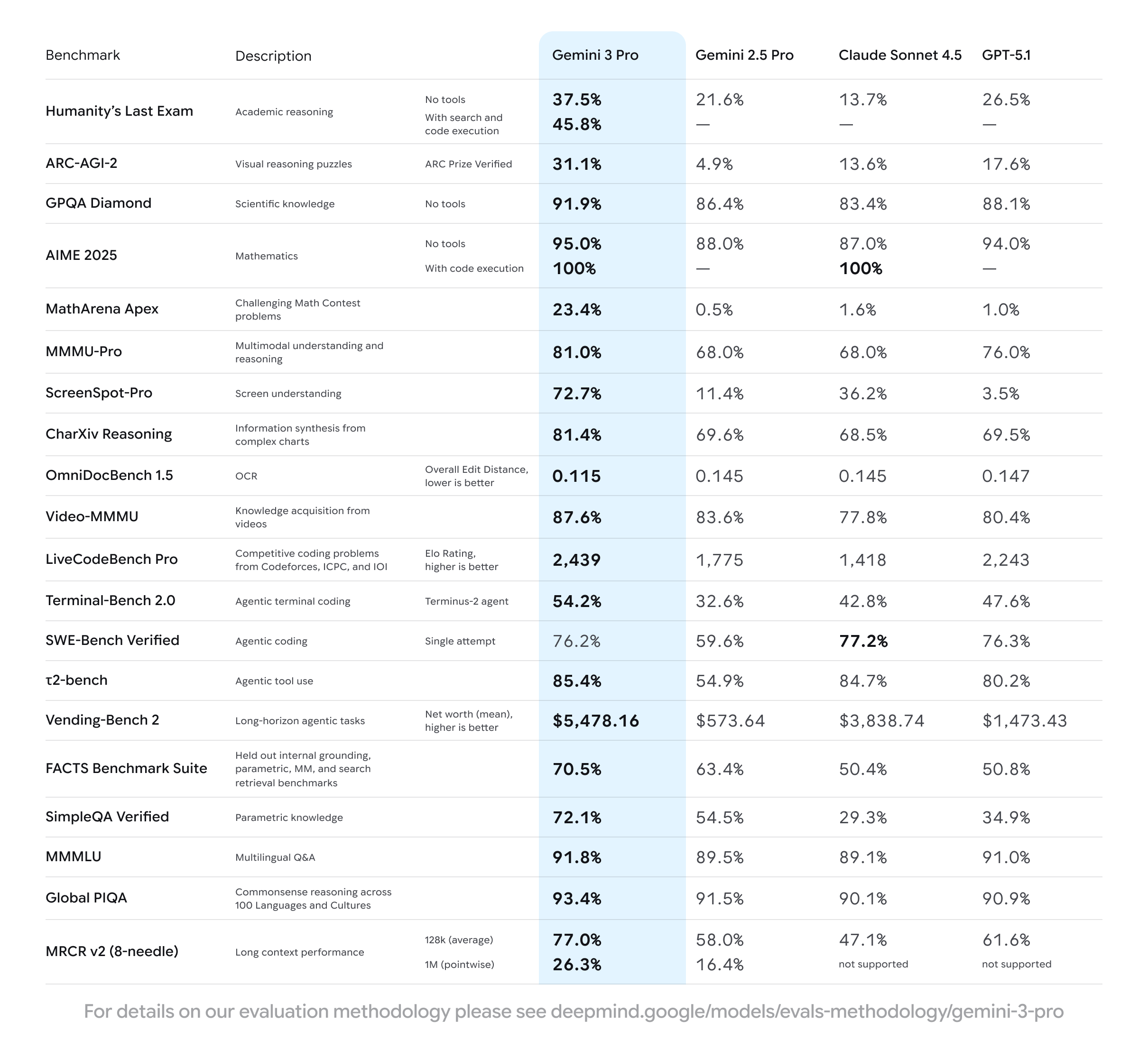

성능 벤치마크 및 실제 테스트

2025년 11월 18일에 실시된 독립적인 테스트 결과 Gemini 3 Pro는 다음을 달성했습니다:

- MMLU-Pro: 88.2%

- GPQA Diamond: 82.7%

- LiveCodeBench: 74.1%

- MMMU (멀티모달): 78.5%

또한, 무료 티어에서의 출력 속도는 텍스트 전용 프롬프트의 경우 평균 초당 45~60토큰으로, 경쟁 모델의 유료 티어와 견줄 만합니다.

Open WebUI 프런트엔드를 사용하거나 Ollama가 노출하는 OpenAI 호환 엔드포인트를 통해 통합함으로써 훨씬 더 빠른 응답을 얻을 수 있습니다.

애플리케이션에 Gemini 3 Pro 통합하기

Ollama는 http://localhost:11434/v1에서 OpenAI 호환 API를 노출합니다. 따라서 모든 LangChain, LlamaIndex 또는 Haystack 프로젝트를 이 API로 연결할 수 있습니다:

from openai import OpenAI

client = OpenAI(

base_url="http://localhost:11434/v1",

api_key="ollama", # 더미 키

)

response = client.chat.completions.create(

model="gemini-3-pro-preview",

messages=[{"role": "user", "content": "사용자 인증을 위한 FastAPI 엔드포인트를 작성하세요."}]

)

print(response.choices[0].message.content)

이러한 호환성은 GPT 모델용으로 구축된 코드베이스를 다시 작성할 필요 없이 Gemini 3 Pro를 대체하여 사용할 수 있음을 의미합니다.

알아두어야 할 무료 티어의 제한 사항

무료 액세스에는 관대하지만 유한한 요율 제한이 포함됩니다. 헤비 사용자들은 지역 및 부하에 따라 분당 약 50~100개의 요청에서 제한에 도달합니다. 또한, 모델은 클라우드에서 호스팅되므로 대기 시간은 연결 상태에 따라 달라집니다(일반적으로 TTF 800~1500ms).

무제한 사용을 위해서는 Ollama Pro 또는 Max로 업그레이드하세요. 하지만 대부분의 개발자들은 무료 티어가 프로토타이핑 및 일상 업무에 충분하다고 생각합니다.

고급 사용법: 함수 호출 및 도구 사용

Gemini 3 Pro는 기본 함수 호출을 지원합니다. Modelfile 또는 API를 통해 도구를 정의할 수 있습니다:

{

"tools": [{

"type": "function",

"function": {

"name": "get_weather",

"description": "현재 날씨 가져오기",

"parameters": { ... }

}

}]

}

모델은 함수를 호출할 시기를 결정하여 웹 브라우징이나 데이터베이스 쿼리와 같은 에이전트 워크플로우를 가능하게 합니다.

일반적인 문제 해결

- 오류 401/403: Gemini API 키를 다시 생성하고

ollama run을 다시 실행하여 재인증하세요. - 모델을 찾을 수 없음: Ollama를 업데이트하고(

ollama update) 다시 시도하세요. - 느린 응답: 유선 연결로 전환하거나 비피크 시간대에 사용하세요.

- 멀티모달 실패: 최신 Ollama 버전을 사용하고 지원되는 클라이언트(Open WebUI가 가장 잘 작동함)를 통해 파일을 업로드했는지 확인하세요.

2025년 개발자에게 이것이 중요한 이유

이제 인프라 비용 없이 최첨단 인텔리전스에 액세스할 수 있습니다. 이는 경쟁 환경을 극적으로 평준화시킵니다. 소규모 팀은 정교한 에이전트를 구축하고, 연구원들은 최신 SOTA 모델과 벤치마크하며, 취미 활동가들은 예산 승인 없이 멀티모달 AI를 탐색할 수 있습니다.

또한, API 관리를 위한 Apidog와 같은 도구와 결합하면 개발 주기를 며칠에서 몇 시간으로 단축할 수 있습니다.

결론: 오늘부터 Gemini 3 Pro를 사용해보세요

지금 바로 ollama run gemini-3-pro-preview를 실행하고 직접 그 차이를 경험해보세요. Google과 Ollama는 첨단 AI 실험의 가장 큰 장벽을 제거했습니다.

오늘 Apidog를 무료로 다운로드하여 Gemini 요청을 디버그하거나 Ollama를 기반으로 풀스택 애플리케이션을 구축하는 등 API 테스트 워크플로우를 강화하세요.

개방적이고 접근 가능한 AI의 미래가 도래했습니다. 단 하나의 명령어로 참여할 수 있습니다.