개발자들은 고급 AI 모델을 애플리케이션에 통합하기 위한 효율적인 방법을 끊임없이 모색합니다. Gemini 3 Flash API는 높은 지능과 속도, 비용 효율성의 균형을 맞춘 강력한 옵션을 제공합니다.

button

Google은 생성형 AI 서비스를 계속 발전시키고 있습니다. 또한 Gemini 3 Flash 모델은 현재 라인업에서 두드러집니다. 엔지니어는 Gemini API를 통해 이 모델에 액세스하여 신속한 프로토타이핑 및 프로덕션 배포를 가능하게 합니다.

Gemini API 키 얻기

API 키를 획득하는 것으로 시작합니다. 먼저 aistudio.google.com에서 Google AI Studio로 이동합니다. 필요한 경우 Google 계정으로 로그인합니다. 다음으로, 사용 가능한 옵션 중에서 Gemini 3 Flash 미리보기 모델을 선택합니다. 그런 다음 API 키 생성 옵션을 클릭합니다.

Google은 이 키를 즉시 제공합니다. 또한, 민감한 자격 증명으로 취급하여 안전하게 보관하십시오. 모든 요청에 x-goog-api-key 헤더에 사용합니다. 또는 스크립트의 편의를 위해 환경 변수로 설정할 수 있습니다.

유효한 키가 없으면 요청은 인증 오류와 함께 즉시 실패합니다. 따라서 Google AI Studio의 대화형 인터페이스에서 테스트하여 키 기능을 조기에 확인하십시오.

Gemini 3 Flash 기능 이해

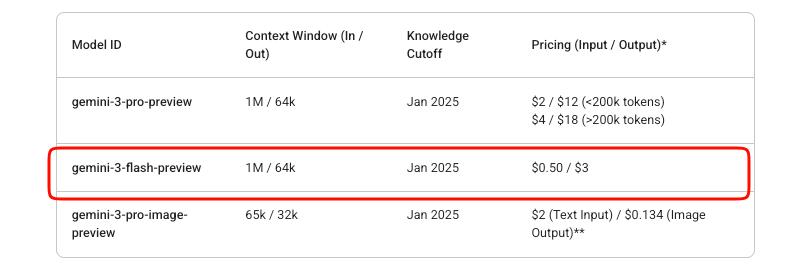

Gemini 3 Flash는 Flash 속도로 Pro 수준의 지능을 제공합니다. 특히, 이 모델 ID는 미리보기 단계 동안 gemini-3-flash-preview로 유지됩니다. 방대한 1,048,576 토큰 입력 컨텍스트 창과 65,536 토큰 출력 제한을 지원합니다.

또한, 다중 모드 입력을 효과적으로 처리합니다. 텍스트, 이미지, 비디오, 오디오 및 PDF를 제공할 수 있습니다. 출력은 주로 텍스트로 구성되며, 스키마 적용을 통해 구조화된 JSON 옵션도 제공됩니다.

주요 기능에는 내장된 추론 제어가 포함됩니다. 개발자는 thinking_level 매개변수를 사용하여 사고 깊이를 조정할 수 있습니다: minimal(최소), low(낮음), medium(중간), high(높음, 기본값). High는 추론 품질을 극대화하는 반면, 낮은 수준은 높은 처리량 시나리오에서 대기 시간을 우선시합니다.

또한, 비전 작업의 미디어 해상도를 제어합니다. 옵션은 low에서 ultra_high까지 다양하며, 프레임 또는 이미지당 토큰 소비에 영향을 미칩니다. 적절하게 선택하십시오. 자세한 이미지는 high, 문서는 medium입니다.

이 모델은 Google 검색 그라운딩, 코드 실행, 함수 호출과 같은 도구를 통합합니다. 그러나 이미지 생성 및 특정 고급 로봇 공학 도구는 제외됩니다.

Gemini 3 Flash API 가격

API 통합에서 비용 관리가 중요합니다. Gemini 3 Flash는 사용량 기반 지불 모델로 운영됩니다. 입력 토큰은 1백만 개당 $0.50, 출력 토큰(사고 토큰 포함)은 1백만 개당 $3입니다.

Google은 AI Studio에서 무료 실험을 제공합니다. 그러나 청구가 활성화되면 프로덕션 API 사용량에는 요금이 부과됩니다. 이 미리보기 모델의 경우 Studio 체험 외에는 무료 등급이 없습니다.

컨텍스트 캐싱 및 배치 처리는 비용을 더욱 최적화하는 데 도움이 됩니다. 캐싱은 반복되는 컨텍스트에 대한 중복 토큰 처리를 줄입니다. 배치 API는 비동기식 대용량 작업에 적합합니다.

Google Cloud Billing 대시보드를 통해 사용량을 모니터링하십시오. 갑작스러운 급증은 종종 높은 media_resolution 설정 또는 광범위한 추론에서 비롯됩니다.

첫 API 요청하기

간단한 텍스트 생성으로 시작합니다. 엔드포인트는 https://generativelanguage.googleapis.com/v1beta/models/gemini-3-flash-preview:generateContent입니다.

POST 요청을 구성합니다. 헤더에 API 키를 포함합니다. 본문은 역할-파트 객체 배열로 된 콘텐츠를 포함합니다.

다음은 기본 cURL 예시입니다:

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-flash-preview:generateContent" \

-H "x-goog-api-key: YOUR_API_KEY" \

-H "Content-Type: application/json" \

-X POST \

-d '{

"contents": [{

"parts": [{"text": "양자 얽힘을 간략하게 설명해 주세요."}]

}]

}'

응답은 텍스트 부분을 포함하는 후보를 반환합니다. 또한 토큰 수에 대한 사용량 메타데이터를 처리합니다.

스트리밍 응답의 경우 :streamGenerateContent 엔드포인트를 사용합니다. 이는 부분 결과를 점진적으로 제공하여 애플리케이션의 인지 대기 시간을 개선합니다.

공식 SDK와 통합하기

Google은 상호 작용을 간소화하는 SDK를 유지 관리합니다. pip install google-generativeai를 통해 Python 패키지를 설치합니다.

클라이언트를 초기화합니다:

import google.generativeai as genai

genai.configure(api_key="YOUR_API_KEY")

model = genai.GenerativeModel("gemini-3-flash-preview")

response = model.generate_content("최근 AI 발전 사항을 요약해 주세요.")

print(response.text)

SDK는 다중 턴 대화 및 도구 사용을 위한 사고 서명을 자동으로 관리합니다. 결과적으로, 프로덕션 코드에서는 원시 HTTP 대신 SDK를 사용하는 것이 좋습니다.

Node.js 사용자는 @google/generative-ai를 통해 유사한 편의성을 누릴 수 있습니다.

다중 모드 입력 처리

Gemini 3 Flash는 다중 모드 처리에서 뛰어납니다. 파일을 업로드하거나 인라인 데이터 URI를 제공할 수 있습니다.

Python에서:

model = genai.GenerativeModel("gemini-3-flash-preview")

image = genai.upload_file("diagram.png")

response = model.generate_content(["이 이미지를 자세히 설명해 주세요.", image])

print(response.text)

토큰 효율성을 위해 생성 구성에서 media_resolution을 조정합니다:

generation_config = {

"media_resolution": "media_resolution_high"

}

비디오 및 PDF도 유사한 패턴을 따릅니다. 또한, 복잡한 분석 작업을 위해 하나의 요청에서 여러 모드를 결합할 수 있습니다.

고급 기능: 사고 수준 및 도구

추론을 명시적으로 제어합니다. 빠른 응답을 위해 thinking_level을 "low"로 설정합니다:

"generationConfig": {

"thinking_level": "low"

}

높은 사고 수준은 내부적으로 더 깊은 사고의 사슬 처리를 가능하게 합니다.

함수 호출과 같은 도구를 활성화합니다. 요청에 함수를 정의하면 모델은 적절할 때 호출을 반환합니다.

구조화된 출력은 JSON 스키마를 강제합니다:

"generationConfig": {

"response_mime_type": "application/json",

"response_schema": {...}

}

이를 결합하여 에이전트 워크플로우를 만듭니다. 예를 들어, 실시간 검색으로 응답을 그라운딩합니다.

Apidog로 테스트 및 디버깅

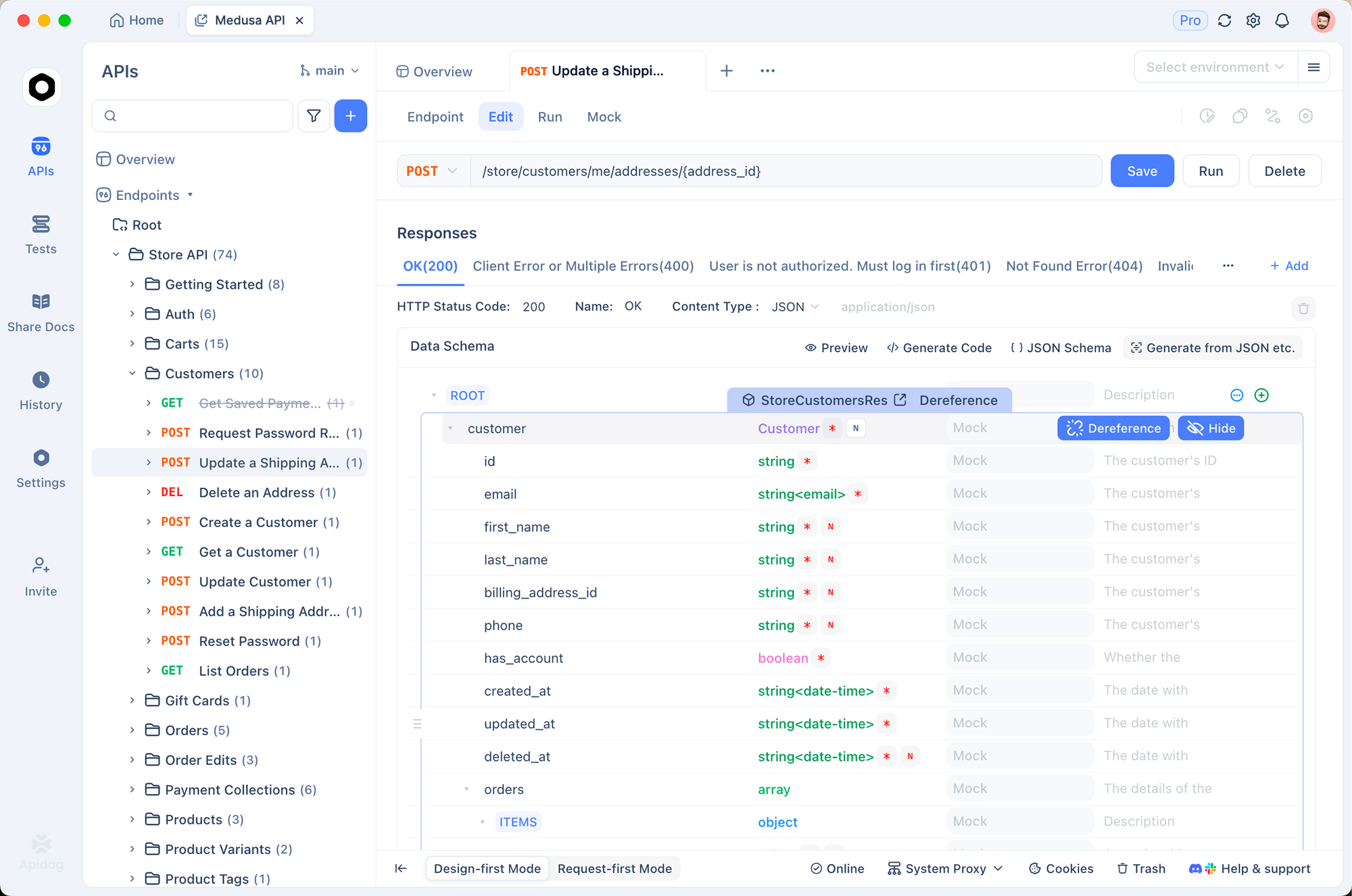

효과적인 테스트는 안정적인 통합을 보장합니다. Apidog는 이 목적을 위한 강력한 도구로 등장했습니다. 이 도구는 API 디자인, 디버깅, 모킹 및 자동화된 테스트를 하나의 플랫폼에 결합합니다.

먼저 Gemini 엔드포인트를 Apidog로 가져옵니다. generateContent 메서드를 가리키는 새 요청을 만듭니다. API 키를 환경 변수로 저장하십시오. Apidog는 개발, 스테이징 및 프로덕션용으로 여러 환경을 지원합니다.

요청을 시각적으로 보냅니다. Apidog는 응답을 명확하게 표시하고, 토큰 사용량과 오류를 강조합니다. 또한, 응답 구조를 자동으로 검증하기 위한 어설션을 설정할 수 있습니다.

다중 턴 채팅의 경우 Apidog의 스크립팅 또는 변수를 사용하여 요청 전반에 걸쳐 대화 기록을 유지하십시오. 이는 실제 사용자 세션을 효율적으로 시뮬레이션합니다.

Apidog는 또한 모의 서버를 생성합니다. 할당량을 소모하지 않고 프런트엔드 개발 중에 Gemini 응답을 시뮬레이션합니다.

또한, 테스트 스위트를 자동화합니다. 다양한 사고 수준, 다중 모드 입력 및 오류 사례를 포괄하는 시나리오를 정의합니다. 이를 CI/CD 파이프라인에서 실행합니다.

많은 개발자들은 Apidog가 원시 cURL 또는 기본 클라이언트에 비해 디버깅 시간을 크게 줄여준다는 것을 발견했습니다. 직관적인 인터페이스는 복잡한 JSON 본문을 손쉽게 처리합니다.

프로덕션 사용을 위한 모범 사례

지수 백오프를 사용하여 재시도 로직을 구현하십시오. 특히 미리보기 단계에서는 비율 제한이 적용됩니다.

토큰을 최소화하기 위해 가능한 경우 컨텍스트를 캐시합니다. 유효성 검사 오류를 피하려면 원시 요청에서 사고 서명을 정확하게 사용하십시오.

비용을 사전에 모니터링합니다. 요청당 입/출력 토큰 수를 기록합니다.

온도는 기본값 1.0으로 유지합니다. 편차는 추론 성능을 저하시킵니다.

마지막으로, 공식 문서를 통해 최신 정보를 확인하십시오. 미리보기 모델은 발전하므로 잠재적인 주요 변경 사항에 대비해야 합니다.

결론

이제 Gemini 3 Flash를 효과적으로 통합하는 데 필요한 지식을 갖추게 되었습니다. 간단한 요청으로 시작하여 다중 모드 및 도구 강화 애플리케이션으로 확장하십시오. Apidog와 같은 도구를 활용하여 개발 워크플로우를 간소화하십시오.

Gemini 3 Flash는 빌더가 지능적이고 반응성이 뛰어난 시스템을 저렴한 비용으로 구축할 수 있도록 지원합니다. AI Studio에서 자유롭게 실험한 다음, 배포를 위해 API로 전환하십시오.

button