개발자들은 불필요한 복잡성을 추가하지 않으면서 생산성을 향상시키는 도구를 찾습니다. DeepSeek-V3.2와 DeepSeek-V3.2-Speciale은 추론 및 에이전트 작업을 위해 최적화된 강력한 오픈소스 모델로, 독점 시스템에 대한 매력적인 대안으로 떠오릅니다. 이 모델들은 코드 생성, 문제 해결, 긴 컨텍스트 처리에서 탁월하여 Claude Code와 같은 터미널 기반 코딩 환경에 통합하기에 이상적입니다.

DeepSeek-V3.2 이해하기: 추론 작업을 위한 오픈소스 강자

개발자들은 투명성과 유연성 때문에 오픈소스 모델을 높이 평가합니다. DeepSeek-V3.2는 논리적 추론, 코드 합성 및 에이전트 기능을 우선시하는 추론 중심 대규모 언어 모델(LLM)으로 두드러집니다. MIT 라이선스로 출시된 이 모델은 DeepSeek-V3.1과 같은 이전 버전을 기반으로 하며, 최대 128,000 토큰의 확장된 컨텍스트를 처리하기 위한 희소 어텐션 메커니즘의 발전을 통합합니다.

DeepSeek-V3.2는 주로 Hugging Face를 통해 접근할 수 있으며, deepseek-ai/DeepSeek-V3.2 저장소에서 모델 가중치, 구성 파일 및 토크나이저 세부 정보를 호스팅합니다. 모델을 로컬에 로드하려면 pip를 통해 Transformers 라이브러리를 설치하고 간단한 스크립트를 실행하세요.

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

model_name = "deepseek-ai/DeepSeek-V3.2"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name, torch_dtype=torch.float16, device_map="auto")

# Example inference

inputs = tokenizer("Write a Python function to compute Fibonacci sequence:", return_tensors="pt").to(model.device)

outputs = model.generate(**inputs, max_new_tokens=100)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))

이 설정은 효율적인 추론을 위해 최소 16GB VRAM을 갖춘 GPU를 필요로 하지만, bitsandbytes와 같은 라이브러리를 통한 양자화 기술은 메모리 사용량을 줄입니다. DeepSeek-V3.2의 아키텍처는 2,360억 개의 매개변수를 가진 MoE(혼합 전문가) 설계를 사용하여, 계산을 최적화하기 위해 토큰당 일부만 활성화합니다. 결과적으로, 소비자 하드웨어에서 경쟁력 있는 성능을 유지하면서 높은 처리량을 달성합니다.

로컬 실험에서 프로덕션 규모 사용으로 전환하려면 종종 API 접근이 필요합니다. 이러한 전환은 하드웨어 관리 없이 확장성을 제공하며, Claude Code와 같은 통합의 길을 열어줍니다.

DeepSeek-V3.2-Speciale: 고급 에이전트 워크플로우를 위한 향상된 기능

DeepSeek-V3.2가 광범위한 유용성을 제공하는 반면, DeepSeek-V3.2-Speciale은 특수 요구 사항을 위해 이러한 기반을 개선합니다. 이 변형은 대회 수준의 추론 및 고위험 시뮬레이션에 맞춰 수학, 코딩 대회 및 다단계 에이전트 작업에서 한계를 뛰어넘습니다. Hugging Face 저장소 deepseek-ai/DeepSeek-V3.2-Speciale을 통해 사용할 수 있으며, 핵심 MoE 아키텍처를 공유하지만 정밀도를 위한 추가적인 후훈련 정렬을 통합합니다.

DeepSeek-V3.2-Speciale도 유사하게 로드합니다.

model_name = "deepseek-ai/DeepSeek-V3.2-Speciale"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name, torch_dtype=torch.bfloat16, device_map="auto")

매개변수 수는 기본 모델과 유사하지만, 희소 어텐션(DeepSeek Sparse Attention, DSA)의 최적화 덕분에 긴 시퀀스에서 최대 50% 더 빠른 추론을 제공합니다. DSA는 미세한 희소성을 사용하여 어텐션 레이어의 2차 복잡성을 줄이면서도 품질을 유지합니다.

실제로 DeepSeek-V3.2-Speciale은 경쟁 프로그래밍을 위한 알고리즘 최적화와 같이 연쇄적 추론이 필요한 시나리오에서 빛을 발합니다. 예를 들어, "이 LeetCode 어려운 문제 [설명]을 풀어주세요. 단계별 접근 방식을 설명해주세요."와 같이 프롬프트를 입력하면 모델은 시간 복잡도 분석을 포함한 구조화된 솔루션을 출력하며, 종종 일반 모델보다 엣지 케이스에서 15-20% 더 나은 성능을 보여줍니다.

하지만 로컬 실행은 더 많은 리소스를 요구하며, 전체 정밀도를 위해서는 24GB 이상의 VRAM이 권장됩니다. 가벼운 설정을 위해서는 4비트 양자화를 적용하세요.

from transformers import BitsAndBytesConfig

quant_config = BitsAndBytesConfig(load_in_4bit=True)

model = AutoModelForCausalLM.from_pretrained(model_name, quantization_config=quant_config)

이 구성은 메모리 사용량을 절반으로 줄이면서도 원본 충실도의 90%를 유지합니다. 기본 모델과 마찬가지로, 추론 중간에 가정을 자체 수정하는 메타인지 추적을 활용하기 위해 사고 모드를 활성화하세요.

오픈소스 접근은 맞춤화를 가능하게 하지만, 협업 또는 확장된 환경에서는 API 엔드포인트가 신뢰성을 제공합니다. 다음으로, 이러한 모델을 클라우드 기반 상호작용으로 연결하는 방법을 살펴보겠습니다.

DeepSeek API 접근: 확장 가능한 개발을 위한 원활한 통합

DeepSeek-V3.2 및 DeepSeek-V3.2-Speciale과 같은 오픈소스 모델은 로컬 설정에서 뛰어난 성능을 발휘하지만, API 접근은 더 넓은 응용 분야를 가능하게 합니다. DeepSeek 플랫폼은 OpenAI 및 Anthropic SDK를 지원하는 호환 가능한 인터페이스를 제공하여 손쉬운 마이그레이션을 돕습니다.

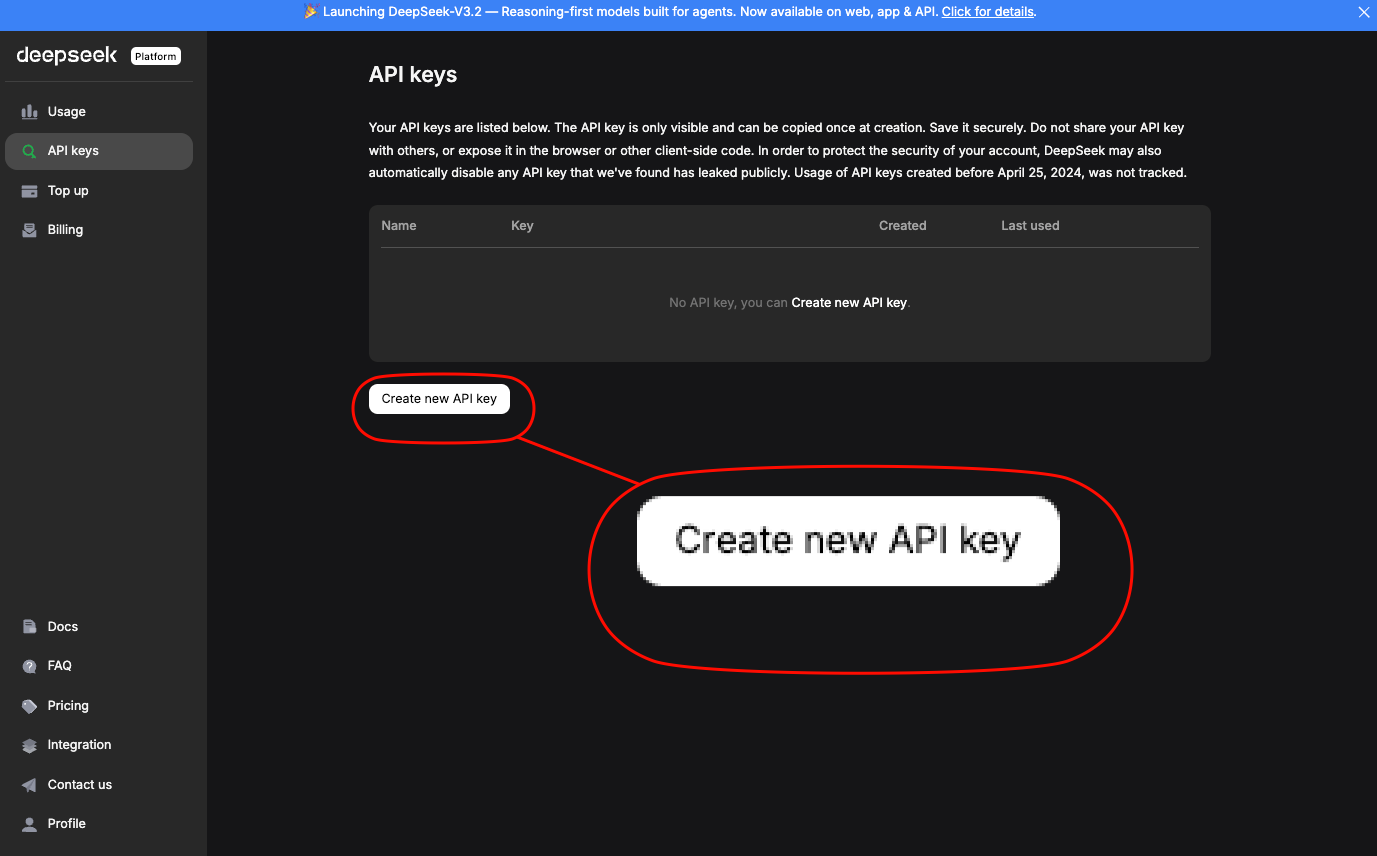

API 키를 얻으려면 platform.deepseek.com에서 가입하세요.

대시보드는 사용량 분석 및 청구 관리를 제공합니다. 표준 엔드포인트를 통해 모델을 호출하세요. DeepSeek-V3.2의 경우 deepseek-chat 별칭을 사용합니다. DeepSeek-V3.2-Speciale은 특정 기본 URL(`https://api.deepseek.com/v3.2_speciale_expires_on_20251215`)을 요구합니다. 이 임시 라우팅은 2025년 12월 15일에 만료됩니다.

기본 curl 요청은 접근 방법을 보여줍니다.

curl https://api.deepseek.com/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $DEEPSEEK_API_KEY" \

-d '{

"model": "deepseek-chat",

"messages": [{"role": "user", "content": "Generate a REST API endpoint in Node.js for user authentication."}],

"max_tokens": 500,

"temperature": 0.7

}'

이것은 오류 처리 및 JWT 통합을 포함하여 생성된 코드가 포함된 JSON을 반환합니다. Claude Code에 필수적인 Anthropic 호환성을 위해 기본 URL을 `https://api.deepseek.com/anthropic`으로 설정하고 `anthropic` Python SDK를 사용하세요.

import anthropic

client = anthropic.Anthropic(base_url="https://api.deepseek.com/anthropic", api_key="your_deepseek_key")

message = client.messages.create(

model="deepseek-chat",

max_tokens=1000,

messages=[{"role": "user", "content": "Explain quantum entanglement in code terms."}]

)

print(message.content[0].text)

이러한 호환성은 즉각적인 대체 사용을 보장합니다. 표준 요금제에서는 분당 10,000 토큰의 속도 제한이 있으며, 기업 플랜을 통해 확장 가능합니다.

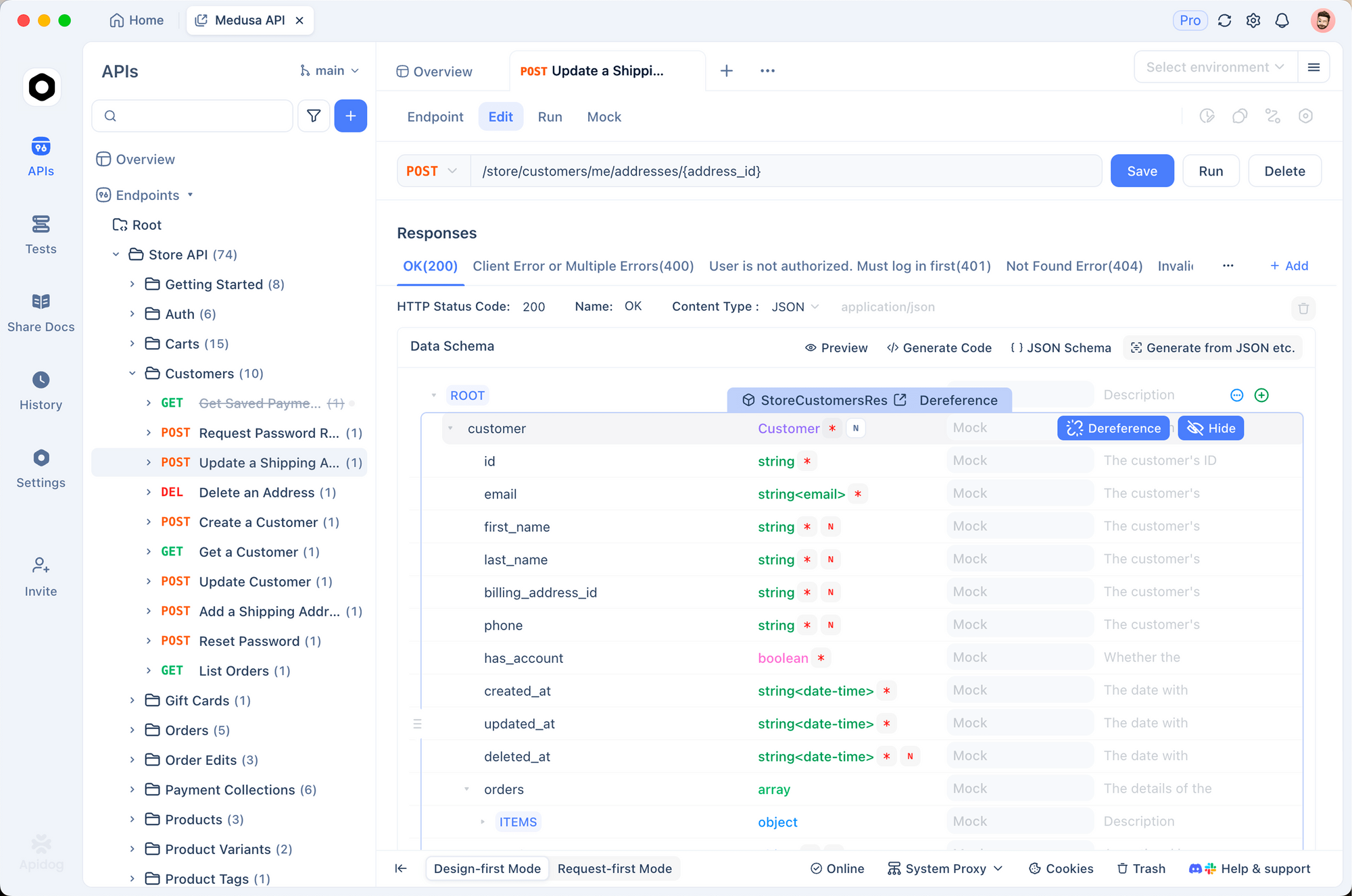

이러한 호출을 프로토타이핑하는 데 Apidog를 사용하세요. DeepSeek 문서의 OpenAPI 사양을 Apidog로 가져온 다음, 가변 페이로드로 요청을 시뮬레이션하세요. 이 도구는 테스트 스위트를 자동으로 생성하여 스키마에 대해 응답을 검증합니다. 이는 모델 출력이 코드베이스 표준과 일치하는지 확인하는 데 필수적입니다.

API 접근이 확보되면 이러한 엔드포인트를 개발 도구에 통합하세요. 특히 Claude Code는 아래에서 설명하듯이 이 설정의 이점을 누립니다.

가격 분석: DeepSeek API 사용을 위한 비용 효율적인 전략

예산에 민감한 개발자들은 예측 가능한 비용을 선호합니다. DeepSeek의 가격 모델은 효율적인 프롬프팅 및 캐싱에 보상을 제공하며, 이는 Claude Code 세션에 직접적인 영향을 미칩니다.

구조를 살펴보면: 캐시 히트는 반복되는 접두사에 적용되며, 세션 전반에 걸쳐 프롬프트를 개선하는 반복적인 코딩에 이상적입니다. 캐시 미스는 전체 입력 요금이 부과되므로, 재사용을 최대화하도록 대화를 구성하세요. 출력은 생성 길이와 선형적으로 비례하므로, max_tokens를 제한하여 비용을 제어하세요.

| 모델 변형 | 입력 캐시 히트 (100만 토큰당 $) | 입력 캐시 미스 (100만 토큰당 $) | 출력 (100만 토큰당 $) | 컨텍스트 길이 |

|---|---|---|---|---|

| DeepSeek-V3.2 | 0.028 | 0.28 | 0.42 | 128K |

| DeepSeek-V3.2-Speciale | 0.028 | 0.28 | 0.42 | 128K |

기업 사용자들은 볼륨 할인을 협상하지만, 무료 계층은 테스트를 위해 매월 100만 토큰을 제공합니다. 대시보드를 통해 모니터링하고, Claude Code에 로깅을 통합하여 토큰 사용량을 추적하세요.

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_API_KEY=$DEEPSEEK_API_KEY

claude --log-tokens

이 명령어는 세션 후 메트릭을 출력하여 프롬프트 최적화에 도움을 줍니다. 긴 컨텍스트 코딩의 경우, V3.2 변형의 DSA는 10만 개 이상의 토큰에서도 비용을 안정적으로 유지하며, 2차적으로 증가하는 밀집 모델과는 다릅니다.

DeepSeek-V3.2 및 V3.2-Speciale을 Claude Code에 통합하기: 단계별 설정

Claude Code는 Anthropic의 에이전트 도구로서 터미널 기반 개발에 혁신을 가져옵니다. 이 도구는 자연어 명령을 해석하고, Git 작업을 실행하며, 코드베이스를 설명하고, 루틴을 자동화하는 모든 작업을 쉘 내에서 수행합니다. 요청을 DeepSeek 모델로 라우팅함으로써, Claude Code의 직관적인 인터페이스를 희생하지 않고도 비용 효율적인 추론을 활용할 수 있습니다.

사전 준비 사항부터 시작하세요: pip(`pip install claude-code`)를 통해 또는 GitHub anthropics/claude-code에서 Claude Code를 설치합니다. Node.js와 git이 PATH에 있는지 확인하세요.

DeepSeek 호환성을 위한 환경 변수를 구성하세요.

export ANTHROPIC_BASE_URL="https://api.deepseek.com/anthropic"

export ANTHROPIC_API_KEY="sk-your_deepseek_key_here"

export ANTHROPIC_MODEL="deepseek-chat" # For V3.2

export ANTHROPIC_SMALL_FAST_MODEL="deepseek-chat"

export API_TIMEOUT_MS=600000 # 10 minutes for long reasoning

export CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC=1 # Optimize for API

DeepSeek-V3.2-Speciale의 경우, 사용자 정의 기본 URL을 추가합니다: export ANTHROPIC_BASE_URL="https://api.deepseek.com/v3.2_speciale_expires_on_20251215/anthropic". claude --version을 실행하여 설정을 확인하세요. 엔드포인트를 자동으로 감지합니다.

프로젝트 디렉토리에서 Claude Code를 실행하세요.

cd /path/to/your/repo

claude

명령어를 통해 상호작용합니다. 코드 생성의 경우: "/generate C++에서 AVL 균형을 사용하여 이진 탐색 트리를 구현하세요." DeepSeek-V3.2는 이를 처리하여 설명과 함께 파일을 출력합니다. 복잡한 작업의 경우, 코드 작성 전에 논리를 추적하는 사고 모드가 암묵적으로 활성화됩니다.

에이전트 워크플로우를 처리합니다: "/agent 이 실패한 테스트 스위트를 디버그하고 수정 사항을 제안하세요." 모델은 스택 트레이스를 분석하고, 패치를 제안하며, Git을 통해 커밋합니다. 이 모든 것은 DeepSeek의 84.8% SWE-Bench 점수에 의해 구동됩니다. 병렬 도구 사용이 여기서 빛을 발합니다. "/use-tool pytest"를 지정하여 테스트를 인라인으로 실행할 수 있습니다.

플러그인을 사용하여 맞춤 설정하세요. Claude Code의 YAML 구성(`~/.claude-code/config.yaml`)을 확장하여 추론 중심 프롬프트에 DeepSeek의 우선순위를 부여하세요.

models:

default: deepseek-chat

fallback: deepseek-chat # For V3.2-Speciale, override per session

reasoning_enabled: true

max_context: 100000 # Leverage 128K window

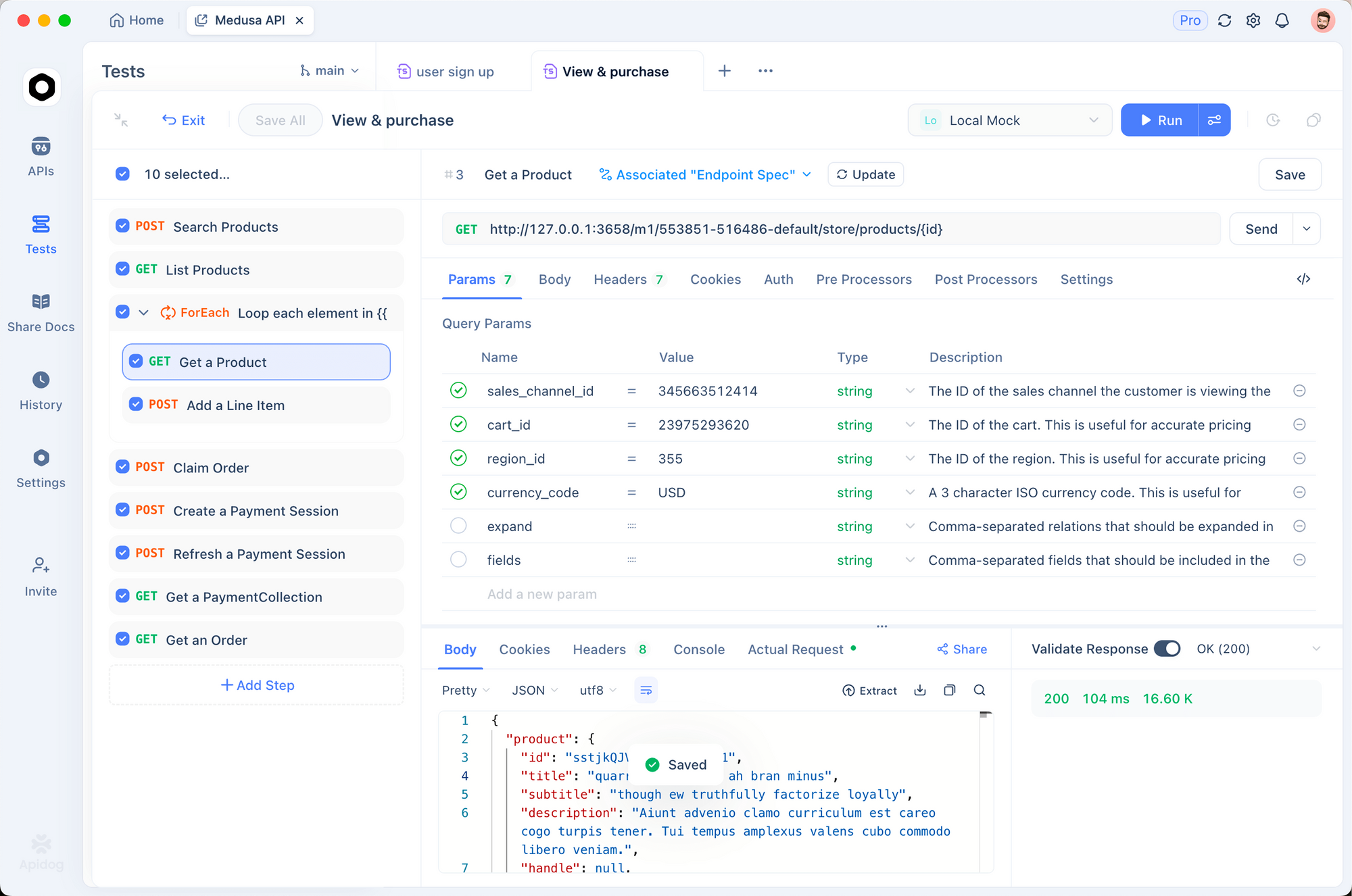

Apidog를 사용하여 통합을 테스트하세요. Claude Code 세션을 HAR 파일로 내보내고, Apidog로 가져온 다음, DeepSeek 엔드포인트에 대해 재생합니다. 이는 지연 시간(일반적으로 1K 토큰당 <2초) 및 오류율을 검증하여 프로덕션용 프롬프트를 개선합니다.

일반적인 문제를 해결하세요: 인증에 실패하면 API 키를 다시 생성하세요. 토큰 제한의 경우, "/summarize repo structure first" 명령으로 대규모 코드베이스를 청크화하세요. 이러한 조정은 원활한 작동을 보장합니다.

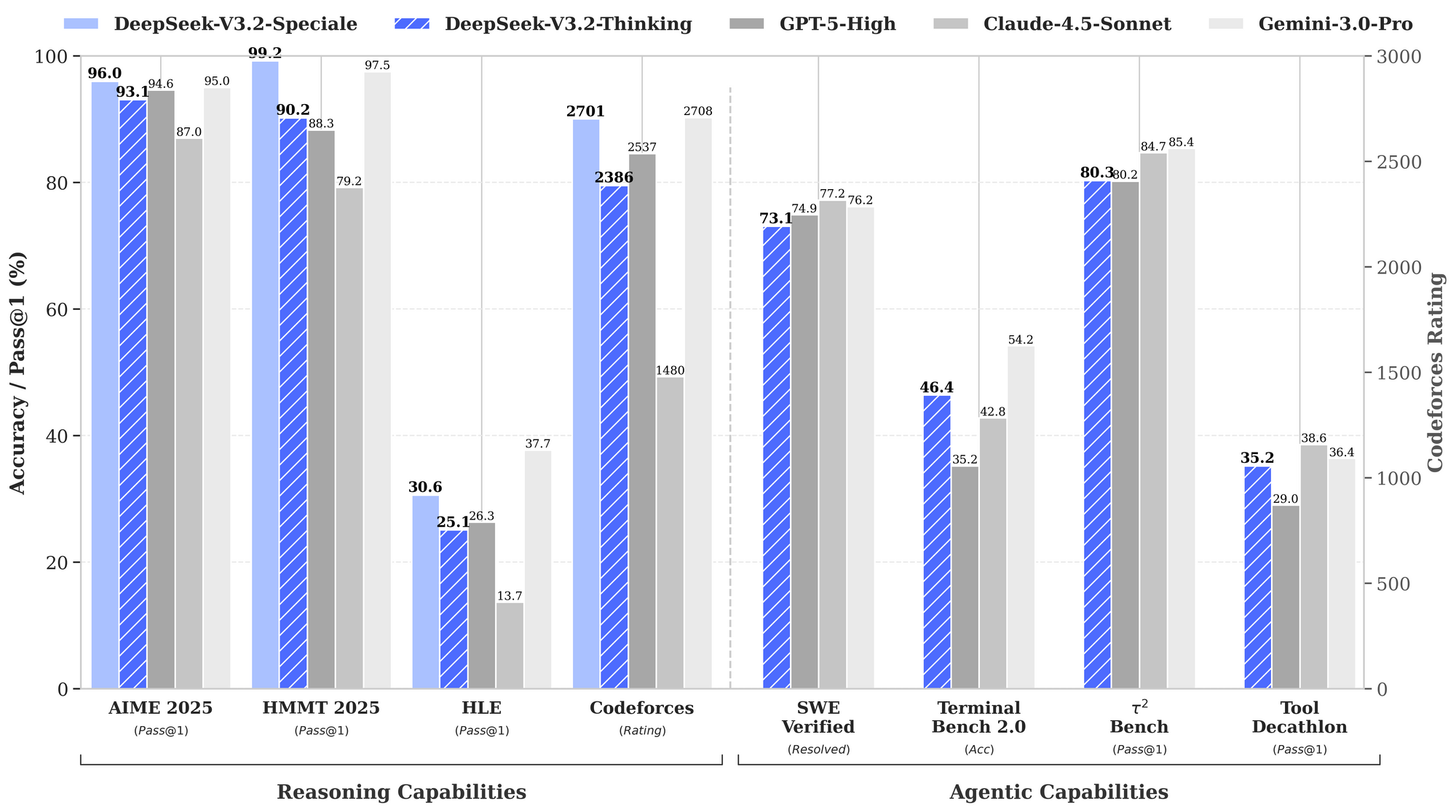

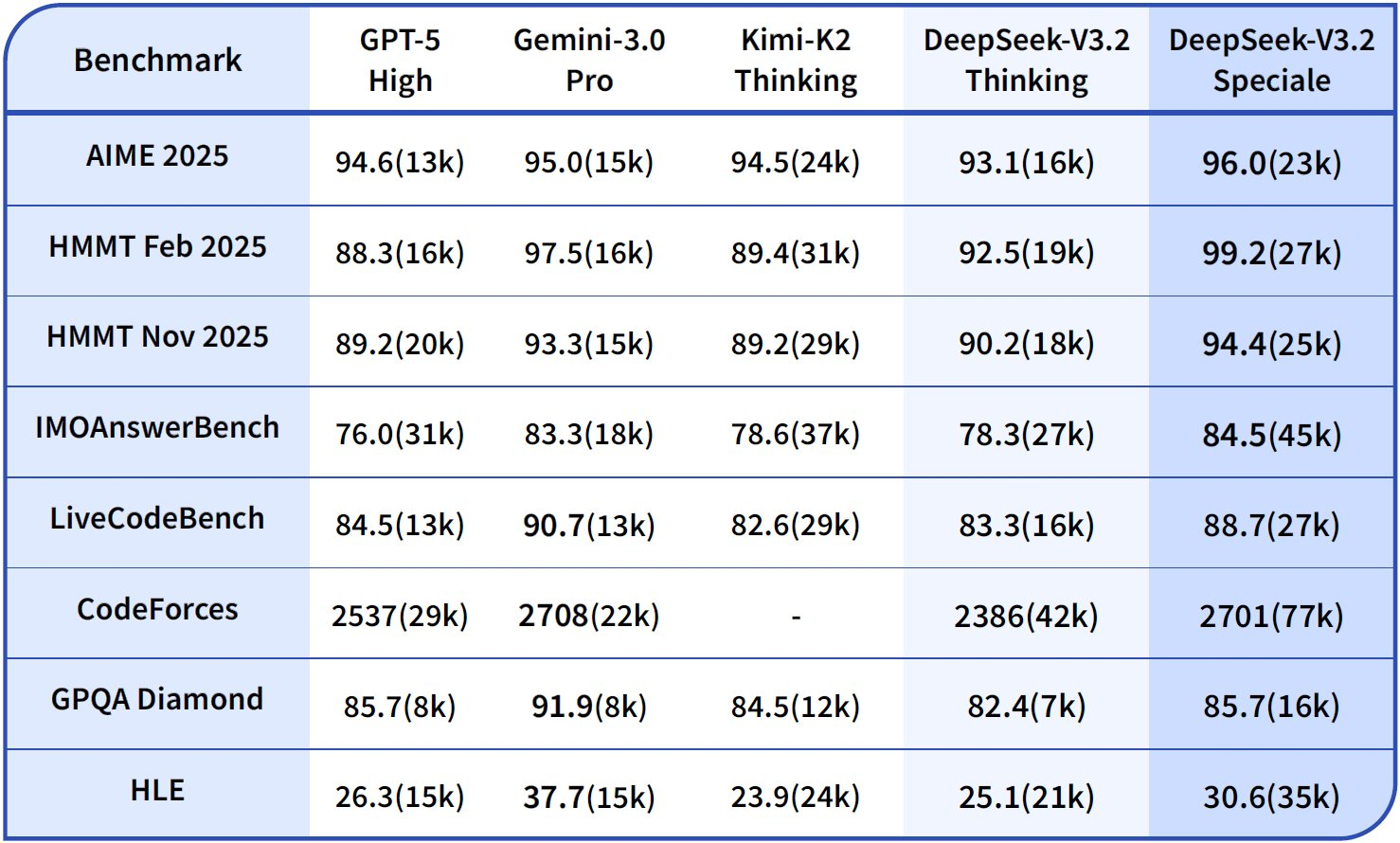

고급 기술: 최적의 성능을 위해 Claude Code에서 DeepSeek 활용하기

기본을 넘어, 고급 사용자들은 DeepSeek의 강점을 활용합니다. 사고의 사슬(CoT)을 명시적으로 활성화하세요: "/think 이 동적 프로그래밍 문제를 해결하세요: [세부 정보]." V3.2-Speciale은 메타인지 추적을 생성하며, 텍스트 내 유사 몬테카를로 시뮬레이션을 통해 자체 수정하여 HMMT에서 정확도를 94.6%까지 높입니다.

여러 파일 편집의 경우 "/edit --files main.py utils.py Add logging decorators"를 사용하세요. 에이전트는 의존성을 탐색하여 변경 사항을 원자적으로 적용합니다. 벤치마크에 따르면 Terminal-Bench 2.0에서 80.3%의 성공률을 보여 Gemini-3.0-Pro를 능가합니다.

외부 도구를 통합하세요: 생성 후 검증을 위해 "/tool npm run build"를 구성하세요. DeepSeek의 도구 사용 벤치마크(84.7%)는 신뢰할 수 있는 오케스트레이션을 보장합니다.

윤리를 모니터링하세요: DeepSeek은 RLHF를 통해 안전에 부합하지만, 코드 가정의 편향을 위해 출력을 감사해야 합니다. Apidog의 스키마 유효성 검사를 사용하여 입력 소독과 같은 보안 패턴을 강제하세요.

팀 규모로 확장하세요: dotfiles 리포지토리를 통해 구성을 공유하세요. CI/CD에서 Claude Code 스크립트를 DeepSeek과 함께 포함하여 자동화된 PR 검토를 수행하면 검토 시간을 40% 단축할 수 있습니다.

실제 적용 사례: DeepSeek 기반 Claude Code의 작동

핀테크 프로젝트를 고려해보세요: "/generate GraphQL을 사용하여 트랜잭션 처리를 위한 보안 API를 생성하세요." DeepSeek-V3.2는 OWASP 표준에 따라 검증된 스키마, 리졸버 및 속도 제한 미들웨어를 출력합니다.

ML 파이프라인에서: "/agent 엣지 배포를 위해 이 PyTorch 모델을 최적화하세요." 이 모델은 양자화를 위해 리팩터링하고, 시뮬레이션된 하드웨어에서 테스트하며, 장단점을 문서화합니다.

이러한 사례들은 GitHub 이슈의 사용자 보고서에 의해 입증된 2-3배의 생산성 향상을 보여줍니다.

결론

DeepSeek-V3.2 및 DeepSeek-V3.2-Speciale은 Claude Code를 추론 중심의 강력한 도구로 변화시킵니다. 오픈소스 로딩부터 API 기반 확장성에 이르기까지, 이 모델들은 비용의 극히 일부로 벤치마크를 선도하는 성능을 제공합니다. API 프로토타이핑을 위한 Apidog부터 시작하여 설명된 단계를 구현하고 간소화된 워크플로우를 경험하세요.

오늘 바로 실험해보세요: 환경을 설정하고, 샘플 명령어를 실행하고, 반복해보세요. 이 통합은 개발 속도를 높일 뿐만 아니라 투명한 추론을 통해 코드에 대한 더 깊은 이해를 촉진합니다. AI가 발전함에 따라 이러한 도구는 개발자들이 최전선에 머물 수 있도록 보장합니다.