개발자들은 코딩 효율성을 높이고, 복잡한 워크플로우를 자동화하며, 지능형 애플리케이션을 구축하기 위해 첨단 AI 모델에 점점 더 의존하고 있습니다. Anthropic의 Claude Opus 4.5는 소프트웨어 엔지니어링, 에이전트(agentic) 작업 및 다단계 추론에서 뛰어난 성능을 제공하며 이 분야의 선두 주자로 떠오르고 있습니다. 이 모델은 실제 코딩 및 컴퓨터 사용 분야에서 새로운 기준을 제시하며, 프로덕션 수준 프로젝트를 수행하는 기술 팀에게 필수적인 도구가 됩니다.

button

이 가이드는 Claude Opus 4.5를 효과적으로 활용하기 위한 기술 지식을 제공합니다. 설정, 핵심 API 메커니즘, 고급 구성 및 최적화 전략을 다룹니다. 다음 단계를 따르면 애플리케이션이 모델의 200K 토큰 컨텍스트 창, 향상된 도구 사용 및 효율적인 토큰 관리를 활용할 수 있도록 위치를 잡을 수 있습니다. 결과적으로 더 빠른 개발 주기와 더 신뢰할 수 있는 AI 기반 기능을 달성할 수 있습니다.

Claude Opus 4.5란 무엇입니까?

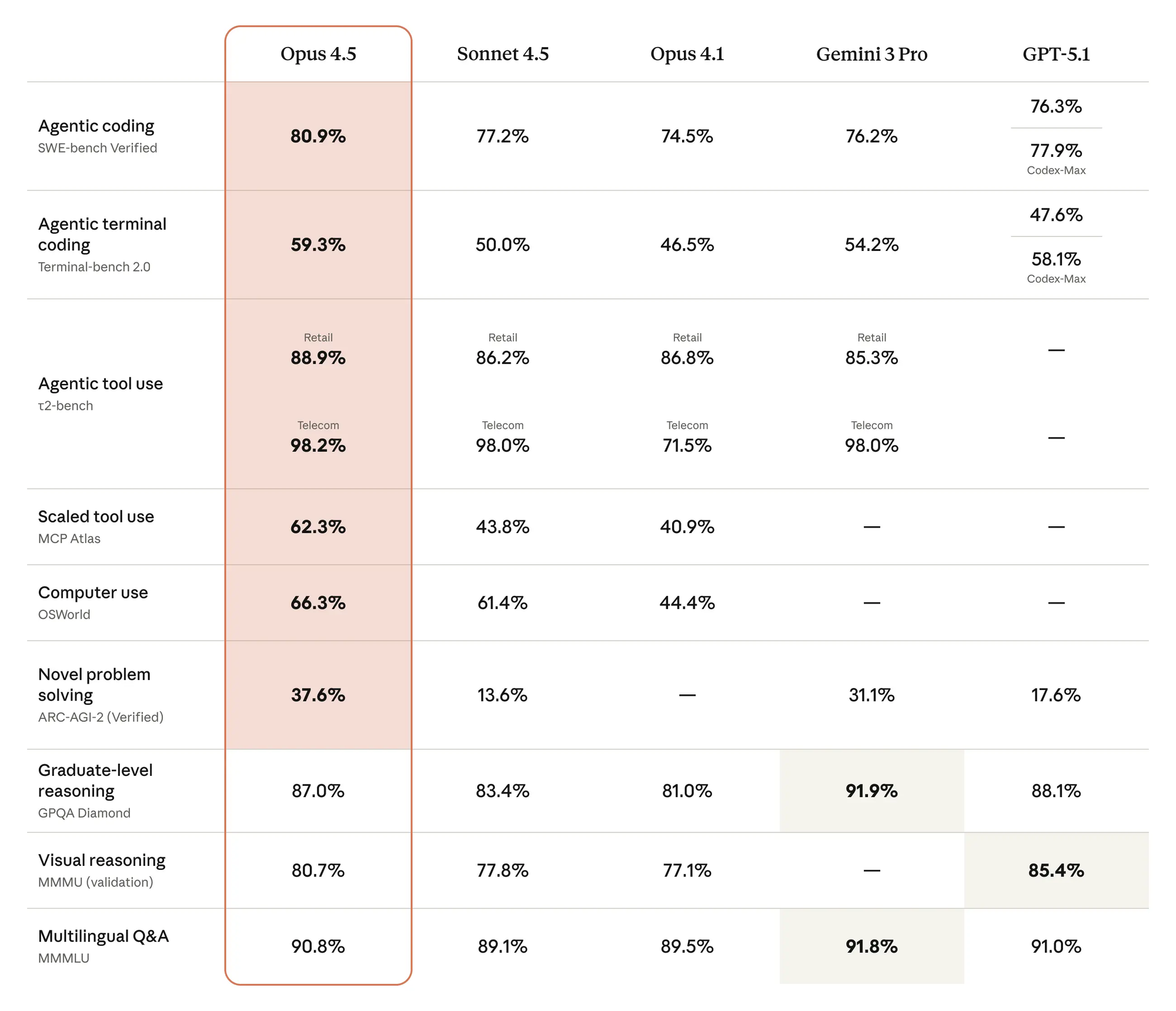

Anthropic 엔지니어들은 추론의 깊이, 코딩 정확성, 에이전트 자율성에 우선순위를 두어 Claude Opus 4.5를 주력 모델로 설계했습니다. 이 버전은 비전 처리, 수학적 정확성, 모호성 해결의 혁신을 통합하여 이전 버전을 기반으로 구축되었습니다. 예를 들어, 이 모델은 엔터프라이즈 시뮬레이션에서 비행 일정을 수정하거나 명시적인 지침 없이 방대한 코드베이스를 디버깅하는 것과 같이 복잡한 시나리오에서 트레이드오프를 처리하는 데 탁월합니다.

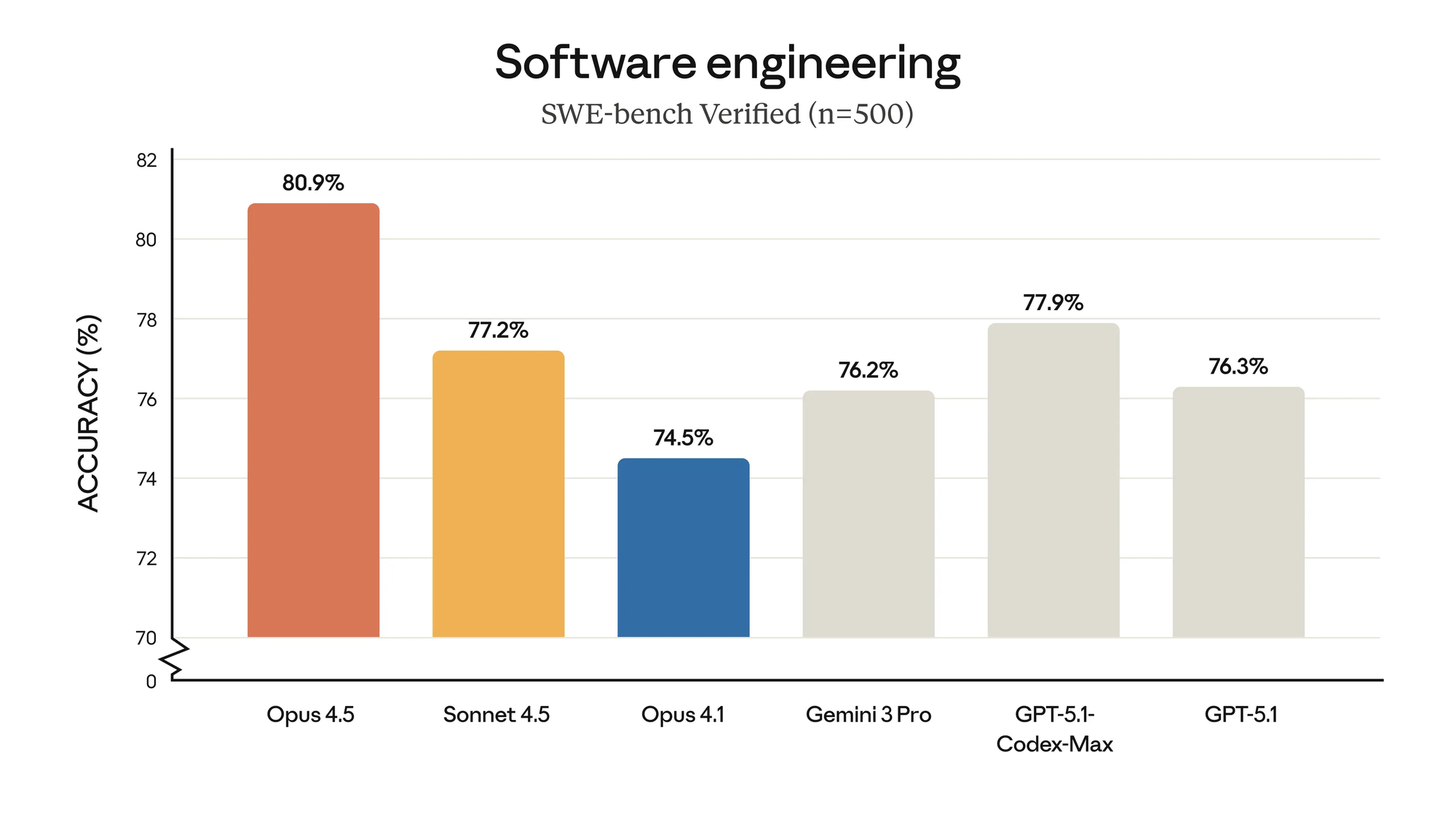

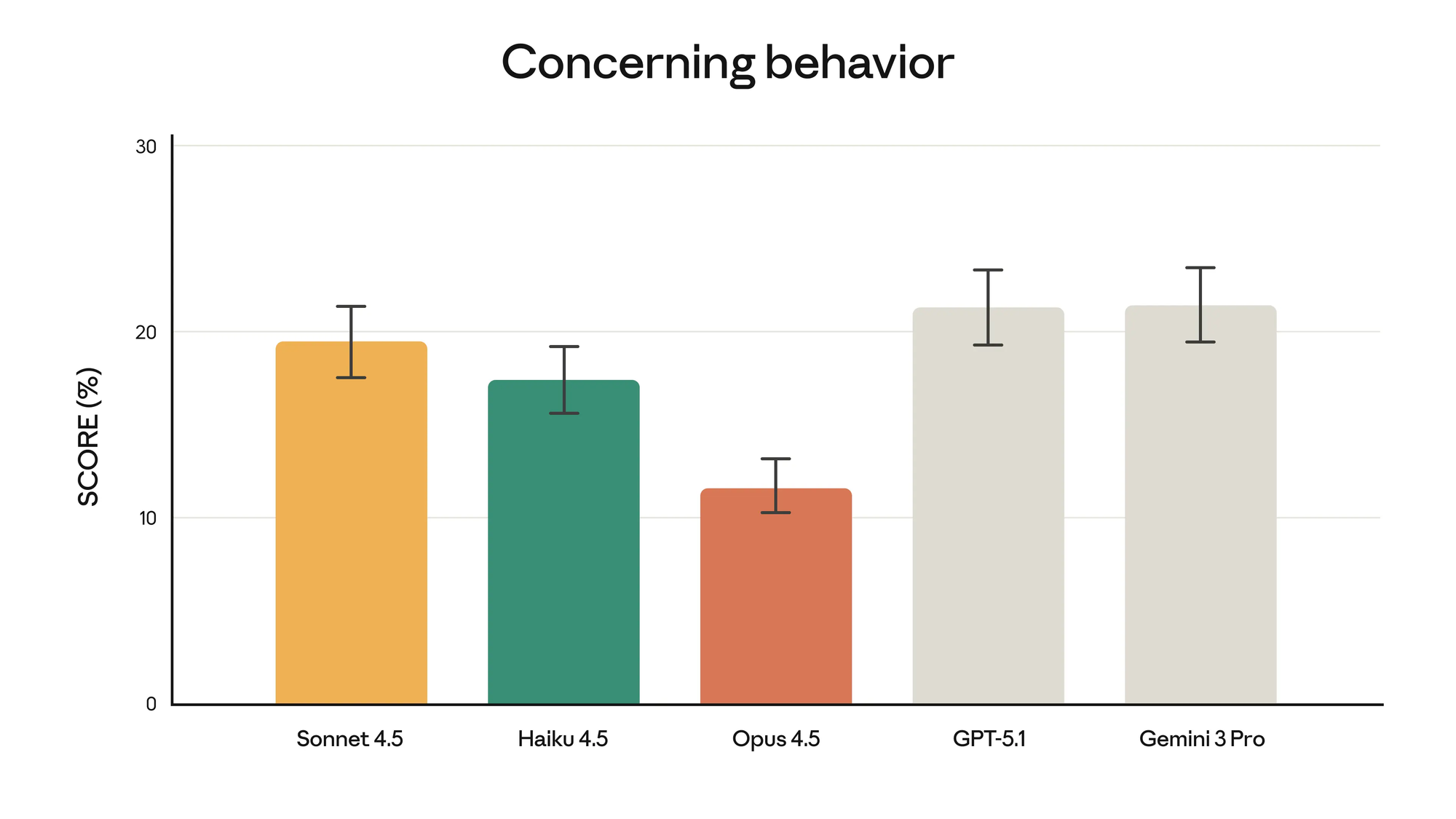

주요 기능으로는 SWE-bench Verified에서 최첨단 결과를 제공하며, 최대 노력 시 이전 모델보다 최대 4.3% 포인트 더 높은 성능을 보이고 출력 토큰을 48% 더 적게 사용합니다.

개발자들은 Claude API를 통해 이러한 강점을 활용할 수 있으며, 이는 긴 형식의 분석 또는 다중 파일 코드 검토에 이상적인 200K 토큰 컨텍스트 창을 지원합니다. 또한 이 모델은 Amazon Bedrock, Google Vertex AI, Microsoft Foundry와 같은 클라우드 플랫폼과 원활하게 통합되어 확장 가능한 배포를 가능하게 합니다.

가격은 프리미엄 포지셔닝을 반영합니다: 백만 입력 토큰당 5달러, 백만 출력 토큰당 25달러이며, 프롬프트 캐싱(최대 90%) 및 배치 처리(50%)를 통해 비용을 절감할 수 있습니다. 그러나 이러한 비용은 정확한 사용 패턴의 필요성을 강조하며, 이는 나중에 다루겠습니다. 본질적으로 Claude Opus 4.5는 개발자가 최소한의 사람 감독으로 초기 계획부터 실행까지 전반적인 프로젝트를 관리하는 에이전트를 구축할 수 있도록 지원합니다.

개발 환경 설정

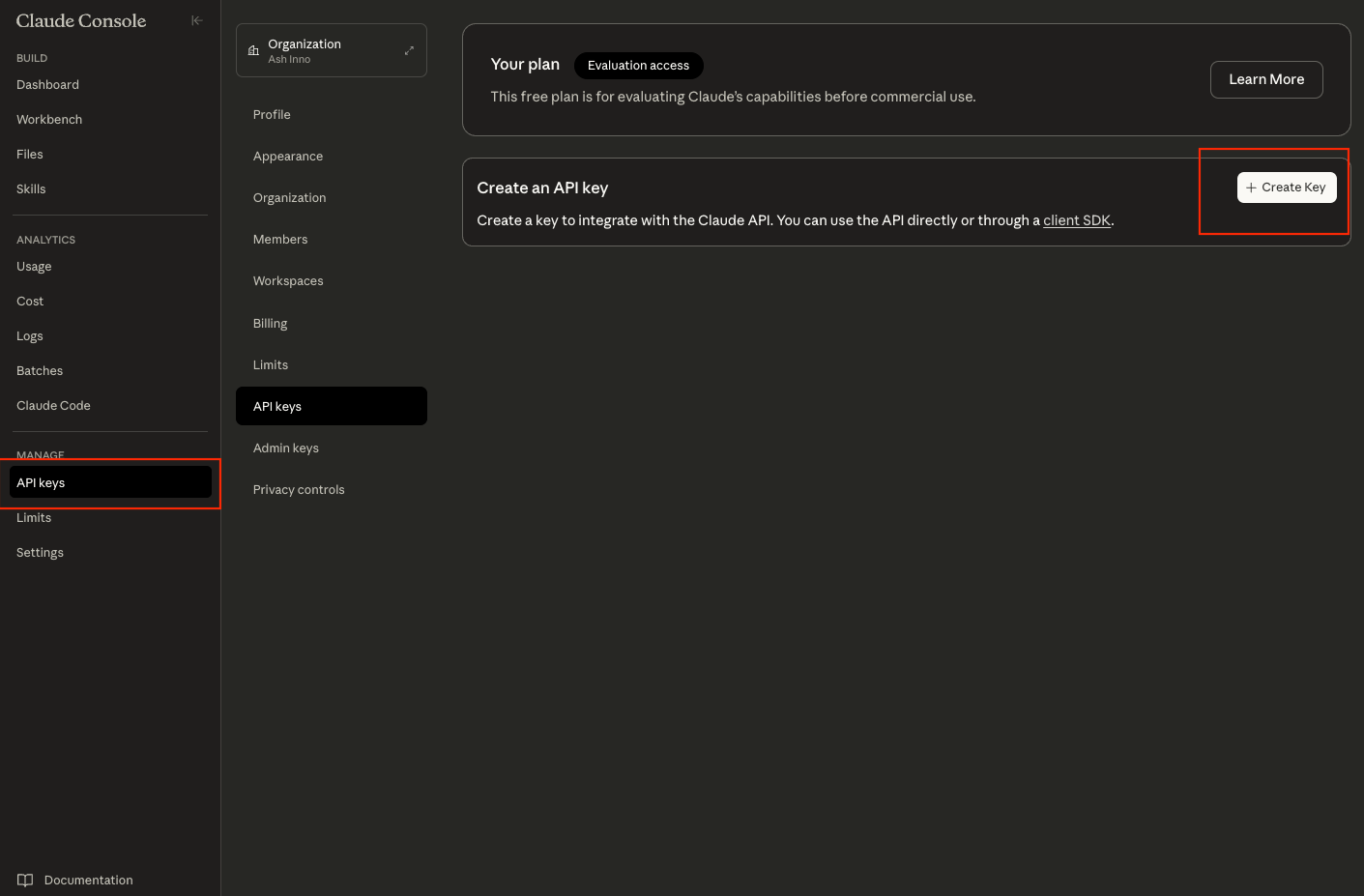

Claude API와 상호 작용하기 위한 강력한 환경을 준비하는 것부터 시작합니다. 먼저, Anthropic Console(console.anthropic.com)에서 API 키를 얻습니다. 가입 또는 로그인하고 "API Keys" 섹션으로 이동하여 새 키를 생성합니다. 터미널에서 export ANTHROPIC_API_KEY='your-key-here'와 같은 환경 변수나 프로젝트 루트의 .env 파일을 사용하여 이를 안전하게 저장하십시오.

다음으로, HTTP 복잡성을 추상화하고 재시도를 처리하는 공식 Anthropic SDK를 설치합니다. Python의 경우 pip install anthropic을 실행합니다. 이 라이브러리는 고처리량 애플리케이션에 필수적인 동기 및 비동기 호출을 지원합니다. 마찬가지로 Node.js 개발자는 npm install @anthropic-ai/sdk를 실행합니다. 모듈을 가져와 설치를 확인합니다: Python에서는 import anthropic; client = anthropic.Anthropic(api_key=os.getenv('ANTHROPIC_API_KEY')).

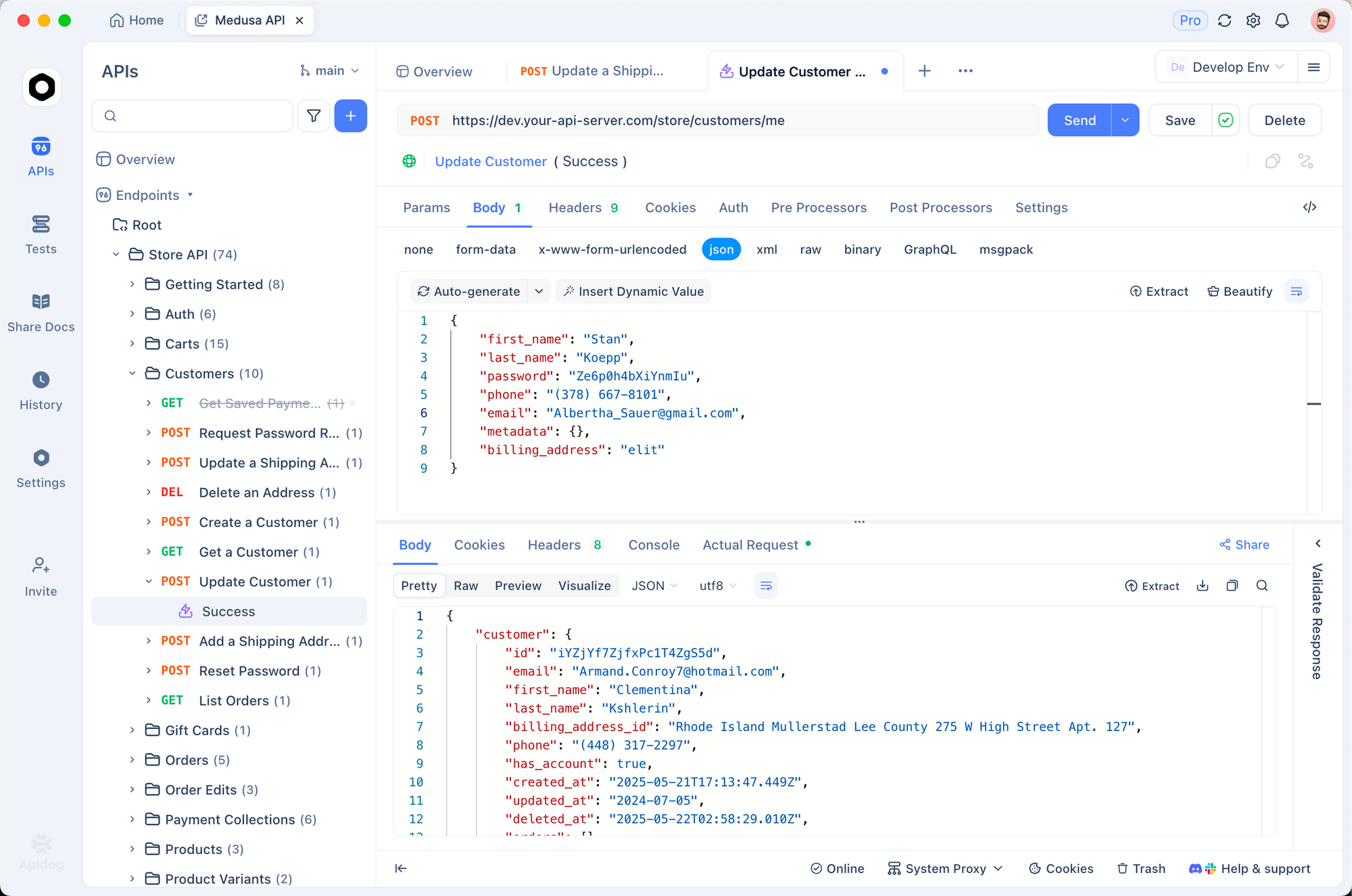

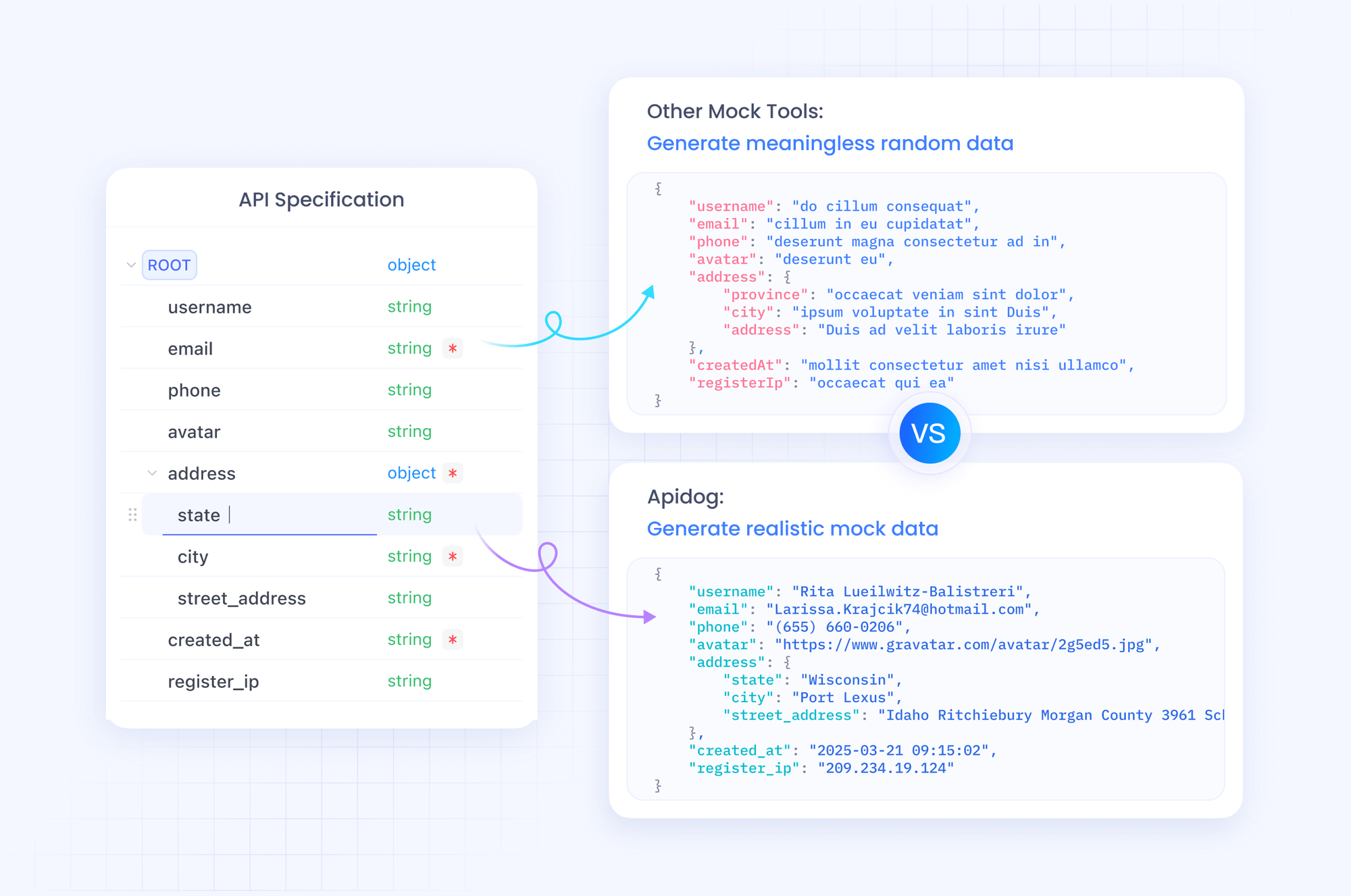

테스트를 위해 Apidog를 조기에 통합하십시오. 이 도구는 SDK 실험에서 curl 명령과 Postman 컬렉션을 생성하여 팀 간 일관성을 보장합니다. API 키를 Apidog의 환경 변수로 가져오고 /v1/messages 엔드포인트에 대한 새 요청을 생성합니다. 이러한 준비는 인증 오류와 같은 일반적인 함정을 방지하여 프롬프트 엔지니어링에 집중할 수 있도록 합니다.

설정이 완료되면 간단한 상태 확인으로 연결을 확인하십시오. 키와 네트워크를 검증하기 위한 기본 요청을 보냅니다. 이 단계는 환경이 API의 속도 제한(초기 Opus 모델의 경우 분당 50개 요청, 사용 등급에 따라 확장 가능)을 처리하는지 확인합니다.

인증 및 API 기본 사항

Anthropic은 표준 OAuth2 기반 메커니즘인 Bearer 토큰을 통해 인증을 시행합니다. 모든 요청에 Authorization 헤더에 Bearer ${ANTHROPIC_API_KEY} 형식으로 API 키를 포함하십시오. 기본 URL은 https://api.anthropic.com/v1이며, 채팅 완료를 위한 주요 엔드포인트는 /messages입니다.

요청은 JSON 페이로드 구조를 따릅니다. 이 릴리스의 정확한 식별자인 claude-opus-4-5-20251101을 지정하는 model 필드를 정의합니다. 시스템 프롬프트는 행동 지침을 설정하고, 사용자 메시지는 응답을 트리거하는 역할-콘텐츠 쌍을 포함하는 messages 배열을 추가합니다. 예를 들어:

{

"model": "claude-opus-4-5-20251101",

"max_tokens": 1024,

"messages": [

{"role": "user", "content": "Explain quantum entanglement in simple terms."}

]

}

SDK는 이를 단순화합니다: Python에서는 client.messages.create(model="claude-opus-4-5-20251101", max_tokens=1024, messages=[{"role": "user", "content": "Your prompt here"}]). 응답은 스트리밍을 위한 텍스트 델타 또는 배치 모드를 위한 전체 블록을 포함하는 content 배열을 반환합니다.

속도 제한은 조직별로 적용됩니다: Opus 4.5는 초기 분당 10,000 토큰으로 제한되며, 최대 50,000 토큰까지 버스트됩니다. x-ratelimit-remaining과 같은 응답 헤더를 통해 모니터링하십시오. 초과될 경우 코드에 지수 백오프를 구현하십시오. SDK는 retry_on=anthropic.RetryStatus.SERVER_ERROR를 사용하여 이를 기본적으로 처리합니다.

보안 모범 사례에는 키를 분기별로 순환하고 콘솔에서 특정 IP 범위로 제한하는 것이 포함됩니다. 따라서 API 호출을 확장하면서 엔터프라이즈 설정에서 규정 준수를 유지할 수 있습니다.

첫 API 요청 만들기

API의 리듬을 파악하기 위해 첫 번째 요청을 실행하십시오. 모델의 추론 능력을 테스트하는 간단한 쿼리로 시작하십시오. Python에서:

import anthropic

import os

client = anthropic.Anthropic(api_key=os.getenv("ANTHROPIC_API_KEY"))

response = client.messages.create(

model="claude-opus-4-5-20251101",

max_tokens=500,

messages=[

{"role": "user", "content": "Write a Python function to compute Fibonacci numbers up to n=20."}

]

)

print(response.content[0].text)

이 코드는 메모이제이션을 활용하여 효율적인 코드를 생성하는 모델을 호출하여 코딩 능력을 보여줍니다. 응답은 기본 노력 시 2초 이내에 도착하며, 간결한 결과를 위해 약 150개의 출력 토큰을 사용합니다.

스트리밍의 경우 호출에 stream=True를 추가하십시오. 이는 실시간 UI에 이상적인 점진적 델타를 생성합니다. 제너레이터 루프를 통해 이를 파싱합니다:

stream = client.messages.stream(

model="claude-opus-4-5-20251101",

max_tokens=500,

messages=[{"role": "user", "content": "Your streaming prompt"}]

)

for text in stream:

print(text.content[0].text, end="", flush=True)

Apidog는 응답 뷰어에서 스트림을 시각화하여 토큰 소비를 강조함으로써 이를 보완합니다. 프로덕션 전에 프롬프트를 다듬기 위해 여기서 실험하십시오.

오류를 사전에 처리하십시오. 429 상태는 스로틀링을 나타냅니다. try-except 블록으로 처리하십시오. 마찬가지로 400은 잘못된 JSON을 나타냅니다. Apidog의 스키마 검사기를 사용하여 페이로드를 검증하십시오. 이러한 기본 사항을 통해 더 복잡한 통합을 위한 기반을 구축할 수 있습니다.

고급 기능: 노력 제어 및 컨텍스트 관리

Claude Opus 4.5는 속도와 깊이의 균형을 맞추는 데 중요한 effort 매개변수를 도입합니다. 요청에서 "low", "medium", "high"로 설정할 수 있습니다. "low"는 빠른 응답(1초 미만 대기 시간)을 우선시하는 반면, "high"는 미묘한 출력을 위해 확장된 계산을 할당하여 SWE-bench와 같은 벤치마크를 15점 향상시킵니다.

다음과 같이 통합하십시오:

response = client.messages.create(

model="claude-opus-4-5-20251101",

effort="high",

max_tokens=2000,

messages=[{"role": "user", "content": "Analyze tradeoffs in microservices vs. monoliths for a fintech app."}]

)

"high" 노력에서 모델은 인터리브 스크래치패드와 64K 사고 예산을 사용하여 자세한 장단점 표를 생성합니다. 그러나 이는 비용을 증가시킵니다. "medium" 노력은 종종 작업의 80%에 충분하며, Sonnet 4.5의 효율성을 76% 적은 토큰으로 달성합니다.

컨텍스트 관리도 마찬가지입니다. 200K 창은 전체 저장소를 수용합니다. 클라이언트 측 압축 SDK를 사용하여 이전 교환을 요약하십시오. pip install anthropic-compaction을 통해 설치한 다음:

from anthropic.compaction import compact_context

compacted = compact_context(previous_messages)

# Append to new messages array

이 기능은 에이전트가 세션 전반에 걸쳐 메모리를 유지하는 에이전트 루프에서 빛을 발합니다. 다중 에이전트 시스템의 경우 도구 호출을 통해 하위 에이전트를 정의하여 Opus 4.5가 팀을 조율할 수 있도록 합니다. 예를 들어, 하나는 연구용, 다른 하나는 검증용으로 사용할 수 있습니다.

도구로 전환하면 Opus 4.5는 고급 정의를 지원합니다. 데이터베이스 쿼리와 같은 함수에 대한 JSON 스키마를 선언하십시오:

{

"name": "get_user_data",

"description": "Fetch user profile",

"input_schema": {"type": "object", "properties": {"user_id": {"type": "string"}}}

}

모델은 도구를 자율적으로 호출하고, 인수를 파싱하며, 결과를 후속 조치에 주입합니다. 이를 통해 사이버 보안 스캔을 위한 API 연결 에이전트와 같은 하이브리드 워크플로우를 사용할 수 있습니다.

도구 통합 및 에이전트 구축

도구 사용은 Claude Opus 4.5를 에이전트 수준으로 끌어올립니다. 요청의 tools 배열에 도구를 정의하십시오. 모델은 컨텍스트에 따라 호출을 결정하고, 정밀도를 위해 XML 형식의 호출을 생성합니다.

예: 날씨 API 도구 통합.

tools = [

{

"name": "get_weather",

"description": "Retrieve current weather for a city",

"input_schema": {

"type": "object",

"properties": {"city": {"type": "string"}},

"required": ["city"]

}

}

]

response = client.messages.create(

model="claude-opus-4-5-20251101",

max_tokens=1000,

tools=tools,

messages=[{"role": "user", "content": "Plan a trip to Paris; check weather."}]

)

모델이 도구를 호출하면 response.stop_reason == "tool_use"에서 추출하고, 외부에서 실행한 다음, 출력을 도구 결과 메시지로 추가합니다. 완전한 에이전트 실행을 위해 완료될 때까지 반복합니다.

컴퓨터 사용의 경우 헤더를 통해 베타 기능을 활성화하십시오. 이를 통해 화면 검사 및 자동화가 가능하며, 픽셀 수준 분석을 위한 Zoom Tool은 UI 디버깅에 중요합니다.

Apidog는 도구 테스트를 간소화합니다: 시뮬레이터에서 엔드포인트를 모의한 다음 SDK 코드로 내보냅니다. 이 반복적인 접근 방식은 에이전트의 신뢰성을 개선하고 환각적인 호출을 줄입니다.

다중 에이전트 설정에서는 상태 지속성을 위해 메모리 도구를 활용하십시오. memory 도구에 주요 사실을 저장하고, 하위 에이전트 전체에서 쿼리합니다. 결과적으로 시스템은 한 에이전트가 계획하고 다른 에이전트가 실행하는 소프트웨어 감사와 같은 방대한 작업을 처리합니다.

오류 처리 및 모범 사례

강력한 애플리케이션은 오류를 예상합니다. API 특이성에 대한 포괄적인 오류 처리를 구현하십시오. 4xx 오류의 경우 error.type(예: "invalid_request")을 기록하고 수정된 페이로드로 재시도하십시오. 데코레이터에 tenacity 라이브러리를 사용하십시오:

from tenacity import retry, stop_after_attempt, wait_exponential

@retry(stop=stop_after_attempt(3), wait=wait_exponential(multiplier=1, min=4, max=10))

def safe_api_call(prompt):

return client.messages.create(model="claude-opus-4-5-20251101", messages=[{"role": "user", "content": prompt}])

응답의 usage(입력, 출력 및 캐시 적중)를 통해 토큰 사용량을 모니터링하십시오. 동적으로 예산을 설정하십시오: 출력이 max_tokens의 80%를 초과하면 잘라내고 요약하십시오.

모범 사례에는 구조화를 위한 XML 태그를 사용한 프롬프트 엔지니어링이 포함됩니다: <thinking>단계별로 추론</thinking><output>최종 답변</output>. 이는 특히 낮은 노력 시 모델을 안내합니다. 또한 윤리적 지침을 시행하는 system 프롬프트를 통해 안전을 활성화하십시오.

생산을 위해 비용을 절감하기 위해 요청을 일괄 처리하십시오: 긴급하지 않은 쿼리를 대기열에 넣고 100단위로 처리하십시오. 자주 사용되는 프롬프트를 캐시하여 90%의 비용을 절감하십시오. 정렬을 위해 출력을 정기적으로 감사하십시오. Opus 4.5는 주입에 저항하지만, 민감한 데이터를 검증하십시오.

성능 및 비용 최적화

최적화는 지속 가능한 사용을 보장합니다. Apidog의 분석을 사용하여 요청 프로파일링: 대기 시간, 토큰 소비 및 성공률을 추적하십시오. 장황한 프롬프트와 같은 병목 현상을 식별하고 압축을 사용하여 압축하십시오.

프롬프트 캐싱 활용: 재사용 가능한 접두사에 cache_control: {"type": "ephemeral"}을 태그하십시오. 적중 시 입력에 대해 25%만 지불합니다. 에이전트의 경우 통화를 통해 캐시를 유지하여 컨텍스트를 저렴하게 유지하십시오.

비동기 패턴으로 확장하십시오. Node.js에서:

const { Anthropic } = require('@anthropic-ai/sdk');

const anthropic = new Anthropic({ apiKey: process.env.ANTHROPIC_API_KEY });

async function parallelRequests(prompts) {

const promises = prompts.map(p =>

anthropic.messages.create({ model: 'claude-opus-4-5-20251101', messages: [{role: 'user', content: p}] })

);

return Promise.all(promises);

}

이는 동시 에이전트 포크를 효율적으로 처리합니다. 높은 노력 시 품질 저하 없이 비용 제어를 위해 사고 예산을 32K로 제한하십시오.

기본값에 대해 설정을 벤치마킹하십시오: Opus 4.5는 SWE-bench에서 72.5%를 달성하므로 사용자 지정 평가를 테스트하십시오. 작업당 노력을 조정하십시오. 아이디어 생성에는 "low", 검증에는 "high"를 사용하십시오.

결론

이제 Claude Opus 4.5 API를 스택에 효과적으로 통합할 수 있는 도구를 갖추었습니다. 초기 설정부터 에이전트 오케스트레이션까지, 이 가이드는 코딩 및 추론에서 그 강점을 활용하는 방법을 제시합니다. 캐싱 또는 노력 조정과 같은 작은 개선이 성능과 경제성에서 상당한 이득을 가져온다는 것을 기억하십시오.

Apidog를 사용하여 각 계층을 검증하면서 반복적으로 실험하십시오. 구축하면서 Anthropic의 업데이트를 모니터링하여 개선 사항을 확인하십시오. 궁극적으로 Claude Opus 4.5는 개발을 수작업에서 조율된 인텔리전스로 전환합니다. 오늘부터 구현을 시작하고 프로젝트가 정밀하게 확장되는 것을 지켜보십시오.

button