開発者やAI愛好家は、シンプルな入力から映画のようなビデオを作成するために、Wan 2.2のような強力な生成モデルにますます注目しています。このモデルは、速度を犠牲にすることなく容量を向上させるMixture-of-Expertsアーキテクチャが際立っています。Wan 2.2 API(LoRAを使用)を組み合わせることで、特定のスタイルや動きに合わせて出力を微調整する機能が得られ、カスタマイズされたビデオ生成に最適です。

Wan 2.2とは?

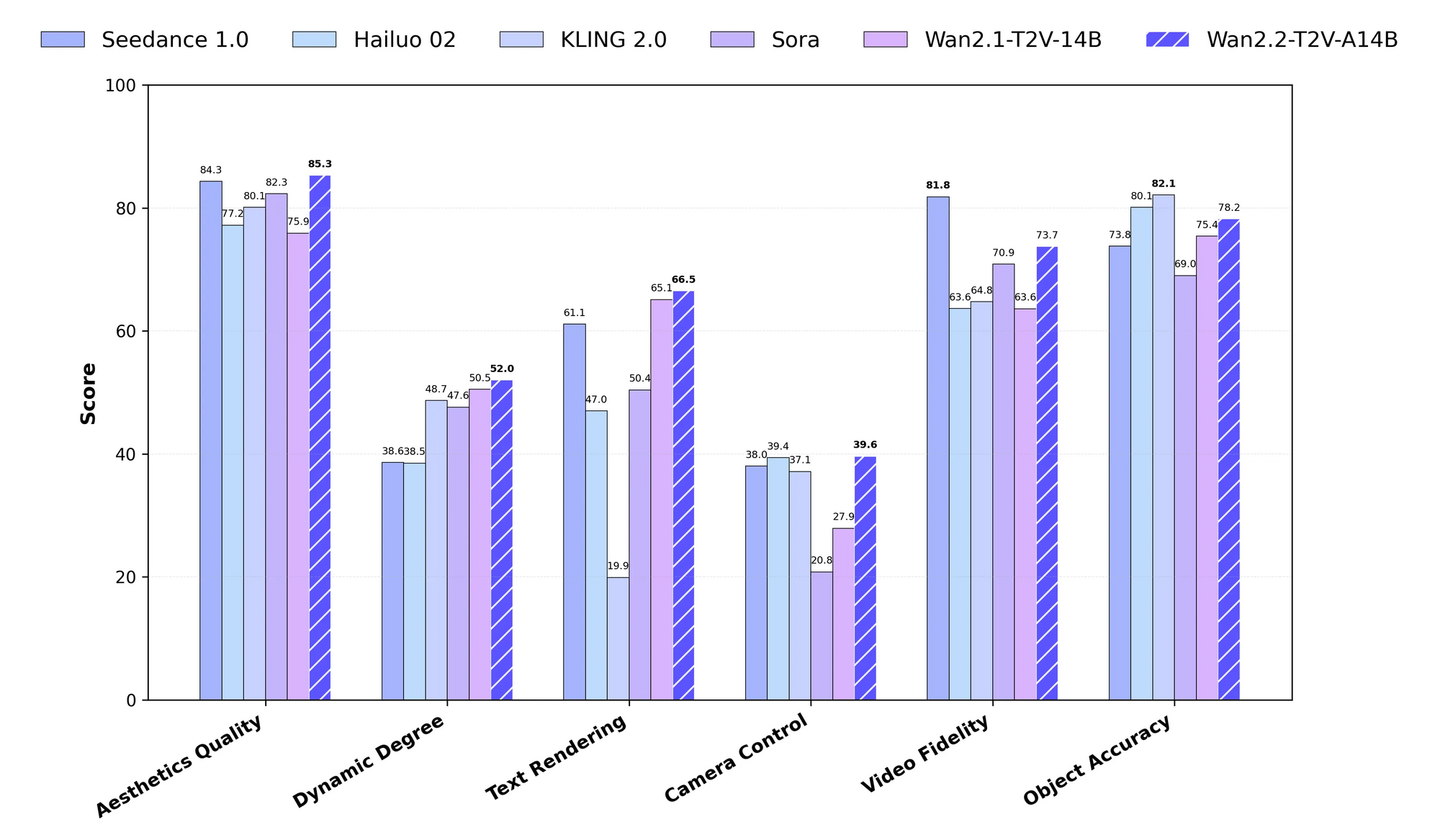

Wan 2.2は、Wanチームが開発した高度なオープンソース大規模ビデオ生成モデルです。エンジニアは、テキストからビデオ(T2V)、画像からビデオ(I2V)、音声からビデオ(S2V)生成などの複雑なタスクを処理できるように設計しました。このモデルは、拡散モデルにおけるノイズ除去プロセスを専門のエキスパート間で分割するMixture-of-Experts(MoE)フレームワークを採用しています。例えば、高ノイズのエキスパートは初期のタイムステップを管理し、低ノイズのエキスパートは後期の段階を洗練します。このアプローチにより、合計270億のパラメータを持ちながら、推論ステップごとにアクティブなのはわずか140億であり、効率性を確保しています。

さらに、Wan 2.2は、ライティング、構図、色調を強調する厳選されたデータセットを通じて、映画的な美学を取り入れています。トレーニングデータは以前のバージョンから大幅に拡張され、画像が65.6%増、ビデオが83.2%増となり、動きの複雑さと意味理解が向上しています。RTX 4090のような消費者向けハードウェアで24 FPSで720Pビデオを生成する5BパラメータのTI2Vモデルのようなバリアントにアクセスできます。

API側面は主に公式リポジトリのgenerate.pyのようなスクリプトを通じて現れますが、ホストされたプラットフォームはそれをWebベースのエンドポイントに拡張します。したがって、Wan 2.2 API(LoRAを使用)で作業する際には、完全な制御のためのローカル実行と、スケーラビリティのためのクラウドサービスを選択できます。

Wan 2.2におけるLoRAとは?

LoRA(Low-Rank Adaptation)は、Wan 2.2のような大規模モデル向けのパラメータ効率の良いファインチューニング手法として機能します。開発者はLoRAを適用して、アーキテクチャ全体を再トレーニングすることなく、ベースモデルを特定のデータセットに適応させます。Wan 2.2では、LoRAはトランスフォーマーの重みをターゲットとし、カスタムのスタイル、キャラクター、または動きをビデオ生成に注入することを可能にします。

例えば、I2Vバリアントを回転するカメラの動きの作成に特化させるために、軌道ショットのデータセットでLoRAをトレーニングします。公式ドキュメントでは、アニメーションのような特定のタスクにWan 2.2でトレーニングされたLoRAを使用することには、潜在的な不安定性があるため注意を促していますが、コミュニティツールがこれを克服しています。fal.aiのようなプラットフォームは、LoRAをAPIに直接統合しており、LoRAの重みとスケーリングファクターへのパスを指定できます。

その結果、Wan 2.2 API(LoRAを使用)にLoRAを組み込むことで、トレーニングコストが削減され、迅速なカスタマイズが可能になります。推論時にLoRAアダプターをマージすることで、ベースモデルの効率を維持しつつ、ターゲットとする出力を実現します。

LoRAを伴うWan 2.2 APIを使用する理由

ビデオAIアプリケーションにおいて、パワーと柔軟性のバランスを取るために、Wan 2.2 API(LoRAを使用)を選択します。従来のファインチューニングは莫大なリソースを必要としますが、LoRAは低ランク行列のみを更新することでこれを最小限に抑えます。この方法はメモリ使用量とトレーニング時間を削減し、個人の開発者でも利用しやすくします。

さらに、Wan 2.2のMoE構造は、エキスパート固有の適応を可能にすることでLoRAを補完します。バニラモデルでは生成が困難な、強化された美学や動きを持つビデオを生成できます。例えば、コンテンツ作成では、LoRAを使用してシーン全体で一貫したキャラクターのスタイルを維持します。

ホストされたAPIは、計算をクラウドにオフロードすることでこれらの利点を増幅させます。fal.aiのようなサービスが重い処理を引き受けるため、プロンプトとパラメータに集中できます。したがって、この組み合わせは、特にApidogのようなツールを統合してシームレスなAPI管理を行う場合に、プロトタイプ作成、本番環境、実験に適しています。

Wan 2.2 APIをローカルで使用するための環境設定方法

まず、GitHubからWan 2.2リポジトリをクローンします。ターミナルでgit clone https://github.com/Wan-Video/Wan2.2.gitコマンドを実行し、その後cd Wan2.2でディレクトリに移動します。次に、pip install -r requirements.txtを使用して依存関係をインストールします。S2Vタスクの場合は、pip install -r requirements_s2v.txtを追加します。

システムがPyTorchバージョン2.4.0以降で動作していることを確認してください。また、モデルのダウンロードのためにpip install "huggingface_hub[cli]"でHugging Face CLIをインストールします。プロンプト拡張を使用する場合は、Dashscope統合のためにexport DASH_API_KEY=your_keyのように環境変数を設定します。

マルチGPUセットアップの場合は、Fully Sharded Data Parallel (FSDP) とDeepSpeed Ulyssesを設定します。これらは--dit_fsdpや--ulysses_size 8のようなフラグで有効にします。シングルGPUユーザーは、--offload_modelと--convert_model_dtypeを通じてメモリ最適化をアクティブにします。このセットアップにより、ローカルのWan 2.2 API(LoRAを使用)の中核であるgenerate.pyスクリプトを実行する準備が整います。

Wan 2.2モデルのダウンロードとインストール方法

Hugging FaceまたはModelScopeからモデルをダウンロードします。T2V-A14Bバリアントの場合、huggingface-cli download Wan-AI/Wan2.2-T2V-A14B --local-dir ./Wan2.2-T2V-A14Bを使用します。I2V-A14BやTI2V-5Bのような他のバリアントについても同様に繰り返します。

チェックポイントを適切なディレクトリに配置します。14BモデルはかなりのVRAM(マルチGPU推論で約80GB)を必要としますが、5B TI2Vは24GBのカードに収まります。ダウンロード後、ファイルの破損を避けるために検証してください。

問題が発生した場合は、アクセス制限のある地域向けにModelScopeミラーに切り替えてください。この手順により、Wan 2.2 API(LoRAを使用)でLoRAアダプターを適用する前に、ベースモデルが準備されていることを確認できます。

Wan 2.2でgenerate.pyスクリプトを基本的なタスクに使用する方法

generate.pyスクリプトを呼び出して生成を実行します。シングルGPUでのシンプルなT2Vタスクの場合、python generate.py --task t2v-A14B --size 1280x720 --ckpt_dir ./Wan2.2-T2V-A14B --offload_model True --convert_model_dtype --prompt "Two anthropomorphic cats in comfy boxing gear fight intensely on a spotlighted stage."を実行します。

他のモードのパラメータを調整します。I2Vでは、--image examples/i2v_input.JPGを追加します。S2Vでは、--audio examples/audio_input.wavを含め、--enable_ttsでTTSを有効にします。マルチGPU実行では、FSDPフラグとともにtorchrun --nproc_per_node=8 generate.pyを使用します。

これらのコマンドは、ローカルのWan 2.2 API(LoRAを使用)の基盤を形成します。プロンプトやサイズを試して出力を洗練し、高度なカスタマイズのためにLoRA統合へスムーズに移行します。

Wan 2.2用のLoRAをトレーニングする方法

AI ToolkitやTrooper.AIトレーナーのようなコミュニティツールを使用してLoRAをトレーニングします。まず、ターゲットスタイルに合わせたビデオや画像を厳選してデータセットを準備します。I2V LoRAの場合、軌道ショットのような動きに特化したクリップに焦点を当てます。

GPUアクセス用にRunPodのようなプラットフォームでトレーナー環境をセットアップします。Wan 2.2のベースウェイトを所定のディレクトリにロードします。ハイパーパラメータを設定します。学習率を1e-5、バッチサイズを1、エポック数をデータセットサイズに応じて10~20に設定します。

損失メトリクスを監視しながらトレーニングスクリプトを実行します。Hugging FaceのPEFTライブラリのようなツールがこれを容易にし、LoRAを.safetensorsファイルとして保存できます。トレーニングが完了したら、このアダプターを生成に適用し、Wan 2.2 API(LoRAを使用)を特殊なタスク向けに強化します。

ローカルWan 2.2生成でLoRAを適用する方法

ComfyUIまたはカスタムスクリプトを介してローカルセットアップにLoRAを統合します。ComfyUIでは、モデルローダーとサンプラーの間にLoadLoRAModelOnlyノードを使用します。LoRAのパスと強度(例: 0.8)を指定します。

generate.pyの場合、公式バージョンには直接統合されていないため、コミュニティフォークまたは拡張機能がLoRAサポートを追加します。あるいは、アニメーションモードにはDiffusersパイプラインを使用し、pipe.load_lora_weights("path/to/lora")でLoRAをロードします。

このアプリケーションは、標準出力をカスタマイズされたビデオに変換します。これにより、スタイルや動きの一貫性を実現し、Wan 2.2 API(LoRAを使用)を本番環境での使用においてより多用途にします。

LoRAを伴うWan 2.2 APIに最適なホスト型サービスとは?

fal.aiのようなプラットフォームを通じて、ホストされたWan 2.2 API(LoRAを使用)にアクセスできます。https://api.fal.ai/v1/fal-ai/wan/v2.2-a14b/text-to-video/loraのエンドポイントは、LoRAをネイティブにサポートしています。APIキーを登録し、クライアントで設定してください。

その他のサービスには、I2V LoRA向けのWaveSpeed.aiやトレーニング向けのTrooper.AIがあります。これらはローカルハードウェアの必要性を排除し、高解像度へのスケーリングを容易にします。結果として、Apidogのようなツールと統合してリクエスト管理を行うことで、より迅速なプロトタイプ作成が可能になります。

fal.ai Wan 2.2 APIの認証とリクエスト送信方法

FAL_KEY環境変数を設定して認証します。JavaScriptの場合はnpm install --save @fal-ai/clientでfal-aiクライアントをインストールするか、Pythonの同等のものを使用します。

promptとloras配列を含むJSONペイロードでPOSTリクエストを送信します。例: {"prompt": "A cyberpunk cityscape at night", "loras": [{"path": "https://example.com/loras/cyberpunk.safetensors", "scale": 0.8}]}。

ビデオURLの応答を監視します。このプロセスは、クラウド環境でWan 2.2 API(LoRAを使用)を活用し、信頼性の高いパフォーマンスを保証します。

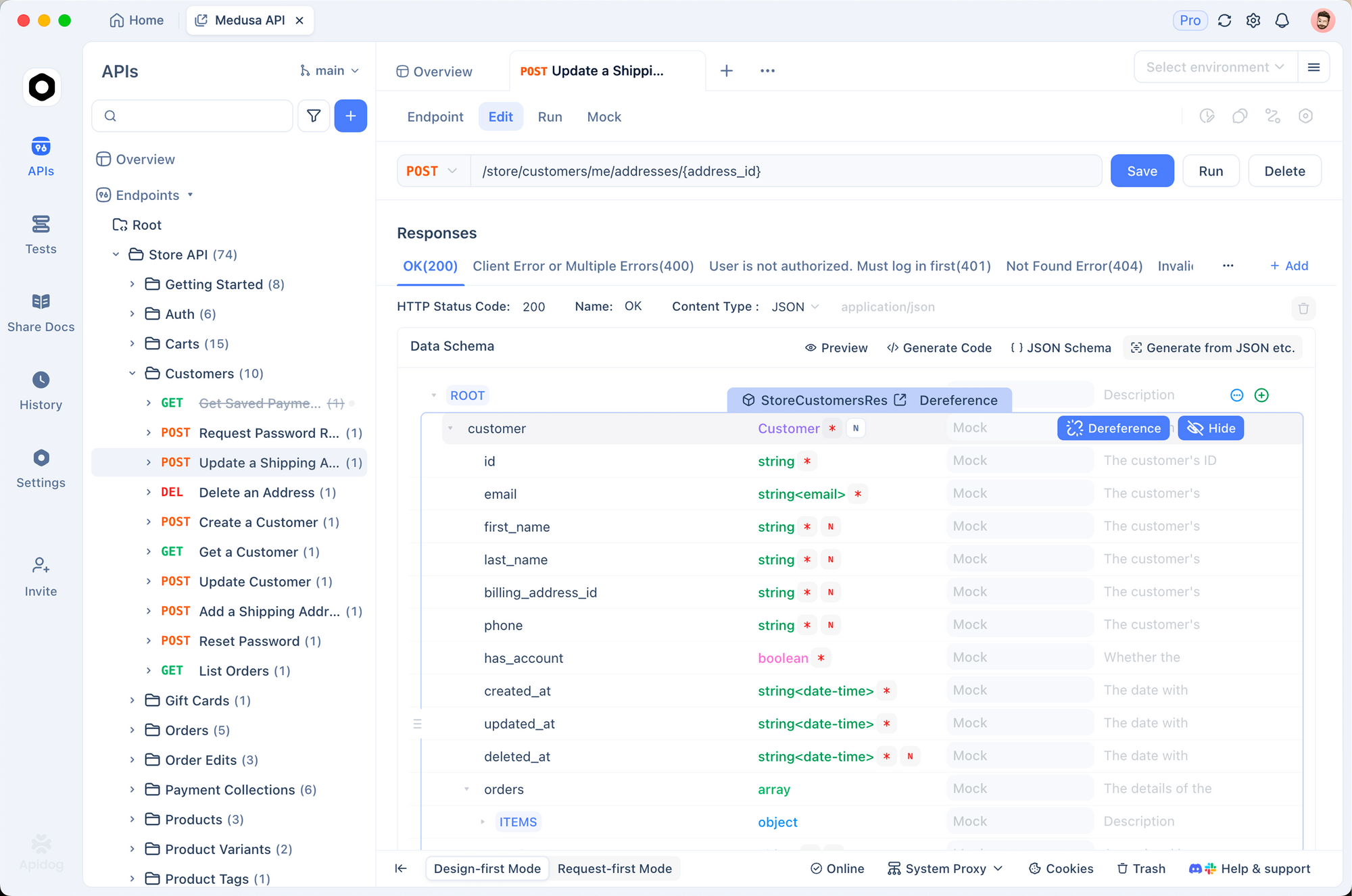

Apidogを使用してLoRAを伴うWan 2.2 APIをテストする方法

まずApidogをインストールし、新しいAPIプロジェクトを作成します。fal.aiのエンドポイント詳細をインポートし、メソッドをPOST、URLをテキストからビデオへのLoRAパスに設定します。

Authorization: Key your_fal_keyのような認証用のヘッダーを追加します。ボディタブで、プロンプトとLoRAパラメータを含むJSONを構築します。リクエストを送信し、生成されたビデオリンクを含む応答を検査します。

環境変数や応答検証といったApidogの機能は、デバッグを効率化します。例えば、一般的なLoRA設定をコレクションとして保存できます。このように、ApidogはWan 2.2 API(LoRAを使用)のテスト時のワークフローを強化し、迅速なイテレーションを可能にします。

LoRAを伴うWan 2.2 APIで調整すべきパラメータは?

出力を最適化するために主要なパラメータを調整します。バランスのためにnum_inference_stepsを27に設定するか、品質を向上させるために高く設定します。3.5のようなガイダンススケールは、プロンプトへの適合性に影響を与えます。

LoRAの場合、アダプターの強度を制御するためにscaleを0.5〜1.0の間で調整します。解像度オプションには720pが含まれ、FPSは4〜60の範囲です。高速な生成のためにアクセラレーションを有効にしますが、忠実度が低下する可能性があります。

さらに、不要な要素を避けるためにネガティブプロンプトを使用します。これらのチューニングは、Wan 2.2 API(LoRAを使用)を洗練し、特定のプロジェクトのニーズに適応させます。

LoRAを伴うWan 2.2でマルチモーダル入力を処理する方法

ローカルスクリプトで--imageまたは--audioを指定するか、ホストされたAPIで同等のフィールドを使用して画像またはオーディオを組み込みます。LoRAを適用してこれらを強化し、I2V出力のスタイル設定などを行います。

fal.aiでは、TI2Vモード用にimage_urlを追加します。LoRAは融合に適応し、一貫性のあるビデオを保証します。したがって、アニメーションキャラクターのような動的なコンテンツを作成し、Wan 2.2 API(LoRAを使用)の可能性を最大限に活用できます。

Wan 2.2推論のための高度な最適化テクニックとは?

限られたハードウェアで実行するために、モデルのオフロードやdtype変換のようなメモリ最適化を採用します。マルチGPUの場合、FSDPがシャードを効率的に分散します。

ホストされたセットアップでは、バッチを処理するために非同期リクエストをキューに入れます。LLMによるプロンプト拡張を使用して入力を豊かにします。これらのテクニックはWan 2.2 API(LoRAを使用)を高速化し、リアルタイムアプリケーションに適したものにします。

LoRAを伴うWan 2.2 APIをアプリケーションに統合する方法

バックエンドサービスでAPI呼び出しをラップすることでアプリケーションを構築します。例えば、fal.aiリクエストをプロキシし、ユーザー入力に基づいてLoRAを追加するNode.jsサーバーを作成します。

時間のかかるジョブのWebhooksを処理し、完了時にユーザーに通知します。インタラクティブなビデオ生成のためにフロントエンドと統合します。この統合により、Wan 2.2 API(LoRAを使用)はコンテンツプラットフォームのようなツールに組み込まれます。

LoRAを伴うWan 2.2の活用事例とは?

サイバーパンクシーンの生成を考えてみましょう。「ネオン輝く道路と空飛ぶ車」というプロンプトと、ディストピアアートでトレーニングされたLoRAを使用します。出力は、詳細が強化された様式化されたビデオを生成します。

別の例として、S2V向けにダンスモーションでLoRAをトレーニングし、オーディオを振り付けに同期させます。これらのケースは、Wan 2.2 API(LoRAを使用)の実用的な使用法を示しています。

Wan 2.2 APIとLoRAの一般的な問題のトラブルシューティング方法

メモリ不足エラーは、オフロードフラグを有効にするか、解像度を下げることで対処します。LoRAが不安定性の原因となる場合、スケールを低くするか、安定したデータセットで再トレーニングします。

APIの障害については、Apidogで認証とパラメータの有効性を確認します。ネットワークの問題にはリトライロジックが必要です。これにより、問題を効率的に解決し、Wan 2.2 API(LoRAを使用)でスムーズな運用を維持できます。

LoRAを伴うWan 2.2に影響を与える可能性のある将来の発展とは?

研究者たちは拡散モデルの進化を続けており、より効率的なLoRAバリアントが統合される可能性があります。コミュニティの貢献により、公式スクリプトにネイティブなLoRAサポートが追加されるかもしれません。

ホストされたサービスは、モダリティを拡張する可能性があります。最新情報を把握しておくことで、Wan 2.2 API(LoRAを使用)の進化を活用できます。

結論

これで、Wan 2.2 API(LoRAを使用)へのアクセスと使用について深く理解できたことでしょう。ローカルセットアップからホストされたAPIまで、そしてApidogのようなツールを使って、印象的なビデオを生成できます。これらの技術を応用して、AI駆動型コンテンツ作成で革新を起こしましょう。