米国時間5月13日に、新しいChatGPTモデルのGPT-4oを発表しました。以前のモデルより、GPT-4oは反応時間が倍増し、テキスト、画像、音声、ビデオをも理解できるようになりました。本文では、OpenAIの最新モデルのGPT-4oの基本情報を完全に解説した上、GPT-4o APIを利用して、それを自分のサービスにも連携する方法を紹介していこうと思います。

また、完全に無料なツールなので、下記のボタンから無料でApidogを利用し始めましょう👇👇👇

GPT-4oとは?

GPT-4oとは、米国時間5月13日にOpenAI社がによって発表された最新のAIモデルになります。4oのoはomniの略で、「すべてを包括」という意味合いがあり、これまでのテキストと画像か、音声でChatGPTとやりとりする利用方式とは違い、テキスト、音声、画像やビデオを組み合わせて、GPT-4oとやりとりすることができるようになりました。

詳しくは公式サイトへ:https://openai.com/index/hello-gpt-4o/

GPT-4oの特徴

それでは、OpenAIの最新モデルであるGPT-4oはこれまでのモデルに比べて、どのような特徴がありますか?

反応時間が2倍速くに

OpenAIによると、GPT-4が人との対話を実現するには、3つのステップを経る必要があると述べています。

- 音声を文字に変換する

- 応答のテキストを生成する

- テキストを音声に変換する

これまでのモデルにおいて、このプロセスの平均遅延は、GPT-3.5で2.8秒、GPT-4で5.4秒と長くなりますが、現在のGPT-4oは、最短で232ミリ秒で応答でき、平均応答時間は320ミリ秒で、ほぼ人間と同じ反応速度でやり取りをすることができるようになります。つまり、最新のGPT-4oモデルを利用することで、ほぼリアルタイムにAIとのやり取りを実現できるのではないのでしょうか。

音声トークンも理解可能

これまでのGPTモデルは、話し手の言葉のトーンを認識できず、背景音も取り込めませんので、会話でのいろんな情報が失うことがあります。しかし、GPT-4oの登場に伴い、話し手の音声トークン、つまり感情をきちんと理解できるようになったため、より人間みたいになるのでしょう。

日本語での利用でトークンが減少

また、GPT-4oは、日本語を含む20種類の言語が使うトークン数を圧縮しました。つまり、これから日本語でChatGPTとやりとりする際、利用するトークンが少なくなります。

- 「こんにちわ、私の名前はGPT−4oです。私は新しいタイプの言語モデルです、初めまして」

上記のやりとりで利用するトークン数が37個から24個に減少することで、1.4倍も減少されたという。

GPT-4o発表会で他の重要情報も

上記のGPT-4oモデル自身の特徴のほかに、GPT-4o発表会で次のような情報も注目されています。

ほぼ全てのサービスが無料に

また、以前有料プランでしか利用できないGPTs、GPT Store、GPT-4などのサービスは、GPT-4oの発表に伴い、無料で開放するという予告もありました。

デスクトップアプリを提供

また、これまでにChatGPTをネットでしか利用できないのですが、GPT-4oモデルの発表会では、新しいmacOS用ChatGPTデスクトップアプリが発表されました。Windows用のアプリも今年後半期で発表される予定があります。

発表会の録画でGPT-4oを知る

OpenAIの最新モデルであるGPT-4oをより詳しく知りたい場合、次の紹介ビデオをご覧ください:

そもそもGPT-4o APIは利用可能?

Webアプリなどを開発する際、APIを利用してAI機能を自分のサービスにも統合するのが非常に便利ですね。GPT-4oモデルの発表に伴い、GPT-4oモデルの素晴らしい能力をも自分のサービスに導入するために、GPT-4o APIを利用する必要がありますね。それでは、GPT-4o APIが利用することができるのでしょうか?その料金はどれくらいですか?次は、これらの問題について詳しく解説していこうと思います。

GPT-4o APIは利用可能?

OpenAI側の最新情報により、GPT-4oモデルのAPIは、すでにChat Completions API、Assistants API、およびBatch APIテキストと視覚モデルとして利用可能です。

GPT-4o APIはどこが良い?

従来のChatGPTモデルのAPIに比べて、GPT-4o APIは次のようなところでより良いと考えられています。

- 高い知能:テキスト、推論、コーディング能力においてGPT-4 Turboレベルのパフォーマンスを提供し、多言語、音声、視覚の能力でも新たな高水準を設定しています。

- 2倍の反応速度:GPT-4 Turboに比べ、トークン生成速度が2倍になりました。

- 50%安い価格:入力トークンと出力トークンの両方において、GPT-4 Turboより50%安価です。

- 5倍高いレート制限:GPT-4 Turboに比べてレート制限が5倍になり、最大毎分1000万トークンまで可能です。

- 視覚能力が改善:ほとんどのタスクにおいて視覚能力が向上しました。

- 非英語言語の能力が改善:非英語言語の処理能力が向上し、非英語テキストをより効率的にトークン化する新しいトークナイザーを使用しています。

GPT-4o APIの料金プラン

それでは、この最新モデルであるGPT-4o APIの利用料金はどれくらいですか?OpenAI APIの公式サイトによりますと、GPT-4oはGPT-4 Turboよりも高速で低コストながら、より強力なビジョン機能を備えています。このモデルは128Kのコンテキストを持ち、2023年10月時点の知識をカバーしているとされています。また、GPT-4 Turboより50%安くなっていて、具体的な料金プランは次:

OpenAI APIの料金ページによると、GPT-4oのテキスト入出力は100万トークンあたり$5と$15です。また、ビジョン処理の料金は画像の幅と高さに応じて計算されます。この例では、150px x 150pxの画像の処理料金は$0.001275と表示されています。ユーザーは低解像度オプションを選ぶこともできます。

ということで、インプットでもアウトプットでも画像生成でも、GPT-4o APIの利用料金は、GPT-4 Turboの半分になっています。

GPT-4o API利用時の注意事項

また、GPT-4o APIを利用したり、他のモデルからGPT-4o APIへの切り替えようとしたりする際、次のようなポイントに注意を払う必要があります:

- GPT-4o APIは覚機能を通じて音声なしのビデオを理解することができます。具体的には、ビデオをフレームに変換する必要があります(1秒あたり2〜4フレーム、一様にサンプリングするか、またはキーフレーム選択アルゴリズムを使用)。そしてそれらのフレームをモデルに入力します。

- 2024年5月14日現在のAPIのGPT-4oには、音声をサポートする機能はまだありません。しかし、OpenAIは今後数週間のうちに、信頼できるテスター向けに音声モダリティを提供することを期待しているとのことです。

- 2024年5月14日現在、GPT-4o APIはしばらく画像生成をサポートしていませんので、画像生成が必要となる場合は、DALL-E 3 APIを利用することがおすすめです。

- OpenAI側は、OpenAIは、GPT-4またはGPT-4 Turboを使用しているすべてのユーザーに、GPT-4oへの切り替えを検討するよう推奨しています。GPT-4o APIは必ずしもGPT-4やGPT-4 Turboより高性能な訳でもないと思い、GPT-4やGPT-4 Turboとの出力を比較しながら、実際にGPT-4oを試すことで、モデルの能力を確認した上、GPT-4oへの切り替えを検討した方が良いのでしょう。

ApidogでGPT-4o APIを利用して便利に管理

GPT-4o APIを利用する場合、APIのテストや管理などの作業が非常に不可欠になるのでしょう?

Apidogという便利なAPI管理ツールを使うことで、どのようなAPIでもより便利で効率的に扱うことができます。GPT-4o APIがすでに利用可能になっていますので、ApidogのAPI Hubにアクセスして、OpenAI APIプロジェクトに簡単にアクセスすることができます。そして、ユーザーはApidogを利用して直ちにGPT-4o APIプロジェクトを自分のプロジェクトにクローンしたり、GPT-4o APIを利用・テストしたり、便利に管理したりすることができます。

GPT-4o APIを利用するためにOpenAI APIキーを取得

GPT-4o APIの利用を始めるために、まずはOpenAI APIトークンを取得する必要があります。それでは、次のチュートリアルを参照しながら、OpenAIのAPIキーを取得しましょう。

⒈OpenAIアカウントに登録

GPT-4o APIの利用を開始するために、まずはOpenAIのアカウントを開設する必要があります。OpenAIの公式サイトにアクセスして、右上隅にある**「Get Started」**ボタンをクリックして、アカウントを開設する事ができます。

⒉OpenAI APIキーの取得

OpenAIのアカウントを開設すると、GPT-4o APIの利用要件の1つとされている認証用のAPIキーを取得する必要があります。次のステップを参照して、ChatGPT APIのAPIキーを取得できます。

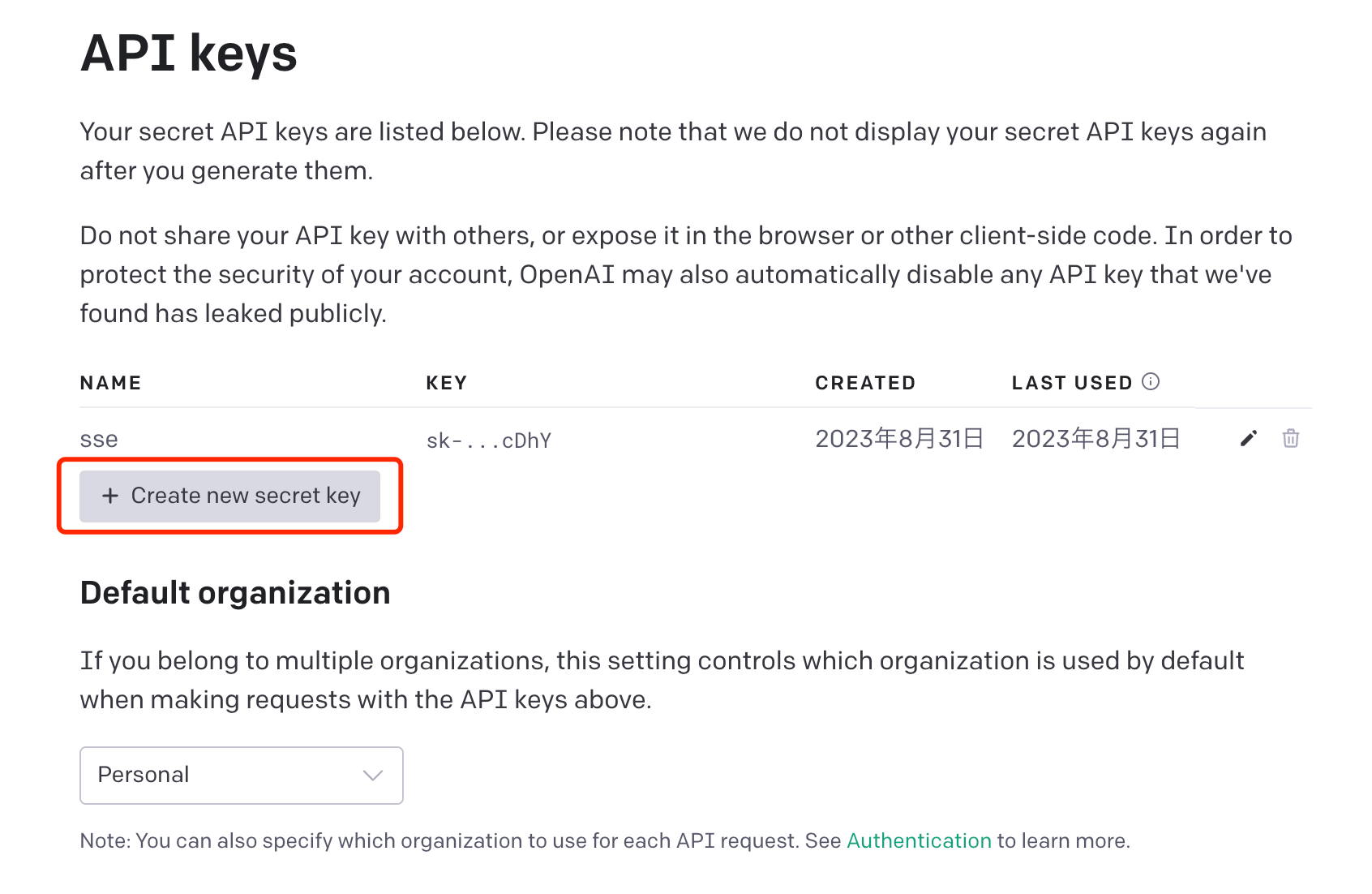

ステップ⒈OpenAIのAPI Keysページにアクセスして、自分のアカウントでログインします。(アカウントが無ければ新規登録)

ステップ⒉「Create new secret key」ボタンをクリックして、新しいAPIキーを生成します。

APIキーを生成すると、APIキーはすぐ画面に表示されます。当該APIキーは再度と表示する事ができないので、APIキーを記録して別の保存に保管する事がお勧めです。

GPT-4o APIを便利にテスト・管理

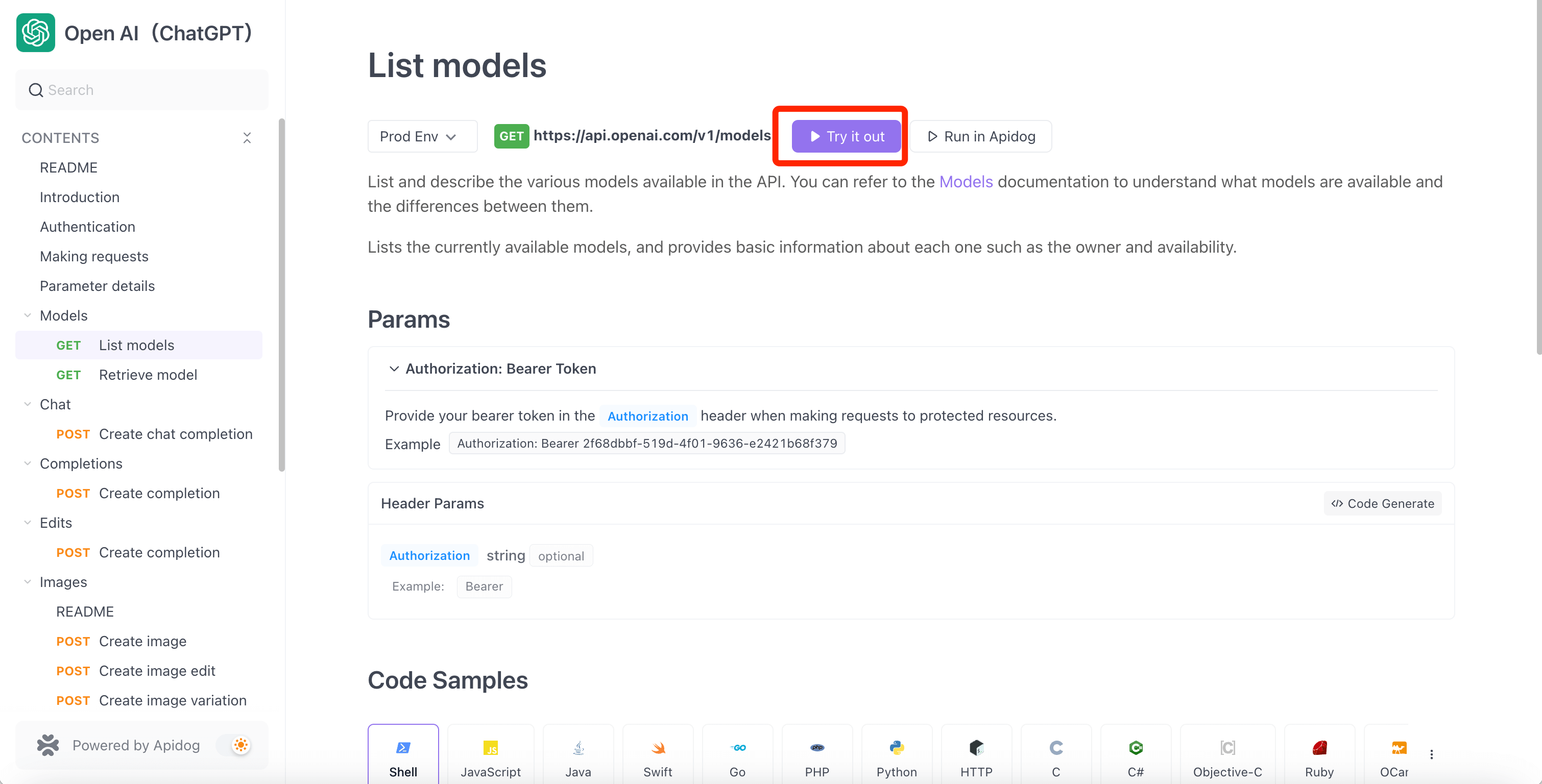

GPT-4o APIを利用するために、Apidogが非常に便利なツールだと思います。Apidogには、OpenAI APIプロジェクトがあります。このプロジェクトでは、OpenAIが提供する全てのAPIを網羅しています。そこで、OpenAIが提供している各APIを確認したい場合、次のページにアクセスしてください。

現在、Chat Completions API、Assistants API、およびBatch APIでしか利用できないので、OpenAI APIプロジェクトの左側メニューからそれぞれを選択して、GPT-4o APIの利用を始めましょう。

また、Apidogはサーバー送信イベント(SSE)をもサポートしていますので、GPT-4o APIのストリーミング化を実現するのも非常に簡単です!詳しくはこちら:

ApidogでGPT-4o APIを利用する詳細ガイド

ApidogのOpenAI APIプロジェクトにアクセスすると、次の操作手順を参照して、簡単にOpenAIのAPIをテストすることができます。それでは、Chat Completions APIからGPT-4oを利用する方法を解説します。

ステップ⒈ApidogのOpenAI APIプロジェクトにアクセスし、左側のメニューからChat Completions関連のエンドポイントを選択し、新しいリクエストの画面で、ChatGPTの仕様書に従って、HTTPメソッドとエンドポイントURLを入力した上、「Body」タブでChatGPTに送信したいメッセージをJSONフォーマットで記述します。

ご案内:GPT-4oを利用する場合、"model":"gpt-4o"を記述して、モデルを「GPT-4o」に指定します。

ステップ⒉「Header」タブに切り替え、ChatGPT APIの認証を通すために、Authorizationパラメータを追加して、取得したChatGPT APIのAPIキーを入力して、「送信」ボタンをクリックします。

ご案内:Apidogでは、OpenAIのAPIキーを環境変数として保存することもできます。OpenAIのAPIキーを環境変数として保存すると、後でAPIキーを再利用する場合でも環境変数を直接に参照することができるので、APIキーを何度も再入力する必要がなくなるので、便利です。

まとめ

この記事では、OpenAIの最新モデルであるGPT-4oについて詳しく解説しました。GPT-4oは以前のモデルよりも反応時間が2倍になり、テキスト、画像、音声、ビデオを理解できるようになりました。さらに、日本語での利用時のトークン数も減少し、コストパフォーマンスが向上しています。

GPT-4o APIは、Chat Completions API、Assistants API、Batch APIで利用可能になっており、従来のChatGPTモデルのAPIに比べて高い知能、2倍の反応速度、50%安い価格、5倍高いレート制限、改善された視覚能力と非英語言語の能力が特徴です。

GPT-4o APIを利用するには、まずOpenAIアカウントを作成し、APIキーを取得する必要があります。そして、Apidogを使えば、簡単にGPT-4o APIをテストし、管理することができます。Apidogには、OpenAI APIプロジェクトがあり、GPT-4o APIの仕様が網羅されています。APIキーを環境変数に保存すれば、再入力する手間も省けます。

今後、GPT-4o APIには音声のサポートも追加される予定です。GPT-4oの優れた機能を活用して、自分のサービスに組み込むことで、より優れたAI体験を提供できるでしょう。