現代のアプリケーションでは、テキストプロンプトから高品質な画像を生成するための効率的なツールが必要です。Z-Image APIはこの要求に直接応えます。開発者は、フォトリアルな結果を迅速に提供する無料のインターフェースを通じて、強力なテキストから画像へのモデルにアクセスできます。このAPIは、AlibabaのTongyi-MAIチームが開発したオープンソースのZ-Image-Turboモデルを活用しており、Apache 2.0ライセンスの下で運用されています。適切なハードウェアを使用すれば、1秒未満の推論が可能であり、ウェブアプリ、モバイルツール、または自動化されたワークフローにおけるリアルタイム機能に最適です。

次に、Z-Image-Turboのオープンソース基盤を探ります。その後、APIアクセス方法についての洞察を得て、その無料の料金体系を確認します。最後に、実用的な統合を実装します。これらのステップにより、画像生成機能を効果的に展開できるようになります。

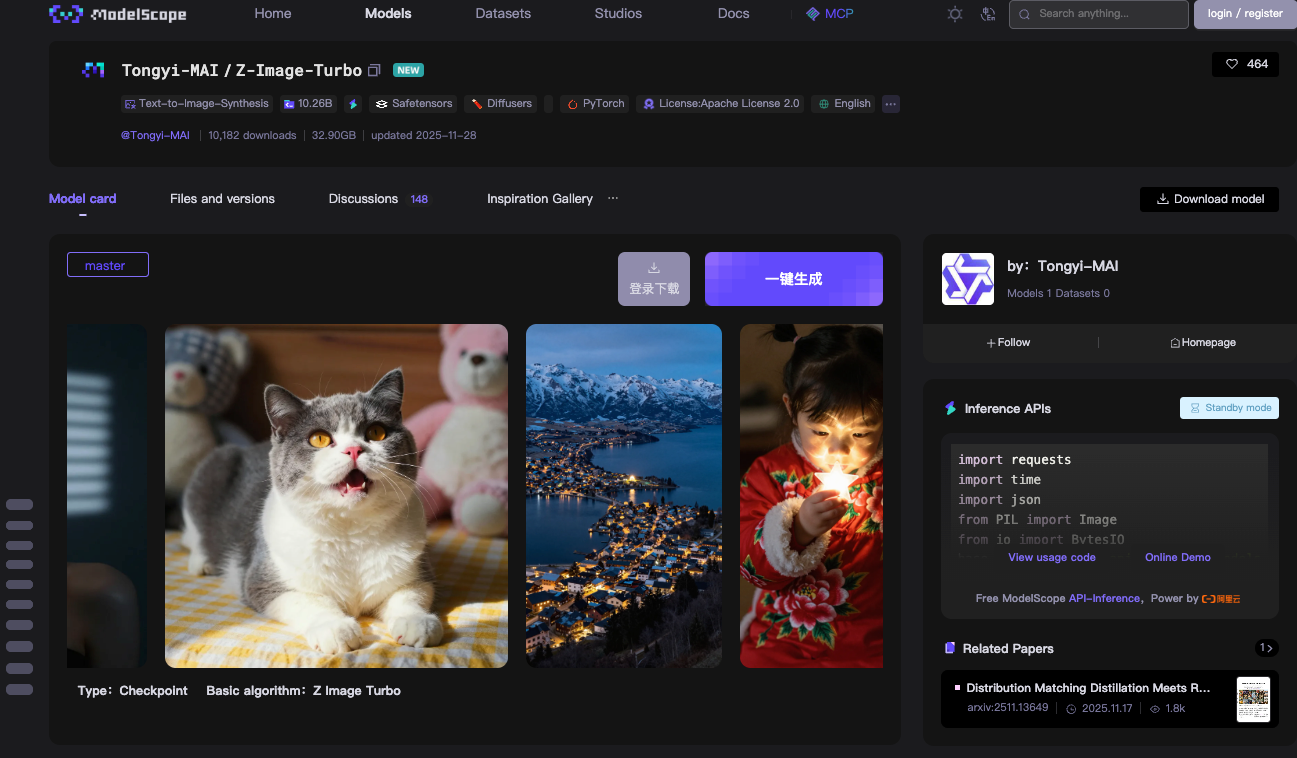

Z-Image-Turboオープンソースモデルの理解

Z-Image APIの背後にある中核技術、すなわちZ-Image-Turboモデルから始めましょう。AlibabaのTongyi-MAIチームは、この60億パラメータモデルをApache 2.0の下で完全にオープンソースとしてリリースしています。このライセンスは、商業利用、変更、配布を制限なく許可しており、これにより本番環境での採用が加速されます。

Z-Image-Turboは、スケーラブルな単一ストリーム拡散トランスフォーマー(S3-DiT)アーキテクチャに基づいて構築されています。従来のデュアルストリームモデルはテキストと画像処理を分離するため、パラメータが無駄になります。しかし、S3-DiTはテキストトークン、視覚的セマンティックトークン、および画像VAEトークンを1つの統合ストリームに連結します。この設計により効率が最大化されます。結果として、このモデルはNVIDIA RTX 40シリーズカードのようなコンシューマー向けGPUの16GB VRAM内に収まります。これにより、出力品質を犠牲にすることなくこれを実現します。

このモデルはフォトリアルな画像合成に優れています。詳細なシーン、ポートレート、風景を記述的なプロンプトから生成します。例えば、「夕暮れの静かな山湖、英語と中国語のバイリンガル標識付き」のようなプロンプトは、鮮明で文脈を理解したビジュアルを生成します。Z-Image-Turboは、統合されたプロンプトエンハンサーのおかげで、複雑な指示をうまく処理します。このコンポーネントは、より良い忠実度のために入力を洗練し、以前の拡散モデルによく見られたアーティファクトを減らします。

推論速度がZ-Image-Turboの強みです。実際には9回の推論ステップに相当する、わずか8回の関数評価(NFE)しか必要としません。エンタープライズH800 GPUでは、1画像あたり500ミリ秒未満という1秒以下のレイテンシを実現します。コンシューマー向け設定では、ハードウェアに応じて2〜5秒で処理されます。この効率性は、Decoupled-DMDやDMDRなどの蒸留技術に由来しており、基本となるZ-Imageモデルを性能を維持したまま圧縮しています。

モデルの重みはModelScopeまたはHugging Faceリポジトリからダウンロードできます。マスターブランチには、合計約24GBのチェックポイントファイルが含まれています。PyTorchとの互換性により、幅広い統合が保証されます。ローカルテストの場合、pip を介して torch、torchvision、および modelscope>=1.18.0 の依存関係をインストールします。基本的なパイプラインスクリプトは、10行未満のコードでモデルをロードし、画像を生成します。

ローカルでの推論の例を以下に示します。

from modelscope.pipelines import pipeline

from modelscope.utils.constant import Tasks

import torch

device = "cuda" if torch.cuda.is_available() else "cpu"

pipe = pipeline(Tasks.text_to_image_synthesis, model="Tongyi-MAI/Z-Image-Turbo", device=device)

output = pipe({

"text": "A photorealistic golden retriever playing in a sunlit park, 1024x1024",

"width": 1024,

"height": 1024,

"num_inference_steps": 9

})

output["output_imgs"][0].save("generated_image.png")

このコードは、パイプラインを初期化し、プロンプトを処理し、結果を保存します。num_inference_steps: 9 パラメータは、最適な速度のために8ステップの蒸留をトリガーすることに注目してください。Turboバリアントは速度を維持するためにclassifier-free guidanceをスキップするため、guidance scaleは0.0のままです。

ベンチマークはZ-Image-Turboの競争力を裏付けています。AlibabaのAIアリーナでは、Eloベースの人間による好感度評価で高得点を獲得し、フォトリアリズムとテキストの忠実度において多くのオープンソースモデルを凌駕します。Stable Diffusion 3のようなモデルと比較して、少ないステップと少ないメモリで、同等の詳細さを提供します。

ただし、制限も存在します。このモデルは極端な解像度よりも速度を優先するため、1536x1536を超える解像度ではファインチューニングなしではぼやけが生じる可能性があります。また、Turboバリアントにはネイティブな画像間編集機能がありません。これは今後リリースされるZ-Image-Editの役割です。それでも、テキストから画像へのタスクにおいては、Z-Image-Turboは堅実で利用しやすい基盤を提供します。

このモデルは、ModelScopeのインフラストラクチャでホストされているZ-Image APIを通じて拡張できます。ローカルからクラウドへの移行により、セットアップの負担が解消されます。結果として、ハードウェアの最適化ではなく、アプリケーションロジックに集中できます。

無料のZ-Image APIへのアクセス:ステップバイステップ設定

API統合へスムーズに移行しましょう。Z-Image APIは、リモート呼び出しのためにZ-Image-TurboをホストするModelScopeの推論サービスを通じて動作します。この設定は最小限の構成で済みますが、エンタープライズグレードの信頼性を提供します。

まず、ModelScopeプラットフォームに登録します。メールアドレスまたはGitHubの認証情報でアカウントを作成してください。ログイン後、プロフィール下のAPIセクションに移動します。ModelScopeトークンを生成してください。これはBearer認証キーとして機能します。すべてのリクエストでAuthorizationヘッダーに必要となるため、安全に保管してください。

APIエンドポイントは非同期処理を中心としており、高いスループットのニーズに適しています。生成タスクはPOSTで https://api-inference.modelscope.cn/v1/images/generations に送信します。レスポンスは即座に task_id を返します。その後、https://api-inference.modelscope.cn/v1/tasks/{task_id} を完了するまで5〜10秒ごとにポーリングします。この設計は、Z-Image-Turboの速度により待機時間が短く(通常はエンドツーエンドで5〜15秒)なるものの、長い生成におけるタイムアウトを防ぎます。

主要なヘッダーは以下の通りです。

Authorization: Bearer {your_token}Content-Type: application/jsonX-ModelScope-Async-Mode: true(送信用)X-ModelScope-Task-Type: image_generation(ステータス確認用)

リクエストボディでは、モデルID、プロンプト、寸法、ステップなどのパラメータを指定します。このバリアントをターゲットにするには、"model": "Tongyi-MAI/Z-Image-Turbo" を設定します。デフォルトの寸法は1024x1024ですが、カスタムのアスペクト比に合わせて height と width を調整できます。最良の結果を得るためには、guidance_scale: 0.0 と num_inference_steps: 9 を維持してください。

完全なcurlの例は、このプロセスを示しています。

# Step 1: Submit task

curl -X POST "https://api-inference.modelscope.cn/v1/images/generations" \

-H "Authorization: Bearer YOUR_TOKEN" \

-H "Content-Type: application/json" \

-H "X-ModelScope-Async-Mode: true" \

-d '{

"model": "Tongyi-MAI/Z-Image-Turbo",

"prompt": "A futuristic cityscape at night with neon signs in Chinese and English",

"height": 1024,

"width": 1024,

"num_inference_steps": 9,

"guidance_scale": 0.0

}'

# Extract task_id from response, e.g., {"task_id": "abc123"}

# Step 2: Poll status

curl -X GET "https://api-inference.modelscope.cn/v1/tasks/abc123" \

-H "Authorization: Bearer YOUR_TOKEN" \

-H "X-ModelScope-Task-Type: image_generation"

成功すると、ステータスレスポンスには "task_status": "SUCCEED" と、ダウンロード可能なURLを含む output_images 配列が含まれます。GETで画像をフェッチし、PNGまたはJPEGとして保存します。

同期的な代替手段として、ModelScopeはmodelscope.cn/aigc/imageGenerationでオンラインデモを提供しています。Z-Image-Turboをデフォルトモデルとして選択してください。クイックモードはパラメータなしで画像を生成し、アドバンストモードはすべての制御を公開します。このインターフェースはプロトタイピングに役立ちますが、自動化にはAPIが適しています。

エラー処理は不可欠です。一般的なコードには、401(無効なトークン)、429(レート制限)、500(サーバーの問題)などがあります。本番コードでは、指数関数的バックオフによるリトライを実装してください。無料ティアのレート制限は1分あたり10〜20リクエスト程度ですが、正確なクォータはアカウントによって異なります。

このAPIはさまざまな環境に統合できます。Python開発者は、先に示したようにHTTP呼び出しに requests を使用します。Node.jsユーザーは、プロミスベースのポーリングに axios を活用します。AWS LambdaやVercelのサーバーレス関数でも、軽量なペイロードのため簡単にデプロイできます。

Apidogはこのアクセスフェーズを強化します。API仕様をApidogにインポートすると、ドキュメントとテストケースが自動生成されます。レスポンスをシミュレートしたり、ポーリングのためのリクエストを連鎖させたり、チーム共有のためにコレクションをエクスポートしたりできます。このプラットフォームはデバッグ時間を短縮し、プロンプトエンジニアリングに集中できるようにします。

これらのステップを通じて、Z-Image APIへの信頼性の高い接続を確立できます。次に、その価格設定を調べて、費用対効果を確認しましょう。

Z-Image APIの料金とクォータ

次に、その手頃な価格を確認しましょう。Z-Image APIは推論に料金を発生させません。ModelScopeは、公式X投稿で発表されたように、Z-Image-Turbo呼び出しに対して無制限の無料計算を提供します。このゼロコストモデルには、ホスティング、帯域幅、GPUリソースが含まれており、AIサービスの中では珍しいことです。

ただし、悪用を防ぐためにクォータが適用されます。無料アカウントにはソフトリミットがあり、1時間あたり約50〜100回の生成で、定期的にリセットされます。ModelScopeダッシュボードから使用状況を監視できます。制限を超えると一時的なスロットリングが発生しますが、必要に応じてより多くのボリュームのためにプロティアにアップグレードできます。プロプランは低料金から始まりますが、ほとんどの開発者やホビイストには無料ティアで十分です。

Z-Image APIのパフォーマンスを最適化するためのベストプラクティス

ターゲットを絞った戦略で利用方法を改善します。まず、最適なパラメータを選択します。バランスのために1024x1024に固定し、必要であれば生成後にアップスケールします。ステップは9に制限してください。これ以上値を上げると、恩恵なしに推論が遅くなります。

ハードウェアアクセラレーションはローカルハイブリッドを強化します。DiffusersでFlash Attentionを有効にします: pipe.transformer.set_attention_backend("flash")。これにより、Ampere GPUでメモリが20〜30%削減されます。

プロンプトエンジニアリングは品質を向上させます。入力を「被写体 + 行動 + 環境 + スタイル」として構成します。Apidogのモックモードでバリエーションをテストし、迅速に反復処理します。

セキュリティ対策は統合を保護します。クライアントサイドコードでトークンを公開しないでください。サーバープロキシを使用します。入力の検証を行い、インジェクション攻撃を防ぎます。

監視ツールはメトリクスを追跡します。生成時間、成功率、トークン使用量をログに記録します。Prometheusのようなツールは、ダッシュボード用に簡単に統合できます。

結論

これでZ-Image APIを完全に使いこなせます。Z-Image-Turboのオープンソースアーキテクチャを理解することから、API呼び出しの実行、ワークフローの最適化まで、このガイドは成功のためにあなたを武装させます。無料の料金モデルは高度な画像生成を民主化し、Apidogのようなツールは開発を効率化します。

これらの技術を次のプロジェクトで実装してください。プロンプトを試行し、統合を拡張し、エコシステムに貢献してください。AIが進化するにつれて、Z-Image-Turboは効率的で創造的なツールの最前線にあなたを位置付けます。