データは現代のビジネス意思決定を推進しますが、それはデータが正確、完全、かつタイムリーである場合に限られます。ELTテストは、データレイク、データウェアハウス、または分析プラットフォームへのパイプラインを流れるデータが、指定された標準を満たしていることを保証します。ELT(Extract, Load, Transform)は、最新のデータ統合において支配的なパターンとなっていますが、多くのチームがその効果的なテストに苦労しています。このガイドでは、ELTパイプラインをすべての段階で検証するための実践的なフレームワークを提供します。

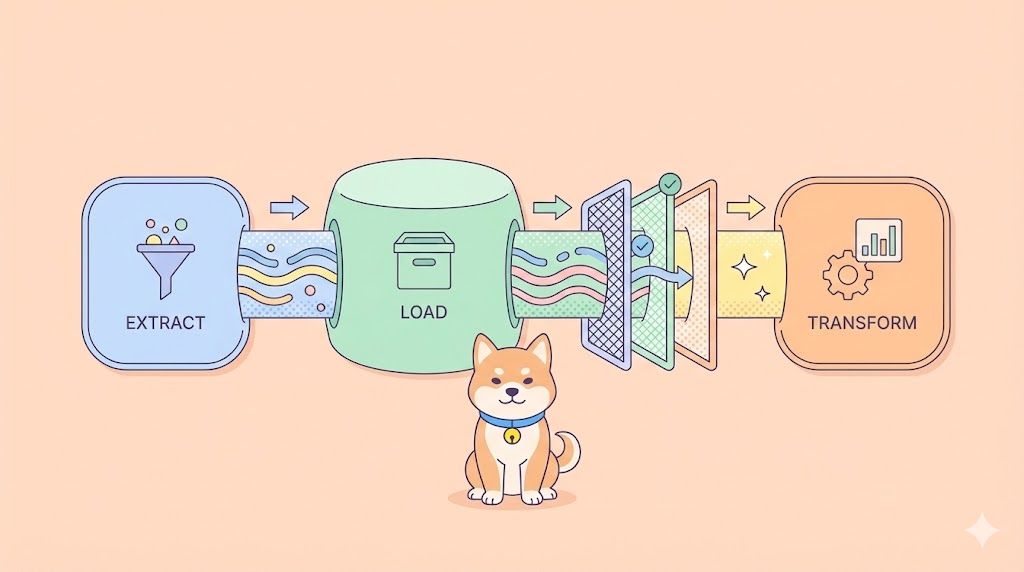

ELTとは何か、そしてETLとの違い

ELT(Extract, Load, Transform)は、従来のETLシーケンスを逆転させます。データをロードする前に変換するのではなく、ソースシステムから生データを抽出し、ターゲット(データレイクまたはウェアハウス)に直接ロードしてから、ターゲットの計算能力を使用してその場で変換します。

| 段階 | ETLパターン | ELTパターン |

|---|---|---|

| 抽出(Extract) | ソースからデータを取得 | ソースからデータを取得 |

| 変換(Transform) | ステージングでクリーンアップ/変更 | ターゲットシステム内で発生 |

| ロード(Load) | 変換済みデータをプッシュ | 最初に生データをプッシュ |

ELTテストは、抽出の完全性、ロードの整合性、変換の正確性を検証し、そのすべてにおいてパフォーマンスとデータ品質を確保する必要があります。

ELTテストが重要な理由:ビジネスへの影響

テストが不十分なELTパイプラインは、連鎖的な問題を引き起こします。

- データ破損:単一の変換バグが不正確なメトリクスを経営者ダッシュボードに伝播させ、数百万ドルの誤った意思決定につながる可能性があります。

- コンプライアンスリスク:GDPRやHIPAAでは、データのリネージと正確性を証明する必要があります。ELTテストは監査証跡を提供します。

- パフォーマンスの低下:テラバイト単位のデータを毎日処理するテストされていないパイプラインは、静かに速度を低下させ、SLAウィンドウを逃す可能性があります。

- 信頼の失墜:ビジネスチームがデータ品質の問題を発見すると、分析プラットフォーム全体を信頼しなくなります。

ある小売企業は、彼らのセールスデータの15%がレポートから欠落していることを発見しました。これは、ELTテストのギャップがソースシステムのスキーマ変更を捕捉できなかったためです。その影響は、不正確な在庫計画とピークシーズンの在庫切れでした。

ELTテストの実施方法:段階的アプローチ

ELTテストは、ソースから消費までのデータの旅を追跡します。各フェーズを検証する方法は次のとおりです。

フェーズ1:抽出テスト

ソースシステムからデータが完全に、かつ正確に抽出されていることを確認します。

テストケース:

- 完全性:抽出されたレコード数とソースシステムの比較

- スキーマ検証:ソーススキーマが予期せず変更されていないことを確認

- データ型の正確性:数値は数値のまま、日付は日付のまま

- 増分抽出:新規または変更されたレコードのみが抽出されること

# 抽出の完全性テスト

def test_extraction_completeness():

source_count = source_db.query("SELECT COUNT(*) FROM orders WHERE date = '2024-01-01'")

extracted_count = staging_area.query("SELECT COUNT(*) FROM raw_orders WHERE date = '2024-01-01'")

assert extracted_count == source_count, f"Missing {source_count - extracted_count} records"

フェーズ2:ロードテスト

生データが破損なくターゲットシステムに正しくロードされることを検証します。

テストケース:

- ロード成功:抽出されたすべてのレコードがロードされること

- データ整合性:切り捨て、エンコーディングの問題、破損がないこと

- パーティショニング:データが正しいパーティション/バケットに配置されること

- 重複検出:重複レコードが挿入されないこと

-- ロード整合性テスト

SELECT

source_table,

COUNT(*) as loaded_records,

SUM(CASE WHEN loaded_at IS NULL THEN 1 ELSE 0 END) as failed_records

FROM raw_data_audit

WHERE load_date = CURRENT_DATE

GROUP BY source_table

HAVING failed_records > 0;

フェーズ3:変換テスト

ビジネスロジックが正しく生データを分析準備完了形式に変換していることを確認します。

テストケース:

- ビジネスルールの正確性:計算が仕様と一致していること

- 参照整合性:外部キーが正しく解決されること

- データ品質:NULL処理、デフォルト値、クレンジング

- 集計ロジック:合計、カウント、平均が数学的に正しいこと

-- 変換の正確性テスト

SELECT

order_id,

raw_amount,

calculated_tax,

(raw_amount * 0.08) as expected_tax

FROM transformed_orders

WHERE ABS(calculated_tax - (raw_amount * 0.08)) > 0.01

フェーズ4:エンドツーエンド検証

パイプライン全体を実行し、最終出力をビジネスの期待値に対して検証します。

テストケース:

- レポートの正確性:最終ダッシュボードが正しいKPIを表示していること

- 照合:集計された合計がソースシステムと一致していること

- タイムライン:データの鮮度がSLAを満たしていること(例:2時間以内)

- 下流への影響:BIツールが変換済みデータをエラーなくクエリできること

ELTテスト vs 従来のデータテスト

ELTテストは、従来のデータウェアハウステストとは主要な点で異なります。

| 側面 | 従来のETLテスト | ELTテスト |

|---|---|---|

| テスト場所 | ステージング層 | ターゲットシステム(Snowflake、BigQuery) |

| パフォーマンスの焦点 | 変換エンジン | ターゲットの計算効率 |

| スキーマ変更 | ETLツールで処理 | ターゲットシステムでテスト |

| ツール | ETLネイティブテスター | SQLベース + APIベースのツール |

現代のELTテストでは、クラウドウェアハウス内のSQL変換を検証し、APIデータ取り込みエンドポイントを監視し、スキーマオンリードアーキテクチャ全体でデータのリネージを追跡する必要があります。

ELTテストのためのツール

SQLベースのテスト:

- dbt(データビルドツール)と組み込みテスト

- データ品質のためのGreat Expectations

- ターゲットウェアハウス内のカスタムSQLスクリプト

APIベースのテスト(ELTにとって重要):

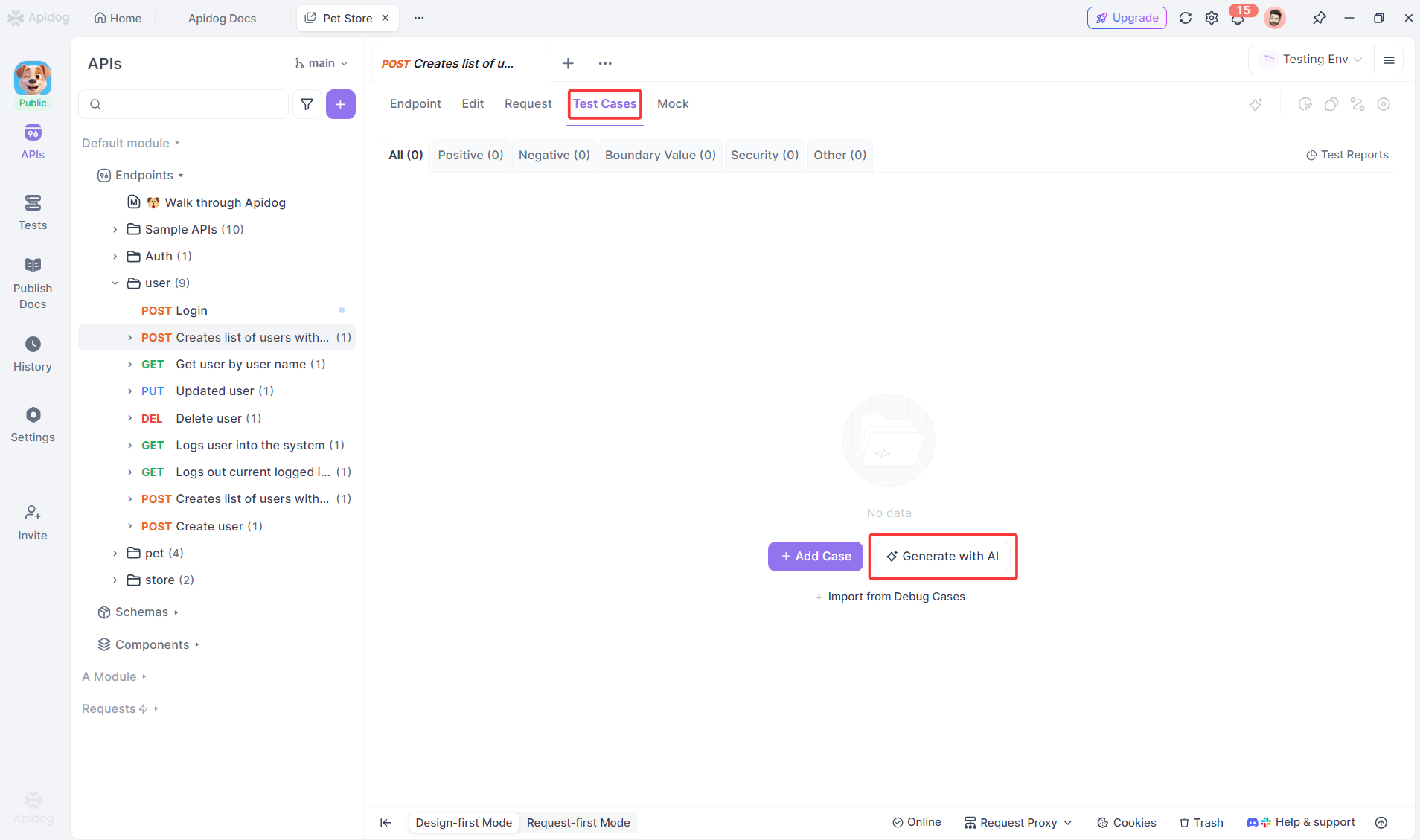

- 取り込みAPI検証とアドホックAPIチェックのためのApidog

- Webhook監視のためのカスタムスクリプト

オーケストレーションテスト:

- Apache Airflowタスク検証

- Prefectフローテスト

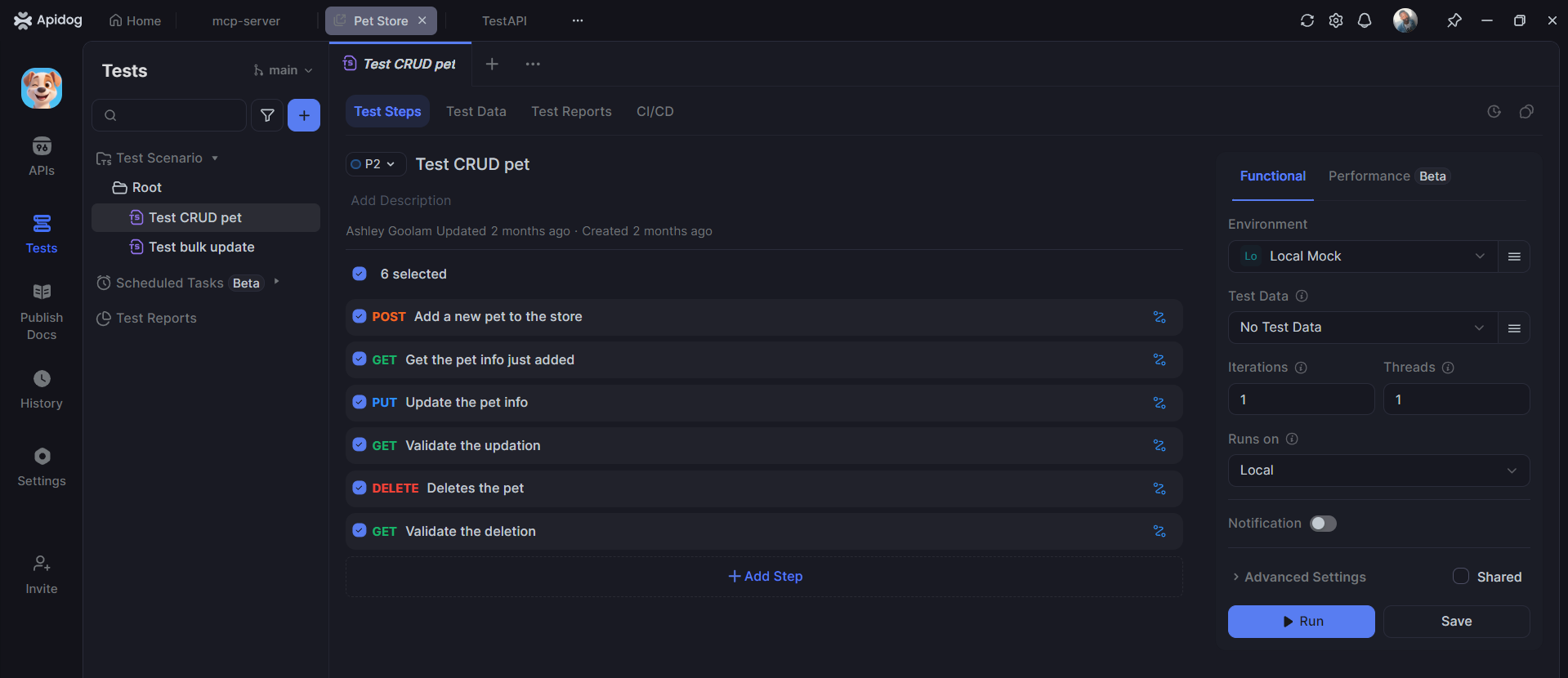

ApidogがELTテストにどのように役立つか

SQLツールが変換を処理する一方で、ApidogはELTパイプラインのAPI層のテストに優れており、これは現代のデータ取り込みと監視にとって重要です。

データ取り込みAPIのテスト

ほとんどのELTパイプラインは、データを抽出するためにAPIを使用します。Apidogはこれらのエンドポイントの検証を自動化します。

# データ取り込みAPIのApidogテスト

Test: POST /api/v1/extract/orders

Given: 有効なAPIキーと日付範囲

When: パラメータ {"start_date": "2024-01-01", "end_date": "2024-01-31"} でリクエストを送信

Test 1: レスポンスステータス 202 (処理のために受け付けられた)

Test 2: レスポンスに追跡用のjob_idが含まれる

Test 3: Webhook通知が5分以内に受信される

Test 4: データがステージングテーブルに表示される

ELTテストにおけるApidogの利点:

- OpenAPI仕様からの自動テスト生成

- 複雑なパイプラインのためのビジュアルワークフロービルダー

- 開発/ステージング/本番データウェアハウスのための環境管理

- スケジュールに従ってデータ品質チェックを実行するためのCI/CD統合

- 監査証跡のための詳細なロギング

ELTテストのベストプラクティス

- 段階的にテストする:ロードの前に抽出を検証し、変換の前にロードを検証する

- 継続的に監視する:データ品質チェックは一度だけでなく、毎時間実行する

- テストをバージョン管理する:SQLテストを変換コードとともにGitに保存する

- 本番に近い環境でテストする:ステージング環境で本番データ量を使用する

- 照合を自動化する:ソースとターゲットのカウントを自動的に比較する

- 異常を警告する:行数が過去の平均から5%以上逸脱した場合に通知する

- データリネージを文書化する:各フィールドが未加工から最終形式にどのように変換されるかを追跡する

よくある質問

Q1: ELTテストはどのくらいの頻度で実行すべきですか?

回答:抽出テストはパイプラインの実行ごとに。データ品質テストは継続的に(毎時間)。完全なエンドツーエンド検証は少なくとも毎日1回実行します。

Q2: ELTテストはデータエンジニアとQAのどちらが担当しますか?

回答:変換を理解しているデータエンジニアがテストを担当します。QAはフレームワークを提供し、ビジネスロジックの結果を検証します。

Q3: ApidogはSQLベースのELTテストを置き換えることができますか?

回答:いいえ。Apidogは、API層(取り込み、監視、オーケストレーション)を検証することでSQLテストを補完します。ウェアハウス内の変換には依然としてSQLテストが必要です。

Q4: テラバイト単位のデータを処理するELTパイプラインをどのようにテストしますか?

回答:全量ではなく、統計的に有意なサンプル(例:データの1%)でテストします。データプロファイリングを使用して、分布が期待値と一致することを確認します。

Q5: 最初に実装すべき最も重要なELTテストは何ですか?

回答:エンドツーエンドの行数照合です。ソースと宛先のレコード数が一致しない場合、他のすべては意味がありません。このテストは、パイプラインの障害の大部分を捕捉します。

結論

ELTテストは、データ駆動型組織にとって不可欠です。バグが機能に影響を与える従来のソフトウェアテストとは異なり、データパイプラインのバグはビジネスの意思決定、コンプライアンス、収益に影響を与えます。抽出、ロード、変換、およびエンドツーエンドのフローをテストする体系的なアプローチは、コストのかかるデータ破損を防ぎ、分析プラットフォームへの信頼を構築します。

最新のELTパイプラインは、取り込みと監視のためにAPIに大きく依存しています。Apidogは、これらのAPIをテストする手間のかかる作業を自動化し、データエンジニアが変換ロジックに集中できるようにしながら、パイプラインの入り口と出口が継続的に検証されるようにします。SQLベースの変換テストとApidogのAPI自動化の組み合わせは、あなたの最も重要なビジネス資産であるデータのための包括的なセーフティネットを作成します。

まず照合テストから始めましょう。データ品質チェックを追加しましょう。API検証を自動化しましょう。取締役会でのプレゼンテーションで正確な数字が示されたとき、将来のあなた自身とビジネスのステークホルダーはあなたに感謝するでしょう。