大規模言語モデルと柔軟なAIツールの台頭により、カスタムAIエージェントの構築がこれまで以上に身近になりました。タスクの自動化支援、研究補助、ユーザーインタラクションのサポート、新しいサービスの提供など、どのような目的であれ、ゼロから始めてニーズに合わせて設計することで、最も柔軟で強力な結果が得られることがよくあります。このガイドでは、AIエージェントをゼロから構築するための9つのステップを紹介します。目的の定義から、その周りにUIやAPIを構築するまでを網羅します。

開発チームが最高の生産性で協力できる、統合されたオールインワンプラットフォームをお探しですか?

Apidogは、お客様のあらゆる要求に応え、Postmanをはるかに手頃な価格で置き換えます!

ステップ1:エージェントの目的と範囲を定義する

コードやプロンプトを一行も書く前に、エージェントが何をするべきかを明確にする必要があります。これは次のことを意味します。

- エージェントが処理する正確なタスクを特定する(例:「営業リードの資格認定」、「アウトリーチメールのドラフト作成」、「サポートチケットの要約」、「ユーザーの好みに基づく本の推薦」など)。

- ターゲットユーザーを特定する — 彼らは社内チームメンバー、最終顧客、それとも他のエージェントですか?

- 成果物を明確にする — エージェントが生成すべき出力(例:JSONオブジェクト、整形されたレポート、ドラフトメッセージ、決定など)。

例:「営業アシスタント」エージェントを想定してみましょう。リードのプロファイルデータを入力として受け取り、リードの公開情報を調査し、リードの適合性をスコアリングし、アウトリーチメールのドラフトを出力するように定義するかもしれません。この範囲が明確に定義されていれば、プロンプトからデータフローに至るまで、他のすべてが計画しやすくなります。

ステップ2:明確な入出力スキーマを確立する

目的が明確になったら、すべてを自由形式にするのではなく、構造化された入出力スキーマを設計します。これにより、APIがリクエストとレスポンスの構造を定義するのと同様に、エージェントに安定した「契約」が与えられます。

- Pydantic(Python)、JSON Schema、またはTypeScriptインターフェースなどのツールを使用して、入力と出力を正式に定義します(この点はRDDによっても強調されました)。

- エージェントが期待するフィールド(型、必須/任意、値の制約など)を正確に定義します。

- 出力については、データ(例:「email_subject」、「email_body」、「lead_score」など)だけでなく、必要に応じてメタデータ(例:timestamp、model_version、processing_timeなど)も指定します。これは、ロギング、デバッグ、またはエージェントの連鎖に特に役立ちます。

from pydantic import BaseModel, Field

from typing import Optional, List

class LeadProfile(BaseModel):

name: str

email: Optional[str]

company: Optional[str]

description: Optional[str]

class OutreachEmail(BaseModel):

subject: str

body: str

lead_score: float = Field(..., ge=0, le=1)

# Example usage:

lead = LeadProfile(name="Alice Johnson", email="alice@example.com", company="Acme Corp")

print(lead.json())このスキーマ優先のアプローチにより、一貫性が確保され、出力の検証が容易になり、他のシステムやUIとの統合が簡素化されます。

ステップ3:システム指示を書く

スキーマが準備できたら、エージェントの詳細な役割定義とシステム指示を作成します。基本的に、AIに次のように伝えます。「あなたはXです。これがあなたの責任、制約、スタイル、トーン、出力形式です。」

- 行動ルールを定義します(例:「常にスキーマに一致するJSONを返す」、「データが不足している場合はエラーオブジェクトで応答する」、「丁寧で簡潔、プロフェッショナルであること」)。

- 応答のばらつきを減らすために、一貫したプロンプト/指示テンプレートを使用します。多くのエージェントは、安定した「システムプロンプト + ユーザープロンプト + スキーマ強制」構造から恩恵を受けます。

- さまざまな指示スタイルを試します。一部のエージェントは非常に明示的な指示によく反応し、他のエージェントはより柔軟な会話形式の指示によく反応します。

このスタイルをサポートする任意のLLM(例:GPT-4、Claude、その他のモデル)を使用できます。多くの開発者は、システム指示をエージェントの初期化時に直接組み込んでいます。

ステップ4:推論と外部アクションを有効にする

エージェントは、論理的に推論し、外部システム(データベース、API、ツール、ウェブ検索、コード実行など)と対話できるようになると、はるかに強力になります。

- ReAct(Reasoning + Action)のようなフレームワークや同様のパターンを使用します。エージェントは推論し、次にアクション(APIの呼び出しなど)を選択し、結果を観察し、再び推論するといった具合に繰り返します。

- エージェントが呼び出すことができるツール関数/インターフェースを提供します。これらには、明確に定義された入力と出力(スキーマに一致するもの)が必要です。例えば、「search_web(query)」→結果を返す、「send_email(payload)」、「query_database(params)」などです。

- データ取得、計算、データベース操作、ウェブスクレイピング、文書処理などのタスクの場合、これらの外部アクションを接続することで、エージェントは単なるテキスト生成以上のことができるようになります。

このステップにより、エージェントは「賢いテキストジェネレーター」から、単に「返答する」だけでなく「行動できる」真の「エージェント」へと変化します。

import openai, os, json

openai.api_key = os.getenv("OPENAI_API_KEY")

SYSTEM_PROMPT = """

You are a helpful assistant. Use the available tools when needed.

Return output in JSON with keys: {action, action_input} or {final_answer}.

"""

TOOLS = {

"search": lambda query: f"[search results for: {query}]",

# add more tools as needed

}

def call_llm(messages):

resp = openai.chat.completions.create(

model="gpt-4o",

messages=messages

)

return resp.choices[0].message["content"]

def agent_loop(user_input):

messages = [{"role":"system","content":SYSTEM_PROMPT},

{"role":"user","content":user_input}]

while True:

reply = call_llm(messages)

data = json.loads(reply)

if "action" in data:

result = TOOLS[data["action"]](data["action_input"])

messages.append({"role":"assistant","content":reply})

messages.append({"role":"tool","content":result})

elif "final_answer" in data:

return data["final_answer"]

if __name__ == "__main__":

answer = agent_loop("Find the population of France and compute 10% of it.")

print(answer)

ステップ5:複数のエージェントをオーケストレートする(必要に応じて)

複雑なワークフロー — 例えば、多段階の営業ファネル、データ分析+レポートパイプライン、または多部署間のワークフロー — の場合、それぞれに定義された役割を持つ複数のエージェントを連携させたいと考えるかもしれません。

- 例えば、プランナーエージェントがステップを決定し、ワーカーエージェントがタスク(データ取得、計算など)を実行し、検証者エージェントが結果の品質をレビューします。

- エージェントにタスクを割り当て、アクションを順序付け、依存関係を処理し、結果を集約する調整ロジック(オーケストレーター)を構築します。

- フレームワークやオーケストレーションライブラリを使用するか、カスタムロジックを記述します。このオーケストレーションをアプリケーションの「コントローラー」層のように扱い、タスク、結果、ステータスを渡し、エージェントを調整することがしばしば役立ちます。

これにより、システムはモジュール化され、保守性が向上し、複雑なタスクや大規模なタスクを処理できるようになります。

ステップ6:メモリとコンテキストを追加する

チャットアシスタント、サポートボット、研究エージェント、パーソナルアシスタントなど、多くの便利なエージェントは、以前のインタラクションや長期にわたる永続的な知識を記憶する必要があります。メモリがなければ、すべてのインタラクションはステートレスでコンテキストがありません。

- 複数ターンにわたるインタラクションを含むタスクのために、短期メモリ(会話履歴、セッションコンテキスト)を実装します。

- 長期メモリ/ナレッジベースを実装します — 事実、ユーザー設定、過去の決定、外部データなどを、しばしばベクトルデータベースや他のストレージソリューションを使用して保存します。

- メモリ検索とグラウンディングのために、RAG(Retrieval-Augmented Generation)の使用を検討します。エージェントがコンテキストを必要とするときに、関連する過去のデータやドキュメントを取得し、現在のプロンプトとともに埋め込み、生成します。

メモリを追加することで、エージェントは継続性、パーソナライゼーション、そしてますます有用な行動を提供できるようになります。

class ConversationMemory:

def __init__(self):

self.history = []

def add(self, message: str):

self.history.append(message)

# Optional: trim if too long

def get_context(self) -> str:

return "\n".join(self.history)

mem = ConversationMemory()

def run_conversation(input_text):

mem.add(f"User: {input_text}")

# pass context to agent

# agent generates response...

response = "..." # from LLM

mem.add(f"Agent: {response}")

return response

# Example usage

run_conversation("Hello, who are you?")

run_conversation("Remember my name is Alice.")

ステップ7:マルチメディア機能を統合する

エージェントの目的に応じて、画像、音声、ビデオ、またはファイル/ドキュメント処理のサポートを追加するかどうかを決定できます(作成しようとしているAIエージェントによっては、このステップは他のエージェントにとってはオプションかもしれませんが、ほとんどのエージェントにとっては非常に必要です)。

- 音声の場合: 音声認識/音声合成ツール(例:Whisper、その他のASR/TTSシステム)を統合します。

- 画像/視覚情報の場合: (必要であれば)画像生成または視覚対応モデルを有効にし、エージェントが画像を分析したり、視覚情報を生成したりできるようにします。

- ドキュメント処理の場合: PDF、Wordドキュメント、またはその他のデータ形式を解析し、エージェントが構造化された出力を読み取ったり生成したりできるようにします。

マルチメディアのサポートは、ドキュメントの要約から画像ベースの分析、インタラクティブなUIタスクまで、エージェントが処理できるタスクの範囲を広げます。

ステップ8:出力の形式設定と配信

エージェントの出力は、人間にとっても他のプログラムやシステムにとっても、適切に構造化され、クリーンで、利用可能であるべきです。

- プログラム的に出力が消費される場合は、構造化された出力形式(JSON、XML、型付きスキーマ)を使用します。

- エージェントがレポート、ログ、または人間が読める要約を生成する場合は、それらを明確に整形します(Markdown、HTML、PDFなど)。

- デバッグや内省のために、出力の一部としてメタデータ(タイムスタンプ、ツール呼び出しログ、トークン使用量など)を含めます。

これにより、出力が信頼性があり、解析可能で、UI、パイプライン、または下流システムへの統合が容易になります。

ステップ9:ユーザーインターフェースまたはAPI層を構築する

最後に、AIエージェントをユーザー向けインターフェースまたはAPIで包み込み、社内ユーザー、顧客、または他のシステムが利用できるようにします。

利用可能なオプションは次のとおりです。

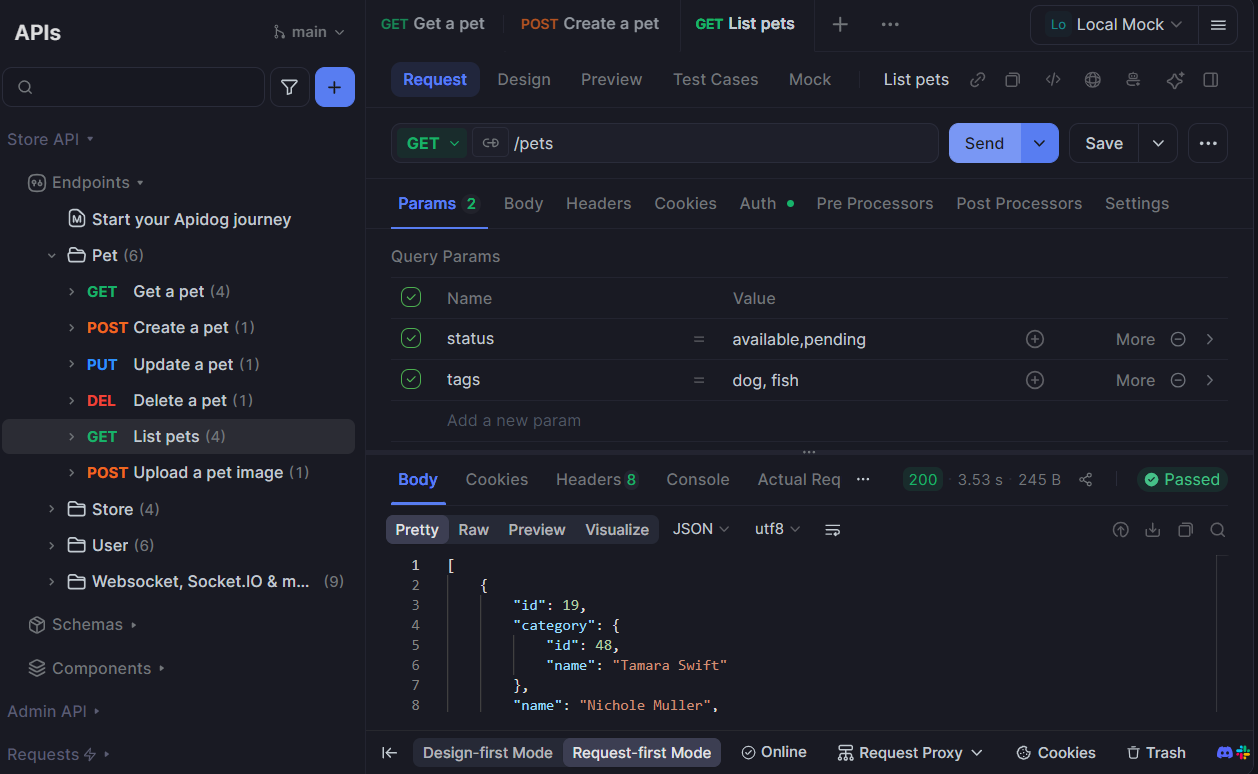

- 外部アプリケーションがプログラム的にエージェントを呼び出せるようにするためのREST API(すべてのAPIエンドポイントをApidogでテスト)またはHTTPエンドポイント(例:FastAPIのようなフレームワークを使用)。 (より多くのコード例はReal Pythonで)

- ユーザーが対話するためのシンプルなチャットUI(ウェブまたはデスクトップ)またはコマンドラインインターフェース。

- 既存のアプリケーション、Slackボット、ダッシュボード、またはカスタムフロントエンドへの埋め込み。

この最後のステップにより、エージェントは「プロジェクト」から、価値を提供する有効な「製品」へと変わります。

from fastapi import FastAPI

from pydantic import BaseModel

app = FastAPI()

class AgentRequest(BaseModel):

prompt: str

class AgentResponse(BaseModel):

result: str

@app.post("/api/agent", response_model=AgentResponse)

def call_agent(req: AgentRequest):

response = agent_loop(req.prompt) # assume agent_loop is defined

return {"result": response}

よくある質問

Q1. 自由形式のテキストではなく、構造化された入出力スキーマを定義する理由は何ですか?

構造化されたスキーマ(Pydantic、JSON Schemaなどを介して)は、エージェントが期待されるフィールドを受け取り、予測可能で機械が読み取れる出力を返すことを保証します。これにより、不正な形式のデータが発生する可能性が減り、検証が簡素化され、他のシステムとの統合がはるかに堅牢になります。

Q2. ReActとは何ですか、そしてなぜそれが役立つのでしょうか?

ReActは「Reasoning + Action(推論+行動)」の略です。これは、エージェントが思考(推論)と実行(ツールを呼び出すかアクションを実行する)を交互に行い、その後結果を観察し、必要に応じて推論を続けるという設計パターンです。これにより、エージェントは多段階のロジックを実行したり、外部ツールやAPIを呼び出したり、結果に基づいて次のステップを決定したりすることができ、単純なワンショットのプロンプト応答ボットよりもはるかに強力になります。

Q3. 単一のエージェントではなく、複数のエージェントを使用すべきなのはどのような場合ですか?

タスクが複雑で、計画、実行、検証、またはデータ取得、推論、レポート作成といった異なるドメインなど、専門化によって恩恵を受ける明確なサブタスクが含まれる場合に、複数のエージェントを使用します。マルチエージェントのセットアップは、モジュール性、明確さ、堅牢性を向上させます。(実用的なガイドはEmpathy First Mediaで)

Q4. メモリはエージェントをどのように改善しますか — そしてどのような種類のメモリが最適ですか?

メモリは継続性を可能にし、エージェントが以前のインタラクション、ユーザー設定、過去の決定、または蓄積された知識を記憶することを可能にします。短期メモリ(セッションコンテキスト)は複数ターンにわたる会話に役立ち、長期メモリ(ベクトルデータベース、ドキュメントストア)は知識検索、パーソナライゼーション、時間を超えた推論をサポートします。多くのアプリケーションでは、これらの組み合わせが理想的です。

Q5. AIエージェントを安全にデプロイし、無限ループや危険な動作を避けるにはどうすればよいですか?

デプロイ前に安全性と監視を追加します。リクエストあたりの推論またはツール呼び出しループの数を制限し、機密性の高いアクションにはロギング、エラー処理、人間によるチェックポイントを実装します。使用量、コスト、パフォーマンスを監視し、エッジケースを徹底的にテストします。

結論

AIエージェントをゼロから構築することは、やりがいのある — そしてますます身近になる — 事業です。目的の定義、明確なスキーマの設計、確かな指示の記述、推論とツール使用の有効化、必要に応じた複数エージェントのオーケストレーション、メモリとコンテキストの追加、出力の正確なフォーマット、そして利用可能なインターフェースの公開といった構造化されたプロセスに従うことで、特定のニーズに合わせた強力で信頼性の高いエージェントを作成できます。

営業アシスタント、研究ツール、チャットボット、または自動化エンジンなど、何を構築する場合でも、このステップバイステップガイドは青写真を提供します。思慮深い設計と優れたアーキテクチャにより、AIエージェントはプロトタイプから、有用で、保守可能で、スケーラブルなツールへと進化させることができます。

最初のエージェントを構築する準備ができたら、シンプルな目的を選び、そのスキーマを作成し、試してみてください。基本が機能し始めたら、メモリ、ツール、インターフェースを重ねていき、あなたの創造物が真に強力なものへと成長するのを見守ることができます。

開発チームが最高の生産性で協力できる、統合されたオールインワンプラットフォームをお探しですか?

Apidogは、お客様のあらゆる要求に応え、Postmanをはるかに手頃な価格で置き換えます!