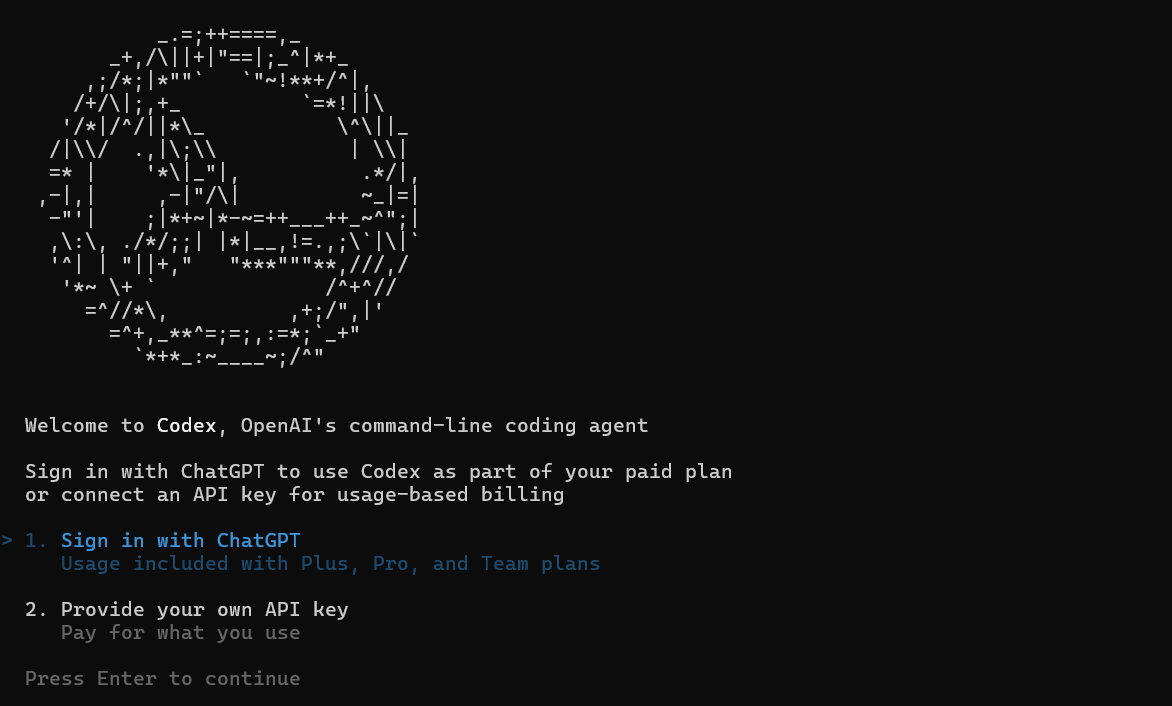

Bayangkan ini: Anda sedang asyik dalam maraton koding, memberi AI Anda basis kode besar untuk direfaktor, ketika tiba-tiba—bam—ia tersedak karena "token limit exceeded." Kedengarannya akrab? Jika Anda memanfaatkan Codex, alat koding canggih dari OpenAI, batas token Codex itu bisa terasa seperti penghalang di tengah-tengah pekerjaan. Tapi jangan takut, rekan pengembang—ini bukan penghentian total; ini adalah undangan untuk menjadi lebih cerdas dalam menyusun prompt Anda. Per September 2025, Codex (didukung oleh model seperti GPT-5-Codex) memiliki jendela token yang luas yang mampu menangani segalanya mulai dari perbaikan cepat hingga perombakan mono-repo. Dalam penjelasan yang mudah ini, kita akan menguraikan apa sebenarnya arti batas token Codex, bagaimana cara memanfaatkannya semaksimal mungkin, dan tips untuk meningkatkan penggunaan Anda. Baik Anda seorang peretas solo atau pemimpin tim, menguasai ini akan membuat sesi AI Anda berjalan lancar. Mari kita dekode token-token ini dan tingkatkan permainan Codex Anda!

Ingin platform All-in-One yang terintegrasi agar Tim Pengembang Anda dapat bekerja sama dengan produktivitas maksimal?

Apidog memenuhi semua permintaan Anda, dan menggantikan Postman dengan harga yang jauh lebih terjangkau!

Mendemistifikasi Batas Token Codex: Permainan Angka

Pada intinya, batas token Codex berputar di sekitar jendela konteks—total "ruang otak" yang dapat ditempati oleh permintaan Anda. Tidak seperti model lama yang dibatasi pada 4K atau 8K token, Codex—diluncurkan pada Mei 2025 dan ditingkatkan dengan codex-1—memiliki panjang konteks 192.000 token yang luar biasa. Itu cukup untuk menelan repo berukuran sedang (bayangkan sekitar 50 ribu baris kode) sambil menyisakan ruang untuk prompt, riwayat, dan output Anda. Token input (kode + instruksi Anda) mencapai maksimum sekitar 150K, dengan output dibatasi pada 42K untuk menjaga respons tetap cepat—total mencapai titik manis 192K itu.

Mengapa begitu luas? Codex dibangun untuk rekayasa dunia nyata: Men-debug aplikasi lama? Masukkan modul lengkap. Membangun fitur? Sertakan spesifikasi, dependensi, dan pengujian tanpa memotong. Varian codex-mini-latest menguranginya menjadi 128K untuk tugas-tugas yang lebih ringan (Tanya Jawab kode, pengeditan cepat), tetapi codex-1 penuh bersinar untuk pekerjaan berat. Batas per-pesan terkait dengan paket Anda—pengguna Plus mendapatkan 30-150 pesan/5 jam, tetapi setiap pesan dapat menghabiskan hingga 192K jika kompleks. Tidak ada batas keras per-permintaan di luar jendela; ini lebih tentang penggunaan keseluruhan untuk mencegah server kewalahan.

Batas-batas ini tidak statis—OpenAI terus berinovasi berdasarkan umpan balik. Pratinjau awal 2025 "tidak terukur" untuk pengujian, tetapi sekarang mereka berjenjang untuk keberlanjutan. Untuk pengguna API, ini adalah bayar-per-token: $1,50/1M input, $6/1M output pada codex-mini, dengan diskon caching 75% untuk pengulangan. Intinya: Batas token Codex sangat murah hati untuk sebagian besar pengembang, tetapi prompting yang cerdas mengubahnya menjadi kekuatan super.

Cara Memanfaatkan Batas Token Codex: Maksimalkan Jendela Anda

Mencapai batas 192K? Tidak, dengan strategi cerdas, Anda jarang akan menyentuhnya—dan ketika Anda melakukannya, Anda akan menyukainya. Kunci untuk menguasai batas token Codex adalah memperlakukannya seperti RAM: Muat yang penting, pangkas yang tidak perlu, dan berulang secara efisien.

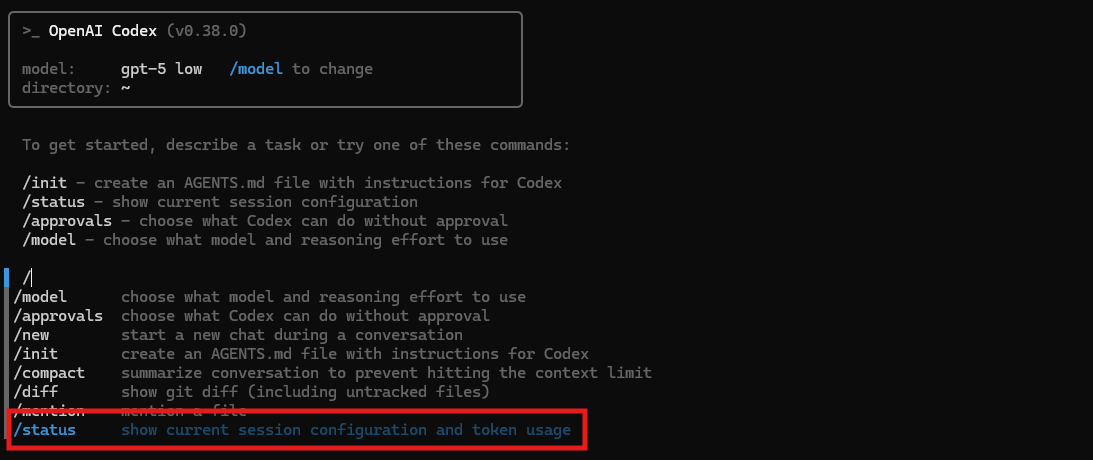

Pertama, potong dengan bijak: Untuk basis kode besar, ringkas file yang tidak penting ("Ini utils.py; fokus pada logika otentikasi") untuk membebaskan token untuk jalur kritis. Alat seperti git diff atau unggahan selektif memangkas 50% input tanpa kehilangan konteks. Di CLI, gunakan --context-file untuk memuat ringkasan terlebih dahulu, menjaga prompt Anda tetap ramping.

Manfaatkan caching: Pola berulang? Diskon 75% OpenAI untuk prompt yang di-cache berarti membuat ulang rangkaian pengujian boilerplate sangat murah. Prompt sekali dengan konteks penuh, lalu referensikan: "Bangun di atas refaktor otentikasi sebelumnya." Ini merangkai sesi tanpa memuat ulang semuanya, memperluas jendela Anda di seluruh maraton.

Gunakan multimodal: GPT-5-Codex dapat memproses gambar (tangkapan layar kesalahan) tanpa memengaruhi token—jelaskan bug UI secara visual, menghemat teks yang berlebihan. Untuk output, atur --max-output 10K untuk fokus pada perbaikan, bukan esai.

Pantau seperti elang: Dasbor CLI menunjukkan penggunaan real-time (misalnya, 486K digunakan, 32% konteks tersisa). Atur peringatan untuk 80%—jeda, ringkas kemajuan di AGENTS.md, dan lanjutkan. Pengguna Pro mendapatkan granularitas yang lebih halus, menemukan pemboros token seperti penalaran yang bertele-tele.

Kasus khusus? Monorepos: Gunakan pencarian vektor untuk mengambil potongan yang relevan secara on-the-fly, hanya memasukkan 20K pada satu waktu. Pemuatan dinamis ini melewati batas statis, ideal untuk penyebaran perusahaan. Hasilnya? Tugas-tugas yang akan membanjiri model lama berjalan lancar, dengan pengembang melaporkan throughput 3x lipat.

Cara Terbaik Memanfaatkan Codex: Melampaui Batas

Batas token Codex hanyalah kanvas—penguasaan sejati datang dari menggunakannya seperti pisau Swiss Army untuk kehidupan pengembangan. Mulailah dengan CLI untuk para pejuang terminal: codex debug app.py --context 50K menyerap setengah batas Anda untuk perbaikan yang ditargetkan, menghasilkan diff PR. Pasangkan dengan ekstensi VS Code untuk saran sebaris—arahkan kursor ke fungsi, tekan "Test with Codex," dan itu menghasilkan suite dalam 10K token.

Untuk tim, delegasikan: Tetapkan agen melalui mode cloud (tidak terbatas untuk lonjakan) untuk tugas paralel—satu men-debug frontend (20K token), yang lain backend (jendela terpisah). Integrasikan MCP untuk serah terima konteks: Lewatkan status yang diringkas antar agen, meminimalkan pemuatan ulang.

Prompt engineering meningkatkan pemanfaatan: "Prioritaskan efisiensi: Jelaskan perbaikan dalam 500 token, kode dalam 2K." Ini memeras nilai dari output. Rantai dengan alat—gunakan Pencarian File untuk menarik cuplikan (5K token), masukkan ke Interpreter untuk eksekusi (tanpa biaya tambahan), lalu perbaiki.

Perusahaan? Batas khusus melalui kredit memungkinkan Anda melonjak hingga 500K+ per tugas, sempurna untuk migrasi. Tingkat gratis? Tetap gunakan model mini untuk dasar-dasar 128K, tingkatkan saat ketagihan.

Jebakan? Prompt yang berlebihan memperbesar input—jaga agar tetap modular. Selalu verifikasi output; token yang dihemat dari halusinasi lebih baik daripada pengulangan yang sia-sia.

Kesimpulan: Token Adalah Sekutu Anda, Bukan Musuh

Batas token Codex—kekuatan 192K itu—bukanlah penghalang; itu adalah cetak biru untuk kejeniusan yang efisien. Dengan memecah, menyimpan dalam cache, dan merangkai, Anda mengubah batasan menjadi kreativitas, menjadikan Codex co-pilot utama Anda. Baik sprint CLI atau maraton IDE, optimalkan tanpa henti dan saksikan produktivitas melonjak. Punya trik hemat token? Bagikan di platform pengembang mana pun—mari kita retas batasnya bersama!