Pendahuluan untuk Llama 3.1 Instruct 405B

Llama 3.1 dari Meta Instruct 405B mewakili lompatan signifikan dalam ranah model bahasa besar (LLM). Sesuai namanya, raksasa ini memiliki 405 miliar parameter yang mengesankan, menjadikannya salah satu model AI terbesar yang tersedia untuk umum hingga saat ini. Skala masif ini diterjemahkan ke dalam kemampuan yang ditingkatkan di berbagai tugas, mulai dari pemahaman dan pembuatan bahasa alami hingga penalaran dan pemecahan masalah yang kompleks.

Salah satu fitur menonjol dari Llama 3.1 405B adalah jendela konteksnya yang diperluas sebesar 128.000 token. Peningkatan substansial dari versi sebelumnya ini memungkinkan model untuk memproses dan menghasilkan potongan teks yang jauh lebih panjang, membuka kemungkinan baru untuk aplikasi seperti pembuatan konten bentuk panjang, analisis dokumen mendalam, dan interaksi percakapan yang diperluas.

Model ini unggul dalam bidang-bidang seperti:

- Ringkasan dan akurasi teks

- Penalaran dan analisis yang bernuansa

- Kemampuan multibahasa (mendukung 8 bahasa)

- Pembuatan dan pemahaman kode

- Potensi penyetelan halus khusus tugas

Dengan sifat sumber terbukanya, Llama 3.1 405B siap untuk mendemokratisasi akses ke teknologi AI mutakhir, memungkinkan para peneliti, pengembang, dan bisnis untuk memanfaatkan kekuatannya untuk berbagai aplikasi.

Perbandingan Penyedia API Llama 3.1

Beberapa penyedia cloud menawarkan akses ke model Llama 3.1 melalui API mereka. Mari kita bandingkan beberapa opsi yang paling menonjol:

| Penyedia | Harga (per juta token) | Kecepatan Output | Latensi | Fitur Utama |

|---|---|---|---|---|

| Together.ai | $7,50 (tarif campuran) | 70 token/detik | Sedang | Kecepatan output yang mengesankan |

| Fireworks | $3,00 (tarif campuran) | Baik | 0,57 detik (sangat rendah) | Harga paling kompetitif |

| Microsoft Azure | Bervariasi berdasarkan tingkatan penggunaan | Sedang | 0,00 detik (hampir instan) | Latensi terendah |

| Replicate | $9,50 (token output) | 29 token/detik | Lebih tinggi dari beberapa pesaing | Model harga yang mudah |

| Anakin AI | $9,90/bulan (model Freemium) | Tidak ditentukan | Tidak ditentukan | Pembuat aplikasi AI tanpa kode |

- Together.ai: Menawarkan kecepatan output yang mengesankan yaitu 70 token/detik, menjadikannya ideal untuk aplikasi yang membutuhkan respons cepat. Harganya kompetitif yaitu $7,50 per juta token, menyeimbangkan antara kinerja dan biaya.

- Fireworks: Menonjol dengan harga paling kompetitif yaitu $3,00 per juta token dan latensi yang sangat rendah (0,57 detik). Ini menjadikannya pilihan yang sangat baik untuk proyek yang sensitif terhadap biaya yang juga membutuhkan waktu respons yang cepat.

- Microsoft Azure: Memiliki latensi terendah (hampir instan) di antara para penyedia, yang sangat penting untuk aplikasi waktu nyata. Namun, struktur harganya bervariasi berdasarkan tingkatan penggunaan, yang berpotensi membuatnya lebih kompleks untuk memperkirakan biaya.

- Replicate: Menawarkan model harga yang mudah dengan $9,50 per juta token output. Meskipun kecepatan outputnya (29 token/detik) lebih rendah dari Together.ai, ia tetap memberikan kinerja yang layak untuk banyak kasus penggunaan.

- Anakin AI: Pendekatan Anakin AI berbeda secara signifikan dari penyedia lain, berfokus pada aksesibilitas dan penyesuaian daripada metrik kinerja mentah. Ini mendukung beberapa model AI, termasuk GPT-3.5, GPT-4, dan Claude 2 & 3, menawarkan fleksibilitas di berbagai tugas AI. Ini dimulai dengan model freemium dengan paket mulai dari $9,90/bulan.

Cara Melakukan Panggilan API ke Model Llama 3.1 Menggunakan Apidog

Untuk memanfaatkan kekuatan Llama 3.1, Anda perlu melakukan panggilan API ke penyedia pilihan Anda. Meskipun proses yang tepat mungkin sedikit berbeda antara penyedia, prinsip-prinsip umumnya tetap sama.

Berikut adalah panduan langkah demi langkah tentang cara melakukan panggilan API menggunakan Apidog:

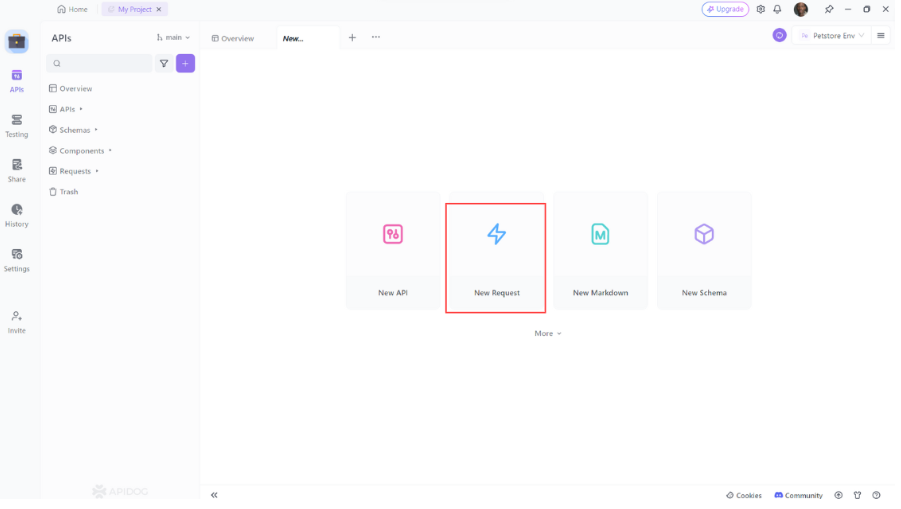

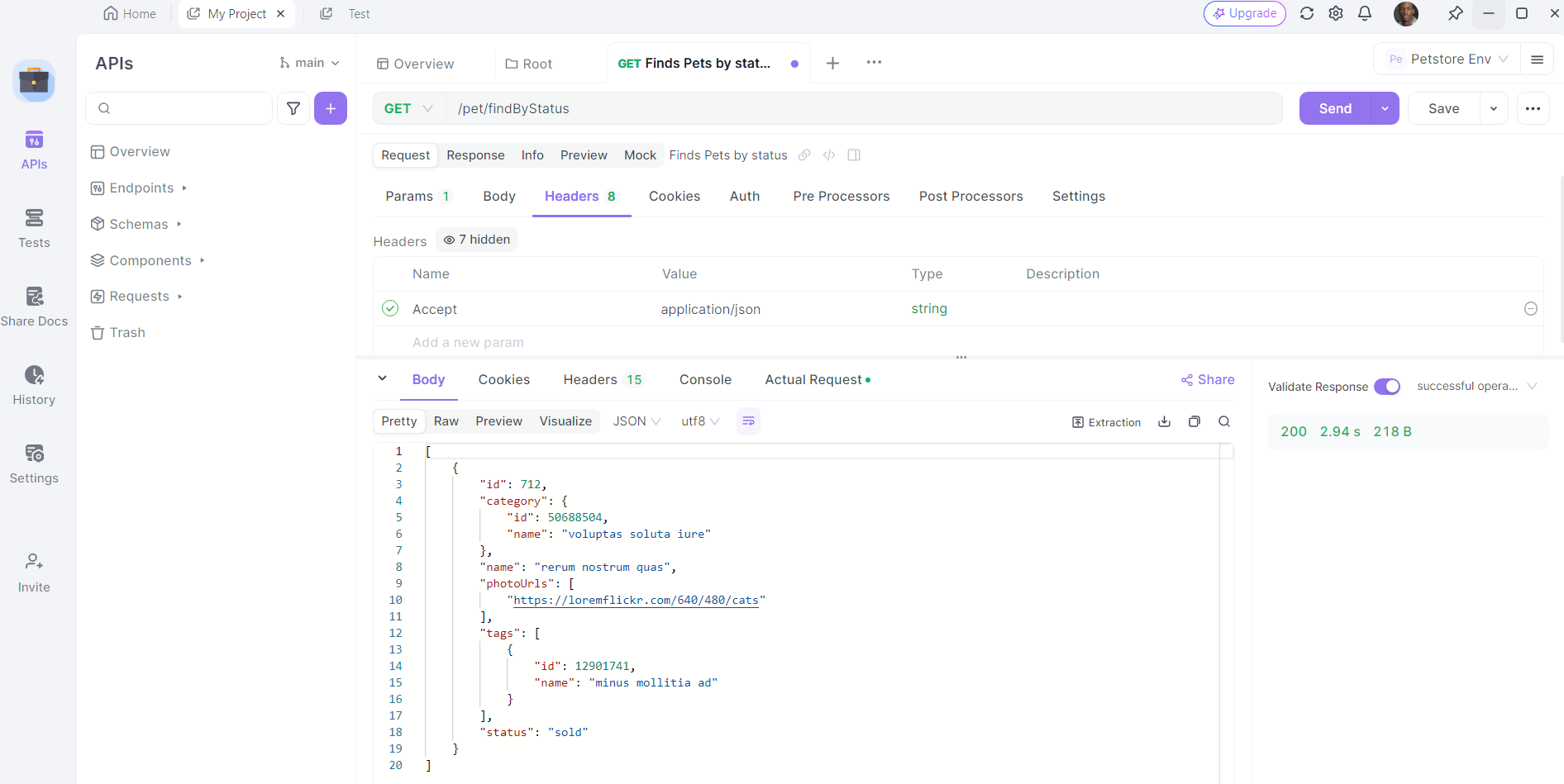

- Buka Apidog: Luncurkan Apidog dan buat permintaan baru.

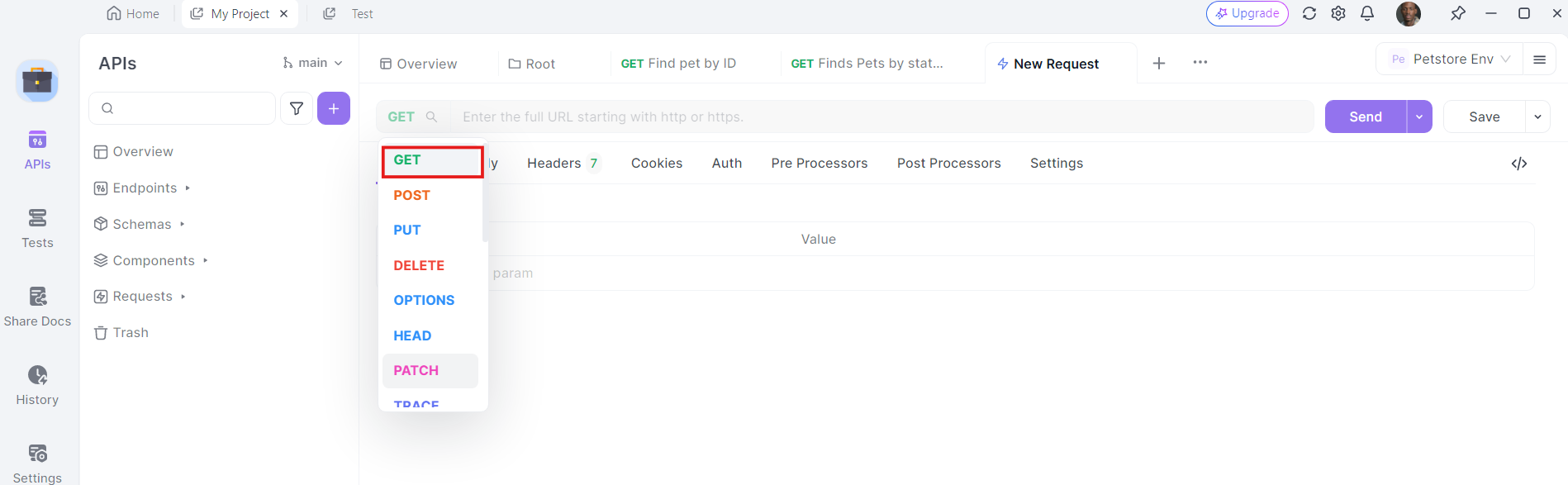

2. Pilih Metode HTTP: Pilih "GET" sebagai metode permintaan atau "Post"

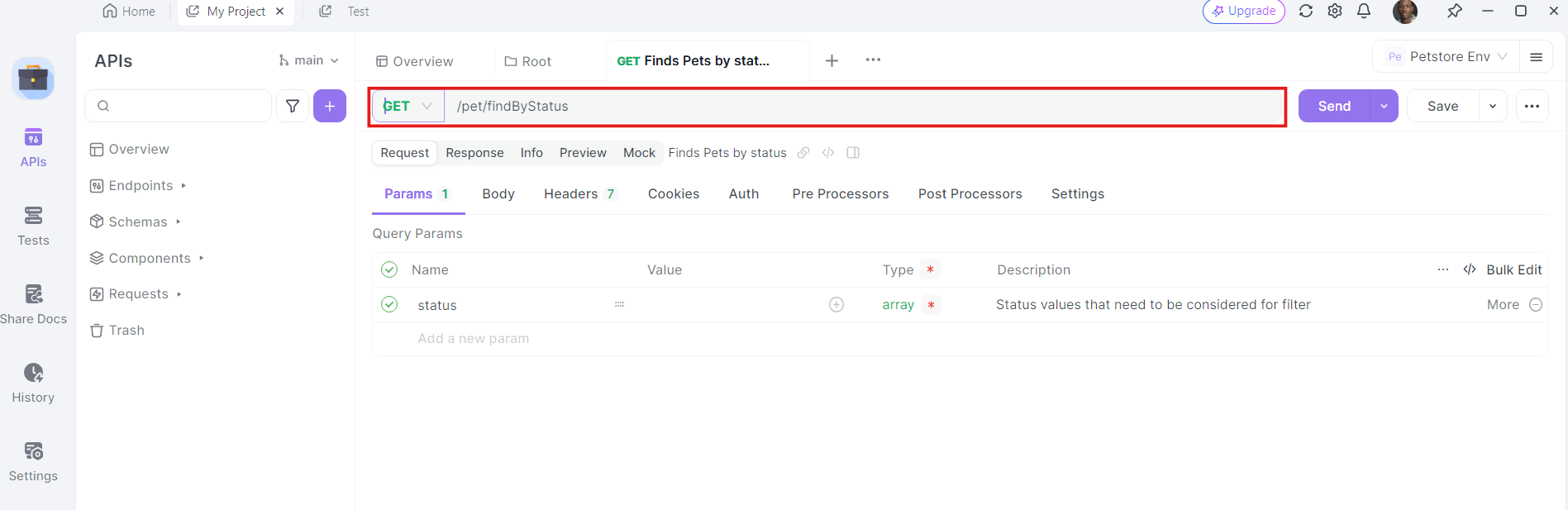

3. Masukkan URL: Di bidang URL, masukkan titik akhir yang ingin Anda kirimi permintaan GET.

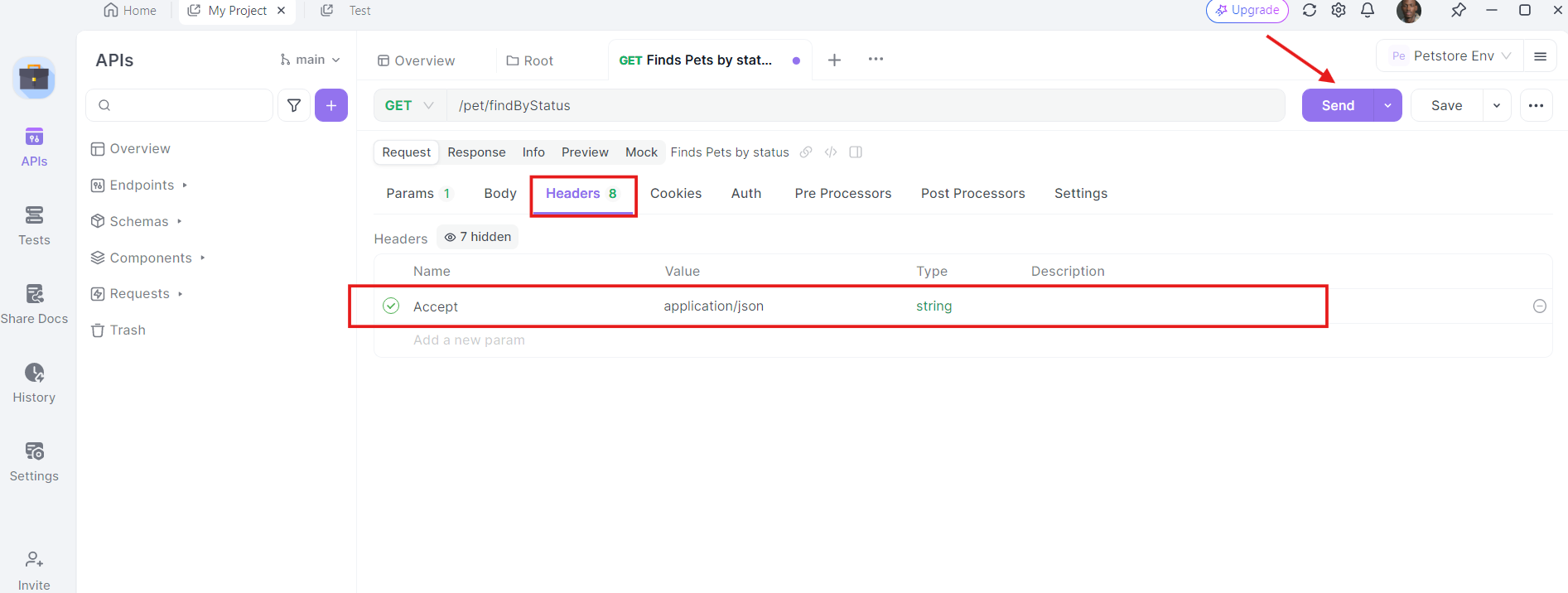

4. Tambahkan Header: Sekarang, saatnya untuk menambahkan header yang diperlukan. Klik tab "Headers" di apidog. Di sini, Anda dapat menentukan header apa pun yang diperlukan oleh API. Header umum untuk permintaan GET mungkin termasuk Authorization, Accept, dan User-Agent.

Contohnya:

- Authorization:

Bearer YOUR_ACCESS_TOKEN - Accept:

application/json

5. Kirim Permintaan dan Periksa Respons: Dengan URL, parameter kueri, dan header di tempatnya, Anda sekarang dapat mengirim permintaan API. Klik tombol "Send" dan apidog akan mengeksekusi permintaan. Anda akan melihat respons yang ditampilkan di bagian respons.

Setelah permintaan dikirim, Apidog akan menampilkan respons dari server. Anda dapat melihat kode status, header, dan isi respons. Ini sangat berharga untuk debugging dan memverifikasi bahwa panggilan API Anda berfungsi seperti yang diharapkan.

Praktik Terbaik untuk Menggunakan API Llama 3.1

Saat bekerja dengan API Llama 3.1, ingatlah praktik terbaik ini:

- Implementasikan Streaming: Untuk respons yang lebih panjang, Anda mungkin ingin mengimplementasikan streaming untuk menerima teks yang dihasilkan dalam potongan waktu nyata. Ini dapat meningkatkan pengalaman pengguna untuk aplikasi yang membutuhkan umpan balik segera.

- Hormati Batas Tarif: Sadari dan patuhi batas tarif yang ditetapkan oleh penyedia API Anda untuk menghindari gangguan layanan.

- Implementasikan Caching: Untuk perintah atau kueri yang sering digunakan, implementasikan sistem caching untuk mengurangi panggilan API dan meningkatkan waktu respons.

- Pantau Penggunaan: Lacak penggunaan API Anda untuk mengelola biaya dan memastikan Anda berada dalam kuota yang dialokasikan.

- Keamanan: Jangan pernah mengekspos kunci API Anda dalam kode sisi klien. Selalu lakukan panggilan API dari lingkungan server yang aman.

- Penyaringan Konten: Implementasikan penyaringan konten pada perintah input dan output yang dihasilkan untuk memastikan penggunaan model yang sesuai.

- Penyetelan Halus: Pertimbangkan untuk menyetel halus model pada data khusus domain jika Anda mengerjakan aplikasi khusus.

- Pemberian Versi: Lacak versi model Llama 3.1 tertentu yang Anda gunakan, karena pembaruan dapat memengaruhi perilaku dan output model.

Kasus Penggunaan Dunia Nyata

Mari kita lihat beberapa kasus penggunaan dunia nyata di mana mengintegrasikan Llama 3.1 dengan API dapat menjadi pengubah permainan:

1. Analisis Sentimen

Jika Anda menjalankan proyek analisis sentimen, Llama 3.1 dapat membantu Anda mengklasifikasikan teks sebagai positif, negatif, atau netral. Dengan mengintegrasikannya dengan API, Anda dapat mengotomatiskan analisis volume data yang besar, seperti ulasan pelanggan atau posting media sosial.

2. Chatbot

Membangun chatbot? Kemampuan pemrosesan bahasa alami Llama 3.1 dapat meningkatkan pemahaman dan respons chatbot Anda. Dengan menggunakan API, Anda dapat mengintegrasikannya dengan mulus dengan kerangka kerja chatbot Anda dan memberikan interaksi waktu nyata.

3. Pengenalan Gambar

Untuk proyek visi komputer, Llama 3.1 dapat melakukan tugas pengenalan gambar. Dengan memanfaatkan API, Anda dapat mengunggah gambar, mendapatkan klasifikasi waktu nyata, dan mengintegrasikan hasilnya ke dalam aplikasi Anda.

Memecahkan Masalah Umum

Terkadang segala sesuatunya tidak berjalan sesuai rencana. Berikut adalah beberapa masalah umum yang mungkin Anda temui dan cara memecahkannya:

1. Kesalahan Otentikasi

Jika Anda mendapatkan kesalahan otentikasi, periksa kembali kunci API Anda dan pastikan dikonfigurasi dengan benar di Apidog.

2. Masalah Jaringan

Masalah jaringan dapat menyebabkan panggilan API gagal. Pastikan koneksi internet Anda stabil dan coba lagi. Jika masalah berlanjut, periksa halaman status penyedia API untuk setiap pemadaman.

3. Pembatasan Tarif

Penyedia API sering memberlakukan batas tarif untuk mencegah penyalahgunaan. Jika Anda melebihi batas, Anda harus menunggu sebelum membuat lebih banyak permintaan. Pertimbangkan untuk mengimplementasikan logika coba lagi dengan backoff eksponensial untuk menangani pembatasan tarif dengan baik.

Rekayasa Prompt dengan Llama 3.1 405B

Untuk mendapatkan hasil terbaik dari Llama 3.1 405B, Anda perlu bereksperimen dengan berbagai perintah dan parameter. Pertimbangkan faktor-faktor seperti:

- Rekayasa prompt: Buat prompt yang jelas dan spesifik untuk memandu output model.

- Suhu: Sesuaikan parameter ini untuk mengontrol keacakan output.

- Token maks: Tetapkan batas yang sesuai untuk panjang teks yang dihasilkan.

Kesimpulan

Llama 3.1 405B mewakili kemajuan signifikan di bidang model bahasa besar, menawarkan kemampuan yang belum pernah terjadi sebelumnya dalam paket sumber terbuka. Dengan memanfaatkan kekuatan model ini melalui API yang disediakan oleh berbagai penyedia cloud, pengembang dan bisnis dapat membuka kemungkinan baru dalam aplikasi berbasis AI.

Masa depan AI adalah terbuka, dan dengan alat seperti Llama 3.1 yang kita miliki, kemungkinannya hanya dibatasi oleh imajinasi dan kecerdikan kita. Saat Anda menjelajahi dan bereksperimen dengan model yang kuat ini, Anda tidak hanya menggunakan alat – Anda berpartisipasi dalam revolusi kecerdasan buatan yang sedang berlangsung, membantu membentuk masa depan bagaimana kita berinteraksi dengan dan memanfaatkan kecerdasan mesin.