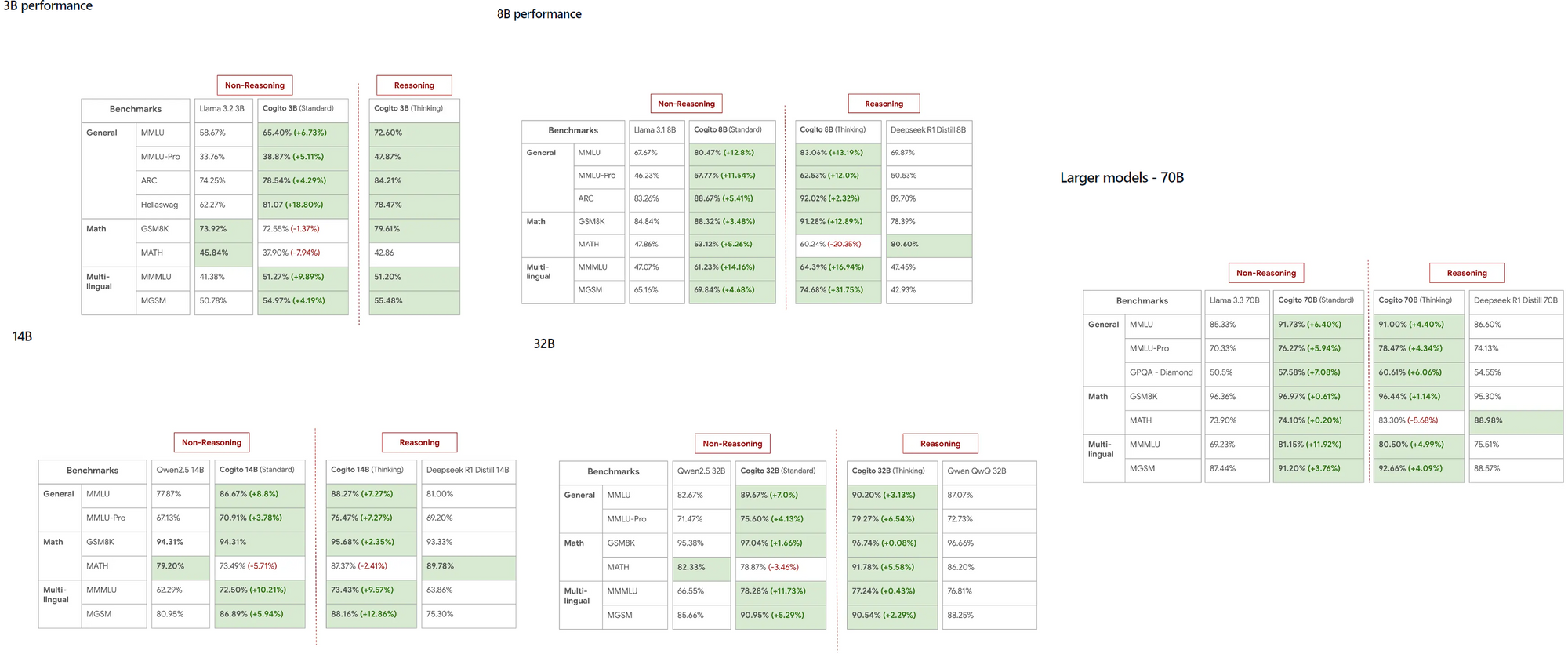

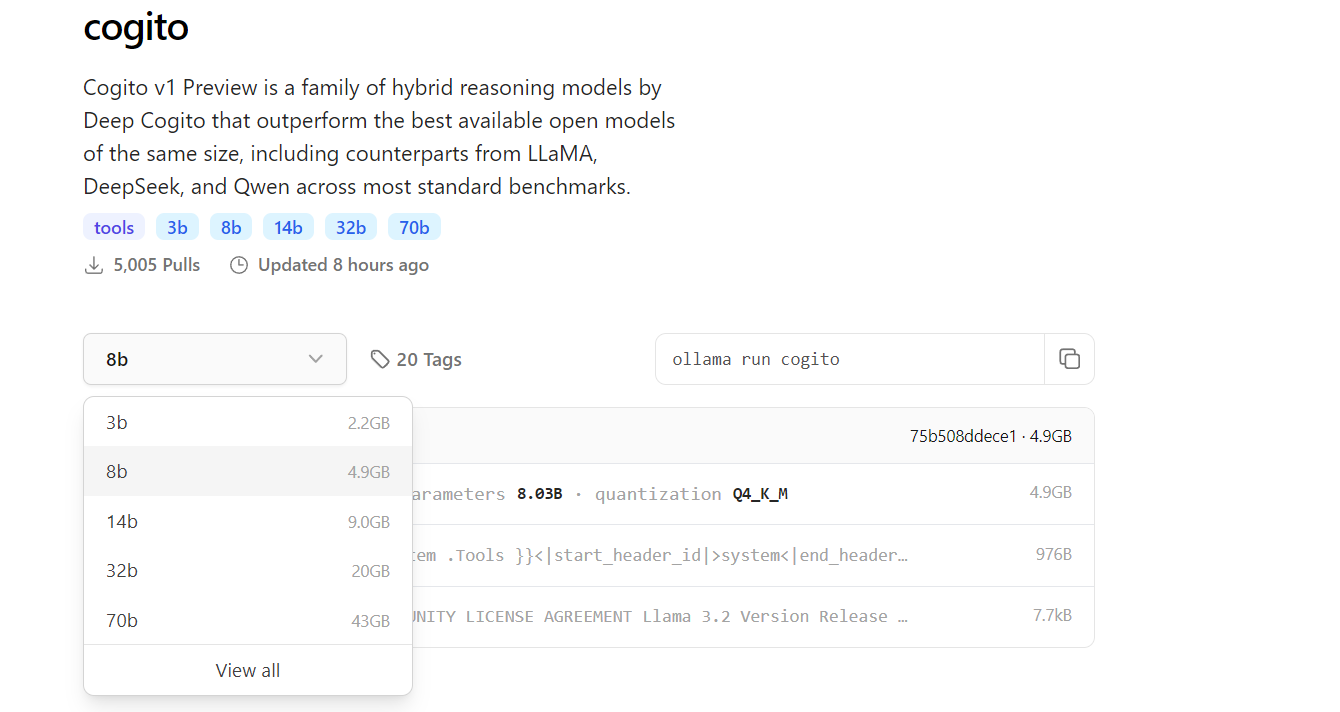

Model Cogito, yang diluncurkan oleh DeepCogito, dengan cepat mendapatkan perhatian di komunitas AI karena kemampuannya yang luar biasa untuk mengungguli model-model yang sudah mapan seperti LLaMA dan DeepSeek di berbagai skala. Model-model sumber terbuka ini, mulai dari 3B hingga 70B parameter, memberi pengembang alat yang ampuh untuk menjelajahi superinteligensi umum secara langsung di mesin lokal mereka.

Apa yang Perlu Anda Ketahui Tentang Cogito dan Ollama

Cogito mewakili serangkaian model AI sumber terbuka yang dikembangkan oleh tim DeepCogito, dengan fokus yang jelas untuk mencapai superinteligensi umum. Model-model ini memanfaatkan teknik yang disebut iterated distillation and amplification (IDA), yang secara iteratif meningkatkan kemampuan penalaran model dengan menggunakan lebih banyak komputasi untuk mencapai solusi yang lebih baik dan kemudian menyuling proses itu ke dalam parameter model. Tersedia dalam ukuran seperti 3B, 8B, 14B, 32B, dan 70B, model Cogito akan diperluas lebih lanjut dengan rilis model 109B dan 400B parameter yang akan datang.

Di sisi lain, Ollama adalah kerangka kerja serbaguna yang memungkinkan pengembang untuk menjalankan LLM secara lokal di mesin mereka, menghilangkan kebutuhan akan API berbasis cloud. Mendukung berbagai platform seperti MacOS, Windows, dan Linux, Ollama memastikan aksesibilitas untuk berbagai pengguna. Dengan menjalankan Cogito secara lokal dengan Ollama, Anda dapat bereksperimen dengan model AI canggih di perangkat, yang tidak hanya menghemat biaya tetapi juga meningkatkan privasi data untuk aplikasi sensitif.

Mengapa Menjalankan Cogito Secara Lokal?

Menjalankan Cogito secara lokal menawarkan beberapa keuntungan bagi pengembang. Pertama, ini menghilangkan ketergantungan pada API eksternal, yang mengurangi latensi dan memastikan bahwa data Anda tetap pribadi. Ini sangat penting untuk aplikasi di mana keamanan data adalah prioritas. Selain itu, model Cogito telah menunjukkan kinerja yang lebih unggul dibandingkan pesaing seperti LLaMA 4 Scout, bahkan pada skala yang lebih kecil, menjadikannya pilihan yang sangat baik untuk tugas-tugas berkinerja tinggi.

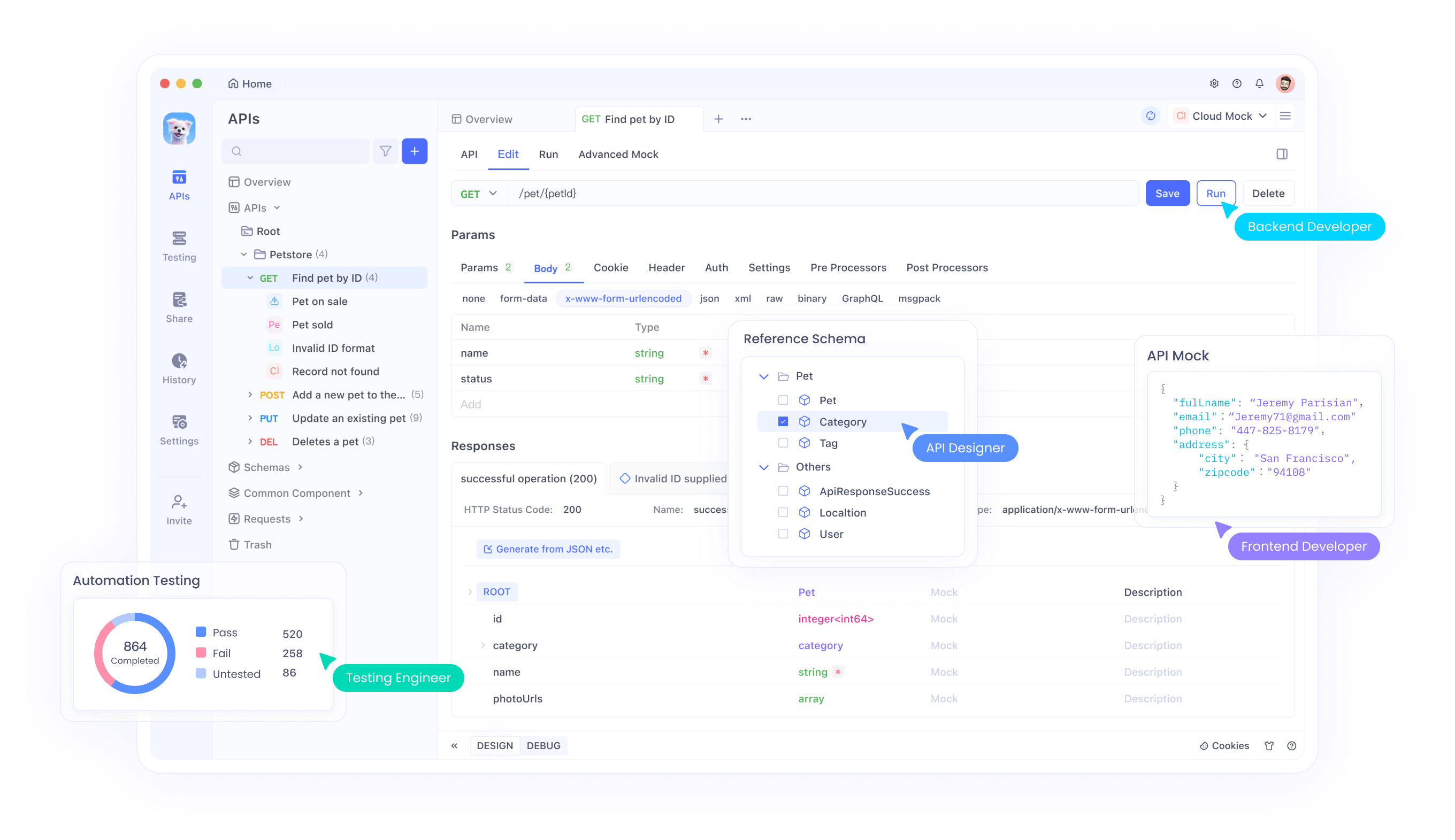

Eksekusi lokal juga ideal untuk pengembang yang bekerja di lingkungan dengan sumber daya terbatas atau area dengan akses internet terbatas, karena memungkinkan operasi tanpa hambatan tanpa konektivitas. Selain itu, antarmuka baris perintah Ollama yang mudah menyederhanakan proses pengelolaan dan menjalankan beberapa model, termasuk Cogito. Akhirnya, pengaturan lokal memungkinkan iterasi yang lebih cepat selama pengembangan, terutama saat menguji integrasi API, yang dapat dikelola secara efisien menggunakan alat seperti Apidog untuk mendesain dan men-debug titik akhir Anda.

Prasyarat untuk Menjalankan Cogito dengan Ollama

Sebelum menyelami proses penyiapan, pastikan sistem Anda memenuhi persyaratan yang diperlukan. Untuk model yang lebih kecil seperti versi parameter 3B atau 8B, mesin Anda harus memiliki setidaknya 16GB RAM, sementara model yang lebih besar seperti 70B mungkin memerlukan 64GB atau lebih untuk berjalan dengan lancar. GPU yang kompatibel, seperti kartu NVIDIA dengan dukungan CUDA, sangat direkomendasikan karena secara signifikan mempercepat inferensi model.

Anda juga perlu menginstal Python 3.8 atau lebih tinggi, karena ini adalah dependensi untuk pustaka Python Ollama dan alat terkait lainnya.

Selanjutnya, unduh dan instal Ollama dari situs web resminya atau repositori GitHub, ikuti instruksi khusus untuk sistem operasi Anda. Penyimpanan adalah faktor penting lainnya—model Cogito dapat berkisar dari beberapa gigabyte untuk model 3B hingga lebih dari 100GB untuk model 70B, jadi pastikan sistem Anda memiliki ruang yang cukup. Terakhir, jika Anda berencana untuk mengintegrasikan Cogito dengan API, menginstal Apidog akan membantu Anda mendesain dan menguji titik akhir API Anda secara efisien, memastikan pengalaman pengembangan yang lancar.

Langkah 1: Instal Ollama di Mesin Anda

Langkah pertama dalam menjalankan Cogito secara lokal adalah menginstal Ollama di mesin Anda. Mulailah dengan mengunjungi situs web Ollama atau halaman GitHub untuk mengunduh penginstal untuk sistem operasi Anda. Untuk pengguna MacOS dan Windows, cukup jalankan penginstal dan ikuti petunjuk di layar untuk menyelesaikan penyiapan. Jika Anda menggunakan Linux, Anda dapat menginstal Ollama secara langsung dengan menjalankan perintah :

curl -fsSL https://ollama.com/install.sh | sh di terminal Anda.

Setelah instalasi selesai, buka terminal dan ketik ollama --version untuk mengonfirmasi bahwa Ollama telah diinstal dengan benar.

Untuk memastikan Ollama berjalan, jalankan ollama serve, yang memulai server lokal untuk manajemen model. Langkah ini juga menyiapkan antarmuka baris perintah Ollama, yang akan Anda gunakan untuk menarik dan menjalankan model seperti Cogito di langkah-langkah berikut.

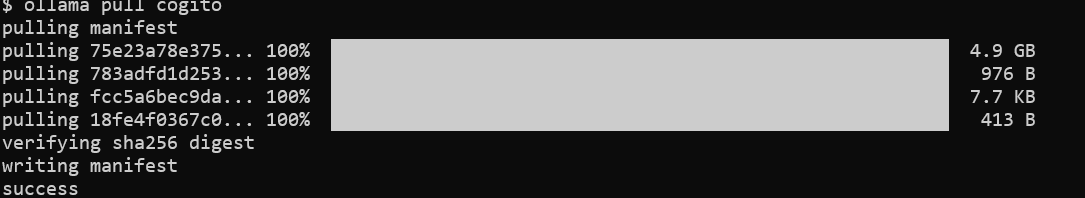

Langkah 2: Tarik Model Cogito dari Pustaka Ollama

Dengan Ollama terinstal, langkah selanjutnya adalah mengunduh model Cogito. Buka terminal Anda dan jalankan perintah ollama pull cogito untuk mengambil model Cogito dari pustaka Ollama.

Secara default, perintah ini menarik versi terbaru dari model Cogito, tetapi Anda dapat menentukan ukuran tertentu dengan menggunakan tag, seperti ollama pull cogito:3b untuk model parameter 3B. Anda dapat menjelajahi ukuran model yang tersedia di https://ollama.com/library/cogito.

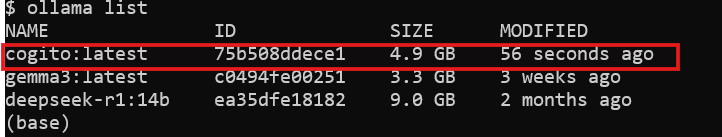

Tergantung pada kecepatan internet Anda dan ukuran model, proses pengunduhan mungkin memakan waktu—harapkan sekitar 2.2GB untuk model 3B dan hingga 43GB untuk model 70B. Setelah pengunduhan selesai, verifikasi bahwa model tersedia di sistem Anda dengan menjalankan ollama list, yang menampilkan semua model yang terinstal. Pada titik ini, Cogito siap untuk dijalankan secara lokal, dan Anda dapat melanjutkan ke langkah berikutnya.

Langkah 3: Jalankan Cogito Secara Lokal dengan Ollama

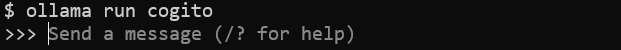

Sekarang model telah diunduh, Anda dapat mulai menjalankan Cogito di mesin Anda. Di terminal Anda, jalankan perintah ollama run cogito untuk meluncurkan model Cogito.

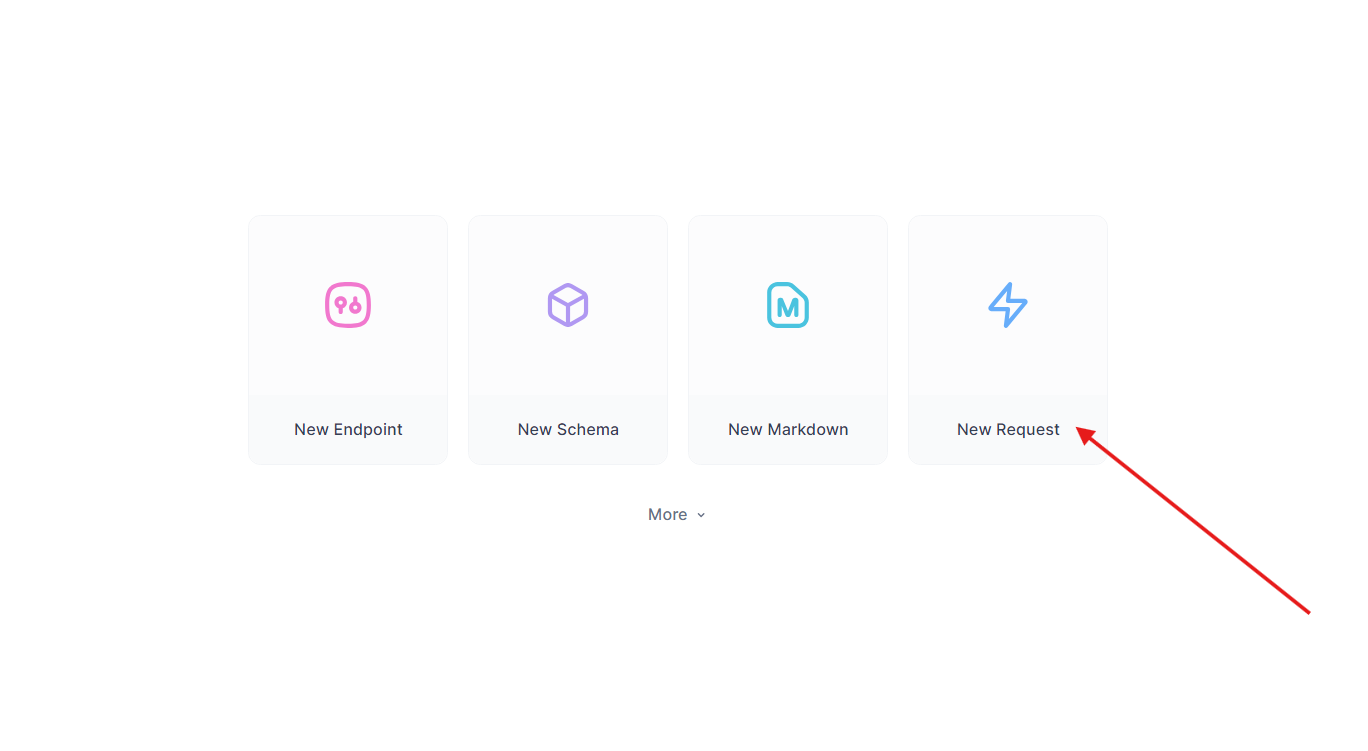

Langkah 4: Tingkatkan Pengujian API dengan Apidog

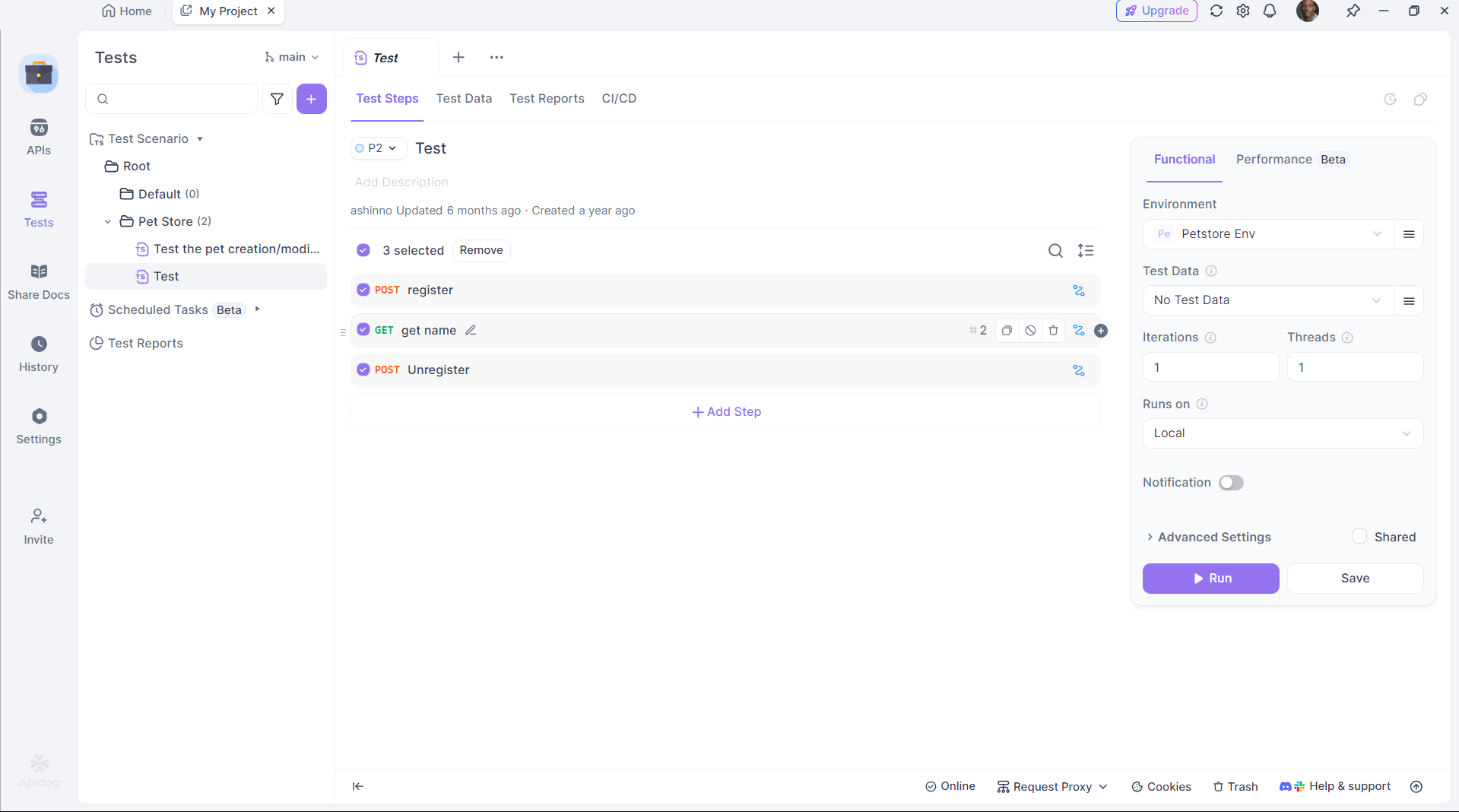

Cogito unggul dalam menghasilkan kode API, tetapi menguji API tersebut sangat penting. Apidog menyederhanakan proses ini:

Instal Apidog:

Unduh dan instal Apidog dari situs resminya.

Uji API yang Dihasilkan:

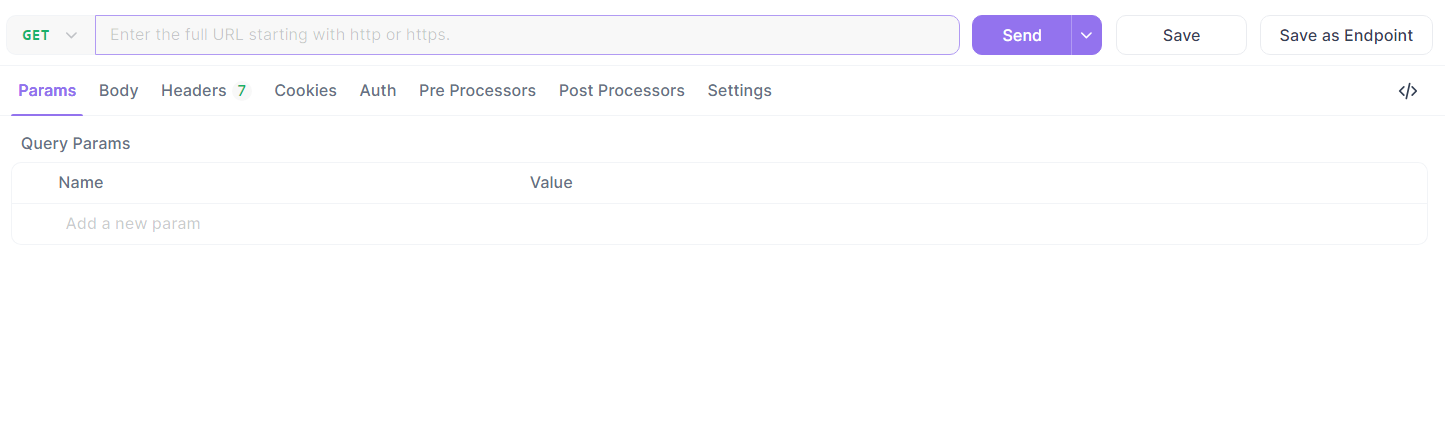

Ambil titik akhir Flask dari sebelumnya. Di Apidog:

- Buat permintaan baru.

- Atur URL ke

http://localhost:5000/api/datadan Kirim permintaan GET.

- Verifikasi respons:

{"message": "Hello, World!"}.

Otomatiskan Pengujian:

Gunakan skrip Apidog untuk mengotomatiskan validasi, memastikan output DeepCoder memenuhi harapan.

Apidog menjembatani kesenjangan antara pembuatan kode dan penerapan, meningkatkan produktivitas.

Memecahkan Masalah Umum

Menjalankan Cogito secara lokal terkadang dapat menimbulkan tantangan, tetapi sebagian besar masalah dapat diselesaikan dengan beberapa pemeriksaan. Jika Ollama gagal memulai, verifikasi bahwa tidak ada proses lain yang menggunakan port 11434—Anda dapat menghentikan proses yang bertentangan atau mengubah port dalam konfigurasi Ollama. Untuk kesalahan "kehabisan memori", pertimbangkan untuk mengurangi ukuran model atau meningkatkan ruang swap sistem Anda untuk mengakomodasi model yang lebih besar. Jika model tidak merespons, pastikan Anda telah menariknya dengan benar menggunakan ollama pull cogito dan bahwa itu muncul di output ollama list. Waktu inferensi yang lambat sering menunjukkan bahwa Anda menjalankan hanya pada CPU—periksa dukungan GPU dengan menjalankan nvidia-smi untuk mengonfirmasi bahwa CUDA aktif.

Saat menggunakan Apidog untuk integrasi API, kesalahan mungkin timbul dari payload JSON yang salah, jadi periksa kembali skema Anda di editor Apidog. Untuk diagnostik yang lebih rinci, tinjau log Ollama di ~/.ollama/logs untuk mengidentifikasi dan menyelesaikan masalah dengan cepat.

Kesimpulan

Menjalankan Cogito secara lokal dengan Ollama membuka dunia kemungkinan bagi pengembang yang ingin menjelajahi superinteligensi umum. Dengan mengikuti langkah-langkah yang diuraikan dalam panduan ini, Anda dapat menyiapkan Cogito di mesin Anda, mengoptimalkan kinerjanya, dan bahkan mengintegrasikannya ke dalam aplikasi yang lebih besar menggunakan API yang dikelola dengan Apidog. Apakah Anda sedang membangun sistem RAG, asisten pengkodean, atau aplikasi web, kemampuan canggih Cogito menjadikannya alat yang ampuh untuk inovasi. Saat tim DeepCogito terus merilis model yang lebih besar dan menyempurnakan teknik mereka, potensi untuk pengembangan AI lokal hanya akan tumbuh, memberdayakan pengembang untuk menciptakan solusi terobosan.