Apakah Anda ingin mengobrol dengan model bahasa canggih seperti Llama 3.1 atau Mistral tanpa terjebak di terminal? Open WebUI adalah tiket Anda menuju antarmuka yang ramping, mirip ChatGPT, yang membuat interaksi dengan LLM Ollama menjadi menyenangkan dan intuitif. Ini memungkinkan Anda menyimpan riwayat obrolan, menyimpan prompt, dan bahkan mengunggah dokumen untuk respons yang lebih cerdas—semua di browser Anda. Dalam panduan ramah pemula ini, saya akan memandu Anda menginstal Ollama, menguji model di terminal, dan kemudian meningkatkan pengalaman dengan Open WebUI untuk antarmuka yang lebih ramah pengguna. Kita akan menggunakan Docker untuk pengaturan cepat dan mengujinya dengan prompt yang menyenangkan. Siap membuat obrolan AI menjadi mudah? Mari kita mulai!

Apa itu Open WebUI? Pusat Komando LLM Anda

Open WebUI adalah antarmuka web sumber terbuka yang di-host sendiri yang terhubung ke Ollama, memungkinkan Anda berinteraksi dengan model bahasa besar (LLM) seperti Llama 3.1 atau Mistral dalam dasbor berbasis browser. Berbeda dengan antarmuka baris perintah Ollama, Open WebUI terasa seperti ChatGPT, menawarkan:

- Riwayat Obrolan: Simpan dan tinjau kembali percakapan Anda.

- Penyimpanan Prompt: Simpan dan gunakan kembali prompt favorit Anda.

- Unggahan Dokumen: Tambahkan file untuk respons yang sadar konteks (Retrieval-Augmented Generation, atau RAG).

- Penggantian Model: Ganti antar model dengan mudah dalam satu klik.

Dengan lebih dari 50K bintang di GitHub, Open WebUI sangat populer di kalangan pengembang dan penggemar AI yang menginginkan cara kolaboratif dan grafis untuk bekerja dengan LLM secara lokal. Pertama, mari kita jalankan Ollama untuk melihat mengapa Open WebUI layak ditambahkan!

Menginstal dan Menguji Ollama

Sebelum kita masuk ke Open WebUI, mari kita siapkan Ollama dan uji model seperti Llama 3.1 atau Mistral di terminal. Ini memberi Anda dasar untuk menghargai antarmuka intuitif Open WebUI.

1. Periksa Persyaratan Sistem:

- OS: Windows, macOS, atau Linux (Ubuntu 24.04 atau yang serupa).

- Perangkat Keras: Setidaknya 16GB RAM dan 10GB penyimpanan kosong untuk model (Llama 3.1 8B membutuhkan ~5GB). GPU (misalnya, NVIDIA 1060 4GB) bersifat opsional untuk kinerja yang lebih cepat.

- Perangkat Lunak: Ollama, dapat diunduh dari ollama.com.

2. Instal Ollama: Unduh dan instal Ollama dari ollama.com untuk OS Anda. Ikuti petunjuk penginstal—pengaturannya cepat. Verifikasi instalasi dengan:

ollama --version

Harapkan versi seperti 0.1.44 (April 2025). Jika gagal, pastikan Ollama ada di PATH Anda.

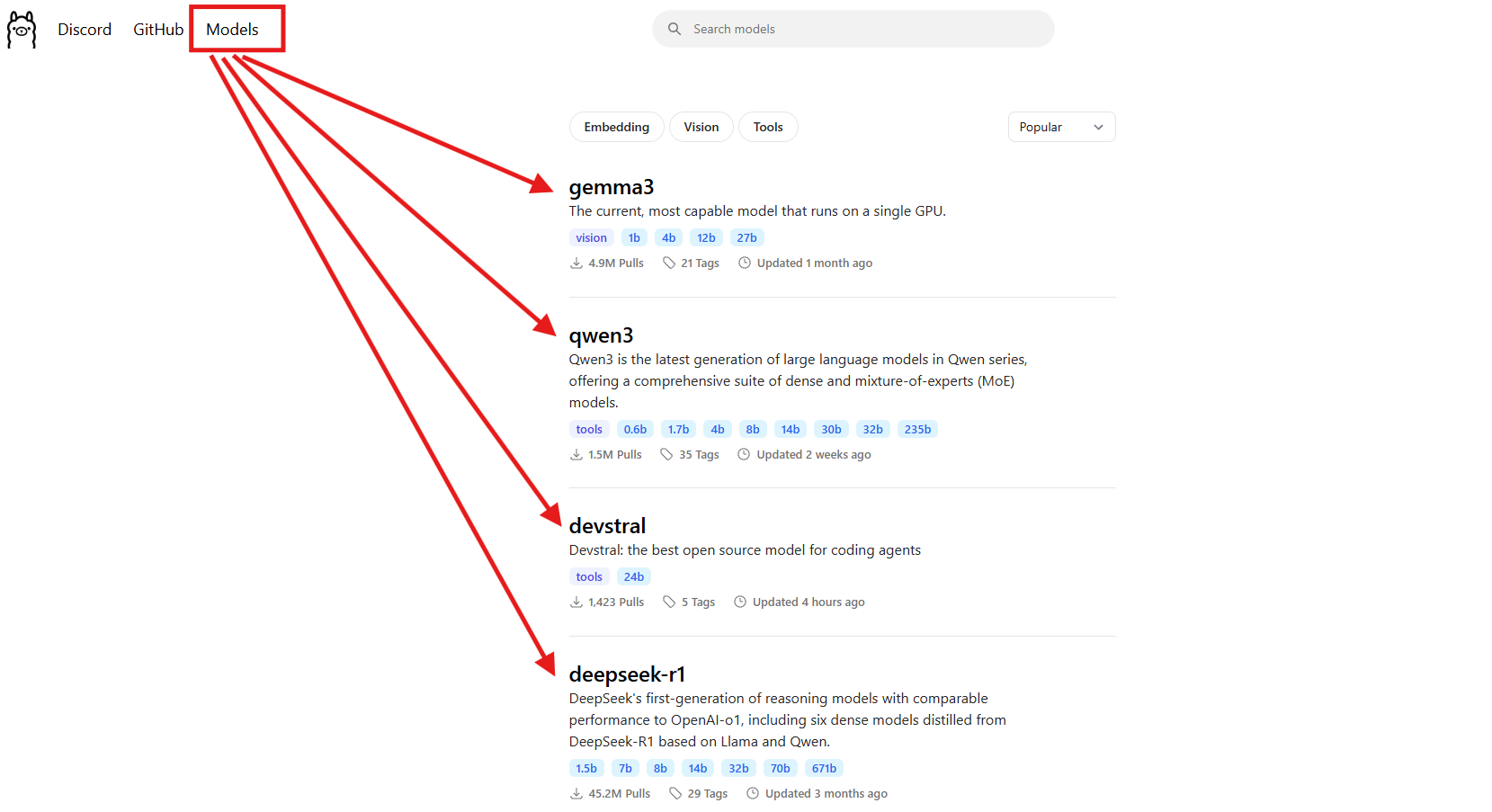

3. Unduh Model: Pilih model seperti Llama 3.1 (8B) atau Mistral (7B). Untuk panduan ini, kita akan menggunakan Llama 3.1:

ollama pull llama3.1

Ini mengunduh sekitar 5GB, jadi ambil kopi jika internet Anda lambat. Periksa apakah sudah terinstal:

ollama list

Cari llama3.1:latest. Mistral (ollama pull mistral) adalah pilihan bagus lainnya jika Anda menginginkan model yang lebih ringan (~4GB).

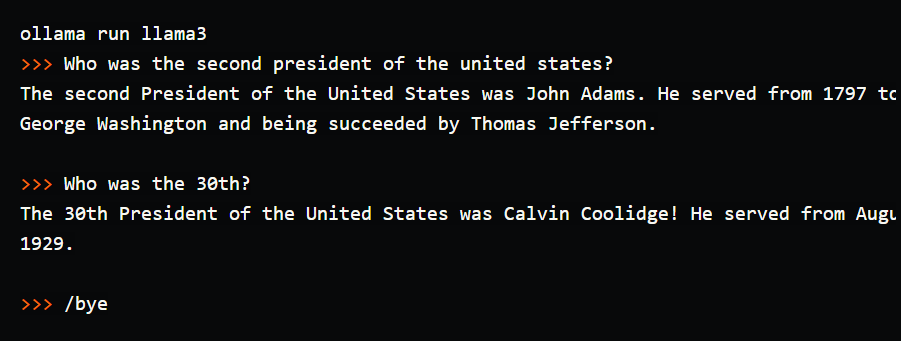

4. Uji Model di Terminal: Coba prompt sederhana untuk melihat Ollama beraksi:

ollama run llama3.1

Di prompt (>>>), ketik: "Ceritakan lelucon ayah tentang komputer." Tekan Enter. Anda mungkin mendapatkan: "Mengapa komputer pergi ke dokter? Karena terkena virus!" Keluar dengan /bye. Saya menjalankan ini dan mendapatkan lelucon yang lucu, tetapi mengetik di terminal terasa canggung—tidak ada riwayat obrolan, tidak ada prompt tersimpan. Di sinilah Open WebUI bersinar, menawarkan antarmuka visual untuk menyimpan percakapan, menggunakan kembali prompt, dan mengunggah dokumen untuk respons yang lebih kaya. Mari kita siapkan!

Menyiapkan Lingkungan Anda untuk Open WebUI

Sekarang Anda telah melihat antarmuka terminal Ollama, mari kita persiapkan Open WebUI untuk membuat pengalaman LLM Anda lebih intuitif. Kita akan mengasumsikan Anda telah menginstal Docker, karena ini diperlukan untuk pengaturan Open WebUI.

1. Verifikasi Docker: Pastikan Docker terinstal dan berjalan:

docker --version

Harapkan sesuatu seperti Docker 27.4.0. Jika Anda tidak memiliki Docker, unduh dan instal Docker Desktop dari situs web resmi mereka—pengaturannya cepat untuk Windows, macOS, atau Linux.

2. Buat Folder Proyek: Jaga semuanya tetap terorganisir:

mkdir ollama-webui

cd ollama-webui

Folder ini akan menjadi dasar Anda untuk menjalankan Open WebUI.

3. Pastikan Ollama Berjalan: Mulai Ollama di terminal terpisah:

ollama serve

Ini menjalankan API Ollama di http://localhost:11434. Biarkan terminal ini terbuka, karena Open WebUI membutuhkannya untuk terhubung ke model Anda.

Menginstal Open WebUI dengan Docker

Dengan Ollama dan Llama 3.1 siap, mari kita instal Open WebUI menggunakan satu perintah Docker untuk pengaturan yang cepat dan andal.

1. Jalankan Open WebUI: Di folder ollama-webui Anda, jalankan:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

Perintah ini:

- Mengunduh image Open WebUI (

ghcr.io/open-webui/open-webui:main, ~3.77GB). - Memetakan port 3000 (lokal) ke 8080 (kontainer) untuk akses browser.

- Menambahkan

host.docker.internaluntuk terhubung ke API Ollama dilocalhost:11434. - Menggunakan volume (

open-webui) untuk mempertahankan riwayat obrolan dan pengaturan. - Memberi nama kontainer

open-webuidan mengaturnya untuk memulai ulang secara otomatis.

Ini membutuhkan waktu sebentar untuk mengunduh. Periksa apakah sedang berjalan dengan docker ps—cari kontainer open-webui.

2. Akses Open WebUI: Buka browser Anda dan buka http://localhost:3000. Anda akan melihat halaman selamat datang Open WebUI. Klik "Sign Up" untuk membuat akun (pengguna pertama mendapatkan hak admin). Gunakan kata sandi yang kuat dan simpan dengan aman. Sekarang Anda siap untuk mengobrol! Jika halaman tidak dimuat, pastikan kontainer berjalan (docker logs open-webui) dan port 3000 kosong.

Menggunakan Open WebUI: Mengobrol dan Menjelajahi Fitur

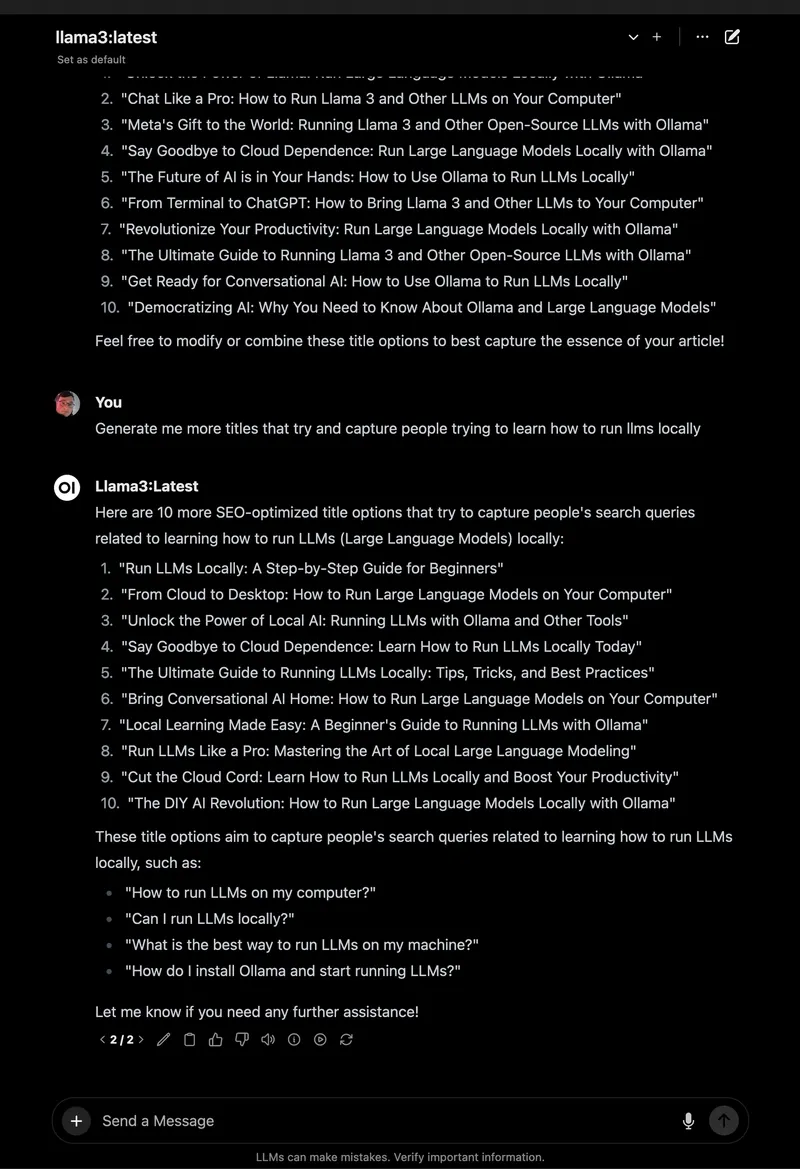

Dengan Open WebUI berjalan, mari kita mulai mengobrol dengan Llama 3.1 dan menjelajahi fitur-fiturnya yang luar biasa, yang menjadikannya peningkatan besar dibandingkan terminal.

1. Mulai Mengobrol:

- Di Open WebUI, pilih

llama3.1:8bdari pemilih model di kiri atas (seharusnya muncul karena Anda sudah mengunduhnya). - Klik "New Chat" di bilah sisi.

- Masukkan prompt yang sama: "Ceritakan lelucon ayah tentang komputer."

- Tekan Enter. Anda akan mendapatkan respons seperti: "Mengapa komputer pergi ke sekolah seni? Karena ingin belajar menggambar 'byte' yang lebih baik!"

Antarmukanya bersih, dengan prompt dan respons Anda tersimpan secara otomatis di riwayat obrolan.

2. Simpan dan Atur Obrolan: Di bilah sisi kiri, klik ikon pin untuk menyimpan obrolan. Ganti namanya (misalnya, "Lelucon Ayah") agar mudah diakses. Anda dapat mengarsipkan atau menghapus obrolan melalui bilah sisi, menjaga eksperimen Anda tetap terorganisir—jauh lebih baik daripada menggulir terminal!

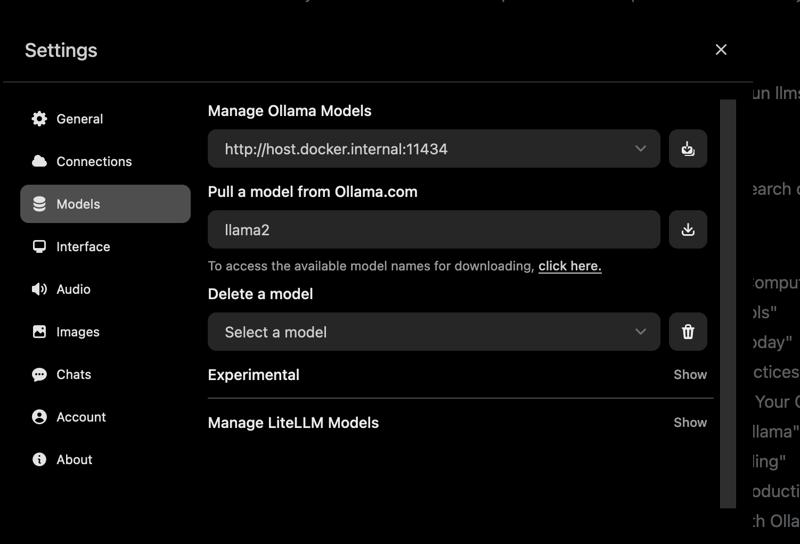

3. Simpan Prompt: Simpan prompt lelucon ayah untuk digunakan kembali:

- Buka Settings > Prompts.

- Klik "New Prompt," beri nama "Lelucon Ayah," dan tempel: "Ceritakan lelucon ayah tentang komputer."

- Simpan. Sekarang Anda dapat menerapkannya di obrolan apa pun dengan satu klik.

4. Unggah Dokumen untuk RAG: Tambahkan konteks ke obrolan Anda:

- Klik ikon "#" di input obrolan untuk membuka perpustakaan dokumen.

- Unggah file teks (misalnya, panduan Spring Boot 3.2).

- Tanyakan: "Bagaimana cara menggunakan REST Client di Spring Boot 3.2?" Llama 3.1 akan merujuk dokumen, memberikan cuplikan kode seperti

RestClient.create().get().uri("/users").retrieve().

Saya menguji ini dengan PDF tutorial Python, dan Open WebUI berhasil memberikan jawaban yang sadar konteks, tidak seperti respons dasar di terminal.

5. Jelajahi Fitur Lainnya:

- Ganti Model: Gunakan pemilih model untuk mencoba Mistral atau model lain yang telah Anda unduh (

ollama pull mistral). - Sesuaikan Respons: Klik "Chat Control" untuk menyesuaikan nada (misalnya, "lucu") atau panjang.

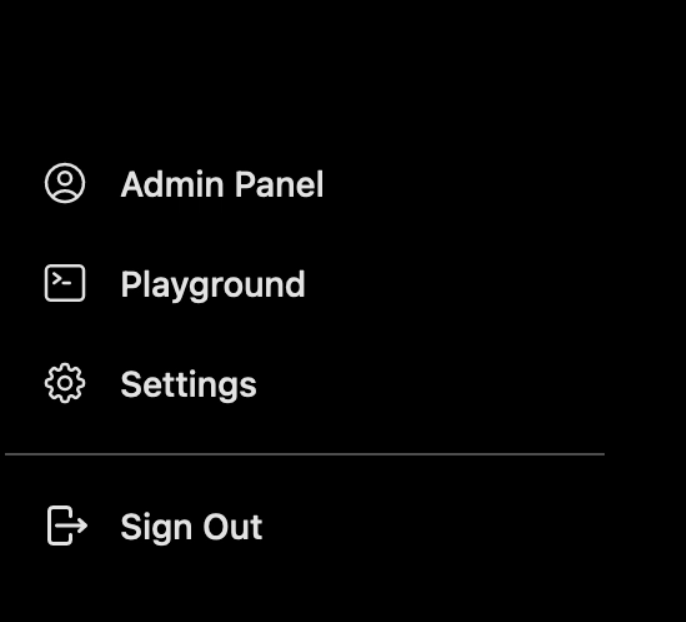

- Alat Admin: Di Settings > Admin, kelola pengguna atau batasi akses model (bagus untuk tim).

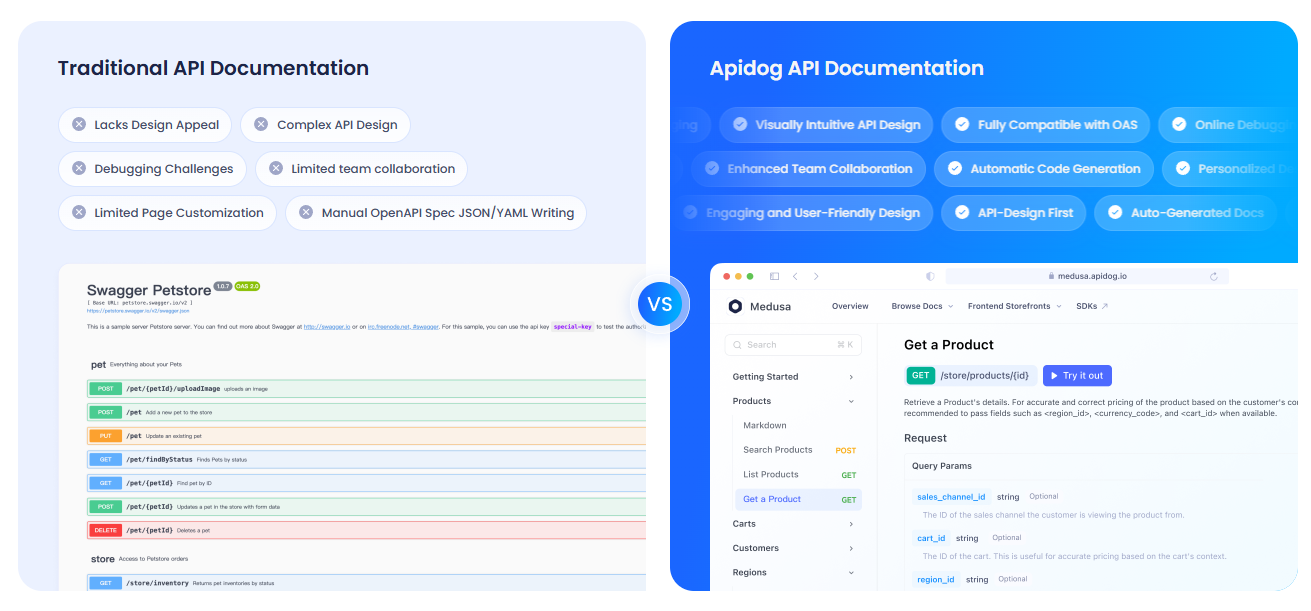

Mendokumentasikan API Anda dengan APIdog

Menggunakan Open WebUI untuk berinteraksi dengan API Ollama dan ingin mendokumentasikan pengaturan Anda? APIdog adalah alat yang fantastis untuk membuat dokumentasi API yang interaktif. Antarmukanya yang ramping dan opsi self-hosting menjadikannya ideal untuk berbagi proyek AI Anda—lihatlah!

Pemecahan Masalah dan Tips

- Masalah Koneksi: Jika Open WebUI tidak dapat menemukan Ollama, pastikan

ollama serveberjalan dan port 11434 terbuka. Periksa log Docker:docker logs open-webui. - Konflik Port: Jika port 3000 sudah digunakan, hentikan kontainer (

docker stop open-webui), hapus (docker rm open-webui), dan jalankan kembali perintahdocker rundengan port baru (misalnya,-p 3001:8080). - Respons Lambat: Gunakan GPU dengan tag

:cudaOllama atau model yang lebih kecil seperti Mistral untuk kecepatan. - Komunitas: Bergabunglah dengan Diskusi GitHub Open WebUI atau Discord untuk dukungan dan ide.

Mengapa Memilih Open WebUI?

Open WebUI mengubah Ollama dari alat terminal yang canggung menjadi platform yang kuat dan ramah pengguna:

- Antarmuka Intuitif: Dasbor berbasis browser sangat cocok untuk pemula dan profesional.

- Organisasi: Obrolan dan prompt yang tersimpan menjaga pekerjaan Anda tetap rapi, tidak seperti log terminal.

- Kesadaran Konteks: Unggahan dokumen memungkinkan RAG untuk jawaban yang lebih cerdas.

- Privasi: Berjalan secara lokal, menjaga data Anda tetap aman.

Setelah menguji terminal dan Open WebUI, saya yakin dengan kemudahan dan fitur GUI-nya. Ini seperti meningkatkan dari ponsel flip ke smartphone!

Kesimpulan: Petualangan Open WebUI Anda Menanti

Anda telah beralih dari obrolan terminal ke pengaturan Open WebUI lengkap dengan Ollama, membuat interaksi LLM menjadi lancar dan menyenangkan! Dengan Llama 3.1, obrolan tersimpan, dan unggahan dokumen, Anda siap menjelajahi AI tidak seperti sebelumnya. Coba model baru, simpan lebih banyak prompt, atau dokumentasikan API Anda dengan APIdog. Bagikan kemenangan Open WebUI Anda di GitHub Open WebUI—saya bersemangat melihat apa yang Anda buat! Selamat mencoba AI!