Menjalankan model bahasa besar (LLM) secara lokal dulunya adalah domain pengguna CLI hardcore dan pengutak-atik sistem. Tapi itu berubah dengan cepat. Ollama, yang dikenal dengan antarmuka baris perintahnya yang sederhana untuk menjalankan LLM sumber terbuka di mesin lokal, baru saja merilis aplikasi desktop asli untuk macOS dan Windows.

Dan itu bukan hanya pembungkus dasar. Aplikasi ini menghadirkan fitur-fitur canggih yang membuat obrolan dengan model, menganalisis dokumen, menulis dokumentasi, dan bahkan bekerja dengan gambar menjadi jauh lebih mudah bagi pengembang.

Dalam artikel ini, kita akan menjelajahi bagaimana pengalaman desktop baru meningkatkan alur kerja pengembang, fitur-fitur apa yang menonjol, dan di mana alat-alat ini benar-benar bersinar dalam kehidupan pengkodean sehari-hari.

Mengapa LLM Lokal Masih Penting

Meskipun alat berbasis cloud seperti ChatGPT, Claude, dan Gemini mendominasi berita utama, ada gerakan yang berkembang menuju pengembangan AI yang mengutamakan lokal. Pengembang menginginkan alat yang:

- Privat - Kode dan dokumen Anda tetap ada di mesin Anda.

- Dapat Disesuaikan - Anda memilih model, batas memori, dan perangkat keras.

- Ramah Offline - Tidak ada ketergantungan pada API eksternal atau waktu aktif.

- Cepat - Tidak ada latensi jaringan atau hambatan server.

Ollama memanfaatkan tren ini secara langsung, memungkinkan Anda menjalankan model seperti LLaMA, Mistral, Gemma, Codellama, Mixtral, dan lainnya secara native di mesin Anda - sekarang dengan pengalaman yang jauh lebih lancar.

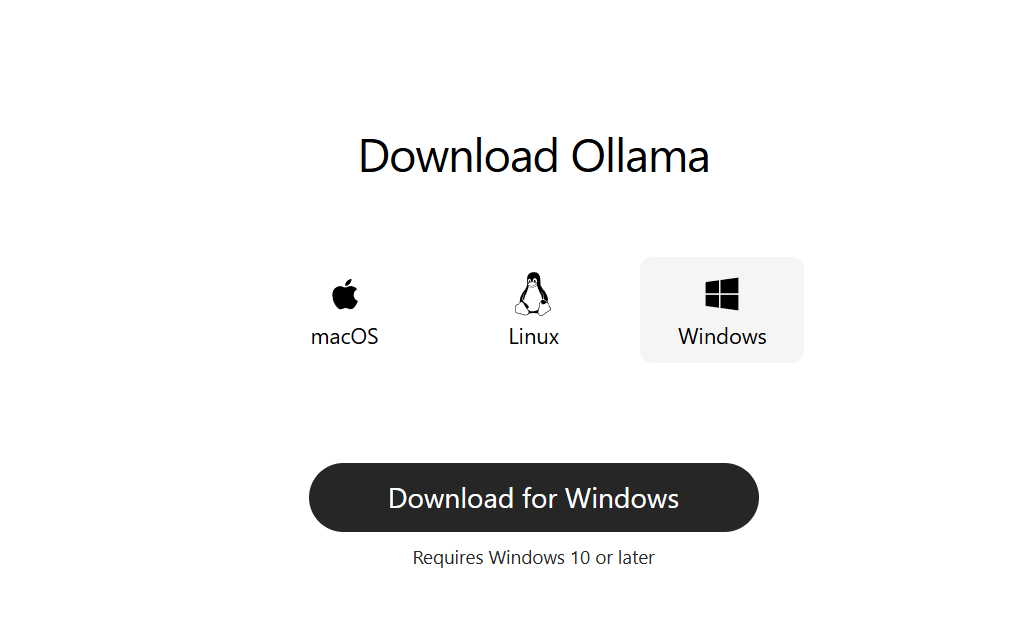

Langkah 1: Unduh Ollama untuk Desktop

Kunjungi ollama.com dan unduh versi terbaru untuk sistem Anda:

- macOS (Apple Silicon atau Intel)

- Windows 10/11 (x64)

Instal seperti aplikasi desktop biasa. Tidak diperlukan pengaturan baris perintah untuk memulai.

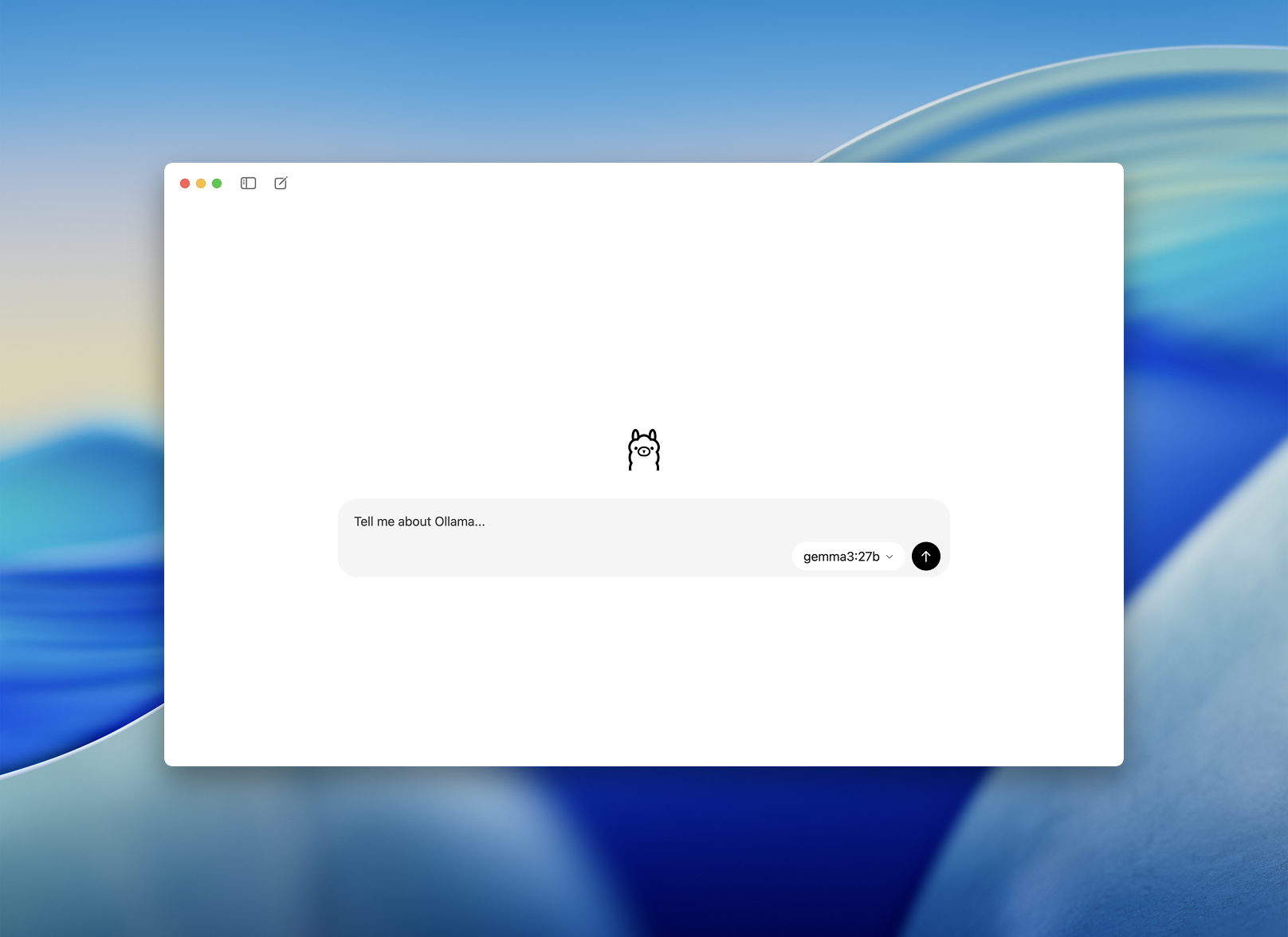

Langkah 2: Luncurkan dan Pilih Model

Setelah terinstal, buka aplikasi desktop Ollama. Antarmukanya bersih dan terlihat seperti jendela obrolan sederhana.

Anda akan diminta untuk memilih model untuk diunduh dan dijalankan. Beberapa opsi termasuk:

llama3– asisten serbagunacodellama– bagus untuk pembuatan dan refactoring kodemistral– cepat, kecil, dan akuratgemma– model open-weight yang didukung Google

Pilih salah satu dan aplikasi akan secara otomatis mengunduh dan memuatnya.

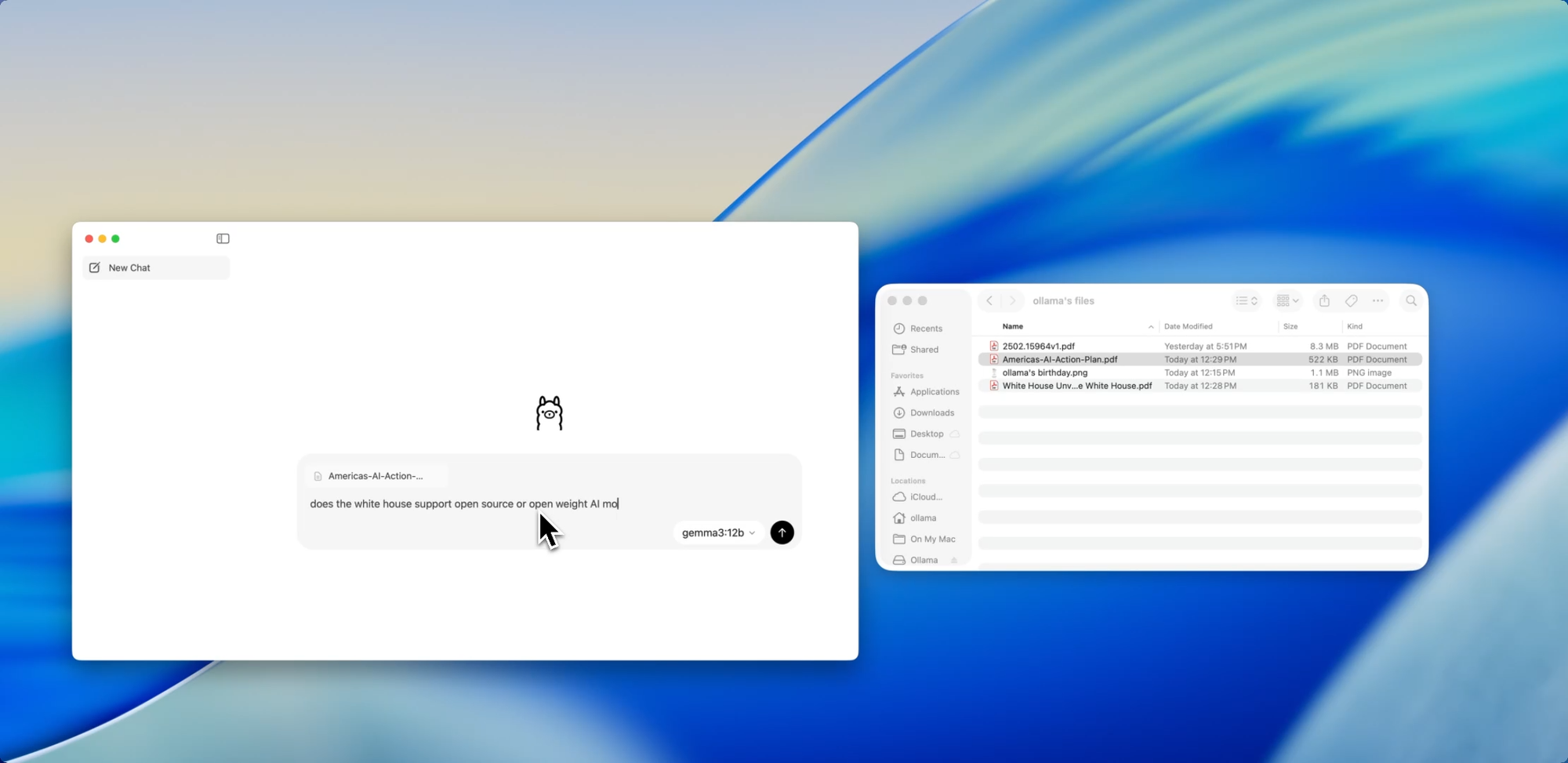

Orientasi yang Lebih Lancar untuk Pengembang - Cara yang Lebih Mudah untuk Berinteraksi dengan Model

Sebelumnya, menggunakan Ollama berarti menyalakan terminal dan mengeluarkan perintah ollama run untuk memulai sesi model. Sekarang, aplikasi desktop terbuka seperti aplikasi native lainnya, menawarkan antarmuka obrolan yang sederhana dan bersih.

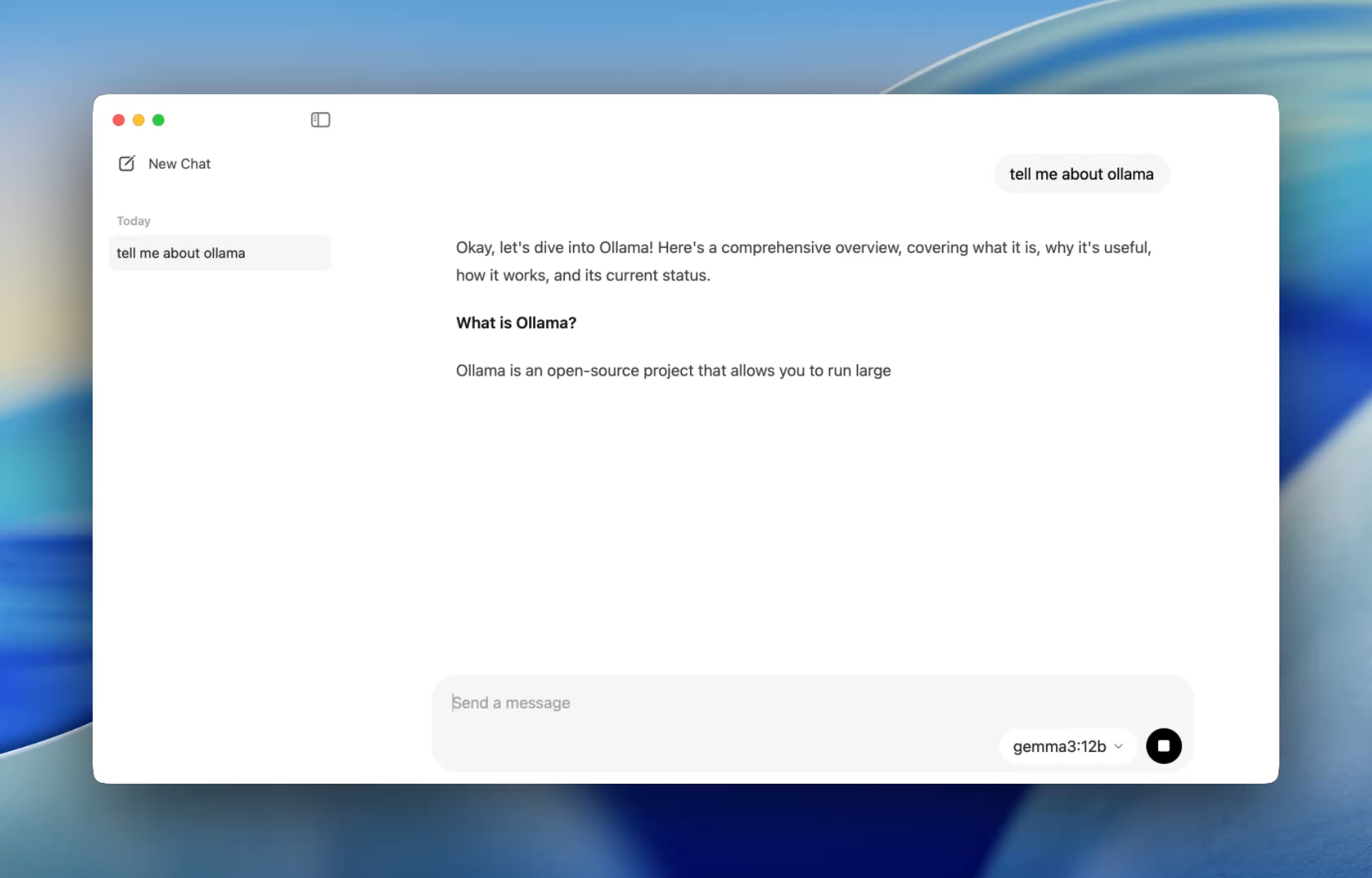

Anda sekarang dapat berbicara dengan model dengan cara yang sama seperti di ChatGPT — tetapi sepenuhnya offline. Ini sempurna untuk:

- Bantuan tinjauan kode

- Pembuatan tes

- Tips refactoring

- Mempelajari API atau bahasa baru

Aplikasi ini memberi Anda akses langsung ke model lokal seperti codellama atau mistral tanpa pengaturan apa pun selain instalasi sederhana.

Dan bagi pengembang yang menyukai kustomisasi, CLI masih berfungsi di balik layar memungkinkan Anda mengaktifkan panjang konteks, prompt sistem, dan versi model melalui terminal jika diperlukan.

Seret. Lepaskan. Ajukan Pertanyaan.

Berinteraksi dengan File

Salah satu fitur yang paling ramah pengembang di aplikasi baru adalah penyerapan file. Cukup seret file ke jendela obrolan — baik itu .pdf, .md, atau .txt — dan model akan membaca isinya.

Perlu memahami dokumen desain 60 halaman? Ingin mengekstrak TODO dari README yang berantakan? Atau meringkas ringkasan produk klien? Jatuhkan saja dan ajukan pertanyaan bahasa alami seperti:

- "Apa fitur utama yang dibahas dalam dokumen ini?"

- "Ringkas ini dalam satu paragraf."

- "Apakah ada bagian yang hilang atau inkonsistensi?"

Fitur ini dapat secara dramatis mengurangi waktu yang dihabiskan untuk memindai dokumentasi, meninjau spesifikasi, atau orientasi ke proyek baru.

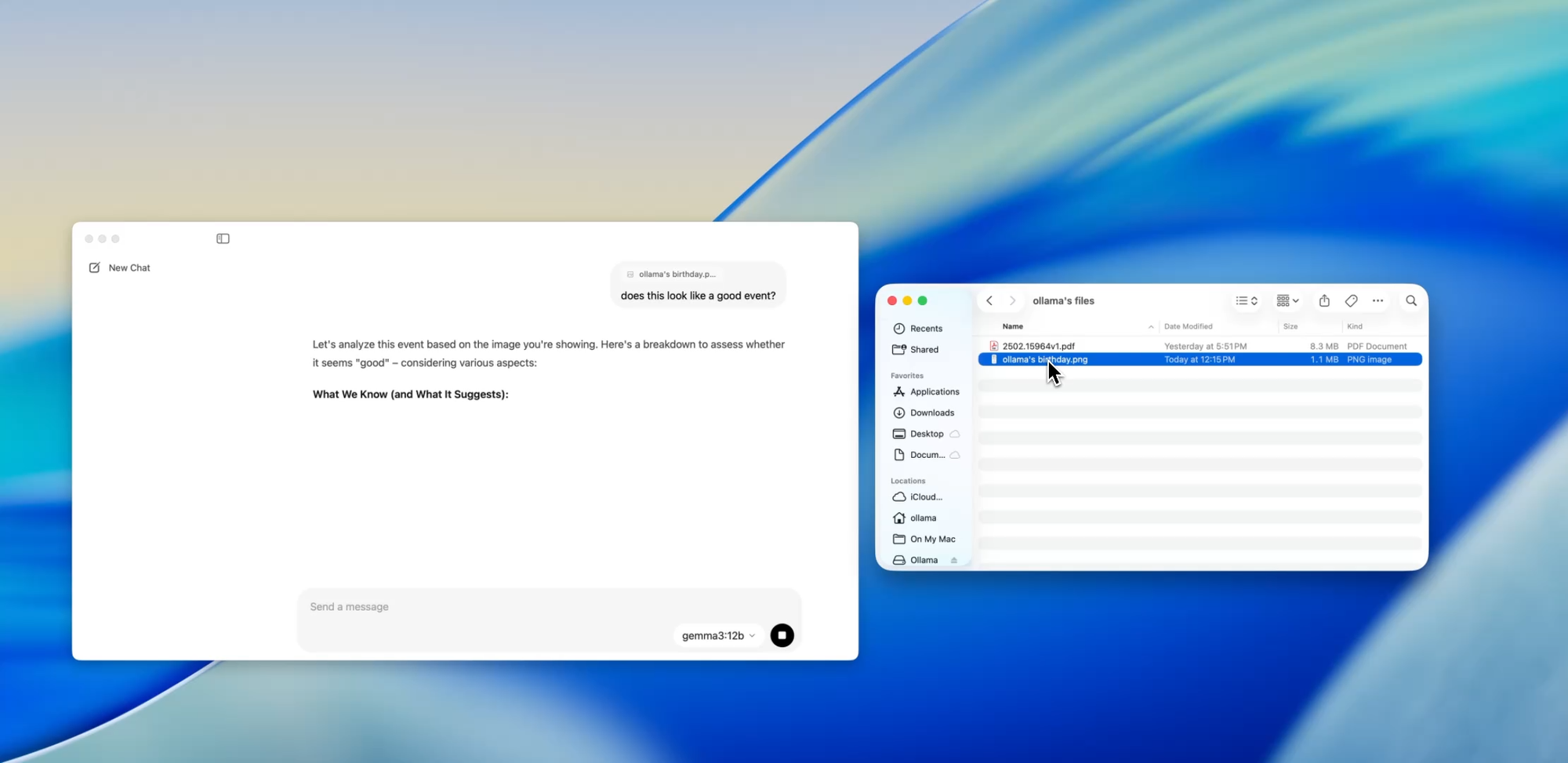

Melampaui Teks

Dukungan Multimodal

Model tertentu dalam Ollama (seperti yang berbasis Llava) sekarang mendukung input gambar. Itu berarti Anda dapat mengunggah gambar, dan model akan menafsirkan dan meresponsnya.

Beberapa kasus penggunaan meliputi:

- Membaca diagram atau grafik dari tangkapan layar

- Mendeskripsikan maket UI

- Meninjau catatan tulisan tangan yang dipindai

- Menganalisis infografis sederhana

Meskipun ini masih tahap awal dibandingkan dengan alat seperti GPT-4 Vision, memiliki dukungan multimodal yang terintegrasi ke dalam aplikasi yang mengutamakan lokal adalah langkah besar bagi pengembang yang membangun sistem multi-input atau menguji antarmuka AI.

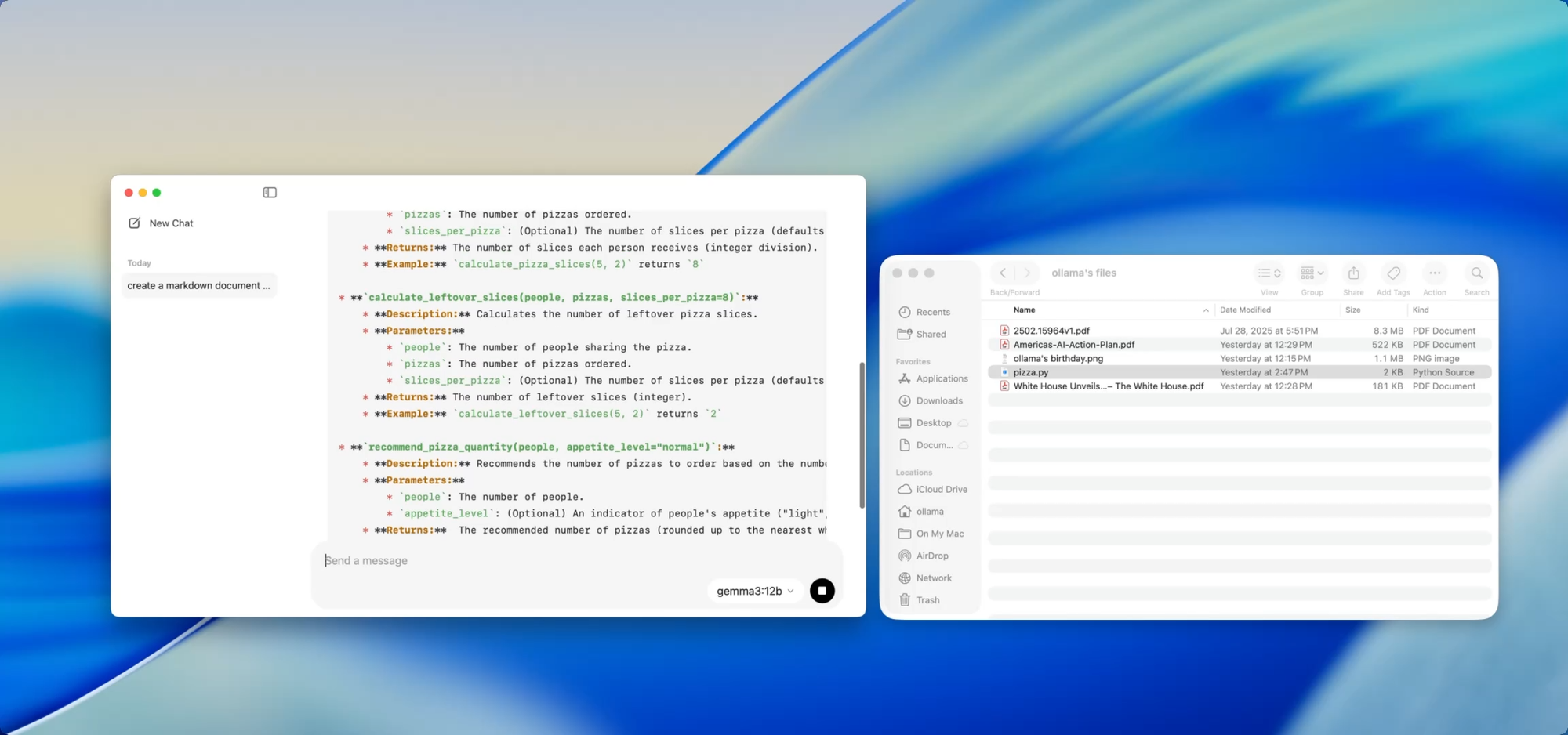

Dokumen Lokal, Privat — Sesuai Perintah Anda

Penulisan Dokumentasi

Jika Anda memelihara basis kode yang berkembang, Anda tahu kesulitan pergeseran dokumentasi. Dengan Ollama, Anda dapat menggunakan model lokal untuk membantu menghasilkan atau memperbarui dokumentasi tanpa pernah mendorong kode sensitif ke cloud.

Cukup seret file — misalnya utils.py — ke dalam aplikasi dan tanyakan:

- "Tulis docstring untuk fungsi-fungsi ini."

- "Buat ikhtisar Markdown tentang apa yang dilakukan file ini."

- "Dependensi apa yang digunakan modul ini?"

Ini menjadi lebih kuat ketika dipasangkan dengan alat seperti [Deepdocs] yang mengotomatiskan alur kerja dokumentasi menggunakan AI. Anda dapat memuat terlebih dahulu README proyek atau file skema Anda, lalu mengajukan pertanyaan lanjutan atau menghasilkan log perubahan, catatan migrasi, atau panduan pembaruan — semuanya secara lokal.

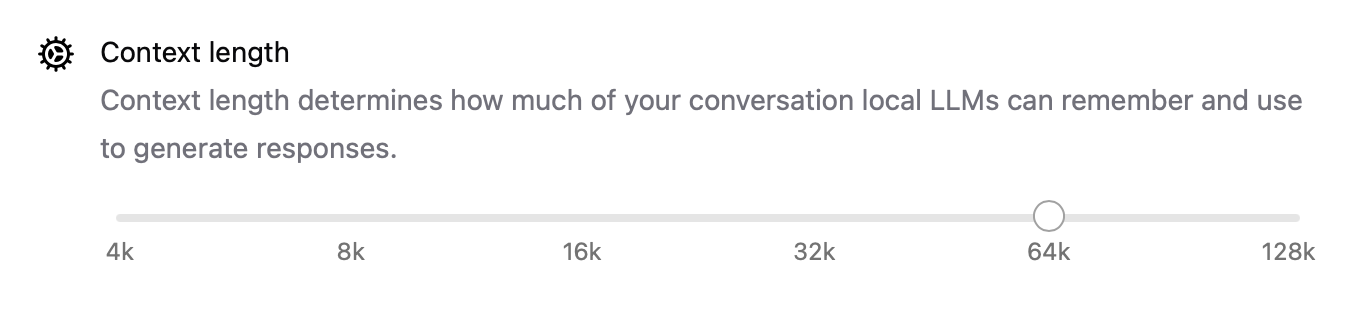

Penyetelan Kinerja di Balik Layar

Dengan rilis baru ini, Ollama juga meningkatkan kinerja secara keseluruhan:

- Akselerasi GPU lebih dioptimalkan untuk Apple Silicon dan kartu Nvidia/AMD modern.

- Panjang konteks sekarang dapat dikonfigurasi dengan pengaturan seperti

num_ctx=8192, sehingga Anda dapat menangani input yang lebih panjang. - Mode jaringan memungkinkan Ollama berjalan sebagai server API lokal yang dapat Anda panggil dari aplikasi atau perangkat lain di LAN Anda.

- Anda sekarang dapat mengubah lokasi penyimpanan untuk model yang diunduh — sempurna jika Anda bekerja dari drive eksternal atau ingin mengisolasi model per proyek.

Peningkatan ini membuat aplikasi fleksibel untuk segala hal mulai dari agen lokal hingga alat pengembang hingga asisten penelitian pribadi.

CLI dan GUI: Terbaik dari Kedua Dunia

Bagian terbaiknya? Aplikasi desktop baru tidak menggantikan terminal — melengkapinya.

Anda masih bisa:

ollama pull codellama

ollama run codellama

Atau mengekspos server model:

ollama serve --host 0.0.0.0

Jadi, jika Anda membangun antarmuka AI khusus, agen, atau plugin yang mengandalkan LLM lokal, Anda sekarang dapat membangun di atas API Ollama dan menggunakan GUI untuk interaksi langsung atau pengujian.

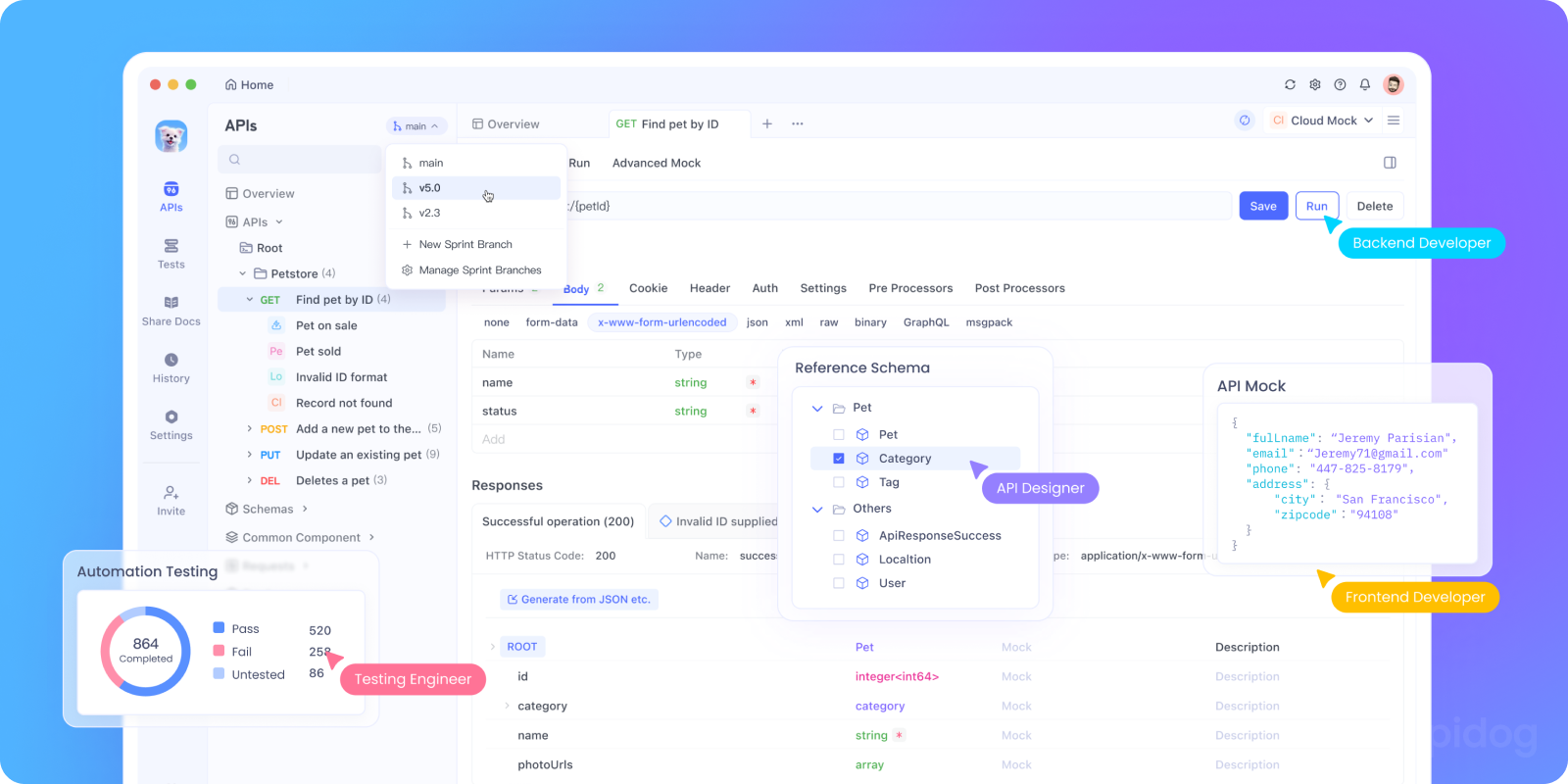

Uji API Ollama Secara Lokal dengan Apidog

Ingin mengintegrasikan Ollama ke dalam aplikasi AI Anda atau menguji titik akhir API lokalnya? Anda dapat menjalankan REST API Ollama menggunakan:

bash tollama serve

Kemudian, gunakan Apidog untuk menguji, men-debug, dan mendokumentasikan titik akhir LLM lokal Anda.

Mengapa menggunakan Apidog dengan Ollama:

- Antarmuka visual untuk mengirim permintaan POST ke server

http://localhost:11434lokal Anda - Mendukung pembuatan permintaan berbantuan AI dan validasi respons

- Sempurna untuk aplikasi AI yang di-host sendiri, kerangka kerja agen, atau alat internal

- Bekerja dengan mulus dengan alur kerja LLM lokal dan server model kustom

Kasus Penggunaan Pengembang yang Benar-benar Berfungsi

Berikut adalah di mana aplikasi Ollama baru bersinar dalam alur kerja pengembang nyata:

| Kasus Penggunaan | Bagaimana Ollama Membantu |

|---|---|

| Asisten Tinjauan Kode | Jalankan codellama secara lokal untuk umpan balik refactoring |

| Pembaruan Dokumentasi | Minta model untuk menulis ulang, meringkas, atau memperbaiki file dokumen |

| Chatbot Dev Lokal | Sematkan ke aplikasi Anda sebagai asisten yang sadar konteks |

| Alat Penelitian Offline | Muat PDF atau whitepaper dan ajukan pertanyaan kunci |

| Tempat Bermain LLM Pribadi | Bereksperimen dengan rekayasa prompt & fine-tuning |

Untuk tim yang khawatir tentang privasi data atau halusinasi model, alur kerja LLM yang mengutamakan lokal menawarkan alternatif yang semakin menarik.

Pikiran Akhir

Versi desktop Ollama membuat LLM lokal terasa tidak seperti eksperimen ilmiah yang serampangan dan lebih seperti alat pengembang yang dipoles.

Dengan dukungan untuk interaksi file, input multimodal, penulisan dokumen, dan kinerja native, ini adalah pilihan serius bagi pengembang yang peduli dengan kecepatan, fleksibilitas, dan kontrol.

Tidak ada kunci API cloud. Tidak ada pelacakan latar belakang. Tidak ada penagihan per-token. Hanya inferensi lokal yang cepat dengan pilihan model terbuka apa pun yang sesuai dengan kebutuhan Anda.

Jika Anda penasaran tentang menjalankan LLM di mesin Anda, atau jika Anda sudah menggunakan Ollama dan menginginkan pengalaman yang lebih lancar, sekaranglah saatnya untuk mencobanya lagi.