OpenAI Agents SDK sekarang mendukung MCP (Model Context Protocol), sebuah terobosan untuk interoperabilitas AI. Hal ini memungkinkan pengembang untuk menghubungkan model AI ke alat dan sumber data eksternal secara efisien. Dalam panduan teknis ini, kami akan memandu Anda membangun MCP Server dengan OpenAI Agents SDK untuk meningkatkan aplikasi AI Anda.

Apa Itu MCP Server dan Mengapa Menggunakannya dengan OpenAI Agents SDK?

MCP (Model Context Protocol) adalah protokol terbuka yang menstandarisasi cara aplikasi menyediakan konteks ke model bahasa besar (LLM). Anggap MCP seperti port USB-C untuk aplikasi AI - ia bertindak sebagai konektor universal yang memungkinkan model AI berinteraksi dengan berbagai sumber data dan alat secara mulus.

OpenAI Agents SDK mengintegrasikan MCP Server untuk memungkinkan agen mengakses alat dan data eksternal. Menggunakan MCP Server memastikan interaksi yang lancar antara agen AI Anda dan sumber daya jarak jauh maupun lokal. Integrasi ini mengurangi kompleksitas dalam pemanggilan alat dan meningkatkan fungsionalitas agen.

Berikut adalah beberapa contoh yang dapat Anda bangun dengan kombinasi OpenAI + MCP Server:

🕵️♂️ used gitingest to download all the docs from @OpenAIDevs Agents SDK

— Dan Mac (@daniel_mac8) March 23, 2025

excellent for providing to your AI Coding Agent as context if building with the OpenAI Agents SDK

download from the GitHub link below ⬇️ pic.twitter.com/0szZ43wMTv

Langkah-Langkah Menggunakan Integrasi OpenAI MCP

Prasyarat untuk Membangun MCP Server dengan OpenAI Agents SDK

Sebelum memulai, pastikan Anda memiliki:

- Python 3.8 atau lebih tinggi terinstal di sistem Anda

- OpenAI Agents SDK terinstal melalui pip:

pip install openai-agents - Node.js disiapkan untuk menjalankan perintah MCP server seperti

npxuntuk contoh tertentu - Direktori proyek dengan lingkungan virtual yang diinisialisasi untuk manajemen dependensi

- Pemahaman dasar tentang pemrograman asinkron di Python, karena SDK menggunakan async/await

Langkah 1: Siapkan Lingkungan Pengembangan Anda untuk MCP Server

# Buat direktori baru untuk proyek Anda

mkdir mcp-agent-project && cd mcp-agent-project

# Inisialisasi lingkungan virtual Python

python -m venv venv && source venv/bin/activate

# Instal dependensi yang diperlukan

pip install openai-agents pyyaml

Siapkan file konfigurasi bernama mcp_agent.config.yaml untuk mendefinisikan MCP Server. Konfigurasi ini mengarah ke MCP server sistem file untuk mengakses file lokal.

Langkah 2: Pahami Jenis-Jenis MCP Server di OpenAI Agents SDK

MCP Server hadir dalam dua jenis seperti yang didefinisikan dalam spesifikasi MCP:

- stdio servers: Berjalan secara lokal sebagai subproses dari aplikasi Anda

- HTTP over SSE servers: Beroperasi dari jarak jauh dan terhubung melalui URL

OpenAI Agents SDK menyediakan dua kelas untuk menangani server ini:

MCPServerStdio: Untuk server berbasis subproses lokalMCPServerSse: Untuk server HTTP over SSE jarak jauh

Pilih jenis server berdasarkan arsitektur aplikasi Anda dan persyaratan latensi. Stdio server ideal untuk pengembangan lokal, sementara SSE server lebih cocok untuk sistem terdistribusi.

Langkah 3: Hubungkan MCP Server ke Agen OpenAI Anda

Impor kelas yang diperlukan dari OpenAI Agents SDK dan definisikan MCP server Anda:

from openai_agents import Agent, MCPServerStdio

# Definisikan jalur ke file sampel Anda

samples_dir = "/path/to/your/files"

# Gunakan pengelola konteks async untuk menginisialisasi server

async with MCPServerStdio(

params={

"command": "npx",

"args": ["-y", "@modelcontextprotocol/server-filesystem", samples_dir],

}

) as server:

# Daftar alat yang disediakan oleh MCP server

tools = await server.list_tools()

# Buat agen yang menggunakan MCP server

agent = Agent(

name="Assistant",

instructions="Use the filesystem tools to help the user with their tasks.",

mcp_servers=[server]

)

# Jalankan agen

result = await agent.run("List the files in the directory.")

Pengaturan ini memungkinkan agen untuk menggunakan alat sistem file secara dinamis selama eksekusi.

Langkah 4: Optimalkan Kinerja dengan Caching Alat

MCP Server memanggil list_tools() setiap kali agen berjalan, yang dapat menyebabkan latensi, terutama dengan server jarak jauh. Untuk mengurangi overhead ini, Anda dapat mengaktifkan caching alat:

# Aktifkan caching saat menginisialisasi server

async with MCPServerStdio(

params={

"command": "npx",

"args": ["-y", "@modelcontextprotocol/server-filesystem", samples_dir],

},

cache_tools_list=True # Aktifkan caching

) as server:

# Daftar alat akan di-cache setelah panggilan pertama

tools = await server.list_tools()

Pertimbangan penting untuk caching:

- Hanya gunakan caching jika Anda yakin daftar alat tidak akan berubah selama runtime

- Jika alat perlu diperbarui, batalkan cache:

await server.invalidate_tools_cache() - Caching berfungsi untuk server stdio dan SSE, dengan manfaat kinerja yang lebih besar untuk server jarak jauh

Langkah 5: Implementasikan Integrasi MCP Server dengan Alur Kerja Agen Anda

Untuk sepenuhnya mengintegrasikan MCP server dengan agen Anda:

from openai_agents import Agent, MCPServerStdio, MCPServerSse

async def run_agent_with_mcp_servers():

# Inisialisasi MCP server stdio lokal

local_server = MCPServerStdio(

params={

"command": "npx",

"args": ["-y", "@modelcontextprotocol/server-filesystem", "./local_files"],

},

cache_tools_list=True

)

# Inisialisasi MCP server SSE jarak jauh (jika diperlukan)

remote_server = MCPServerSse(

url="<https://your-remote-mcp-server.com/stream>",

cache_tools_list=True

)

async with local_server, remote_server:

# Buat agen dengan kedua server

agent = Agent(

name="MultiToolAgent",

instructions="Use the available tools to accomplish tasks.",

mcp_servers=[local_server, remote_server]

)

# Jalankan agen

result = await agent.run("Complete the requested task using appropriate tools.")

return result

Pendekatan ini memberi agen Anda akses ke alat lokal dan jarak jauh melalui antarmuka MCP standar.

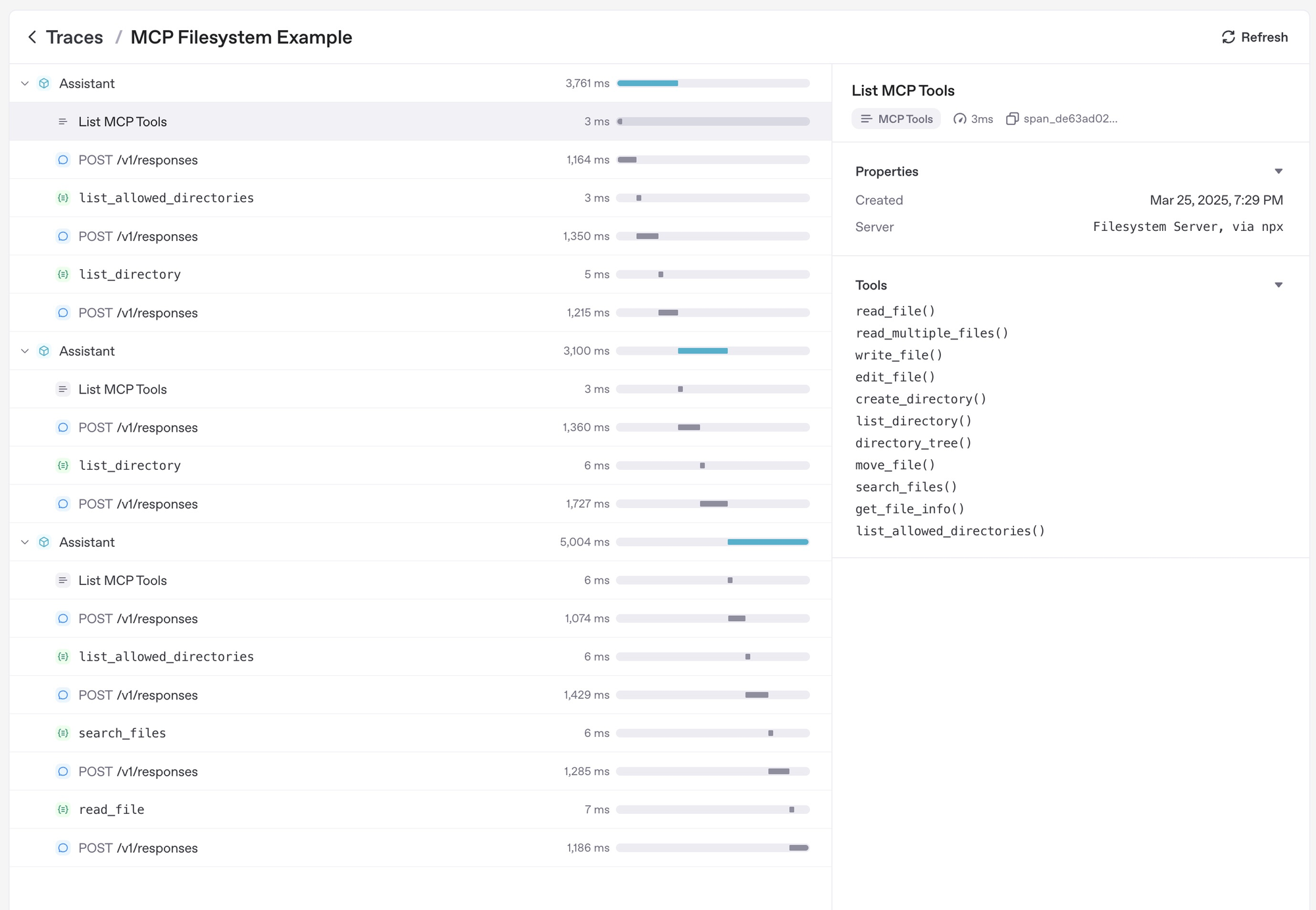

Langkah 6: Debug dan Pantau MCP Server Anda

Strategi debugging dan pemantauan yang efektif meliputi:

- Memeriksa log MCP server untuk kesalahan selama eksekusi alat

- Menggunakan dasbor pelacakan OpenAI Agents SDK untuk memantau panggilan alat

- Menguji kasus ekstrem seperti nama alat yang tidak valid atau waktu henti server untuk memastikan ketahanan

- Memantau latensi saat menggunakan server SSE jarak jauh dan mengoptimalkan dengan caching jika diperlukan

- Memanfaatkan fungsionalitas pelacakan bawaan SDK, yang secara otomatis menangkap:

- Panggilan ke MCP server untuk mendaftar alat

- Informasi terkait MCP pada panggilan fungsi

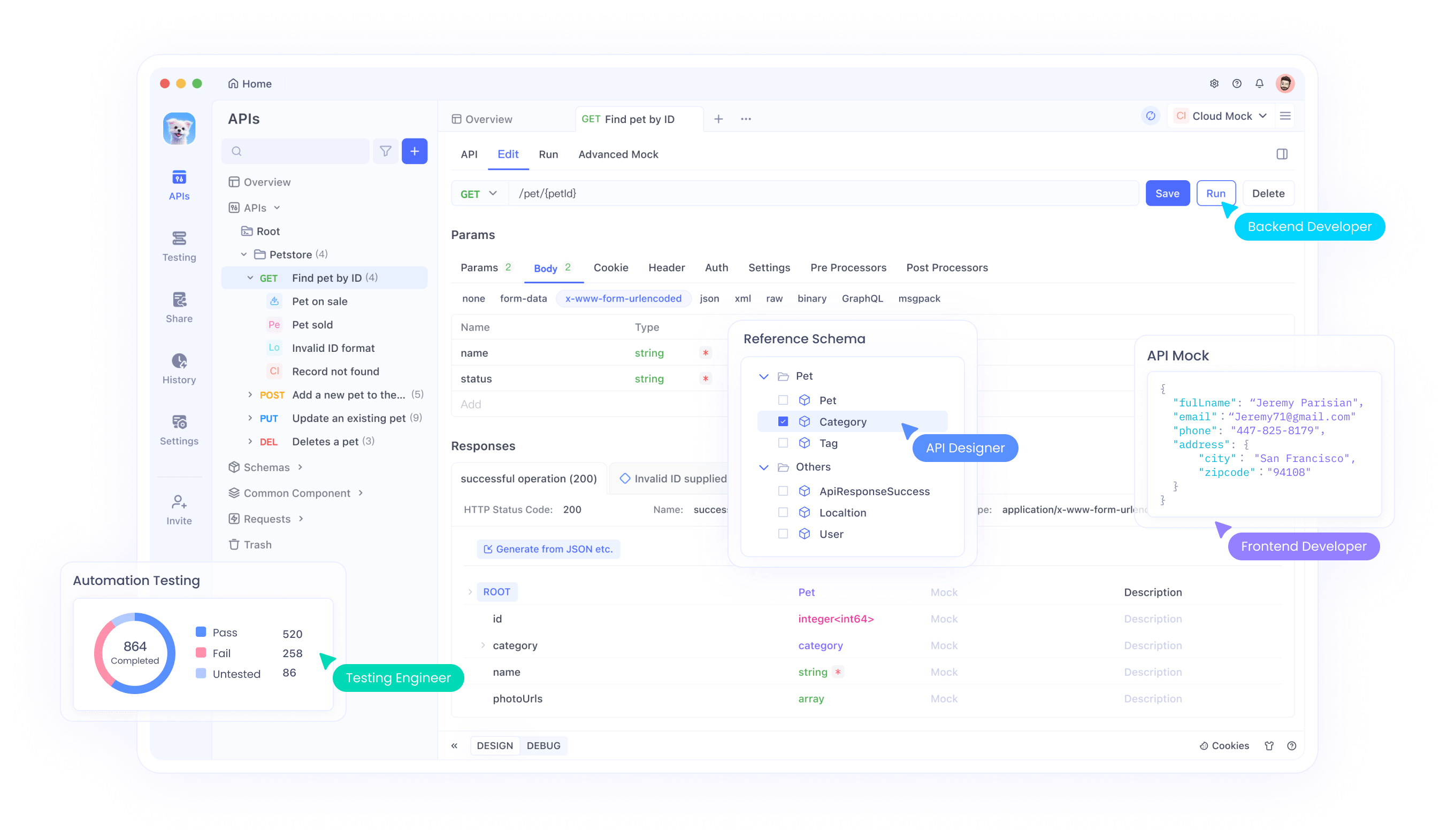

Selain itu, Anda juga harus mempertimbangkan untuk menggunakan alat Pengujian API All-in-One untuk membuat siklus Pengembangan API Anda lebih mudah.

Apidog adalah alat canggih yang menyederhanakan pengembangan API, menjadikannya pendamping yang sangat baik saat membangun MCP Server dengan OpenAI Agents SDK. Karena MCP Server sering melibatkan interaksi dengan API—baik untuk server HTTP over SSE jarak jauh atau pengujian panggilan alat—Apidog dapat meningkatkan alur kerja Anda.

Kesimpulan

Membangun MCP Server dengan OpenAI Agents SDK membuka kemungkinan baru untuk meningkatkan agen AI dengan alat dan sumber data eksternal. Antarmuka MCP standar membuat integrasi lebih sederhana dan lebih andal di berbagai lingkungan.

Dengan mengikuti panduan ini, Anda dapat membuat agen yang kuat yang memanfaatkan sumber daya lokal dan jarak jauh melalui Model Context Protocol. Seiring pertumbuhan ekosistem MCP, agen Anda akan dapat mengakses serangkaian alat dan kemampuan yang terus berkembang.

Untuk contoh lebih lanjut dan dokumentasi terperinci, kunjungi dokumentasi MCP OpenAI Agents SDK resmi. Dukungan SDK untuk MCP merupakan langkah maju yang signifikan dalam membuat agen AI lebih mampu dan terhubung ke dunia digital.