Sulit mengevaluasi dan mengoptimalkan pipeline model bahasa besar (LLM) Anda? Hadir LangWatch, platform pengubah permainan yang memudahkan Anda untuk memantau, mengevaluasi, dan menyempurnakan alur kerja LLM kustom Anda. Dalam panduan ini, kita akan menyelami apa itu LangWatch, mengapa ini luar biasa, dan cara menginstal serta menggunakannya untuk meningkatkan proyek AI Anda. Kita akan membahas pengaturan chatbot sederhana, mengintegrasikan LangWatch, dan mengujinya dengan contoh pertanyaan—semuanya sambil menjaga agar mudah diikuti. Mari kita mulai!

Menginginkan platform Terintegrasi, All-in-One untuk Tim Pengembang Anda bekerja sama dengan produktivitas maksimum?

Apidog memenuhi semua permintaan Anda, dan menggantikan Postman dengan harga yang jauh lebih terjangkau!

Apa Itu LangWatch dan Mengapa Anda Harus Peduli?

LangWatch adalah platform pilihan Anda untuk mengatasi masalah sulit evaluasi LLM. Berbeda dengan model tradisional dengan metrik standar seperti skor F1 untuk klasifikasi, BLEU untuk terjemahan, atau ROUGE untuk ringkasan, LLM generatif bersifat non-deterministik dan sulit untuk ditentukan. Ditambah lagi, setiap perusahaan memiliki data, model yang disesuaikan, dan pipeline kustomnya sendiri, membuat evaluasi menjadi sakit kepala. Di sinilah LangWatch bersinar!

LangWatch memungkinkan Anda untuk:

- Bereksperimen dan Mengoptimalkan: Uji dan tingkatkan pipeline LLM Anda dengan mudah.

- Memantau Kinerja: Lacak bagaimana AI Anda berperilaku secara real-time.

- Mengevaluasi Hasil: Gunakan dataset dan evaluator untuk mengukur akurasi dan kualitas.

- Mendukung Pipeline Kustom: Bekerja dengan data dan model unik Anda.

Baik Anda membangun chatbot, alat terjemahan, atau aplikasi AI kustom, LangWatch membantu Anda memastikan LLM Anda memberikan hasil terbaik. Siap melihatnya beraksi? Mari kita instal dan gunakan LangWatch!

Panduan Langkah demi Langkah untuk Menginstal dan Menggunakan LangWatch

Prasyarat

Sebelum kita mulai, Anda akan membutuhkan:

- Python 3.8+: Untuk menjalankan proyek (python.org).

- Akun LangWatch: Daftar di app.langwatch.ai.

- Kunci API OpenAI: Untuk demo chatbot (dapatkan di platform.openai.com).

- Editor Kode: VS Code, PyCharm, atau IDE favorit Anda.

- Git dan Docker: Opsional, untuk pengaturan LangWatch lokal.

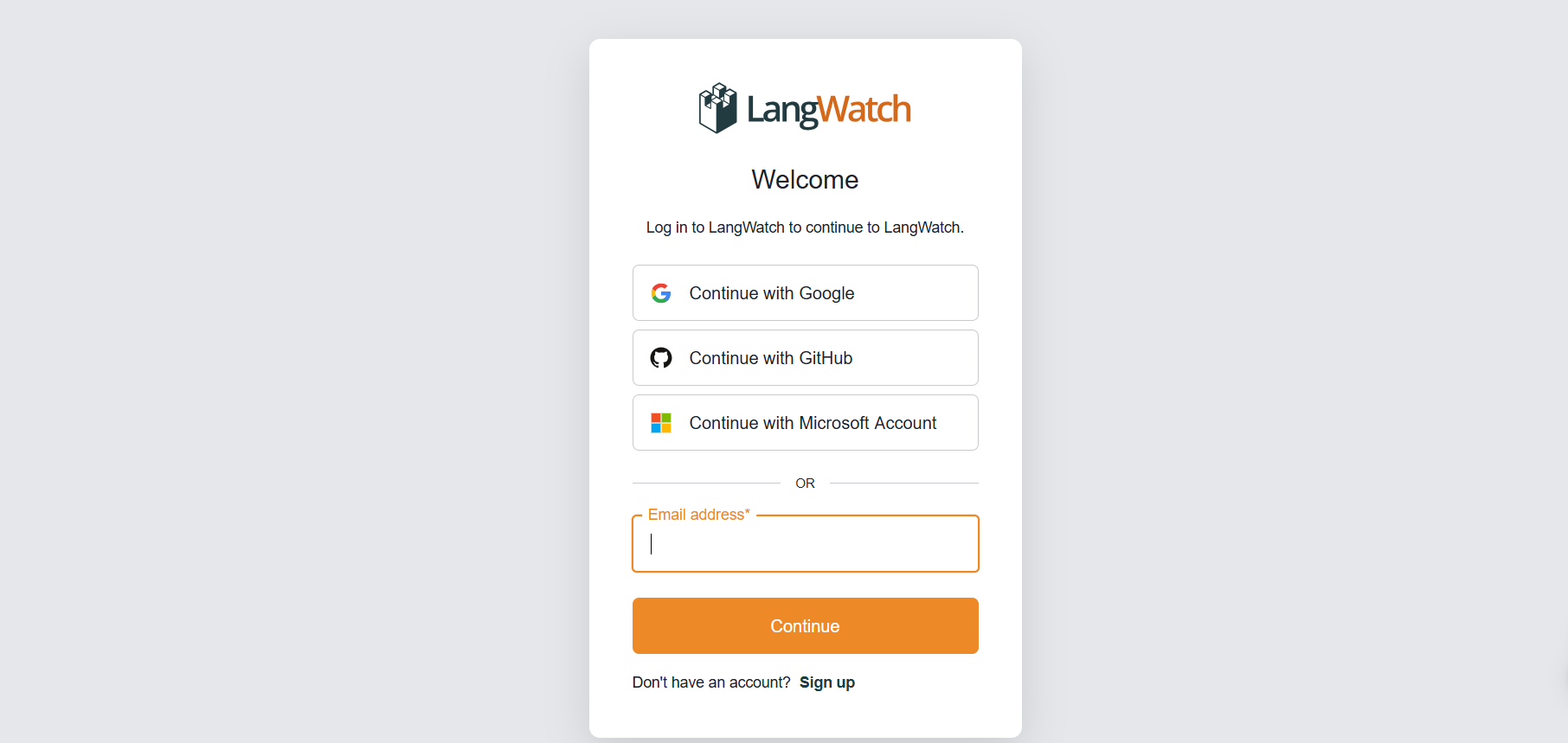

Langkah 1: Daftar untuk LangWatch

Buat Akun:

- Buka app.langwatch.ai dan daftar untuk akun gratis.

- Proyek default bernama "AI Bites" dibuat untuk Anda. Kita akan menggunakannya untuk tutorial ini, tetapi Anda dapat membuat yang baru jika Anda mau.

Dapatkan Kunci API Anda:

- Di dasbor LangWatch Anda, buka Pengaturan Proyek untuk menemukan

LANGWATCH_API_KEYAnda. Anda akan membutuhkannya nanti.

Langkah 2: Siapkan Proyek Python dengan LangWatch

Mari kita buat proyek Python dan integrasikan LangWatch untuk melacak chatbot sederhana.

- Buat Folder Proyek:

- Buat direktori baru (misalnya,

langwatch-demo) dan masuk ke dalamnya:

mkdir langwatch-demo

cd langwatch-demo

2. Siapkan Lingkungan Virtual:

- Buat dan aktifkan lingkungan virtual untuk menjaga dependensi terisolasi:

python -m venv venv

source venv/bin/activate # Di Windows: venv\Scripts\activate

3. Instal LangWatch dan Dependensi:

- Instal LangWatch dan Chainlit (untuk UI chatbot):

pip install langwatch chainlit openai

4. Buat Kode Chatbot:

- Buat file bernama

app.pydan tempel kode ini untuk membangun chatbot sederhana menggunakan model GPT-4o-mini OpenAI:

import os

import chainlit as cl

import asyncio

from openai import AsyncClient

openai_client = AsyncClient() # Asumsi OPENAI_API_KEY diatur di lingkungan

model_name = "gpt-4o-mini"

settings = {

"temperature": 0.3,

"max_tokens": 500,

"top_p": 1,

"frequency_penalty": 0,

"presence_penalty": 0,

}

@cl.on_chat_start

async def start():

cl.user_session.set(

"message_history",

[

{

"role": "system",

"content": "You are a helpful assistant that only reply in short tweet-like responses, using lots of emojis."

}

]

)

async def answer_as(name: str):

message_history = cl.user_session.get("message_history")

msg = cl.Message(author=name, content="")

stream = await openai_client.chat.completions.create(

model=model_name,

messages=message_history + [{"role": "user", "content": f"speak as {name}"}],

stream=True,

**settings,

)

async for part in stream:

if token := part.choices[0].delta.content or "":

await msg.stream_token(token)

message_history.append({"role": "assistant", "content": msg.content})

await msg.send()

@cl.on_message

async def main(message: cl.Message):

message_history = cl.user_session.get("message_history")

message_history.append({"role": "user", "content": message.content})

await asyncio.gather(answer_as("AI Bites"))

5. Atur Kunci API OpenAI Anda:

- Tambahkan kunci API OpenAI Anda sebagai variabel lingkungan:

export OPENAI_API_KEY="kunci-api-openai-anda" # Di Windows: set OPENAI_API_KEY=kunci-api-openai-anda

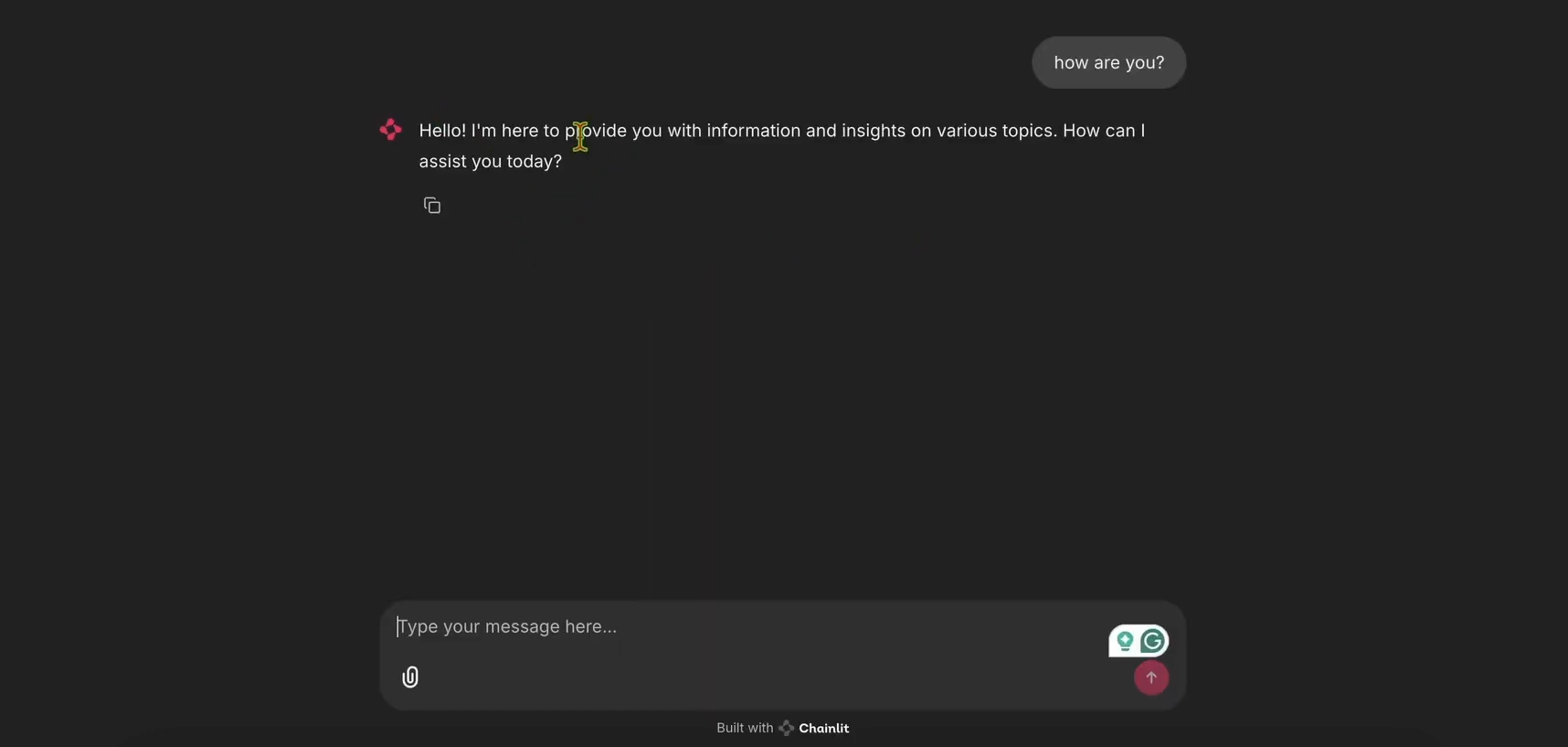

6. Jalankan Chatbot:

- Mulai aplikasi Chainlit:

chainlit run app.py

- Buka http://localhost:8000 untuk melihat UI chatbot. Coba untuk memastikan berfungsi!

Langkah 3: Integrasikan LangWatch untuk Pelacakan

Sekarang, mari kita tambahkan LangWatch untuk melacak pesan chatbot.

- Modifikasi

app.pyuntuk LangWatch:

- Perbarui

app.pyuntuk menyertakan LangWatch dan tambahkan dekorator@langwatch.trace()ke fungsimain:

import os

import chainlit as cl

import asyncio

import langwatch

from openai import AsyncClient

openai_client = AsyncClient()

model_name = "gpt-4o-mini"

settings = {

"temperature": 0.3,

"max_tokens": 500,

"top_p": 1,

"frequency_penalty": 0,

"presence_penalty": 0,

}

@cl.on_chat_start

async def start():

cl.user_session.set(

"message_history",

[

{

"role": "system",

"content": "You are a helpful assistant that only reply in short tweet-like responses, using lots of emojis."

}

]

)

async def answer_as(name: str):

message_history = cl.user_session.get("message_history")

msg = cl.Message(author=name, content="")

stream = await openai_client.chat.completions.create(

model=model_name,

messages=message_history + [{"role": "user", "content": f"speak as {name}"}],

stream=True,

**settings,

)

async for part in stream:

if token := part.choices[0].delta.content or "":

await msg.stream_token(token)

message_history.append({"role": "assistant", "content": msg.content})

await msg.send()

@cl.on_message

@langwatch.trace()

async def main(message: cl.Message):

message_history = cl.user_session.get("message_history")

message_history.append({"role": "user", "content": message.content})

await asyncio.gather(answer_as("AI Bites"))

2. Uji Integrasi:

- Mulai ulang aplikasi Chainlit:

chainlit run app.py

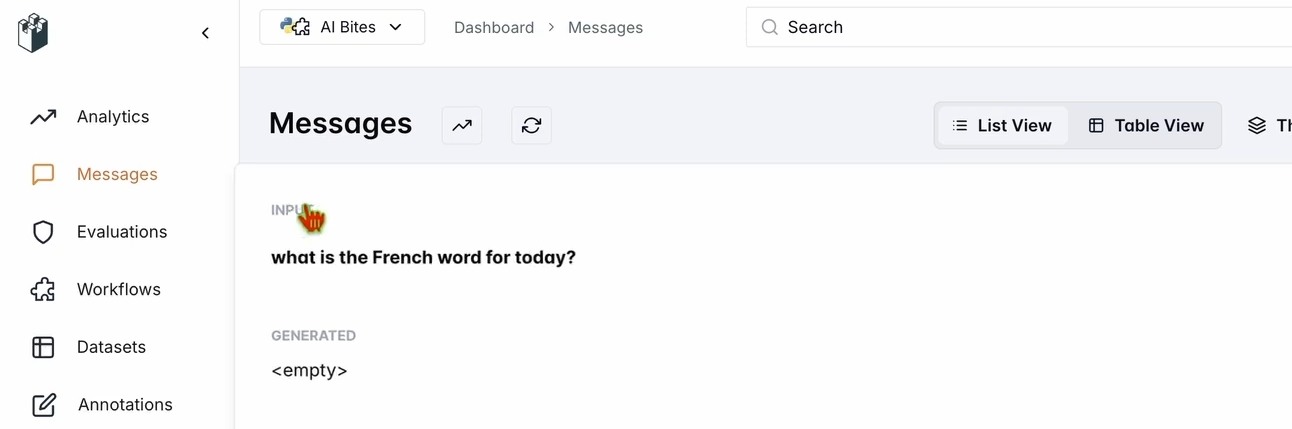

- Di UI chatbot, tanyakan: "Apa kata bahasa Prancis untuk hari ini?"

- Periksa dasbor LangWatch Anda:

- Buka app.langwatch.ai.

- Pilih Pesan dari bilah sisi kiri.

- Verifikasi bahwa pertanyaan Anda dan respons chatbot (misalnya, "Aujourd’hui! 🇫🇷😊") terlacak.

Langkah 4: Siapkan Alur Kerja untuk Mengevaluasi Chatbot Anda

Mari kita buat dataset dan evaluator di LangWatch untuk menilai kinerja chatbot.

- Buat Dataset:

- Di dasbor LangWatch, buka Dataset dan klik Dataset Baru.

- Tambahkan dataset sederhana dengan setidaknya satu pertanyaan dan jawaban. Contohnya:

| Pertanyaan | Jawaban yang Diharapkan |

|---|---|

| Apa kata bahasa Prancis untuk hari ini? | Aujourd’hui |

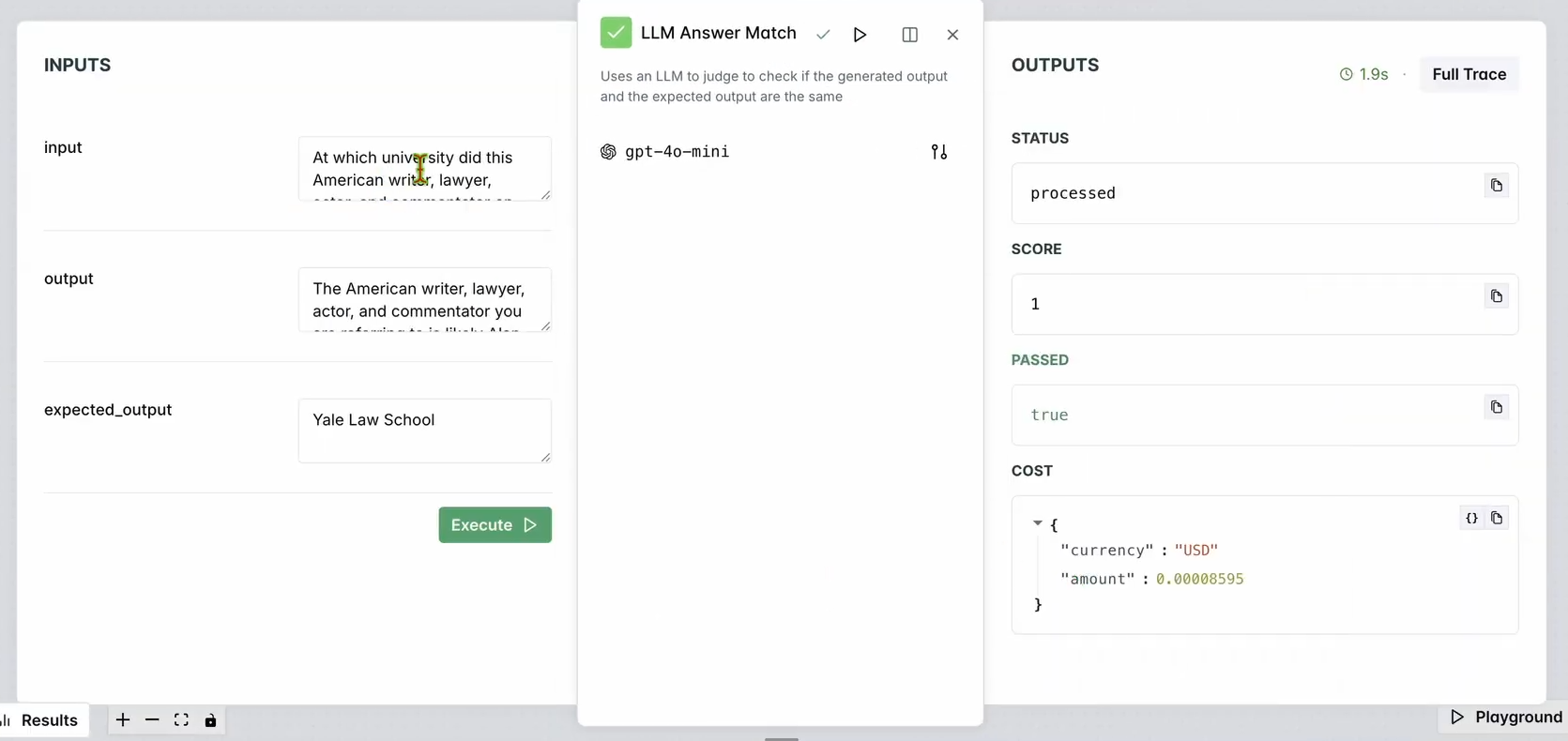

2. Siapkan Evaluator:

- Buka Evaluator di dasbor LangWatch.

- Seret evaluator LLM Answer Match ke ruang kerja.

- Konfigurasikan:

- Atur Pertanyaan Input ke pertanyaan input database Anda (misalnya "Apa kata bahasa Prancis untuk hari ini?").

- Atur Output yang Diharapkan juga ke respons database Anda (misalnya "Aujourd’hui").

- Secara opsional, ubah model LLM evaluator (misalnya, Llama, Gemini, atau Claude Sonnet) untuk variasi.

3. Jalankan Evaluator:

- Klik Jalankan Alur Kerja Sampai Sini untuk menguji evaluator.

- Periksa hasilnya untuk memastikan respons chatbot cocok dengan output yang diharapkan.

Anda akan melihat sesuatu seperti:

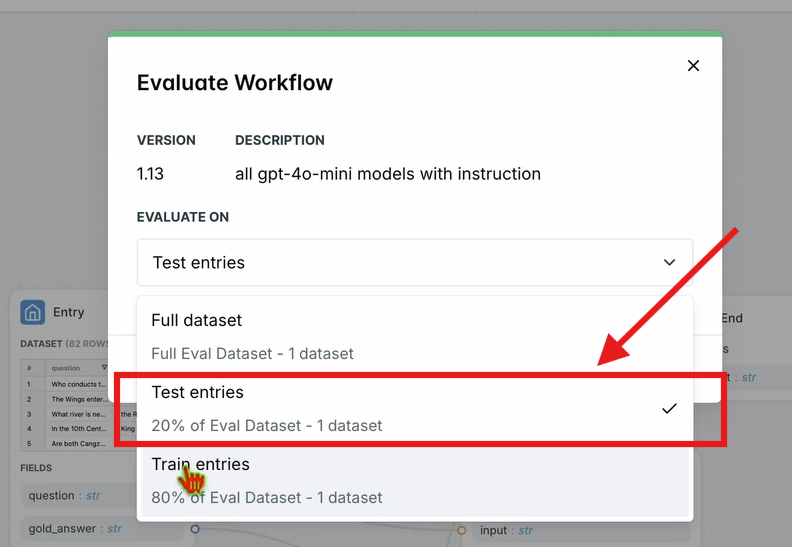

4. Evaluasi Alur Kerja:

- Di bilah navigasi atas, klik Evaluasi Alur Kerja dan pilih Uji Entri.

- Ini mengevaluasi seluruh alur kerja terhadap dataset Anda. Hasil akan muncul setelah waktu pemrosesan singkat.

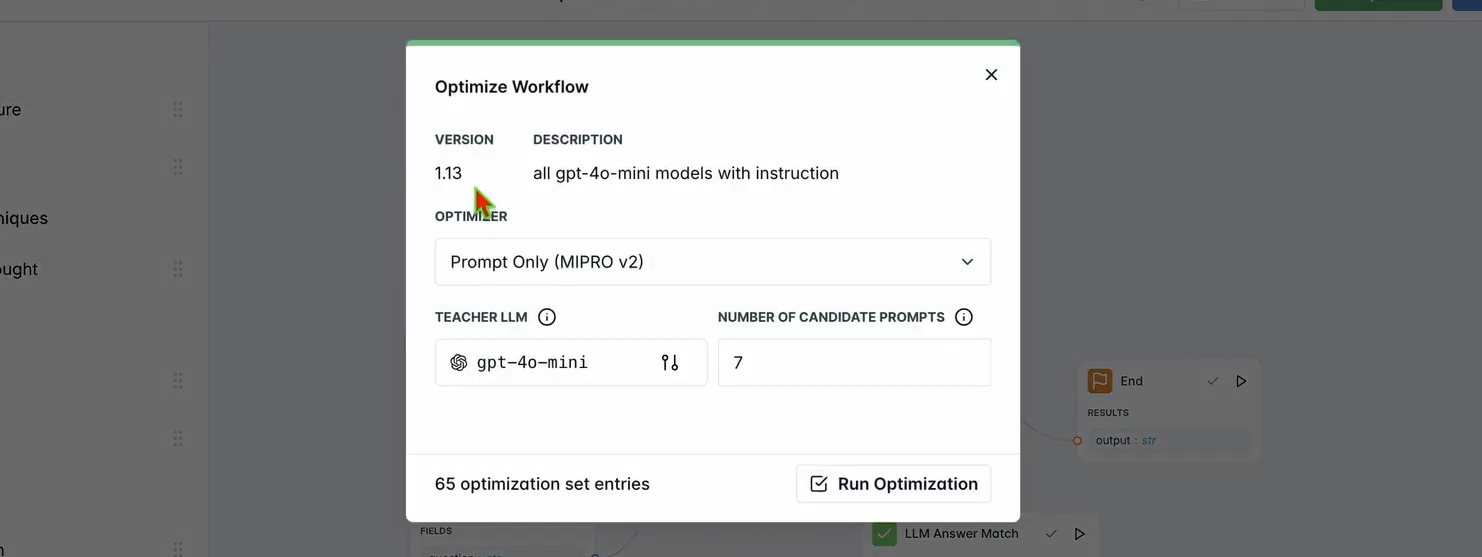

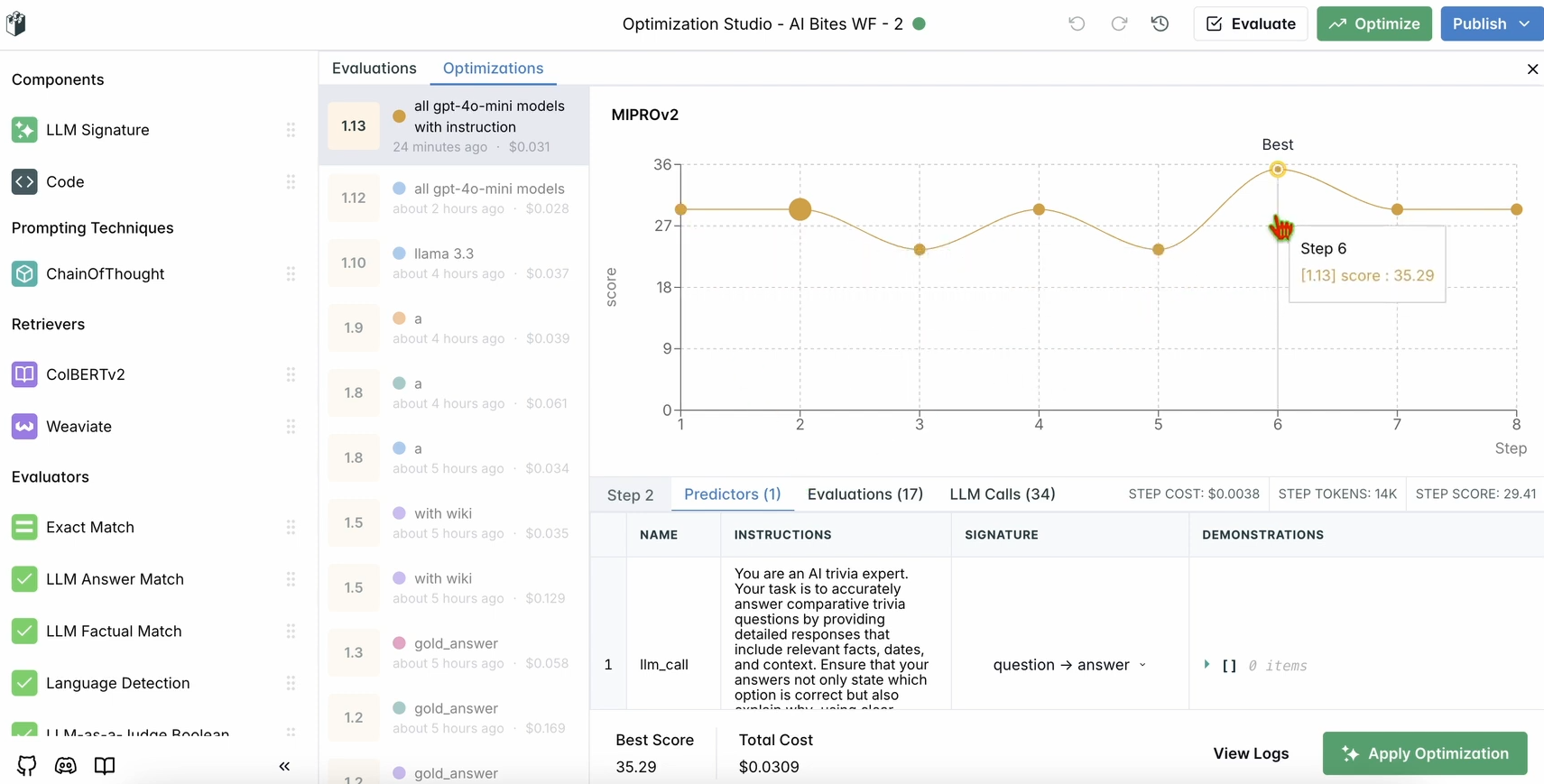

Langkah 5: Optimalkan Alur Kerja Anda

Setelah evaluasi Anda selesai, mari kita optimalkan kinerja chatbot.

1. Jalankan Optimasi:

- Di dasbor LangWatch, klik Optimalkan di bilah navigasi atas.

- Pilih Prompt Saja untuk menyempurnakan prompt chatbot.

- Tunggu beberapa menit hingga optimasi selesai.

2. Periksa Peningkatan:

- Tinjau hasil yang dioptimalkan di dasbor. Anda akan melihat peningkatan akurasi atau kualitas respons berdasarkan saran LangWatch.

Langkah 6: Pengaturan LangWatch Lokal Opsional

Ingin menjalankan LangWatch secara lokal untuk pengujian dengan data sensitif? Ikuti langkah-langkah ini:

- Kloning Repositori:

git clone https://github.com/langwatch/langwatch.git

cd langwatch

2. Siapkan Lingkungan:

- Salin file lingkungan contoh:

cp langwatch/.env.example langwatch/.env

3. Jalankan dengan Docker:

- Mulai server LangWatch:

docker compose up -d --wait --build

4. Akses Dasbor:

- Buka http://localhost:5560 untuk masuk ke alur onboarding LangWatch.

- Ikuti petunjuk untuk menyiapkan instans lokal Anda.

Catatan: Pengaturan Docker hanya untuk pengujian dan tidak dapat diskalakan untuk produksi. Untuk produksi, gunakan LangWatch Cloud atau Enterprise On-Premises.

Mengapa Menggunakan LangWatch?

LangWatch memecahkan teka-teki evaluasi LLM dengan menyediakan platform terpadu untuk memantau, mengevaluasi, dan mengoptimalkan pipeline AI Anda. Baik Anda menyempurnakan prompt, menganalisis kinerja, atau memastikan chatbot Anda memberikan jawaban yang akurat (seperti "Aujourd’hui" untuk "today" dalam bahasa Prancis), LangWatch membuatnya mudah. Integrasinya dengan Python dan alat seperti Chainlit dan OpenAI berarti Anda dapat mulai melacak dan meningkatkan aplikasi LLM Anda dalam hitungan menit.

Misalnya, chatbot demo kami sekarang merespons dalam semburan mirip tweet dengan emoji, dan LangWatch membantu memastikan itu akurat dan dioptimalkan. Ingin meningkatkan skala? Tambahkan lebih banyak pertanyaan ke dataset Anda atau bereksperimen dengan model LLM yang berbeda di evaluator.

Kesimpulan

Begitulah! Anda telah mempelajari apa itu LangWatch, cara menginstalnya, dan cara menggunakannya untuk memantau dan mengoptimalkan chatbot. Dari menyiapkan proyek Python hingga melacak pesan dan mengevaluasi kinerja dengan dataset, LangWatch memberdayakan Anda untuk mengendalikan pipeline LLM Anda. Pertanyaan uji kami—"Apa kata bahasa Prancis untuk hari ini?"—menunjukkan betapa mudahnya melacak dan meningkatkan respons AI.

Siap meningkatkan permainan AI Anda? Kunjungi app.langwatch.ai, daftar, dan mulai bereksperimen dengan LangWatch hari ini.

Menginginkan platform Terintegrasi, All-in-One untuk Tim Pengembang Anda bekerja sama dengan produktivitas maksimum?

Apidog memenuhi semua permintaan Anda, dan menggantikan Postman dengan harga yang jauh lebih terjangkau!