Baru-baru ini, AI Meta yang canggih Llama 3.2 telah dirilis sebagai model bahasa yang mengubah permainan, menawarkan kemampuan mengesankan untuk pemrosesan teks dan gambar. Bagi pengembang dan penggemar AI yang ingin memanfaatkan kekuatan model canggih ini di mesin lokal mereka, alat seperti LM Studio menonjol. Panduan komprehensif ini akan memandu Anda melalui proses menjalankan Llama 3.2 secara lokal menggunakan platform canggih ini, memberdayakan Anda untuk memanfaatkan teknologi AI mutakhir tanpa bergantung pada layanan cloud.

Apa yang Baru dengan Llama 3.2: Inovasi AI Terbaru

Sebelum menyelami proses instalasi, mari kita jelajahi secara singkat apa yang membuat Llama 3.2 istimewa:

- Kemampuan Multimodal: Llama 3.2 dapat memproses teks dan gambar, membuka kemungkinan baru untuk aplikasi AI.

- Peningkatan Efisiensi: Dirancang untuk kinerja yang lebih baik dengan latensi yang berkurang, sehingga ideal untuk penerapan lokal.

- Ukuran Model yang Bervariasi: Tersedia dalam berbagai ukuran, dari model 1B dan 3B ringan yang cocok untuk perangkat edge hingga versi 11B dan 90B yang kuat untuk tugas yang lebih kompleks.

- Konteks yang Diperluas: Mendukung panjang konteks 128K, memungkinkan pemahaman dan pembuatan konten yang lebih komprehensif.

Jalankan Llama 3.2 dengan LM Studio Secara Lokal

LM Studio menawarkan pendekatan yang lebih ramah pengguna dengan antarmuka grafis. Berikut cara menjalankan Llama 3.2 secara lokal menggunakan LM Studio:

Langkah 1: Unduh dan Instal LM Studio

- Kunjungi situs web LM Studio.

- Unduh versi yang kompatibel dengan sistem operasi Anda.

- Ikuti petunjuk instalasi yang disediakan.

Langkah 2: Luncurkan LM Studio

Setelah diinstal, buka LM Studio. Anda akan disambut dengan antarmuka yang intuitif.

Langkah 3: Temukan dan Unduh Llama 3.2

- Gunakan fungsi pencarian di LM Studio untuk menemukan Llama 3.2.

- Pilih versi Llama 3.2 yang sesuai untuk kebutuhan Anda (misalnya, 3B untuk aplikasi ringan atau 11B untuk tugas yang lebih kompleks).

- Klik tombol unduh untuk memulai proses pengunduhan.

Langkah 4: Konfigurasikan Model

Setelah mengunduh, Anda dapat mengonfigurasi berbagai parameter:

- Sesuaikan panjang konteks jika diperlukan (Llama 3.2 mendukung hingga 128K).

- Atur nilai suhu dan pengambilan sampel top-p untuk mengontrol keacakan keluaran.

- Bereksperimen dengan pengaturan lain untuk menyempurnakan perilaku model.

Langkah 5: Mulai Berinteraksi dengan Llama 3.2

Dengan model yang dikonfigurasi, Anda sekarang dapat:

- Gunakan antarmuka obrolan untuk melakukan percakapan dengan Llama 3.2.

- Coba perintah yang berbeda untuk menjelajahi kemampuan model.

- Gunakan fitur Playground untuk bereksperimen dengan perintah dan pengaturan yang lebih canggih.

Langkah 6: Siapkan Server Lokal (Opsional)

Untuk pengembang, LM Studio memungkinkan Anda untuk menyiapkan server lokal:

- Buka tab Server di LM Studio.

- Konfigurasikan pengaturan server (port, titik akhir API, dll.).

- Mulai server untuk menggunakan Llama 3.2 melalui panggilan API di aplikasi Anda.

Praktik Terbaik untuk Menjalankan Llama 3.2 Secara Lokal

Untuk mendapatkan hasil maksimal dari pengaturan Llama 3.2 lokal Anda, pertimbangkan praktik terbaik ini:

- Pertimbangan Perangkat Keras: Pastikan mesin Anda memenuhi persyaratan minimum. GPU khusus dapat secara signifikan meningkatkan kinerja, terutama untuk ukuran model yang lebih besar.

- Rekayasa Prompt: Buat prompt yang jelas dan spesifik untuk mendapatkan hasil terbaik dari Llama 3.2. Bereksperimen dengan susunan kata yang berbeda untuk mengoptimalkan kualitas keluaran.

- Pembaruan Reguler: Selalu perbarui alat yang Anda pilih (LM Studio) dan model Llama 3.2 untuk kinerja terbaik dan fitur terbaru.

- Bereksperimen dengan Parameter: Jangan ragu untuk menyesuaikan pengaturan untuk menemukan keseimbangan yang tepat untuk kasus penggunaan Anda. Nilai yang lebih rendah umumnya menghasilkan keluaran yang lebih fokus dan deterministik, sementara nilai yang lebih tinggi memperkenalkan lebih banyak kreativitas dan variabilitas.

- Penggunaan Etis: Selalu gunakan model AI secara bertanggung jawab dan sadari potensi bias dalam keluaran. Pertimbangkan untuk menerapkan perlindungan atau filter tambahan jika diterapkan di lingkungan produksi.

- Privasi Data: Menjalankan Llama 3.2 secara lokal meningkatkan privasi data. Berhati-hatilah terhadap data yang Anda masukkan dan bagaimana Anda menggunakan keluaran model, terutama saat menangani informasi sensitif.

- Manajemen Sumber Daya: Pantau sumber daya sistem Anda saat menjalankan Llama 3.2, terutama untuk periode yang lebih lama atau dengan ukuran model yang lebih besar. Pertimbangkan untuk menggunakan pengelola tugas atau alat pemantauan sumber daya untuk memastikan kinerja optimal.

Memecahkan Masalah Umum

Saat menjalankan Llama 3.2 secara lokal, Anda mungkin menghadapi beberapa tantangan. Berikut adalah solusi untuk masalah umum:

- Kinerja Lambat:

- Pastikan Anda memiliki RAM dan daya CPU/GPU yang cukup.

- Coba gunakan ukuran model yang lebih kecil jika tersedia (misalnya, 3B alih-alih 11B).

- Tutup aplikasi latar belakang yang tidak perlu untuk membebaskan sumber daya sistem.

2. Kesalahan Kehabisan Memori:

- Kurangi panjang konteks dalam pengaturan model.

- Gunakan varian model yang lebih kecil jika tersedia.

- Tingkatkan RAM sistem Anda jika memungkinkan.

3. Masalah Instalasi:

- Periksa apakah sistem Anda memenuhi persyaratan minimum untuk LM Studio.

- Pastikan Anda memiliki versi terbaru dari alat yang Anda gunakan.

- Coba jalankan instalasi dengan hak administrator.

4. Kegagalan Unduhan Model:

- Periksa stabilitas koneksi internet Anda.

- Nonaktifkan sementara firewall atau VPN yang mungkin mengganggu pengunduhan.

- Coba unduh selama jam sibuk untuk bandwidth yang lebih baik.

5. Keluaran yang Tidak Terduga:

- Tinjau dan perbaiki prompt Anda untuk kejelasan dan kekhususan.

- Sesuaikan suhu dan parameter lain untuk mengontrol keacakan keluaran.

- Pastikan Anda menggunakan versi dan konfigurasi model yang benar.

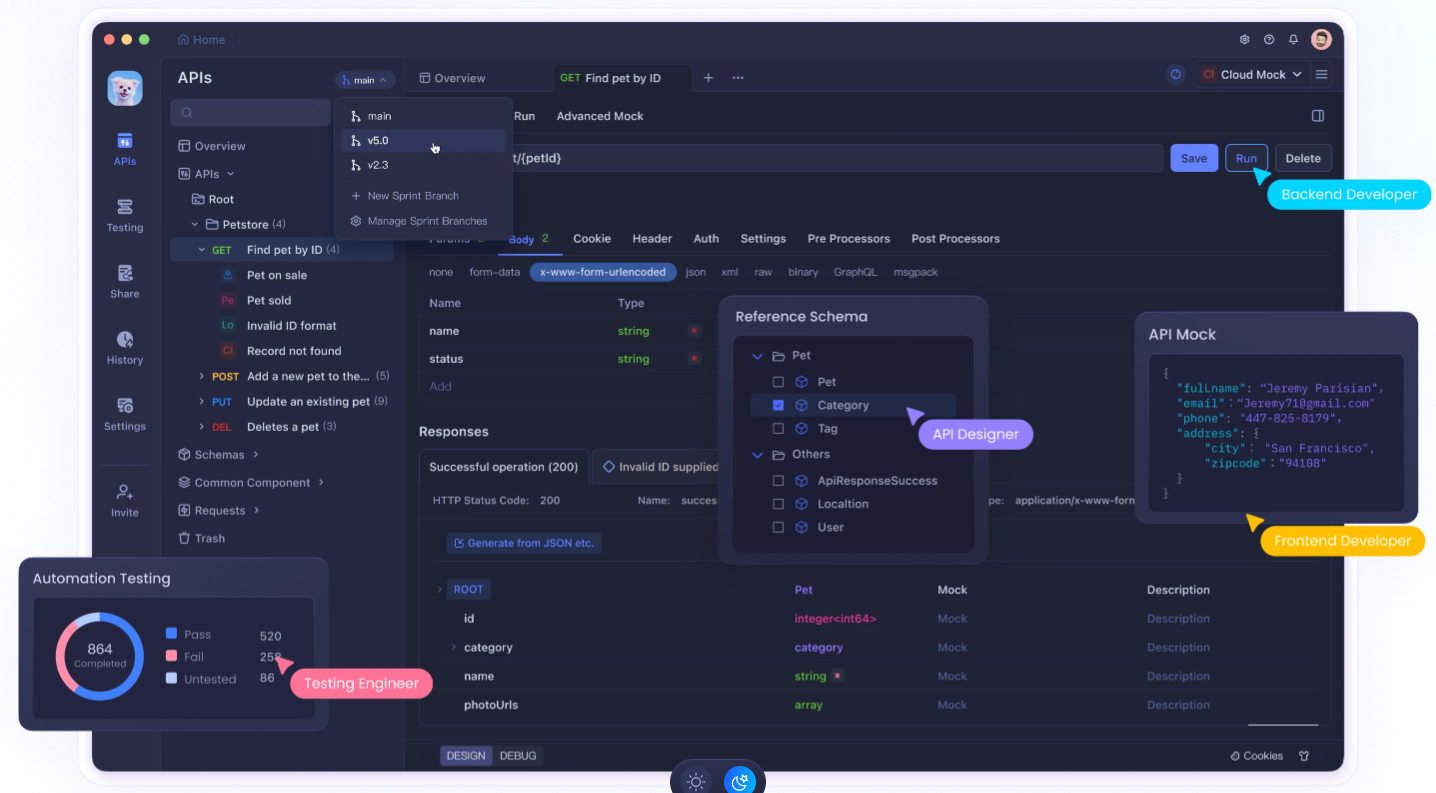

Menggunakan Apidog Meningkatkan Pengembangan API Anda

Menjalankan Llama 3.2 secara lokal sangat kuat, mengintegrasikannya ke dalam aplikasi Anda seringkali membutuhkan pengembangan dan pengujian API yang kuat. Di sinilah Apidog berperan. Apidog adalah platform pengembangan API komprehensif yang dapat secara signifikan meningkatkan alur kerja Anda saat bekerja dengan LLM lokal seperti Llama 3.2.

Fitur Utama Apidog untuk Integrasi LLM Lokal:

- Desain dan Dokumentasi API: Rancang dan dokumentasikan API dengan mudah untuk integrasi Llama 3.2 Anda, memastikan komunikasi yang jelas antara model lokal Anda dan bagian lain dari aplikasi Anda.

- Pengujian Otomatis: Buat dan jalankan pengujian otomatis untuk titik akhir API Llama 3.2 Anda, memastikan keandalan dan konsistensi dalam respons model Anda.

- Server Mock: Gunakan fungsionalitas server mock Apidog untuk mensimulasikan respons Llama 3.2 selama pengembangan, memungkinkan Anda untuk maju bahkan ketika Anda tidak memiliki akses langsung ke pengaturan lokal Anda.

- Manajemen Lingkungan: Kelola lingkungan yang berbeda (misalnya, Llama 3.2 lokal, API produksi) di dalam Apidog, sehingga mudah untuk beralih di antara konfigurasi selama pengembangan dan pengujian.

- Alat Kolaborasi: Bagikan desain API dan hasil pengujian Llama 3.2 Anda dengan anggota tim, mendorong kolaborasi yang lebih baik dalam proyek berbasis AI.

- Pemantauan Kinerja: Pantau kinerja titik akhir API Llama 3.2 Anda, membantu Anda mengoptimalkan waktu respons dan penggunaan sumber daya.

- Pengujian Keamanan: Terapkan pengujian keamanan untuk integrasi API Llama 3.2 Anda, memastikan bahwa penerapan model lokal Anda tidak menimbulkan kerentanan.

Memulai dengan Apidog untuk Pengembangan Llama 3.2:

- Mendaftar untuk akun Apidog.

- Buat proyek baru untuk integrasi API Llama 3.2 Anda.

- Rancang titik akhir API Anda yang akan berinteraksi dengan instance Llama 3.2 lokal Anda.

- Siapkan lingkungan untuk mengelola konfigurasi yang berbeda (misalnya, pengaturan LM Studio).

- Buat pengujian otomatis untuk memastikan integrasi Llama 3.2 Anda berfungsi dengan benar.

- Gunakan fitur server mock untuk mensimulasikan respons Llama 3.2 selama tahap awal pengembangan.

- Berkolaborasi dengan tim Anda dengan berbagi desain API dan hasil pengujian.

Dengan memanfaatkan Apidog bersama dengan pengaturan Llama 3.2 lokal Anda, Anda dapat membuat aplikasi bertenaga AI yang lebih kuat, terdokumentasi dengan baik, dan diuji secara menyeluruh.

Kesimpulan: Merangkul Kekuatan AI Lokal

Menjalankan Llama 3.2 secara lokal merupakan langkah signifikan menuju demokratisasi teknologi AI. Apakah Anda memilih antarmuka yang ramah pengguna dari LM Studio atau yang lain, Anda sekarang memiliki alat untuk memanfaatkan kekuatan model bahasa canggih di mesin Anda sendiri.

Ingatlah bahwa penerapan lokal model bahasa besar seperti Llama 3.2 hanyalah permulaan. Untuk benar-benar unggul dalam pengembangan AI, pertimbangkan untuk mengintegrasikan alat seperti Apidog ke dalam alur kerja Anda. Platform canggih ini dapat membantu Anda merancang, menguji, dan mendokumentasikan API yang berinteraksi dengan instance Llama 3.2 lokal Anda, menyederhanakan proses pengembangan Anda dan memastikan keandalan aplikasi bertenaga AI Anda.

Saat Anda memulai perjalanan Anda dengan Llama 3.2, teruslah bereksperimen, tetaplah ingin tahu, dan selalu berupaya untuk menggunakan AI secara bertanggung jawab. Masa depan AI tidak hanya di cloud – tetapi juga di mesin lokal Anda, menunggu untuk dieksplorasi dan dimanfaatkan untuk aplikasi inovatif. Dengan alat dan praktik yang tepat, Anda dapat membuka potensi penuh AI lokal dan menciptakan solusi inovatif yang mendorong batas-batas dari apa yang mungkin dalam teknologi.