Pengembang terus mencari alat yang meningkatkan produktivitas tanpa membengkakkan biaya. GLM-4.5 muncul sebagai pengubah permainan di bidang ini, menawarkan kemampuan tangguh untuk tugas pengkodean. Saat Anda memasangkannya dengan Claude Code, Anda mendapatkan akses ke bantuan AI canggih yang menyaingi model-model papan atas. M

Memahami GLM-4.5: Fondasi Pengkodean AI Tingkat Lanjut

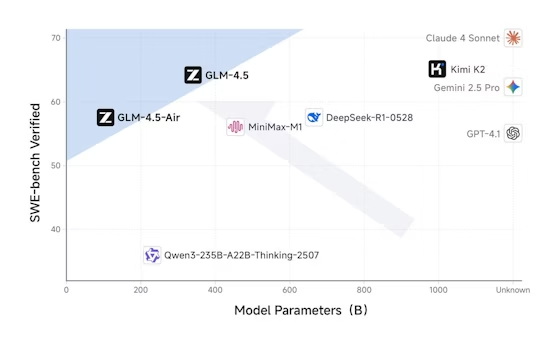

Z.ai mengembangkan GLM-4.5 sebagai model bahasa besar unggulan yang disesuaikan untuk aplikasi berorientasi agen. Insinyur di Z.ai menggunakan arsitektur Mixture-of-Experts (MoE), yang mengaktifkan 32 miliar parameter dari total 355 miliar selama setiap *forward pass*. Desain ini mengoptimalkan efisiensi, memungkinkan model menangani tugas-tugas kompleks tanpa *overhead* komputasi yang berlebihan. Selain itu, GLM-4.5 menjalani *pretraining* pada 15 triliun token, diikuti dengan *fine-tuning* pada *dataset* khusus untuk pembuatan kode, penalaran, dan perilaku agen.

Model ini mendukung jendela konteks 128k token, memungkinkannya memproses *codebase* yang ekstensif atau instruksi multi-langkah dalam sekali jalan. Pengembang menghargai fitur ini karena mengurangi kebutuhan akan *prompt* yang berulang. Selain itu, GLM-4.5 menggabungkan mode penalaran hibrida: Mode Berpikir untuk masalah rumit dan Mode Non-Berpikir untuk respons cepat. Anda mengaktifkan ini melalui parameter `thinking.type` dalam panggilan API, memberikan fleksibilitas berdasarkan tuntutan tugas.

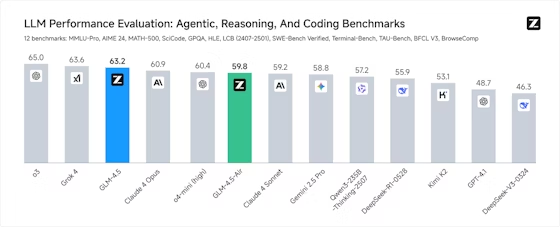

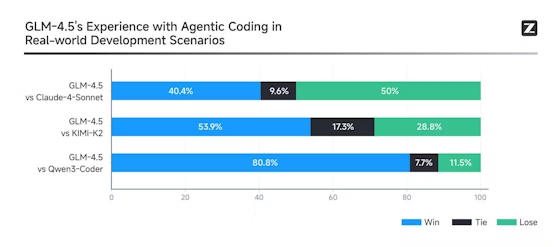

*Benchmark* menggarisbawahi kehebatan GLM-4.5. Ia menempati peringkat kedua secara global di 12 *suite*, termasuk MMLU Pro untuk penalaran multifaset dan LiveCodeBench untuk tantangan pengkodean *real-time*. Secara praktis, ini berarti GLM-4.5 menghasilkan skrip Python atau fungsi JavaScript dengan akurasi tinggi, seringkali mengungguli model seperti Claude 3.5 Sonnet dalam tugas panggilan fungsi. Namun, kekuatan sejatinya terletak pada fungsi agen, di mana ia memanggil alat, menjelajahi web, atau merekayasa komponen perangkat lunak secara otonom.

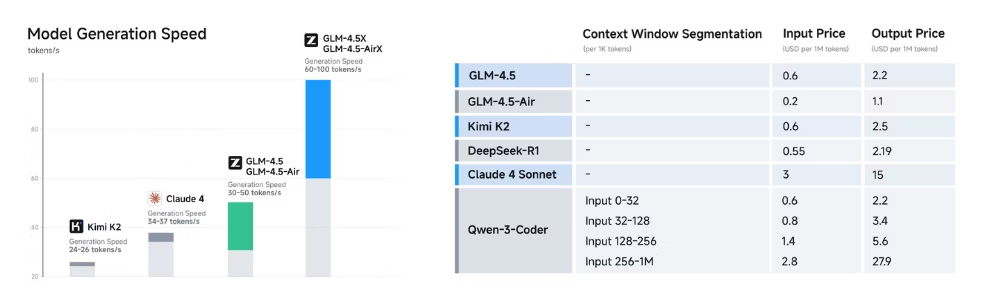

GLM-4.5-Air, varian yang lebih ringan dengan total 106 miliar parameter dan 12 miliar aktif, melengkapi model utama untuk skenario yang menuntut kecepatan daripada kekuatan mentah. Kedua varian terintegrasi dengan mulus dengan alat pengembangan, menjadikannya ideal untuk lingkungan pengkodean. Akibatnya, tim mengadopsi GLM-4.5 untuk merampingkan alur kerja, mulai dari *debugging* kode lama hingga membuat prototipe aplikasi baru.

Apa Itu Claude Code dan Mengapa Mengintegrasikannya dengan GLM-4.5?

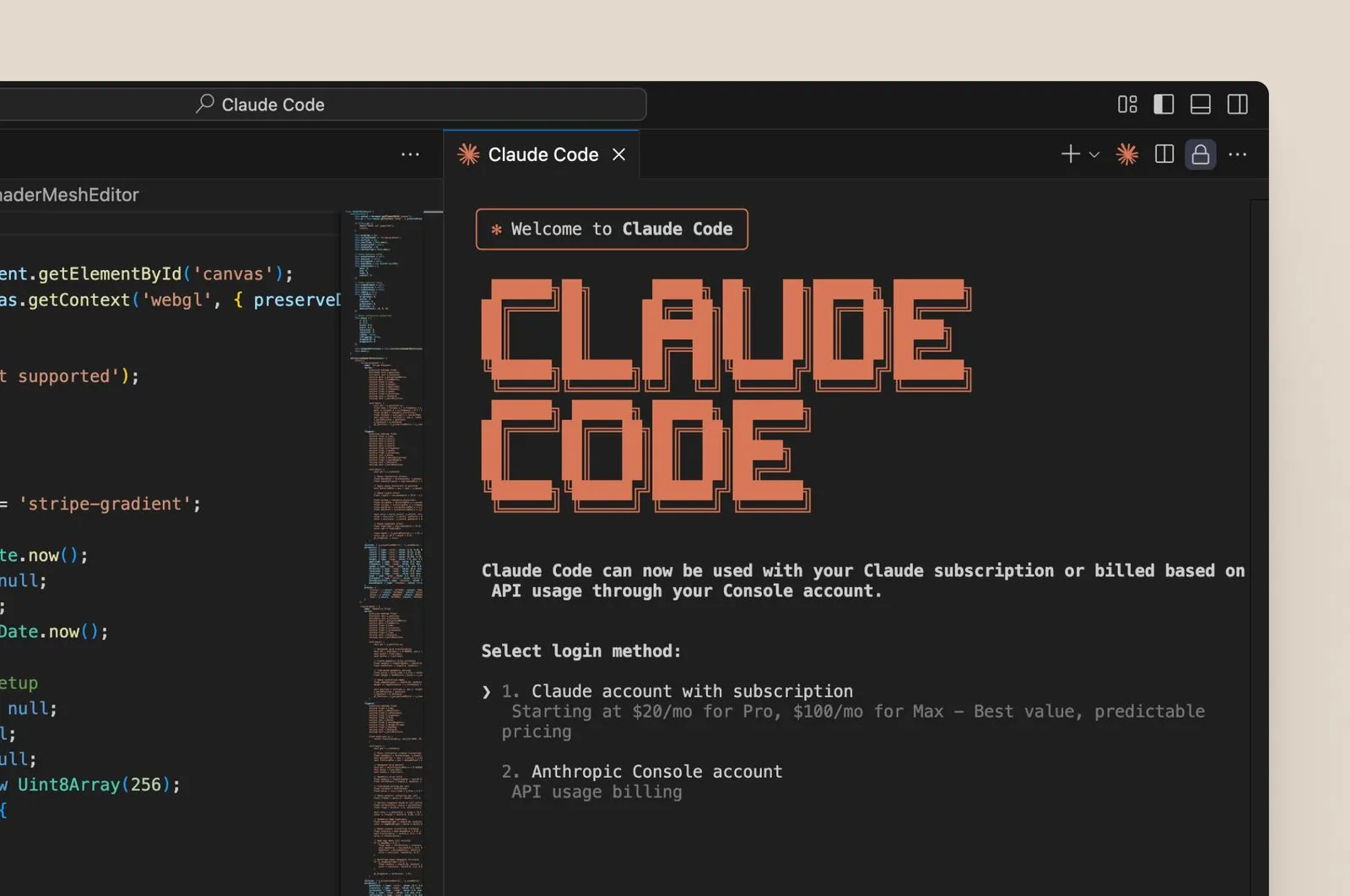

Claude Code berfungsi sebagai asisten pengkodean berbasis terminal yang memanfaatkan AI untuk mengotomatiskan tugas pengembangan. Pengguna menginstalnya sebagai alat CLI atau mengintegrasikannya ke dalam IDE seperti VS Code. Awalnya dirancang berdasarkan model Claude Anthropic, Claude Code mengeksekusi perintah, menghasilkan *snippet* kode, dan mengelola repositori melalui masukan bahasa alami. Misalnya, Anda mungkin menginstruksikannya untuk "refactor fungsi ini untuk kinerja yang lebih baik," dan ia merespons dengan kode yang dioptimalkan.

Integrasi dengan GLM-4.5 terjadi melalui titik akhir API Z.ai yang kompatibel dengan Anthropic. Kompatibilitas ini memungkinkan Anda menukar model Claude dengan GLM-4.5 tanpa mengubah fungsionalitas inti Claude Code. Akibatnya, pengembang mengarahkan permintaan ke server Z.ai, mendapatkan manfaat dari tingkat pemanggilan alat GLM-4.5 yang superior—hingga 90% keberhasilan dalam *benchmark*.

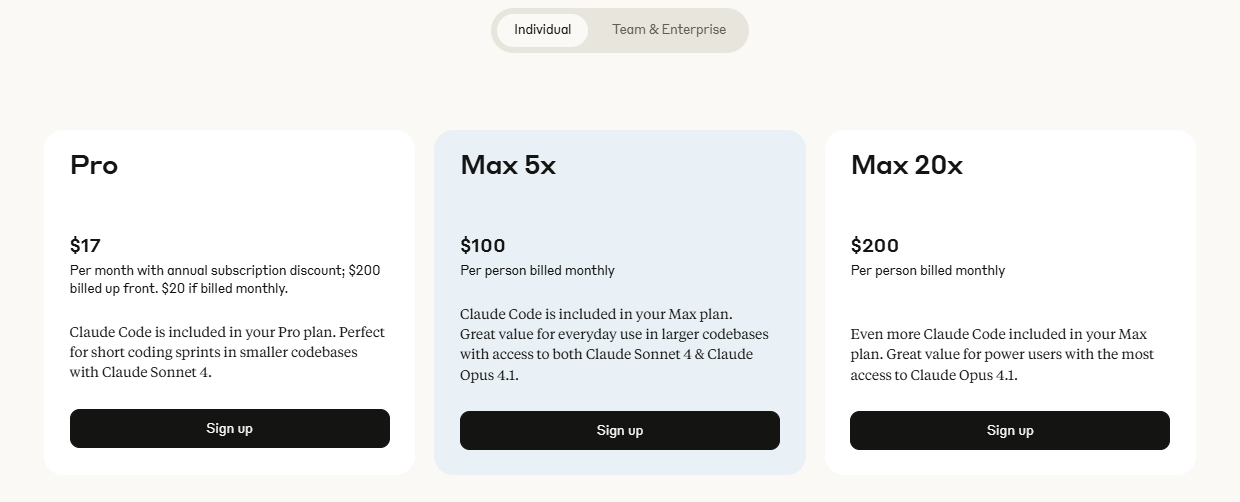

Mengapa melakukan peralihan ini? GLM-4.5 menawarkan keunggulan biaya dan peningkatan kinerja dalam pengkodean agen. Paket Claude tradisional dapat berharga $100-$200 per bulan untuk penggunaan berat, tetapi Paket Pengkodean GLM Z.ai dimulai dari $3 untuk Lite dan $15 untuk Pro, menyediakan 3x penggunaan tingkat Claude yang sebanding. Keterjangkauan ini menarik pengembang independen dan *startup*. Selain itu, GLM-4.5 unggul dalam domain seperti pengembangan *front-end* dan perbaikan *bug*, menyelesaikan tugas dalam hitungan menit yang mungkin memakan waktu berjam-jam secara manual.

Manfaat Menggunakan GLM-4.5 dengan Claude Code

Menggabungkan GLM-4.5 dan Claude Code menghasilkan keuntungan nyata. Pertama, Anda mencapai siklus iterasi yang lebih cepat. Kecepatan generasi GLM-4.5 melebihi 100 token per detik, memungkinkan saran kode *real-time* di Claude Code. Kecepatan ini terbukti krusial selama sesi *debugging*, di mana perbaikan cepat mencegah gangguan alur kerja.

Kedua, integrasi meningkatkan akurasi. *Fine-tuning* pembelajaran penguatan GLM-4.5 memastikan *output* yang andal, mengurangi halusinasi dalam pembuatan kode. Misalnya, ia mematuhi praktik terbaik dalam bahasa seperti Java atau C++, menggabungkan penanganan kesalahan dan optimasi secara otomatis. Oleh karena itu, pengembang menghabiskan lebih sedikit waktu untuk merevisi kode yang dihasilkan AI.

Ketiga, efisiensi biaya menonjol. Paket GLM Coding Pro seharga $15/bulan membuka tugas-tugas intensif dengan kapasitas 3x lipat dari paket Claude Max. Lite seharga $3 cocok untuk kebutuhan ringan, membuat AI canggih dapat diakses. Didukung oleh GLM-4.5 dan GLM-4.5-Air, paket-paket ini menjanjikan integrasi alat yang akan datang, memperluas kemampuan lebih lanjut.

Keamanan juga meningkat. API Z.ai mendukung *output* terstruktur seperti JSON, memastikan respons yang dapat diprediksi di Claude Code. Selain itu, *caching* konteks meminimalkan komputasi yang berlebihan, menurunkan latensi dalam sesi panjang.

Terakhir, sifat *open-source* GLM-4.5 memungkinkan penyesuaian. Tim melakukan *fine-tune* model untuk tugas-tugas spesifik domain, mengintegrasikannya lebih dalam ke dalam alur kerja Claude Code. Secara keseluruhan, pasangan ini mengubah pengkodean dari upaya tunggal menjadi proses yang diperkaya AI.

Panduan Langkah demi Langkah: Menyiapkan GLM-4.5 di Claude Code

Anda memulai dengan menyiapkan lingkungan Anda. Instal Claude Code melalui CLI atau ekstensi resminya. Selanjutnya, daftar di platform Z.ai untuk mendapatkan kunci API. Berlangganan Paket Pengkodean GLM jika penggunaan Anda melebihi tingkatan gratis—Lite cocok untuk pemula.

Konfigurasi integrasi. Di pengaturan Claude Code, temukan file konfigurasi API (seringkali ~/.claude/config.yaml). Perbarui URL dasar ke titik akhir Z.ai: https://api.z.ai/api/paas/v4/chat/completions. Masukkan kunci API Anda di *header* otorisasi.

Uji penyiapan. Luncurkan Claude Code dan berikan perintah sederhana: "Buat fungsi Python untuk mengurutkan daftar." GLM-4.5 memproses ini melalui API yang kompatibel, mengembalikan kode. Verifikasi *output* untuk kebenaran.

Aktifkan fitur-fitur canggih. Atur `thinking.type` ke "enabled" untuk tugas-tugas kompleks. Ini mengaktifkan penalaran mendalam GLM-4.5, ideal untuk keputusan arsitektur. Gunakan *streaming* dengan menambahkan `stream: true` ke permintaan, memungkinkan tampilan kode progresif di Claude Code.

Tangani alat. GLM-4.5 mendukung panggilan fungsi—definisikan alat dalam *prompt* Anda, dan model akan memanggilnya. Untuk penjelajahan web, sertakan alat peramban; Claude Code mengarahkan ini dengan mulus.

Pecahkan masalah. Jika otentikasi gagal, buat ulang kunci Anda. Untuk batas *rate*, pantau penggunaan di *dashboard* Z.ai. Apidog membantu di sini dengan mensimulasikan panggilan sebelum integrasi langsung.

Menguji API GLM-4.5 dengan Apidog: Memastikan Keandalan

Apidog merampingkan pengujian API, menjadikannya penting untuk integrasi GLM-4.5. Anda membuat proyek baru di Apidog dan mengimpor spesifikasi OpenAPI Z.ai. Definisikan titik akhir seperti /chat/completions.

Buat permintaan. Atur *header* dengan kunci API Anda dan *content-type* sebagai JSON. Di *body*, tentukan model sebagai "glm-4.5" dan tambahkan *array* pesan untuk *prompt*.

Jalankan pengujian. Apidog mengeksekusi panggilan, menampilkan respons dengan kode status. Tegaskan *output* yang diharapkan, seperti kode berstruktur JSON.

Otomatiskan skenario. Buat *suite* pengujian untuk variasi—uji Mode Berpikir versus Non-Berpikir, atau suhu yang berbeda (0.6 untuk kreativitas yang seimbang).

Pantau kinerja. Apidog melacak latensi dan kesalahan, membantu mengoptimalkan parameter sebelum penerapan Claude Code.

Integrasikan dengan CI/CD. Ekspor skrip Apidog ke *pipeline*, memastikan keandalan GLM-4.5 setelah pembaruan.

Penggunaan Lanjutan: Memanfaatkan Fitur Agen GLM-4.5 di Claude Code

GLM-4.5 unggul dalam tugas agen. Anda mendefinisikan agen dalam *prompt* Claude Code, dan GLM-4.5 mengaturnya. Misalnya, buat agen *refactoring*: "Analisis *codebase* ini dan sarankan perbaikan."

Gunakan pemanggilan multi-alat. GLM-4.5 menangani rantai—menjelajahi dokumen, menghasilkan kode, mengujinya—semuanya dalam satu sesi.

*Fine-tune* untuk spesifik. Unggah *dataset* ke Z.ai untuk model kustom, lalu arahkan Claude Code ke sana.

Skala dengan *caching*. Simpan konteks di *cache* GLM-4.5, mempercepat pengkodean iteratif.

Gabungkan varian. Beralih ke GLM-4.5-Air untuk tugas cepat, sisakan GLM-4.5 penuh untuk tugas intensif.

Harga dan Paket: Membuat GLM-4.5 Terjangkau untuk Pengguna Claude Code

Z.ai menyesuaikan paket untuk Claude Code. Lite seharga $3/bulan menawarkan 3x penggunaan Claude Pro untuk pengkodean kasual. Pro seharga $15/bulan melipatgandakan Claude Max, cocok untuk profesional.

Tingkatan gratis ada untuk pengujian, tetapi paket membuka potensi tak terbatas. Bandingkan: API Standar berharga $0.2/M token masukan, tetapi paket digabungkan untuk penghematan.

Tantangan Umum dan Solusi

Lonjakan latensi? Optimalkan *prompt*. Kesalahan dalam panggilan alat? Sempurnakan definisi. Apidog mengidentifikasi ini lebih awal.

Kesimpulan

Mengintegrasikan GLM-4.5 dengan Claude Code memberdayakan pengembang. Ikuti langkah-langkah ini, manfaatkan Apidog, dan ubah praktik pengkodean Anda. Kombinasi ini memberikan efisiensi, akurasi, dan keterjangkauan—mulai hari ini.