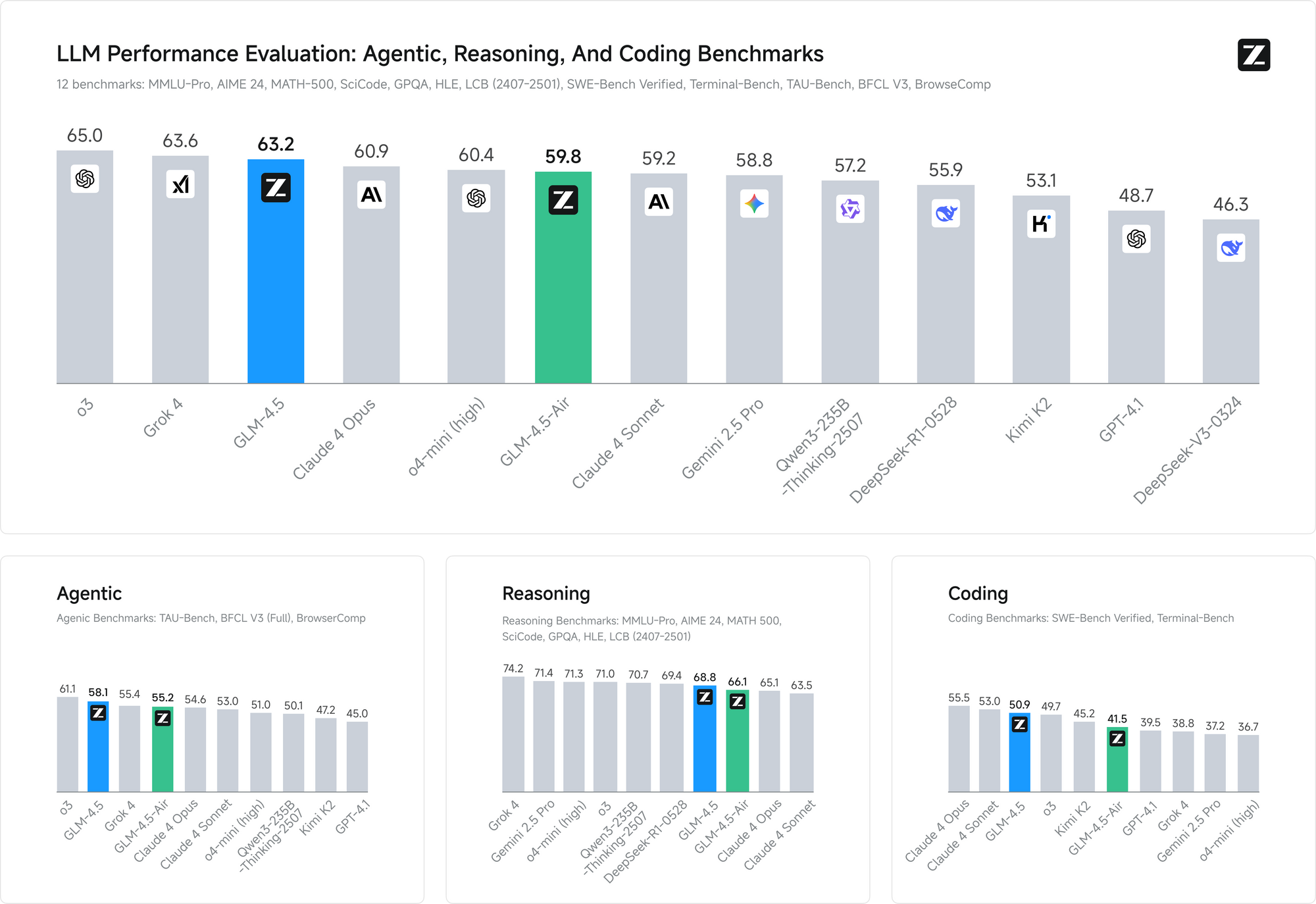

Lanskap AI sumber terbuka baru saja menyaksikan pergeseran seismik lainnya. Z.ai, perusahaan AI Tiongkok yang sebelumnya dikenal sebagai Zhipu, telah merilis GLM-4.5 dan GLM-4.5 Air, menjanjikan untuk melampaui DeepSeek sekaligus menetapkan standar baru untuk kinerja dan aksesibilitas AI. Model-model ini mewakili lebih dari sekadar peningkatan inkremental—mereka mewujudkan pemikiran ulang mendasar tentang bagaimana penalaran hibrida dan kemampuan agen harus berfungsi di lingkungan produksi.

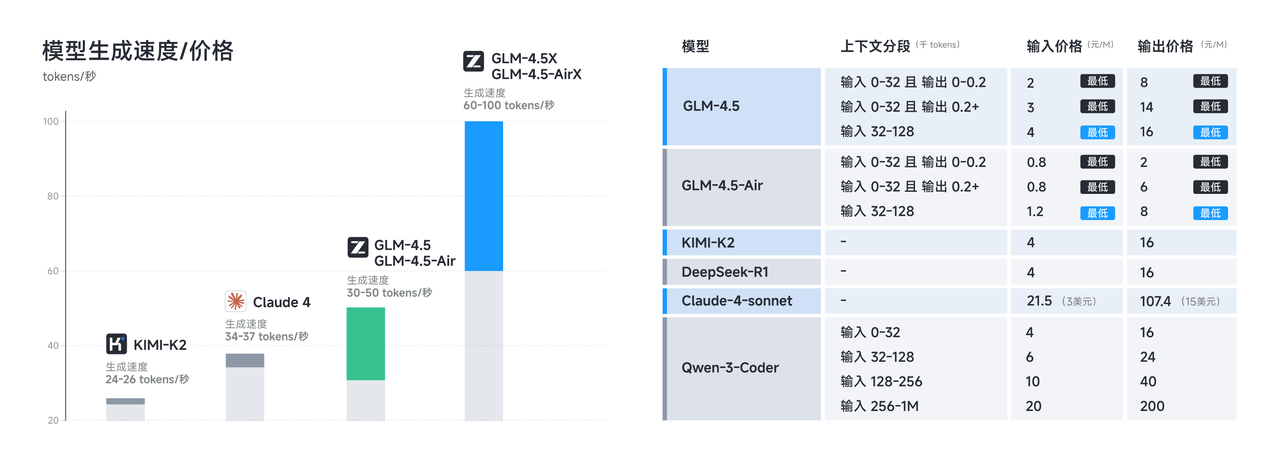

Perilisan ini datang pada saat yang krusial ketika pengembang semakin menuntut alternatif hemat biaya untuk model-model proprietary tanpa mengorbankan kemampuan. Baik GLM-4.5 maupun GLM-4.5 Air memenuhi janji ini melalui inovasi arsitektur canggih yang memaksimalkan efisiensi sambil mempertahankan kinerja mutakhir di seluruh tugas penalaran, pengkodean, dan multimodal.

Memahami Revolusi Arsitektur GLM-4.5

Seri GLM-4.5 mewakili penyimpangan signifikan dari arsitektur transformer tradisional. Dibangun di atas arsitektur yang sepenuhnya dikembangkan sendiri, GLM-4.5 mencapai kinerja SOTA dalam model sumber terbuka melalui beberapa inovasi kunci yang membedakannya dari pesaing.

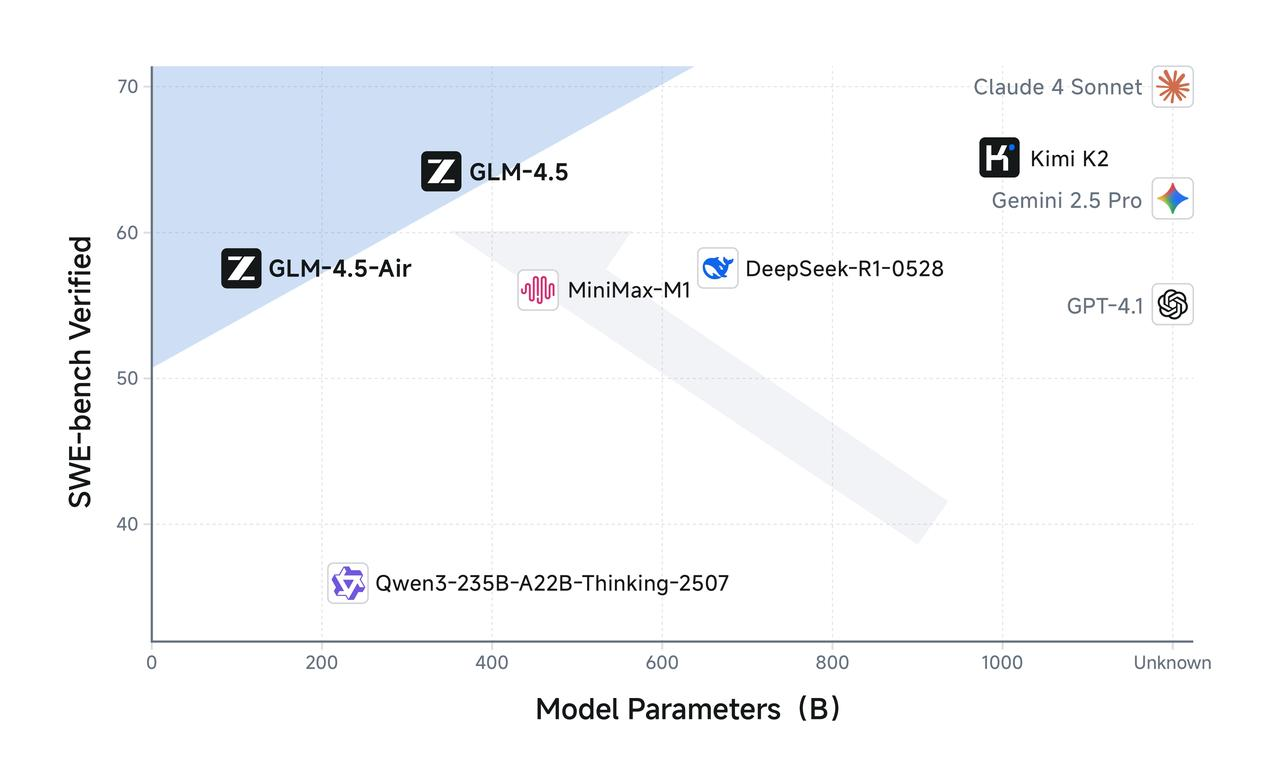

GLM-4.5 memiliki total 355 miliar parameter dengan 32 miliar parameter aktif, sementara GLM-4.5 Air mengadopsi desain yang lebih ringkas dengan total 106 miliar parameter dan 12 miliar parameter aktif. Konfigurasi parameter ini mencerminkan keseimbangan yang cermat antara efisiensi komputasi dan kemampuan model, memungkinkan kedua model untuk memberikan kinerja yang mengesankan sambil mempertahankan biaya inferensi yang wajar.

Model-model ini menggunakan arsitektur Mixture of Experts (MoE) yang canggih yang hanya mengaktifkan sebagian parameter selama inferensi. Keduanya memanfaatkan desain Mixture of Experts untuk efisiensi optimal, memungkinkan GLM-4.5 memproses tugas-tugas kompleks hanya dengan menggunakan 32 miliar dari 355 miliar parameternya. Sementara itu, GLM-4.5 Air mempertahankan kemampuan penalaran yang sebanding dengan hanya 12 miliar parameter aktif dari total 106 miliar parameter yang dimilikinya.

Pendekatan arsitektur ini secara langsung mengatasi salah satu tantangan paling mendesak dalam penerapan model bahasa besar: overhead komputasi inferensi. Model padat tradisional memerlukan pengaktifan semua parameter untuk setiap operasi inferensi, menciptakan beban komputasi yang tidak perlu untuk tugas-tugas yang lebih sederhana. Seri GLM-4.5 memecahkan masalah ini melalui perutean parameter cerdas yang mencocokkan kompleksitas komputasi dengan persyaratan tugas.

Selain itu, model-model ini mendukung jendela konteks input hingga 128k dan output 96k, menyediakan kemampuan penanganan konteks yang substansial yang memungkinkan penalaran bentuk panjang yang canggih dan analisis dokumen yang komprehensif. Jendela konteks yang diperluas ini terbukti sangat berharga untuk aplikasi agen di mana model harus mempertahankan kesadaran akan interaksi multi-langkah yang kompleks.

Karakteristik Kinerja GLM-4.5 Air yang Dioptimalkan

GLM-4.5 Air muncul sebagai juara efisiensi dalam seri ini, secara khusus direkayasa untuk skenario di mana sumber daya komputasi memerlukan pengelolaan yang cermat. GLM-4.5 Air adalah model dasar yang dirancang khusus untuk aplikasi agen AI, dibangun di atas arsitektur Mixture-of-Experts (MoE) yang memprioritaskan kecepatan dan optimasi sumber daya tanpa mengorbankan kemampuan inti.

Varian Air menunjukkan bagaimana pengurangan parameter yang cermat dapat mempertahankan kualitas model sambil secara dramatis meningkatkan kelayakan penerapan. Dengan total 106 miliar parameter dan 12 miliar parameter aktif, GLM-4.5 Air mencapai peningkatan efisiensi yang luar biasa yang secara langsung berarti pengurangan biaya inferensi dan waktu respons yang lebih cepat.

Persyaratan memori merupakan area lain di mana GLM-4.5 Air unggul. GLM-4.5 Air membutuhkan memori GPU 16GB (INT4 terkuantisasi sekitar 12GB), membuatnya dapat diakses oleh organisasi dengan kendala perangkat keras moderat. Faktor aksesibilitas ini terbukti krusial untuk adopsi yang luas, karena banyak tim pengembangan tidak dapat membenarkan biaya infrastruktur yang terkait dengan model yang lebih besar.

Optimasi melampaui efisiensi parameter murni untuk mencakup pelatihan khusus untuk tugas-tugas berorientasi agen. Ini telah dioptimalkan secara ekstensif untuk penggunaan alat, penjelajahan web, pengembangan perangkat lunak, dan pengembangan front-end, memungkinkan integrasi tanpa batas dengan agen pengkodean. Spesialisasi ini berarti GLM-4.5 Air memberikan kinerja yang unggul pada tugas-tugas pengembangan praktis dibandingkan dengan model serbaguna dengan ukuran serupa.

Latensi respons menjadi sangat penting dalam aplikasi interaktif di mana pengguna mengharapkan umpan balik yang hampir instan. Jumlah parameter GLM-4.5 Air yang berkurang dan pipeline inferensi yang dioptimalkan memungkinkan waktu respons di bawah satu detik untuk sebagian besar kueri, membuatnya cocok untuk aplikasi waktu nyata seperti penyelesaian kode, debugging interaktif, dan pembuatan dokumentasi langsung.

Implementasi dan Manfaat Penalaran Hibrida

Karakteristik utama dari kedua model GLM-4.5 terletak pada kemampuan penalaran hibrida mereka. Baik GLM-4.5 maupun GLM-4.5 Air adalah model penalaran hibrida yang menyediakan dua mode: mode berpikir untuk penalaran kompleks dan penggunaan alat, serta mode tidak berpikir untuk respons instan. Arsitektur mode ganda ini mewakili inovasi mendasar dalam cara model AI menangani berbagai jenis tugas kognitif.

Mode berpikir aktif ketika model menghadapi masalah kompleks yang memerlukan penalaran multi-langkah, penggunaan alat, atau analisis yang diperluas. Selama mode berpikir, model menghasilkan langkah-langkah penalaran perantara yang tetap terlihat oleh pengembang tetapi tersembunyi dari pengguna akhir. Transparansi ini memungkinkan debugging dan optimasi proses penalaran sambil mempertahankan antarmuka pengguna yang bersih.

Sebaliknya, mode tidak berpikir menangani kueri langsung yang mendapat manfaat dari respons instan tanpa overhead penalaran yang diperpanjang. Model secara otomatis menentukan mode mana yang akan digunakan berdasarkan kompleksitas dan konteks kueri, memastikan pemanfaatan sumber daya yang optimal di berbagai kasus penggunaan.

Pendekatan hibrida ini memecahkan tantangan yang terus-menerus dalam sistem AI produksi: menyeimbangkan kecepatan respons dengan kualitas penalaran. Model tradisional mengorbankan kecepatan untuk penalaran komprehensif atau memberikan respons cepat tetapi berpotensi dangkal. Sistem hibrida GLM-4.5 menghilangkan pertukaran ini dengan mencocokkan kompleksitas penalaran dengan persyaratan tugas.

Keduanya menyediakan mode berpikir untuk tugas-tugas kompleks dan mode tidak berpikir untuk respons instan, menciptakan pengalaman pengguna yang mulus yang beradaptasi dengan berbagai tuntutan kognitif. Pengembang dapat mengonfigurasi parameter pemilihan mode untuk menyempurnakan keseimbangan antara kecepatan dan kedalaman penalaran berdasarkan persyaratan aplikasi tertentu.

Mode berpikir terbukti sangat berharga untuk aplikasi agen di mana model harus merencanakan tindakan multi-langkah, mengevaluasi opsi penggunaan alat, dan mempertahankan penalaran yang koheren di seluruh interaksi yang diperpanjang. Sementara itu, mode tidak berpikir memastikan kinerja responsif untuk kueri sederhana seperti pencarian fakta atau tugas penyelesaian kode langsung.

Spesifikasi Teknis dan Detail Pelatihan

Fondasi teknis yang mendasari kemampuan GLM-4.5 yang mengesankan mencerminkan upaya rekayasa ekstensif dan metodologi pelatihan inovatif. Dilatih dengan 15 triliun token, dengan dukungan untuk jendela konteks input hingga 128k dan output 96k, model-model ini menunjukkan skala dan kecanggihan yang diperlukan untuk kinerja mutakhir.

Kurasi data pelatihan merupakan faktor kritis dalam kualitas model, terutama untuk aplikasi khusus seperti pembuatan kode dan penalaran agen. Korpus pelatihan 15 triliun token menggabungkan berbagai sumber termasuk repositori kode, dokumentasi teknis, contoh penalaran, dan konten multimodal yang memungkinkan pemahaman komprehensif di seluruh domain.

Kemampuan jendela konteks membedakan GLM-4.5 dari banyak model pesaing. GLM-4.5 menyediakan panjang konteks 128k dan kapasitas pemanggilan fungsi asli, memungkinkan analisis bentuk panjang yang canggih dan percakapan multi-giliran tanpa pemotongan konteks. Jendela konteks output 96k memastikan model dapat menghasilkan respons komprehensif tanpa batasan panjang buatan.

Pemanggilan fungsi asli mewakili keuntungan arsitektur lain yang menghilangkan kebutuhan akan lapisan orkestrasi eksternal. Model dapat langsung memanggil alat dan API eksternal sebagai bagian dari proses penalaran mereka, menciptakan alur kerja agen yang lebih efisien dan andal. Kemampuan ini terbukti penting untuk aplikasi produksi di mana model harus berinteraksi dengan basis data, layanan eksternal, dan alat pengembangan.

Proses pelatihan menggabungkan optimasi khusus untuk tugas-tugas agen, memastikan model mengembangkan kemampuan yang kuat dalam penggunaan alat, penalaran multi-langkah, dan pemeliharaan konteks. Arsitektur terpadu untuk penalaran, pengkodean, dan alur kerja persepsi-aksi multimodal memungkinkan transisi tanpa batas antara berbagai jenis tugas dalam interaksi tunggal.

Tolok ukur kinerja memvalidasi efektivitas pendekatan pelatihan ini. Pada kedua tolok ukur, GLM-4.5 menyamai kinerja Claude dalam evaluasi kemampuan agen, menunjukkan kemampuan kompetitif terhadap model proprietary terkemuka sambil mempertahankan aksesibilitas sumber terbuka.

Keuntungan Lisensi dan Penerapan Komersial

Lisensi sumber terbuka merupakan salah satu keunggulan kompetitif paling signifikan GLM-4.5 dalam lanskap AI saat ini. Model dasar, model hibrida (berpikir/tidak berpikir), dan versi FP8 semuanya dirilis untuk penggunaan komersial tanpa batasan dan pengembangan sekunder di bawah lisensi MIT, memberikan kebebasan yang belum pernah ada sebelumnya untuk penerapan komersial.

Pendekatan lisensi ini menghilangkan banyak batasan yang membatasi model sumber terbuka lainnya. Organisasi dapat memodifikasi, mendistribusikan ulang, dan mengkomersialkan implementasi GLM-4.5 tanpa biaya lisensi atau batasan penggunaan. Lisensi MIT secara khusus menangani masalah komersial yang seringkali mempersulit penerapan AI perusahaan.

Berbagai Metode Akses dan Integrasi Platform

GLM-4.5 dan GLM-4.5 Air menawarkan berbagai jalur akses kepada pengembang, masing-masing dioptimalkan untuk kasus penggunaan dan persyaratan teknis yang berbeda. Memahami opsi penerapan ini memungkinkan tim untuk memilih metode integrasi yang paling sesuai untuk aplikasi spesifik mereka.

Situs Web Resmi dan Akses API Langsung

Metode akses utama melibatkan penggunaan platform resmi Z.ai di chat.z.ai, yang menyediakan antarmuka yang ramah pengguna untuk interaksi model langsung. Antarmuka berbasis web ini memungkinkan pembuatan prototipe dan pengujian cepat tanpa memerlukan pekerjaan integrasi teknis. Pengembang dapat mengevaluasi kemampuan model, menguji strategi rekayasa prompt, dan memvalidasi kasus penggunaan sebelum berkomitmen pada implementasi API.

Akses API langsung melalui titik akhir resmi Z.ai menyediakan kemampuan integrasi tingkat produksi dengan dokumentasi dan dukungan komprehensif. API resmi menawarkan kontrol yang terperinci atas parameter model, termasuk pemilihan mode penalaran hibrida, pemanfaatan jendela konteks, dan opsi pemformatan respons.

Integrasi OpenRouter untuk Akses yang Disederhanakan

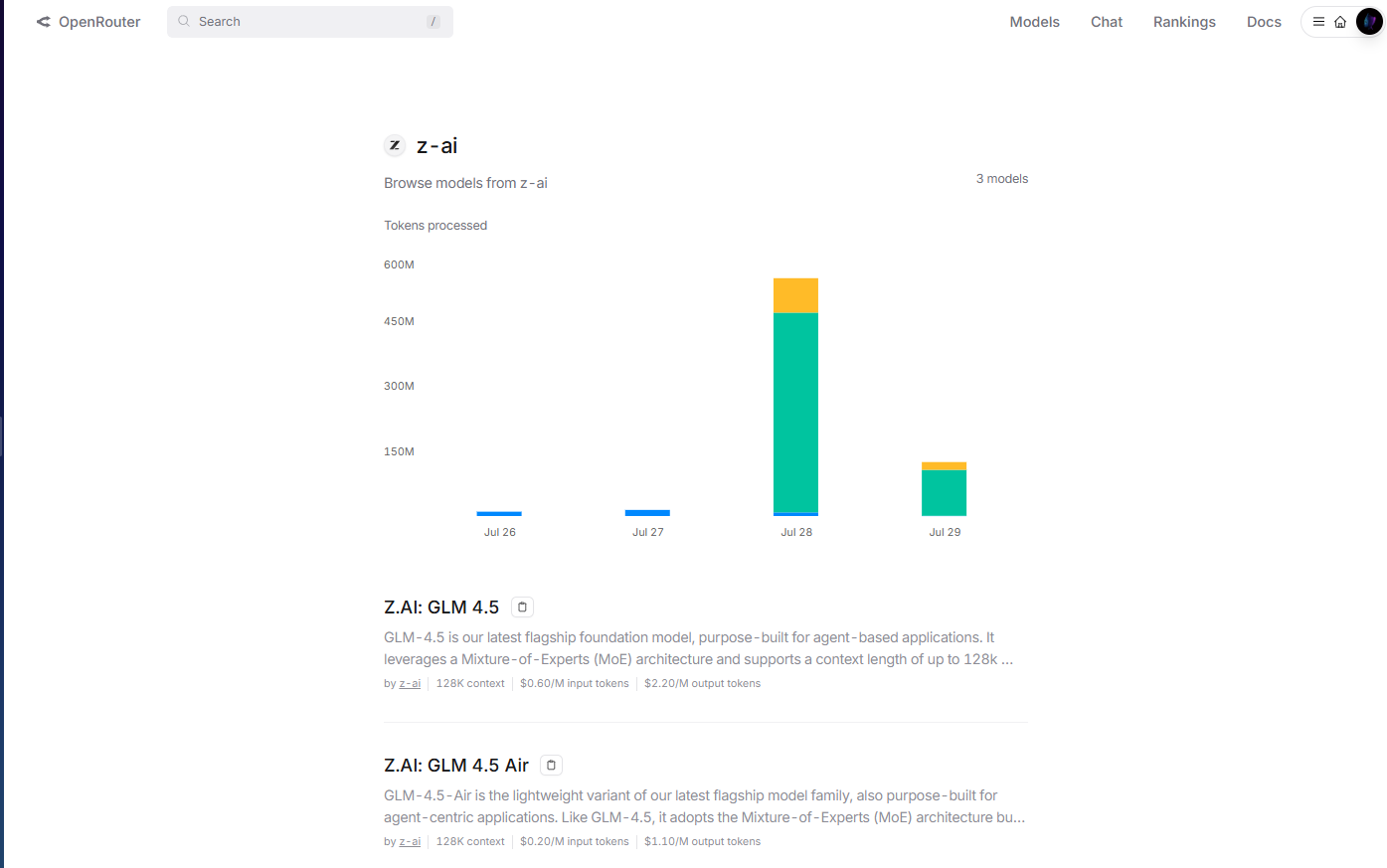

OpenRouter menyediakan akses yang disederhanakan ke model GLM-4.5 melalui platform API terpadu mereka di openrouter.ai/z-ai. Metode integrasi ini terbukti sangat berharga bagi pengembang yang sudah menggunakan infrastruktur multi-model OpenRouter, karena menghilangkan kebutuhan akan manajemen kunci API terpisah dan pola integrasi.

Implementasi OpenRouter menangani otentikasi, pembatasan laju, dan penanganan kesalahan secara otomatis, mengurangi kompleksitas integrasi untuk tim pengembangan. Selain itu, format API standar OpenRouter memungkinkan peralihan model yang mudah dan pengujian A/B antara GLM-4.5 dan model lain yang tersedia tanpa modifikasi kode.

Manajemen biaya menjadi lebih transparan melalui sistem penagihan terpadu OpenRouter, yang menyediakan analitik penggunaan terperinci dan kontrol pengeluaran di berbagai penyedia model. Pendekatan terpusat ini menyederhanakan manajemen anggaran bagi organisasi yang menggunakan beberapa model AI dalam aplikasi mereka.

Hugging Face Hub untuk Penerapan Sumber Terbuka

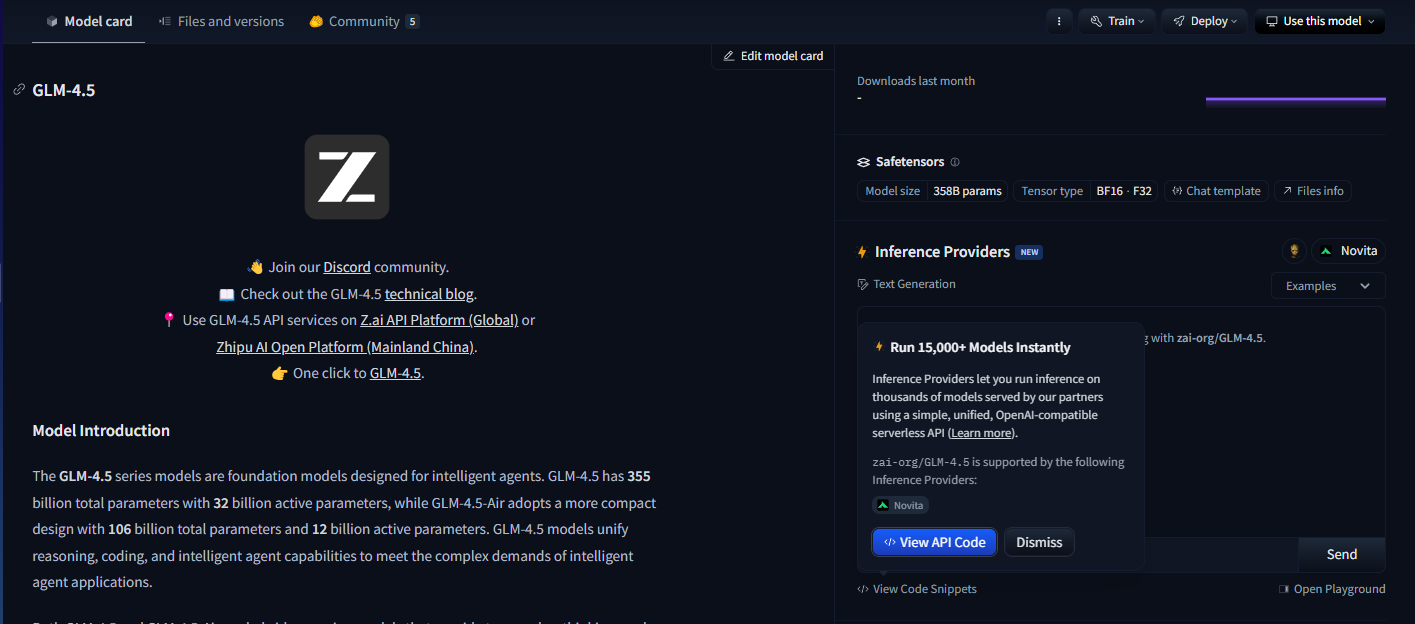

Hugging Face Hub menampung model GLM-4.5, menyediakan kartu model komprehensif, dokumentasi teknis, dan contoh penggunaan yang didorong oleh komunitas. Platform ini terbukti penting bagi pengembang yang lebih memilih pola penerapan sumber terbuka atau memerlukan kustomisasi model yang ekstensif.

Integrasi Hugging Face memungkinkan penerapan lokal menggunakan pustaka Transformers, memberikan organisasi kendali penuh atas hosting model dan privasi data. Pengembang dapat mengunduh bobot model secara langsung, mengimplementasikan pipeline inferensi khusus, dan mengoptimalkan konfigurasi penerapan untuk lingkungan perangkat keras tertentu.

Opsi Penerapan yang Dihosting Sendiri

Organisasi dengan persyaratan privasi data yang ketat atau kebutuhan infrastruktur khusus dapat menerapkan model GLM-4.5 menggunakan konfigurasi yang dihosting sendiri. Lisensi MIT memungkinkan penerapan tanpa batasan di seluruh lingkungan cloud pribadi, infrastruktur on-premise, atau arsitektur hibrida.

Penerapan yang dihosting sendiri memberikan kontrol maksimum atas perilaku model, konfigurasi keamanan, dan pola integrasi. Organisasi dapat mengimplementasikan sistem otentikasi khusus, infrastruktur pemantauan khusus, dan optimasi khusus domain tanpa ketergantungan eksternal.

Penerapan berbasis kontainer menggunakan Docker atau Kubernetes memungkinkan implementasi yang dihosting sendiri yang dapat diskalakan dan dapat beradaptasi dengan berbagai tuntutan beban kerja. Pola penerapan ini terbukti sangat berharga bagi organisasi dengan keahlian orkestrasi kontainer yang sudah ada.

Integrasi dengan Alur Kerja Pengembangan Menggunakan Apidog

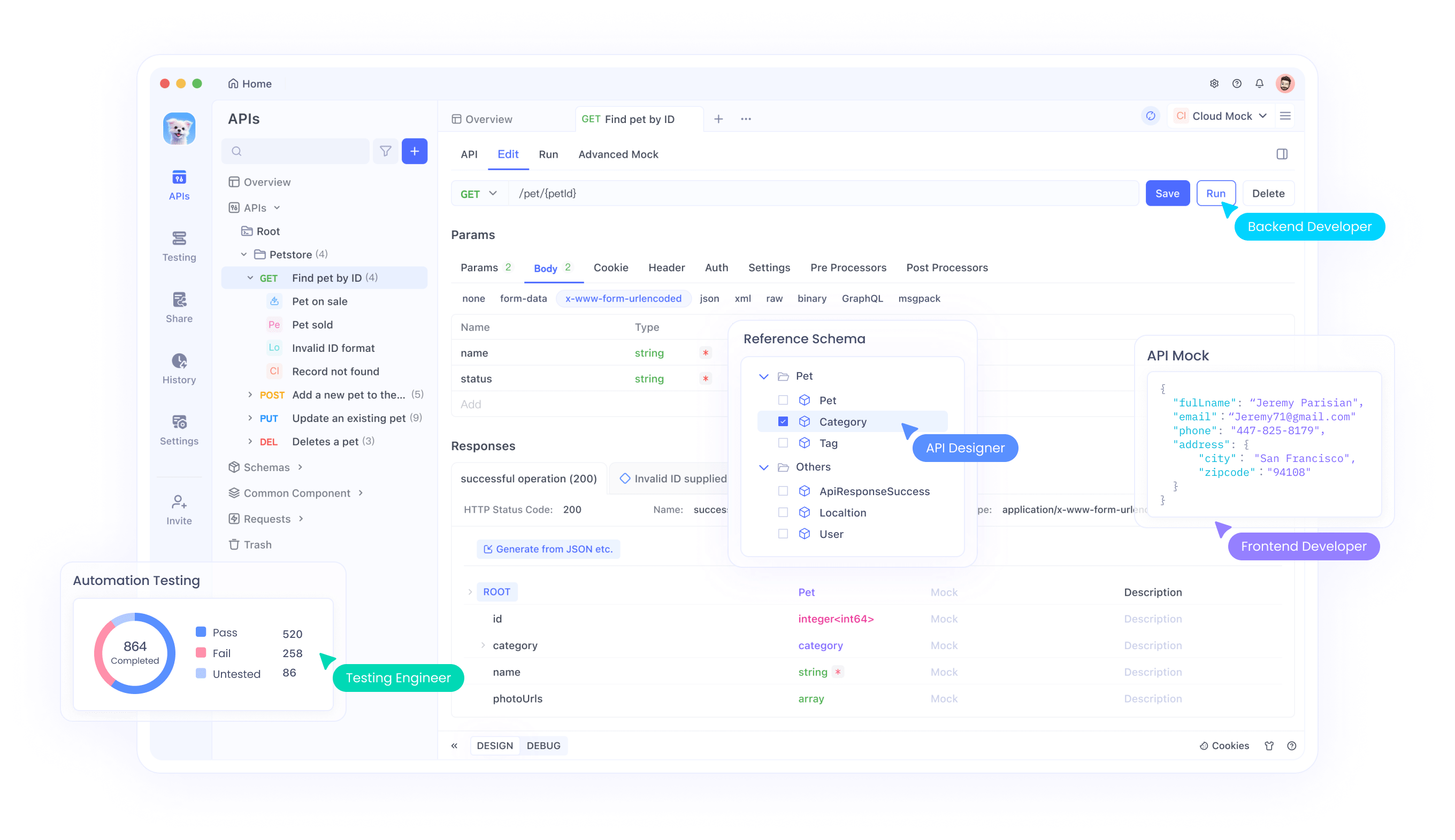

Pengembangan AI modern memerlukan perangkat canggih untuk mengelola integrasi model, pengujian, dan alur kerja penerapan secara efektif di berbagai metode akses ini. Apidog menyediakan kemampuan manajemen API komprehensif yang menyederhanakan integrasi GLM-4.5 terlepas dari pendekatan penerapan yang dipilih.

Saat mengimplementasikan model GLM-4.5 di berbagai platform—baik melalui OpenRouter, akses API langsung, penerapan Hugging Face, atau konfigurasi yang dihosting sendiri—pengembang harus memvalidasi kinerja di berbagai kasus penggunaan, menguji konfigurasi parameter yang berbeda, dan memastikan penanganan kesalahan yangandal. Kerangka pengujian API Apidog memungkinkan evaluasi sistematis respons model, karakteristik latensi, dan pola pemanfaatan sumber daya di semua metode penerapan ini.

Kemampuan pembuatan dokumentasi platform terbukti sangat berharga saat menerapkan GLM-4.5 melalui beberapa metode akses secara bersamaan. Pengembang dapat secara otomatis menghasilkan dokumentasi API komprehensif yang mencakup opsi konfigurasi model, skema input/output, dan contoh penggunaan khusus untuk kemampuan penalaran hibrida GLM-4.5 di seluruh OpenRouter, API langsung, dan penerapan yang dihosting sendiri.

Fitur kolaboratif dalam Apidog memfasilitasi berbagi pengetahuan di seluruh tim pengembangan yang bekerja dengan implementasi GLM-4.5. Anggota tim dapat berbagi konfigurasi pengujian, mendokumentasikan praktik terbaik, dan berkolaborasi pada pola integrasi yang memaksimalkan efektivitas model.

Kemampuan manajemen lingkungan memastikan penerapan GLM-4.5 yang konsisten di seluruh lingkungan pengembangan, staging, dan produksi, terlepas dari apakah tim menggunakan layanan terkelola OpenRouter, integrasi API langsung, atau implementasi yang dihosting sendiri. Pengembang dapat mempertahankan konfigurasi terpisah untuk lingkungan yang berbeda sambil memastikan pola penerapan yang dapat direproduksi.

Strategi Implementasi dan Praktik Terbaik

Penerapan model GLM-4.5 yang berhasil memerlukan pertimbangan cermat terhadap persyaratan infrastruktur, teknik optimasi kinerja, dan pola integrasi yang memaksimalkan efektivitas model. Organisasi harus mengevaluasi kasus penggunaan spesifik mereka terhadap kemampuan model untuk menentukan konfigurasi penerapan yang optimal.

Persyaratan perangkat keras sangat bervariasi antara GLM-4.5 dan GLM-4.5 Air, memungkinkan organisasi untuk memilih varian yang sesuai dengan kendala infrastruktur mereka. Tim dengan infrastruktur GPU yang kuat dapat memanfaatkan model GLM-4.5 penuh untuk kemampuan maksimum, sementara lingkungan dengan sumber daya terbatas mungkin menemukan GLM-4.5 Air memberikan kinerja yang memadai dengan biaya infrastruktur yang lebih rendah.

Penyetelan model (fine-tuning) merupakan pertimbangan kritis lainnya bagi organisasi dengan persyaratan khusus. Lisensi MIT memungkinkan kustomisasi model yang komprehensif, memungkinkan tim untuk mengadaptasi GLM-4.5 untuk domain-spesifik aplikasi. Namun, penyetelan memerlukan kurasi dataset yang cermat dan keahlian pelatihan untuk mencapai hasil yang optimal.

Konfigurasi mode hibrida memerlukan penyetelan parameter yang cermat untuk menyeimbangkan kecepatan respons dengan kualitas penalaran. Aplikasi dengan persyaratan latensi yang ketat mungkin lebih memilih default mode non-berpikir yang lebih agresif, sementara aplikasi yang memprioritaskan kualitas penalaran mungkin mendapat manfaat dari ambang batas mode berpikir yang lebih rendah.

Pola integrasi API harus memanfaatkan kemampuan pemanggilan fungsi asli GLM-4.5 untuk menciptakan alur kerja agen yang efisien. Daripada mengimplementasikan lapisan orkestrasi eksternal, pengembang dapat mengandalkan kemampuan penggunaan alat bawaan model untuk mengurangi kompleksitas sistem dan meningkatkan keandalan.

Pertimbangan Keamanan dan Manajemen Risiko

Menerapkan model sumber terbuka seperti GLM-4.5 memperkenalkan pertimbangan keamanan yang harus ditangani organisasi melalui strategi manajemen risiko yang komprehensif. Ketersediaan bobot model memungkinkan audit keamanan yang menyeluruh tetapi juga memerlukan penanganan yang cermat untuk mencegah akses tidak sah atau penyalahgunaan.

Keamanan inferensi model memerlukan perlindungan terhadap input yang merugikan yang dapat mengganggu perilaku model atau mengekstrak informasi sensitif dari data pelatihan. Organisasi harus mengimplementasikan validasi input, pemfilteran output, dan sistem deteksi anomali untuk mengidentifikasi interaksi yang berpotensi bermasalah.

Keamanan infrastruktur penerapan menjadi kritis saat menghosting GLM-4.5 model di lingkungan produksi. Praktik keamanan standar termasuk isolasi jaringan, kontrol akses, dan enkripsi berlaku untuk penerapan model AI sama seperti untuk aplikasi tradisional.

Pertimbangan privasi data memerlukan perhatian cermat terhadap aliran informasi antara aplikasi dan GLM-4.5 model. Organisasi harus memastikan bahwa input data sensitif menerima perlindungan yang sesuai dan bahwa output model tidak secara tidak sengaja mengekspos informasi rahasia.

Keamanan rantai pasokan meluas ke asal model dan verifikasi integritas. Organisasi harus memvalidasi checksum model, memverifikasi sumber unduhan, dan mengimplementasikan kontrol yang memastikan model yang diterapkan sesuai dengan konfigurasi yang dimaksudkan.

Sifat sumber terbuka GLM-4.5 memungkinkan audit keamanan komprehensif yang memberikan keuntungan dibandingkan model proprietary di mana properti keamanan tetap tidak transparan. Organisasi dapat menganalisis arsitektur model, karakteristik data pelatihan, dan potensi kerentanan melalui pemeriksaan langsung daripada mengandalkan pernyataan keamanan vendor.

Kesimpulan

GLM-4.5 dan GLM-4.5 Air mewakili kemajuan signifikan dalam kemampuan AI sumber terbuka, memberikan kinerja kompetitif sambil mempertahankan aksesibilitas dan fleksibilitas yang mendefinisikan proyek sumber terbuka yang sukses. Z.ai telah merilis model dasar generasi berikutnya GLM-4.5, mencapai kinerja SOTA dalam model sumber terbuka melalui inovasi arsitektur yang mengatasi tantangan penerapan dunia nyata.

Arsitektur penalaran hibrida menunjukkan bagaimana desain yang cermat dapat menghilangkan pertukaran tradisional antara kecepatan respons dan kualitas penalaran. Inovasi ini menyediakan template untuk pengembangan model di masa depan yang memprioritaskan utilitas praktis daripada kinerja tolok ukur murni.

Keuntungan efisiensi biaya membuat GLM-4.5 dapat diakses oleh organisasi yang sebelumnya menganggap kemampuan AI canggih sangat mahal. Kombinasi biaya inferensi yang berkurang dan lisensi yang permisif menciptakan peluang untuk penerapan AI di berbagai industri dan ukuran organisasi.