Rilis model AI canggih seperti Gemini 2.5 Pro milik Google menghasilkan kegembiraan yang signifikan di kalangan komunitas pengembang. Kemampuan penalaran yang ditingkatkan, kemampuan pengkodean, dan pemahaman multimodalnya menjanjikan untuk merevolusi cara kita membangun aplikasi. Namun, mengakses model terbaru sering kali disertai dengan pertanyaan tentang biaya dan ketersediaan. Banyak pengembang bertanya, "Bagaimana saya dapat menggunakan Gemini 2.5 Pro secara gratis?" Meskipun akses API yang langsung dan tidak terbatas biasanya melibatkan biaya, ada cara yang sah untuk berinteraksi dengan model yang kuat ini tanpa biaya, terutama melalui antarmuka webnya, dan bahkan secara programatik melalui proyek komunitas.

Cara Resmi Menggunakan Gemini 2.5 Pro Secara Gratis: Antarmuka Web

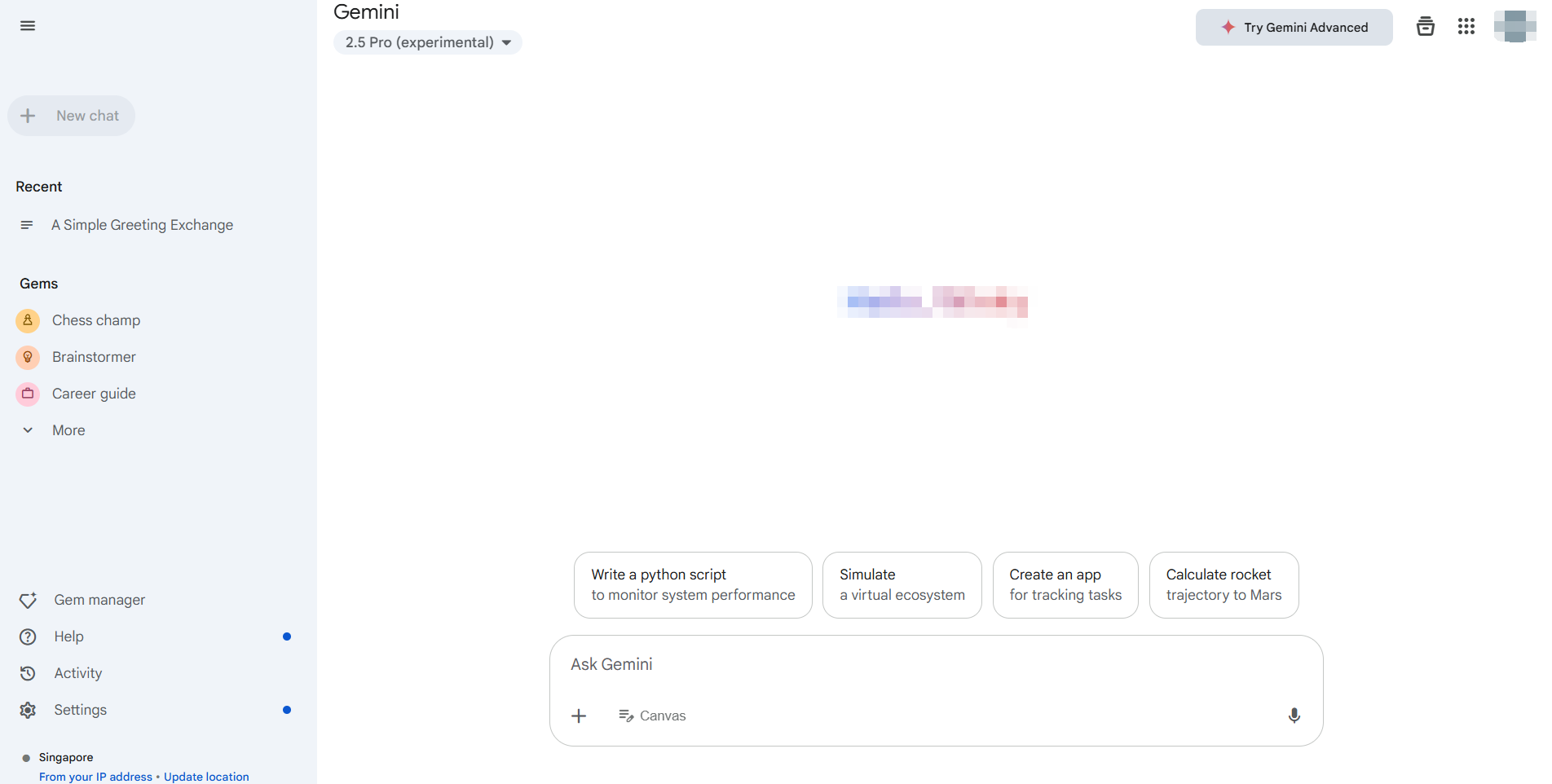

Cara yang paling sederhana dan didukung secara resmi untuk menggunakan Gemini 2.5 Pro tanpa biaya adalah melalui aplikasi web khususnya, biasanya dapat diakses di https://gemini.google.com/. Google memberikan akses ke model terbarunya, termasuk Gemini 2.5 Pro (ketersediaan mungkin bervariasi berdasarkan wilayah dan status akun), melalui antarmuka ini untuk pengguna umum.

Keuntungan Utama Antarmuka Web:

- Biaya Nol: Ini adalah tingkat gratis standar yang menawarkan interaksi langsung.

- Akses Fitur Lengkap: Anda biasanya dapat memanfaatkan kemampuan inti model, termasuk pembuatan teks, brainstorming, bantuan pengkodean, dan potensi pembuatan gambar (seperti dengan Imagen3, tergantung pada ketersediaan) dan interaksi dengan ekstensi Google Workspace (Gmail, Docs, Drive, dll.).

- Antarmuka yang Ramah Pengguna: Antarmuka web dirancang untuk kemudahan penggunaan, tidak memerlukan pengaturan selain masuk ke akun Google Anda.

Cara Menggunakannya:

- Navigasikan ke aplikasi web Gemini.

- Masuk dengan Akun Google Anda.

- Pastikan Gemini 2.5 Pro terpilih jika beberapa model tersedia (sering ditunjukkan di pengaturan atau dekat input prompt).

5. Mulai berinteraksi! Ketik prompt Anda, unggah file (jika didukung), dan jelajahi kemampuannya.

Bagi banyak pengguna dan pengembang yang perlu mengevaluasi Gemini 2.5 Pro, menguji prompt, atau melakukan tugas non-programatik, antarmuka web resmi adalah solusi ideal tanpa biaya. Ini memberikan akses langsung ke kekuatan model tanpa memerlukan kunci API atau berurusan dengan kuota penggunaan yang terkait dengan API berbayar. Metode ini dengan sempurna memenuhi kebutuhan untuk menggunakan Gemini 2.5 Pro secara gratis untuk eksplorasi dan interaksi manual.

Cara Menggunakan Gemini 2.5 Pro Secara Programatik Tanpa Biaya API Langsung

Sementara antarmuka web sangat baik untuk penggunaan manual, pengembang sering kali memerlukan akses programatik untuk integrasi, otomatisasi, atau pemrosesan batch. API Google Generative AI resmi untuk model seperti Gemini 2.5 Pro biasanya melibatkan biaya berdasarkan penggunaan token. Namun, komunitas pengembang sering kali menciptakan alat untuk menjembatani kesenjangan ini.

Salah satu alat tersebut, yang disorot dalam sumber daya komunitas seperti perpustakaan Gemini API Python, memungkinkan pengembang untuk berinteraksi dengan antarmuka web Gemini gratis secara programatik.

Pemberitahuan Penting: Penting untuk memahami bahwa ini BUKAN API Google Generative AI resmi. Perpustakaan ini bekerja dengan membalikkan rekayasa panggilan API pribadi aplikasi web dan menggunakan cookie browser untuk otentikasi.

- Tak Resmi: Tidak didukung atau disetujui oleh Google.

- Potensial Tidak Stabil: Bergantung pada elemen antarmuka web yang dapat berubah tanpa pemberitahuan, merusak perpustakaan.

- Pertimbangan Keamanan: Memerlukan ekstraksi cookie otentikasi dari browser Anda, yang membawa risiko keamanan yang melekat jika tidak ditangani dengan hati-hati.

- Syarat Layanan: Penggunaan mungkin melanggar syarat layanan Google untuk aplikasi web.

Meski dengan peringatan ini, perpustakaan semacam ini menawarkan cara bagi pengembang untuk bereksperimen dan menggunakan Gemini 2.5 Pro tanpa biaya di luar batasan tingkat gratis antarmuka web itu sendiri, tetapi dengan cara yang otomatis.

Panduan Langkah-demi-Langkah:

Prasyarat: Pastikan Anda telah menginstal Python 3.10+.

Instalasi: Instal perpustakaan menggunakan pip:

pip install -U gemini_webapi

# Opsional: Instal browser-cookie3 untuk mengambil cookie dengan lebih mudah

pip install -U browser-cookie3Otentikasi (Bagian yang Sulit):

- Masuk ke

gemini.google.comdi browser web Anda. - Buka Alat Pengembang (F12), pergi ke tab

Jaringan, dan muat ulang halaman. - Cari permintaan (permintaan apa pun biasanya berhasil).

- Di header permintaan (biasanya di bawah "Cookies"), temukan dan salin nilai untuk

__Secure-1PSIDdan__Secure-1PSIDTS. Perlakukan ini seperti kata sandi! - Alternatif: Jika

browser-cookie3diinstal, perpustakaan mungkin dapat mengimpor cookie secara otomatis jika Anda sudah masuk melalui browser yang didukung, menyederhanakan langkah ini tetapi tetap bergantung pada status browser lokal.

Inisialisasi & Penggunaan Dasar:

import asyncio

from gemini_webapi import GeminiClient

from gemini_webapi.constants import Model # Mengimpor konstanta Model

# --- Otentikasi ---

# Metode 1: Tempel cookie secara manual (tangani dengan aman!)

Secure_1PSID = "NILAI_COOKIE__SECURE_1PSID_ANDA"

Secure_1PSIDTS = "NILAI_COOKIE__SECURE_1PSIDTS_ANDA" # Mungkin opsional

async def run_gemini():

# Metode 2: Gunakan browser-cookie3 (jika diinstal dan sudah masuk)

# client = GeminiClient(proxy=None) # Mencoba impor cookie otomatis

# Inisialisasi dengan cookie manual

client = GeminiClient(Secure_1PSID, Secure_1PSIDTS, proxy=None)

await client.init(timeout=30) # Inisialisasi koneksi

# --- Pilih Model dan Buat Konten ---

prompt = "Jelaskan perbedaan antara API REST dan GraphQL."

# Gunakan pengenal model Gemini 2.5 Pro

print(f"Mengirim prompt ke Gemini 2.5 Pro...")

response = await client.generate_content(prompt, model=Model.G_2_5_PRO) # Gunakan model tertentu

print("\nRespon:")

print(response.text)

# Tutup sesi klien (penting untuk manajemen sumber daya)

await client.close()

if __name__ == "__main__":

asyncio.run(run_gemini())Periksa lebih banyak detail integrasi di sini.

Jelajahi Lebih Lanjut: Perpustakaan seperti ini sering mendukung fitur yang tersedia di UI web, seperti obrolan multi-putaran (client.start_chat()), unggahan file, permintaan pembuatan gambar, dan menggunakan ekstensi (@Gmail, @Youtube), mencerminkan kemampuan aplikasi web secara programatik.

Ingat, pendekatan ini mengotomatiskan interaksi dengan tingkat web gratis, bukan API berbayar. Ini memungkinkan eksperimen programatik dengan Gemini 2.5 Pro tanpa biaya API langsung tetapi disertai dengan peringatan tentang keandalan dan keamanan yang signifikan.

Tantangan Debugging dengan LLMs

Apakah Anda berinteraksi dengan Gemini 2.5 Pro melalui web, API resmi, atau perpustakaan tidak resmi, memahami dan mendebug respons sangat penting, terutama ketika berhadapan dengan keluaran yang kompleks atau streaming. Banyak LLM, terutama dalam bentuk API, menggunakan Server-Sent Events (SSE) untuk mengalirkan respons token demi token atau potongan demi potongan. Ini memberikan nuansa waktu nyata tetapi bisa sulit untuk didebug menggunakan klien HTTP standar.

Alat pengujian API tradisional mungkin hanya menampilkan data SSE mentah: potongan, membuatnya sulit untuk menyusun pesan lengkap atau memahami alur informasi, terutama "proses pemikiran" model jika diberikan. Di sinilah alat khusus menjadi sangat berharga.

Memperkenalkan Apidog: Platform pengembangan API yang komprehensif dan serba bisa, dirancang untuk menangani seluruh siklus hidup API – mulai dari desain dan dokumentasi hingga debugging, pengujian otomatis, dan mocking. Meskipun kuat di seluruh bidang, Apidog sangat unggul dalam menangani protokol API modern, menjadikannya alat pengujian API yang luar biasa untuk pengembang yang bekerja dengan LLMs. Fitur debugging SSEnya dirancang khusus untuk mengatasi tantangan respons streaming.

Kuasi Respon LLM Waktu Nyata

Bekerja dengan LLM seperti Gemini 2.5 Pro sering melibatkan Server-Sent Events (SSE) untuk streaming hasil. Teknologi ini memungkinkan model AI untuk mendorong data ke klien Anda secara waktu nyata, menunjukkan teks yang dihasilkan atau bahkan langkah-langkah penalaran saat terjadi. Meskipun sangat baik untuk pengalaman pengguna, mendebug aliran SSE mentah dengan alat dasar bisa menjadi mimpi buruk dengan pesan yang terfragmentasi.

Apidog, sebagai alat pengujian API terkemuka, mengubah debugging SSE dari tugas yang membosankan menjadi proses yang jelas. Inilah cara Apidog membantu Anda mengendalikan aliran LLM:

- Deteksi SSE Otomatis: Ketika Anda mengirim permintaan ke endpoint LLM menggunakan Apidog, jika header respons

Content-Typeadalahtext/event-stream, Apidog secara otomatis mengenalinya sebagai aliran SSE. - Tampilan Garis Waktu Waktu Nyata: Alih-alih hanya membuang baris

data:mentah, Apidog menyajikan pesan yang masuk secara kronologis dalam tampilan "Garis Waktu" khusus. Ini memungkinkan Anda melihat alur informasi persis seperti yang dikirim server. - Penggabungan Cerdas Otomatis: Ini adalah perubahan besar untuk debugging SSE LLM. Apidog memiliki kecerdasan bawaan untuk mengenali format streaming umum yang digunakan oleh penyedia AI utama, termasuk:

- Format Kompatibel API OpenAI (digunakan oleh banyak orang)

- Format Kompatibel API Gemini

- Format Kompatibel API Claude

- Format Kompatibel API Ollama (untuk model yang dijalankan secara lokal, sering JSON Streaming/NDJSON)

Jika aliran cocok dengan format-format ini, Apidog secara otomatis menggabungkan fragmen pesan individu (data: potongan) menjadi respons akhir yang lengkap dan koheren atau langkah-langkah menengah. Tidak perlu lagi menyalin dan menempel potongan secara manual! Anda melihat gambaran utuh seperti yang dimaksudkan AI.

4. Memvisualisasikan Proses Pemikiran: Untuk model yang mengalirkan penalaran atau "pikiran" mereka bersamaan dengan konten utama (seperti konfigurasi tertentu dari DeepSeek), Apidog sering kali dapat menampilkan informasi meta ini dengan jelas dalam garis waktu, memberikan wawasan yang sangat berharga tentang proses model.

Menggunakan Apidog untuk debugging SSE berarti Anda mendapatkan tampilan yang jelas, waktu nyata, dan sering kali terstruktur secara otomatis tentang bagaimana endpoint LLM Anda merespons. Ini membuat identifikasi masalah, memahami proses pembuatan, dan memastikan keluaran akhir benar jauh lebih mudah dibandingkan dengan klien HTTP umum atau alat pengujian API tradisional yang kurang menangani SSE secara khusus.

Kesimpulan: Mengakses Gemini 2.5 Pro Secara Gratis

Anda dapat menjelajahi Gemini 2.5 Pro secara gratis melalui antarmuka web resminya. Pengembang yang mencari akses seperti API tanpa biaya dapat mencoba alat yang dibangun oleh komunitas, meskipun ini disertai dengan risiko seperti ketidakstabilan dan potensi masalah syarat layanan.

Untuk bekerja dengan LLM seperti Gemini—terutama ketika berurusan dengan respons streaming—alat tradisional sering kali tidak memadai. Di sinilah Apidog bersinar. Dengan fitur seperti deteksi SSE otomatis, tampilan garis waktu, dan penggabungan cerdas data yang terfragmentasi, Apidog membuat debugging respons waktu nyata jauh lebih mudah. Dukungan parsing kustomnya lebih lanjut menyederhanakan alur kerja yang kompleks, menjadikannya alat yang harus dimiliki untuk pengembangan API dan LLM modern.