Mari kita hadapi: Asisten pengkodean AI seperti GitHub Copilot memang fantastis, tetapi biaya berlangganannya dapat membuat dompet Anda bolong. Perkenalkan DeepSeek R1—model bahasa sumber terbuka gratis yang menyaingi GPT-4 dan Claude 3.5 dalam tugas penalaran dan pengkodean . Pasangkan dengan Cline, plugin VS Code yang mengubah AI ini menjadi agen pengkodean penuh, dan Anda mendapatkan pengaturan yang sangat kuat yang menulis, men-debug, dan bahkan mengeksekusi kode secara mandiri—semuanya tanpa mengeluarkan uang sepeser pun.

Dalam panduan ini, saya akan memandu Anda melalui semua yang perlu Anda ketahui, mulai dari menginstal Cline hingga mengoptimalkan DeepSeek R1 untuk proyek Anda. Mari kita mulai!

Apa yang Membuat DeepSeek R1 Istimewa?

1. Gratis (Ya, Sungguh!)

Tidak seperti model berpemilik, DeepSeek R1 sepenuhnya sumber terbuka dan dapat digunakan secara komersial. Tidak ada batasan token, tidak ada biaya tersembunyi—hanya kekuatan AI mentah .

2. Kinerja yang Menyaingi Model Berbayar

DeepSeek R1 unggul dalam pengkodean, matematika, dan penalaran logis. Misalnya, varian parameter 32B-nya mengungguli o1-mini OpenAI dalam tolok ukur pembuatan kode, dan model 70B-nya cocok dengan Claude 3.5 Sonnet dalam tugas-tugas kompleks .

3. Opsi Penerapan yang Fleksibel

Jalankan secara lokal untuk privasi dan kecepatan, atau gunakan API DeepSeek yang terjangkau (serendah $0,01 per juta token) untuk akses berbasis cloud .

Menyiapkan DeepSeek R1 di VS Code dengan Cline

Langkah 1: Instal Plugin Cline

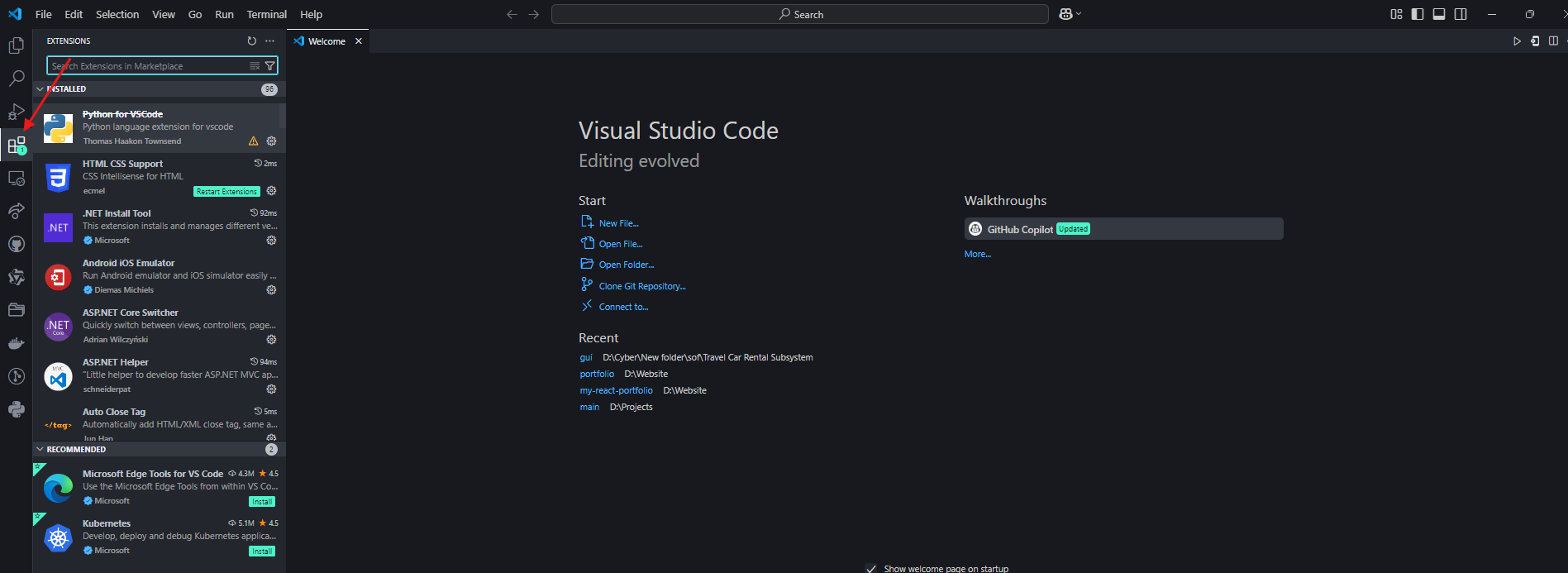

- Buka VS Code dan navigasikan ke tab Ekstensi.

2. Cari “Cline” dan instal.

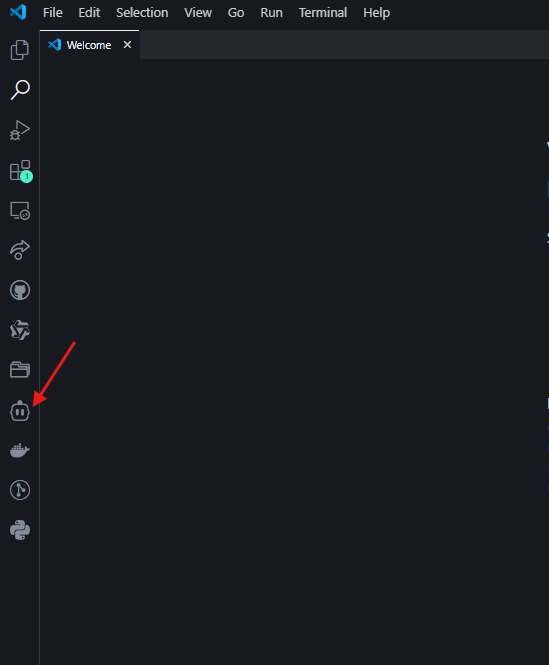

3. Klik ikon robot di bilah sisi kiri untuk mengaktifkan Cline .

Langkah 2: Pilih Alur Kerja DeepSeek R1 Anda

Opsi A: Pengaturan Lokal (Gratis, Mengutamakan Privasi)

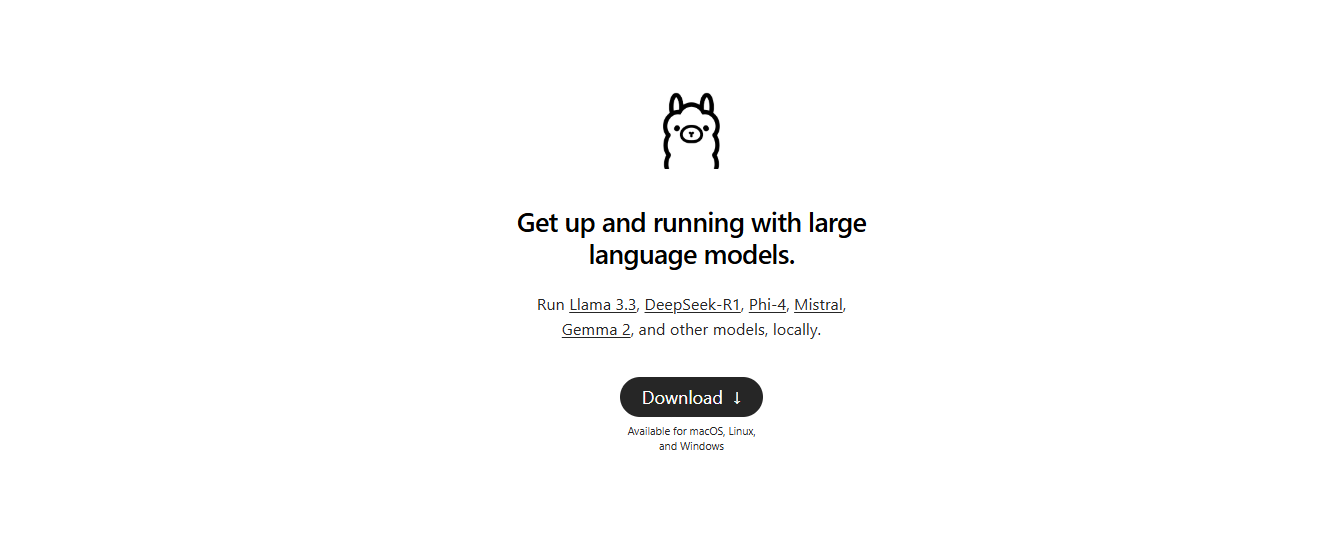

- Instal Ollama: Unduh dari ollama.com untuk mengelola model AI lokal .

2. Tarik Model: Di terminal Anda, jalankan:

ollama pull deepseek-r1:14b # Untuk perangkat keras tingkat menengah (mis., RTX 3060)

Model yang lebih kecil seperti 1.5b berfungsi untuk tugas-tugas dasar, tetapi 14B+ direkomendasikan untuk pengkodean .

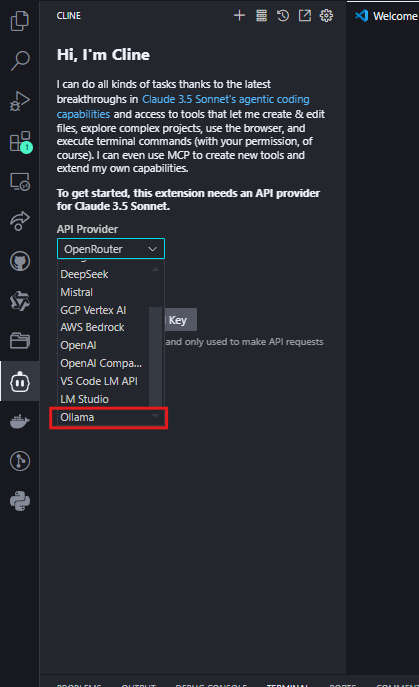

- Konfigurasikan Cline:

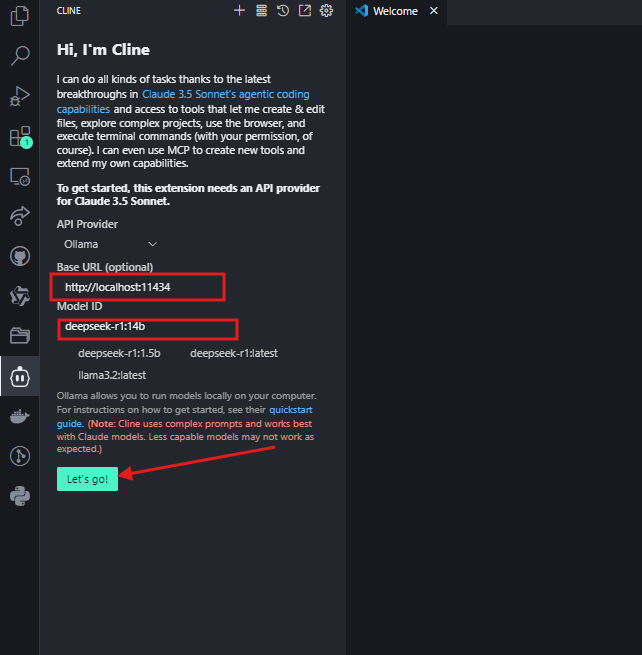

- Atur Penyedia API ke “Ollama”.

- Masukkan

http://localhost:11434sebagai URL Dasar dan pilih model Anda (mis.,deepseek-r1:14b) .

Klik "Ayo" dan Anda sekarang dapat menggunakannya.

Opsi B: Integrasi OpenRouter (Pengalihan Model yang Fleksibel)

Untuk pengembang yang menginginkan akses ke beberapa model AI (termasuk DeepSeek R1) melalui satu kunci API, OpenRouter menawarkan solusi yang efisien. Ini ideal jika Anda sesekali perlu membandingkan output dengan model seperti GPT-4 atau Claude tetapi menginginkan DeepSeek R1 sebagai default Anda.

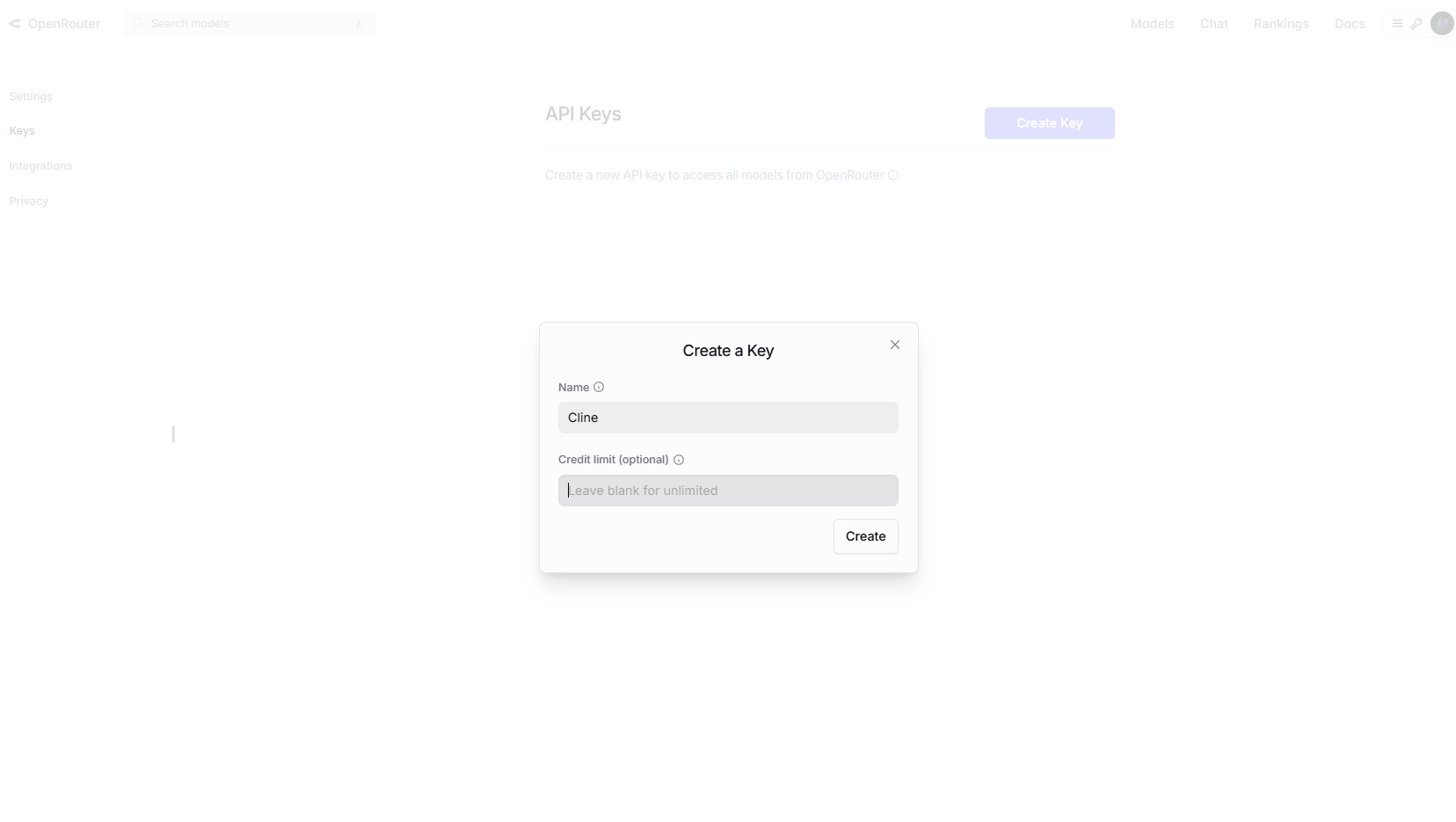

Langkah 1: Dapatkan Kunci API OpenRouter Anda

- Kunjungi OpenRouter.ai dan daftar.

- Navigasikan ke Kunci API dan buat kunci baru.

Opsional: Aktifkan batasan pengeluaran di pengaturan akun untuk pengendalian biaya.

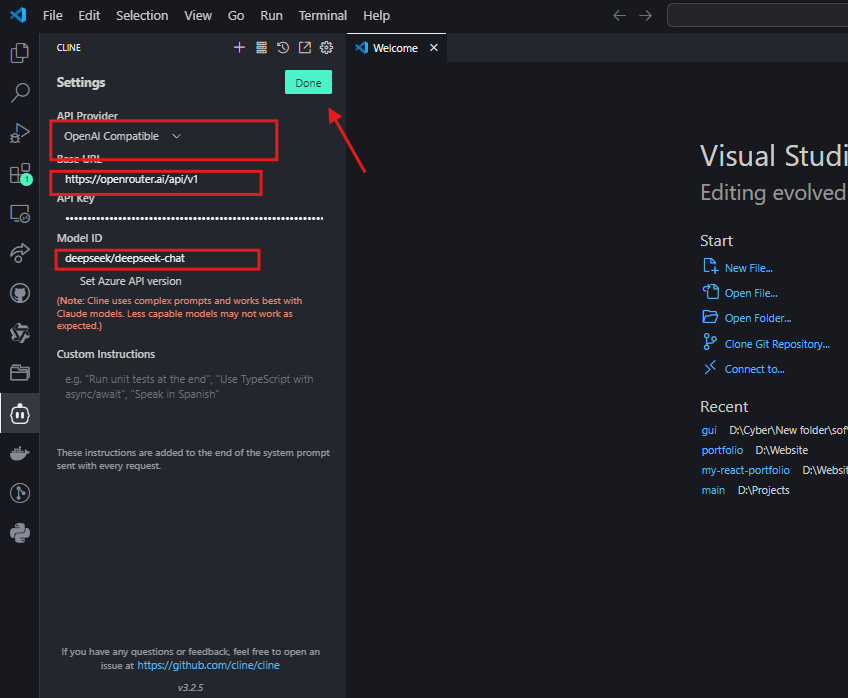

Langkah 2: Konfigurasikan Cline untuk OpenRouter

- Di VS Code, buka pengaturan Cline.

- Pilih “Kompatibel dengan OpenAI” sebagai penyedia API.

- Atur URL Dasar ke

https://openrouter.ai/api/v1. - Tempelkan kunci API OpenRouter Anda.

- Di bidang ID Model, masukkan

deepseek/deepseek-chat

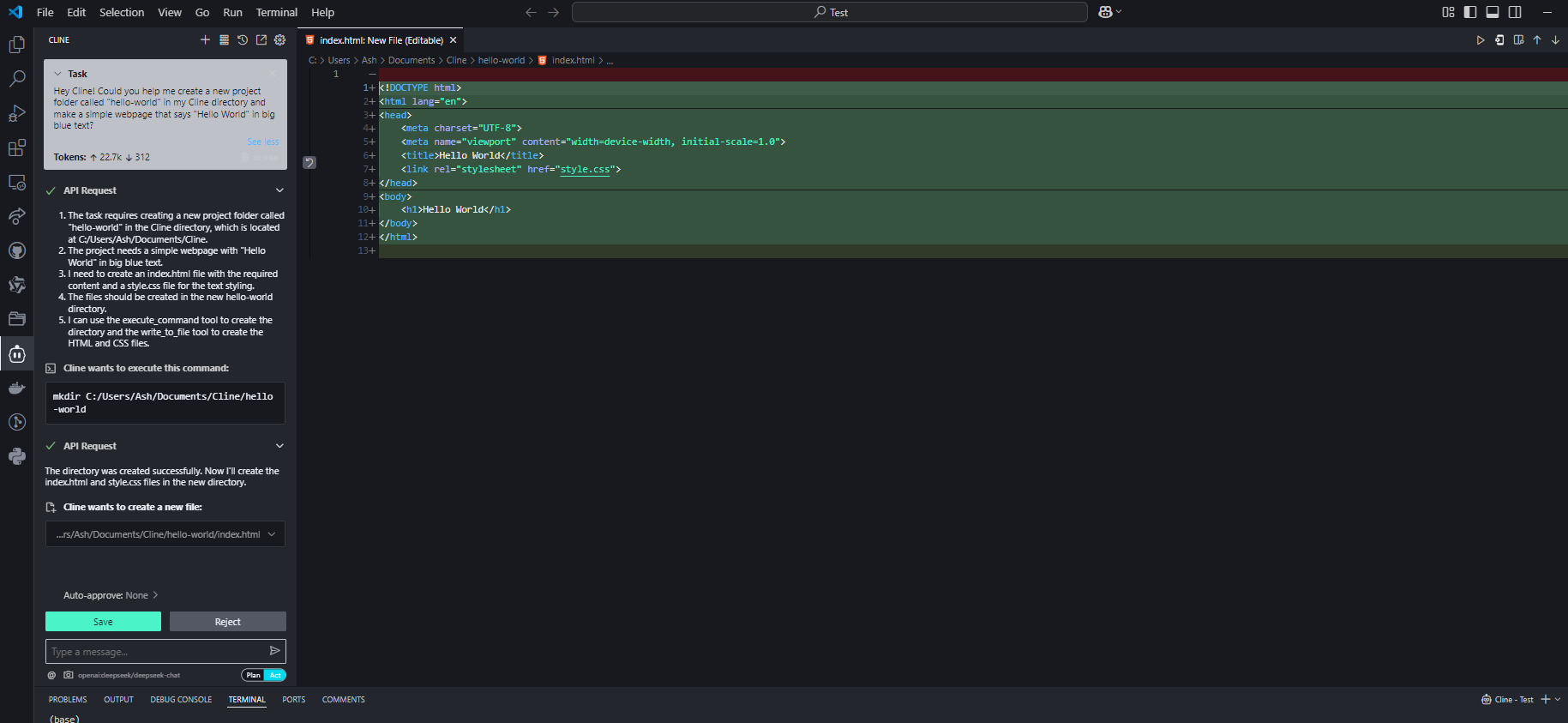

Langkah 3: Uji Integrasi

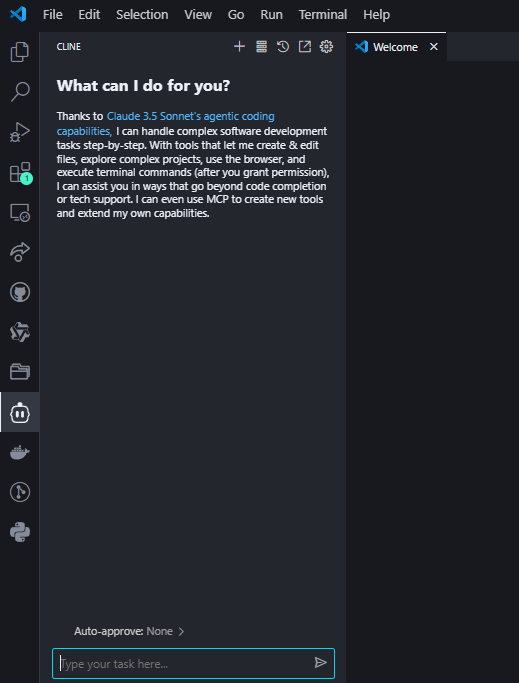

Ajukan pertanyaan pengkodean kepada Cline untuk mengonfirmasi pengaturan:

Jika dikonfigurasi dengan benar, DeepSeek R1 akan menghasilkan kode dengan penjelasan di antarmuka Cline.

Mengapa Memilih OpenRouter?

- Akses Multi-Model: Beralih dengan mudah antara DeepSeek R1 dan 50+ model lainnya (mis., GPT-4, Claude) tanpa mengonfigurasi ulang API4.

- Transparansi Biaya: Lacak penggunaan token di semua model dalam satu dasbor4.

- Dukungan Cadangan: Secara otomatis mengarahkan permintaan ke model cadangan jika API DeepSeek R1 kelebihan beban4.

Pertimbangan Biaya

Meskipun harga OpenRouter untuk DeepSeek R1 sangat mirip dengan biaya API langsung (~$0,01 per juta token input), selalu periksa halaman harga mereka untuk tarif waktu nyata. Untuk pengguna berat, penagihan terpadu OpenRouter dapat menyederhanakan pengelolaan pengeluaran25.

Tips Pro untuk Mengoptimalkan Kinerja

1. Ukuran Model vs. Perangkat Keras

| Model | RAM yang Dibutuhkan | GPU yang Direkomendasikan |

|---|---|---|

| 1.5B | 4GB | Terintegrasi |

| 7B | 8–10GB | NVIDIA GTX 1660 |

| 14B | 16GB+ | RTX 3060/3080 |

| 70B | 40GB+ | RTX 4090/A100 |

Tip: Model terkuantisasi (mis., Q4_K_M.gguf) mengurangi penggunaan VRAM sebesar 30% tanpa kehilangan kualitas yang signifikan .

2. Rekayasa Prompt

- Untuk Kode: Sertakan instruksi eksplisit seperti “Gunakan Python 3.11 dan petunjuk tipe” .

- Untuk Debugging: Tempelkan log kesalahan dan tanyakan “Jelaskan kesalahan ini dan perbaiki” .

Memecahkan Masalah Umum

1. Respons Lambat

- Perbaikan: Beralih ke model yang lebih kecil atau aktifkan akselerasi GPU di Ollama dengan

OLLAMA_GPU_LAYERS=12.

2. Halusinasi atau Jawaban di Luar Jalur

- Perbaikan: Gunakan prompt yang lebih ketat (mis., “Jawab hanya menggunakan konteks yang diberikan”) atau tingkatkan ke model yang lebih besar seperti 32B .

3. Cline Mengabaikan Konteks File

- Perbaikan: Selalu berikan jalur file lengkap (mis.,

/src/components/Login.jsx) alih-alih referensi yang tidak jelas .

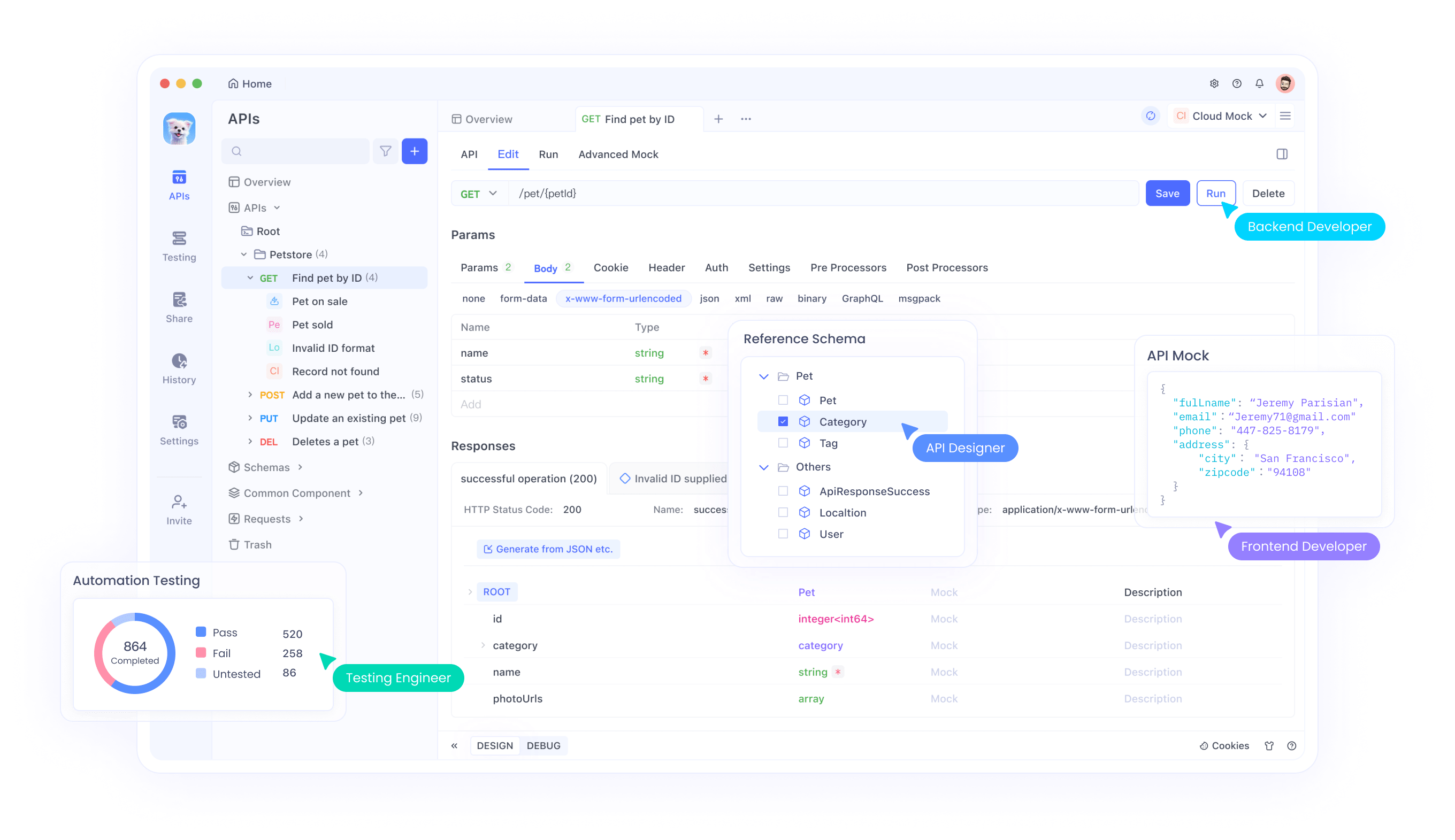

Kasus Penggunaan Tingkat Lanjut dengan Integrasi Apidog

Setelah pengaturan DeepSeek R1 + Cline Anda berjalan, gunakan Apidog untuk:

- Uji Titik Akhir API: Validasi respons DeepSeek secara terprogram.

- Otomatiskan Alur Kerja: Rantai pembuatan kode Cline dengan panggilan API (mis., sebarkan skrip yang dihasilkan ke AWS).

- Pantau Kinerja: Lacak latensi dan akurasi dari waktu ke waktu .

Kesimpulan: Mengapa Kombinasi Ini Menang

DeepSeek R1 dan Cline bukan hanya alat—mereka adalah perubahan paradigma. Anda mendapatkan kecerdasan tingkat GPT-4 tanpa biaya, kendali penuh atas privasi, dan alur kerja yang terasa seperti berpasangan dengan pengembang senior.

Siap untuk meningkatkan pengkodean Anda?

- Instal Cline dan Ollama.

- Pilih model DeepSeek R1 Anda.

- Bangun sesuatu yang luar biasa—dan beri tahu saya bagaimana hasilnya!

Jangan lupa untuk mengunduh Apidog untuk menyederhanakan pengujian dan otomatisasi API. Ini adalah pendamping yang sempurna untuk perjalanan pengkodean bertenaga AI Anda!