Bayangkan memiliki kemampuan untuk mengekstrak data dari situs web mana pun dan mengumpulkan wawasan dalam skala besar—semuanya hanya dengan beberapa baris kode. Terdengar seperti sihir, bukan? Nah, Firecrawl memungkinkan hal ini.

Dalam panduan pemula ini, saya akan memandu Anda melalui semua yang perlu Anda ketahui tentang Firecrawl, mulai dari instalasi hingga teknik ekstraksi data tingkat lanjut. Baik Anda seorang pengembang, analis data, atau hanya ingin tahu tentang web scraping, tutorial ini akan membantu Anda memulai dengan Firecrawl dan mengintegrasikannya ke dalam alur kerja Anda.

Apa itu Firecrawl?

Firecrawl adalah mesin web scraping dan crawling inovatif yang mengubah konten situs web menjadi format seperti markdown, HTML, dan data terstruktur. Hal ini membuatnya ideal untuk Large Language Models (LLM) dan aplikasi AI. Dengan Firecrawl, Anda dapat secara efisien mengumpulkan data terstruktur dan tidak terstruktur dari situs web, menyederhanakan alur kerja analisis data Anda.

Fitur Utama Firecrawl

Crawl: Web Crawling Komprehensif

Endpoint /crawl Firecrawl memungkinkan Anda untuk secara rekursif menjelajahi situs web, mengekstrak konten dari semua sub-halaman. Fitur ini sangat cocok untuk menemukan dan mengatur sejumlah besar data web, mengubahnya menjadi format yang siap untuk LLM.

Scrape: Ekstraksi Data Tertarget

Gunakan fitur Scrape untuk mengekstrak data spesifik dari satu URL. Firecrawl dapat mengirimkan konten dalam berbagai format, termasuk markdown, data terstruktur, tangkapan layar, dan HTML. Ini sangat berguna untuk mengekstrak informasi spesifik dari URL yang diketahui.

Map: Pemetaan Situs Cepat

Fitur Map dengan cepat mengambil semua URL yang terkait dengan situs web tertentu, memberikan gambaran komprehensif tentang strukturnya. Ini sangat berharga untuk penemuan dan organisasi konten.

Extract: Mengubah Data Tidak Terstruktur menjadi Format Terstruktur

Endpoint /extract adalah fitur bertenaga AI Firecrawl yang menyederhanakan proses pengumpulan data terstruktur dari situs web. Ini menangani pekerjaan berat crawling, parsing, dan mengatur data ke dalam format terstruktur.

Memulai dengan Firecrawl

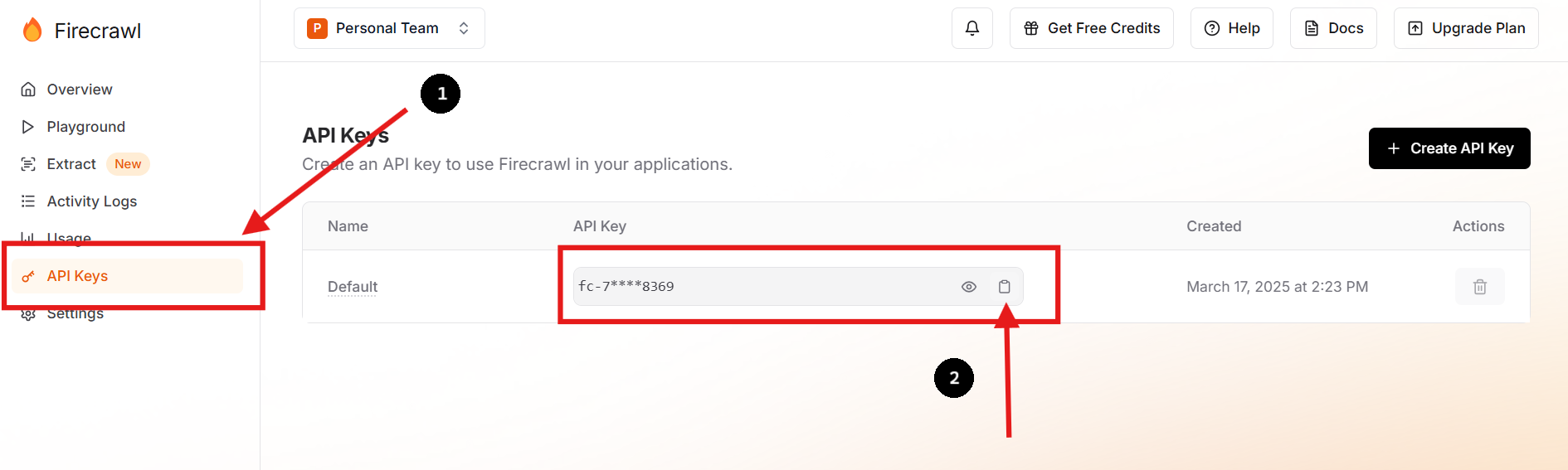

Langkah 1: Daftar dan Dapatkan Kunci API Anda

Kunjungi situs web resmi Firecrawl dan daftar untuk sebuah akun. Setelah masuk, navigasikan ke dasbor Anda untuk menemukan kunci API Anda.

Anda juga dapat membuat kunci API baru dan menghapus kunci sebelumnya jika Anda lebih suka atau perlu melakukannya.

Langkah 2: Siapkan Lingkungan Anda

Di direktori proyek Anda, buat file .env untuk menyimpan kunci API Anda dengan aman sebagai variabel lingkungan. Anda dapat melakukan ini dengan menjalankan perintah berikut di terminal Anda:

touch .env

echo "FIRECRAWL_API_KEY='fc-KUNCI-ANDA-DI-SINI'" >> .envPendekatan ini menjaga informasi sensitif keluar dari basis kode utama Anda, meningkatkan keamanan dan menyederhanakan manajemen konfigurasi.

Langkah 3: Instal Firecrawl SDK

Untuk pengguna Python, instal Firecrawl SDK menggunakan pip:

pip install firecrawl Langkah 4: Gunakan Fungsi "Scrape" Firecrawl

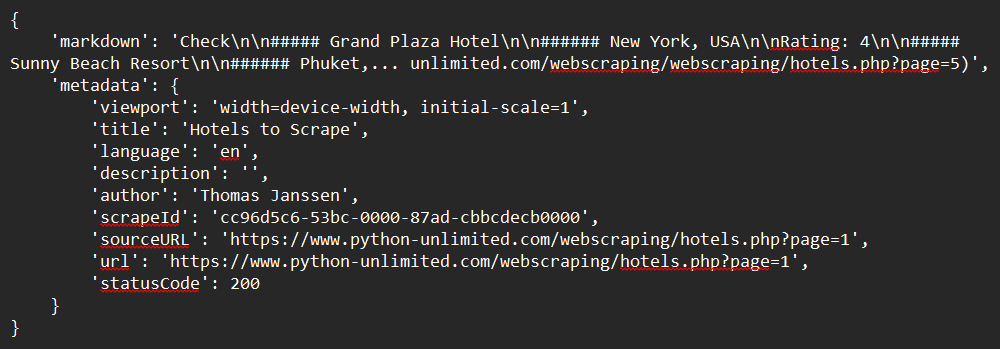

Berikut adalah contoh sederhana tentang cara melakukan scrape situs web menggunakan Python SDK:

from firecrawl import FirecrawlApp

from dotenv import load_dotenv

import os

# Load environment variables from .env file

load_dotenv()

# Initialize FirecrawlApp with the API key from .env

app = FirecrawlApp(api_key=os.getenv("FIRECRAWL_API_KEY"))

# Define the URL to scrape

url = "https://www.python-unlimited.com/webscraping/hotels.php?page=1"

# Scrape the website

response = app.scrape_url(url)

# Print the response

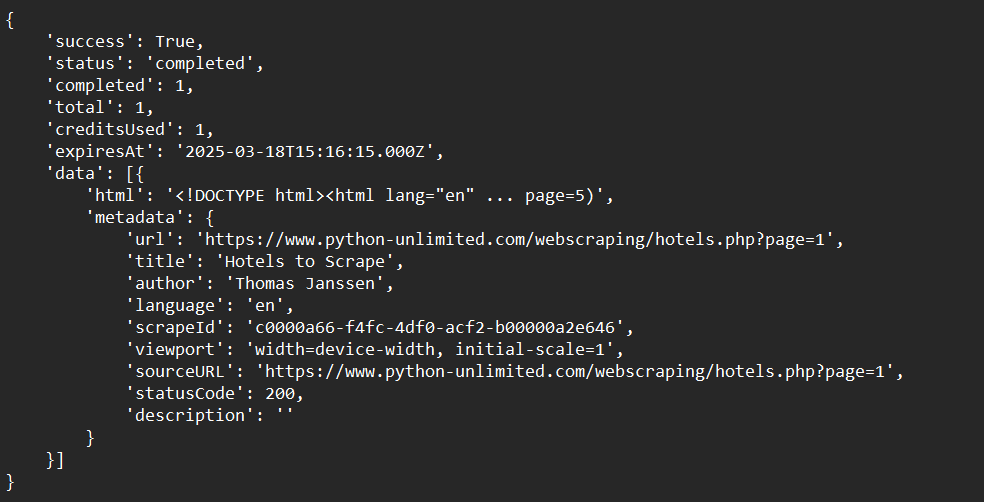

print(response)Contoh Keluaran:

Langkah 5: Gunakan Fungsi "Crawl" Firecrawl

Di sini kita akan melihat contoh sederhana tentang cara melakukan crawl situs web menggunakan Python SDK:

from firecrawl import FirecrawlApp

from dotenv import load_dotenv

import os

# Load environment variables from .env file

load_dotenv()

# Initialize FirecrawlApp with the API key from .env

app = FirecrawlApp(api_key=os.getenv("FIRECRAWL_API_KEY"))

# Crawl a website and capture the response:

crawl_status = app.crawl_url(

'https://www.python-unlimited.com/webscraping/hotels.php?page=1',

params={

'limit': 100,

'scrapeOptions': {'formats': ['markdown', 'html']}

},

poll_interval=30

)

print(crawl_status)Contoh Keluaran:

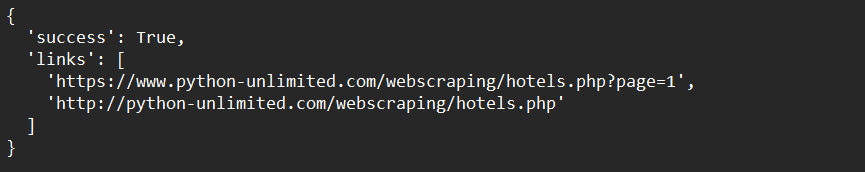

Langkah 6: Gunakan Fungsi "Map" Firecrawl

Berikut adalah contoh sederhana tentang cara memetakan data situs web menggunakan Python SDK:

from firecrawl import FirecrawlApp

from dotenv import load_dotenv

import os

# Load environment variables from .env file

load_dotenv()

# Initialize FirecrawlApp with the API key from .env

app = FirecrawlApp(api_key=os.getenv("FIRECRAWL_API_KEY"))

# Map a website:

map_result = app.map_url('https://www.python-unlimited.com/webscraping/hotels.php?page=1')

print(map_result)Contoh Keluaran:

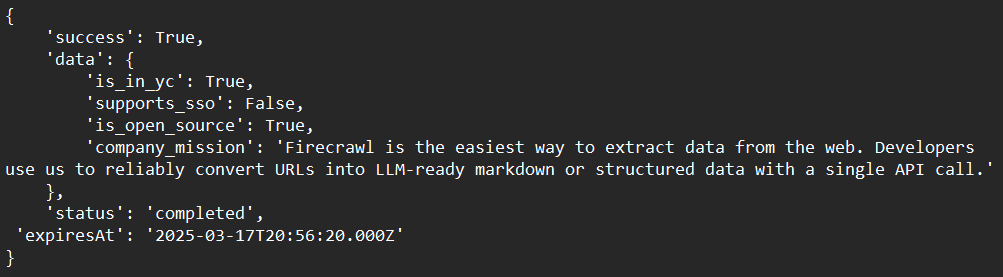

Langkah 7: Gunakan Fungsi "Extract" Firecrawl (Beta Terbuka)

Di bawah ini adalah contoh sederhana tentang cara mengekstrak data situs web menggunakan Python SDK:

from firecrawl import FirecrawlApp

from pydantic import BaseModel, Field

from dotenv import load_dotenv

import os

# Load environment variables from .env file

load_dotenv()

# Initialize FirecrawlApp with the API key from .env

app = FirecrawlApp(api_key=os.getenv("FIRECRAWL_API_KEY"))

# Define schema to extract contents into

class ExtractSchema(BaseModel):

company_mission: str

supports_sso: bool

is_open_source: bool

is_in_yc: bool

# Call the extract function and capture the response

response = app.extract([

'https://docs.firecrawl.dev/*',

'https://firecrawl.dev/',

'https://www.ycombinator.com/companies/'

], {

'prompt': "Extract the data provided in the schema.",

'schema': ExtractSchema.model_json_schema()

})

# Print the response

print(response)Contoh Keluaran:

Teknik Tingkat Lanjut dengan Firecrawl

Menangani Konten Dinamis

Firecrawl dapat menangani konten dinamis berbasis JavaScript dengan menggunakan browser tanpa kepala untuk merender halaman sebelum melakukan scraping. Ini memastikan Anda menangkap semua konten, bahkan jika dimuat secara dinamis.

Melewati Pemblokir Web Scraping

Gunakan fitur bawaan Firecrawl untuk melewati pemblokir web scraping umum, seperti CAPTCHA atau batas laju. Ini melibatkan rotasi agen pengguna dan alamat IP untuk meniru lalu lintas alami.

Berintegrasi dengan LLM

Kombinasikan Firecrawl dengan LLM seperti LangChain untuk membangun alur kerja AI yang kuat. Misalnya, Anda dapat menggunakan Firecrawl untuk mengumpulkan data dan kemudian memasukkannya ke dalam LLM untuk tugas analisis atau pembuatan.

Memecahkan Masalah Umum

Masalah: "Kunci API Tidak Dikenali"

Solusi: Pastikan kunci API Anda disimpan dengan benar sebagai variabel lingkungan atau dalam file .env.

Masalah: "Crawling Terlalu Lambat"

Solusi: Gunakan crawling asinkron untuk mempercepat proses. Firecrawl mendukung permintaan bersamaan untuk meningkatkan efisiensi.

Masalah: "Konten Tidak Diekstraksi dengan Benar"

Solusi: Periksa apakah situs web menggunakan konten dinamis. Jika ya, pastikan Firecrawl dikonfigurasi untuk menangani rendering JavaScript.

Kesimpulan

Selamat telah menyelesaikan panduan pemula komprehensif tentang Firecrawl! Kami telah membahas semua yang Anda butuhkan untuk memulai—mulai dari apa itu Firecrawl, hingga instruksi instalasi terperinci, contoh penggunaan, dan opsi penyesuaian tingkat lanjut. Sekarang, Anda seharusnya memiliki pemahaman yang jelas tentang cara:

- Menyiapkan dan menginstal Firecrawl di lingkungan pengembangan Anda.

- Mengonfigurasi dan menjalankan Firecrawl untuk melakukan scrape, crawl, memetakan, dan mengekstrak data secara efisien.

- Memecahkan masalah proses crawling Anda untuk memenuhi kebutuhan spesifik Anda.

Firecrawl adalah alat yang sangat kuat yang dapat secara signifikan menyederhanakan alur kerja ekstraksi data Anda. fleksibilitas, efisiensi, dan kemudahan integrasinya menjadikannya pilihan ideal untuk tantangan web crawling modern.

Sekarang saatnya untuk mempraktikkan keterampilan baru Anda. Mulailah bereksperimen dengan situs web yang berbeda, sesuaikan parser Anda, dan berintegrasi dengan alat tambahan untuk membuat solusi yang benar-benar disesuaikan yang memenuhi kebutuhan unik Anda.

Siap meningkatkan alur kerja web scraping Anda 10x lipat? Unduh Apidog secara gratis hari ini dan temukan bagaimana ia dapat meningkatkan integrasi Firecrawl Anda!