Developer mencari alat yang meningkatkan produktivitas tanpa menambah kerumitan yang tidak perlu. DeepSeek-V3.2 dan DeepSeek-V3.2-Speciale muncul sebagai model sumber terbuka yang kuat dan dioptimalkan untuk tugas penalaran dan agentik, menawarkan alternatif menarik untuk sistem kepemilikan. Model-model ini unggul dalam pembuatan kode, pemecahan masalah, dan pemrosesan konteks panjang, menjadikannya ideal untuk diintegrasikan ke dalam lingkungan pengkodean berbasis terminal seperti Claude Code.

Memahami DeepSeek-V3.2: Kekuatan Sumber Terbuka untuk Tugas Penalaran

Pengembang menghargai model sumber terbuka karena transparansi dan fleksibilitasnya. DeepSeek-V3.2 menonjol sebagai model bahasa besar (LLM) yang mengutamakan penalaran, yang memprioritaskan inferensi logis, sintesis kode, dan kapabilitas agentik. Dirilis di bawah lisensi MIT, model ini dibangun di atas iterasi sebelumnya seperti DeepSeek-V3.1, menggabungkan kemajuan dalam mekanisme sparse attention untuk menangani konteks yang diperpanjang hingga 128.000 token.

Anda mengakses DeepSeek-V3.2 terutama melalui Hugging Face, di mana repositori di deepseek-ai/DeepSeek-V3.2 menyimpan bobot model, file konfigurasi, dan detail tokenizer. Untuk memuat model secara lokal, instal pustaka Transformers melalui pip dan jalankan skrip sederhana:

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

model_name = "deepseek-ai/DeepSeek-V3.2"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name, torch_dtype=torch.float16, device_map="auto")

# Contoh inferensi

inputs = tokenizer("Tulis fungsi Python untuk menghitung deret Fibonacci:", return_tensors="pt").to(model.device)

outputs = model.generate(**inputs, max_new_tokens=100)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))

Pengaturan ini membutuhkan GPU dengan VRAM minimal 16GB untuk inferensi yang efisien, meskipun teknik kuantisasi melalui pustaka seperti bitsandbytes mengurangi jejak memori. Arsitektur DeepSeek-V3.2 menggunakan desain mixture-of-experts (MoE) dengan 236 miliar parameter, hanya mengaktifkan subset per token untuk mengoptimalkan komputasi. Akibatnya, ia mencapai throughput tinggi pada perangkat keras konsumen sambil mempertahankan kinerja yang kompetitif.

Transisi dari eksperimen lokal ke penggunaan skala produksi seringkali membutuhkan akses API. Pergeseran ini menyediakan skalabilitas tanpa pengelolaan perangkat keras, membuka jalan bagi integrasi seperti Claude Code.

DeepSeek-V3.2-Speciale: Kapabilitas yang Ditingkatkan untuk Alur Kerja Agentik Tingkat Lanjut

Meskipun DeepSeek-V3.2 menawarkan utilitas luas, DeepSeek-V3.2-Speciale menyempurnakan fondasi ini untuk kebutuhan khusus. Varian ini, yang disetel untuk penalaran tingkat kompetisi dan simulasi berisiko tinggi, mendorong batas-batas dalam matematika, kompetisi pengkodean, dan tugas agen multi-langkah. Tersedia melalui repositori Hugging Face di deepseek-ai/DeepSeek-V3.2-Speciale, ia berbagi arsitektur MoE inti tetapi menggabungkan penyesuaian pasca-pelatihan tambahan untuk presisi.

Muat DeepSeek-V3.2-Speciale dengan cara serupa:

model_name = "deepseek-ai/DeepSeek-V3.2-Speciale"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name, torch_dtype=torch.bfloat16, device_map="auto")

Jumlah parameternya mencerminkan model dasar, namun optimisasi dalam sparse attention—DeepSeek Sparse Attention (DSA)—menghasilkan inferensi hingga 50% lebih cepat pada urutan panjang. DSA menggunakan sparsity berbutir halus, menjaga kualitas sambil mengurangi kompleksitas kuadratik pada lapisan attention.

Dalam praktiknya, DeepSeek-V3.2-Speciale unggul dalam skenario yang membutuhkan penalaran berantai, seperti mengoptimalkan algoritma untuk pemrograman kompetitif. Misalnya, berikan perintah: "Selesaikan masalah sulit LeetCode ini: [deskripsi]. Jelaskan pendekatan Anda langkah demi langkah." Model ini menghasilkan solusi terstruktur dengan analisis kompleksitas waktu, seringkali mengungguli model generalis sebesar 15-20% pada kasus-kasus ekstrem.

Namun, eksekusi lokal membutuhkan lebih banyak sumber daya—merekomendasikan VRAM 24GB+ untuk presisi penuh. Untuk pengaturan yang lebih ringan, terapkan kuantisasi 4-bit:

from transformers import BitsAndBytesConfig

quant_config = BitsAndBytesConfig(load_in_4bit=True)

model = AutoModelForCausalLM.from_pretrained(model_name, quantization_config=quant_config)

Konfigurasi ini mempertahankan 90% fidelitas asli sambil mengurangi separuh penggunaan memori. Seperti halnya model dasar, aktifkan mode berpikir untuk memanfaatkan jejak metakognitifnya, di mana ia mengoreksi asumsi sendiri di tengah penalaran.

Akses sumber terbuka memberdayakan penyesuaian, tetapi untuk lingkungan kolaboratif atau berskala, endpoint API memberikan keandalan. Selanjutnya, mari kita lihat bagaimana menjembatani model-model ini ke interaksi berbasis cloud.

Mengakses DeepSeek API: Integrasi Tanpa Hambatan untuk Pengembangan Skalabel

Model sumber terbuka seperti DeepSeek-V3.2 dan DeepSeek-V3.2-Speciale berkembang dalam pengaturan lokal, namun akses API membuka aplikasi yang lebih luas. Platform DeepSeek menawarkan antarmuka yang kompatibel, mendukung OpenAI dan Anthropic SDK untuk migrasi yang mudah.

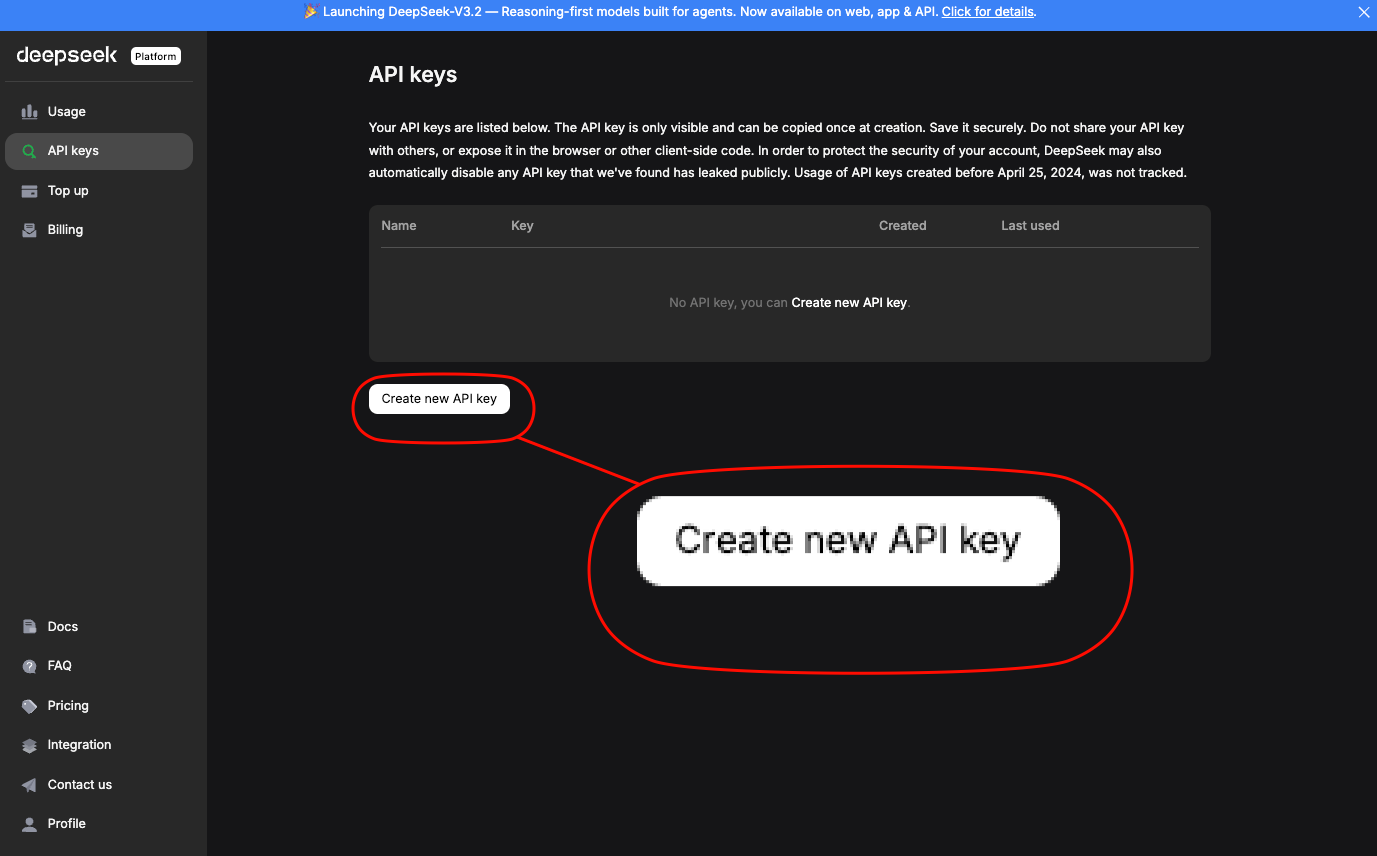

Daftar di platform.deepseek.com untuk mendapatkan kunci API.

Dasbor menyediakan analitik penggunaan dan kontrol penagihan. Panggil model melalui endpoint standar; untuk DeepSeek-V3.2, gunakan alias deepseek-chat. DeepSeek-V3.2-Speciale memerlukan URL dasar tertentu: https://api.deepseek.com/v3.2_speciale_expires_on_20251215—perhatikan bahwa perutean sementara ini kedaluwarsa pada 15 Desember 2025.

Permintaan curl dasar menunjukkan akses:

curl https://api.deepseek.com/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $DEEPSEEK_API_KEY" \

-d '{

"model": "deepseek-chat",

"messages": [{"role": "user", "content": "Buat endpoint REST API di Node.js untuk autentikasi pengguna."}],

"max_tokens": 500,

"temperature": 0.7

}'

Ini mengembalikan JSON dengan kode yang dihasilkan, termasuk penanganan kesalahan dan integrasi JWT. Untuk kompatibilitas Anthropic—kunci untuk Claude Code—atur URL dasar ke https://api.deepseek.com/anthropic dan gunakan SDK Python anthropic:

import anthropic

client = anthropic.Anthropic(base_url="https://api.deepseek.com/anthropic", api_key="your_deepseek_key")

message = client.messages.create(

model="deepseek-chat",

max_tokens=1000,

messages=[{"role": "user", "content": "Jelaskan keterikatan kuantum dalam istilah kode."}]

)

print(message.content[0].text)

Kompatibilitas semacam itu memastikan penggantian yang mudah. Batas kecepatan berada pada 10.000 token per menit untuk tingkatan standar, dapat ditingkatkan melalui paket perusahaan.

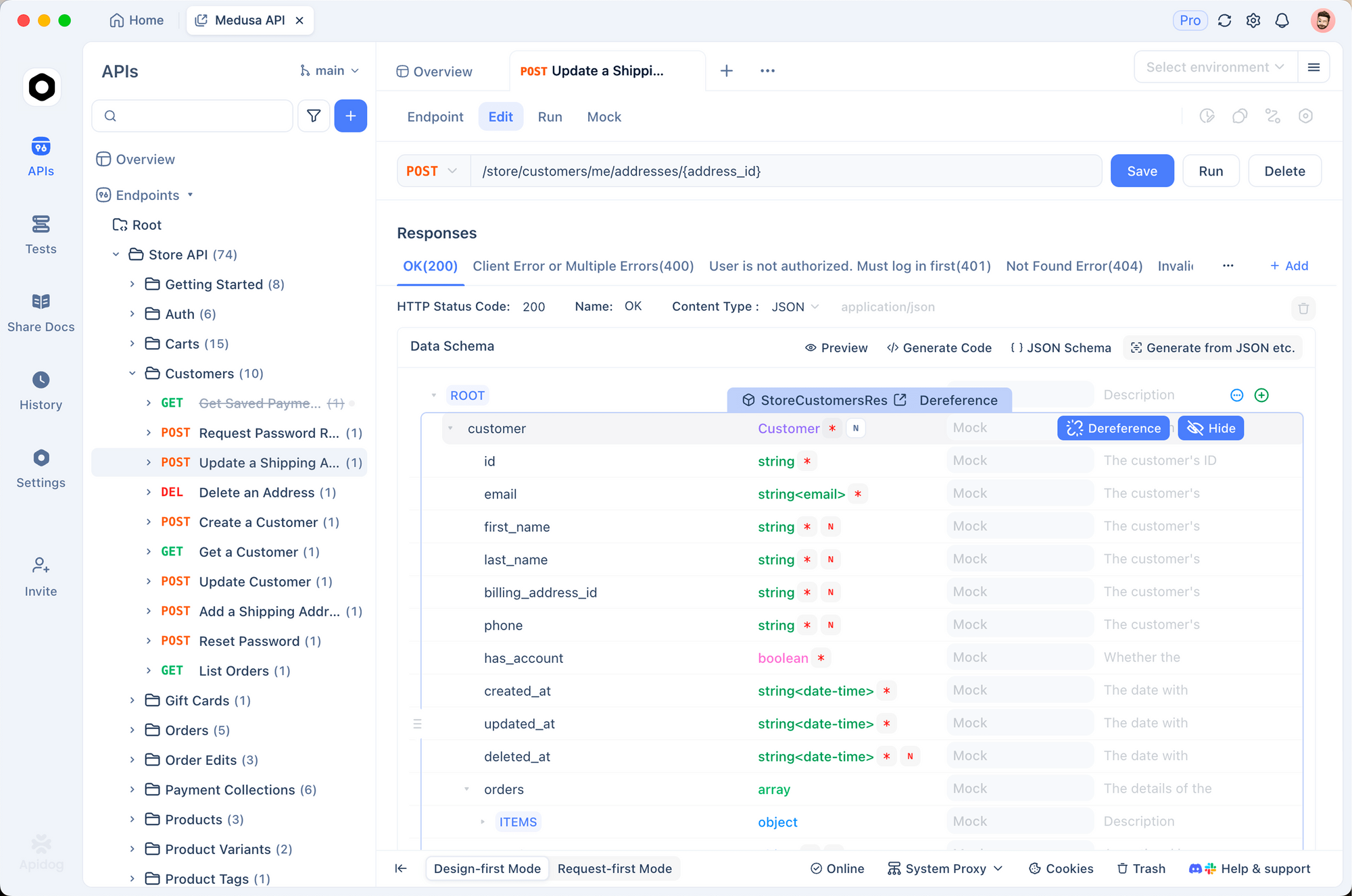

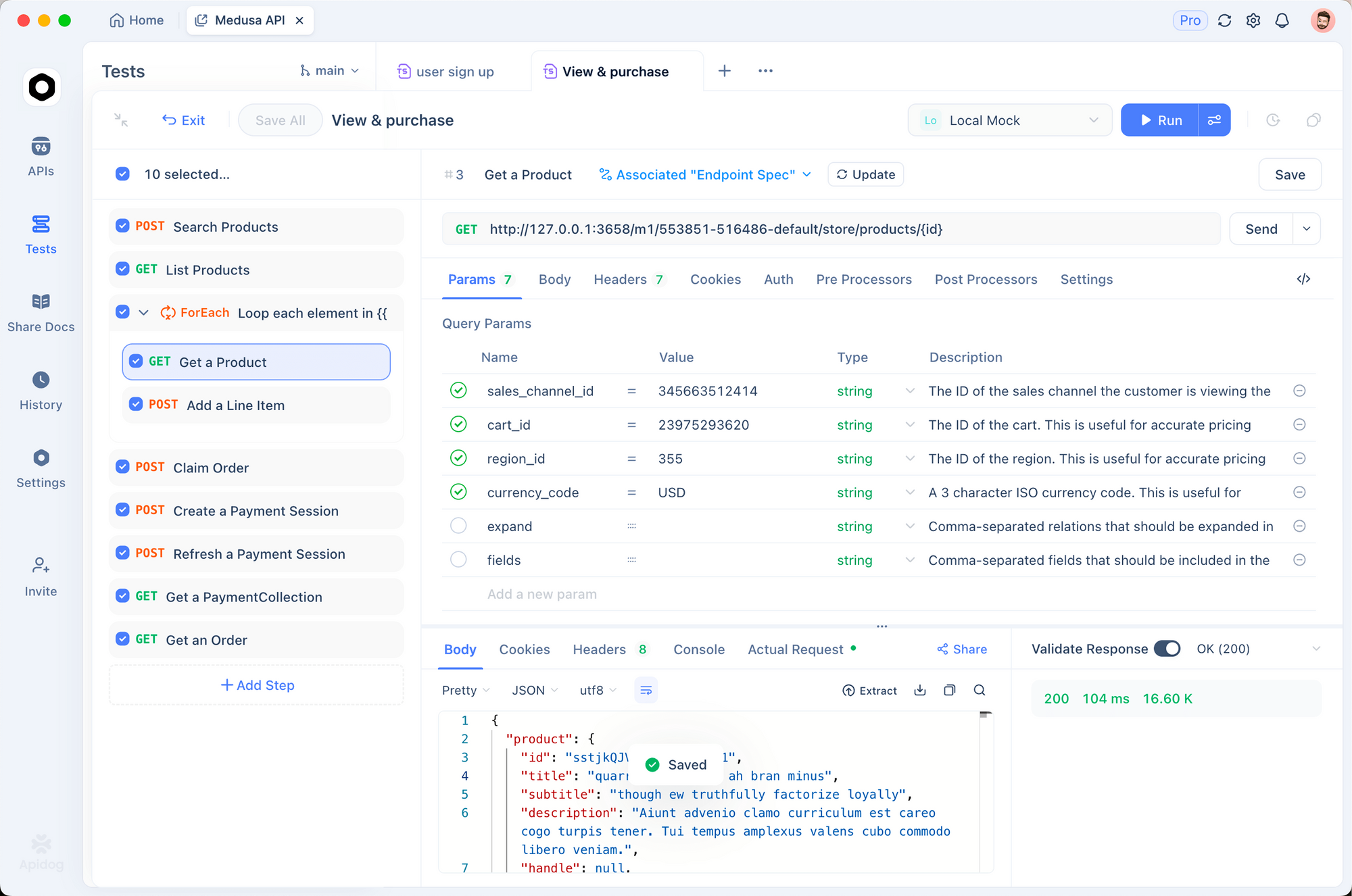

Gunakan Apidog untuk membuat prototipe panggilan ini. Impor spesifikasi OpenAPI dari dokumen DeepSeek ke Apidog, lalu simulasikan permintaan dengan payload variabel. Alat ini secara otomatis menghasilkan suite pengujian, memvalidasi respons terhadap skema—penting untuk memastikan output model selaras dengan standar codebase Anda.

Dengan akses API yang aman, integrasikan endpoint ini ke dalam alat pengembangan. Claude Code, khususnya, diuntungkan dari pengaturan ini, seperti yang akan dijelaskan di bawah.

Rincian Harga: Strategi Hemat Biaya untuk Penggunaan DeepSeek API

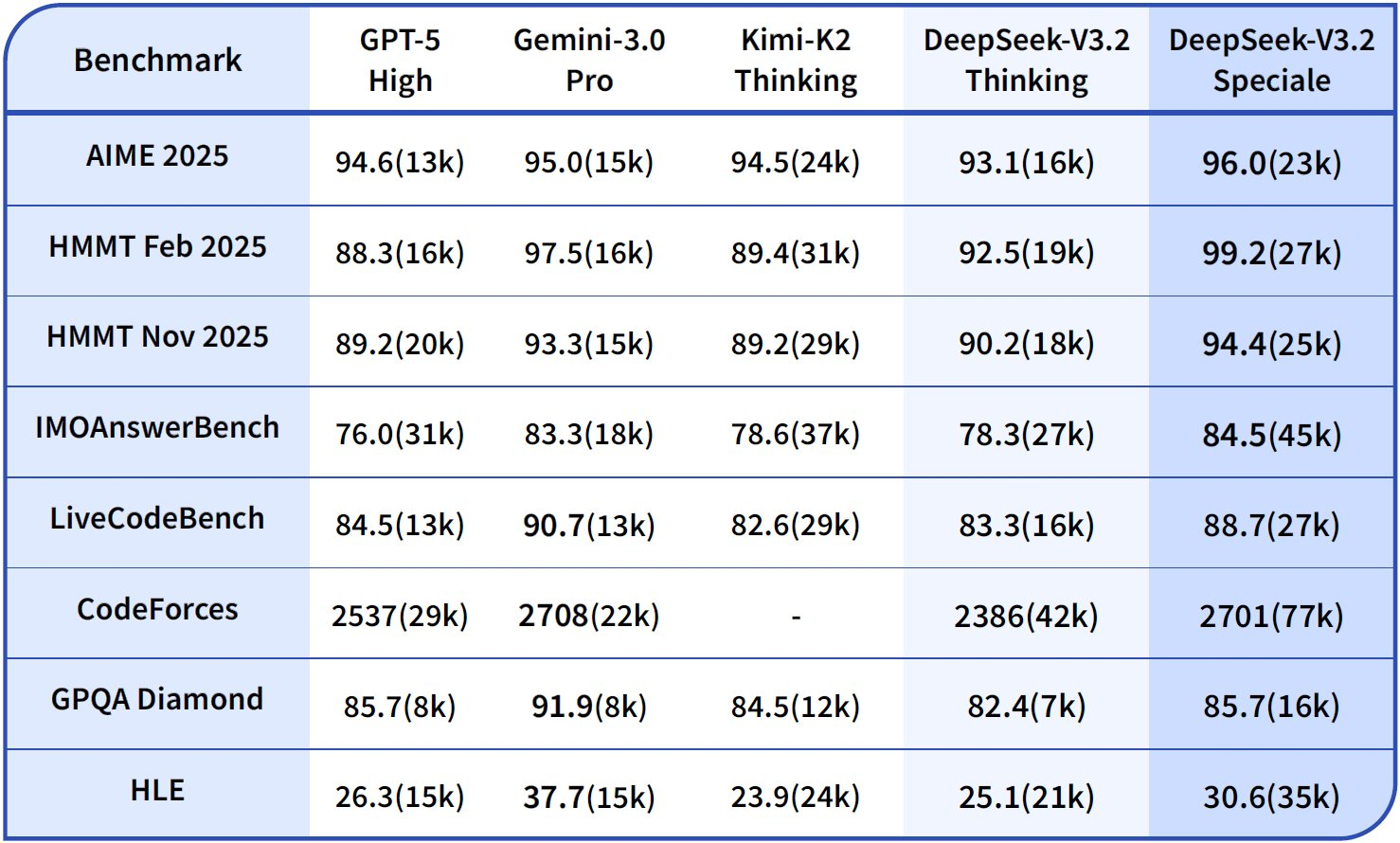

Pengembang yang sadar anggaran menghargai biaya yang dapat diprediksi. Model harga DeepSeek menghargai prompt dan caching yang efisien, yang secara langsung memengaruhi sesi Claude Code.

Rinci strukturnya: Cache hit berlaku untuk prefiks yang berulang, ideal untuk pengkodean iteratif di mana Anda menyempurnakan prompt di seluruh sesi. Misses mengenakan tarif input penuh, jadi strukturkan percakapan untuk memaksimalkan penggunaan kembali. Output berskala linier dengan panjang generasi—batasi max_tokens untuk mengontrol pengeluaran.

| Varian Model | Cache Hit Input ($/1 Juta Token) | Cache Miss Input ($/1 Juta Token) | Output ($/1 Juta Token) | Panjang Konteks |

|---|---|---|---|---|

| DeepSeek-V3.2 | 0.028 | 0.28 | 0.42 | 128K |

| DeepSeek-V3.2-Speciale | 0.028 | 0.28 | 0.42 | 128K |

Pengguna perusahaan menegosiasikan diskon volume, tetapi tingkatan gratis menawarkan 1 Juta token bulanan untuk pengujian. Pantau melalui dasbor; integrasikan pencatatan di Claude Code untuk melacak penggunaan token:

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_API_KEY=$DEEPSEEK_API_KEY

claude --log-tokens

Perintah ini mengeluarkan metrik pasca-sesi, membantu mengoptimalkan prompt. Untuk pengkodean konteks panjang, DSA dalam varian V3.2 menjaga biaya tetap stabil bahkan pada 100 ribu+ token, tidak seperti model dense yang meningkat secara kuadratik.

Mengintegrasikan DeepSeek-V3.2 dan V3.2-Speciale ke dalam Claude Code: Penyiapan Langkah demi Langkah

Claude Code merevolusi pengembangan berbasis terminal sebagai alat agentik dari Anthropic. Ini menafsirkan perintah bahasa alami, menjalankan operasi git, menjelaskan codebase, dan mengotomatiskan rutinitas—semuanya dalam shell Anda. Dengan merutekan permintaan ke model DeepSeek, Anda memanfaatkan penalaran yang hemat biaya tanpa mengorbankan antarmuka intuitif Claude Code.

Mulailah dengan prasyarat: Instal Claude Code melalui pip (pip install claude-code) atau dari GitHub anthropics/claude-code. Pastikan Node.js dan git berada di PATH Anda.

Konfigurasikan variabel lingkungan untuk kompatibilitas DeepSeek:

export ANTHROPIC_BASE_URL="https://api.deepseek.com/anthropic"

export ANTHROPIC_API_KEY="sk-your_deepseek_key_here"

export ANTHROPIC_MODEL="deepseek-chat" # Untuk V3.2

export ANTHROPIC_SMALL_FAST_MODEL="deepseek-chat"

export API_TIMEOUT_MS=600000 # 10 menit untuk penalaran panjang

export CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC=1 # Optimalkan untuk API

Untuk DeepSeek-V3.2-Speciale, tambahkan dasar kustom: export ANTHROPIC_BASE_URL="https://api.deepseek.com/v3.2_speciale_expires_on_20251215/anthropic". Verifikasi penyiapan dengan menjalankan claude --version; ini akan mendeteksi endpoint secara otomatis.

Luncurkan Claude Code di direktori proyek Anda:

cd /path/to/your/repo

claude

Berinteraksi melalui perintah. Untuk pembuatan kode: "/generate Implementasi pohon pencarian biner di C++ dengan penyeimbangan AVL." DeepSeek-V3.2 memproses ini, menghasilkan file dengan penjelasan. Mode berpikirnya aktif secara implisit untuk tugas-tugas kompleks, melacak logika sebelum kode.

Tangani alur kerja agentik: "/agent Debug suite pengujian yang gagal ini dan sarankan perbaikan." Model menganalisis jejak tumpukan, mengusulkan patch, dan melakukan commit melalui git—semuanya ditenagai oleh skor SWE-Bench DeepSeek sebesar 84,8%. Penggunaan alat paralel bersinar di sini; tentukan "/use-tool pytest" untuk menjalankan pengujian secara langsung.

Sesuaikan dengan plugin. Perluas konfigurasi YAML Claude Code (~/.claude-code/config.yaml) untuk memprioritaskan DeepSeek untuk prompt yang membutuhkan penalaran berat:

models:

default: deepseek-chat

fallback: deepseek-chat # Untuk V3.2-Speciale, ganti per sesi

reasoning_enabled: true

max_context: 100000 # Manfaatkan jendela 128K

Uji integrasi menggunakan Apidog. Ekspor sesi Claude Code sebagai file HAR, impor ke Apidog, dan putar ulang terhadap endpoint DeepSeek. Ini memvalidasi latensi (biasanya <2 detik untuk 1K token) dan tingkat kesalahan, menyempurnakan prompt untuk produksi.

Pecahkan masalah umum: Jika autentikasi gagal, buat ulang kunci API Anda. Untuk batas token, potong codebase besar dengan "/summarize repo structure first." Penyesuaian ini memastikan operasi yang lancar.

Teknik Lanjutan: Memanfaatkan DeepSeek di Claude Code untuk Kinerja Optimal

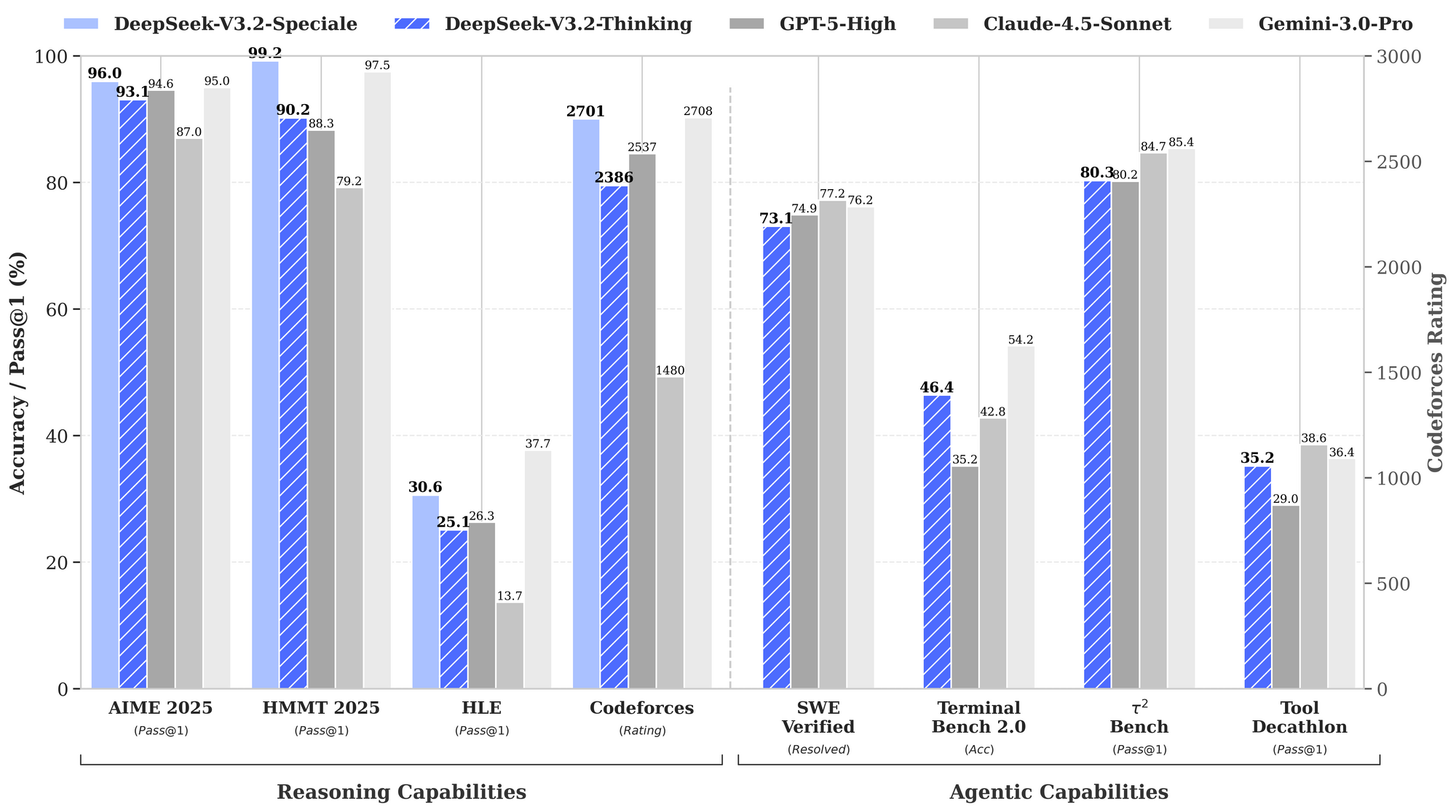

Selain dasar-dasar, pengguna tingkat lanjut memanfaatkan kekuatan DeepSeek. Aktifkan chain-of-thought (CoT) secara eksplisit: "/think Selesaikan masalah pemrograman dinamis ini: [detail]." V3.2-Speciale menghasilkan jejak metakognitif, mengoreksi diri melalui simulasi quasi-Monte Carlo dalam teks—meningkatkan akurasi hingga 94,6% pada HMMT.

Untuk pengeditan multi-file, gunakan "/edit --files main.py utils.py Tambahkan dekorator logging." Agen menavigasi dependensi, menerapkan perubahan secara atomik. Tolok ukur menunjukkan keberhasilan 80,3% pada Terminal-Bench 2.0, mengungguli Gemini-3.0-Pro.

Integrasikan alat eksternal: Konfigurasikan "/tool npm run build" untuk validasi pasca-generasi. Tolok ukur penggunaan alat DeepSeek (84,7%) memastikan orkestrasi yang andal.

Pantau etika: DeepSeek selaras dengan keamanan melalui RLHF, tetapi audit output untuk bias dalam asumsi kode. Gunakan validasi skema Apidog untuk menerapkan pola aman, seperti sanitasi input.

Skala untuk tim: Bagikan konfigurasi melalui repos dotfile. Dalam CI/CD, sematkan skrip Claude Code dengan DeepSeek untuk tinjauan PR otomatis—memangkas waktu tinjauan hingga 40%.

Aplikasi Dunia Nyata: Claude Code yang Ditenagai DeepSeek dalam Aksi

Pertimbangkan proyek fintech: "/generate API Aman untuk pemrosesan transaksi menggunakan GraphQL." DeepSeek-V3.2 menghasilkan skema, resolver, dan middleware pembatasan kecepatan, divalidasi terhadap standar OWASP.

Dalam pipeline ML: "/agent Optimalkan model PyTorch ini untuk deployment edge." Ini melakukan refactoring untuk kuantisasi, menguji pada perangkat keras yang disimulasikan, dan mendokumentasikan trade-off.

Kasus-kasus ini menunjukkan peningkatan produktivitas 2-3x, didukung oleh laporan pengguna pada masalah GitHub.

Kesimpulan

DeepSeek-V3.2 dan DeepSeek-V3.2-Speciale mengubah Claude Code menjadi kekuatan yang berpusat pada penalaran. Dari pemuatan sumber terbuka hingga skalabilitas berbasis API, model-model ini memberikan kinerja terdepan dengan harga yang sangat terjangkau. Terapkan langkah-langkah yang diuraikan—dimulai dengan Apidog untuk prototipe API—dan saksikan alur kerja yang efisien.

Bereksperimenlah hari ini: Siapkan lingkungan Anda, jalankan perintah contoh, dan lakukan iterasi. Integrasi ini tidak hanya mempercepat pengembangan tetapi juga menumbuhkan pemahaman kode yang lebih dalam melalui penalaran yang transparan. Seiring dengan evolusi AI, alat seperti ini memastikan pengembang tetap berada di garis depan.