Para insinyur DeepSeek merilis DeepSeek-V3.1-Terminus sebagai peningkatan iteratif pada model V3.1 mereka, mengatasi masalah yang dilaporkan pengguna sekaligus memperkuat kekuatan intinya. Versi ini berfokus pada peningkatan praktis yang dihargai pengembang dalam aplikasi dunia nyata, seperti keluaran bahasa yang konsisten dan fungsionalitas agen yang tangguh. Seiring berkembangnya model AI, tim seperti DeepSeek memprioritaskan penyempurnaan yang meningkatkan keandalan tanpa merombak fondasinya. Akibatnya, DeepSeek-V3.1-Terminus muncul sebagai alat yang disempurnakan untuk tugas-tugas mulai dari pembuatan kode hingga penalaran kompleks.

Rilis ini menggarisbawahi komitmen DeepSeek terhadap inovasi sumber terbuka. Model ini kini tersedia di Hugging Face, memungkinkan akses langsung untuk eksperimen. Para insinyur membangun di atas basis V3.1, memperkenalkan penyesuaian yang meningkatkan kinerja di berbagai tolok ukur. Akibatnya, pengguna mengalami lebih sedikit frustrasi, seperti respons campuran bahasa Mandarin-Inggris atau karakter yang tidak menentu, yang sebelumnya menghambat interaksi yang mulus.

Memahami Arsitektur DeepSeek-V3.1-Terminus

Arsitek DeepSeek merancang DeepSeek-V3.1-Terminus dengan kerangka kerja Mixture of Experts (MoE) hibrida, mencerminkan struktur pendahulunya, DeepSeek-V3. Pendekatan ini menggabungkan komponen padat dan jarang, memungkinkan model untuk mengaktifkan hanya ahli yang relevan untuk tugas-tugas tertentu. Akibatnya, ia mencapai efisiensi tinggi, memproses kueri dengan overhead komputasi yang berkurang dibandingkan dengan model yang sepenuhnya padat.

Pada intinya, model ini memiliki 685 miliar parameter, yang didistribusikan di seluruh modul ahli. Para insinyur menggunakan tipe tensor BF16, F8_E4M3, dan F32 untuk parameter ini, mengoptimalkan presisi dan kecepatan. Namun, masalah yang dicatat melibatkan proyeksi keluaran self-attention yang tidak sepenuhnya mematuhi format skala UE8M0 FP8, yang DeepSeek berencana untuk selesaikan dalam iterasi mendatang. Cacat kecil ini tidak mengurangi fungsionalitas keseluruhan secara signifikan tetapi menyoroti sifat iteratif pengembangan model.

Selain itu, DeepSeek-V3.1-Terminus mendukung mode berpikir dan non-berpikir. Dalam mode berpikir, model terlibat dalam penalaran multi-langkah, menarik logika internal untuk menangani masalah kompleks. Mode non-berpikir, sebaliknya, memprioritaskan respons cepat untuk kueri langsung. Dualitas ini berasal dari pasca-pelatihan pada checkpoint V3.1-Base yang diperluas, yang menggabungkan metode ekstensi konteks panjang dua fase. Pengembang mengumpulkan dokumen panjang tambahan untuk memperkuat dataset, memperpanjang fase pelatihan untuk penanganan konteks yang lebih baik.

Peningkatan Utama dalam DeepSeek-V3.1-Terminus Dibandingkan Versi Sebelumnya

Para insinyur DeepSeek menyempurnakan DeepSeek-V3.1-Terminus dengan mengatasi umpan balik dari rilis V3.1, menghasilkan peningkatan yang nyata. Terutama, mereka mengurangi inkonsistensi bahasa, menghilangkan campuran bahasa Mandarin-Inggris yang sering terjadi dan karakter acak yang mengganggu keluaran sebelumnya. Perubahan ini memastikan respons yang lebih bersih dan profesional, terutama di lingkungan multibahasa.

Selain itu, peningkatan agen menonjol sebagai kemajuan besar. Agen Kode kini menangani tugas pemrograman dengan akurasi yang lebih tinggi, sementara Agen Pencarian meningkatkan efisiensi pengambilan. Peningkatan ini berasal dari data pelatihan yang disempurnakan dan templat yang diperbarui, memungkinkan model untuk mengintegrasikan alat dengan lebih mulus.

Perbandingan tolok ukur mengungkapkan keuntungan ini secara kuantitatif. Misalnya, dalam mode penalaran tanpa penggunaan alat, skor MMLU-Pro naik dari 84.8 menjadi 85.0, dan GPQA-Diamond meningkat dari 80.1 menjadi 80.7. Humanity's Last Exam menunjukkan lompatan substansial dari 15.9 menjadi 21.7, menunjukkan kinerja yang lebih kuat pada evaluasi yang menantang. LiveCodeBench tetap hampir stabil di 74.9, dengan fluktuasi kecil di Codeforces dan Aider-Polyglot.

Beralih ke penggunaan alat agentik, model ini unggul lebih jauh. BrowseComp meningkat dari 30.0 menjadi 38.5, dan SimpleQA naik dari 93.4 menjadi 96.8. SWE Verified maju ke 68.4 dari 66.0, SWE-bench Multilingual ke 57.8 dari 54.5, dan Terminal-bench ke 36.7 dari 31.3. Meskipun BrowseComp-zh sedikit menurun, tren keseluruhan menunjukkan keandalan yang superior.

Selain itu, DeepSeek-V3.1-Terminus mencapai ini tanpa mengorbankan kecepatan. Ia merespons lebih cepat daripada beberapa pesaing sambil mempertahankan kualitas yang sebanding dengan DeepSeek-R1 pada tolok ukur yang sulit. Keseimbangan ini muncul dari pasca-pelatihan yang dioptimalkan, menggabungkan data konteks panjang untuk generalisasi yang lebih baik.

Tolok Ukur Kinerja dan Evaluasi untuk DeepSeek-V3.1-Terminus

Para evaluator menilai DeepSeek-V3.1-Terminus di berbagai tolok ukur, mengungkapkan kekuatannya dalam penalaran dan integrasi alat. Dalam penalaran non-alat, model ini mencetak 85.0 pada MMLU-Pro, menunjukkan retensi pengetahuan yang luas. GPQA-Diamond mencapai 80.7, menunjukkan kemahiran dalam pertanyaan tingkat pascasarjana.

Selain itu, Humanity's Last Exam pada 21.7 menyoroti penanganan topik esoterik yang lebih baik. Tolok ukur pengkodean seperti LiveCodeBench (74.9) dan Aider-Polyglot (76.1) menunjukkan kegunaan praktis, meskipun Codeforces turun menjadi 2046, menunjukkan area untuk penyempurnaan lebih lanjut.

Beralih ke skenario agentik, skor BrowseComp 38.5 mencerminkan kemampuan navigasi web yang ditingkatkan. Skor SimpleQA yang hampir sempurna 96.8 menggarisbawahi akurasi dalam resolusi kueri. Suite SWE-bench, termasuk Verified (68.4) dan Multilingual (57.8), menegaskan kehebatan rekayasa perangkat lunaknya. Terminal-bench pada 36.7 menunjukkan kompetensi dalam interaksi baris perintah.

Secara komparatif, DeepSeek-V3.1-Terminus mengungguli V3.1 di sebagian besar metrik, mencapai keuntungan biaya 68x dengan pengorbanan kinerja minimal. Ini menyaingi model sumber tertutup dalam efisiensi, menjadikannya ideal untuk aplikasi bisnis.

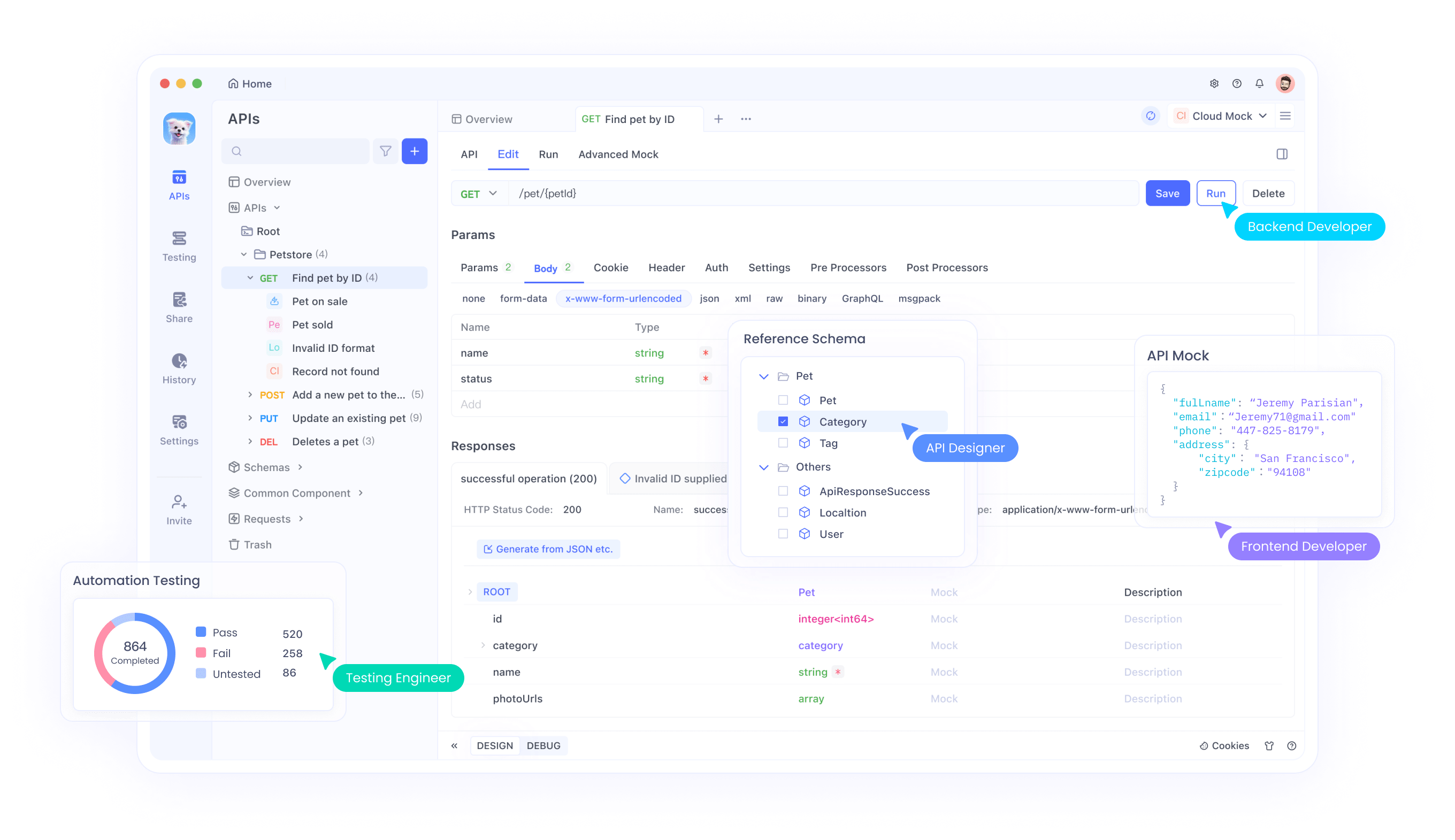

Mengintegrasikan DeepSeek-V3.1-Terminus dengan API dan Alat Seperti Apidog

Pengembang mengintegrasikan DeepSeek-V3.1-Terminus melalui API yang kompatibel dengan OpenAI, menyederhanakan adopsi. Mereka menentukan 'deepseek-chat' untuk mode non-berpikir atau 'deepseek-reasoner' untuk mode berpikir.

Untuk memulai, pengguna membuat kunci API di platform DeepSeek. Dengan Apidog, mereka menyiapkan lingkungan dengan memasukkan URL dasar (https://api.deepseek.com) dan menyimpan kunci sebagai variabel. Pengaturan ini memfasilitasi pengujian penyelesaian obrolan dan panggilan fungsi.

Selain itu, Apidog mendukung debugging, memungkinkan pengembang untuk memverifikasi respons secara efisien. Untuk panggilan fungsi, mereka mendefinisikan alat dalam permintaan, memungkinkan model untuk memanggil fungsi eksternal secara dinamis.

Harga tetap kompetitif di $1.68 per juta token keluaran, mendorong penggunaan yang luas. Integrasi meluas ke kerangka kerja seperti Geneplore AI atau API AI/ML, mendukung sistem multi-agen.

Perbandingan dengan Model AI Pesaing

DeepSeek-V3.1-Terminus bersaing secara efektif dengan model seperti DeepSeek-R1, menyamai kualitas dalam penalaran sambil merespons lebih cepat. Ini melampaui V3.1 dalam penggunaan alat, dengan peningkatan BrowseComp sebesar 8.5 poin.

Terhadap opsi berpemilik, ia menawarkan aksesibilitas sumber terbuka dan efisiensi biaya. Misalnya, ia mendekati kinerja tingkat Sonnet dalam tolok ukur.

Selain itu, mode hibridanya memberikan keserbagunaan yang tidak ada pada beberapa pesaing. Oleh karena itu, ia menarik bagi pengembang yang sadar anggaran yang mencari fitur-fitur tangguh.

Strategi Penerapan untuk DeepSeek-V3.1-Terminus

Para insinyur menerapkan model secara lokal menggunakan repo DeepSeek-V3. Untuk cloud, platform seperti AWS Bedrock menjadi hostnya.

Kode inferensi yang dioptimalkan di repositori membantu pengaturan. Oleh karena itu, skalabilitas cocok untuk berbagai lingkungan.

Fitur Lanjutan: Panggilan Fungsi dan Integrasi Alat

Pengembang mengimplementasikan panggilan fungsi dengan mendefinisikan skema dalam permintaan API. Ini memungkinkan interaksi dinamis, seperti mengkueri basis data.

Apidog membantu dalam menguji fitur-fitur ini, memastikan integrasi yang kuat.

Analisis Biaya dan Kiat Optimasi

Dengan biaya per-token yang rendah, DeepSeek-V3.1-Terminus menawarkan nilai. Optimalkan dengan memilih mode secara bijak—non-berpikir untuk tugas sederhana.

Pantau penggunaan melalui Apidog untuk mengelola pengeluaran secara efektif.

Umpan Balik Pengguna dan Penerimaan Komunitas

Pengguna merayakan rilis ini, mencatat peningkatan stabilitas. Beberapa mengantisipasi V4, mencerminkan ekspektasi tinggi.

Forum seperti Reddit ramai dengan diskusi tentang kekuatan agentiknya.

Kesimpulan: Merangkul DeepSeek-V3.1-Terminus dalam Pengembangan AI

DeepSeek-V3.1-Terminus menyempurnakan kemampuan AI, menawarkan pengembang alat yang kuat dan efisien. Peningkatannya dalam agen dan bahasa membuka jalan bagi aplikasi inovatif. Seiring tim mengadopsinya, model terus berkembang, didorong oleh masukan komunitas.