Dalam dunia aplikasi bertenaga AI, Claude API dari Anthropic telah menjadi solusi utama bagi banyak pengembang yang mencari kemampuan pemrosesan bahasa tingkat lanjut. Namun, seperti halnya layanan populer lainnya, Anda mungkin akan menemui batasan laju (rate limits) yang dapat menghentikan sementara fungsionalitas aplikasi Anda. Memahami batasan ini dan menerapkan strategi untuk bekerja di dalamnya sangat penting untuk menjaga pengalaman pengguna yang lancar.

Untuk Pemrograman AI, Claude telah muncul sebagai asisten yang hebat bagi pengguna biasa maupun pengembang. Namun, banyak pengguna mengalami frustrasi umum: batasan laju.

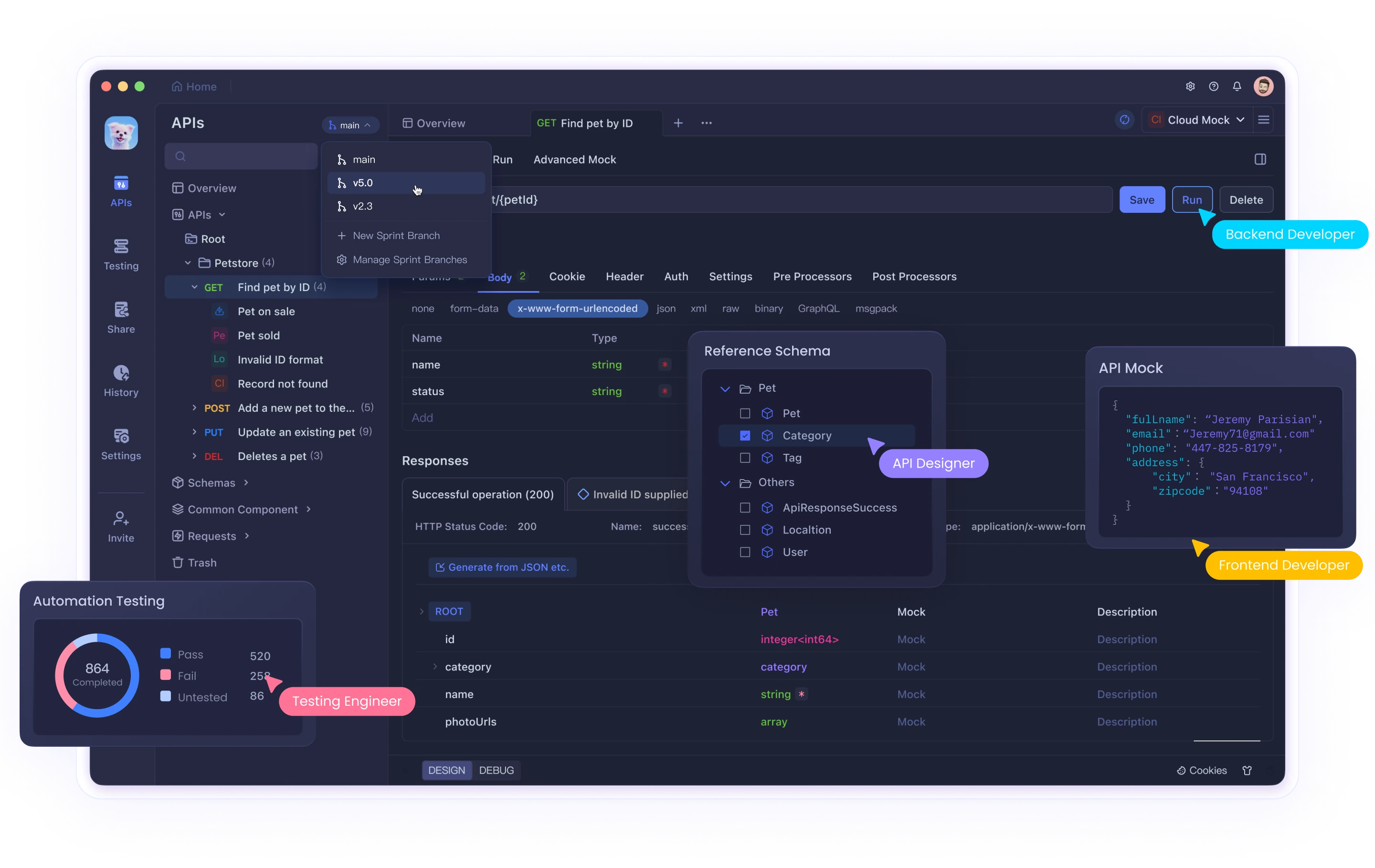

Baik Anda menggunakan antarmuka web Claude atau berintegrasi dengan API-nya melalui alat seperti Cursor atau Cline, mencapai batasan ini dapat mengganggu alur kerja dan produktivitas Anda. Meskipun alat seperti Claude menyediakan kemampuan AI yang hebat, mengelola interaksi API secara efektif memerlukan pengujian dan alat debugging yang tepat. Apidog membantu pengembang menavigasi kompleksitas ini saat bekerja dengan AI dan API lainnya.

Panduan komprehensif ini akan membahas mengapa batasan laju Claude API ada, bagaimana mengidentifikasi ketika Anda telah mencapainya, dan memberikan tiga solusi terperinci untuk membantu Anda mengatasi tantangan ini secara efektif.

Apa Itu Batasan Laju Claude API dan Mengapa Batasan Itu Ada?

Batasan laju adalah pembatasan yang diberlakukan oleh penyedia API untuk mengontrol volume permintaan yang dapat dilakukan pengguna dalam jangka waktu tertentu. Anthropic menerapkan batasan ini karena beberapa alasan penting:

- Manajemen Sumber Daya Server: Mencegah satu pengguna mengonsumsi terlalu banyak sumber daya komputasi

- Akses yang Adil: Memastikan distribusi akses API yang adil di antara semua pengguna

- Pencegahan Penyalahgunaan: Melindungi dari aktivitas jahat seperti scraping atau serangan DDoS

- Stabilitas Layanan: Menjaga kinerja sistem secara keseluruhan selama waktu penggunaan puncak

Batasan Laju Spesifik Claude API

Batasan laju Claude bervariasi berdasarkan jenis akun Anda:

- Pengguna Gratis: Sekitar 100 pesan per hari, dengan kuota yang direset pada tengah malam

- Pengguna Pro: Kira-kira lima kali lipat batas pengguna gratis (sekitar 500 pesan setiap hari)

- Pengguna API: Batas khusus berdasarkan paket dan perjanjian khusus Anda dengan Anthropic

Selain itu, selama waktu penggunaan puncak, batasan ini mungkin ditegakkan lebih ketat, dan Anda mungkin mengalami throttling sementara bahkan sebelum mencapai alokasi maksimum Anda.

Mengidentifikasi Masalah Batasan Laju

Anda mungkin telah mencapai batasan laju ketika aplikasi Anda menerima kode status HTTP 429 Too Many Requests. Respons biasanya menyertakan header dengan informasi tentang:

- Kapan Anda dapat melanjutkan membuat permintaan

- Statistik penggunaan Anda saat ini

- Informasi kuota yang tersisa

Solusi 1: Terapkan Batasan Laju yang Tepat dalam Kode Anda

Pendekatan paling mendasar untuk menangani batasan laju API adalah menerapkan batasan laju sisi klien. Ini secara proaktif mencegah aplikasi Anda melebihi volume permintaan yang diizinkan.

Menggunakan Algoritma Token Bucket

Token bucket adalah algoritma populer untuk batasan laju yang bekerja dengan cara:

- Mempertahankan "bucket" yang terisi dengan token pada tingkat yang konstan

- Mengonsumsi token untuk setiap permintaan API

- Memblokir permintaan ketika tidak ada token yang tersedia

Berikut adalah implementasi Python:

import time

import threading

class TokenBucket:

def __init__(self, tokens_per_second, max_tokens):

self.tokens_per_second = tokens_per_second

self.max_tokens = max_tokens

self.tokens = max_tokens

self.last_refill = time.time()

self.lock = threading.Lock()

def _refill_tokens(self):

now = time.time()

elapsed = now - self.last_refill

new_tokens = elapsed * self.tokens_per_second

self.tokens = min(self.max_tokens, self.tokens + new_tokens)

self.last_refill = now

def get_token(self):

with self.lock:

self._refill_tokens()

if self.tokens >= 1:

self.tokens -= 1

return True

return False

def wait_for_token(self, timeout=None):

start_time = time.time()

while True:

if self.get_token():

return True

if timeout is not None and time.time() - start_time > timeout:

return False

time.sleep(0.1) # Sleep to avoid busy waiting

# Example usage with Claude API

import anthropic

# Create a rate limiter (5 requests per second, max burst of 10)

rate_limiter = TokenBucket(tokens_per_second=5, max_tokens=10)

client = anthropic.Anthropic(api_key="your_api_key")

def generate_with_claude(prompt):

# Wait for a token to become available

if not rate_limiter.wait_for_token(timeout=30):

raise Exception("Timed out waiting for rate limit token")

try:

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": prompt}]

)

return response.content

except Exception as e:

if "429" in str(e):

print("Rate limit hit despite our rate limiting! Backing off...")

time.sleep(10) # Additional backoff

return generate_with_claude(prompt) # Retry

raise

Implementasi ini:

- Membuat token bucket yang diisi ulang pada tingkat yang konstan

- Menunggu token tersedia sebelum membuat permintaan

- Menerapkan backoff tambahan jika batasan laju masih ditemui

Menangani Respons 429 dengan Exponential Backoff

Bahkan dengan batasan laju proaktif, Anda mungkin sesekali mencapai batasan. Menerapkan exponential backoff membantu aplikasi Anda pulih dengan baik:

import time

import random

def call_claude_api_with_backoff(prompt, max_retries=5, base_delay=1):

retries = 0

while retries <= max_retries:

try:

# Wait for rate limiter token

rate_limiter.wait_for_token()

# Make the API call

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": prompt}]

)

return response.content

except Exception as e:

if "429" in str(e) and retries < max_retries:

# Calculate delay with exponential backoff and jitter

delay = base_delay * (2 ** retries) + random.uniform(0, 0.5)

print(f"Rate limited. Retrying in {delay:.2f} seconds...")

time.sleep(delay)

retries += 1

else:

raise

raise Exception("Max retries exceeded")

Fungsi ini:

- Mencoba membuat panggilan API

- Jika terjadi kesalahan 429, ia menunggu waktu yang meningkat secara eksponensial

- Menambahkan jitter acak untuk mencegah sinkronisasi permintaan

- Menyerah setelah jumlah percobaan ulang maksimum

Solusi 2: Terapkan Antrean Permintaan dan Prioritisasi

Untuk aplikasi dengan berbagai tingkat kepentingan permintaan, menerapkan antrean permintaan dengan penanganan prioritas dapat mengoptimalkan penggunaan API Anda.

Membangun Sistem Antrean Prioritas

import heapq

import threading

import time

from dataclasses import dataclass, field

from typing import Any, Callable, Optional

@dataclass(order=True)

class PrioritizedRequest:

priority: int

execute_time: float = field(compare=False)

callback: Callable = field(compare=False)

args: tuple = field(default_factory=tuple, compare=False)

kwargs: dict = field(default_factory=dict, compare=False)

class ClaudeRequestQueue:

def __init__(self, requests_per_minute=60):

self.queue = []

self.lock = threading.Lock()

self.processing = False

self.requests_per_minute = requests_per_minute

self.interval = 60 / requests_per_minute

def add_request(self, callback, priority=0, delay=0, *args, **kwargs):

"""Add a request to the queue with the given priority."""

with self.lock:

execute_time = time.time() + delay

request = PrioritizedRequest(

priority=-priority, # Negate so higher values have higher priority

execute_time=execute_time,

callback=callback,

args=args,

kwargs=kwargs

)

heapq.heappush(self.queue, request)

if not self.processing:

self.processing = True

threading.Thread(target=self._process_queue, daemon=True).start()

def _process_queue(self):

"""Process requests from the queue, respecting rate limits."""

while True:

with self.lock:

if not self.queue:

self.processing = False

return

# Get the highest priority request that's ready to execute

request = self.queue[0]

now = time.time()

if request.execute_time > now:

# Wait until the request is ready

wait_time = request.execute_time - now

time.sleep(wait_time)

continue

# Remove the request from the queue

heapq.heappop(self.queue)

# Execute the request outside the lock

try:

request.callback(*request.args, **request.kwargs)

except Exception as e:

print(f"Error executing request: {e}")

# Wait for the rate limit interval

time.sleep(self.interval)

# Example usage

queue = ClaudeRequestQueue(requests_per_minute=60)

def process_result(result, callback):

print(f"Got result: {result[:50]}...")

if callback:

callback(result)

def make_claude_request(prompt, callback=None, priority=0):

def execute():

try:

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": prompt}]

)

process_result(response.content, callback)

except Exception as e:

if "429" in str(e):

# Re-queue with a delay if rate limited

print("Rate limited, re-queuing...")

queue.add_request(

make_claude_request,

priority=priority-1, # Lower priority for retries

delay=10, # Wait 10 seconds before retrying

prompt=prompt,

callback=callback,

priority=priority

)

else:

print(f"Error: {e}")

queue.add_request(execute, priority=priority)

# Make some requests with different priorities

make_claude_request("High priority question", priority=10)

make_claude_request("Medium priority question", priority=5)

make_claude_request("Low priority question", priority=1)

Implementasi ini:

- Membuat antrean prioritas untuk permintaan API

- Memproses permintaan berdasarkan prioritas dan waktu eksekusi yang dijadwalkan

- Secara otomatis membatasi permintaan untuk tetap berada di bawah batasan laju

- Menangani percobaan ulang dengan prioritas yang menurun

Solusi 3: Mendistribusikan Permintaan di Beberapa Instance

Untuk aplikasi bervolume tinggi, mendistribusikan permintaan Claude API di beberapa instance dapat membantu Anda meningkatkan skala di luar batasan akun tunggal.

Load Balancing di Beberapa Kunci API

import random

import threading

from datetime import datetime, timedelta

class APIKeyManager:

def __init__(self, api_keys, requests_per_day_per_key):

self.api_keys = {}

self.lock = threading.Lock()

# Initialize each API key's usage tracking

for key in api_keys:

self.api_keys[key] = {

'key': key,

'daily_limit': requests_per_day_per_key,

'used_today': 0,

'last_reset': datetime.now().date(),

'available': True

}

def _reset_daily_counters(self):

"""Reset daily counters if it's a new day."""

today = datetime.now().date()

for key_info in self.api_keys.values():

if key_info['last_reset'] < today:

key_info['used_today'] = 0

key_info['last_reset'] = today

key_info['available'] = True

def get_available_key(self):

"""Get an available API key that hasn't exceeded its daily limit."""

with self.lock:

self._reset_daily_counters()

available_keys = [

key_info for key_info in self.api_keys.values()

if key_info['available'] and key_info['used_today'] < key_info['daily_limit']

]

if not available_keys:

return None

# Choose a key with the fewest used requests today

selected_key = min(available_keys, key=lambda k: k['used_today'])

selected_key['used_today'] += 1

# If key has reached its limit, mark as unavailable

if selected_key['used_today'] >= selected_key['daily_limit']:

selected_key['available'] = False

return selected_key['key']

def mark_key_used(self, api_key):

"""Mark that a request was made with this key."""

with self.lock:

if api_key in self.api_keys:

self.api_keys[api_key]['used_today'] += 1

if self.api_keys[api_key]['used_today'] >= self.api_keys[api_key]['daily_limit']:

self.api_keys[api_key]['available'] = False

def mark_key_rate_limited(self, api_key, retry_after=60):

"""Mark a key as temporarily unavailable due to rate limiting."""

with self.lock:

if api_key in self.api_keys:

self.api_keys[api_key]['available'] = False

# Start a timer to mark the key available again after the retry period

def make_available_again():

with self.lock:

if api_key in self.api_keys:

self.api_keys[api_key]['available'] = True

timer = threading.Timer(retry_after, make_available_again)

timer.daemon = True

timer.start()

# Example usage

api_keys = [

"key1_abc123",

"key2_def456",

"key3_ghi789"

]

key_manager = APIKeyManager(api_keys, requests_per_day_per_key=100)

def call_claude_api_distributed(prompt):

api_key = key_manager.get_available_key()

if not api_key:

raise Exception("No available API keys - all have reached their daily limits")

client = anthropic.Anthropic(api_key=api_key)

try:

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": prompt}]

)

return response.content

except Exception as e:

if "429" in str(e):

# Parse retry-after header if available, otherwise use default

retry_after = 60 # Default

key_manager.mark_key_rate_limited(api_key, retry_after)

# Recursively try again with a different key

return call_claude_api_distributed(prompt)

else:

raise

Pendekatan ini:

- Mengelola beberapa kunci API dan melacak penggunaannya

- Mendistribusikan permintaan untuk tetap berada di bawah batasan laju per kunci

- Menangani respons batasan laju dengan menghapus sementara kunci yang terpengaruh dari rotasi

- Secara otomatis mengatur ulang penghitung penggunaan setiap hari

Praktik Terbaik untuk Mengelola Batasan Laju Claude API

Selain tiga solusi di atas, berikut adalah beberapa praktik terbaik tambahan:

Pantau Penggunaan Anda Secara Proaktif

- Terapkan dasbor untuk melacak penggunaan API Anda

- Siapkan peringatan saat Anda mendekati batasan laju

- Tinjau secara teratur pola penggunaan untuk mengidentifikasi peluang optimasi

Terapkan Degradasi yang Baik

- Rancang aplikasi Anda untuk memberikan respons alternatif saat dibatasi laju

- Pertimbangkan untuk menyimpan respons sebelumnya untuk kueri serupa

- Berikan umpan balik transparan kepada pengguna saat mengalami batasan laju

Optimalkan Prompt Anda

- Kurangi panggilan API yang tidak perlu dengan membuat prompt yang lebih efektif

- Gabungkan kueri terkait ke dalam permintaan tunggal jika memungkinkan

- Pra-proses input untuk menghilangkan kebutuhan akan permintaan klarifikasi

Berkomunikasi dengan Anthropic

- Untuk aplikasi produksi, pertimbangkan untuk meningkatkan ke paket tingkat yang lebih tinggi

- Hubungi Anthropic tentang batasan laju khusus untuk kasus penggunaan spesifik Anda

- Tetap terinformasi tentang pembaruan platform dan perubahan pada kebijakan batasan laju

Kesimpulan

Batasan laju adalah bagian tak terhindarkan dari bekerja dengan API yang hebat seperti Claude. Dengan menerapkan solusi yang diuraikan dalam artikel ini—kode batasan laju yang tepat, antrean permintaan, dan penanganan permintaan terdistribusi—Anda dapat membangun aplikasi yang kuat yang menangani batasan ini dengan baik.

Ingatlah bahwa batasan laju ada untuk memastikan akses yang adil dan stabilitas sistem bagi semua pengguna. Bekerja dalam batasan ini tidak hanya meningkatkan keandalan aplikasi Anda tetapi juga berkontribusi pada kesehatan ekosistem secara keseluruhan.

Dengan perencanaan yang matang dan penerapan strategi ini, Anda dapat memaksimalkan penggunaan kemampuan AI Claude yang hebat sambil mempertahankan pengalaman yang lancar bagi pengguna Anda, bahkan saat aplikasi Anda berkembang.