Sebuah tim sangat mengandalkan AI untuk menghasilkan kode aplikasi mereka—sebuah praktik yang kini disebut "vibe coding." Dalam satu minggu setelah penerapan, server mereka disusupi. Pengembang yang membagikan insiden ini dapat segera menebak vektor serangan karena kerentanannya dapat diprediksi. Artikel ini menguraikan apa yang salah, mengapa kode yang dihasilkan AI secara unik rentan terhadap eksploitasi keamanan, dan menyediakan daftar periksa konkret untuk mengamankan proyek yang dibantu AI sebelum mencapai produksi.

Insiden: Apa yang Terjadi

Kisah ini muncul di komunitas r/webdev Reddit pada Januari 2026, dengan cepat memperoleh lebih dari 400 upvote dan memicu diskusi intens. Seorang pengembang membagikan apa yang terjadi di perusahaan mereka ketika dua kolega merangkul "vibe coding"—praktik membangun aplikasi dengan cepat menggunakan alat pembuatan kode AI seperti ChatGPT, Claude, atau Cursor dengan tinjauan manual minimal.

Tim sangat antusias. Mereka meluncurkan produk dengan cepat. AI menangani segalanya mulai dari kueri database hingga alur otentikasi. Ketika waktu penerapan tiba, AI bahkan menyarankan nomor versi "16.0.0" untuk rilis pertama mereka—sebuah detail yang kemudian akan terasa ironis.

Satu minggu setelah penerapan, server diretas.

Pengembang yang membagikan cerita itu tidak terkejut. Melihat kode program, mereka dapat segera mengidentifikasi beberapa kerentanan keamanan yang telah diperkenalkan oleh AI. Para penyerang juga menemukannya.

Ini bukan insiden yang terisolasi. Peneliti keamanan telah memperingatkan tentang apa yang mereka sebut "kerentanan sintetis"—celah keamanan yang muncul hampir secara eksklusif dalam kode yang dihasilkan AI karena cara model bahasa dilatih dan bagaimana mereka mendekati tugas pengkodean.

Mengapa Kode yang Dihasilkan AI Rentan

Asisten pengkodean AI dilatih dengan repositori besar kode publik. Ini menciptakan beberapa titik buta keamanan:

1. Data Pelatihan Termasuk Kode yang Rentan

GitHub, Stack Overflow, dan situs web tutorial berisi jutaan baris kode yang tidak aman. Contoh yang ditulis untuk tujuan pembelajaran sering kali mengabaikan pertimbangan keamanan. Pola yang usang tetap ada dalam data pelatihan. AI belajar dari semuanya secara setara.

Ketika Anda meminta AI untuk menulis kode otentikasi, ia mungkin mereproduksi pola dari tutorial tahun 2018 yang tidak memiliki perlindungan CSRF, atau jawaban Stack Overflow yang menyimpan kata sandi dalam teks biasa demi kesederhanaan.

2. AI Mengoptimalkan untuk "Berfungsi" Bukan "Aman"

Model bahasa menghasilkan kode yang memenuhi perintah. Jika Anda meminta endpoint login, AI akan membuat sesuatu yang membuat pengguna masuk. Apakah implementasi tersebut tahan terhadap injeksi SQL, mengenkripsi kata sandi dengan benar, atau memvalidasi token sesi adalah hal sekunder dari tujuan utama.

Ini secara fundamental berbeda dari cara berpikir pengembang berpengalaman. Pengembang yang sadar keamanan bertanya "bagaimana ini bisa dieksploitasi?" di setiap langkah. Asisten AI tidak secara alami menerapkan pola pikir yang berlawanan ini.

3. Keterbatasan Jendela Konteks Mencegah Keamanan Holistik

Kerentanan keamanan sering kali muncul dari interaksi antar komponen. Pemeriksaan otentikasi mungkin ada di satu file sementara kueri database di file lain mengasumsikan otentikasi sudah terjadi. AI yang menghasilkan kode file-per-file atau fungsi-per-fungsi tidak selalu dapat mempertahankan konteks keamanan ini.

4. Pengembang Terlalu Percaya pada Output AI

Ini adalah faktor manusia. Ketika kode berasal dari AI yang tampak percaya diri dan kompeten, pengembang sering kali melewatkan tinjauan cermat yang akan mereka terapkan pada kode dari anggota tim junior. Pendekatan "vibe coding" secara eksplisit merangkul ini: hasilkan cepat, luncurkan cepat, perbaiki nanti.

Masalahnya adalah kerentanan keamanan sering kali tidak dapat "diperbaiki nanti" setelah penyerang menemukannya terlebih dahulu.

7 Celah Keamanan Paling Umum dalam API yang Dihasilkan AI

Berdasarkan analisis repositori kode yang dihasilkan AI dan audit keamanan, kerentanan ini paling sering muncul:

1. Validasi Input yang Hilang atau Lemah

Endpoint yang dihasilkan AI sering kali menerima input pengguna secara langsung tanpa sanitasi:

// AI-generated: Vulnerable to injection

app.post('/search', (req, res) => {

const query = req.body.searchTerm;

db.query(`SELECT * FROM products WHERE name LIKE '%${query}%'`);

});

Perbaikan memerlukan kueri berparameter, batasan panjang input, dan validasi karakter—langkah-langkah yang sering diabaikan AI.

2. Alur Otentikasi yang Rusak

- Token disimpan di localStorage alih-alih cookie httpOnly

- Kadaluarsa token yang hilang

- ID sesi yang lemah atau dapat diprediksi

- Tidak ada pembatasan tingkat pada upaya login

- Token reset kata sandi yang tidak kedaluwarsa

3. Paparan Data Berlebihan

AI cenderung mengembalikan objek database lengkap daripada memilih bidang tertentu:

// AI-generated: Returns sensitive fields

app.get('/user/:id', (req, res) => {

const user = await User.findById(req.params.id);

res.json(user); // Includes passwordHash, internalNotes, etc.

});

4. Pemeriksaan Otorisasi yang Hilang

AI membuat endpoint yang berfungsi tetapi lupa memverifikasi bahwa pengguna yang meminta memiliki izin:

// AI-generated: No ownership verification

app.delete('/posts/:id', async (req, res) => {

await Post.deleteOne({ _id: req.params.id });

res.json({ success: true });

});

// Pengguna terotentikasi mana pun dapat menghapus postingan apa pun

5. Dependensi yang Tidak Aman

AI sering menyarankan paket populer tanpa memeriksa kerentanan yang diketahui:

// AI suggests outdated package with CVEs

const jwt = require('jsonwebtoken'); // Version not specified

Tanpa pinning versi eksplisit dan pemindaian kerentanan, proyek mewarisi utang keamanan sejak hari pertama.

6. Rahasia dan Kredensial yang Ditempelkan dalam Kode

Ini seringkali muncul secara mengejutkan dalam kode yang dihasilkan AI:

// AI-generated: Secret in source code

const stripe = require('stripe')('sk_live_abc123...');

AI belajar dari tutorial dan contoh di mana kunci yang ditempelkan dalam kode umum untuk tujuan ilustrasi.

7. Header Keamanan yang Hilang

Aplikasi Express, Flask, atau Rails yang dihasilkan AI biasanya kekurangan:

- Konfigurasi CORS (atau CORS yang terlalu permisif)

- Header Content-Security-Policy

- X-Frame-Options

- Middleware pembatasan tingkat

- Pemberlakuan HTTPS

Daftar Periksa Pengujian Keamanan untuk Proyek yang Dibantu AI

Sebelum menerapkan proyek apa pun dengan kode yang dihasilkan AI, jalankan daftar periksa ini:

Otentikasi & Otorisasi

- [ ] Semua endpoint memerlukan otentikasi jika sesuai

- [ ] Pemeriksaan otorisasi memverifikasi pengguna memiliki/dapat mengakses sumber daya yang diminta

- [ ] Kata sandi di-hash dengan bcrypt, Argon2, atau sejenisnya (faktor biaya ≥10)

- [ ] Token sesi bersifat acak secara kriptografis dan kedaluwarsa

- [ ] Upaya login yang gagal dibatasi tingkatnya

- [ ] Token reset kata sandi bersifat sekali pakai dan berbatas waktu

- [ ] JWT menyertakan kedaluwarsa dan divalidasi di sisi server

Validasi Input

- [ ] Semua input pengguna divalidasi untuk tipe, panjang, dan format

- [ ] Kueri database menggunakan pernyataan berparameter

- [ ] Unggahan file memvalidasi tipe, ukuran, dan memindai malware

- [ ] URL dan pengalihan divalidasi terhadap daftar izin

- [ ] Parser JSON/XML memiliki batas ukuran yang dikonfigurasi

Perlindungan Data

- [ ] Respons API hanya mengembalikan bidang yang diperlukan

- [ ] Data sensitif dienkripsi saat tidak aktif

- [ ] Kredensial database menggunakan variabel lingkungan, bukan kode

- [ ] Rahasia disimpan dalam sistem manajemen rahasia yang tepat

- [ ] Log tidak berisi kata sandi, token, atau PII

Keamanan Transport

- [ ] HTTPS diberlakukan dalam produksi

- [ ] Header HSTS dikonfigurasi

- [ ] TLS 1.2+ diperlukan

- [ ] Cookie aman memiliki flag Secure dan HttpOnly

Keamanan Khusus API

- [ ] Pembatasan tingkat mencegah penyalahgunaan

- [ ] CORS dikonfigurasi untuk asal tertentu, bukan

* - [ ] Versi API memungkinkan penghentian endpoint yang tidak aman

- [ ] Pesan kesalahan tidak membocorkan detail internal

- [ ] GraphQL memiliki batasan kedalaman/kompleksitas kueri

Dependensi

- [ ] Semua paket memiliki pin versi spesifik

- [ ]

npm audit/pip check/ atau yang serupa tidak menunjukkan kerentanan kritis - [ ] Pembaruan dependensi otomatis dikonfigurasi

- [ ] Tidak ada paket yang ditinggalkan atau tidak terawat

Cara Menguji Keamanan API Anda Sebelum Penerapan

Tinjauan manual tidak cukup. Anda membutuhkan pengujian sistematis yang menangkap kerentanan yang diperkenalkan AI dan terlewatkan oleh tinjauan Anda.

Langkah 1: Pemindaian Keamanan Otomatis

Gunakan alat yang dirancang untuk menemukan kerentanan umum:

# Untuk proyek Node.js

npm audit --audit-level=high

# Untuk proyek Python

pip-audit

# Untuk image kontainer

trivy image your-app:latest

Langkah 2: Pengujian Keamanan API

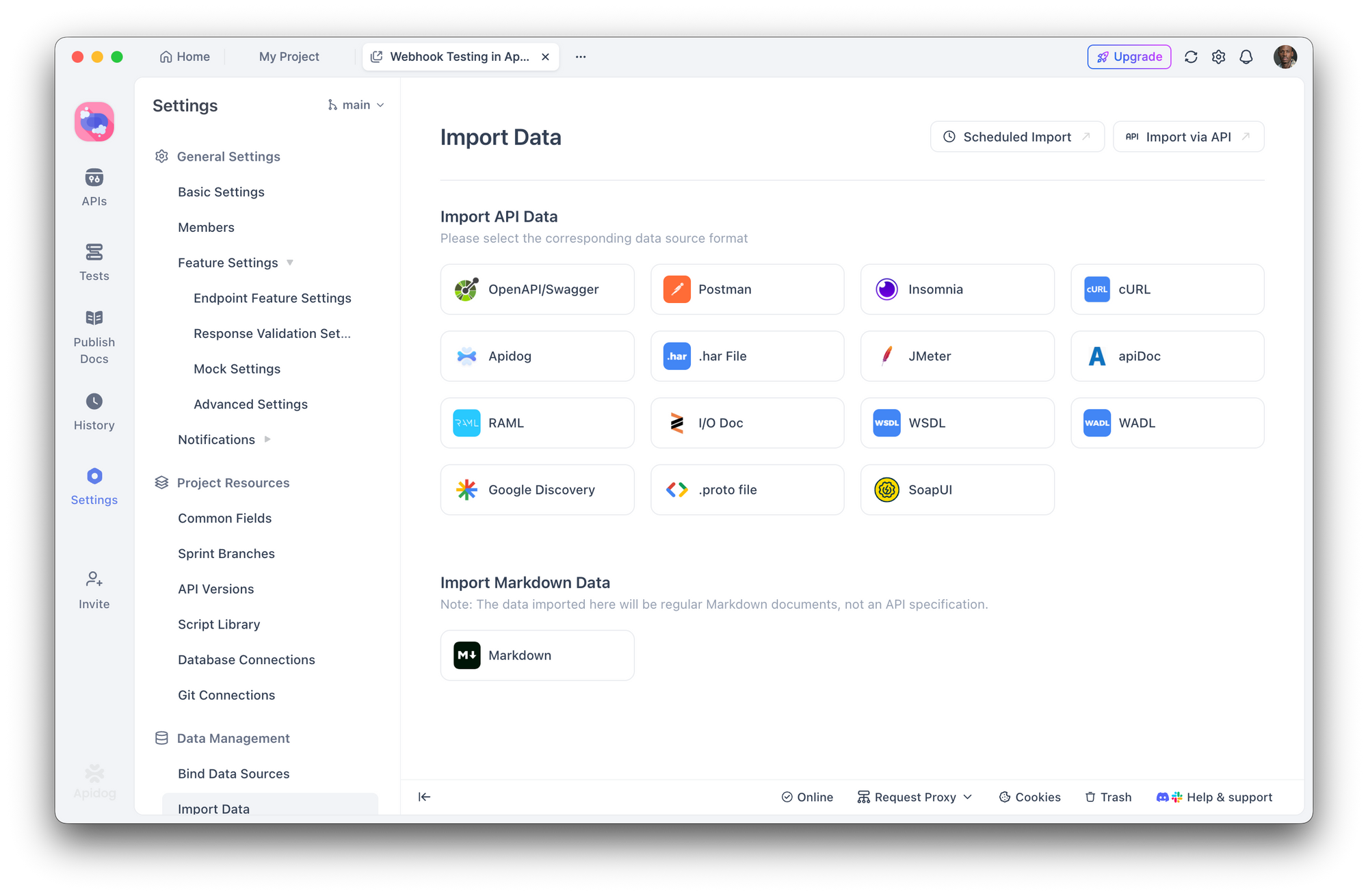

Di sinilah Apidog menjadi esensial. Alih-alih menguji setiap endpoint secara manual, Anda dapat:

- Impor spesifikasi API Anda (OpenAPI/Swagger) atau biarkan Apidog menemukan endpoint

2. Buat skenario pengujian keamanan yang memeriksa:

- Otentikasi yang hilang mengembalikan 401

- Pengguna yang salah mengakses sumber daya mengembalikan 403

- Input tidak valid mengembalikan 400 dengan pesan kesalahan yang aman

- Upaya injeksi SQL diblokir

- Jalankan rangkaian pengujian otomatis sebelum setiap penerapan

- Integrasikan dengan CI/CD untuk menangkap regresi

Dengan pembuat pengujian visual Apidog, Anda tidak perlu menulis pengujian keamanan dari awal. Definisikan pernyataan seperti "respons tidak boleh mengandung 'kata sandi'" atau "permintaan tanpa token otentikasi harus mengembalikan 401" dan jalankan di seluruh permukaan API Anda.

Langkah 3: Simulasi Pengujian Penetrasi

Uji API Anda seperti yang akan dilakukan penyerang:

- Enumerasi endpoint - Apakah ada rute tersembunyi atau tidak terdokumentasi?

- Uji bypass otentikasi - Bisakah Anda mengakses rute yang dilindungi tanpa token yang valid?

- Coba serangan injeksi - SQL, NoSQL, injeksi perintah pada semua bidang input

- Periksa IDOR - Bisakah pengguna A mengakses data pengguna B dengan mengubah ID?

- Penyalahgunaan pembatasan tingkat - Apa yang terjadi dengan 1000 permintaan per detik?

Skenario pengujian Apidog memungkinkan Anda mensimulasikan serangan ini secara sistematis, menyimpan hasil untuk perbandingan di seluruh penerapan.

Langkah 4: Audit Header Keamanan

Periksa header respons Anda:

curl -I https://your-api.com/endpoint

Cari:

Strict-Transport-SecurityX-Content-Type-Options: nosniffX-Frame-Options: DENYContent-Security-Policy

Membangun Alur Kerja Berbasis Keamanan dengan Alat AI

Asisten pengkodean AI tidak akan hilang—mereka semakin kuat. Solusinya bukan menghindari mereka tetapi membangun keamanan ke dalam alur kerja Anda.

Rekayasa Prompt untuk Keamanan

Saat menggunakan AI untuk menghasilkan kode, mintalah pertimbangan keamanan secara eksplisit:

Alih-alih:

"Buat endpoint pendaftaran pengguna"

Tanyakan:

"Buat endpoint pendaftaran pengguna dengan validasi input, hashing kata sandi menggunakan bcrypt dengan faktor biaya 12, perlindungan terhadap serangan waktu, pembatasan tingkat, dan penanganan kesalahan yang tepat yang tidak membocorkan informasi apakah email ada"

Tahap Tinjauan Wajib

Tetapkan alur kerja di mana kode yang dihasilkan AI harus melewati:

- Tinjauan manusia - Apakah kode ini melakukan apa yang kita inginkan?

- Linting otomatis - ESLint, Pylint dengan plugin keamanan

- Pemindaian keamanan - Snyk, npm audit, pemeriksaan dependensi OWASP

- Pengujian API - Rangkaian pengujian Apidog memvalidasi persyaratan keamanan

- Penerapan staging - Jalankan pengujian integrasi di lingkungan yang realistis

Perlakukan Kode AI Seperti Input yang Tidak Tepercaya

Ini adalah perubahan pola pikir kunci. Kode dari AI harus diperlakukan dengan skeptisisme yang sama seperti kode dari kontributor yang tidak dikenal. Akankah Anda menerapkan kode dari permintaan pull acak tanpa tinjauan? Terapkan standar yang sama untuk kode yang dihasilkan AI.

Kesimpulan

Peretasan server yang terjadi satu minggu setelah penerapan tidak disebabkan oleh penyerang canggih atau eksploitasi zero-day. Itu disebabkan oleh kerentanan umum yang secara rutin diperkenalkan oleh alat AI dan yang secara rutin dilewatkan oleh praktik "vibe coding".

Pembuatan kode AI sangat kuat. Ini mempercepat pengembangan dan membuat tugas-tugas kompleks dapat diakses. Namun tanpa pengujian keamanan yang sistematis, kecepatan itu menjadi kerentanan.

Alat seperti Apidog menjadikan pengujian keamanan praktis dengan memungkinkan Anda menentukan dan mengotomatiskan persyaratan keamanan di seluruh permukaan API Anda. Tujuannya bukan untuk memperlambat pengembangan yang dibantu AI—tetapi untuk membangun lapisan verifikasi yang diperlukan oleh kode yang dihasilkan AI.

Server Anda tidak peduli apakah kode ditulis oleh manusia atau AI. Ia hanya peduli apakah kode itu aman.