Le **XBai o4** de MetaStone AI, lancé le 1er août 2025, est un modèle de langage open-source de quatrième génération qui surpasse **OpenAI-o3-mini** dans les tâches de raisonnement complexes. Ce modèle développé en Chine introduit des techniques d'entraînement avancées et une inférence optimisée, ce qui en fait un tournant dans le développement de l'IA. Disponible sur GitHub et Hugging Face, XBai o4 favorise la transparence et la collaboration.

L'essor de XBai o4 : un aperçu technique

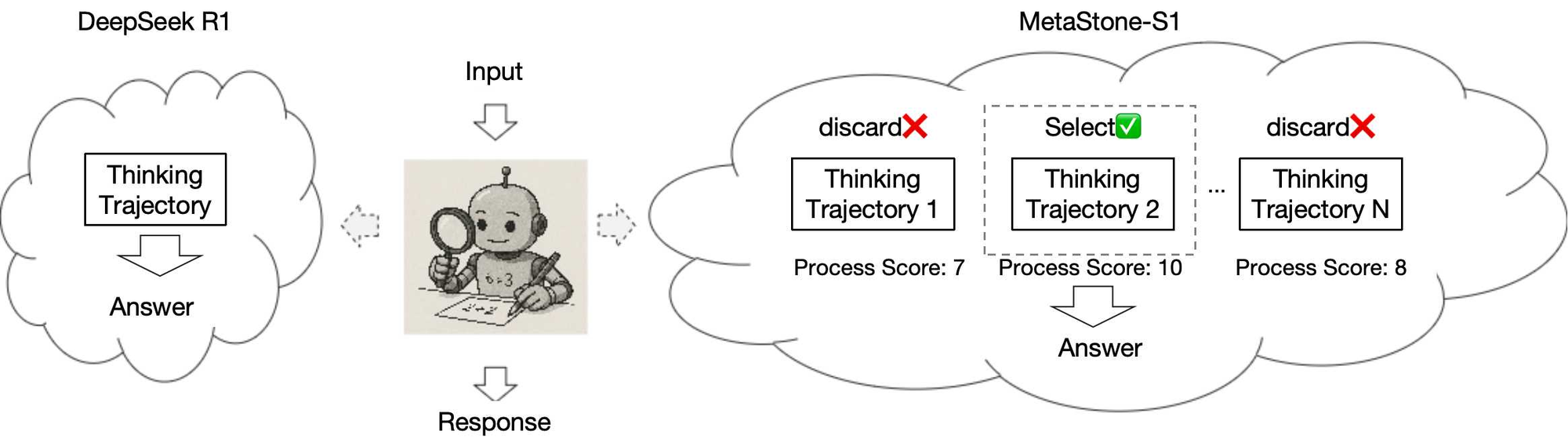

XBai o4, développé par MetaStone AI, représente un bond en avant dans la technologie de l'IA open-source. Contrairement aux modèles propriétaires, le code et les poids de XBai o4 sont disponibles publiquement sur GitHub et Hugging Face, favorisant la transparence et la collaboration. Plus précisément, le modèle utilise une nouvelle approche d'entraînement appelée la « forme générative réflexive », qui intègre l'**apprentissage par renforcement Long-CoT** et l'**apprentissage par récompense de processus**. Par conséquent, ce cadre unifié permet à XBai o4 d'exceller dans le raisonnement profond et la sélection de trajectoires de raisonnement de haute qualité, le distinguant de ses prédécesseurs et concurrents comme OpenAI-o3-mini.

De plus, XBai o4 optimise l'efficacité de l'inférence en partageant le réseau dorsal entre ses modèles de récompense de politique (PRM) et ses modèles de politique. Ce choix architectural réduit le coût d'inférence des PRM de 99 %, ce qui se traduit par des temps de réponse plus rapides et des sorties de meilleure qualité. Par exemple, les paramètres du modèle sont enregistrés dans deux fichiers distincts : `model.safetensors` pour le point de contrôle du modèle de politique et un fichier séparé pour la tête SPRM, comme détaillé dans le référentiel Hugging Face.

Comprendre la forme générative réflexive

La pierre angulaire du succès de XBai o4 réside dans sa forme générative réflexive. Ce paradigme d'entraînement combine deux techniques avancées :

- **Apprentissage par renforcement Long-CoT** : Cette méthode étend l'incitation Chain-of-Thought (CoT) en incorporant l'apprentissage par renforcement pour affiner le processus de raisonnement du modèle sur des contextes étendus. En conséquence, XBai o4 peut aborder des problèmes complexes en plusieurs étapes avec une plus grande précision.

- **Apprentissage par récompense de processus** : Cette approche récompense le modèle pour la sélection de trajectoires de raisonnement de haute qualité pendant l'entraînement. Par conséquent, XBai o4 apprend à prioriser les chemins de raisonnement optimaux, améliorant ses performances dans les tâches nécessitant une prise de décision nuancée.

En intégrant ces méthodes, XBai o4 atteint un équilibre entre le raisonnement profond et l'efficacité computationnelle. De plus, le réseau dorsal partagé minimise la redondance, permettant au modèle de traiter les entrées plus rapidement sans sacrifier la qualité. Cette innovation est particulièrement significative par rapport à OpenAI-o3-mini, qui, bien qu'efficace, ne possède pas le même niveau d'accessibilité open-source et de capacités de raisonnement optimisées.

Comparaison de XBai o4 à OpenAI-o3-mini

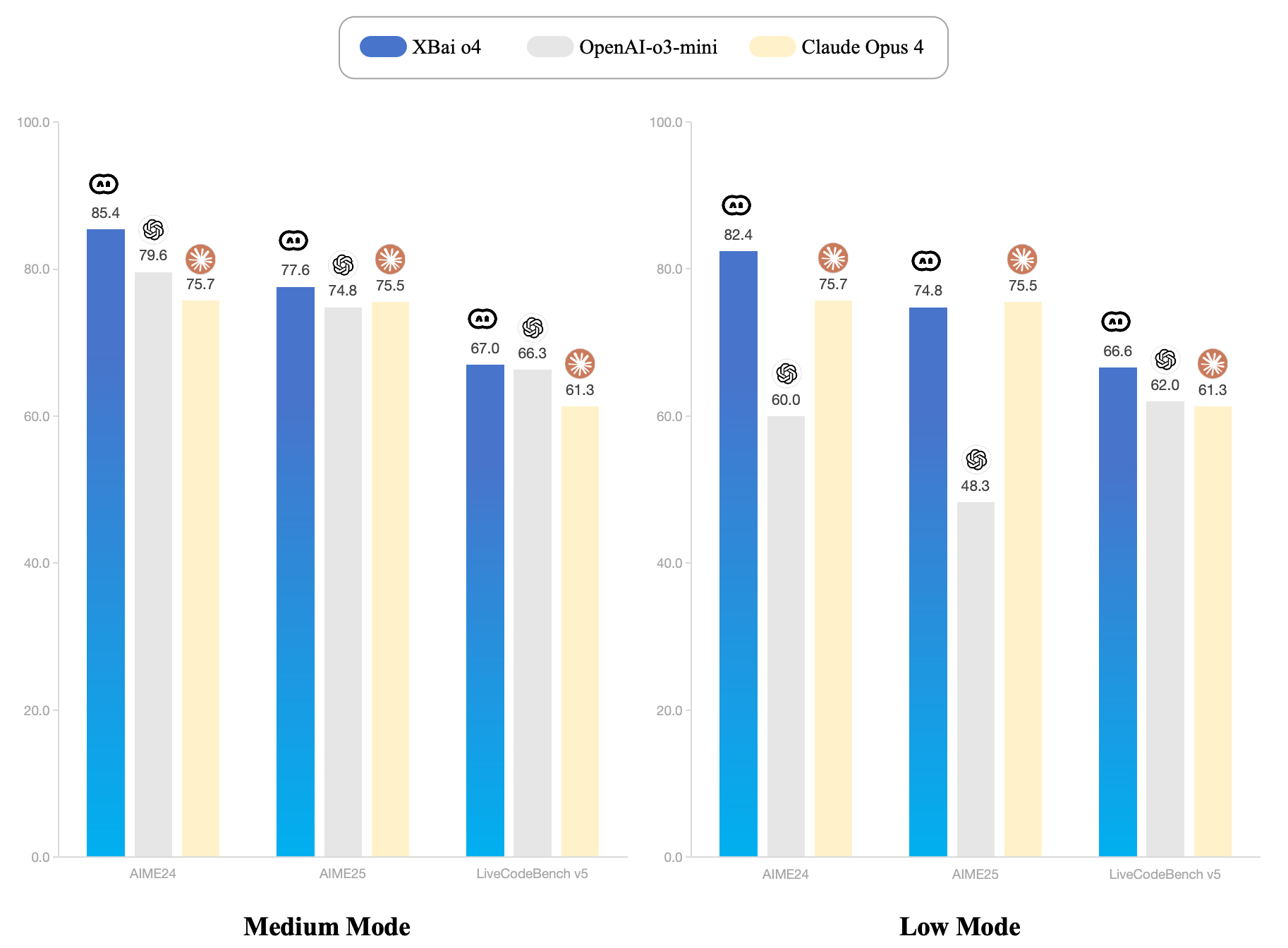

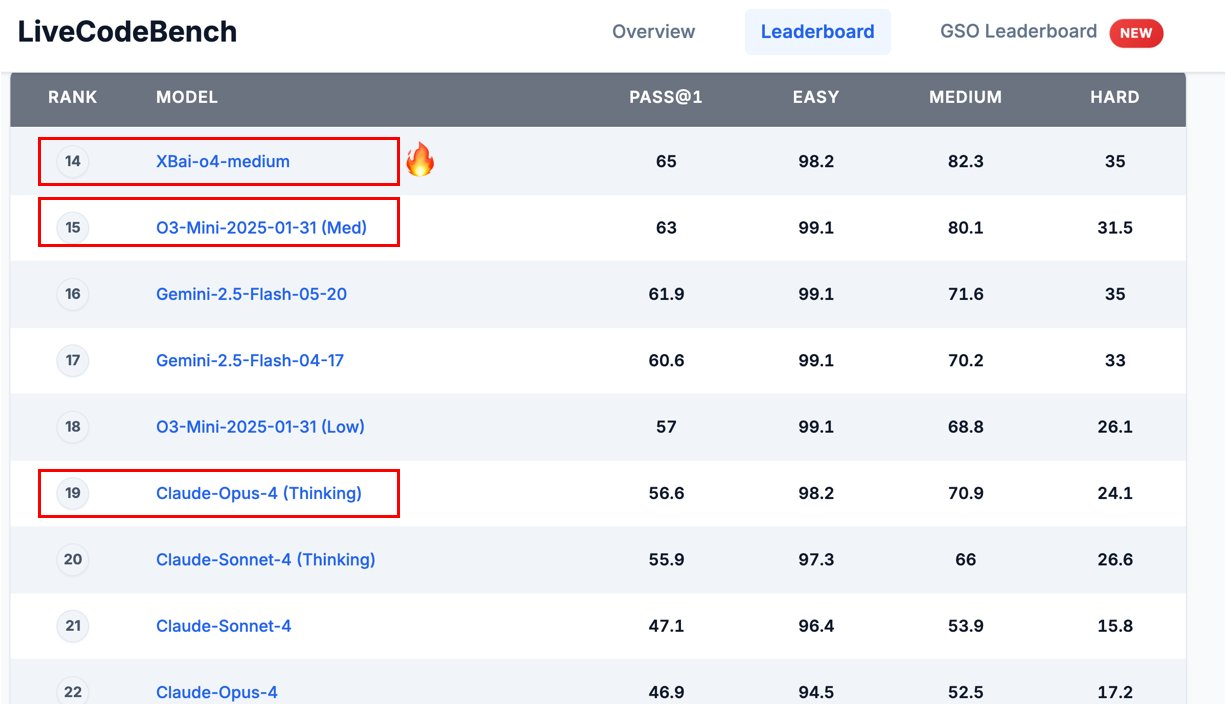

OpenAI-o3-mini, une version compacte de la série o3 plus large d'OpenAI, est conçu pour l'efficacité dans les tâches de complexité moyenne. Cependant, XBai o4 prétend « surpasser complètement » OpenAI-o3-mini en mode Moyen, comme indiqué dans l'annonce GitHub de MetaStone AI.

Pour comprendre cette affirmation, examinons les métriques de performance clés :

- Raisonnement complexe : La forme générative réflexive de XBai o4 lui permet de gérer des tâches de raisonnement complexes, telles que les benchmarks mathématiques (par exemple, AIME24), avec une précision supérieure. En revanche, OpenAI-o3-mini, bien que compétent, a du mal avec les tâches nécessitant des chaînes de raisonnement étendues.

- Vitesse d'inférence : En réduisant les coûts d'inférence des PRM de 99 %, XBai o4 offre des réponses plus rapides, ce qui le rend idéal pour les applications en temps réel. OpenAI-o3-mini, bien qu'optimisé pour la vitesse, n'atteint pas ce niveau d'efficacité dans les contextes open-source.

- Accessibilité open-source : La disponibilité de XBai o4 sur des plateformes comme GitHub et Hugging Face permet aux développeurs de personnaliser et de déployer le modèle librement. Inversement, OpenAI-o3-mini reste propriétaire, limitant son adaptabilité pour la recherche et le développement.

Par exemple, le pipeline de test de MetaStone AI pour les benchmarks mathématiques, tel que décrit dans leur référentiel GitHub, démontre la capacité de XBai o4 à traiter des tâches comme AIME24 avec une grande précision. Le pipeline utilise des scripts comme `score_model_queue.py` et `policy_model_queue.py` pour évaluer les performances, en tirant parti d'outils comme XFORMERS pour des mécanismes d'attention optimisés.

Implémentation technique de XBai o4

Pour déployer XBai o4, les développeurs ont besoin d'une configuration robuste, comme décrit dans le référentiel GitHub. Voici un guide de configuration simplifié basé sur les instructions fournies :

Configuration de l'environnement :

- Créez un environnement Conda avec Python 3.10 : `conda create -n xbai_o4 python==3.10`.

- Activez l'environnement : `conda activate xbai_o4`.

- Installez les dépendances : `pip install -e verl`, `pip install -r requirements.txt`, et `pip install flash_attn==2.7.4.post1`.

Entraînement et évaluation :

- Démarrez Ray pour le calcul distribué : `bash ./verl/examples/ray/run_worker_n.sh`.

- Lancez l'entraînement multi-nœuds : `bash ./scripts/run_multi_node.sh`.

- Exécutez le pipeline de test pour les benchmarks mathématiques : `python test/inference.py --task 'aime24' --input_file data/aime24.jsonl --output_file path/to/result`.

Intégration API :

- Lancez les API du modèle de politique pour une évaluation rapide : `CUDA_VISIBLE_DEVICES=0 python test/policy_model_queue.py --model_path path/to/huggingface/model --ip '0.0.0.0' --port '8000'`.

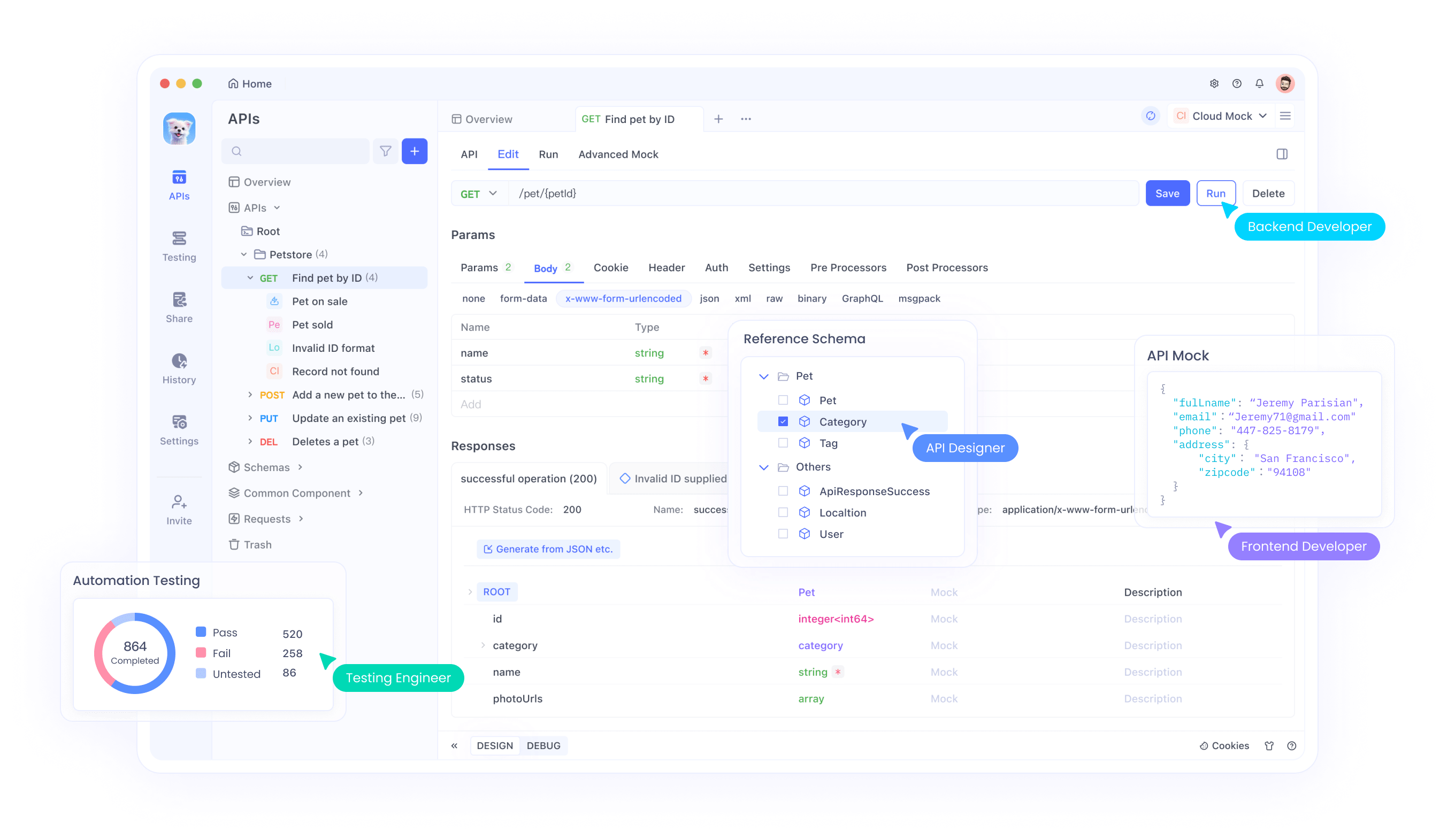

- Utilisez des outils comme **Apidog** pour tester et gérer ces API, assurant une intégration transparente dans des systèmes plus grands.

Cette configuration met en évidence la flexibilité de XBai o4 pour les environnements de recherche et de production. De plus, la compatibilité du modèle avec des outils comme Apidog simplifie les tests d'API, permettant aux développeurs de valider efficacement les points d'accès.

Performances et évaluation des benchmarks

Les notes de publication de MetaStone AI soulignent les performances supérieures de XBai o4 sur des benchmarks mathématiques comme AIME24. Le pipeline de test, détaillé dans le référentiel GitHub, utilise une combinaison d'API de modèle de politique et de score pour évaluer les capacités de raisonnement du modèle. Par exemple, le script `inference.py` traite des fichiers d'entrée comme `aime24.jsonl` et génère des résultats avec 16 échantillons, en tirant parti de plusieurs points d'accès API pour la vitesse.

De plus, les performances du modèle sont améliorées par le backend d'attention XFORMERS, qui optimise l'utilisation de la mémoire et la vitesse de calcul. Cela est particulièrement évident dans la configuration `VLLM_ATTENTION_BACKEND=XFORMERS`, qui assure un traitement efficace sur les systèmes équipés de GPU.

En revanche, OpenAI-o3-mini, bien qu'efficace pour les tâches générales, n'offre pas le même niveau de transparence dans son processus d'évaluation. La nature open-source de XBai o4 permet aux chercheurs d'examiner et de reproduire ses benchmarks, favorisant ainsi la confiance dans ses affirmations de performance.

Réception de la communauté et scepticisme

La communauté de l'IA a réagi avec un mélange d'enthousiasme et de scepticisme à la sortie de XBai o4. Un message Reddit sur r/accelerate, par exemple, souligne le potentiel du modèle mais soulève des préoccupations concernant le surajustement des benchmarks, en référence à des problèmes passés avec des modèles comme Llama-4. Certains utilisateurs remettent en question la crédibilité de MetaStone AI, un acteur relativement nouveau par rapport à des organisations établies comme Qwen. Néanmoins, la disponibilité open-source des poids et du code de XBai o4 encourage la vérification indépendante, ce qui pourrait dissiper les doutes avec le temps.

Par exemple, un utilisateur sur Threads a signalé avoir testé XBai o4 sur un M4 Max avec le backend `mlx-lm`, notant qu'il avait réussi le « test d'ambiance 1+1 » pour les tâches de raisonnement. Cependant, des défis comme le rendu de visualisations complexes (par exemple, la cinématique inverse) suggèrent des domaines d'amélioration.

Intégration avec Apidog pour les tests d'API

Pour les développeurs qui intègrent XBai o4 dans leurs flux de travail, des outils comme Apidog sont inestimables. Apidog simplifie le processus de test et de gestion des API, telles que celles utilisées dans le pipeline d'évaluation de XBai o4. En fournissant une interface conviviale pour l'envoi de requêtes à des points d'accès comme `http://ip:port/score`, Apidog garantit que les développeurs peuvent valider les performances du modèle sans configurations manuelles complexes. De plus, son téléchargement gratuit le rend accessible aux chercheurs et aux amateurs, s'alignant sur l'éthique open-source de XBai o4.

Pour illustrer, considérons un scénario où un développeur utilise Apidog pour tester l'API du modèle de politique de XBai o4. En configurant l'URL du point d'accès et les paramètres (par exemple, `--model_path` et `--port`), Apidog peut envoyer des requêtes de test et analyser les réponses, simplifiant ainsi le processus de débogage. Cette intégration est particulièrement utile pour la mise à l'échelle des évaluations sur plusieurs nœuds, comme recommandé dans les instructions de configuration GitHub.

Implications futures pour l'IA open-source

La sortie de XBai o4 souligne l'importance croissante de l'IA open-source dans la démocratisation de l'accès aux technologies avancées. Contrairement aux modèles propriétaires comme OpenAI-o3-mini, XBai o4 permet aux développeurs de personnaliser et d'étendre le modèle pour des cas d'utilisation spécifiques. Par exemple, sa forme générative réflexive pourrait être adaptée à des domaines comme la recherche scientifique, la modélisation financière ou la génération de code automatisée.

De plus, les améliorations d'efficacité du modèle ouvrent la voie au déploiement de grands modèles de langage dans des environnements aux ressources limitées. En réduisant les coûts d'inférence, XBai o4 rend possible l'exécution d'une IA sophistiquée sur du matériel grand public, élargissant ainsi ses applications potentielles.

Cependant, des défis subsistent. Le scepticisme de la communauté de l'IA souligne la nécessité d'un benchmarking rigoureux et transparent pour valider les affirmations de performance. De plus, bien que XBai o4 excelle dans le raisonnement, ses capacités de visualisation (par exemple, la cinématique inverse) nécessitent un raffinement supplémentaire, comme noté dans les retours de la communauté.

Conclusion : la place de XBai o4 dans l'écosystème de l'IA

En résumé, XBai o4 représente une avancée significative dans l'IA open-source, offrant des capacités de raisonnement et une efficacité supérieures par rapport à OpenAI-o3-mini. Sa forme générative réflexive, combinant l'apprentissage par renforcement Long-CoT et l'apprentissage par récompense de processus, établit une nouvelle norme pour la résolution de problèmes complexes. De plus, sa disponibilité open-source sur GitHub et Hugging Face favorise la collaboration et l'innovation, en faisant une ressource précieuse pour les développeurs et les chercheurs.

Pour ceux qui souhaitent explorer les capacités de XBai o4, des outils comme **Apidog** offrent un moyen efficace de tester et d'intégrer ses API, assurant un déploiement transparent dans des applications du monde réel. Alors que le paysage de l'IA continue d'évoluer, XBai o4 témoigne de la puissance de l'innovation open-source, défiant les modèles propriétaires et repoussant les limites de ce que l'IA peut accomplir.