Comprendre exactement quels points de terminaison d'API sont disponibles pour Codex d'OpenAI est devenu de plus en plus complexe à mesure que la plateforme a considérablement évolué depuis son lancement en 2021. Les développeurs se demandent souvent : "Quels points de terminaison d'API puis-je réellement utiliser avec CodeX ?" La réponse nécessite de distinguer les systèmes hérités, les implémentations actuelles et les capacités émergentes au sein de l'écosystème en évolution rapide d'OpenAI.

Pourquoi les points de terminaison de l'API Codex sont importants en 2025

Codex évolue au-delà de ses racines de 2021 en tant qu'outil de complétion de code pour devenir un agent à part entière pour l'ingénierie logicielle. Il gère désormais des tâches complexes telles que la résolution de dépendances, l'exécution de tests et le débogage d'interface utilisateur avec des entrées multimodales. Les développeurs tirent parti de ses points de terminaison d'API pour intégrer ces capacités dans les pipelines CI/CD, les bots personnalisés ou les applications d'entreprise. Comprendre ces points de terminaison débloque une automatisation évolutive, réduisant les temps de tâche jusqu'à 90 % dans les environnements cloud.

Évolution de l'API CodeX : Des complétions aux points de terminaison agentiques

Initialement, Codex s'appuyait sur le point de terminaison /v1/completions avec des modèles comme davinci-codex. D'ici 2025, OpenAI a pivoté vers l'API Chat Completions, intégrant GPT-5-Codex pour un raisonnement avancé. Les points de terminaison bêta pour les tâches cloud et les revues de code étendent davantage les fonctionnalités, prenant en charge l'exécution parallèle et l'intégration GitHub.

Cette transition répond aux limitations antérieures, telles que la perte de contexte et les contraintes de concurrence. Par conséquent, les développeurs accèdent désormais à Codex via un cadre d'API unifié, avec des fonctionnalités bêta disponibles via les plans Pro. Apidog complète cela en permettant des tests rapides des points de terminaison, assurant une adoption en douceur.

Points de terminaison d'API principaux pour Codex en 2025

OpenAI structure l'accès à Codex autour de quelques points de terminaison clés, principalement via l'API standard et les extensions bêta. Ci-dessous, nous décrivons chacun d'eux, y compris les méthodes HTTP, les paramètres et des exemples de code.

1. Point de terminaison Chat Completions : Alimenter la génération de code

Le point de terminaison /v1/chat/completions (POST) sert d'interface principale pour GPT-5-Codex, gérant la génération de code, le débogage et les explications.

Paramètres Clés :

- model : Utilisez "gpt-5-codex" pour les tâches de codage ; "codex-mini-latest" pour les requêtes plus légères.

- messages : Tableau de paires rôle-contenu, par exemple, [{"role": "system", "content": "Vous êtes un expert Python."}, {"role": "user", "content": "Écrivez une API REST Django pour l'authentification des utilisateurs."}].

- max_tokens : Défini à 4096 pour des sorties détaillées.

- temperature : 0.2 pour un code précis ; 0.7 pour des explorations créatives.

- tools : Prend en charge l'appel de fonctions pour les intégrations externes.

Authentification : Jeton Bearer via Authorization: Bearer $OPENAI_API_KEY.

Exemple en Python :

python

import openai

client = openai.OpenAI(api_key="sk-your-key")

response = client.chat.completions.create(

model="gpt-5-codex",

messages=[

{"role": "system", "content": "Follow Python PEP 8 standards."},

{"role": "user", "content": "Generate a REST API endpoint for task management."}

],

max_tokens=2000,

temperature=0.3

)

print(response.choices[0].message.content)Ce point de terminaison excelle dans les flux de travail itératifs, en maintenant le contexte à travers les messages. Il résout 74 % des tâches SWE-bench de manière autonome, surpassant les modèles généraux. Cependant, optimisez les invites pour éviter le gonflement des jetons, en utilisant Apidog pour surveiller l'utilisation.

2. Point de terminaison de délégation de tâches cloud : Exécution autonome

Le point de terminaison bêta /v1/codex/cloud/tasks (POST) délègue les tâches à des conteneurs cloud sandboxés, idéal pour le traitement parallèle.

Paramètres Clés :

- task_prompt : Instructions comme "Refactoriser ce module pour TypeScript."

- environment : JSON définissant l'environnement d'exécution, par exemple, {"runtime": "node:18", "packages": ["typescript"]}.

- repository_context : URL ou branche du dépôt GitHub.

- webhook : URL pour les mises à jour de l'état des tâches.

- multimodal_inputs : Images Base64 pour les tâches d'interface utilisateur.

Exemple en Node.js :

javascript

const OpenAI = require('openai');

const openai = new OpenAI({ apiKey: process.env.OPENAI_API_KEY });

async function runTask() {

const task = await openai.beta.codex.cloud.create({

task_prompt: 'Create a React component with Jest tests.',

environment: { runtime: 'node:18', packages: ['react', 'jest'] },

repository_context: 'https://github.com/user/repo/main',

webhook: 'https://your-webhook.com'

});

console.log(`Task ID: ${task.id}`);

}Ce point de terminaison réduit les temps d'achèvement de 90 % grâce à la mise en cache. Utilisez Apidog pour simuler les réponses de webhook pour les tests.

3. Point de terminaison de révision de code : Automatiser l'analyse des PR

Le point de terminaison bêta /v1/codex/reviews (POST) analyse les PR GitHub, déclenché par des balises comme "@codex review".

Paramètres Clés :

- pull_request_url : Lien de la PR GitHub.

- focus_areas : Tableau comme ["sécurité", "bugs"].

- sandbox_config : Paramètres d'exécution, par exemple, {"network": "restricted"}.

Exemple cURL :

bash

curl https://api.openai.com/v1/codex/reviews \

-H "Authorization: Bearer $OPENAI_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"pull_request_url": "https://github.com/user/repo/pull/456",

"focus_areas": ["performance", "dependencies"],

"sandbox_config": {"tests": true}

}'Ce point de terminaison améliore la qualité du code en détectant les problèmes tôt, en s'intégrant aux pipelines CI/CD.

4. Point de terminaison de complétions hérité : Utilisation limitée pour la compatibilité ascendante

Le point de terminaison déprécié /v1/completions prend en charge codex-mini-latest pour la génération de code de base mais est programmé pour être supprimé d'ici 2026. Il utilise un modèle plus simple basé sur des invites, moins adapté aux tâches agentiques.

Paramètres Clés :

- model : "codex-mini-latest".

- prompt : Entrée de texte brut, par exemple, "Écrivez une fonction Python pour analyser les fichiers CSV."

- max_tokens : Jusqu'à 2048.

Exemple en Python :

python

import openai

client = openai.OpenAI(api_key="sk-your-key")

response = client.completions.create(

model="codex-mini-latest",

prompt="Write a Python function to parse CSV files.",

max_tokens=500

)

print(response.choices[0].text)Migrez vers les complétions de chat pour une meilleure gestion du contexte et de meilleures performances, car les points de terminaison hérités manquent de support multimodal et de raisonnement agentique.

Meilleures pratiques pour l'utilisation des points de terminaison de l'API CodeX

Maximisez l'efficacité des points de terminaison avec ces stratégies :

- Élaborez des invites précises : Spécifiez les langages et les contraintes, par exemple, "Utilisez Go avec la gestion des erreurs."

- Optimisez les jetons : Regroupez les requêtes et surveillez-les via l'analyse Apidog.

- Gérez les erreurs : Vérifiez `finish_reason` pour les sorties incomplètes et réessayez.

- Sécurisez les appels : Utilisez des environnements sandboxés et nettoyez les entrées.

- Itérez le contexte : Tirez parti de l'historique des conversations pour les flux de travail agentiques.

Ces pratiques réduisent les itérations de 50 %, augmentant la productivité.

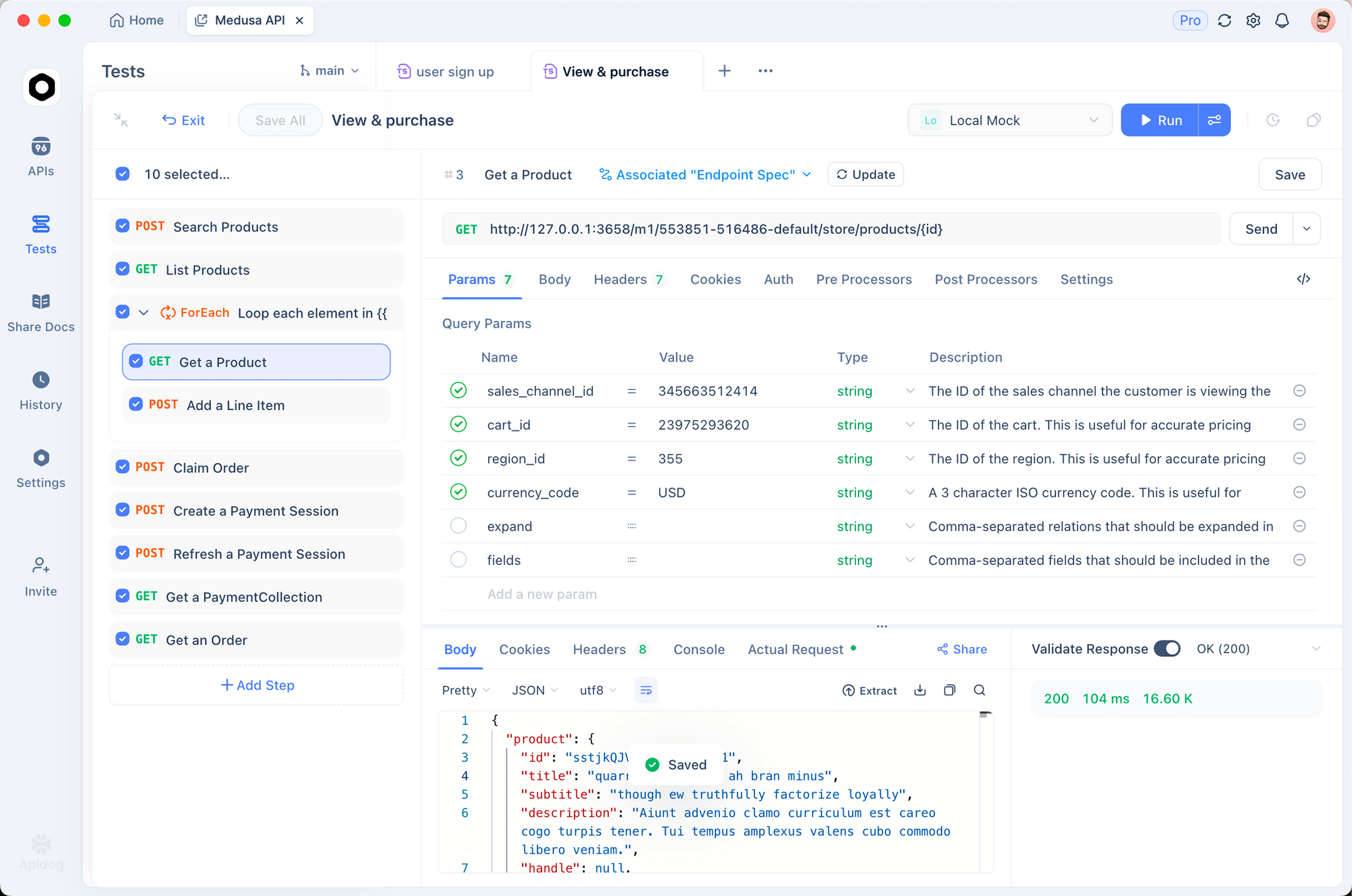

Flux de travail de développement d'API avec l'intégration Apidog

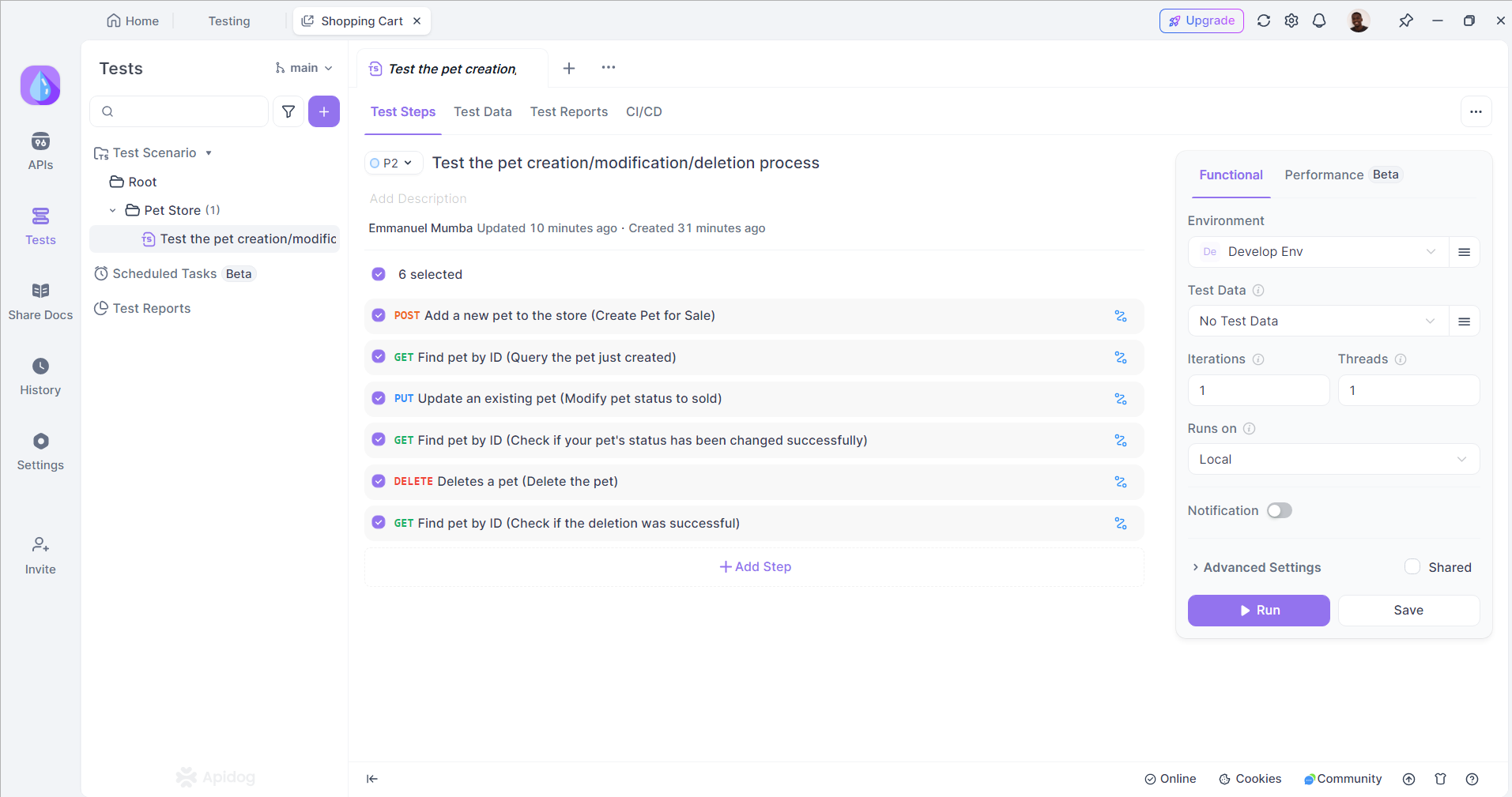

Bien que CodeX ait évolué au-delà des points de terminaison d'API traditionnels, les développeurs travaillant sur des projets axés sur les API bénéficient considérablement de la combinaison de l'assistance de CodeX avec des outils de développement d'API complets comme Apidog. Cette intégration crée des flux de travail puissants qui améliorent à la fois la précision de la génération de code et la fiabilité de l'API.

Apidog offre des fonctionnalités essentielles de test, de documentation et de collaboration d'API qui complètent parfaitement les capacités de génération de code de CodeX. Lorsque CodeX génère du code d'implémentation d'API, Apidog peut immédiatement valider, tester et documenter les points de terminaison résultants via des processus automatisés.

Utilisation d'Apidog dans votre flux de travail de développement

L'intégration d'Apidog dans votre flux de travail de développement peut améliorer votre processus de gestion d'API. Voici comment utiliser efficacement Apidog en parallèle de votre développement web :

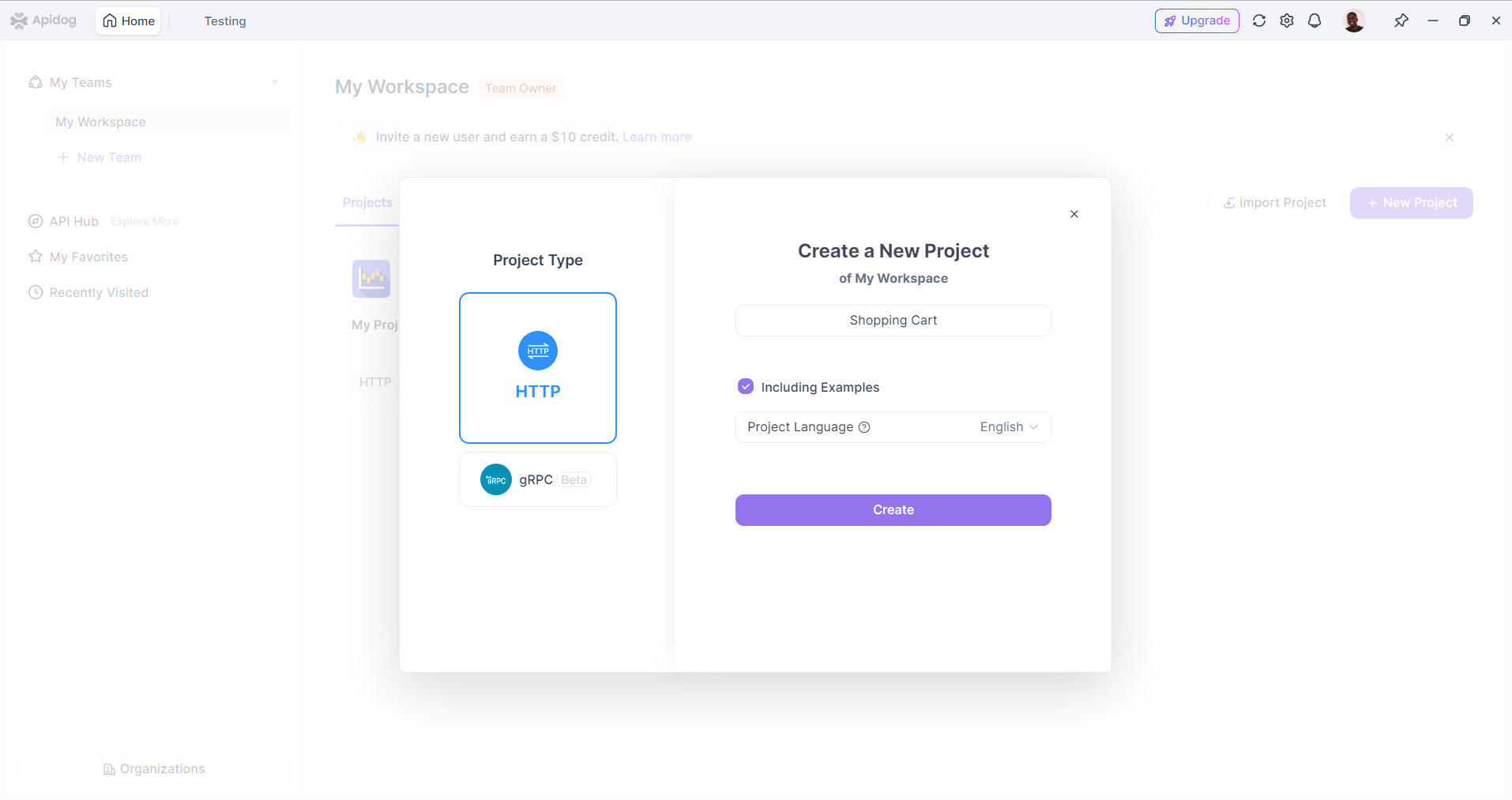

Étape 1 : Définissez vos spécifications d'API

Commencez par définir vos spécifications d'API dans Apidog. Créez un nouveau projet d'API et décrivez les points de terminaison, les paramètres de requête et les formats de réponse. Cette documentation servira de référence pour votre équipe de développement.

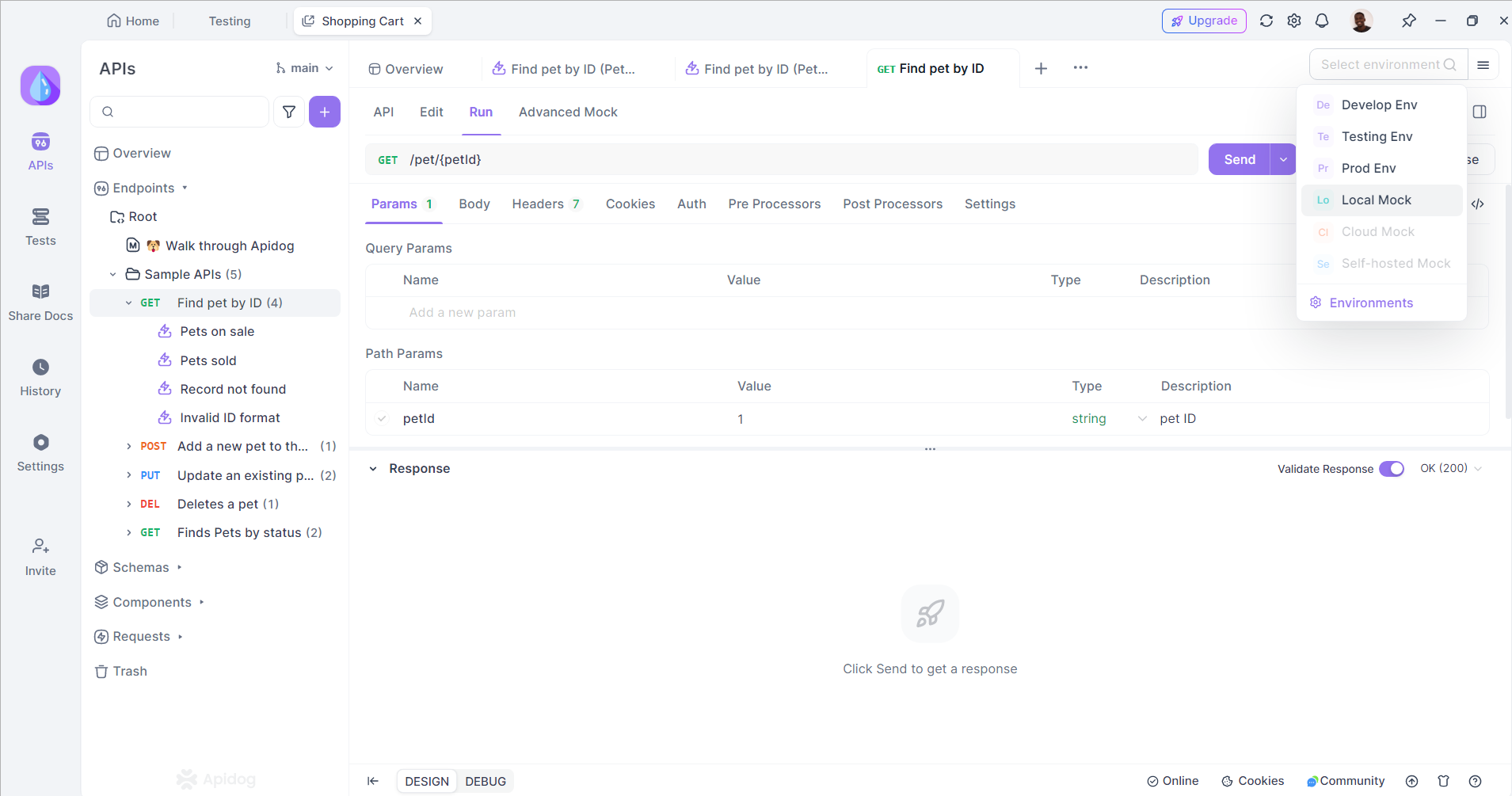

Étape 2 : Générez des réponses simulées

Utilisez Apidog pour générer des réponses simulées pour vos points de terminaison d'API. Cela vous permet de tester votre application frontend sans dépendre de l'API réelle, qui peut être en cours de développement ou indisponible. La simulation de réponses vous aide à identifier les problèmes tôt dans le processus de développement.

Étape 3 : Testez les points de terminaison d'API

Une fois votre API prête, utilisez Apidog pour tester les points de terminaison. Cela garantit qu'ils renvoient les données attendues et gèrent correctement les erreurs. Vous pouvez également utiliser les fonctionnalités de test d'Apidog pour automatiser ce processus, ce qui vous fait gagner du temps et réduit le risque d'erreur humaine.

Étape 4 : Collaborez avec votre équipe

Encouragez votre équipe à utiliser Apidog pour la collaboration. Les développeurs peuvent laisser des commentaires sur les spécifications d'API, suggérer des modifications et suivre les révisions. Cette approche collaborative favorise la communication et garantit que tout le monde est sur la même longueur d'onde.

Étape 5 : Maintenez la documentation

À mesure que votre API évolue, assurez-vous de mettre à jour la documentation dans Apidog. Cela aidera à tenir votre équipe informée des changements et à garantir que les partenaires externes ont accès aux dernières informations.

Le flux de travail intégré suit généralement ce modèle :

- La spécification en langage naturel décrit la fonctionnalité d'API souhaitée

- CodeX génère le code d'implémentation basé sur la spécification

- Apidog importe et valide automatiquement les points de terminaison d'API générés

- Les tests en temps réel garantissent que le code généré répond aux exigences fonctionnelles

- La documentation collaborative permet une compréhension et une maintenance à l'échelle de l'équipe

- La validation continue maintient la fiabilité de l'API tout au long des cycles de développement

Configuration d'entreprise et gestion d'équipe

Les implémentations CodeX d'entreprise nécessitent des couches de configuration supplémentaires qui vont au-delà des configurations de développeur individuelles. Ces configurations garantissent la conformité, la sécurité et la collaboration d'équipe tout en maintenant l'expérience d'intégration simplifiée qui caractérise les implémentations CodeX modernes.

Codex est un agent unique qui s'exécute partout où vous codez – terminal, IDE, dans le cloud, dans GitHub et sur votre téléphone, mais les environnements d'entreprise peuvent nécessiter une approbation et une configuration administratives avant que les membres de l'équipe ne puissent accéder à toutes les fonctionnalités. Ce processus de configuration garantit la conformité organisationnelle tout en maintenant la productivité du développement.

Les configurations administratives englobent généralement :

- Autorisations d'accès des utilisateurs alignées sur les rôles et responsabilités organisationnels

- Contrôles d'accès aux dépôts qui respectent les structures d'autorisations GitHub existantes

- Surveillance de la conformité pour les activités de génération et de modification de code

- Analyses d'utilisation qui fournissent des informations sur la productivité de l'équipe et l'utilisation de l'assistance IA

Les fonctionnalités axées sur l'équipe permettent un développement collaboratif avec l'assistance de l'IA tout en maintenant la responsabilité individuelle et les normes de qualité du code. Ces capacités collaboratives s'intègrent de manière transparente aux flux de travail d'équipe existants sans nécessiter d'implémentations d'API personnalisées ou de gestion des points de terminaison.

Optimisation des performances et gestion des ressources

Comprendre les caractéristiques de performance de CodeX permet une utilisation plus efficace dans différents scénarios de développement et cas d'utilisation. Contrairement aux points de terminaison d'API traditionnels avec des temps de réponse et des exigences de ressources prévisibles, les performances de CodeX varient considérablement en fonction de la complexité de la tâche, de l'environnement d'exécution et des ressources de calcul disponibles.

Le système sélectionne automatiquement les environnements d'exécution optimaux en fonction des caractéristiques de la tâche, des ressources disponibles et des exigences de performance. Les opérations simples s'exécutent généralement localement pour une réponse immédiate, tandis que les tâches d'analyse complexes tirent parti des ressources cloud pour des capacités de calcul améliorées.

Modèle d'optimisation des performances :

python

import time

import logging

def monitor_codex_performance(operation_type):

"""Monitor CodeX performance across different operations"""

start_time = time.time()

try:

if operation_type == "simple_completion":

# Local CLI execution for immediate response

result = execute_local_codex("Generate simple function")

elif operation_type == "complex_analysis":

# Cloud execution for resource-intensive tasks

result = delegate_to_cloud("Analyze entire codebase architecture")

elif operation_type == "code_review":

# GitHub integration for collaborative review

result = trigger_github_review("@codex review security issues")

duration = time.time() - start_time

logging.info(f"{operation_type} completed in {duration:.2f}s")

return result

except Exception as e:

duration = time.time() - start_time

logging.error(f"{operation_type} failed after {duration:.2f}s: {str(e)}")

raiseL'utilisation optimale de CodeX implique de comprendre ces modèles d'exécution :

- Suggestions et complétions de code simples : L'exécution locale via l'intégration CLI ou IDE offre des temps de réponse immédiats

- Refactoring et analyse complexes : Les environnements cloud offrent des ressources de calcul supérieures pour les opérations intensives

- Opérations à l'échelle du dépôt : L'intégration GitHub offre un accès complet au contexte et des capacités de coordination

- Activités de révision de code mobile : L'intégration de l'application iOS permet un travail de développement indépendant du lieu

Considérations de sécurité et meilleures pratiques

Les implémentations CodeX intègrent des mesures de sécurité complètes qui répondent aux défis uniques associés au développement assisté par l'IA. Ces fonctionnalités de sécurité fonctionnent de manière transparente au sein de l'expérience d'intégration tout en maintenant une protection robuste pour le code sensible et la propriété intellectuelle organisationnelle.

Les implémentations CodeX modernes nécessitent des mesures d'authentification renforcées par rapport aux modèles d'utilisation d'API traditionnels. Le système exige l'authentification multi-facteurs pour les comptes e-mail/mot de passe tout en recommandant fortement la configuration de la MFA pour les fournisseurs de connexion sociale afin d'assurer la sécurité des comptes.

L'architecture basée sur le cloud met en œuvre des mesures complètes de protection des données qui garantissent la confidentialité du code tout en permettant une assistance IA sophistiquée. Les environnements d'exécution sandboxés empêchent l'exposition des données entre projets tout en maintenant la conscience contextuelle nécessaire à une assistance au développement efficace.

De plus, tout le traitement du code s'effectue dans des environnements sécurisés et chiffrés qui répondent aux normes de sécurité d'entreprise, garantissant que la propriété intellectuelle sensible reste protégée tout au long du processus de développement.

Adopter l'avenir du développement intégré

L'écosystème CodeX continuera d'évoluer vers des modèles d'intégration encore plus fluides, mais le principe fondamental reste constant : l'assistance de l'IA doit améliorer plutôt que compliquer les flux de travail de développement. En adoptant ces approches intégrées et en tirant parti d'outils complémentaires comme Apidog pour les projets de développement d'API, les développeurs peuvent atteindre une productivité sans précédent tout en maintenant les normes les plus élevées de qualité et de fiabilité du code.

L'avenir appartient aux environnements de développement où l'assistance de l'IA fonctionne de manière transparente et intelligente, permettant aux développeurs de se concentrer sur la résolution créative de problèmes et la réflexion architecturale plutôt que sur la gestion de la complexité de l'intégration technique. CodeX représente une étape significative vers cet avenir, fournissant une base pour la prochaine génération d'expériences de développement assisté par l'IA.