Le Model Context Protocol (MCP) est un standard ouvert conçu pour créer un langage commun entre les applications de modèles de langage étendus (LLM) et les services externes. Il établit une méthode standardisée permettant à un modèle d'IA de découvrir et d'interagir avec des outils, d'accéder à des données et d'utiliser des invites prédéfinies, quelle que soit la manière dont le modèle ou les services externes sont construits.

À la base, le MCP permet à une application, appelée "Client MCP", de se connecter à un ou plusieurs "Serveurs MCP". Ces serveurs exposent des capacités que le LLM peut ensuite utiliser. Cela découple la logique centrale de l'IA des implémentations spécifiques des outils qu'elle utilise, rendant les systèmes d'IA plus modulaires, évolutifs et interopérables.

Le protocole définit plusieurs types de fonctionnalités qu'un serveur peut offrir. Un client MCP peut prendre en charge certaines ou toutes ces fonctionnalités, selon son objectif. Comprendre ces fonctionnalités est essentiel pour saisir ce qu'une intégration MCP permet.

| Fonctionnalité | Description |

|---|---|

| Outils | Fonctions exécutables qu'un LLM peut invoquer pour effectuer des actions. |

| Invites | Modèles prédéfinis pour structurer les interactions avec le LLM. |

| Ressources | Données et contenu exposés par le serveur que le LLM peut lire. |

| Découverte | La capacité d'être informé lorsque les capacités d'un serveur changent. |

| Instructions | Directives fournies par le serveur sur la façon dont le LLM doit se comporter. |

| Échantillonnage | Complétions LLM et suggestions de paramètres initiées par le serveur. |

| Racines | Définitions des limites du système de fichiers pour les opérations du LLM. |

| Élicitation | Un mécanisme permettant au serveur de demander des informations à l'utilisateur. |

| Tâches | Un moyen de suivre l'état des opérations de longue durée. |

| Applications | Interfaces HTML interactives fournies par le serveur. |

En prenant en charge ces fonctionnalités, différentes applications peuvent exploiter le même ensemble d'outils externes et de sources de données de manière cohérente, favorisant un écosystème plus riche de services d'IA interconnectés.

Un guide des clients MCP

Un client MCP est toute application capable de se connecter à un serveur MCP pour consommer les fonctionnalités qu'il offre. Ces clients agissent comme un pont entre l'utilisateur, le LLM et le vaste monde des capacités externes. Ils peuvent aller d'outils destinés aux développeurs, tels que des éditeurs de code et des interfaces en ligne de commande, à des applications de bureau conviviales et des plateformes sans code.

La fonction principale d'un client est de gérer la connexion à un ou plusieurs serveurs MCP et d'intégrer les Outils, Invites et Ressources découverts dans son expérience utilisateur. Par exemple, un assistant de codage pourrait utiliser le MCP pour trouver et exécuter un outil qui exécute des tests, tandis qu'un chatbot pourrait l'utiliser pour extraire des données d'une base de connaissances interne d'une entreprise via une Ressource.

La croissance de l'écosystème MCP a conduit à une gamme diversifiée de clients, chacun adapté à des flux de travail et des cas d'utilisation différents. L'exploration de certains des principaux clients peut fournir une image plus claire de la façon dont ce protocole est mis en œuvre en pratique pour construire des applications d'IA plus puissantes et sensibles au contexte.

Top 10 des clients MCP

Les clients suivants démontrent l'étendue de l'adoption du MCP, des produits commerciaux largement utilisés aux projets open source innovants. Chacun offre une manière unique d'interagir avec l'écosystème croissant des serveurs MCP.

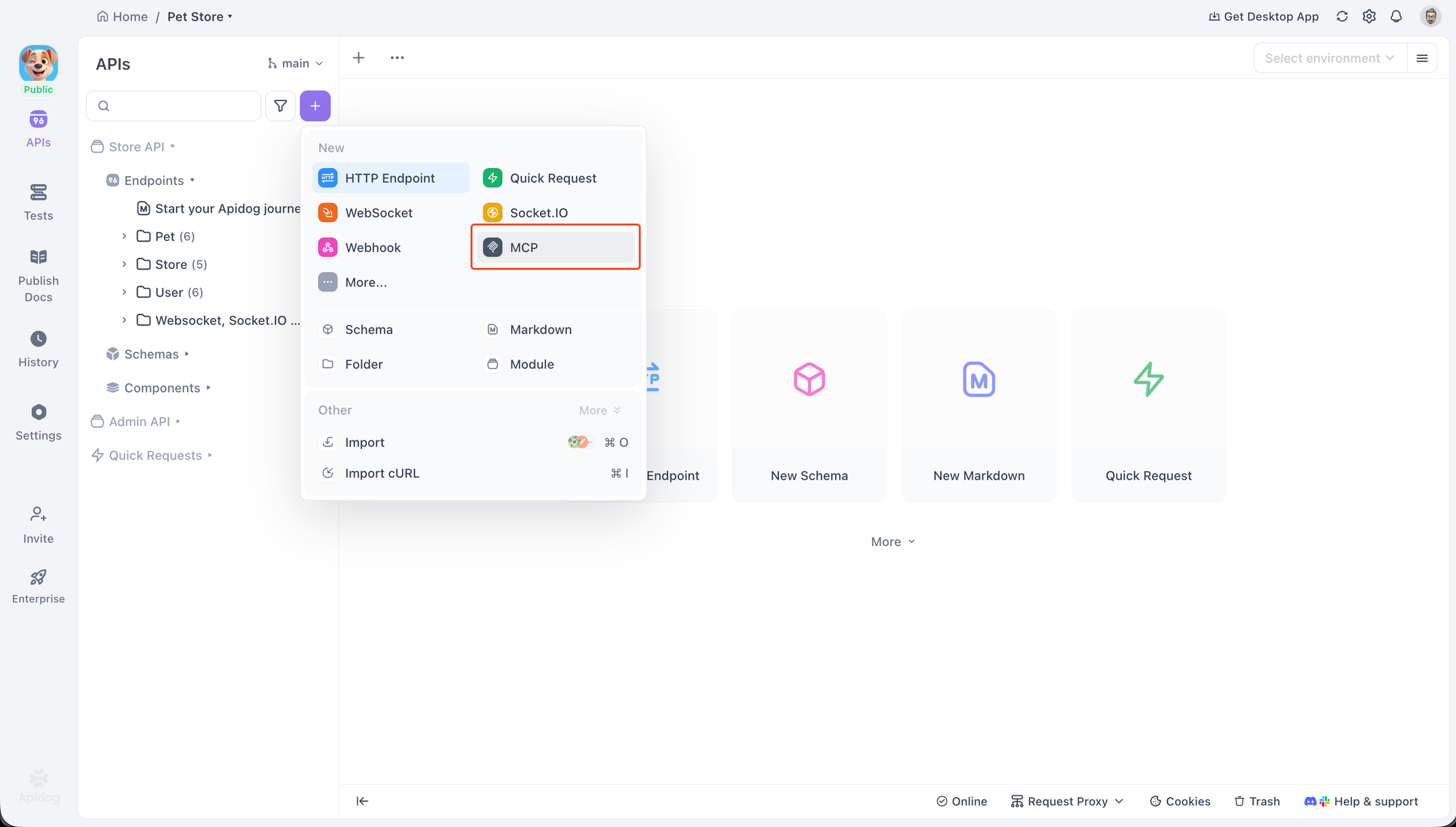

Client MCP Apidog

Apidog est une plateforme complète de développement d'API qui inclut un client MCP intégré pour le débogage et le test des serveurs MCP. Cela en fait un excellent outil pour les développeurs qui construisent ou intègrent le MCP, car il fournit une interface dédiée pour interagir avec toutes les principales fonctionnalités du MCP.

Le client prend en charge deux méthodes de transport principales pour se connecter aux serveurs : STDIO pour les processus locaux et HTTP pour les serveurs distants. Cette flexibilité permet aux développeurs de tester une grande variété de configurations de serveurs.

Pour commencer, une nouvelle requête MCP peut être créée au sein d'un projet Apidog. La connexion à un serveur est simple. Il suffit de coller une commande utilisée pour démarrer un serveur local. Par exemple, pour se connecter à un serveur d'exemple, vous pouvez utiliser une commande comme celle-ci :

npx -y @modelcontextprotocol/server-everything

Apidog reconnaîtra cela comme une commande, sélectionnera automatiquement le protocole STDIO et demandera une confirmation de sécurité avant de démarrer le processus local. Pour les serveurs distants, coller une URL changera le protocole en HTTP.

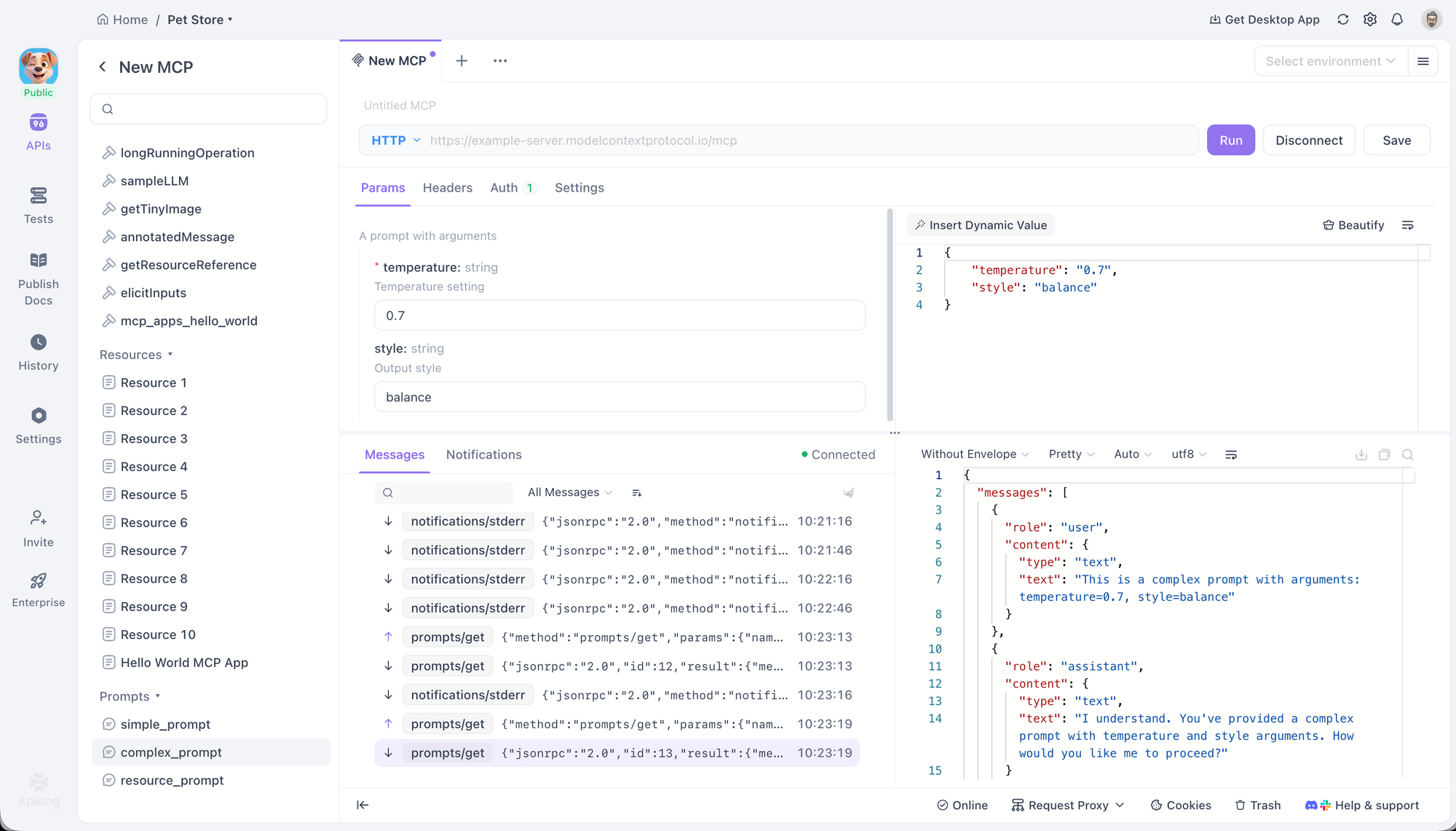

Une fois connecté, Apidog affiche une arborescence de tous les Outils, Invites et Ressources fournis par le serveur. Cela permet une interaction et un débogage directs. Les utilisateurs peuvent sélectionner un Outil, remplir ses paramètres à l'aide d'un formulaire ou d'un éditeur JSON, et l'exécuter pour voir la réponse. De même, les Invites peuvent être exécutées pour afficher la sortie générée, et les Ressources peuvent être récupérées pour inspecter leur contenu.

Le client offre également des options de configuration avancées. Pour les connexions HTTP, il prend en charge diverses méthodes d'authentification, y compris OAuth 2.0, les clés API et les jetons Bearer, et peut gérer automatiquement le flux OAuth 2.0. Des en-têtes personnalisés et des variables d'environnement peuvent également être définis, avec une prise en charge complète du système de variables d'Apidog.

ChatGPT

En tant qu'assistant IA phare d'OpenAI, l'intégration du MCP par ChatGPT est un indicateur significatif de l'importance croissante du protocole. Il prend en charge la connexion à des serveurs MCP distants, lui permettant d'exploiter des outils externes pour mener des recherches approfondies et accéder à des fonctionnalités spécialisées.

L'intégration est gérée via l'interface utilisateur des connexions dans les paramètres de ChatGPT. Une fois un serveur configuré, ses outils deviennent disponibles pour le modèle. Cela permet à ChatGPT d'aller au-delà de ses capacités intégrées, en utilisant des outils de serveurs configurés pour effectuer des tâches comme la recherche dans des bases de données propriétaires ou l'interaction avec des API tierces de manière standardisée. Ce support est particulièrement précieux dans les environnements d'entreprise où la sécurité et la conformité sont primordiales.

L'écosystème Claude

Anthropic a profondément intégré le MCP dans sa suite de produits, y compris son assistant web claude.ai, l'application de bureau Claude Desktop App et l'outil de codage agentique Claude Code. Ce support multi-facettes présente différents aspects du standard MCP.

claude.ai prend en charge les serveurs MCP distants, permettant aux utilisateurs web de connecter leurs conversations Claude à des outils, invites et ressources externes.

L'application Claude Desktop App va plus loin en permettant les connexions aux serveurs locaux, ce qui améliore la confidentialité et la sécurité en gardant les données sur la machine de l'utilisateur. Elle prend entièrement en charge les Ressources, les Invites, les Outils et même les Applications interactives.

Claude Code est un exemple puissant d'intégration bidirectionnelle. Il agit comme un client MCP, consommant des Outils, des Invites et des Ressources d'autres serveurs pour l'aider dans ses tâches de codage. Simultanément, il fonctionne également comme un serveur MCP, exposant ses propres capacités à d'autres clients MCP.

Agent de codage GitHub Copilot

GitHub Copilot, l'assistant de codage IA le plus largement adopté, exploite le MCP pour augmenter son contexte et ses capacités. L'agent de codage Copilot peut déléguer des tâches et interagir avec des serveurs MCP locaux et distants pour utiliser des outils externes.

Cette intégration permet aux développeurs d'adapter Copilot à leurs besoins spécifiques de projet. Par exemple, un développeur peut connecter Copilot à un serveur MCP interne qui fournit des outils pour interagir avec un système de build propriétaire ou une base de données spécifique au projet. Cela étend la connaissance de Copilot au-delà du code lui-même, lui permettant d'effectuer des tâches de développement plus complexes et sensibles au contexte.

Cursor

Cursor est un éditeur de code axé sur l'IA, conçu dès le départ pour le développement assisté par l'IA. Son support natif du MCP est une partie essentielle de son architecture, permettant une intégration profonde avec le flux de travail d'un développeur.

L'éditeur prend en charge les Outils MCP via sa fonction Composer, permettant aux utilisateurs d'invoquer des fonctions externes directement pendant le codage. Il prend également en charge les Invites, les Racines et l'Élicitation, ce qui lui permet d'avoir des sessions interactives plus complexes avec les serveurs. Cursor peut se connecter aux serveurs via STDIO et SSE, offrant une flexibilité pour les ensembles d'outils locaux et distants.

LM Studio

LM Studio est une application de bureau populaire qui facilite la découverte, le téléchargement et l'exécution locale de LLM open source. Sa contribution clé à l'écosystème MCP est sa capacité à connecter ces modèles locaux aux serveurs MCP.

Cela comble le fossé entre le monde des modèles open source et l'utilisation standardisée des outils fournie par le MCP. Les utilisateurs peuvent ajouter des configurations de serveur à un fichier local mcp.json pour commencer. Une caractéristique remarquable est son interface utilisateur de confirmation d'outil, qui demande l'approbation de l'utilisateur avant qu'un modèle local ne soit autorisé à exécuter un appel d'outil, offrant une couche importante de sécurité et de contrôle.

Amazon Q

L'assistant alimenté par l'IA d'Amazon, Amazon Q, a adopté le MCP dans ses versions en ligne de commande (Amazon Q CLI) et IDE (Amazon Q IDE). Cela démontre l'utilité du protocole dans les environnements de développement professionnels pour gérer l'infrastructure cloud et rationaliser les tâches de codage.

L'Amazon Q CLI est un assistant de codage agentique pour le terminal qui offre une prise en charge complète des serveurs MCP. Il permet aux utilisateurs d'accéder aux outils et aux invites enregistrées directement depuis leur ligne de commande.

L'Amazon Q IDE, disponible pour les principaux IDE comme VS Code et JetBrains, apporte des capacités similaires dans une interface graphique. Il permet aux utilisateurs de contrôler et d'organiser les ressources AWS et de gérer les autorisations pour chaque outil MCP via l'interface utilisateur de l'IDE, offrant un contrôle granulaire sur les capacités de l'assistant.

AIQL TUUI

AIQL TUUI est une application de chat IA de bureau gratuite et open source qui se distingue par son support complet du standard MCP et sa nature multiplateforme. Elle fonctionne sur macOS, Windows et Linux et prend en charge un large éventail de fournisseurs d'IA et de modèles locaux.

Son intégration MCP est étendue, couvrant les Ressources, les Invites, les Outils, la Découverte, l'Échantillonnage et l'Élicitation. Cela permet une expérience riche et interactive où les utilisateurs peuvent basculer en toute transparence entre différents LLM et agents. L'application offre un contrôle avancé sur les paramètres d'échantillonnage et permet la personnalisation des outils, ce qui en fait un choix puissant pour les utilisateurs avancés et les développeurs qui souhaitent un client hautement configurable.

Langflow

Langflow est un constructeur visuel open source pour la création d'applications IA. Sa position unique dans l'écosystème MCP réside dans son double rôle de client et de serveur, facilité par une interface graphique basée sur des flux.

En tant que client MCP, Langflow peut utiliser les outils de n'importe quel serveur MCP pour construire des agents et des flux de travail. Cela permet aux utilisateurs de glisser-déposer des nœuds représentant des outils MCP dans leurs flux, rendant les intégrations complexes plus accessibles.

Inversement, les utilisateurs peuvent également exporter leurs agents et flux créés en tant que serveur MCP complet. Cette fonctionnalité puissante permet aux développeurs de prototyper visuellement un ensemble d'outils, puis de les exposer à d'autres clients MCP, réduisant considérablement la barrière à la création et au partage de capacités d'IA personnalisées.

AgenticFlow

AgenticFlow cible un public différent en fournissant une plateforme IA sans code pour construire des agents qui gèrent des tâches de vente, de marketing et de création. Il utilise le MCP comme protocole sous-jacent pour se connecter en toute sécurité à une bibliothèque massive de plus de 10 000 outils et 2 500 API.

La plateforme simplifie le processus de connexion à un serveur MCP en quelques étapes seulement, en faisant abstraction des détails techniques. Cela permet aux non-développeurs de créer des agents IA puissants capables d'interagir avec un large éventail de services externes. Les utilisateurs peuvent gérer leurs connexions en toute sécurité et révoquer l'accès à tout moment, ce qui en fait un point d'entrée sûr et accessible dans le monde de l'utilisation des outils IA.

Conclusion

Le Model Context Protocol est en train de devenir rapidement une couche fondamentale pour la manière dont les systèmes d'IA interagissent avec le monde extérieur. En standardisant la façon dont les LLM découvrent et utilisent les outils, les invites et les sources de données, le MCP élimine le couplage étroit entre les modèles et les services et le remplace par une architecture propre, modulaire et interopérable. Ce changement rend les applications d'IA plus faciles à étendre, plus sûres à utiliser et bien plus adaptables aux flux de travail du monde réel.

Comme le montre la liste croissante des clients MCP, le protocole est déjà adopté dans un large éventail de cas d'utilisation — des outils pour développeurs comme Apidog, Cursor et GitHub Copilot, aux assistants d'entreprise comme ChatGPT et Amazon Q, et même aux plateformes sans code telles que Langflow et AgenticFlow. Chaque client applique le MCP différemment, mais tous bénéficient de la même promesse fondamentale : réutilisation, flexibilité et intégration cohérente des outils.

À l'avenir, la véritable valeur du MCP réside dans l'écosystème qu'il permet. À mesure que davantage de serveurs exposent des outils de haute qualité et que davantage de clients adoptent le protocole, les développeurs et les utilisateurs gagnent la liberté de combiner des modèles, des outils et des flux de travail sans avoir à reconstruire les intégrations à partir de zéro. Que vous déboguiez un serveur MCP, construisiez un assistant de codage agentique ou conceviez visuellement des flux de travail IA, le MCP offre un terrain d'entente qui permet à l'innovation de s'étendre.