Lorsque nous effectuons des tests logiciels, nous nous demandons souvent si les résultats sont vraiment exacts. C'est là qu'un Oracle de test s'avère utile ! Tester ne consiste pas seulement à exécuter des étapes ; il s'agit de savoir ce qui devrait se passer une fois ces étapes terminées. Sans un moyen fiable de déterminer la réussite ou l'échec, même l'exécution de test la plus approfondie n'est que de la conjecture.

Le concept d'un Oracle de test semble académique, mais c'est l'une des idées les plus pratiques en assurance qualité logicielle. Savoir comment construire et utiliser des oracles de test augmentera la fiabilité de vos tests et la confiance de vos livraisons, que vous testiez des algorithmes sophistiqués, des API ou des interfaces utilisateur.

Qu'est-ce qu'un Oracle de Test exactement ?

Un Oracle de Test est un mécanisme qui détermine si un test a réussi ou échoué en comparant la sortie réelle d'un système avec le comportement attendu. Considérez-le comme votre arbitre – il observe le match et annonce définitivement « but » ou « pas de but ». Sans un oracle, vous vous contentez de taper dans le ballon sans savoir si vous avez marqué.

Chaque test a besoin d'un oracle, même s'il est implicite. Lorsque vous testez manuellement une page de connexion et que vous voyez « Bienvenue ! » après avoir entré vos identifiants, votre cerveau sert d'oracle : vous savez que le succès se manifeste par un message de bienvenue et non par une page d'erreur. En test automatisé, nous devons rendre ces oracles explicites et fiables.

Le Problème Classique de l'Oracle

Prenons l'exemple du test d'une fonction qui calcule les frais de livraison. Vous entrez la destination, le poids et le mode d'expédition, et vous obtenez un prix. Comment savez-vous que le prix est correct ?

// Exemple d'un oracle peu clair

function calculateShipping(weight, zone, method) {

return 15.99; // Est-ce correct ? Qui sait !

}

Votre oracle pourrait être :

- Une autre implémentation du même algorithme (un système de référence)

- Une table de valeurs attendues pré-calculées

- Une règle métier comme « doit être entre 5 $ et 100 $ »

- Un modèle mathématique en lequel vous avez confiance

Sans cela, ce 15.99 n'est qu'un nombre, pas un résultat vérifié.

Types d'Oracles de Test : Choisissez le Bon Outil

Tous les oracles ne fonctionnent pas de la même manière. Choisir le bon type pour votre situation est la moitié de la bataille.

| Type d'Oracle | Comment ça fonctionne | Mieux utilisé pour | Limitations |

|---|---|---|---|

| Oracle Spécifié | Compare la sortie aux exigences documentées | Contrats d'API, critères d'acceptation | Les exigences doivent être complètes et exactes |

| Oracle Heuristique | Utilise des règles empiriques et la logique métier | Seuils de performance, validation de format | Peut manquer des bogues subtils, peut être subjectif |

| Oracle de Référence | Compare à un système ou modèle fiable | Tests de migration de données, validation d'algorithme | Nécessite une référence fiable qui peut ne pas exister |

| Oracle Statistique | Vérifie si les résultats se situent dans les plages attendues | Tests de charge, bases de référence de performance | Nécessite des données historiques, peut manquer des valeurs aberrantes |

| Oracle Humain | Vérification manuelle par un expert du domaine | Tests exploratoires, validation UX | Lent, coûteux, incohérent |

Exemple : Tester une API avec Plusieurs Oracles

Examinons un point de terminaison GET /api/users/{id} :

# Test case with multiple oracles

def test_get_user_by_id():

response = client.get("/api/users/123")

# Oracle 1: Spécifié - Le code de statut doit être 200

assert response.status_code == 200

# Oracle 2: Heuristique - Temps de réponse inférieur à 500ms

assert response.elapsed < 0.5

# Oracle 3: Spécifié - Validation du schéma

schema = {"id": int, "email": str, "name": str}

assert validate_schema(response.json(), schema)

# Oracle 4: Référence - Comparer à la base de données

user_from_db = db.query("SELECT * FROM users WHERE id=123")

assert response.json()["email"] == user_from_db.email

Cette approche multicouche détecte différents types de défauts. L'oracle du code de statut trouve les erreurs de routage, l'heuristique détecte les problèmes de performance, la validation du schéma détecte les bogues de format, et l'oracle de base de données révèle la corruption de données.

Alors, quand utiliser un Oracle de Test : Scénarios Pratiques

Savoir comment utiliser un Oracle de Test signifie reconnaître quand une vérification explicite est nécessaire et quand des vérifications implicites suffisent.

Utilisez un oracle explicite lorsque :

- Le résultat attendu n'est pas évident dans le contexte du test

- La logique métier est complexe et sujette aux erreurs

- Vous testez des calculs ou des transformations

- La conformité réglementaire exige une vérification documentée

- Vous testez plusieurs systèmes qui doivent rester synchronisés

Les oracles implicites fonctionnent pour :

- Interactions UI simples (clic sur un bouton → chargement de la page)

- Tests de fumée où toute réponse est meilleure qu'aucune réponse

- Tests exploratoires où le jugement humain est suffisant

Comment Écrire un Oracle de Test : Un Processus Étape par Étape

La création d'un Oracle de Test fiable suit un schéma simple :

Étape 1 : Identifier ce qui Nécessite une Vérification

Demandez-vous : Quelle sortie prouve que cette fonctionnalité fonctionne ? Est-ce un code de statut ? Un enregistrement de base de données ? Un message d'interface utilisateur ? Un résultat de calcul ?

Exemple : Pour une API de paiement, l'oracle pourrait vérifier :

- Statut HTTP 200

- ID de paiement dans la réponse

- Enregistrement de transaction créé dans la base de données

- Reçu par e-mail envoyé

- Solde mis à jour correctement

Étape 2 : Choisir le Type d'Oracle

Sélectionnez en fonction de ce en quoi vous pouvez avoir confiance. Si les exigences sont solides, utilisez des oracles spécifiés. Si vous avez un système existant, utilisez-le comme oracle de référence. Pour les performances, utilisez des seuils heuristiques.

Étape 3 : Le Rendre Déterministe

Un bon oracle ne tergiverse jamais. Évitez les assertions vagues comme response.should_be_fast(). Au lieu de cela : assert response_time < 200ms.

Étape 4 : Superposer Plusieurs Oracles

Les chemins critiques méritent plusieurs méthodes de vérification. Un paiement peut passer une vérification de code de statut mais échouer à une vérification d'intégrité de base de données.

Étape 5 : Automatiser et Maintenir

Les oracles doivent vivre dans votre code de test, et non dans la tête des testeurs. Contrôlez-les en version avec vos tests et mettez-les à jour lorsque les exigences changent.

Exemple de Code : Test Complet avec Oracle

Voici un test API robuste avec plusieurs oracles :

describe('Order API', () => {

it('creates order with valid items', async () => {

// Arrange (Given)

const orderData = {

items: [{ productId: 123, quantity: 2 }],

shippingAddress: { city: 'New York', zip: '10001' }

};

// Act (When)

const response = await api.post('/api/orders', orderData);

const order = response.data;

// Assert (Then) - Multiple oracles

// Oracle 1: Specified - Status and structure

expect(response.status).toBe(201);

expect(order).toHaveProperty('orderId');

// Oracle 2: Heuristic - Reasonable total

expect(order.totalAmount).toBeGreaterThan(0);

expect(order.totalAmount).toBeLessThan(10000);

// Oracle 3: Reference - Database consistency

const dbOrder = await db.orders.findById(order.orderId);

expect(dbOrder.status).toBe('confirmed');

// Oracle 4: Side effect - Inventory reduced

const inventory = await db.products.getStock(123);

expect(inventory).toBe(initialStock - 2);

});

});

Ce test détectera les bogues qu'un seul oracle manquerait – problèmes de performance, incohérence de données ou logique métier manquante.

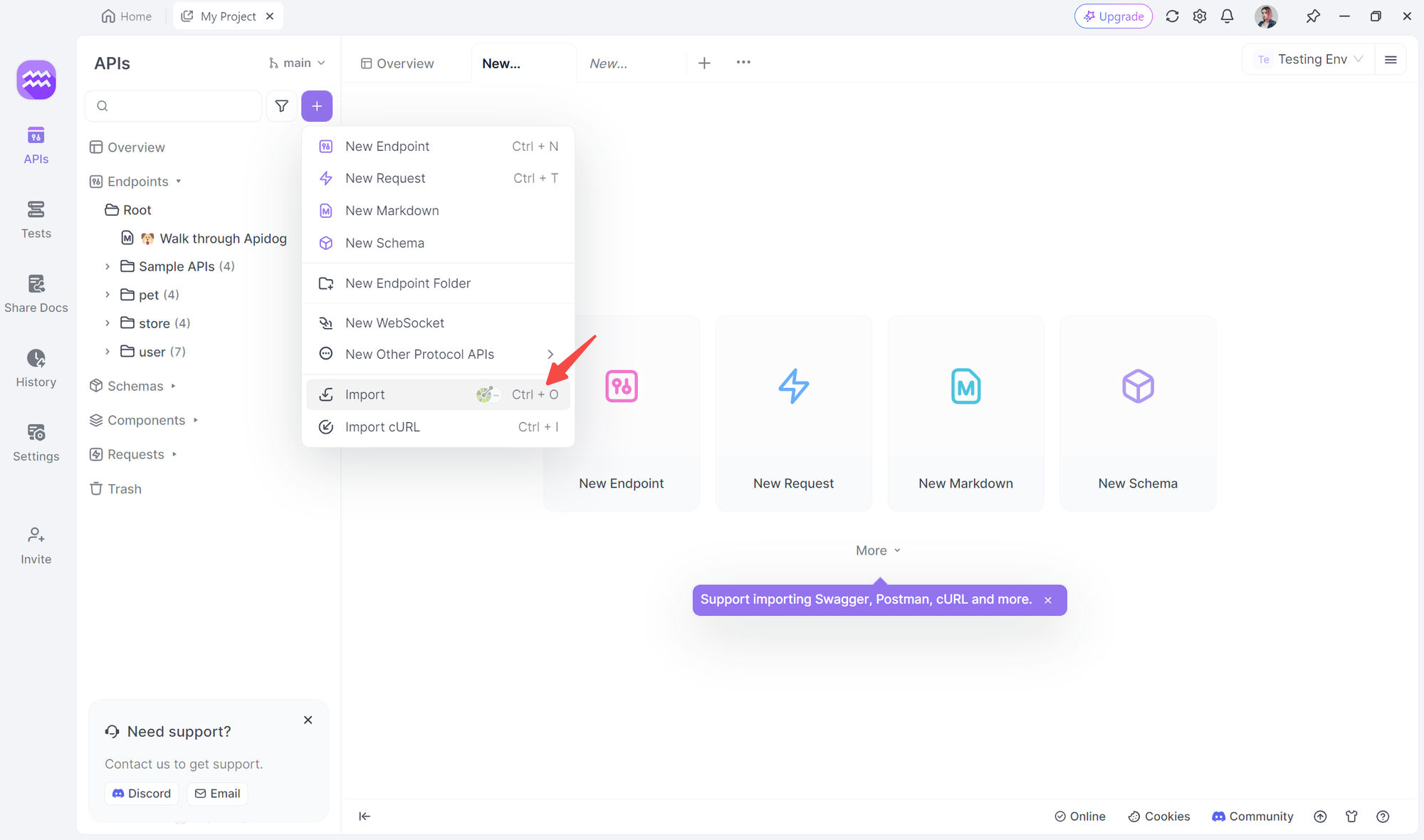

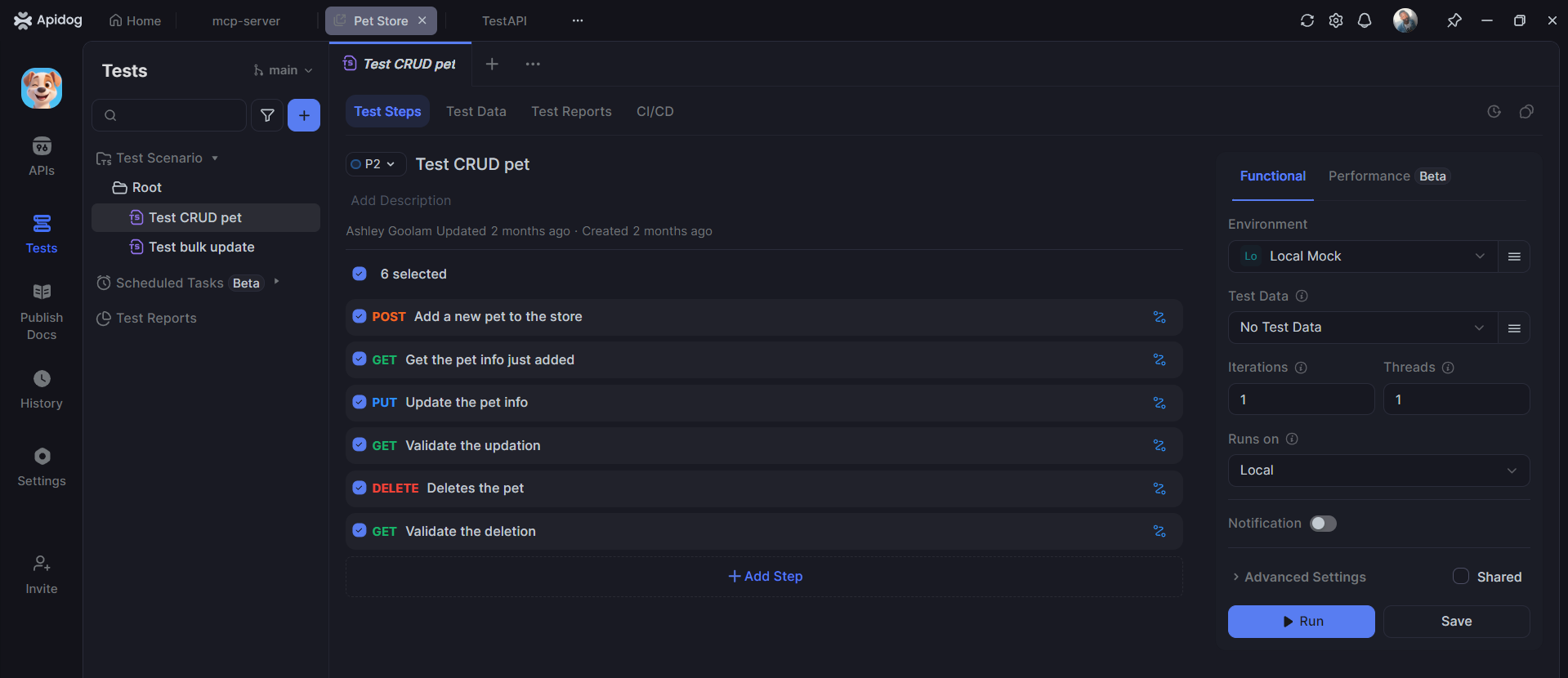

Comment Apidog Aide à Automatiser les Oracles de Test API

Lors du test manuel d'API, la création d'oracles est fastidieuse. Vous devez élaborer des réponses attendues, valider les schémas et vérifier les codes de statut pour chaque point de terminaison. Apidog automatise l'ensemble de ce processus, transformant votre spécification API en une suite d'oracles de test exécutables.

Génération Automatique de Cas de Test à partir de la Spécification API

Importez votre spécification OpenAPI dans Apidog, et il crée instantanément des oracles de test intelligents pour chaque point de terminaison :

Pour GET /api/users/{id}, Apidog génère des oracles qui vérifient :

- Le code de statut est 200 pour les ID valides, 404 pour les ID invalides

- Le schéma de réponse correspond au modèle utilisateur

- Le temps de réponse est inférieur à 500 ms (configurable)

- Les champs requis (id, email, name) sont présents et non nuls

- Les types de données sont corrects (id est un entier, email est une chaîne)

Pour POST /api/users, Apidog crée des oracles pour :

- La création réussie renvoie 201 avec l'en-tête Location

- Le format d'e-mail invalide renvoie 400 avec un message d'erreur spécifique

- Les champs requis manquants déclenchent des erreurs de validation

- L'e-mail dupliqué renvoie un statut de conflit 409

- Le corps de la réponse contient l'ID utilisateur généré correspondant à la requête

Cette automatisation signifie que vos tests API sont directement dérivés de votre contrat API. Lorsque la spécification change, Apidog signale les tests affectés et suggère des mises à jour, empêchant la dérive des tests.

Questions Fréquemment Posées

Q1 : Quelle est la différence entre un oracle de test et un cas de test ?

R : Un cas de test décrit les étapes à exécuter. Un Oracle de Test est le mécanisme qui décide si le résultat de ces étapes est correct. Considérez le cas de test comme la recette et l'oracle comme le test de goût qui juge si le plat a été réussi.

Q2 : Apidog peut-il générer automatiquement des oracles de test ?

R : Oui. Apidog analyse votre spécification API et crée automatiquement des oracles pour les codes de statut, les schémas, les types de données, les champs requis et les seuils de performance. Ces oracles sont directement dérivés de votre contrat API et se mettent à jour automatiquement lorsque la spécification change.

Q3 : Comment savoir si mon oracle de test est suffisamment bon ?

R : Un bon oracle est déterministe (donne toujours la même réponse), précis (correspond aux règles métier) et efficace (ne ralentit pas les tests). Si vos tests réussissent parfois et échouent parfois pour le même code, votre oracle est trop vague. S'il manque de vrais bogues, il est trop faible.

Q4 : Dois-je utiliser plusieurs oracles de test pour un seul test ?

R : Absolument, surtout pour les chemins critiques. Une API de paiement devrait vérifier le code de statut, l'enregistrement de transaction, le reçu par e-mail et le solde du compte. Chaque oracle détecte une classe de bogues différente. Il suffit d'équilibrer la rigueur avec la vitesse d'exécution des tests.

Q5 : Un oracle de test est-il nécessaire pour les tests unitaires ?

R : Oui, mais ils sont souvent plus simples. Un oracle de test unitaire pourrait simplement comparer la valeur de retour d'une fonction à une constante attendue. Le principe est le même : vous avez besoin d'un moyen fiable de déterminer la réussite/l'échec, même s'il ne s'agit que de assertEquals(attendu, réel).

Conclusion

Comprendre l'Oracle de Test est ce qui sépare les tests amateurs de l'assurance qualité professionnelle. Il ne suffit pas d'exécuter des tests – vous devez savoir, avec confiance, si les résultats sont corrects. Que vous utilisiez des exigences spécifiées, des références fiables ou des règles heuristiques, un oracle bien conçu est votre filet de sécurité contre une fausse confiance.

Pour les tests API, le défi de créer et de maintenir des oracles est intimidant. Les approches manuelles ne peuvent pas suivre l'évolution des API. C'est là que des outils comme Apidog deviennent essentiels. En générant automatiquement des oracles à partir de votre spécification API, Apidog garantit que vos tests restent alignés sur votre contrat, détectent les défauts réels et libèrent votre équipe pour se concentrer sur des décisions stratégiques de qualité plutôt que sur une validation répétitive.

Commencez à traiter vos oracles de test comme des artefacts de première classe. Documentez-les, gérez leurs versions et automatisez-les. Votre futur vous-même – et vos utilisateurs – vous remercieront lorsque les versions de production se dérouleront sans problème parce que vos tests savaient réellement à quoi ressemblait le « correct ».