Si vous avez déjà assisté à une réunion de planification de tests et entendu quelqu'un dire : « Écrivons un script de test pour cette fonctionnalité », pendant qu'une autre personne ajoutait : « J'aurai le cas de test prêt demain », vous vous êtes peut-être demandé s'ils parlaient réellement de la même chose. Ces termes sont utilisés de manière interchangeable, et les mélanger entraînerait certainement de la confusion, des attentes non concordantes et des lacunes dans la couverture des tests qui n'apparaîtraient qu'après la publication.

Par conséquent, comprendre la distinction entre un cas de test et un script de test n'est pas un concept académique, c'est une distinction pratique qui affecte la façon dont vous concevez les tests, qui les exécute et comment vous les maintenez au fil du temps. Ce guide clarifiera la différence, vous montrera quand utiliser une approche particulière et vous donnera les meilleures pratiques qui rendront votre effort de test plus efficace et moins chaotique.

bouton

Qu'est-ce qu'un cas de test ?

Un cas de test est un ensemble de conditions ou de variables sous lesquelles un testeur détermine si un système sous test satisfait aux exigences. Considérez-le comme une recette : il vous indique les ingrédients (préconditions), les étapes (actions) et l'apparence du plat final (résultats attendus). Les cas de test sont des documents conçus pour être lus, compris et exécutés par des humains.

Un cas de test bien rédigé répond à ces questions :

- Quelle exigence spécifique testons-nous ?

- Quelles conditions doivent exister avant de commencer ?

- Quelles actions exactes effectuons-nous ?

- Quelles données utilisons-nous ?

- Comment savons-nous si le test a réussi ou échoué ?

Les cas de test se trouvent dans des outils de gestion de tests comme Apidog, TestRail, des feuilles Excel, ou même des pages Confluence. Ils privilégient la clarté et l'exhaustivité à la précision technique, car leur public comprend des testeurs manuels, des analystes commerciaux et des chefs de produit qui peuvent ne pas lire le code.

Par exemple, un cas de test pour une fonctionnalité de connexion pourrait ressembler à ceci :

ID du cas de test : TC_Login_001

Objectif : Vérifier qu'un utilisateur valide peut se connecter avec les bonnes informations d'identification

Préconditions : Le compte utilisateur existe ; l'utilisateur est sur la page de connexion

Étapes :

- Saisir le nom d'utilisateur : test@example.com

- Saisir le mot de passe : ValidPass123

- Cliquer sur le bouton de connexion

Résultat attendu : L'utilisateur est redirigé vers le tableau de bord ; le message de bienvenue affiche le nom d'utilisateur

Remarquez l'accent mis sur la lisibilité humaine et le détail explicite. N'importe qui peut exécuter ce cas de test, même s'il ne l'a pas écrit.

Qu'est-ce qu'un script de test ?

Un script de test est un ensemble d'instructions automatisées écrites dans un langage de programmation qui exécute des étapes de test sans intervention humaine. Si un cas de test est une recette, un script de test est un robot de cuisine programmé pour suivre cette recette parfaitement à chaque fois, à la vitesse d'une machine.

Les scripts de test sont du code. Ils utilisent des frameworks comme Selenium, Playwright ou Cypress pour interagir avec les applications via des API, des navigateurs ou des interfaces mobiles. Leur public est technique : les ingénieurs en automatisation et les développeurs qui maintiennent la suite. Les scripts se concentrent sur la précision, la réutilisabilité et l'intégration avec les pipelines CI/CD.

Le même scénario de connexion sous forme de script de test (utilisant Playwright) :

test('valid user login', async ({ page }) => {

await page.goto('/login');

await page.locator('#username').fill('test@example.com');

await page.locator('#password').fill('ValidPass123');

await page.locator('button[type="submit"]').click();

await expect(page).toHaveURL('/dashboard');

await expect(page.locator('#welcome-msg')).toContainText('test@example.com');

});

Le script effectue la même validation mais le fait de manière programmatique, s'exécute en quelques millisecondes et s'intègre directement dans votre suite de tests automatisée.

Cas de test vs script de test : les différences clés

Comprendre la distinction entre un cas de test et un script de test signifie reconnaître qu'ils servent des objectifs différents. Voici comment ils se comparent selon des dimensions essentielles :

| Aspect | Cas de test | Script de test |

|---|---|---|

| Format | Document lisible par l'homme (texte) | Code lisible par machine (JavaScript, Python, etc.) |

| Public | Testeurs manuels, analystes commerciaux, chefs de produit | Ingénieurs en automatisation, développeurs |

| Exécution | Manuelle, étape par étape par une personne | Automatisée, exécutée par des frameworks |

| Vitesse | Plus lente, limitée par le rythme humain | Extrêmement rapide, s'exécute en quelques secondes |

| Maintenance | Mises à jour textuelles simples, mais de nombreuses copies | Refactoring de code, gestion de version |

| Coût initial | Temps de création faible, temps d'exécution élevé | Temps de création élevé, temps d'exécution faible |

| Flexibilité | Le testeur peut s'adapter à la volée | Rigide ; le code doit être mis à jour pour les changements |

| Idéal pour | Tests exploratoires, UX, ad hoc | Tests de régression, de fumée, basés sur les données |

L'idée fondamentale de la distinction entre cas de test et script de test est la suivante : les cas de test définissent quoi tester, tandis que les scripts de test définissent comment le tester automatiquement. Le premier se concentre sur la couverture et la clarté ; le second sur la vitesse d'exécution et la répétabilité.

Quand utiliser les cas de test ou les scripts de test

Le choix entre les cas de test manuels et les scripts automatisés ne relève pas de la préférence, mais du contexte. Utilisez ces conseils pour prendre la bonne décision :

Utilisez les cas de test lorsque :

- La fonctionnalité change fréquemment (l'automatisation se casserait constamment)

- Vous testez l'expérience utilisateur, le design visuel ou la qualité subjective

- Le test nécessite un jugement humain complexe difficile à coder

- Vous avez besoin d'une validation rapide et unique d'une nouvelle fonctionnalité

- Votre équipe manque de compétences ou d'infrastructure d'automatisation

Utilisez les scripts de test lorsque :

- Le test doit être exécuté de manière répétée à travers les versions (suite de régression)

- Vous avez besoin d'un retour rapide sur les fonctionnalités principales (pipelines CI/CD)

- Des tests basés sur les données avec des centaines de combinaisons d'entrées sont requis

- Les étapes de test sont stables et peu susceptibles de changer

- Vous disposez des ressources techniques pour maintenir le code d'automatisation

La plupart des équipes matures utilisent les deux. Elles maintiennent une bibliothèque de cas de test manuels pour les tests exploratoires et UX, tout en construisant une suite de régression automatisée à partir des cas de test les plus critiques et stables.

Meilleures pratiques pour la rédaction de cas de test et de scripts de test

Que vous documentiez un test manuel ou que vous codiez un script automatisé, ces principes renforcent les deux :

Pour les cas de test :

- Soyez explicite, pas présomptueux : Écrivez les étapes de manière à ce qu'un nouveau membre de l'équipe puisse les exécuter sans poser de questions. « Cliquer sur le bouton Soumettre » vaut mieux que « Soumettre le formulaire ».

- Un test, un objectif : Chaque cas de test doit valider une seule exigence ou un seul scénario. Les tests combinés masquent les échecs et compliquent le débogage.

- Incluez des données réelles : Au lieu de « nom d'utilisateur valide », utilisez « test.user@company.com ». Les données réelles éliminent l'ambiguïté et accélèrent l'exécution.

- Liez aux exigences : Chaque cas de test doit être relié à une exigence, une user story ou un critère d'acceptation. Cela garantit la couverture et aide à l'analyse d'impact lorsque les exigences changent.

Pour les scripts de test :

- Suivez le modèle Page Object : Séparez la logique de test des localisateurs d'interface utilisateur. Lorsque l'ID du bouton de connexion change, vous mettez à jour un seul objet de page, et non cinquante scripts.

- Rendez les tests indépendants : Chaque script doit configurer ses propres données et nettoyer après son exécution. Un état partagé crée des tests instables qui échouent de manière aléatoire.

- Utilisez des noms descriptifs : Un test nommé

test_login_001ne vous dit rien. Nommez-letest_valid_user_redirects_to_dashboard_after_login. - Implémentez des attentes intelligentes : N'utilisez jamais de temporisateurs de sommeil fixes. Utilisez les attentes du framework qui mettent en pause jusqu'à ce que les éléments soient prêts. Cela élimine les conditions de concurrence et accélère l'exécution.

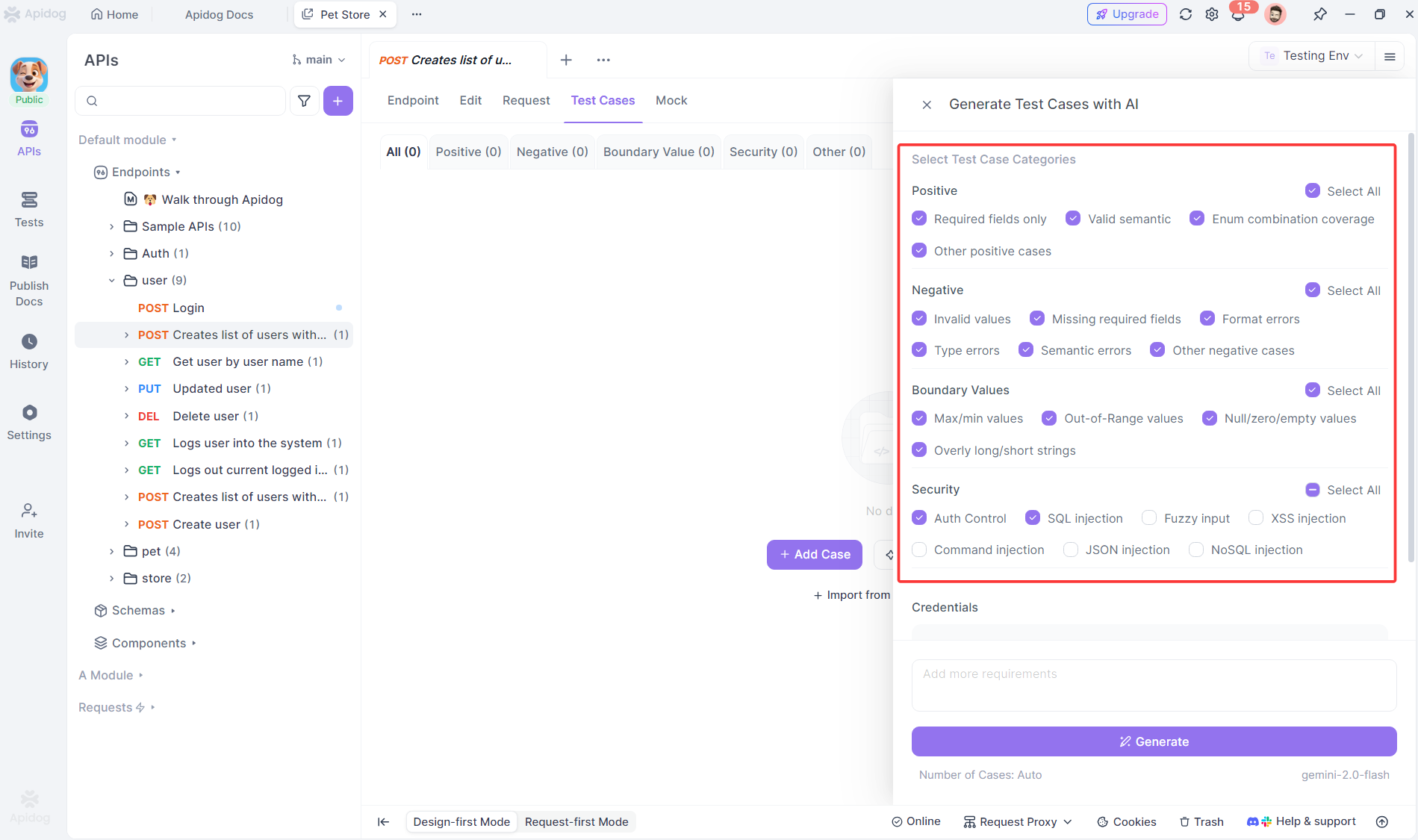

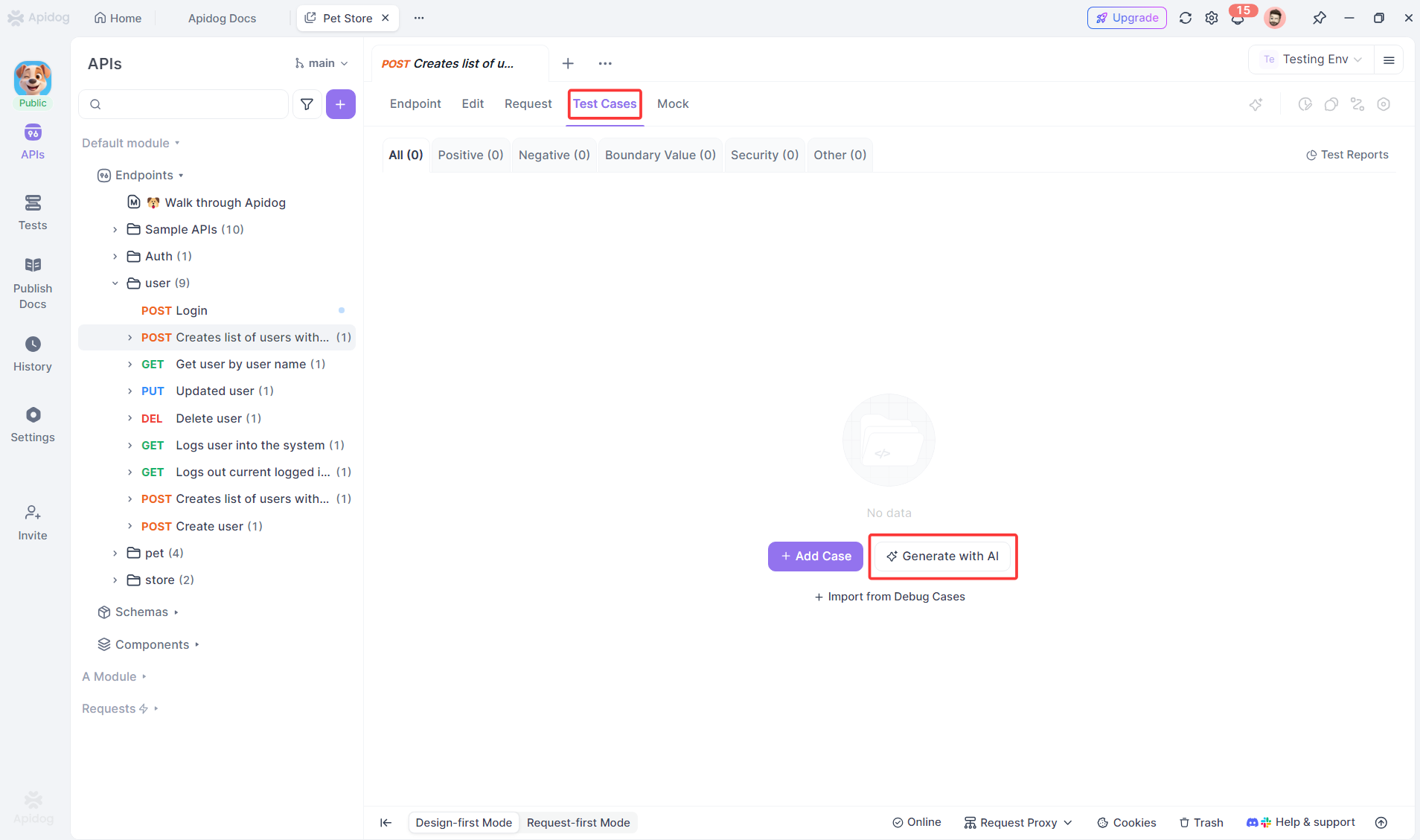

Comment Apidog aide à générer automatiquement des cas de test

L'un des plus grands goulots d'étranglement des tests est l'effort manuel requis pour écrire des cas de test complets. C'est là qu'Apidog change la donne.

Apidog utilise l'IA pour analyser votre documentation API et générer automatiquement des cas de test – et non des scripts – pour chaque endpoint. Il crée des tests de chemin positif, des tests négatifs avec des données invalides, des tests de valeurs limites et des tests de sécurité basés sur votre spécification. Chaque cas de test généré inclut des préconditions, des données d'entrée exactes, des codes d'état HTTP attendus et des points de validation de réponse.

Par exemple, lorsque vous importez une spécification OpenAPI pour une API de paiement, Apidog produit instantanément des cas de test pour :

- Paiement réussi avec une carte valide

- Échec de paiement avec une carte expirée

- Échec de paiement pour fonds insuffisants

- Montant invalide (négatif, zéro, dépassant la limite)

- Champs obligatoires manquants

Cette automatisation ne remplace pas le jugement humain – elle accélère la fondation. Votre équipe examine les cas de test générés, les affine pour la logique métier et les hiérarchise pour l'exécution. Ce qui prenait des jours prend maintenant des heures, et les lacunes de couverture se réduisent parce que l'IA vérifie systématiquement ce que les humains pourraient négliger.

bouton

Lorsque vous êtes prêt à automatiser, ces cas de test bien spécifiés se convertissent proprement en scripts de test. Les étapes claires et les résultats attendus servent de plan parfait pour votre framework d'automatisation, que vous utilisiez Postman, RestAssured ou Playwright.

Foire aux questions

Q1 : Un cas de test peut-il devenir directement un script de test ?

R : Oui, mais pas automatiquement. Un cas de test bien écrit fournit le plan d'un script de test – les étapes, les données et les résultats attendus se traduisent directement en code. Cependant, vous devez ajouter des détails techniques comme les localisateurs, la logique de configuration/démontage et les assertions. Considérez les cas de test comme le document d'exigences pour votre automatisation.

Q2 : Une approche est-elle meilleure que l'autre dans le débat Cas de test vs Script de test ?

R : Non, elles servent des objectifs différents. Les cas de test manuels excellent pour les tests exploratoires, UX et ad hoc où le jugement humain est important. Les scripts de test dominent pour les tests de régression répétitifs où la vitesse et la cohérence sont critiques. Les équipes matures utilisent les deux de manière stratégique, et non religieuse.

Q3 : Comment maintenons-nous la traçabilité entre les cas de test et les scripts de test ?

R : Utilisez un outil de gestion de tests qui relie les tests manuels et automatisés au même ID d'exigence. Dans le code de votre script, incluez des commentaires faisant référence à l'ID du cas de test (par exemple, // Automatisation pour TC_Login_001). Lorsque les exigences changent, interrogez votre système pour les tests manuels et automatisés liés afin d'évaluer l'impact.

Q4 : Les testeurs juniors devraient-ils écrire des scripts de test ?

R : Pas au début. Commencez-les par la rédaction manuelle de cas de test pour qu'ils acquièrent des connaissances du domaine et des fondamentaux des tests. Une fois qu'ils maîtrisent les bases de JavaScript ou de Python, associez-les à des ingénieurs en automatisation seniors pour co-écrire des scripts. Passer directement au script sans les fondamentaux des tests crée une automatisation fragile et inefficace.

Q5 : Comment Apidog gère-t-il la logique métier complexe dans la génération de cas de test ?

R : Apidog génère des cas de test de base complets basés sur les contrats d'API, mais il ne comprend pas vos règles métier uniques de manière autonome. Vous examinez et améliorez sa sortie en ajoutant de la logique conditionnelle, des appels API en chaîne et des validations spécifiques au métier. L'IA vous offre 80 % de couverture instantanément ; votre expertise fournit les 20 % restants qui comptent le plus.

Conclusion

La distinction entre cas de test et script de test ne consiste pas à choisir un camp, mais à utiliser le bon outil pour le travail. Les cas de test apportent clarté, couverture et jugement humain à votre effort de qualité. Les scripts de test apportent vitesse, répétabilité et intégration à votre pipeline de livraison.

Votre objectif devrait être une stratégie équilibrée : rédigez des cas de test clairs et traçables pour la couverture et l'exploration ; automatisez les plus critiques et stables en scripts maintenables. Et chaque fois que possible, utilisez des outils intelligents comme Apidog pour accélérer la création des deux.

La qualité survient lorsque vous faites des choix délibérés sur la manière dont vous testez, et pas seulement sur ce que vous testez. Comprendre la différence entre un cas de test et un script de test est la première étape vers ces choix délibérés et efficaces.

bouton