Si vous avez déjà remis un cas de test à un collègue pour n'entendre que : "Je ne comprends pas ce que cela signifie", alors vous savez déjà pourquoi la **spécification des cas de test** est importante. Nous sommes tous passés par là, à fixer une étape de test qui semblait parfaitement logique lorsque nous l'avons écrite, mais qui se lit maintenant comme une énigme. Des spécifications claires séparent les tests efficaces de l'effort gaspillé, pourtant de nombreuses équipes les traitent comme une réflexion après coup.

Ce guide vous montrera comment rédiger des documents de **spécification des cas de test** qui sont précis, exploitables et précieux pour tous ceux qui les utilisent. Que vous soyez un testeur cherchant à améliorer votre savoir-faire, un chef d'équipe visant à standardiser la production de votre équipe, ou un développeur qui souhaite comprendre ce qui est testé, vous trouverez des conseils pratiques qui fonctionnent dans le monde réel.

Qu'est-ce que la spécification des cas de test exactement ?

La **spécification des cas de test** est la documentation formelle d'un scénario de test unique, incluant son objectif, ses entrées, ses étapes d'exécution, ses résultats attendus et ses critères de réussite/échec. Pensez-y comme une recette que n'importe qui dans votre équipe peut suivre, qu'il ait écrit la fonctionnalité ou qu'il vienne de rejoindre le projet hier.

Une spécification bien conçue répond à cinq questions avant le début de l'exécution :

- Quel comportement spécifique testons-nous ?

- Quelles conditions doivent être en place avant de commencer ?

- Quelles actions précises effectuons-nous ?

- Comment savons-nous si le résultat est correct ?

- Qu'est-ce qui prouve que le test a réussi ou échoué ?

Sans réponses claires, vous ne testez pas, vous explorez. L'exploration a sa place, mais une assurance qualité reproductible et fiable exige une **spécification des cas de test** rigoureuse.

Pourquoi la spécification des cas de test mérite votre attention

L'effort que vous investissez dans la **spécification des cas de test** rapporte des dividendes tout au long du cycle de développement. Voici ce que vous gagnez :

- Clarté sous pression : Lorsque les délais sont serrés et les tensions montent, les tests ambigus sont mal exécutés ou totalement ignorés. Des spécifications claires survivent aux cycles de publication stressants car elles éliminent les incertitudes.

- Accélération de l'intégration : Les nouveaux membres de l'équipe peuvent apporter une contribution significative dès le premier jour lorsque les cas de test décrivent exactement ce qu'il faut faire. Vous réduisez le temps de jumelage et donnez aux gens les moyens de travailler de manière autonome plus rapidement.

- Reproduction des défauts : Lorsqu'un test échoue en CI à 2 heures du matin, des spécifications détaillées aident les développeurs à reproduire le problème sans vous réveiller. Les étapes, les données et les détails de l'environnement sont importants.

- Audit et conformité : Dans les secteurs réglementés, la **spécification des cas de test** n'est pas seulement utile, elle est obligatoire. Les auditeurs veulent la preuve que vous avez testé ce que vous avez déclaré avoir testé, et les cas de test vagues ne tiennent pas la route.

- Prêt pour l'automatisation : Les tests manuels avec des spécifications claires sont beaucoup plus faciles à automatiser ultérieurement. La logique, les données et les résultats attendus sont déjà définis ; il ne vous reste plus qu'à les traduire en code.

Composants essentiels de toute spécification de cas de test

Avant de parler des meilleures pratiques, harmonisons-nous sur les éléments non négociables. Une **spécification de cas de test** complète comprend :

| Composant | Objectif | Ce qu'il faut inclure |

|---|---|---|

| ID du cas de test | Identification unique | Une convention de nommage cohérente (par exemple, TC_Login_001) |

| Scénario de test | Description de haut niveau | Résumé en une ligne de ce qui est testé |

| Traçabilité des exigences | Lien vers la source | ID de l'exigence, user story ou référence au document de conception |

| Préconditions | Exigences de configuration | État des données, permissions utilisateur, configuration de l'environnement |

| Étapes de test | Séquence d'actions | Étapes numérotées et atomiques : action + entrée + cible |

| Données de test | Valeurs d'entrée | Noms d'utilisateur, montants, noms de fichiers spécifiques — jamais « données valides » |

| Résultat attendu | Critères de réussite | Sortie précise, état de l'interface utilisateur, modification de la base de données ou message d'erreur |

| Postconditions | Besoins de nettoyage | Comment restaurer le système à son état d'origine |

| Critères de réussite/échec | Norme de jugement | Condition mesurable qui élimine l'ambiguïté |

Négliger un composant invite à la confusion. Par exemple, écrire « Saisir des identifiants valides » comme étape force le testeur à chercher ce que signifie « valide ». Spécifiez plutôt le nom d'utilisateur et le mot de passe exacts.

Meilleures pratiques pour rédiger des spécifications de cas de test efficaces

Écrire une bonne **spécification de cas de test** est une compétence, pas un talent. Suivez ces pratiques pour vous améliorer immédiatement :

1. Rédigez pour un étranger

Imaginez que la personne qui exécute votre test ne sache rien de la fonctionnalité. Utilisez un langage simple, évitez le jargon et définissez tous les termes qui ne sont pas universellement compris. Si vous devez utiliser un acronyme, épellez-le d'abord.

2. Rendez les étapes atomiques

Chaque étape de test doit contenir une seule action. Au lieu de « Saisir le nom d'utilisateur et le mot de passe, puis cliquer sur connexion », divisez-la en trois étapes. Cela facilite le débogage en cas d'échec – vous savez exactement quelle action a échoué.

3. Spécifiez, n'impliquez pas

Ne supposez jamais que le testeur sait ce que vous voulez dire. « Vérifier que le rapport semble correct » est subjectif. « Vérifier que le rapport affiche l'ID de transaction, la date et le montant dans l'ordre » est objectif et vérifiable.

4. Couvrez les cas négatifs et limites

La plupart des testeurs rédigent naturellement des tests de chemin positif. Une **spécification de cas de test** solide inclut intentionnellement des entrées invalides, des données manquantes et des valeurs limites. Pensez à ce qui se passe lorsque les utilisateurs font tout de travers.

5. Contrôlez la version de vos spécifications

Les cas de test évoluent avec votre produit. Utilisez le même système de contrôle de version pour les spécifications que pour le code. Suivez les modifications, révisez les mises à jour et maintenez un historique. En cas d'échec d'un test, vous voulez savoir si la spécification a été modifiée récemment.

6. Standardisez au sein de l'équipe

Créez un modèle de **spécification de cas de test** et imposez son utilisation. La standardisation réduit la charge cognitive et accélère les révisions. Tout le monde sait où trouver les préconditions, les résultats attendus et les liens de traçabilité.

Pièges courants qui affaiblissent la spécification des cas de test

Même les testeurs expérimentés tombent dans ces pièges. Soyez attentif à ceux-ci dans votre propre travail :

- Résultats attendus vagues : « Le système devrait gérer la requête avec grâce » n'est pas un résultat. À quoi ressemble « avec grâce » ? Un message ? Une redirection ? Un événement journalisé ?

- Sur-spécification : Inclure des détails d'implémentation comme « Cliquer sur le bouton bleu avec l'ID #btn-123 » rend les tests fragiles. Lorsque l'interface utilisateur change, votre spécification est obsolète. Concentrez-vous sur les actions de l'utilisateur, pas sur les sélecteurs techniques.

- Manque de nettoyage des préconditions : Si votre test crée des données, spécifiez comment les supprimer. Les préconditions non nettoyées empoisonnent les tests ultérieurs et créent des défaillances en cascade.

- Pas de lien de traçabilité : Lorsqu'une exigence change, comment savoir quels tests mettre à jour ? Sans traçabilité, vous ne le savez pas. Liez chaque test à son exigence source.

- Supposer les connaissances du testeur : « Tester le flux de paiement comme d'habitude » suppose que tout le monde définit « d'habitude » de la même manière. Ce n'est pas le cas. Expliquez clairement.

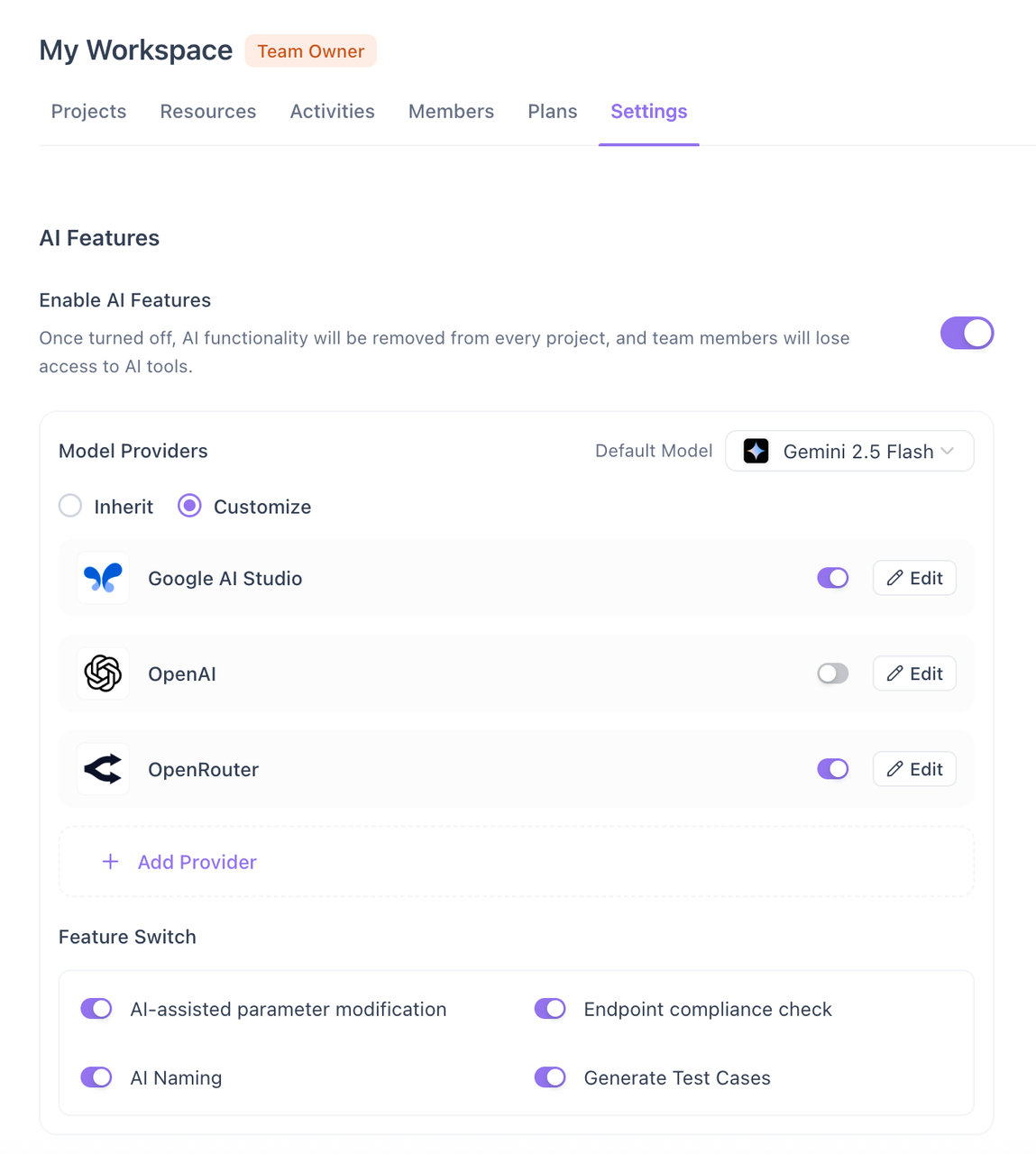

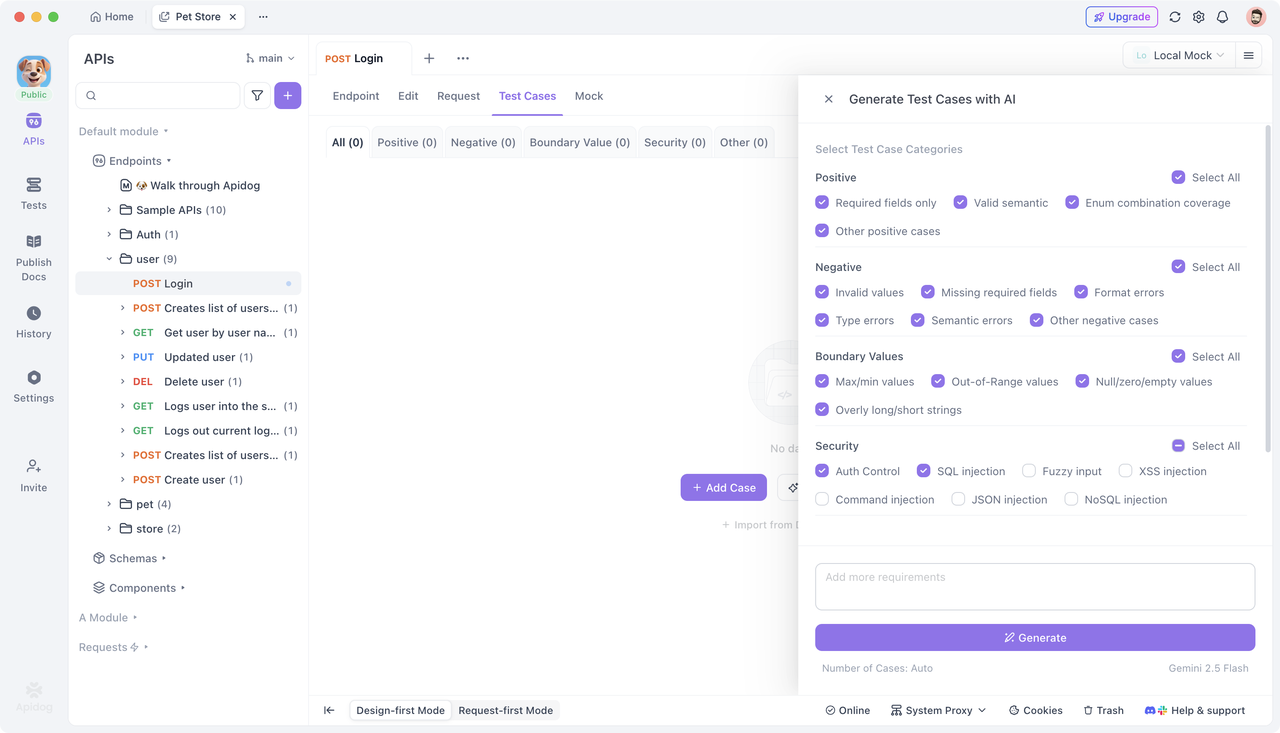

Comment Apidog rationalise la spécification des cas de test avec l'IA

Pour les tests d'API, la **spécification des cas de test** manuelle peut être particulièrement fastidieuse. Vous devez prendre en compte les codes de statut, les schémas de réponse, l'authentification, les en-têtes, les paramètres de requête et d'innombrables cas limites. Apidog transforme ce fardeau en un avantage concurrentiel.

En analysant votre documentation d'API ou vos points de terminaison en direct, Apidog peut générer automatiquement des cas de test complets à l'aide de l'IA.

Il crée des tests positifs pour les chemins de réussite, des tests négatifs pour les entrées invalides, des tests de limites pour les champs numériques et des tests de sécurité pour les cas limites d'authentification. Chaque spécification inclut des entrées précises, des sorties attendues et des assertions, prêtes pour la révision et l'exécution.

Au lieu de partir de zéro, votre équipe examine les brouillons de **spécification de cas de test** générés par l'IA, les affinant pour le contexte métier plutôt que pour la couverture de base. Cette approche garantit la cohérence, élimine les erreurs humaines et réduit le temps de spécification jusqu'à 70 %. Le résultat est une suite de tests de meilleure qualité qui s'aligne sur votre contrat d'API dès le premier jour.

Foire aux questions

Q1 : Quel degré de détail doit avoir une spécification de cas de test pour les tests exploratoires ?

R : Les tests exploratoires valorisent la liberté, mais même ici, la **spécification des cas de test** joue un rôle. Créez des spécifications basées sur des chartes qui définissent la mission, la portée et le temps imparti sans scénariser chaque étape. Par exemple : « Explorer le flux de paiement en utilisant des cartes de crédit invalides pendant 60 minutes, en se concentrant sur la gestion des erreurs. » Cela offre une structure tout en préservant l'autonomie du testeur.

Q2 : À qui appartient la spécification du cas de test – à l'auteur ou à l'équipe ?

R : Elle appartient à l'équipe. Bien que l'auteur rédige la version initiale, le **processus de révision des cas de test** en fait un artefact partagé. Une fois validée, n'importe qui peut proposer des mises à jour via votre flux de travail de contrôle de version. La propriété collective prévient les silos de connaissances et garantit que les spécifications restent à jour.

Q3 : Les localisateurs d'interface utilisateur doivent-ils être inclus dans les spécifications de cas de test ?

R : Généralement, non. Les spécifications doivent se concentrer sur les actions de l'utilisateur et les résultats attendus. Les localisateurs appartiennent aux objets de page de votre couche d'automatisation, et non aux spécifications lisibles par l'homme. Cette séparation maintient la stabilité des spécifications lorsque l'implémentation de l'interface utilisateur change et les rend accessibles aux testeurs manuels qui ne se soucient pas des sélecteurs CSS.

Q4 : Comment maintenons-nous les spécifications de cas de test lorsque les exigences changent fréquemment ?

R : Utilisez la traçabilité des exigences comme boussole. Lorsqu'une exigence change, interrogez votre outil de gestion des tests pour tous les cas de test liés et examinez-les lors d'une session ciblée. Le contrôle de version vous aide à suivre l'historique des spécifications, et des outils automatisés comme Apidog peuvent régénérer les spécifications de test API après des modifications de points de terminaison, signalant les différences pour examen humain.

Q5 : Pouvons-nous réutiliser les spécifications de cas de test entre les projets ?

R : Oui, pour les fonctions courantes comme la connexion, la recherche ou les mises à jour de profil utilisateur. Maintenez une bibliothèque de modèles de **spécifications de cas de test** standardisés pour ces modèles. Lors de la réutilisation, examinez-les et adaptez-les toujours au contexte et aux données spécifiques du projet. Réutilisez la structure, pas aveuglément le contenu.

Conclusion

Maîtriser la **spécification des cas de test** est l'une des compétences les plus précieuses qu'un professionnel de la qualité logicielle puisse développer. Elle comble le fossé entre l'intention et l'exécution, entre les exigences et la validation, entre l'espoir et la confiance. Lorsque les spécifications sont claires, complètes et collaboratives, toute votre équipe avance plus vite avec moins de surprises.

Commencez par auditer vos spécifications actuelles par rapport aux composants et aux meilleures pratiques décrits ici. Choisissez une amélioration — peut-être l'ajout de liens de traçabilité ou la décomposition d'étapes composées — et appliquez-la de manière cohérente pendant un mois. Les résultats parleront d'eux-mêmes. La qualité n'arrive pas par accident ; elle arrive par spécification.