Chaque équipe logicielle souhaite livrer des produits de haute qualité, mais voici la dure vérité : même les testeurs les plus qualifiés écrivent des cas de test imparfaits. Un test peut manquer un cas limite critique, utiliser un langage peu clair, ou même dupliquer les efforts d'une autre suite. Ces problèmes ne font pas que gaspiller du temps ; ils laissent des bugs se glisser en production. C'est là qu'un processus de revue des cas de test discipliné devient votre filet de sécurité.

Si vous vous êtes déjà demandé si vos cas de test étaient suffisamment bons, ou si vous en avez marre de ne découvrir les lacunes qu'après la mise en ligne d'une fonctionnalité, ce guide vous guidera à travers un flux de travail de revue éprouvé qui détecte les problèmes tôt, couvre les outils de test modernes comme Apidog et construit une suite de tests à laquelle vous pouvez faire confiance.

Qu'est-ce qu'un processus de revue des cas de test ?

Un processus de revue des cas de test est une évaluation structurée des cas de test avant que quiconque ne les exécute. Considérez-le comme une porte de qualité pour votre assurance qualité. L'objectif est simple : s'assurer que chaque cas de test est clair, correct, complet et étroitement aligné sur les exigences. Lorsqu'il est bien fait, ce processus révèle des défauts dans la conception du test elle-même (par exemple, des scénarios manquants, des résultats attendus incorrects ou des étapes peu claires) afin que vous puissiez les corriger avec un minimum de retouches.

Plutôt que de traiter les cas de test comme des artefacts jetables, un processus de revue approprié les traite comme une documentation vivante qui mérite le même examen que le code de production. C'est la différence entre espérer que vos tests fonctionnent et savoir qu'ils fonctionneront.

Pourquoi le processus de revue des cas de test est-il réellement important ?

Le processus de revue des cas de test n'est pas de la paperasse pour la paperasse. Il apporte une valeur mesurable :

- Améliore la précision et la couverture en vérifiant systématiquement que tous les chemins fonctionnels, les cas limites, et les scénarios positifs et négatifs correspondent aux exigences documentées. Fini de deviner si vous avez tout couvert.

- Réduit considérablement les retouches et les coûts. Trouver des problèmes pendant la conception des tests coûte des centimes par rapport à les découvrir pendant l'exécution — ou pire, après la sortie lorsque les clients les trouvent en premier.

- Renforce la collaboration d'équipe en forçant les conversations entre les testeurs, les développeurs et les parties prenantes métier. Ces discussions mettent en évidence les malentendus sur les exigences avant que le code ne soit écrit.

- Applique la cohérence à travers votre pratique de test. Des modèles, une terminologie et des approches standards rendent votre suite de tests maintenable à mesure que les équipes évoluent et que les projets progressent.

Sauter la revue peut sembler plus rapide au début, mais c'est un cas classique de "mesurer deux fois, couper une fois". L'heure que vous passez à revoir permet d'économiser des jours de débogage plus tard.

Qui devrait participer à une revue de cas de test ?

Les revues efficaces sont, par conception, multi-parties prenantes. Différentes perspectives détectent différents problèmes. Voici qui devrait être dans la pièce :

| Rôle | Objectif Principal | Valeur Apportée |

|---|---|---|

| Responsables/Chefs de Test | Alignement avec la stratégie de test et les objectifs du projet | Garantit que les tests servent les objectifs métier, pas seulement les cases à cocher techniques |

| Pairs/Testeurs Seniors | Correction technique, validité des données, profondeur de la couverture | Détecte les erreurs logiques, suggère des scénarios oubliés, valide les données de test |

| Développeurs | Faisabilité technique et alignement avec l'implémentation | Signale les tests qui ne peuvent pas être automatisés, identifie les contraintes architecturales |

| Analystes Métier/Product Owners | Couverture des règles métier et validation des scénarios utilisateur | Confirme que les tests reflètent les besoins réels des utilisateurs et les exigences réglementaires |

La magie opère lorsque ces voix se confrontent. Un développeur peut remarquer qu'un test suppose un état impossible. Un chef de produit peut réaliser qu'une règle métier critique n'a jamais été traduite en scénario de test. Le processus de revue des cas de test prospère grâce à cette friction constructive.

Le flux de travail de revue des cas de test en sept étapes

Un processus de revue des cas de test reproductible suit une séquence claire. Voici comment l'exécuter efficacement :

Étape 1 : Préparation

Rassemblez les derniers cas de test et vérifiez qu'ils reflètent les exigences actuelles de votre SRS, FRD ou récits utilisateurs. Effectuez une vérification rapide d'entrée : Les cas de test sont-ils suffisamment complets pour être examinés, ou nécessitent-ils d'abord un nettoyage de base ? Une revue prématurée fait perdre du temps à tout le monde.

Étape 2 : Attribution des relecteurs et éventuel lancement

Sélectionnez les relecteurs en fonction de la complexité de la fonctionnalité et du domaine technique. Pour les fonctionnalités majeures, organisez une réunion de lancement de 15 minutes pour expliquer la portée, les objectifs et les documents de référence. Cela permet d'aligner tout le monde avant qu'ils ne se plongent dans la revue individuelle.

Étape 3 : Préparation individuelle

Chaque relecteur examine indépendamment les cas de test en utilisant des listes de contrôle et des normes. Ils notent les défauts, les questions sur l'ambiguïté des exigences et les suggestions pour une meilleure couverture. Ce travail individuel garantit que les nouvelles perspectives ne sont pas diluées par la pensée de groupe.

Étape 4 : Session ou réunion de revue

Le groupe se réunit — virtuellement ou en personne — pour discuter des résultats. L'auteur parcourt les cas de test tandis que les relecteurs posent des questions et remettent en question les hypothèses. Le modérateur enregistre les défauts en temps réel, en se concentrant sur la clarification de l'intention plutôt que sur la défense de l'ego.

Étape 5 : Enregistrement et classification des défauts

Tous les problèmes ne sont pas égaux. Classez-les pour prioriser la reprise :

- Critique : Couverture manquante pour les fonctionnalités essentielles ou les chemins critiques pour la sécurité.

- Majeur : Résultats attendus incorrects ou scénarios négatifs manquants qui pourraient cacher des bogues.

- Mineur : Problèmes de grammaire, fautes de frappe ou incohérences de formatage qui réduisent la clarté.

Les défauts typiques incluent des préconditions incomplètes, des données de test erronées, des tests de limites manquants ou des cas de test qui ne correspondent plus à la fonctionnalité implémentée.

Étape 6 : Retravail

L'auteur met à jour les cas de test pour corriger les défauts enregistrés. Il ne s'agit pas seulement de corriger des fautes de frappe, mais d'améliorer la clarté, d'étendre la couverture et parfois de fusionner des tests redondants. L'objectif est une suite légère et efficace, pas une suite gonflée.

Étape 7 : Suivi et vérification

Un modérateur ou un responsable vérifie que toutes les modifications convenues ont été appliquées correctement. Une fois satisfait, les parties prenantes donnent leur approbation formelle, et les cas de test sont mis à jour dans votre référentiel. Cette étape de clôture évite les cycles de révision sans fin.

Construire un référentiel centralisé de cas de test

Votre processus de revue des cas de test n'est aussi bon que ce qui se passe après l'approbation. Les cas de test approuvés doivent résider dans un référentiel centralisé avec contrôle de version. Il ne s'agit pas seulement de classer des documents, mais de créer un actif réutilisable.

Un référentiel bien géré permet :

- La traçabilité : Lier les tests aux exigences et aux défauts, afin que vous sachiez exactement pourquoi un test existe.

- La réutilisabilité : Les tests de régression deviennent du "plug-and-play" au lieu de "réécrire tout".

- La cohérence : Les nouveaux membres de l'équipe apprennent vos standards par l'exemple.

- La collaboration : Plusieurs équipes peuvent contribuer sans se marcher sur les pieds.

Lorsque le référentiel devient la source unique de vérité, le processus de revue des cas de test se transforme d'une activité ponctuelle en une fondation pour une qualité continue.

Techniques de revue courantes adaptées à votre équipe

Toutes les équipes n'ont pas besoin d'inspections formelles. Choisissez la technique qui correspond à votre maturité et à votre calendrier :

- Auto-revue : L'auteur vérifie son propre travail par rapport aux exigences et aux directives. Bon pour un contrôle rapide de bon sens, mais sujet aux angles morts.

- Revue par les pairs : Un autre testeur effectue une revue en utilisant une approche "créateur-vérificateur". Équilibre la rigueur et la rapidité.

- Revue de supervision : Les responsables de test effectuent des inspections formelles à l'aide de listes de contrôle détaillées. Idéal pour les fonctionnalités à haut risque.

- Walkthroughs : L'auteur présente les cas de test à l'équipe, qui les affine collectivement. Excellent pour le partage des connaissances.

De nombreuses équipes utilisent une approche hybride : des revues par les pairs pour les fonctionnalités courantes, des walkthroughs pour les nouvelles fonctionnalités complexes et des revues de supervision avant les versions majeures.

Rationalisation du processus de revue des cas de test avec Apidog

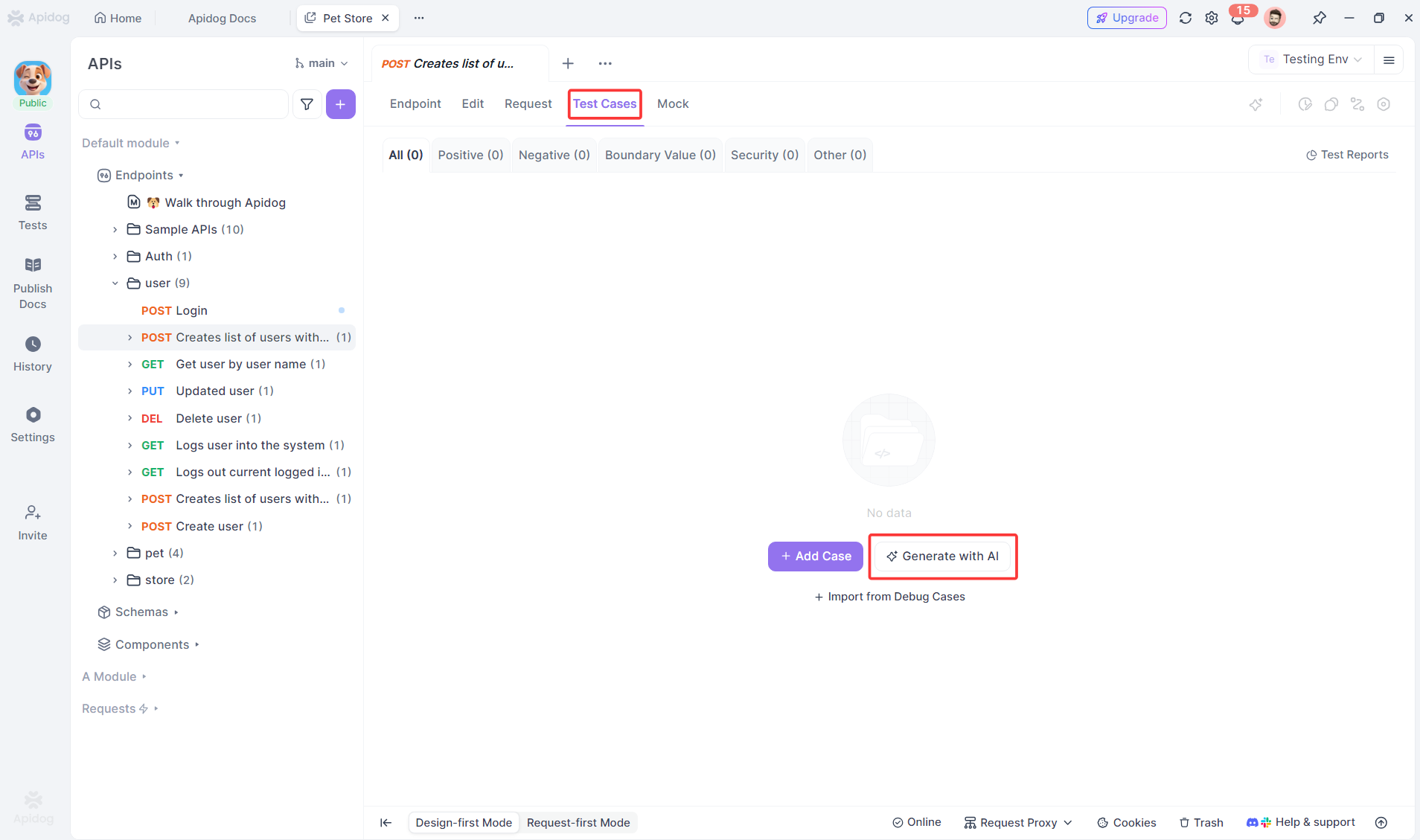

Pour les tests d'API, le processus de revue des cas de test peut être considérablement rationalisé avec des outils modernes. Apidog automatise la lourde tâche de création de cas de test, offrant aux relecteurs un point de départ solide au lieu d'une page blanche.

Cas de test générés par l'IA à partir de spécifications API

Grâce à l'analyse alimentée par l'IA, Apidog génère des cas de test complets pour vos points d'accès API en examinant les paramètres de requête, les schémas de réponse et les règles métier. Lorsque vous importez une spécification OpenAPI dans Apidog, vous pouvez générer automatiquement des tests positifs, des tests négatifs, des tests de sécurité et des scénarios de cas limites à l'aide de l'IA.

Au lieu d'écrire manuellement des dizaines de tests pour les valeurs limites, les vérifications de nullité et les scénarios d'erreur, Apidog les crée instantanément.

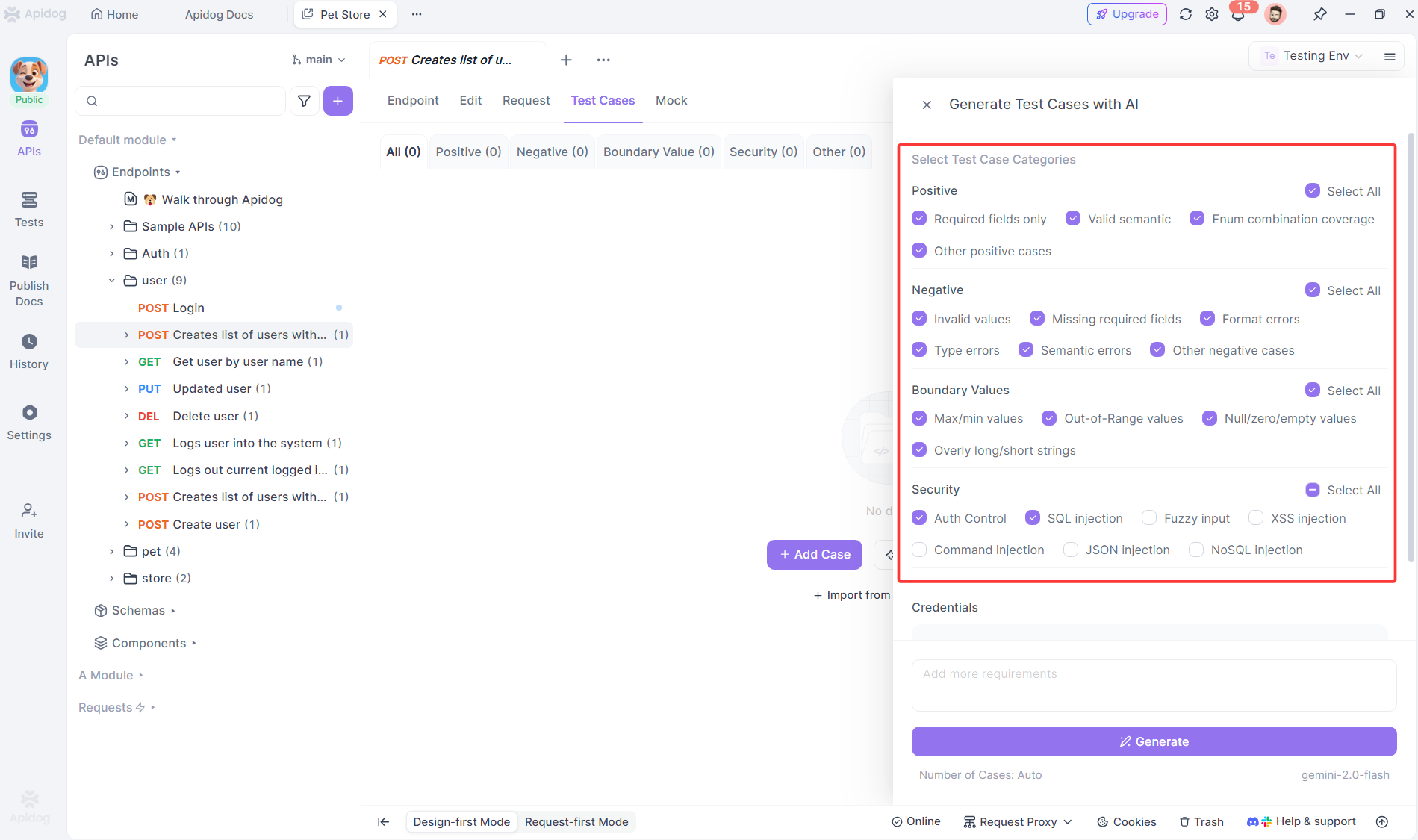

Extension intelligente des cas de test

Mais les capacités d'IA d'Apidog vont au-delà de la génération initiale. La plateforme peut désormais générer intelligemment des cas de test supplémentaires basés sur vos cas de test de points d d'accès existants, transformant la façon dont les équipes étendent leur couverture de tests d'API pendant le processus de revue.

Lorsque vous avez des cas de test existants pour un point d'accès, l'IA d'Apidog analyse vos modèles de test actuels, les combinaisons de paramètres et la logique de validation pour générer automatiquement des scénarios de test complémentaires que vous auriez pu manquer. L'IA examine vos cas de test existants et identifie les lacunes de couverture — générant des tests de valeurs limites, des scénarios négatifs, des cas extrêmes et des conditions d'erreur qui suivent les mêmes modèles que vos tests créés actuels, accélérant considérablement votre processus de revue des cas de test.

Questions Fréquemment Posées

Q1. Combien de temps devrait durer une session de revue de cas de test typique ?

Rép : Une session de revue ciblée devrait durer de 30 à 60 minutes. Si vous avez besoin de plus de temps, divisez la revue en plusieurs sessions couvrant différentes zones fonctionnelles. Les réunions plus longues entraînent la fatigue et des problèmes manqués. La clé est la préparation — les relecteurs bien préparés effectuent une analyse individuelle préalable, de sorte que le temps de réunion est consacré à la discussion, et non à une lecture silencieuse.

Q2. Pouvons-nous toujours effectuer des revues de cas de test dans un environnement Agile avec des sprints courts ?

Rép : Absolument. En fait, l'Agile rend les revues encore plus critiques. Intégrez-les à votre définition du "done" : un récit utilisateur n'est pas terminé tant que ses cas de test n'ont pas été revus et approuvés. Utilisez des revues par les pairs légères pour les récits de routine et réservez les walkthroughs pour les fonctionnalités complexes. L'investissement en temps est rentabilisé pendant l'exécution du sprint lorsque moins de bogues perturbent votre vélocité.

Q3. Que faire si les relecteurs ne sont pas d'accord sur la nécessité d'un cas de test ?

Rép : Le désaccord est sain. Documentez la justification de la décision dans votre outil de gestion des tests. Si le litige concerne la priorité métier, escaladez au propriétaire du produit. S'il s'agit de faisabilité technique, laissez le développeur et le testeur travailler en binôme sur un compromis. Le processus de revue des cas de test devrait faire émerger ces débats tôt, et non les supprimer.

Q4. Comment éviter que le processus de revue ne devienne un goulot d'étranglement ?

Rép : Établissez des critères d'entrée et de sortie clairs. N'envoyez pas des cas de test bâclés pour examen. Utilisez des revues par les pairs plus petites et asynchrones pour les fonctionnalités simples. Automatisez ce que vous pouvez — des outils comme Apidog génèrent instantanément des cas de test à l'aide de l'IA, réduisant ainsi le temps de rédaction manuelle. Suivez le temps de traitement des revues dans vos métriques de projet et abordez les retards de manière proactive.

Q5. Devons-nous examiner les scripts de test automatisés de la même manière que les cas de test manuels ?

Rép : Oui, mais avec une approche technique. Les scripts automatisés doivent être examinés pour leur qualité de code, leur maintenabilité et leur vitesse d'exécution, en plus de la couverture. Incluez les développeurs dans ces revues pour faire respecter les normes de codage et suggérer des localisateurs plus stables. La logique et la couverture doivent toujours correspondre aux exigences, tout comme pour les tests manuels.

Conclusion

Un processus de revue des cas de test discipliné est l'un des investissements les plus rentables qu'une équipe logicielle puisse faire. Il transforme les tests d'une chasse aux bugs réactive en une stratégie de qualité proactive. En suivant le flux de travail en sept étapes, en impliquant les bonnes parties prenantes et en tirant parti des outils modernes comme Apidog pour la génération de tests d'API, vous construisez une suite de tests qui détecte les défauts réels et gagne la confiance de l'équipe.

Commencez petit. Choisissez une fonctionnalité pour une revue pilote. Mesurez les bogues que vous prévenez. Au fur et à mesure que les avantages deviennent évidents, étendez la pratique à tous vos projets. La qualité n'est pas un accident — c'est le résultat de processus délibérés, et le processus de revue des cas de test est la pierre angulaire de cette approche délibérée.