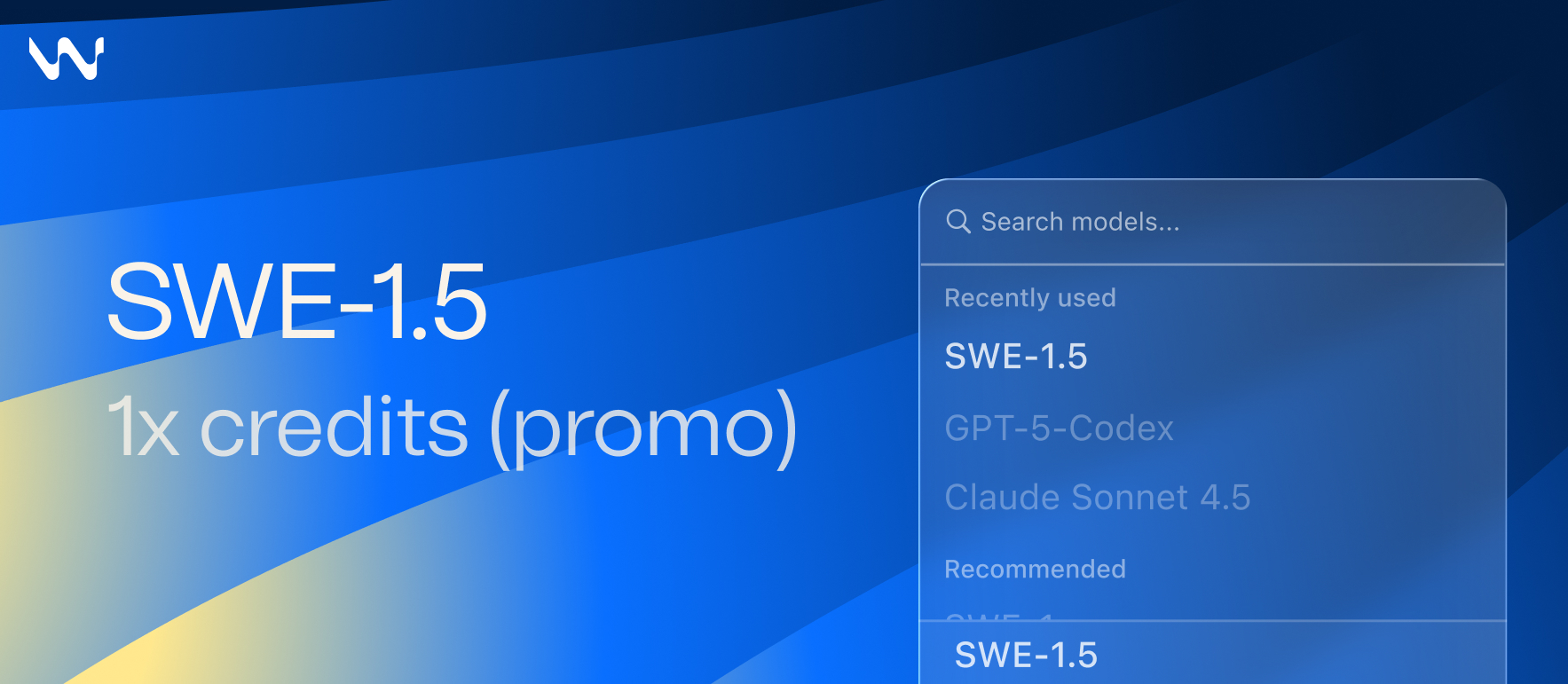

Les développeurs recherchent constamment des outils qui accélèrent les flux de travail sans sacrifier la qualité. Cognition offre exactement cela avec la sortie de SWE-1.5, désormais disponible sur Windsurf. Ce modèle d'IA avancé optimise les tâches d'ingénierie logicielle, permettant une génération de code et une résolution de problèmes plus rapides. Les ingénieurs intègrent de tels modèles dans leurs environnements via des API, garantissant des interactions fluides et des performances fiables.

Les ingénieurs de Cognition ont conçu SWE-1.5 pour relever un défi majeur du codage assisté par l'IA : l'équilibre entre des temps de réponse rapides et des résultats intelligents. De plus, ce modèle marque une avancée significative dans les systèmes basés sur des agents, où la vitesse a un impact direct sur l'expérience utilisateur. À mesure que les équipes adoptent SWE-1.5 sur Windsurf, elles constatent une latence réduite dans les tâches allant du débogage à la création d'applications full-stack. Cependant, y parvenir a nécessité des partenariats innovants et des mises à niveau d'infrastructure, que nous explorerons ensuite.

Comprendre SWE-1.5 : un modèle de taille "Frontière" conçu pour l'ingénierie logicielle

Cognition développe SWE-1.5 comme un modèle spécialisé avec des centaines de milliards de paramètres, se concentrant exclusivement sur les applications d'ingénierie logicielle. Les développeurs bénéficient de sa capacité à gérer efficacement des bases de code complexes. Par exemple, le modèle traite les requêtes et génère des réponses à des vitesses qui rivalisent avec les processus de pensée humaine, ce qui le rend idéal pour la collaboration en temps réel.

SWE-1.5 intègre un apprentissage par renforcement de bout en bout, entraîné sur des environnements de tâches réels. Cette approche garantit que le modèle s'adapte à divers langages de programmation et scénarios. Les ingénieurs de Cognition ont itéré en permanence sur l'architecture du modèle, affinant son harnais et ses outils pour maximiser les performances. Par conséquent, les utilisateurs de Windsurf accèdent à un système qui non seulement pense rapidement, mais fournit également des solutions précises.

La conception du modèle met l'accent sur l'unification : il combine l'IA centrale avec des moteurs d'inférence et l'orchestration des agents. Cette intégration élimine les goulots d'étranglement courants dans les systèmes disjoints. En conséquence, SWE-1.5 surpasse les modèles à usage général dans les tâches spécialisées. Les développeurs qui le déploient constatent des améliorations immédiates de la productivité, comme l'édition de fichiers de configuration en quelques secondes plutôt qu'en quelques minutes.

Le partenariat avec Cerebras : propulser des vitesses d'inférence inégalées

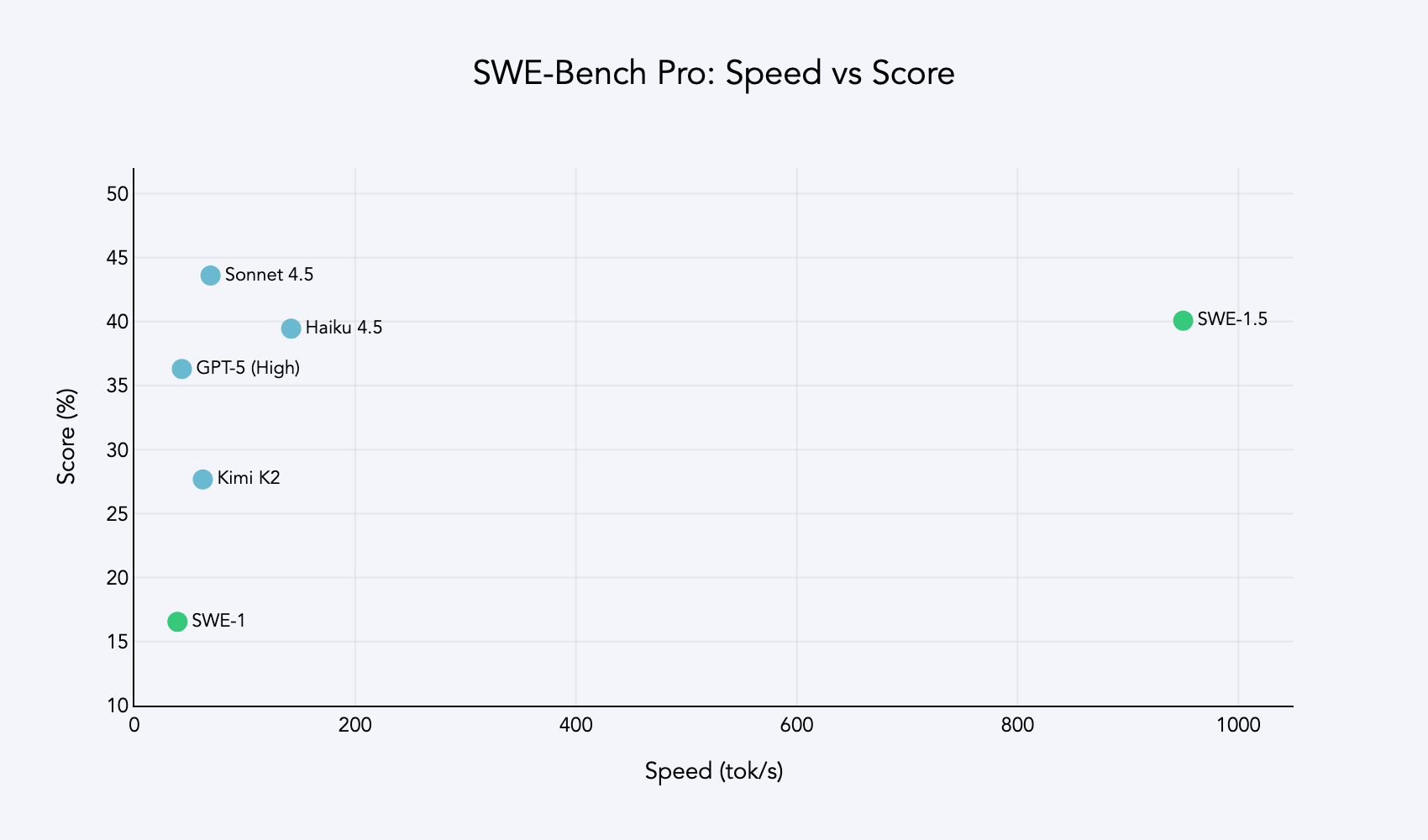

Cognition s'associe à Cerebras pour atteindre des vitesses d'inférence allant jusqu'à 950 tokens par seconde dans SWE-1.5. Cette collaboration exploite du matériel avancé pour repousser les limites des performances de l'IA. Plus précisément, la technologie de Cerebras permet un décodage spéculatif et une génération de tokens optimisée, ce qui accélère la sortie du modèle sans compromettre la qualité.

De plus, cet avantage de vitesse positionne SWE-1.5 comme 6 fois plus rapide que Haiku 4.5 et 13 fois plus rapide que Sonnet 4.5. Les ingénieurs mesurent ces gains en termes pratiques : des tâches qui prenaient autrefois 20 secondes sont maintenant terminées en moins de cinq. Une telle efficacité s'inscrit dans la "fenêtre de flux", où les développeurs maintiennent leur concentration sans interruption.

Cependant, la réalisation de ces vitesses a nécessité des optimisations à l'échelle du système. Cognition a réécrit les outils essentiels à partir de zéro, réduisant la surcharge de la vérification de lint et de l'exécution des commandes. Ces améliorations profitent à tous les modèles sur Windsurf, créant un écosystème plus réactif. Par conséquent, les utilisateurs bénéficient d'interactions fluides, qu'il s'agisse d'explorer de grands référentiels ou d'automatiser des corrections de routine.

Benchmarks qui distinguent SWE-1.5 : dominer SWE-Bench Pro

SWE-1.5 excelle sur le benchmark SWE-Bench Pro de Scale AI, atteignant des résultats quasi-état de l'art sur des tâches difficiles. Cet ensemble de données teste les modèles sur diverses bases de code, simulant des problèmes d'ingénierie logicielle réels. Le modèle de Cognition complète ces évaluations en une fraction du temps requis par les concurrents, soulignant son efficacité.

De plus, les benchmarks internes de Cognition révèlent des avantages pratiques. Par exemple, les ingénieurs utilisent SWE-1.5 pour créer rapidement des applications full-stack, intégrant des composants frontend et backend avec une intervention manuelle minimale. Les performances du modèle sur des métriques comme le nombre minimum de retweets ou les filtres d'engagement dans les outils connexes soulignent sa robustesse.

En outre, les comparaisons avec les modèles précédents montrent des améliorations marquées. SWE-1.5 réduit les taux d'erreur dans les appels d'outils et améliore la qualité du code grâce à une notation basée sur des rubriques. Les développeurs apprécient la façon dont il gère les cas extrêmes, tels que les modifications de manifestes Kubernetes, avec précision. En conséquence, les équipes sur Windsurf l'adoptent pour des projets critiques, confiantes dans sa fiabilité.

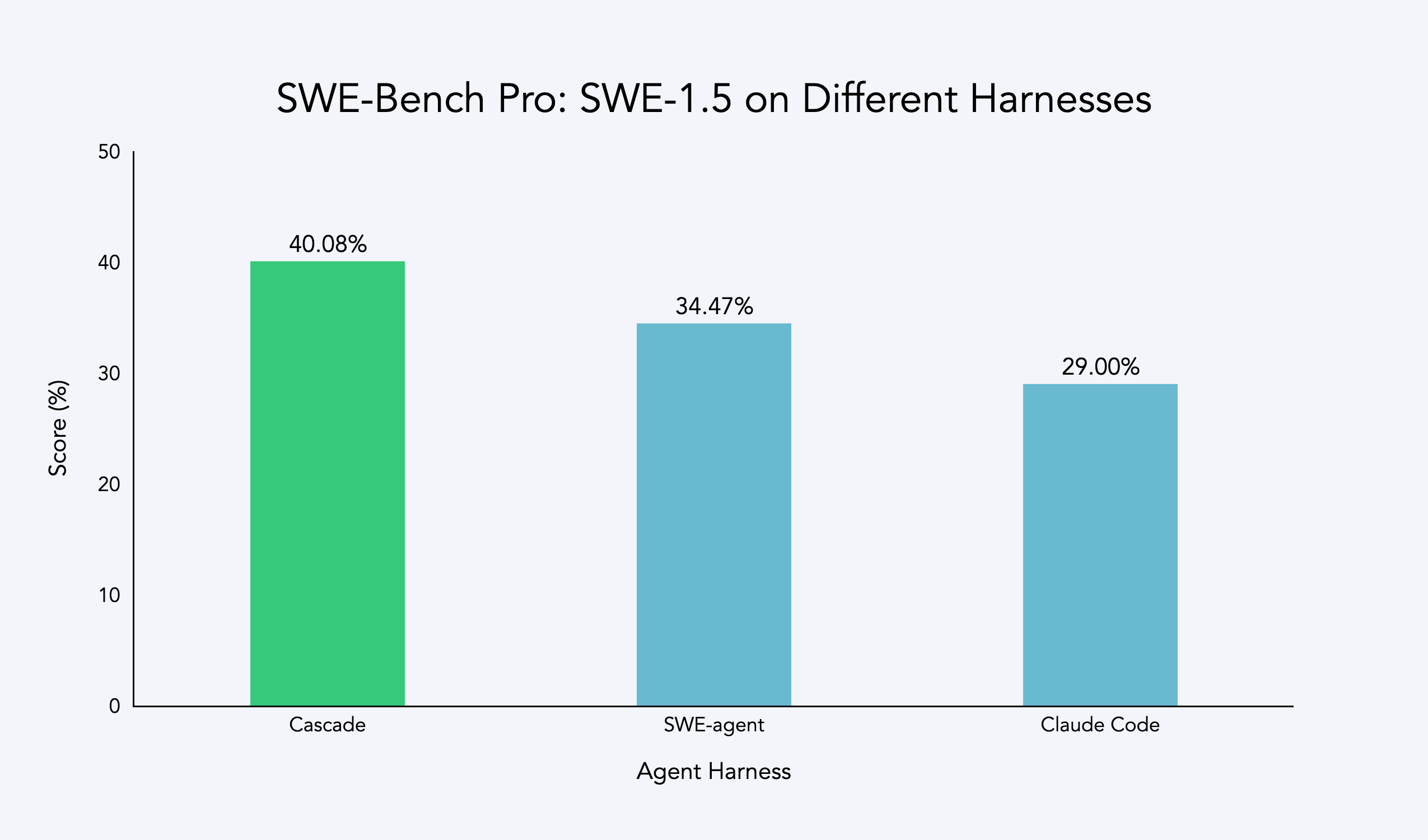

Le harnais d'agent Cascade : fondement de l'intelligence de SWE-1.5

Cognition développe le harnais d'agent Cascade spécifiquement pour SWE-1.5, permettant une co-optimisation du modèle et de l'orchestration. Ce harnais facilite l'apprentissage par renforcement sur des trajectoires multi-tours, garantissant que l'IA gère efficacement les interactions étendues.

De plus, le harnais intègre des outils réécrits pour la vitesse, s'adaptant à un temps d'exécution 10 fois plus rapide du modèle. Les ingénieurs surveillent les performances via des déploiements bêta, recueillant des données sur des métriques telles que le débit de tokens et la précision des réponses. Ce processus itératif affine le système, éliminant les faiblesses identifiées dans les versions précédentes.

Cependant, des défis sont apparus pendant le développement, tels que des échecs d'appels d'outils dans des configurations alternatives. Cognition les a résolus en améliorant la compatibilité du harnais, ce qui a conduit à des évaluations supérieures. Par conséquent, SWE-1.5 fonctionne de manière optimale sur Windsurf, où les utilisateurs exploitent toutes ses capacités pour des tâches telles que l'exploration de bases de code via Codemaps.

Infrastructure de formation : mise à l'échelle avec les puces GB200 et Otterlink

Cognition entraîne SWE-1.5 sur des milliers de puces GB200 NVL72, marquant l'une des premières utilisations en production de ce matériel. Un accès anticipé en juin 2025 a permis à l'équipe de construire des systèmes tolérants aux pannes et d'optimiser les communications NVLink.

De plus, l'hyperviseur Otterlink VM met à l'échelle les environnements à des dizaines de milliers de machines concurrentes, alignant la formation sur les réalités de la production. Cette configuration reflète les charges de travail de Devin et Windsurf, garantissant que le modèle se généralise bien.

En outre, le processus de formation utilise un gradient de politique non biaisé pour la stabilité sur de longues séquences. Les ingénieurs sélectionnent les modèles de base par des évaluations rigoureuses, appliquant un RL post-formation pour un réglage fin pour l'ingénierie logicielle. En conséquence, SWE-1.5 apparaît comme un outil robuste, prêt à être déployé sur Windsurf.

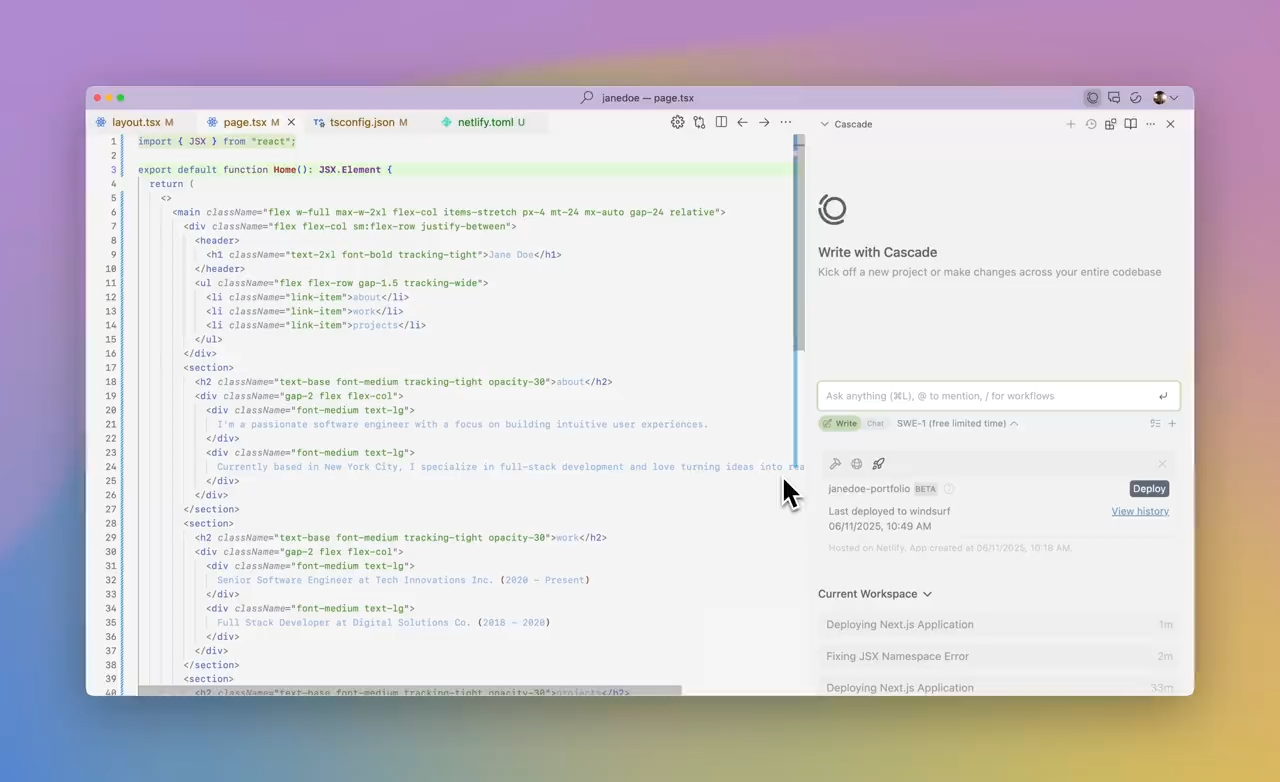

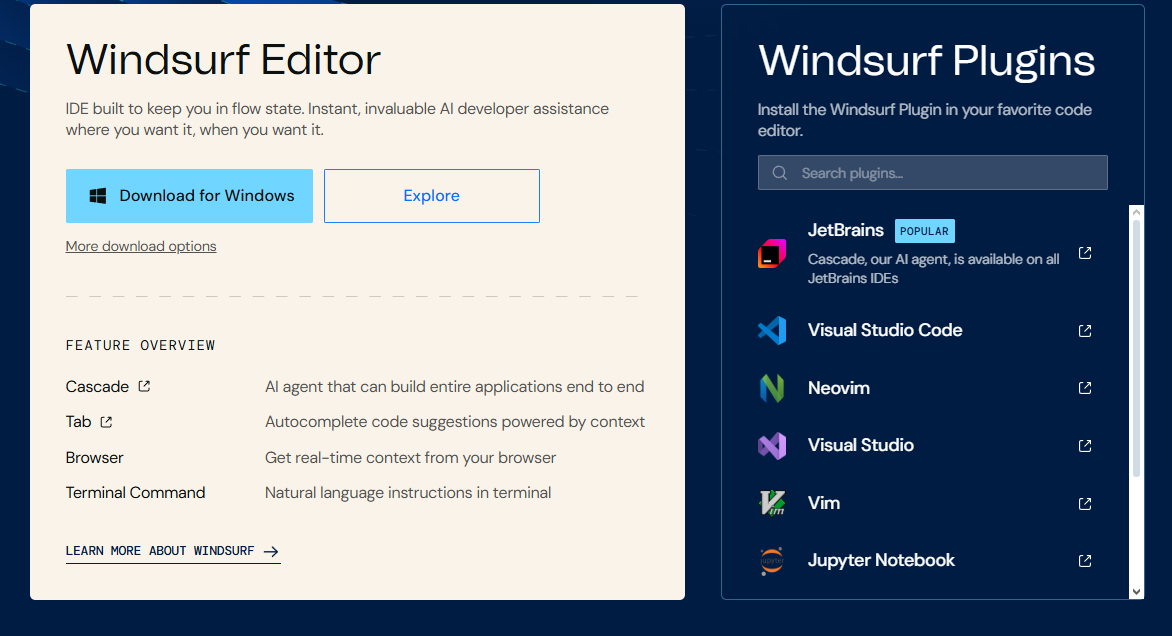

Disponibilité sur Windsurf : intégration transparente pour les développeurs

Cognition rend SWE-1.5 disponible sur Windsurf dès aujourd'hui. Cette plateforme intègre profondément le modèle, offrant des fonctionnalités comme Codemaps pour naviguer dans de grandes bases de code.

De plus, l'acquisition de Windsurf par Cognition améliore la compatibilité, permettant aux utilisateurs de déployer SWE-1.5 dans des environnements familiers. Les développeurs le téléchargent et le configurent facilement, bénéficiant de systèmes de priorité de requête personnalisés pour des sessions fluides.

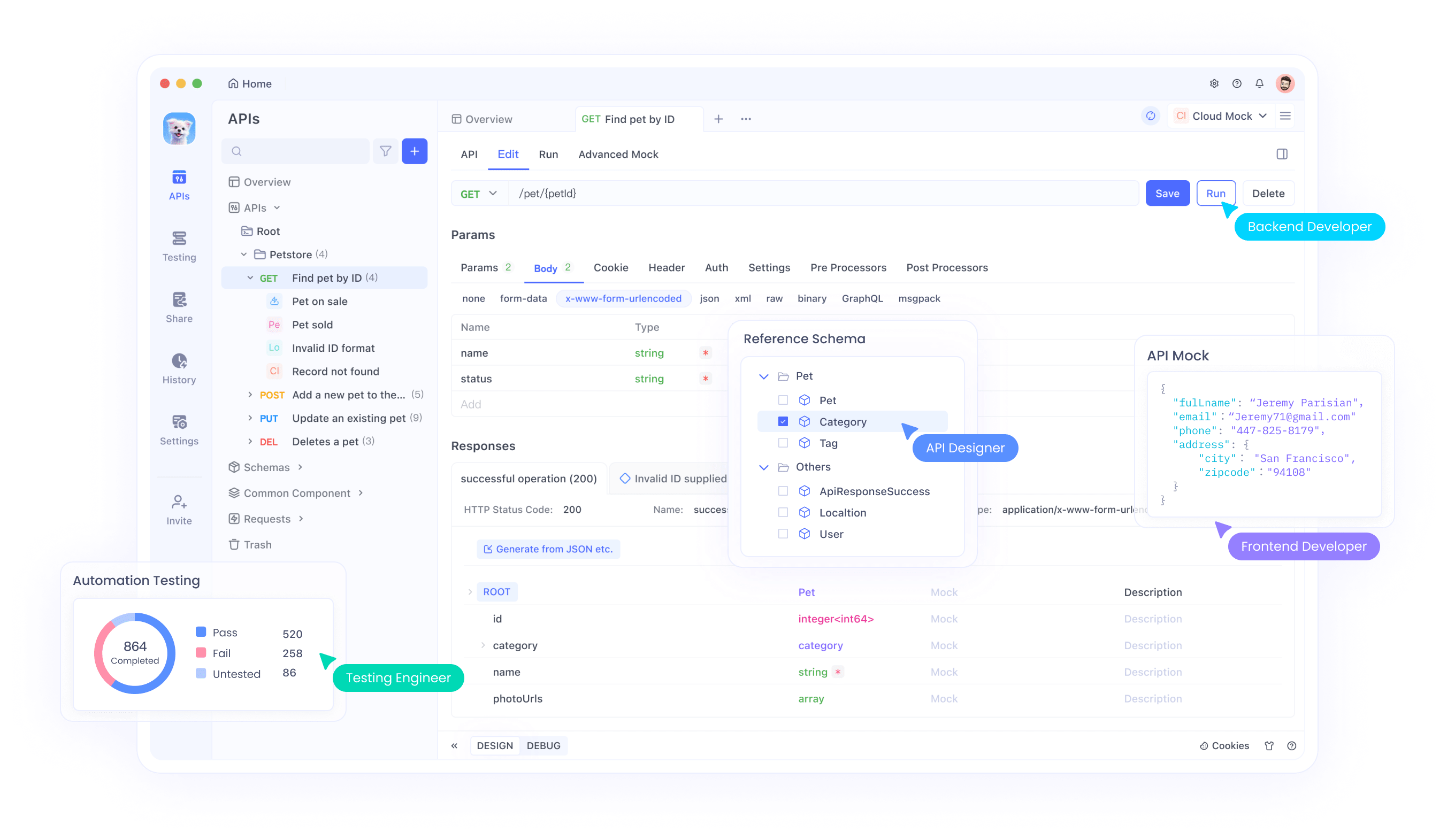

Cependant, pour maximiser son potentiel, les équipes le combinent avec des outils API. Comme mentionné précédemment, le téléchargement gratuit d'Apidog aide à gérer les intégrations, garantissant que les API connectées à SWE-1.5 fonctionnent parfaitement.

Surmonter les défis : du test bêta à la production

Cognition déploie plusieurs versions bêta de SWE-1.5, nommées "Falcon Alpha", pour recueillir des retours du monde réel. Les ingénieurs testent le modèle en interne, identifiant les domaines à améliorer.

De plus, le renforcement des récompenses empêche la manipulation des évaluateurs, garantissant de véritables gains de performance. Des experts humains examinent attentivement les résultats, affinant les évaluateurs pour plus de précision.

Cependant, des obstacles initiaux tels que des retards système ont entraîné des réécritures, renforçant finalement la plateforme. Par conséquent, SWE-1.5 est lancé sur Windsurf en tant que produit poli, prêt pour une adoption généralisée.

L'impact de la vitesse sur l'expérience du développeur

La vitesse définit la valeur de SWE-1.5 sur Windsurf, permettant un codage en "état de flux". Les ingénieurs accomplissent les tâches sans attendre, stimulant la créativité et la production.

De plus, cette réactivité encourage l'expérimentation, car des boucles de rétroaction rapides affinent les idées rapidement.

Cependant, maintenir la qualité et la vitesse exige un équilibre minutieux, que Cognition atteint grâce à des tests rigoureux.

Comparaison de SWE-1.5 avec ses pairs de l'industrie

SWE-1.5 surpasse Haiku 4.5 et Sonnet 4.5 en vitesse tout en égalant leur intelligence. Les benchmarks confirment son avantage dans les tâches spécifiques au logiciel.

De plus, contrairement aux modèles généraux, il se spécialise dans l'ingénierie, offrant des solutions sur mesure.

En outre, l'écosystème de Windsurf amplifie ces avantages, offrant un environnement cohérent.

Considérations de sécurité et d'éthique lors du déploiement de SWE-1.5

Cognition priorise la sécurité dans SWE-1.5, en mettant en œuvre des mesures de protection contre les vulnérabilités. Les utilisateurs de Windsurf bénéficient d'interactions chiffrées et de contrôles d'accès.

De plus, une formation éthique garantit des résultats impartiaux, favorisant une utilisation équitable dans le développement.

Cependant, les équipes doivent surveiller les intégrations, en utilisant des outils comme Apidog pour vérifier la sécurité des API.

Intégration de SWE-1.5 avec les chaînes d'outils existantes

Les développeurs connectent SWE-1.5 aux IDE et aux pipelines CI/CD sur Windsurf. Les API facilitent cela, permettant des automatisations personnalisées.

De plus, la compatibilité avec des langages comme Python et JavaScript élargit l'attrait.

En outre, les contributions de la communauté améliorent les fonctionnalités, favorisant l'innovation.

Optimisation des performances : conseils pour les utilisateurs de Windsurf

Pour maximiser SWE-1.5, optimisez les invites pour la clarté. Utilisez Codemaps pour le contexte.

De plus, surveillez les métriques d'utilisation pour affiner les interactions.

En outre, intégrez avec Apidog pour les tâches liées aux API, garantissant l'efficacité.

Le rôle de l'apprentissage par renforcement dans le succès de SWE-1.5

L'apprentissage par renforcement façonne SWE-1.5, récompensant les actions correctes dans les simulations.

De plus, la formation multi-tours gère efficacement les conversations.

Cependant, la mise à l'échelle du RL exige une infrastructure robuste, que Cognition fournit.

Innovations matérielles permettant SWE-1.5

Les puces GB200 alimentent la formation, offrant un débit élevé.

De plus, l'inférence Cerebras accélère le déploiement.

En outre, Otterlink met à l'échelle les environnements, s'alignant sur les besoins du monde réel.

Considérations environnementales dans la formation de modèles d'IA

Cognition optimise la consommation d'énergie lors de la formation de SWE-1.5.

De plus, une inférence efficace réduit l'empreinte carbone.

Cependant, la mise à l'échelle nécessite des pratiques durables.

Tendances mondiales d'adoption de l'IA en ingénierie logicielle

Les développeurs du monde entier adoptent des modèles comme SWE-1.5.

De plus, Windsurf facilite l'accès dans diverses régions.

En outre, les efforts de localisation étendent la portée.

Développement collaboratif : comment les équipes utilisent SWE-1.5

Les groupes collaborent via des sessions partagées sur Windsurf.

De plus, les éditions en temps réel améliorent le travail d'équipe.

En outre, l'intégration du contrôle de version rationalise les flux de travail.

Conclusion : pourquoi SWE-1.5 sur Windsurf est important maintenant

Cognition lance SWE-1.5 sur Windsurf, redéfinissant l'IA en ingénierie logicielle. Sa vitesse et son intelligence donnent du pouvoir aux développeurs, favorisant l'innovation. Pendant que vous explorez, rappelez-vous que de petites optimisations produisent de grands impacts — commencez par télécharger Apidog gratuitement pour gérer les API en toute transparence.