Sora 2 d'OpenAI se distingue comme un outil puissant qui combine des invites textuelles avec une synchronisation audio avancée pour produire des clips réalistes. Les développeurs recherchent fréquemment des moyens d'exploiter cette technologie tout en évitant les distractions visuelles comme les filigranes, qui peuvent nuire aux applications professionnelles. Heureusement, l'utilisation de l'API Sora 2 offre une voie vers des sorties plus propres, en particulier lorsqu'elle est intégrée à des outils robustes de gestion d'API.

bouton

Cet article explore les aspects techniques de Sora 2, en se concentrant sur l'utilisation de l'API et les stratégies pour éliminer les filigranes. Vous apprendrez comment configurer votre environnement, exécuter des appels d'API et appliquer des méthodes de post-traitement. De plus, le guide intègre des exemples pratiques et des conseils d'optimisation pour améliorer vos projets.

Comprendre Sora 2 et ses Capacités

OpenAI a lancé Sora 2 le 30 septembre 2025, marquant une avancée significative dans la technologie de génération vidéo. Ce modèle s'appuie sur le Sora original en incorporant des simulations physiques plus précises, des animations réalistes et un audio synchronisé. Par exemple, Sora 2 rend avec précision des scénarios complexes tels qu'un ballon de basket rebondissant sur un panneau ou un gymnaste exécutant des routines complexes. Les développeurs exploitent ces fonctionnalités pour créer du contenu dynamique pour des applications dans le divertissement, l'éducation et le marketing.

Sora 2 fonctionne comme un modèle basé sur la diffusion qui transforme des invites textuelles en vidéos d'une durée maximale de 20 secondes, avec des résolutions atteignant 1080p dans les niveaux supérieurs. Il prend en charge des styles allant du réalisme cinématographique à l'esthétique anime. Cependant, les sorties officielles de l'application et du site web Sora incluent souvent des filigranes visibles pour indiquer la génération par IA, conformément aux politiques d'IA responsable d'OpenAI. Ces filigranes apparaissent sous forme de superpositions mobiles ou de métadonnées intégrées, ce qui peut limiter l'utilisabilité dans des contextes commerciaux.

En passant à la version API, Sora 2 offre une plus grande flexibilité. L'API, disponible en préversion pour les développeurs, permet un accès programmatique aux points de terminaison de génération sans les contraintes de l'application grand public. Vous y accédez via la plateforme d'OpenAI, nécessitant une clé API et potentiellement un abonnement Pro pour des fonctionnalités améliorées comme des résolutions plus élevées et l'absence de filigranes intégrés dans certaines configurations. Selon la documentation des développeurs, les points de terminaison de l'API se concentrent sur les requêtes texte-vers-vidéo, où vous spécifiez des paramètres tels que l'invite, la durée et le style.

Des plateformes comme Replicate et ComfyUI proposent des versions hébergées de l'API Sora 2, permettant des sorties sans filigrane via leurs interfaces. Ces alternatives s'intègrent parfaitement avec des outils comme Apidog, qui gère l'authentification et le formatage des requêtes. En utilisant l'API, vous contournez le filigrane par défaut appliqué dans le niveau gratuit de l'application, bien que certaines implémentations intègrent toujours des métadonnées. Néanmoins, cette approche vous permet de générer des vidéos propres adaptées à vos besoins.

Accéder à l'API Sora 2 : Prérequis et Configuration

Avant de générer des vidéos, vous devez sécuriser l'accès à l'API Sora 2. OpenAI déploie la disponibilité de l'API aux développeurs ayant des comptes actifs, en priorisant souvent ceux qui ont des abonnements Pro ou entreprise. Commencez par vous connecter à la plateforme développeur d'OpenAI à platform.openai.com. Là, vous créez une clé API dans la section des clés API. Assurez-vous que votre compte répond aux exigences d'accès à la préversion de Sora 2, ce qui peut impliquer de rejoindre une liste d'attente ou de vérifier votre cas d'utilisation.

Une fois approuvé, vous configurez votre environnement de développement. Installez les bibliothèques nécessaires, telles que le SDK Python d'OpenAI, en utilisant pip : pip install openai. Cette bibliothèque simplifie les interactions avec l'API. Pour les utilisateurs de JavaScript, le package Node.js offre des fonctionnalités similaires. De plus, si vous optez pour des hôtes tiers comme Replicate, inscrivez-vous sur leur site et obtenez un jeton API.

La sécurité joue un rôle crucial ici. Stockez toujours votre clé API dans des variables d'environnement plutôt que de la coder en dur, afin d'éviter toute exposition. Par exemple, en Python, utilisez os.environ['OPENAI_API_KEY'] = 'your-key'. Cette pratique protège vos identifiants lors de projets collaboratifs.

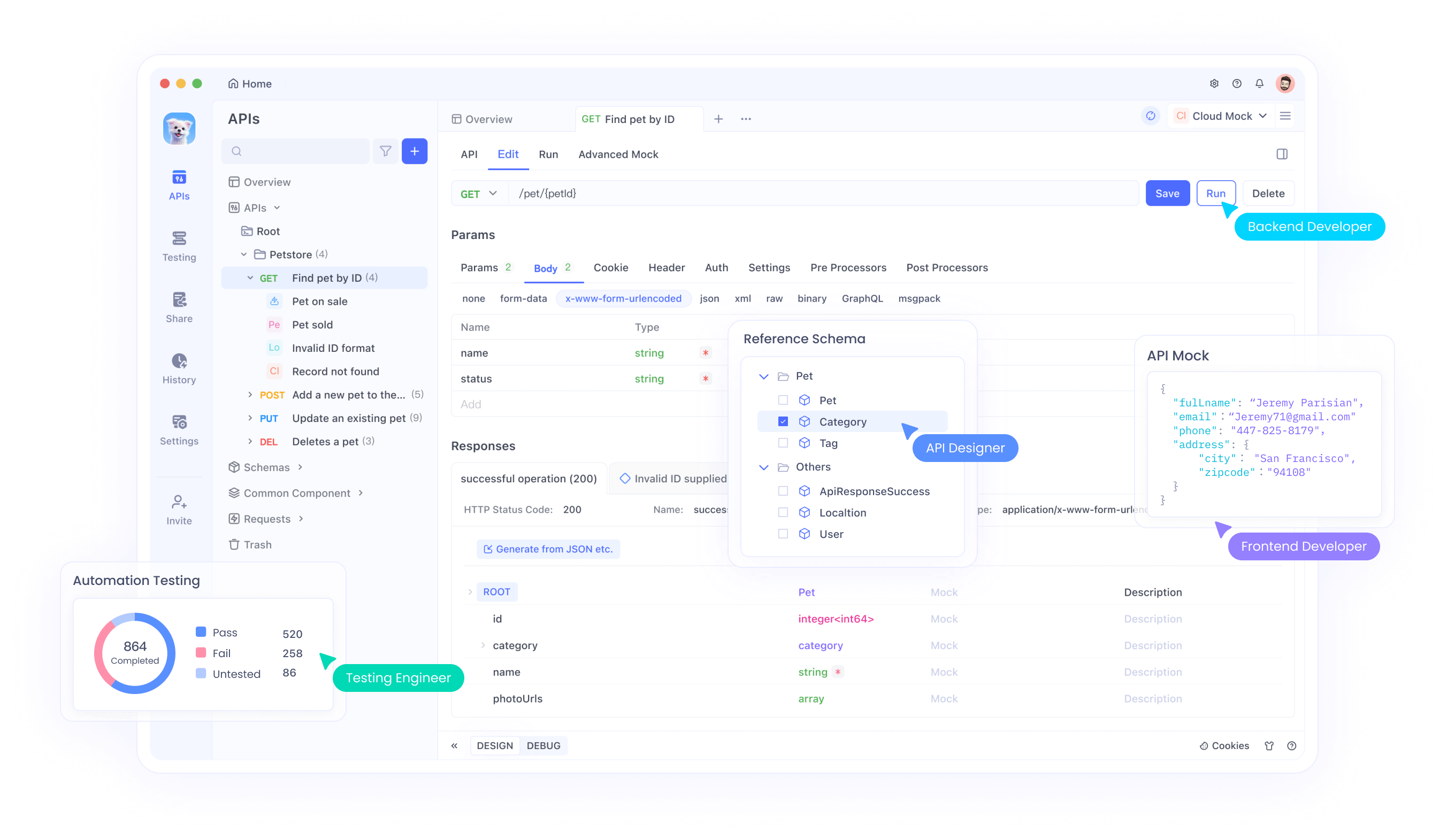

Maintenant, intégrez Apidog à votre configuration. En tant que client API complet, Apidog excelle dans le test et la documentation des points de terminaison OpenAI, y compris Sora 2. Téléchargez et installez Apidog depuis leur site officiel. Au lancement, créez un nouveau projet et importez la spécification de l'API OpenAI en collant l'URL du schéma OpenAPI ou en téléchargeant un fichier JSON. Apidog génère automatiquement des points de terminaison pour des modèles comme Sora 2, vous permettant de personnaliser les requêtes avec des paramètres tels que le nom du modèle ("sora-2") et les invites d'entrée.

L'interface d'Apidog ressemble à Postman mais offre des fonctionnalités avancées comme les tests automatisés et le mocking. Vous ajoutez votre clé API à l'en-tête d'autorisation, généralement en tant que jeton Bearer. Testez un point de terminaison simple, comme la liste des modèles, pour vérifier la connectivité : Envoyez une requête GET à /v1/models et confirmez que Sora 2 apparaît dans la réponse. Cette étape garantit que votre configuration fonctionne correctement avant de passer à la génération vidéo.

Configuration d'Apidog pour les Requêtes API Sora 2

Avec votre environnement prêt, plongez dans les capacités d'Apidog pour Sora 2. Créez une nouvelle collection d'API dédiée à la génération vidéo. À l'intérieur, ajoutez une requête POST au point de terminaison Sora 2, généralement /v1/video/generations ou similaire, basé sur la documentation d'OpenAI. Définissez le corps de la requête au format JSON.

Les paramètres clés incluent :

model: Spécifiez "sora-2" pour invoquer la dernière version.prompt: Une description textuelle détaillée, par exemple, "Un chat exécutant un triple axel sur glace avec un miaulement audio synchronisé."duration: En secondes, jusqu'à 20.resolution: Options comme "720p" ou "1080p" pour les utilisateurs Pro.style: "realistic", "cinematic", ou "anime".

Apidog vous permet de les paramétrer pour la réutilisabilité. Par exemple, utilisez des variables comme {{prompt}} pour tester rapidement plusieurs scénarios. De plus, activez les variables d'environnement pour basculer entre les clés API de test et de production.

Pour gérer les réponses asynchrones — car la génération vidéo peut prendre plusieurs minutes — vous configurez des webhooks ou du polling dans Apidog. Configurez un script pour vérifier l'état de la génération via une requête GET au point de terminaison de l'ID de tâche. Cette automatisation fait gagner du temps et garantit que vous récupérez efficacement les vidéos terminées.

De plus, Apidog prend en charge le scripting avec JavaScript pour les actions avant et après la requête. Écrivez un script pour valider la longueur de l'invite avant l'envoi, afin d'éviter les erreurs. Par exemple :

if (pm.variables.get('prompt').length > 1000) {

throw new Error('Prompt too long');

}

Cette protection technique améliore la fiabilité. Une fois configuré, envoyez votre première requête et surveillez la réponse, qui inclut généralement une URL vidéo ou un fichier encodé en base64.

Générer des Vidéos avec l'API Sora 2 : Exemples Étape par Étape

Vous exécutez maintenant des générations réelles. Commencez par une invite de base pour tâter le terrain. Dans Apidog, remplissez le corps :

{

"model": "sora-2",

"prompt": "A bustling city street at dusk with pedestrians and cars, ambient street sounds included.",

"duration": 10,

"resolution": "720p"

}

Envoyez la requête. L'API la traite et renvoie un ID de tâche. Interrogez le point de terminaison d'état toutes les 10 secondes jusqu'à ce qu'il soit "completed". Récupérez l'URL de la vidéo à partir de la réponse.

Pour une utilisation avancée, incorporez des caméos — une fonctionnalité permettant des éléments du monde réel comme la ressemblance d'une personne. Téléchargez une vidéo de référence via une requête de formulaire multipartie dans Apidog. Le corps pourrait ressembler à :

{

"model": "sora-2",

"prompt": "The uploaded person giving a TED talk on AI.",

"cameo_video": "base64-encoded-video",

"audio_sync": true

}

Apidog gère nativement les téléchargements de fichiers, ce qui rend cela transparent.

Cependant, les sorties peuvent toujours contenir des filigranes si vous utilisez le niveau standard. L'accès à l'API Pro, disponible pour les abonnés ChatGPT Pro, offre souvent des options de téléchargement sans filigrane. Vérifiez votre niveau d'abonnement ; la mise à niveau débloque cette fonctionnalité.

Pour optimiser les invites, expérimentez avec les détails. Ajoutez des descripteurs physiques comme "saut défiant la gravité" pour exploiter les forces de simulation de Sora 2. Suivez les métriques d'utilisation dans les analyses d'Apidog pour rester dans les limites de débit, généralement 500 générations par mois pour un accès prioritaire.

Stratégies pour Supprimer les Filigranes des Vidéos Sora 2

Même avec l'accès à l'API, certaines vidéos incluent des filigranes. Vous y remédiez par le post-traitement. Tout d'abord, comprenez les types de filigranes : les superpositions visibles (logos mobiles) et les métadonnées invisibles (normes C2PA).

Pour la suppression visible, utilisez des outils basés sur l'IA. Vmake AI, un service en ligne gratuit, utilise l'apprentissage profond pour détecter et effacer les filigranes mobiles. Téléchargez votre vidéo Sora 2, sélectionnez la zone du filigrane et traitez. L'outil préserve la qualité en inpeignant les sections supprimées avec des pixels contextuels.

Alternativement, utilisez des bibliothèques open-source comme OpenCV en Python. Chargez la vidéo :

import cv2

cap = cv2.VideoCapture('sora_video.mp4')

width = int(cap.get(cv2.CAP_PROP_FRAME_WIDTH))

height = int(cap.get(cv2.CAP_PROP_FRAME_HEIGHT))

fps = cap.get(cv2.CAP_PROP_FPS)

out = cv2.VideoWriter('clean_video.mp4', cv2.VideoWriter_fourcc(*'mp4v'), fps, (width, height))

while cap.isOpened():

ret, frame = cap.read()

if not ret:

break

# Detect and mask watermark (custom logic, e.g., ROI cropping or ML model)

clean_frame = remove_watermark(frame) # Implement function

out.write(clean_frame)

cap.release()

out.release()

Implémentez remove_watermark en utilisant un modèle pré-entraîné de Hugging Face, tel qu'un réseau de segmentation entraîné sur des ensembles de données de filigranes.

Pour les métadonnées, supprimez les balises C2PA avec FFmpeg : ffmpeg -i input.mp4 -codec copy -bsf:v "filter_units=remove_types=6" output.mp4. Cette commande supprime des filtres de flux de bits spécifiques sans ré-encodage.

Cependant, tenez compte des implications légales. Les conditions d'OpenAI interdisent la falsification des signaux de provenance, mais pour un usage interne ou lorsque cela est autorisé, ces méthodes s'appliquent. Attribuez toujours le contenu généré par l'IA de manière éthique.

En intégrant cela dans les flux de travail Apidog, automatisez le post-traitement via des scripts. Après avoir récupéré l'URL de la vidéo, téléchargez et exécutez le code de suppression.

Techniques Avancées pour l'Optimisation de l'API Sora 2

Pour améliorer votre utilisation, enchaînez plusieurs appels API. Générez une vidéo de base, puis remixez-la avec une invite de suivi : "Prolongez la scène précédente avec une tournure dramatique." Utilisez l'ID de tâche comme référence dans les requêtes ultérieures.

De plus, incorporez des améliorations audio. Sora 2 synchronise automatiquement les effets sonores, mais vous pouvez affiner en spécifiant "inclure une musique de fond orchestrale" dans les invites.

L'optimisation des performances implique le traitement par lots des requêtes. Apidog prend en charge les collections pour exécuter plusieurs tests simultanément, idéal pour les expériences de prompt A/B.

De plus, surveillez les coûts. La tarification de l'API Sora 2 commence à 0,05 $ par seconde de vidéo pour le standard, avec des tarifs plus élevés pour le Pro pour les fonctionnalités premium. Suivez via le tableau de bord d'OpenAI et définissez des alertes dans Apidog.

Pour la scalabilité, déployez dans des environnements de production. Utilisez des fonctions cloud comme AWS Lambda pour gérer les appels API, déclenchés par les entrées utilisateur. Sécurisez avec des passerelles API.

Bonnes Pratiques et Dépannage pour Sora 2 avec Apidog

Adoptez ces pratiques pour maximiser l'efficacité. Premièrement, validez rigoureusement les entrées — des invites médiocres produisent des vidéos de qualité inférieure. Utilisez les tests d'assertion d'Apidog pour vérifier les codes d'état de réponse (200 pour le succès).

Dépannez les problèmes courants : Si l'authentification échoue, régénérez votre clé. Pour les limites de débit, implémentez un backoff exponentiel dans les scripts :

import time

def api_call_with_retry(func, max_retries=5):

for attempt in range(max_retries):

try:

return func()

except Exception as e:

if 'rate_limit' in str(e):

time.sleep(2 ** attempt)

else:

raise

Erreurs réseau ? Passez aux paramètres de proxy d'Apidog.

De plus, collaborez en partageant des projets Apidog via des liens, assurant l'alignement de l'équipe sur les configurations Sora 2.

Études de Cas : Applications Réelles de Sora 2 Sans Filigrane

Considérez une entreprise de marketing utilisant l'API Sora 2 pour créer des clips publicitaires. Ils génèrent des vidéos sans filigrane pour les présentations clients, en intégrant Apidog pour des itérations rapides.

Dans l'éducation, les enseignants produisent des leçons animées. Après suppression, les vidéos s'intègrent proprement dans des plateformes comme YouTube.

Ces exemples illustrent la polyvalence de Sora 2 lorsqu'il n'est pas encombré de filigranes.

Perspectives d'Avenir et Mises à Jour pour l'API Sora 2

OpenAI continue de faire évoluer Sora 2, avec des extensions prévues comme des durées plus longues et de meilleures intégrations. Restez informé via leur blog.

Apidog ajoute régulièrement des fonctionnalités, telles que la génération de requêtes assistée par l'IA, complétant les avancées de Sora 2.

En résumé, maîtriser Sora 2 sans filigranes implique un accès à l'API, la facilitation par Apidog et des techniques de suppression ciblées. Mettez en œuvre ces étapes pour produire efficacement des vidéos de qualité professionnelle.

bouton