Vous êtes-vous déjà demandé comment les applications modernes évoluent sans effort sans que vous ayez à gérer un seul serveur ? C'est la magie des API serverless – une innovation majeure dans le cloud computing qui redéfinit la façon dont nous construisons et déployons les services backend. Si vous êtes un développeur lassé de l'approvisionnement de serveurs ou un propriétaire d'entreprise cherchant une mise à l'échelle rentable, les API serverless pourraient bien être votre nouveau meilleur ami. Dans cette exploration approfondie, nous allons décortiquer l'infrastructure derrière les API serverless, peser leurs avantages et inconvénients, mettre en lumière les outils populaires, les comparer aux backends traditionnels avec serveurs, explorer les tests avec Apidog, et répondre à la grande question : quand devriez-vous passer au serverless ? En nous appuyant sur les avis d'experts, analysons cela techniquement et voyons pourquoi les API serverless connaissent une popularité explosive en 2025.

Vous voulez une plateforme intégrée, tout-en-un, pour que votre équipe de développeurs travaille avec une productivité maximale ?

Apidog répond à toutes vos exigences et remplace Postman à un prix beaucoup plus abordable !

Comprendre l'infrastructure et l'architecture des API serverless

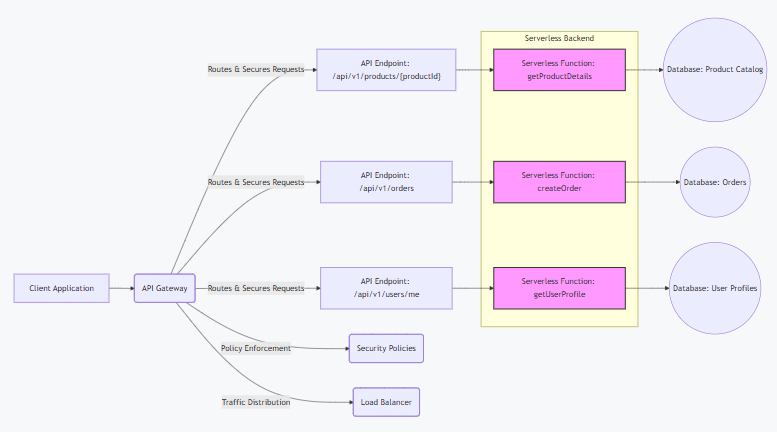

À la base, une API serverless est une API construite sur le calcul serverless, où les fournisseurs de cloud gèrent l'infrastructure backend, permettant aux développeurs de se concentrer uniquement sur le code. Contrairement aux configurations traditionnelles, les API serverless s'exécutent sur des plateformes Function as a Service (FaaS), exécutant du code dans des conteneurs sans état déclenchés par des événements comme les requêtes HTTP.

Techniquement, l'architecture s'articule autour du calcul événementiel. Lorsqu'une requête atteint votre point d'accès d'API serverless, le fournisseur (par exemple, AWS Lambda) lance un conteneur, exécute votre fonction et la met à l'échelle automatiquement en fonction de la demande. Cela utilise un modèle de paiement à l'usage – pas de serveurs inactifs signifie pas de coûts inutiles. Les éléments clés comprennent :

- Passerelle API : Agit comme point d'entrée, gérant le routage, l'authentification (par exemple, JWT ou OAuth), la limitation de débit et la transformation des requêtes. Par exemple, AWS API Gateway s'intègre à Lambda, mettant en cache les réponses pour une faible latence.

- Couche FaaS : Votre code réside ici sous forme de fonctions. Chaque fonction est isolée, avec des temps d'exécution limités (par exemple, 15 minutes sur Lambda) pour encourager la conception de microservices.

- Services Backend : Les API serverless se connectent à des bases de données gérées comme DynamoDB (NoSQL) ou Aurora Serverless (SQL), du stockage comme S3, et des files d'attente comme SQS pour le traitement asynchrone.

- Mécanismes de mise à l'échelle : Les fournisseurs utilisent des groupes de mise à l'échelle automatique et des équilibreurs de charge en coulisses. Pour un trafic élevé, les conteneurs se répliquent sur plusieurs zones de disponibilité, assurant une disponibilité de 99 % via la redondance.

Comparées aux architectures monolithiques, les API serverless se décomposent en fonctions granulaires, permettant une mise à l'échelle indépendante. Cependant, cela introduit des démarrages à froid – une latence initiale (50-500ms) lorsque les fonctions démarrent à partir d'un état inactif. Les stratégies d'atténuation incluent la concurrence provisionnée (pré-chauffage des fonctions) ou l'utilisation d'outils de pré-chauffage comme AWS Lambda Warmer.

En substance, l'architecture d'API serverless fait abstraction du système d'exploitation, du réseau et de l'approvisionnement, vous permettant de déployer du code sous forme de fonctions qui répondent à des déclencheurs. Elle est événementielle, sans état et très résiliente, mais nécessite une conception minutieuse pour éviter le verrouillage propriétaire.

Avantages et inconvénients des API serverless

Les API serverless ne sont pas une solution miracle, mais leurs avantages l'emportent souvent sur les inconvénients pour de nombreux cas d'utilisation. Analysons cela techniquement.

Avantages

- Efficacité des coûts : Ne payez que pour le temps d'exécution (par exemple, Lambda facture 0,20 $ par million de requêtes + 0,0000166667 $/Go-seconde). Pas de coûts pour le temps d'inactivité, idéal pour un trafic variable – économisez jusqu'à 90 % par rapport aux instances EC2 toujours actives.

- Mise à l'échelle automatique : Gère les pics de manière transparente ; Lambda se met à l'échelle jusqu'à 1 000 exécutions concurrentes par région par défaut, avec des limites de rafale allant jusqu'à 3 000. Aucun approvisionnement manuel n'est nécessaire.

- Mise sur le marché plus rapide : Concentrez-vous sur le code, pas sur l'infrastructure. Déployez des fonctions en quelques secondes via CLI (par exemple,

aws lambda update-function-code), accélérant les pipelines CI/CD. - Résilience intégrée : Les fournisseurs offrent un déploiement multi-AZ, des tentatives automatiques et des files d'attente de lettres mortes pour les événements échoués.

- Écosystème d'intégration : Connexions faciles à des services comme S3 (pour les déclencheurs de fichiers) ou DynamoDB (pour les flux de données), permettant des architectures événementielles.

Inconvénients

- Démarrages à froid : Pics de latence (jusqu'à 10s pour les fonctions complexes) lors de la mise à l'échelle à partir de zéro. Des solutions de contournement comme la concurrence provisionnée ajoutent des coûts (0,035 $/Go-heure).

- Verrouillage propriétaire : Les fonctionnalités propriétaires (par exemple, les couches Lambda) rendent la migration difficile. Utilisez des standards comme OpenFaaS pour la portabilité.

- Limites d'exécution : Les délais d'attente (15 min max), la mémoire (10 Go) et les tailles de charge utile (6 Mo synchrone) restreignent les tâches de longue durée – utilisez Step Functions pour l'orchestration.

- Défis de débogage : La nature distribuée rend le traçage difficile ; des outils comme X-Ray (0,0001 $/trace) aident, mais ajoutent de la complexité.

- Gestion de l'état : Les fonctions sans état nécessitent un stockage externe (par exemple, Redis), augmentant la latence et les coûts pour les applications avec état.

Globalement, les API serverless excellent pour les charges de travail en rafale et événementielles, mais peuvent ne pas convenir aux applications à débit élevé constant.

Outils et plateformes populaires pour les API serverless

Construire des API serverless est plus facile avec ces plateformes et outils, chacun offrant des fonctionnalités uniques pour différents besoins.

- AWS Lambda + API Gateway : L'OG du serverless. Lambda exécute du code dans plus de 15 langages, avec Gateway gérant le routage. Prix : 0,20 $/M requêtes. Avantages : Intégration AWS profonde. Inconvénients : Démarrages à froid.

- Google Cloud Functions + API Gateway : Événementiel, prend en charge Node.js/Python/Go. Prix : 0,40 $/M invocations. Avantages : Démarrages à froid rapides (via Firestore). Inconvénients : Limité à l'écosystème Google.

- Azure Functions + API Management : Fonctions déclenchées par minuterie en C#/Java/JS. Prix : 0,20 $/M exécutions. Avantages : Prise en charge du cloud hybride. Inconvénients : Courbe d'apprentissage plus raide.

- Vercel Serverless Functions : Fonctions Edge pour les applications Next.js. Prix : Niveau gratuit (100 Go-heures/mois). Avantages : Réseau Edge mondial. Inconvénients : Lié à l'hébergement Vercel.

- Cloudflare Workers : Stockage KV pour l'état. Prix : 0,30 $/M requêtes. Avantages : Zéro démarrage à froid. Inconvénients : Limite de 10 ms de CPU.

Des outils comme Serverless Framework (pour les déploiements multi-cloud) ou SAM (spécifique à AWS) simplifient l'orchestration. Pour GraphQL, Apollo Server sur Lambda est populaire.

Backends serverless vs. avec serveurs : Une comparaison technique

Le serverless (FaaS) et les backends avec serveurs (VMs/conteneurs traditionnels) diffèrent en termes de gestion, de mise à l'échelle et de coût. Voici une ventilation :

- Gestion : Le serverless abstrait l'infrastructure – pas de correctifs OS ou d'équilibrage de charge. Les serveurs nécessitent un contrôle total (par exemple, l'orchestration Kubernetes).

- Mise à l'échelle : Le serverless s'auto-adapte par requête (de zéro à des milliers en quelques secondes). Les serveurs nécessitent des groupes de mise à l'échelle manuels/automatiques, avec un délai d'approvisionnement.

- Modèle de coût : Serverless : Paiement à l'usage (par exemple, les Go-secondes de Lambda). Serveurs : Coûts fixes pour les instances toujours actives (par exemple, 0,10 $/heure pour EC2).

- Performance : Le serverless risque des démarrages à froid ; les serveurs offrent une latence constante mais gaspillent des ressources en cas de faible trafic.

- Gestion de l'état : Le serverless est sans état (utilise des bases de données externes) ; les serveurs prennent en charge nativement les applications avec état.

- Cas d'utilisation : Serverless pour les microservices/API ; serveurs pour les applications monolithiques ou gourmandes en calcul.

Dans les benchmarks, le serverless peut être 50 % moins cher pour les charges intermittentes mais 20 % plus lent en raison des démarrages. Choisissez en fonction des modèles de trafic – les approches hybrides combinent les deux.

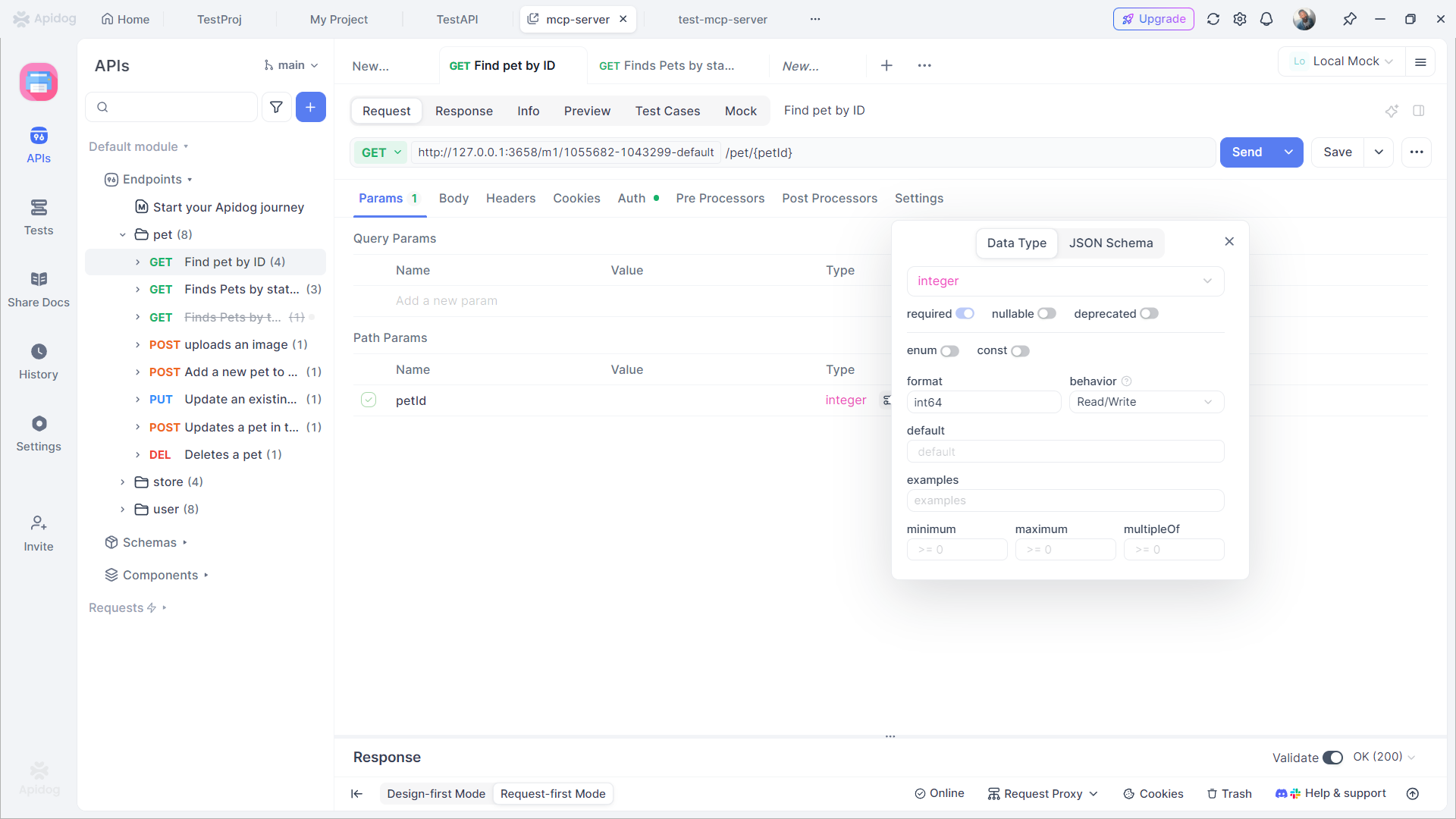

Tester les API serverless avec Apidog

Tester les API serverless est crucial pour assurer la fiabilité, et Apidog est un outil de premier plan pour cela. Cette plateforme tout-en-un prend en charge la conception visuelle, les tests automatisés et les serveurs Mock.

Comment Apidog aide à tester les API serverless

- Assertions visuelles : Définissez des énumérations et validez les réponses visuellement – aucun code n'est nécessaire.

- Exécutions illimitées : Exécutions de collections illimitées et gratuites, contrairement à la limite de 25/mois de Postman.

- Intégration CI/CD : Connectez-vous aux pipelines comme Jenkins pour des tests automatiques lors des déploiements.

- Mocking : Générez des données conformes aux énumérations pour les tests hors ligne.

- Assistance IA : Générez automatiquement des tests à partir d'invites, par exemple, "Tester l'énumération pour user_status."

Avantages : La synchronisation en temps réel d'Apidog détecte les problèmes tôt, et ses connexions de base de données testent les flux avec état. Le prix commence gratuitement, avec la version Pro à 9 $/mois – moins cher que Postman.

Quand devriez-vous utiliser les API serverless ?

Les API serverless offrent une approche moderne pour la construction et le déploiement d'applications, mais elles ne sont pas une solution universelle. Comprendre leurs forces et leurs limites est essentiel pour les utiliser efficacement. Voici une analyse des moments où il faut envisager les API serverless, avec des explications détaillées :

- Le trafic est variable : Le serverless est idéal pour les applications avec des modèles de trafic imprévisibles ou en pointe. Par exemple, les plateformes de commerce électronique pendant les ventes flash ou les sites d'inscription à des événements connaissant des pics soudains. Les fonctions serverless se mettent automatiquement à l'échelle pour gérer la demande et se réduisent à zéro lorsqu'elles sont inactives, garantissant que vous ne payez que pour l'utilisation réelle plutôt que pour l'approvisionnement d'une infrastructure coûteuse et toujours active.

- Prototypage rapide et MVP : Si vous avez besoin de valider rapidement une idée ou de construire un produit minimum viable (MVP), le serverless vous permet de déployer des fonctions en quelques secondes. Cette agilité accélère l'expérimentation, réduit le temps de mise sur le marché et permet aux équipes d'itérer en fonction des retours d'utilisateurs réels sans s'engager dans des configurations d'infrastructure complexes.

- Applications événementielles : Le serverless excelle dans les architectures événementielles. Les cas d'utilisation incluent le traitement des données IoT (par exemple, la gestion des déclencheurs de capteurs), la gestion des webhooks (par exemple, la réponse aux événements GitHub ou Stripe) et l'orchestration de microservices. Les fonctions sont déclenchées précisément lorsque des événements se produisent, assurant une utilisation efficace des ressources et simplifiant les flux de travail basés sur les événements.

- Optimisation des coûts pour les charges de travail intermittentes : Si votre application passe un temps significatif en veille (par exemple, 80 % ou plus), le serverless peut réduire considérablement les coûts. Les serveurs traditionnels entraînent des dépenses même lorsqu'ils sont inactifs, mais le serverless suit un modèle de paiement à l'exécution. Cela le rend économique pour les applications à faible trafic, les tâches par lots ou les tâches de fond qui s'exécutent par intermittence.

- Équipes avec peu de DevOps : Les organisations disposant de ressources DevOps limitées bénéficient de l'infrastructure gérée du serverless. Les fournisseurs de cloud gèrent la mise à l'échelle, les correctifs et la maintenance, permettant aux développeurs de se concentrer uniquement sur le code. Cela réduit les frais généraux d'exploitation et accélère les cycles de développement, facilitant la livraison plus rapide de fonctionnalités pour les petites équipes.

Quand éviter les API serverless :

Le serverless peut ne pas convenir pour :

- Processus de longue durée : Les fonctions ont généralement des limites de temps (par exemple, 15 minutes sur AWS Lambda), ce qui les rend mal adaptées aux tâches comme l'encodage vidéo ou les exportations de grandes données.

- Applications avec état : Le serverless est sans état par conception ; évitez-le pour les applications nécessitant des connexions persistantes ou un état en mémoire (par exemple, les serveurs WebSocket).

- Exigences de latence ultra-faible : Les démarrages à froid (délais lors de l'initialisation des fonctions) peuvent introduire de la latence, il faut donc éviter le serverless pour les systèmes en temps réel exigeant des temps de réponse constants inférieurs à 50 ms.

Verdict final

Commencez petit en prototypant un seul microservice ou point d'accès API. Mesurez les performances, les coûts et l'évolutivité dans votre contexte spécifique. Le serverless est un outil puissant pour les bons cas d'utilisation – adoptez-le pour le développement agile, les charges de travail variables et les besoins événementiels, mais associez-le à une infrastructure traditionnelle pour les exigences avec état ou de haute performance. En alignant le serverless avec vos objectifs architecturaux et en testant vos API avec Apidog, vous pouvez maximiser l'efficacité et l'innovation.