Les développeurs recherchent des outils qui améliorent la productivité tout en conservant le contrôle de leurs flux de travail. Devstral, un modèle d'IA open-source de Mistral AI, apparaît comme une solution puissante pour les tâches de codage. Conçu pour générer, déboguer et expliquer du code, Devstral se distingue par sa capacité à fonctionner localement via Ollama, une plateforme qui déploie des modèles d'IA sur votre matériel. Cette approche offre la confidentialité, réduit la latence et élimine les coûts du cloud ; des avantages clés pour les utilisateurs techniques. De plus, il prend en charge l'utilisation hors ligne, garantissant des sessions de codage ininterrompues.

Pourquoi choisir le déploiement local ? Premièrement, il protège les bases de code sensibles, essentielles dans les secteurs réglementés comme la finance ou la santé. Deuxièmement, il réduit les temps de réponse en contournant les délais Internet, idéal pour l'assistance en temps réel. Troisièmement, il permet d'économiser de l'argent en évitant les frais d'abonnement, élargissant l'accès aux développeurs solo. Prêt à exploiter Devstral ?

Configuration d'Ollama : installation étape par étape

Pour exécuter Devstral localement, vous devez d'abord installer Ollama. Cette plateforme simplifie le déploiement de modèles d'IA, ce qui la rend accessible même sur du matériel modeste. Suivez ces étapes pour commencer :

Configuration système requise

Assurez-vous que votre machine répond à ces spécifications :

- OS : Windows, macOS ou Linux

- RAM : Minimum 16 Go (32 Go préférés pour les modèles plus volumineux)

- CPU : Processeur multicœur moderne

- GPU : Facultatif mais recommandé (NVIDIA avec prise en charge de CUDA)

- Stockage : Au moins 20 Go d'espace libre pour les fichiers de modèle

Processus d'installation

- Télécharger Ollama : Visitez ollama.com et récupérez le programme d'installation pour votre système d'exploitation.

- Exécuter le programme d'installation :

- Sous Windows, exécutez le fichier

.exeet suivez les invites. - Sur macOS, ouvrez le fichier

.dmget faites glisser Ollama vers Applications. - Sous Linux, utilisez

curl -fsSL https://ollama.com/install.sh | shpour une configuration rapide.

- Vérifier l'installation : Ouvrez un terminal et tapez

ollama --version. Vous devriez voir le numéro de version (par exemple, 0.1.x). Sinon, vérifiez votre variable PATH.

Récupération de Devstral

Avec Ollama installé, extrayez Devstral de sa bibliothèque :

- Exécutez

ollama pull devstral. Cela télécharge le modèle, ce qui peut prendre du temps en fonction de votre bande passante (attendez-vous à 10-15 Go). - Confirmez la disponibilité avec

ollama list. Devstral devrait apparaître dans la sortie.

Lancement de Devstral

Exécutez ollama run devstral. Le terminal affiche un message de chargement, suivi d'une invite indiquant la préparation. Si des erreurs se produisent (par exemple, mémoire insuffisante), vérifiez votre matériel ou consultez la documentation de dépannage d'Ollama.

En suivant ces étapes, vous établissez une instance Devstral locale, prête pour les tâches de codage.

Utilisation de Devstral pour le codage : applications pratiques

Devstral excelle dans le codage, en tirant parti de sa formation sur de vastes ensembles de données de code. Voici comment vous l'utilisez activement :

Génération de code

Besoin d'une fonction rapidement ? Tapez une invite claire :

- Entrée : « Générer une fonction Python pour inverser une chaîne. »

- Sortie :

def reverse_string(text):

return text[::-1]

Cela utilise le découpage de Python, démontrant l'efficacité de Devstral.

Prise en charge du débogage

Bloqué sur un bug ? Fournissez votre code et le problème :

- Entrée : « Pourquoi ce fetch JavaScript renvoie-t-il undefined ?

fetch('https://api.example.com').then(data => console.log(data));» - Sortie : « Il vous manque

.json()pour analyser la réponse. Essayez :fetch('https://api.example.com').then(res => res.json()).then(data => console.log(data));»

Devstral identifie la correction, ce qui permet de gagner du temps de débogage.

Achèvement du code

Démarrez une fonction et laissez Devstral terminer :

- Entrée : « Terminer cette fonction Python :

def factorial(n):» - Sortie :

def factorial(n):

if n == 0 or n == 1:

return 1

return n * factorial(n - 1)

Cette solution récursive démontre la compréhension des algorithmes par Devstral.

Apprentissage de nouveaux concepts

Explorer un langage ? Demandez des explications :

- Entrée : « Montrez-moi comment créer une classe en C++. »

- Sortie :

class MyClass {

public:

int value;

MyClass(int v) : value(v) {}

void print() { std::cout << value << std::endl; }

};

Devstral associe le code à un contexte implicite, facilitant la compréhension.

Interagissez via le terminal après avoir lancé ollama run devstral. Pour une utilisation avancée, explorez l'intégration de l'API si elle est prise en charge ; consultez la documentation d'Ollama pour les points de terminaison.

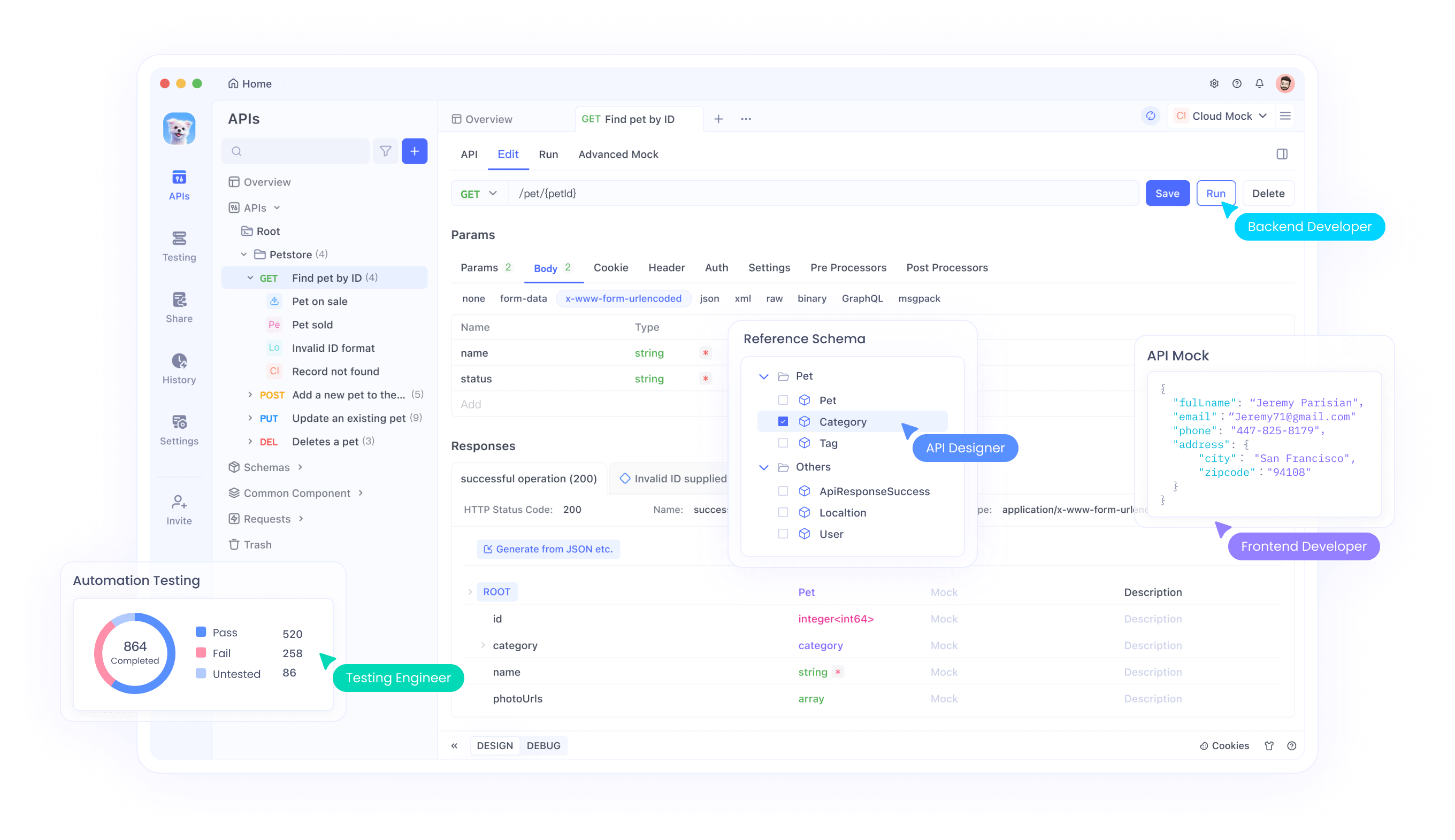

Améliorer le flux de travail avec Apidog : intégration des tests d'API

Alors que Devstral gère le codage, Apidog garantit que vos API fonctionnent de manière fiable. Cet outil rationalise le développement d'API, complétant les capacités de Devstral.

Tests d'API

Validez les points de terminaison avec Apidog :

- Lancez Apidog et créez un projet.

- Définissez un point de terminaison (par exemple,

GET /users). - Définissez les paramètres et exécutez les tests. Vérifiez l'état 200 et le JSON valide.

Serveurs simulés

Simulez des API pendant le développement :

- Dans Apidog, accédez à l'onglet du serveur simulé.

- Spécifiez les réponses (par exemple,

{ "id": 1, "name": "Test" }). - Utilisez l'URL générée dans votre code, en testant sans serveurs en direct.

Documentation de l'API

Générez des documents automatiquement :

- Créez des cas de test dans Apidog.

- Exportez la documentation au format HTML ou Markdown pour le partage en équipe.

L'intégration d'Apidog garantit que vos API s'alignent sur le code généré par Devstral, créant ainsi un pipeline robuste.

Utilisation avancée : personnalisation de Devstral

Optimisez le potentiel de Devstral grâce à ces techniques :

Réglage des paramètres

Ajustez les paramètres tels que temperature (aléatoire) ou top-p (diversité de sortie) via les options de configuration d'Ollama. Testez les valeurs pour équilibrer la créativité et la précision.

Intégration IDE

Recherchez des plugins compatibles avec Ollama pour VS Code ou JetBrains IDE. Cela intègre Devstral directement dans votre éditeur, améliorant ainsi le flux de travail.

Utilisation de l'API

Si Ollama expose une API, créez des scripts pour automatiser les tâches. Exemple : un script Python envoyant des invites à Devstral via des requêtes HTTP.

Engagement communautaire

Suivez les mises à jour sur mistral.ai ou les forums d'Ollama. Contribuez aux corrections ou partagez des cas d'utilisation pour façonner le développement.

Ces étapes adaptent Devstral à vos besoins, augmentant ainsi l'efficacité.

Contexte technique : sous le capot

Devstral et Ollama combinent une technologie de pointe :

Architecture Devstral

Mistral AI a construit Devstral en tant que LLM basé sur un transformateur, formé sur du code et du texte. Sa prise en charge multilingue découle d'ensembles de données étendus, permettant une génération de code précise.

Framework Ollama

Ollama optimise les modèles pour l'exécution locale, prenant en charge l'accélération du processeur et du GPU. Il gère le chargement des modèles, la gestion de la mémoire et l'inférence, en abstraisant la complexité pour les utilisateurs.

Cette synergie offre une IA haute performance sans dépendance au cloud.

Conclusion

L'exécution de Devstral localement avec Ollama permet aux développeurs de disposer d'un outil de codage privé, rentable et hors ligne. Vous l'installez facilement, l'utilisez pour diverses tâches de codage et l'améliorez avec les tests d'API d'Apidog. Cette combinaison stimule la productivité et la qualité. Rejoignez la communauté Devstral, expérimentez les personnalisations et améliorez vos compétences. Téléchargez Apidog gratuitement dès aujourd'hui pour compléter votre boîte à outils.