Exécuter des modèles de codage avancés localement permet aux développeurs d'exploiter l'IA de pointe sans dépendre des services cloud. DeepCoder, un modèle de codage open source complet de 14 milliards de paramètres, offre des performances exceptionnelles comparables à O3-mini. Lorsqu'il est associé à Ollama, un framework léger pour exécuter des modèles de langage volumineux (LLM), vous pouvez déployer DeepCoder sur votre machine efficacement. Ce guide technique vous guide tout au long du processus, de la configuration à l'exécution, tout en intégrant des outils comme Apidog pour les tests d'API.

Qu'est-ce que DeepCoder ?

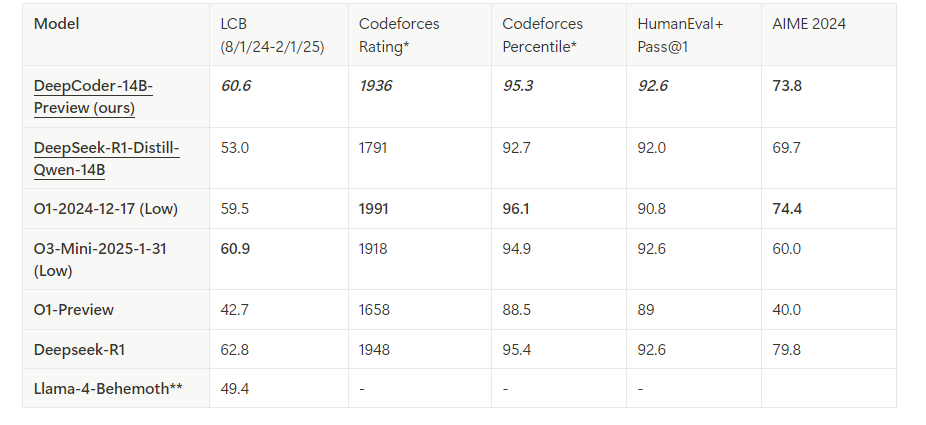

DeepCoder est un modèle de codage open source de 14 milliards de paramètres développé grâce à une collaboration entre Agentica et Together AI. Construit en affinant Deepseek-R1-Distilled-Qwen-14B avec l'apprentissage par renforcement distribué (RL), il excelle dans les tâches de raisonnement et de génération de code. De plus, une version plus petite de 1,5 milliard existe pour les environnements aux ressources limitées. Contrairement aux modèles propriétaires, la nature open source de DeepCoder permet une transparence et une personnalisation complètes, ce qui en fait un favori parmi les développeurs.

Ollama, d'autre part, simplifie le déploiement des LLM comme DeepCoder. Il fournit un runtime léger et une API pour une intégration transparente dans les flux de travail de développement. En combinant ces outils, vous débloquez un assistant de codage local puissant.

Conditions préalables pour exécuter DeepCoder localement

Avant de continuer, assurez-vous que votre système répond aux exigences. Voici ce dont vous avez besoin :

Matériel :

- Une machine avec au moins 32 Go de RAM (64 Go recommandés pour le modèle 14B).

- Un GPU moderne (par exemple, NVIDIA RTX 3090 ou supérieur) avec 24 Go+ de VRAM pour des performances optimales.

- Alternativement, un CPU avec suffisamment de cœurs (par exemple, Intel i9 ou AMD Ryzen 9) fonctionne pour le modèle 1,5B.

Logiciel :

- Système d'exploitation : Linux (Ubuntu 20.04+), macOS ou Windows (via WSL2).

- Git : pour cloner les référentiels.

- Docker (facultatif) : pour un déploiement conteneurisé.

- Python 3.9+ : pour les scripts et les interactions avec l'API.

Dépendances :

- Ollama : installé et configuré.

- Fichiers de modèle DeepCoder : téléchargés depuis la bibliothèque officielle Ollama.

Avec cela en place, vous êtes prêt à installer et à configurer l'environnement.

Étape 1 : Installez Ollama sur votre machine

Ollama sert d'élément fondamental pour exécuter DeepCoder localement. Suivez ces étapes pour l'installer :

Télécharger Ollama :

Visitez le site Web officiel d'Ollama ou utilisez un gestionnaire de paquets. Pour Linux, exécutez :

curl -fsSL https://ollama.com/install.sh | sh

Sur macOS, utilisez Homebrew :

brew install ollama

Vérifier l'installation :

Vérifiez la version pour confirmer qu'Ollama est installé correctement :

ollama --version

Démarrer le service Ollama :

Lancez Ollama en arrière-plan :

ollama serve &

Cela exécute le serveur sur localhost:11434, exposant une API pour les interactions avec le modèle.

Ollama est maintenant opérationnel. Ensuite, vous récupérerez le modèle DeepCoder.

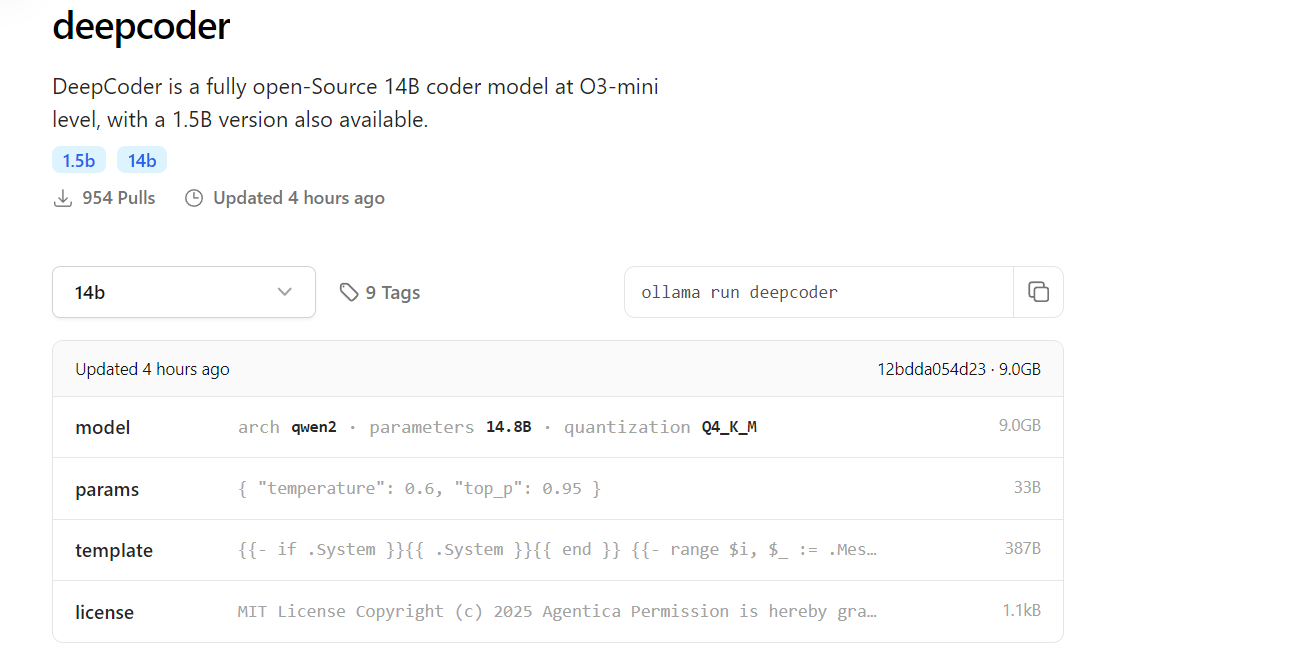

Étape 2 : Téléchargez DeepCoder depuis la bibliothèque Ollama

DeepCoder est disponible dans la bibliothèque de modèles Ollama. Voici comment le récupérer :

Récupérer DeepCoder :

Téléchargez le modèle 14B (ou 1,5B pour les configurations plus légères) :

ollama pull deepcoder

Cette commande récupère la dernière version balisée. Pour une balise spécifique, utilisez :

ollama pull deepcoder:14b-preview

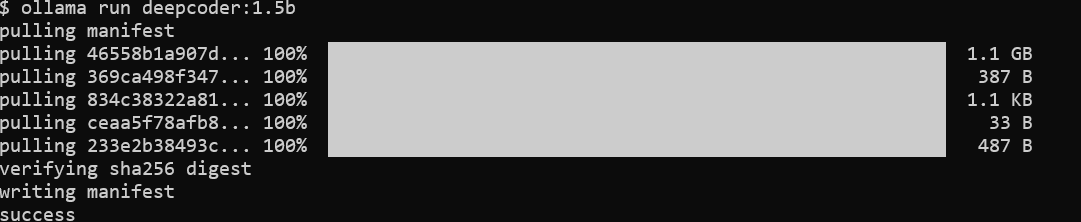

Surveiller la progression du téléchargement :

Le processus diffuse des mises à jour, affichant les digests de fichiers et l'état d'achèvement. Attendez-vous à un téléchargement de plusieurs gigaoctets pour le modèle 14B, assurez-vous donc d'avoir une connexion Internet stable.

Vérifier l'installation :

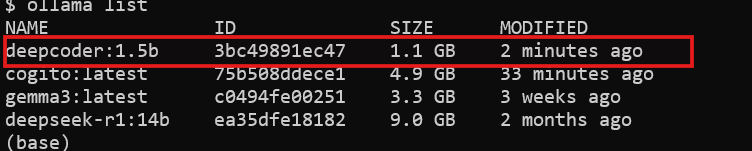

Vérifiez si DeepCoder est disponible :

ollama list

Vous verrez deepcoder répertorié parmi les modèles installés.

Avec DeepCoder téléchargé, vous êtes prêt à l'exécuter.

Étape 3 : Exécutez DeepCoder localement avec Ollama

Maintenant, exécutez DeepCoder et testez ses capacités :

Démarrer DeepCoder :

Lancez le modèle dans une session interactive :

ollama run deepcoder

Cela ouvre une invite où vous pouvez saisir des requêtes de codage.

Ajuster les paramètres (facultatif) :

Pour une utilisation avancée, modifiez les paramètres tels que la température via un fichier de configuration ou un appel d'API (couvert plus tard).

DeepCoder est maintenant en cours d'exécution localement. Cependant, pour l'intégrer dans les flux de travail, vous utiliserez son API.

Étape 4 : Interagissez avec DeepCoder via l'API Ollama

Ollama expose une API RESTful pour un accès programmatique. Voici comment l'exploiter :

Vérifier la disponibilité de l'API :

Assurez-vous que le serveur Ollama est en cours d'exécution :

curl http://localhost:11434

Une réponse confirme que le serveur est actif.

Envoyer une requête :

Utilisez curl pour interroger DeepCoder :

curl http://localhost:11434/api/generate -d '{

"model": "deepcoder",

"prompt": "Generate a REST API endpoint in Flask",

"stream": false

}'

La réponse comprend le code généré, tel que :

from flask import Flask, jsonify

app = Flask(__name__)

@app.route('/api/data', methods=['GET'])

def get_data():

return jsonify({"message": "Hello, World!"})

if __name__ == "__main__":

app.run(debug=True)

Intégrer avec Python :

Utilisez la bibliothèque requests de Python pour une interaction plus propre :

import requests

url = "http://localhost:11434/api/generate"

payload = {

"model": "deepcoder",

"prompt": "Write a Node.js Express API",

"stream": False

}

response = requests.post(url, json=payload)

print(response.json()["response"])

L'API libère le potentiel de DeepCoder pour l'automatisation et l'intégration.

Étape 5 : Améliorez les tests d'API avec Apidog

DeepCoder excelle dans la génération de code d'API, mais tester ces API est crucial. Apidog simplifie ce processus :

Installer Apidog :

Téléchargez et installez Apidog depuis son site officiel.

Tester l'API générée :

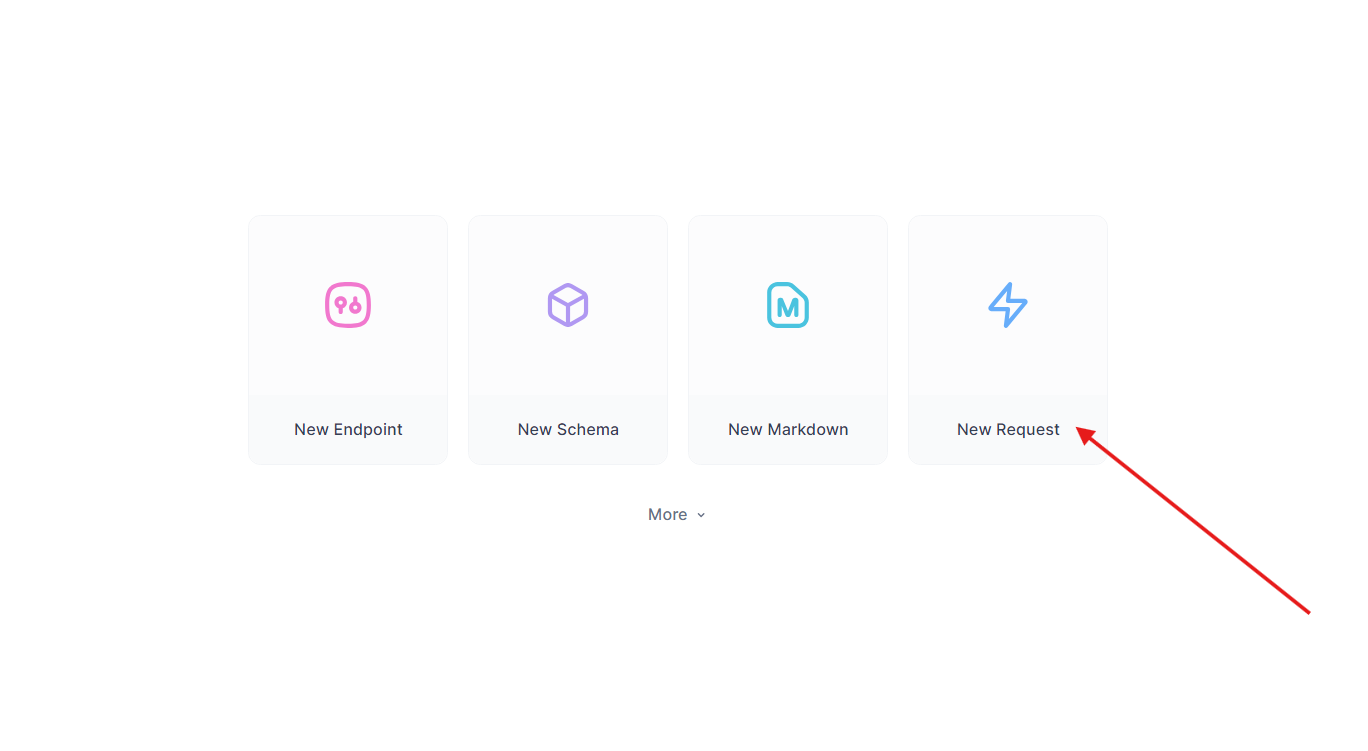

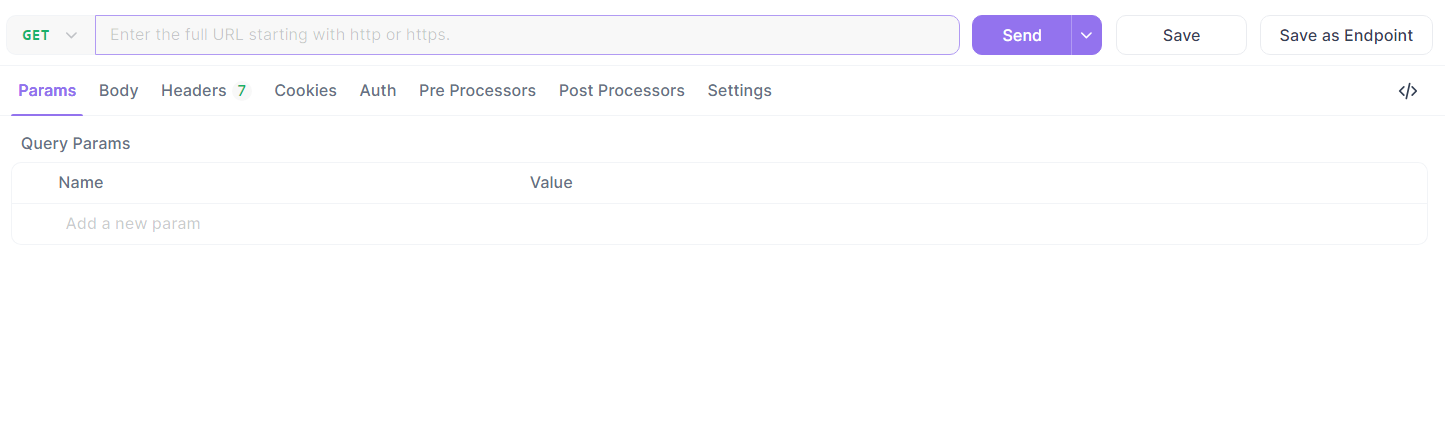

Prenez le point de terminaison Flask de tout à l'heure. Dans Apidog :

- Créez une nouvelle requête.

- Définissez l'URL sur

http://localhost:5000/api/dataet envoyez une requête GET.

- Vérifiez la réponse :

{"message": "Hello, World!"}.

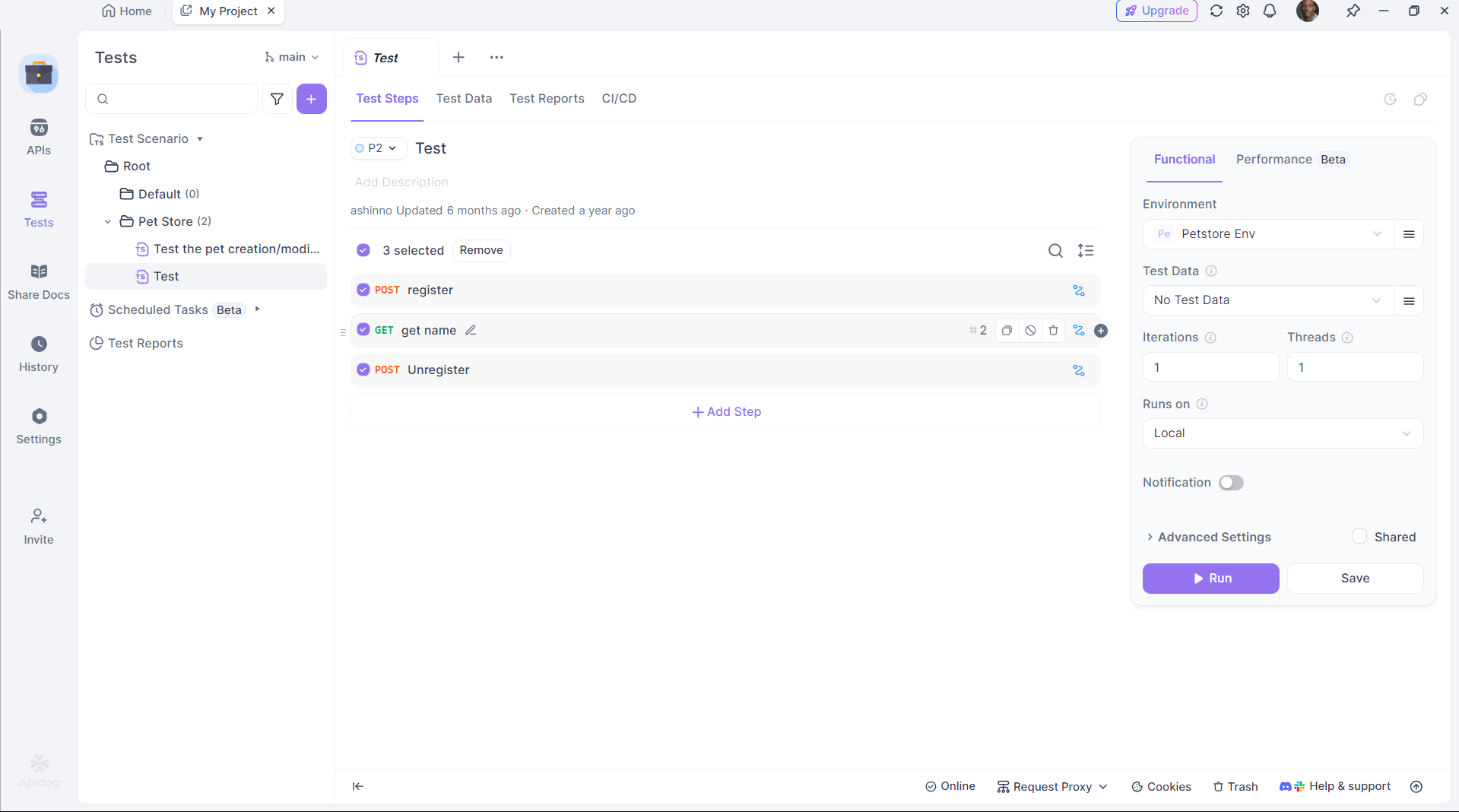

Automatiser les tests :

Utilisez le script d'Apidog pour automatiser la validation, en vous assurant que la sortie de DeepCoder répond aux attentes.

Apidog comble le fossé entre la génération de code et le déploiement, améliorant la productivité.

Étape 6 : Optimiser les performances de DeepCoder

Pour maximiser l'efficacité, affinez la configuration de DeepCoder :

Accélération GPU :

Assurez-vous qu'Ollama décharge le calcul sur votre GPU. Vérifiez avec :

nvidia-smi

L'utilisation du GPU indique une accélération réussie.

Gestion de la mémoire :

Pour le modèle 14B, allouez suffisamment de VRAM. Ajustez l'espace d'échange sur Linux si nécessaire :

sudo fallocate -l 32G /swapfile

sudo chmod 600 /swapfile

sudo mkswap /swapfile

sudo swapon /swapfile

Quantification du modèle :

Utilisez une quantification plus petite (par exemple, 4 bits) pour le modèle 1,5B :

ollama pull deepcoder:1.5b-q4

Ces ajustements garantissent que DeepCoder fonctionne sans problème sur votre matériel.

Pourquoi choisir DeepCoder avec Ollama ?

L'exécution de DeepCoder localement offre des avantages distincts :

- Confidentialité : Gardez le code sensible hors des serveurs cloud.

- Coût : Évitez les frais d'abonnement.

- Personnalisation : Adaptez le modèle à vos besoins.

L'associer au framework léger d'Ollama et aux capacités de test d'Apidog crée un écosystème de développement puissant et autonome.

Conclusion

La configuration de DeepCoder localement avec Ollama est simple mais transformatrice. Vous installez Ollama, récupérez DeepCoder, l'exécutez et l'intégrez via l'API, le tout en quelques étapes. Des outils comme Apidog améliorent encore l'expérience en garantissant que les API générées fonctionnent parfaitement. Que vous soyez un développeur solo ou que vous fassiez partie d'une équipe, cette configuration offre un assistant de codage open source robuste.